你不买我不买,显卡出货量破二十年新低!红绿蓝三家混战,国产GPU引起海外关注

显卡市场的寒气,藏不住了。

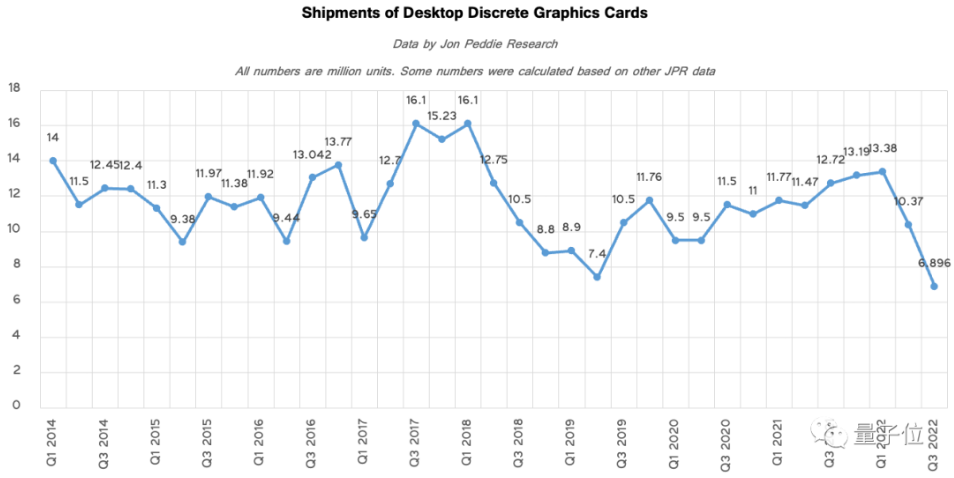

刚刚过去的2022年,全球独显出货量创下二十年新低,比2021年同期下跌将近50%。

Jon Peddie Research(JPR)最新数据显示,今年第三季度独显出货量仅690万块。

如果追溯到2005年Q3,这一数据为2000万+。

而英伟达作为全球显卡市场头号玩家,遭受的重创早就开始显现:今年Q2、Q3业绩连续下滑,如今股价已跌至去年最高点一半左右。

内忧之下,还有外患。

前有CPU巨头英特尔高调官宣分拆图形芯片部门,为更好和英伟达、AMD打擂台;后有中国GPU厂商异军突起,多家公司在今年宣布流片或量产,已引起国外关注。

看来老黄的2022,或许并不好过。

今年显卡市场扑朔迷离

如果以“短缺”概括2021年显卡市场,那么今年的江湖,则如过山车般跌宕。

年初还在到处缺货,市场价高过发售价太过正常,一些装机玩家索性改买品牌高性价笔记本。1月时,Meta还被曝一次性从英伟达买下1.6万个GPU,还引来不少艳羡目光。

3月,情况就发生了变化。

显卡市场价已有跳水现象,再到7月,国内外消费者已基本都能以建议零售价从官方渠道及主流平台购入英伟达及AMD显卡。

“空气卡”一词逐渐隐退,不再是引发大家共鸣的表达。

缺芯潮基本结束。

短短数月的变化,主要源于两点。

其一,全球消费热潮冷却;

其二,大规模挖矿行动的终结。

当然,此前显卡缺货引发的供应链加码生产,一消一涨,数月内就将显卡从“空气”变成“实体”。

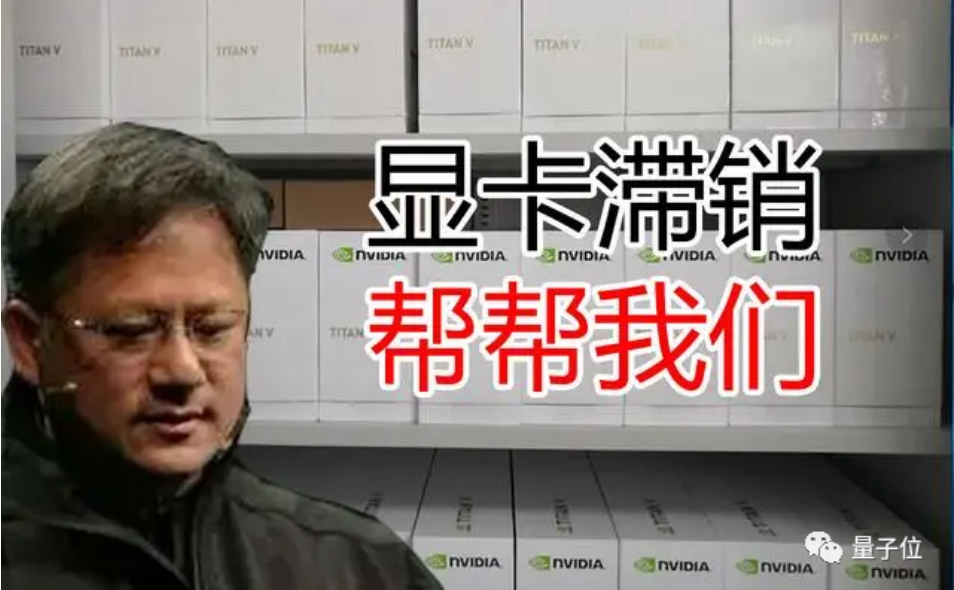

但很快,产品过剩去库存,就成为了后半年主旋律。对各大厂商,冷热交替过快过烈,着实一番冰火两重天体验。

以占大半壁江山的英伟达为例。

7月初大批产品跌至零售价,到中旬,高端款RTX 3090 Ti跌到了比零售价还便宜38%。

一个月后,英伟达颤颤巍巍预披露了Q2财报,不出所料,与消费级显卡直接挂钩的游戏业务塌方,营收环比跌掉44%,黄仁勋表示,随季度推进,该板块销售预测还将下调,去库存成为主要目标。

随后,就是官方打折,甚至搞出买30系显卡及配备的电脑,送59.99美元游戏的促销路数。

在这种动荡之下,英伟达生意越来越不好做,从财报上就能看到。

2022年5-7月,公司营收环比下跌了66%(non-GAAP),净利润环比下跌62%(non-GAAP)。后面一季的数据略有回涨,营收环比涨幅为16%(non-GAAP),但同比去年同期,跌幅还是很大,达到了55%(non-GAAP)。

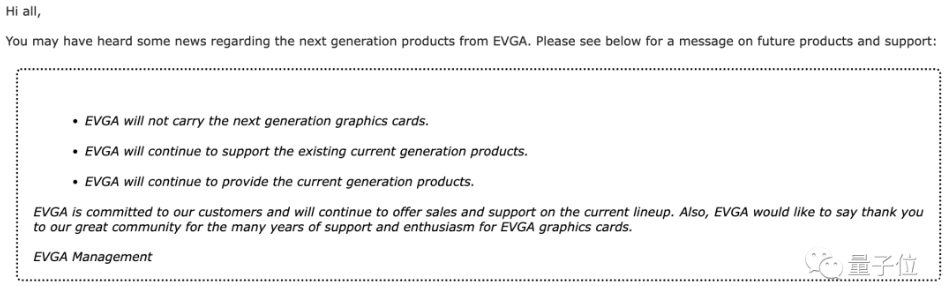

这当中,英伟达还和最大合作伙伴EVGA闹掰了。

9月,EVGA单方面宣布,不会同英伟达下一代产品合作。

要知道,两者合作20多年,而且EVGA收入中80%来自英伟达合作的显卡。

根据EVGA的说法,英伟达的合作态度是两者关系恶化的关键。具体来说,英伟达一方沟通越来越少,新产品信息不同步,重要活动也不cue合作方,连价格调整也不事先同步。

比如RTX 3090 Ti显卡,英伟达给零售商报价比EVGA对外低了300美元,却不事先沟通,这下,合作方相当“被动”。

由于双方交恶时间点又赶在40系列显卡前一周,当时引发不小震动。

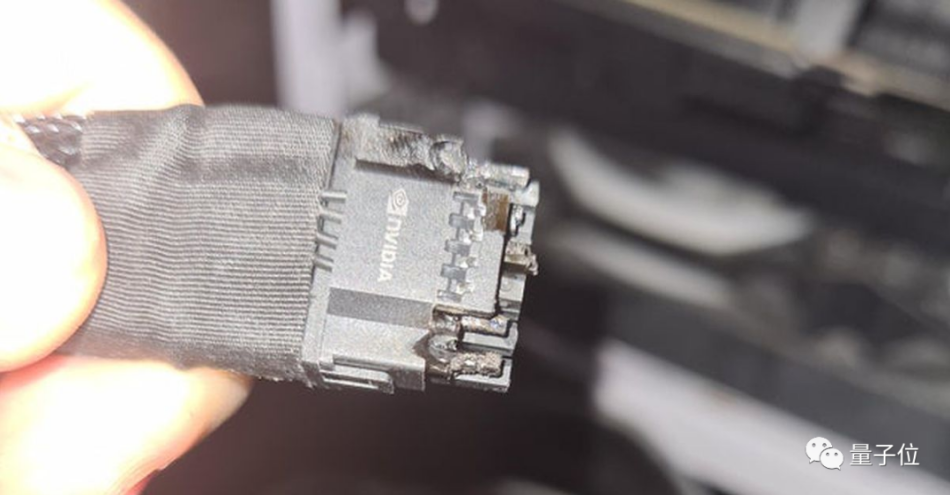

而几天后40系高调发布,售价最高12999人民币,很多消费者反馈却是“不值”二字,更别说4090电源接口熔化,又是一波不满。

△ 图源:theverge

而更大的变动或许还没到来——英伟达的新对手也越来越多。

各路对手杀到老黄城下

最明显的一个动向就是,英特尔开抢GPU市场份额了。

本月初,英特尔宣布将把图形芯片部门(AXG)一分为二,通过重组业务,更好地和英伟达、AMD竞争。

过去英特尔一直在主导CPU市场,GPU方面一直不是其发展核心。但在AI热浪下,英特尔也不得不重视起加速计算市场了。

其在官方声明表示:

图形芯片和加速计算是英特尔的关键增长引擎。我们正在改进我们的结构,以加速和扩大它们的影响,并通过向客户发出统一的声音来推动上市战略。

据JPR统计,今年第三季度独显市场中,英特尔占比4%。对比来看,AMD也仅有8%。

而更引人注目的变化,发生在国内。

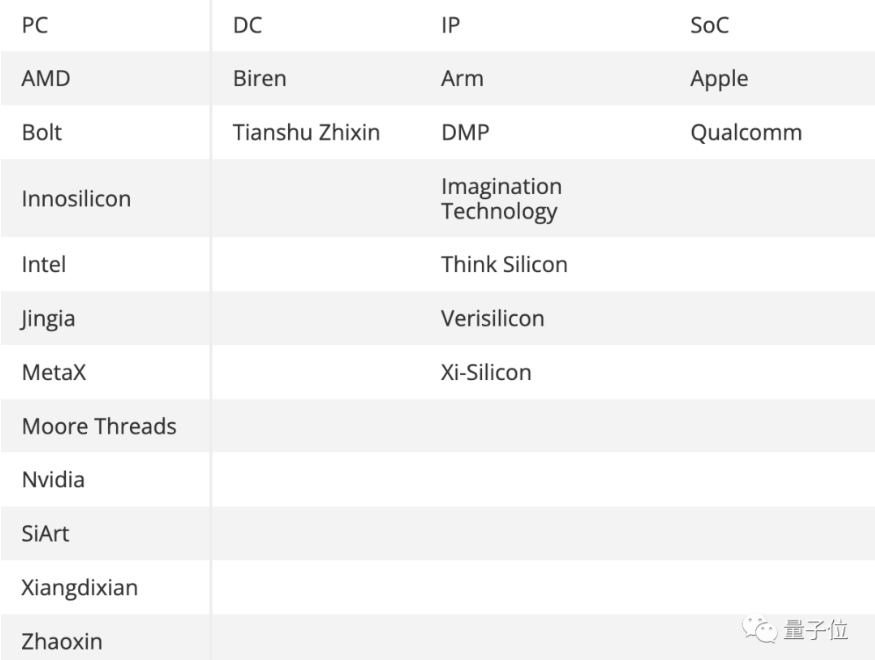

今年,摩尔线程一年内交出两块全功能GPU;芯动科技发布了“风华2号”、“风华1号”开始量产;面向数据中心的壁仞则发布了首款通用GPU芯片BR100,单芯片峰值算力达到PFLOPS级别;象帝先也发布了拥有100%自主知识产权的通用GPU……

脚步之快,已引发海外关注。

权威机构Jon Peddie Research在其对2022全球GPU市场的年度报告中写道:

在AI和高性能计算的驱动下,中国厂商正在向GPU市场发起进军。

由此也带动全球GPU厂商数量激增,独显厂商中,中国面孔就占据了一半席位。

当然这不是一夜之间发生的事。

在AI浪潮的驱动下,中国在数字化升级和人工智能行业融入的脚步上都十分迅速,国内对于GPU的需求空前高涨。

另一边,中国人工智能行业过度依赖英伟达显卡的情况也确实存在。这不光会造成资金上的压力,还容易出现“卡脖子”的情况。

在多种趋势和因素的影响下,早在20年下半年开始,资本市场上讲出了包括图形渲染在内的全功能GPU的新故事。壁仞科技、摩尔线程先后成立并大笔融资,芯动科技、兆芯等老牌芯片公司的独立显卡项目也在这附近官宣。

如今2年时间过去,已有多家厂商完成了流片或量产。

不可否认,当下或许还只是国内厂商迈出的第一步。从IP供应商处购买授权的方式,好处是能够减少投入加速回报,还能迅速积累经验、逐步建立起人才队伍。但在自研上后面还有很长的路要走。

而且如苹果、三星等攀登IP自研之路时,也并非一帆风顺。苹果分手3年后又回头重新与Imagination合作,据市场传闻有专利方面的原因。

因此,对于国内GPU自研,还需要更多耐心。

但无论如何,在全球显卡市场遭遇动荡的背景下,风险和机遇都随之而来。眼下,或许只是市场变革的开始了。

另外,最新消息显示,英伟达、AMD以及英特尔都已削减在台积电的订单。

参考链接:

[1]https://www.tomshardware.com/news/sales-of-desktop-graphics-cards-hit-20-year-low

[2]https://www.tomshardware.com/news/ai-and-tech-sovereignity-drive-number-of-gpu-developers-in-china

詹士 明敏 发自 凹非寺

来自|量子位

收起阅读 »react的useState源码分析

前言

简单说下为什么React选择函数式组件,主要是class组件比较冗余、生命周期函数写法不友好,骚写法多,functional组件更符合React编程思想等等等。更具体的可以拜读dan大神的blog。其中Function components capture the rendered values这句十分精辟的道出函数式组件的优势。

但是在16.8之前react的函数式组件十分羸弱,基本只能作用于纯展示组件,主要因为缺少state和生命周期。本人曾经在hooks出来前负责过纯函数式的react项目,所有状态处理都必须在reducer中进行,所有副作用都在saga中执行,可以说是十分艰辛的经历了。在hooks出来后我在公司的一个小中台项目中使用,落地效果不错,代码量显著减少的同时提升了代码的可读性。因为通过custom hooks可以更好地剥离代码结构,不会像以前类组件那样在cDU等生命周期堆了一大堆逻辑,在命令式代码和声明式代码中有一个良性的边界。

useState在React中是怎么实现的

Hooks take some getting used to — and especially at the boundary of imperative and declarative code.

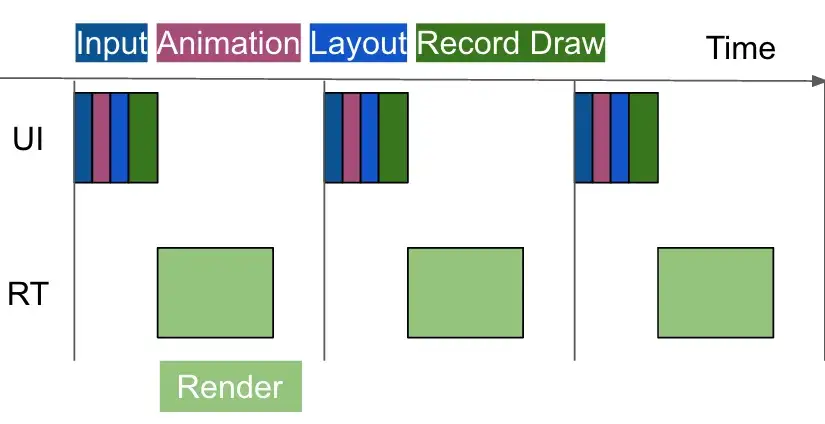

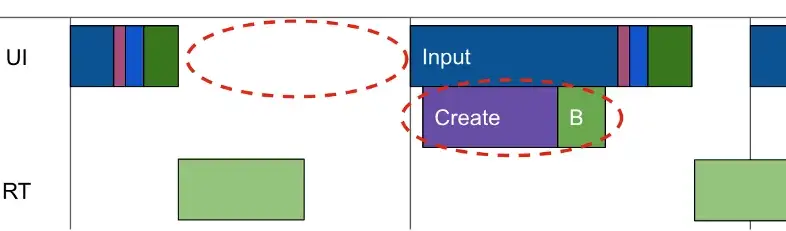

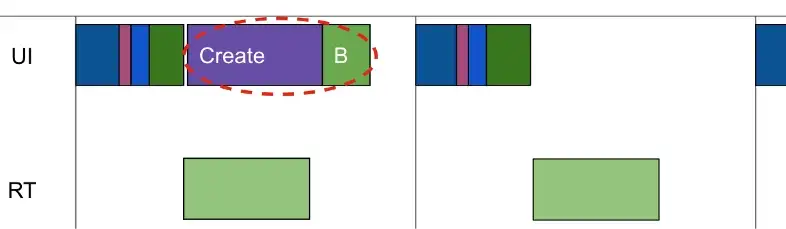

如果对hooks不太了解的可以先看看这篇文章:前情提要,十分简明的介绍了hooks的核心原理,但是我对useEffect,useRef等钩子的实现比较好奇,所以开始啃起了源码,下面我会结合源码介绍useState的原理。useState具体逻辑分成三部分:mountState,dispatch, updateState

hook的结构

首先的是hooks的结构,hooks是挂载在组件Fiber结点上memoizedState的

//hook的结构

export type Hook = {

memoizedState: any, //上一次的state

baseState: any, //当前state

baseUpdate: Update<any, any> | null, // update func

queue: UpdateQueue<any, any> | null, //用于缓存多次action

next: Hook | null, //链表

};renderWithHooks

在reconciler中处理函数式组件的函数是renderWithHooks,其类型是:

renderWithHooks(

current: Fiber | null, //当前的fiber结点

workInProgress: Fiber,

Component: any, //jsx中用<>调用的函数

props: any,

refOrContext: any,

nextRenderExpirationTime: ExpirationTime, //需要在什么时候结束

): any在renderWithHooks,核心流程如下:

//从memoizedState中取出hooks

nextCurrentHook = current !== null ? current.memoizedState : null;

//判断通过有没有hooks判断是mount还是update,两者的函数不同

ReactCurrentDispatcher.current =

nextCurrentHook === null

? HooksDispatcherOnMount

: HooksDispatcherOnUpdate;

//执行传入的type函数

let children = Component(props, refOrContext);

//执行完函数后的dispatcher变成只能调用context的

ReactCurrentDispatcher.current = ContextOnlyDispatcher;

return children;useState构建时流程

mountState

在HooksDispatcherOnMount中,useState调用的是下面的mountState,作用是创建一个新的hook并使用默认值初始化并绑定其触发器,因为useState底层是useReducer,所以数组第二个值返回的是dispatch。

type BasicStateAction<S> = (S => S) | S;

function mountState<S>(

initialState: (() => S) | S,

){

const hook = mountWorkInProgressHook();

//如果入参是func则会调用,但是不提供参数,带参数的需要包一层

if (typeof initialState === 'function') {

initialState = initialState();

}

//上一个state和基本(当前)state都初始化

hook.memoizedState = hook.baseState = initialState;

const queue = (hook.queue = {

last: null,

dispatch: null,

eagerReducer: basicStateReducer, // useState使用基础reducer

eagerState: (initialState: any),

});

//返回触发器

const dispatch: Dispatch<

//useState底层是useReducer,所以type是BasicStateAction

(queue.dispatch = (dispatchAction.bind(

null,

//绑定当前fiber结点和queue

((currentlyRenderingFiber: any): Fiber),

queue,

): any));

return [hook.memoizedState, dispatch];

}mountWorkInProgressHook

这个函数是mountState时调用的构建hook的方法,在初始化完毕后会连接到当前hook.next(如果有的话)

function mountWorkInProgressHook(): Hook {

const hook: Hook = {

memoizedState: null,

baseState: null,

queue: null,

baseUpdate: null,

next: null,

};

if (workInProgressHook === null) {

// 列表中的第一个hook

firstWorkInProgressHook = workInProgressHook = hook;

} else {

// 添加到列表的末尾

workInProgressHook = workInProgressHook.next = hook;

}

return workInProgressHook;

}dispatch分发函数

在上面我们提到,useState底层是useReducer,所以返回的第二个参数是dispatch函数,其中的设计十分巧妙。

假设我们有以下代码:

相关参考视频讲解:进入学习

const [data, setData] = React.useState(0)

setData('first')

setData('second')

setData('third')在第一次setData后, hooks的结构如上图

在第二次setData后, hooks的结构如上图

在第三次setData后, hooks的结构如上图

在正常情况下,是不会在dispatcher中触发reducer而是将action存入update中在updateState中再执行,但是如果在react没有重渲染需求的前提下是会提前计算state即eagerState。作为性能优化的一环。

function dispatchAction<S, A>(

fiber: Fiber,

queue: UpdateQueue<S, A>,

action: A,

) {

const alternate = fiber.alternate;

{

flushPassiveEffects();

//获取当前时间并计算可用时间

const currentTime = requestCurrentTime();

const expirationTime = computeExpirationForFiber(currentTime, fiber);

const update: Update<S, A> = {

expirationTime,

action,

eagerReducer: null,

eagerState: null,

next: null,

};

//下面的代码就是为了构建queue.last是最新的更新,然后last.next开始是每一次的action

// 取出last

const last = queue.last;

if (last === null) {

// 自圆

update.next = update;

} else {

const first = last.next;

if (first !== null) {

update.next = first;

}

last.next = update;

}

queue.last = update;

if (

fiber.expirationTime === NoWork &&

(alternate === null || alternate.expirationTime === NoWork)

) {

// 当前队列为空,我们可以在进入render阶段前提前计算出下一个状态。如果新的状态和当前状态相同,则可以退出重渲染

const lastRenderedReducer = queue.lastRenderedReducer; // 上次更新完后的reducer

if (lastRenderedReducer !== null) {

let prevDispatcher;

if (__DEV__) {

prevDispatcher = ReactCurrentDispatcher.current; // 暂存dispatcher

ReactCurrentDispatcher.current = InvalidNestedHooksDispatcherOnUpdateInDEV;

}

try {

const currentState: S = (queue.lastRenderedState: any);

// 计算下次state

const eagerState = lastRenderedReducer(currentState, action);

// 在update对象中存储预计算的完整状态和reducer,如果在进入render阶段前reducer没有变化那么可以服用eagerState而不用重新再次调用reducer

update.eagerReducer = lastRenderedReducer;

update.eagerState = eagerState;

if (is(eagerState, currentState)) {

// 在后续的时间中,如果这个组件因别的原因被重渲染且在那时reducer更变后,仍有可能重建这次更新

return;

}

} catch (error) {

// Suppress the error. It will throw again in the render phase.

} finally {

if (__DEV__) {

ReactCurrentDispatcher.current = prevDispatcher;

}

}

}

}

scheduleWork(fiber, expirationTime);

}

}useState更新时流程

updateReducer

因为useState底层是useReducer,所以在更新时的流程(即重渲染组件后)是调用updateReducer的。

function updateState<S>(

initialState: (() => S) | S,

): [S, Dispatch<BasicStateAction<S>>] {

return updateReducer(basicStateReducer, (initialState: any));

}所以其reducer十分简单

function basicStateReducer<S>(state: S, action: BasicStateAction<S>): S {

return typeof action === 'function' ? action(state) : action;

}我们先把复杂情况抛开,跑通updateReducer流程

function updateReducer(

reducer: (S, A) => S,

initialArg: I,

init?: I => S,

){

// 获取当前hook,queue

const hook = updateWorkInProgressHook();

const queue = hook.queue;

queue.lastRenderedReducer = reducer;

// action队列的最后一个更新

const last = queue.last;

// 最后一个更新是基本状态

const baseUpdate = hook.baseUpdate;

const baseState = hook.baseState;

// 找到第一个没处理的更新

let first;

if (baseUpdate !== null) {

if (last !== null) {

// 第一次更新时,队列是一个自圆queue.last.next = queue.first。当第一次update提交后,baseUpdate不再为空即可跳出队列

last.next = null;

}

first = baseUpdate.next;

} else {

first = last !== null ? last.next : null;

}

if (first !== null) {

let newState = baseState;

let newBaseState = null;

let newBaseUpdate = null;

let prevUpdate = baseUpdate;

let update = first;

let didSkip = false;

do {

const updateExpirationTime = update.expirationTime;

if (updateExpirationTime < renderExpirationTime) {

// 优先级不足,跳过这次更新,如果这是第一次跳过更新,上一个update/state是newBaseupdate/state

if (!didSkip) {

didSkip = true;

newBaseUpdate = prevUpdate;

newBaseState = newState;

}

// 更新优先级

if (updateExpirationTime > remainingExpirationTime) {

remainingExpirationTime = updateExpirationTime;

}

} else {

// 处理更新

if (update.eagerReducer === reducer) {

// 如果更新被提前处理了且reducer跟当前reducer匹配,可以复用eagerState

newState = ((update.eagerState: any): S);

} else {

// 循环调用reducer

const action = update.action;

newState = reducer(newState, action);

}

}

prevUpdate = update;

update = update.next;

} while (update !== null && update !== first);

• if (!didSkip) {

• newBaseUpdate = prevUpdate;

• newBaseState = newState;

• }

• // 只有在前后state变了才会标记

• if (!is(newState, hook.memoizedState)) {

• markWorkInProgressReceivedUpdate();

• }

• hook.memoizedState = newState;

• hook.baseUpdate = newBaseUpdate;

• hook.baseState = newBaseState;

queue.lastRenderedState = newState;

}

const dispatch: Dispatch<A> = (queue.dispatch: any);

return [hook.memoizedState, dispatch];

}

export function markWorkInProgressReceivedUpdate() {

didReceiveUpdate = true;

}

后记

作为系列的第一篇文章,我选择了最常用的hooks开始,抛开提前计算及与react-reconciler的互动,整个流程是十分清晰易懂的。mount的时候构建钩子,触发dispatch时按序插入update。updateState的时候再按序触发reducer。可以说就是一个简单的redux。

作者:flyzz177

来源:juejin.cn/post/7184636589564231735

徒手撸一个注解框架

运行时注解主要是通过反射来实现的,而编译时注解则是在编译期间帮助我们生成代码,所以编译时注解效率高,但是实现起来复杂一点,运行时注解效率较低,但是实现起来简单。 首先来看下运行时注解怎么实现的吧。

1.运行时注解

1.1定义注解

首先定义两个运行时注解,其中Retention标明此注解在运行时生效,Target标明此注解的程序元范围,下面两个示例RuntimeBindView用于描述成员变量和类,成员变量绑定view,类绑定layout;RuntimeBindClick用于描述方法,让指定的view绑定click事件。

@Retention(RetentionPolicy.RUNTIME)//运行时生效

@Target({ElementType.FIELD,ElementType.TYPE})//描述变量和类

public @interface RuntimeBindView {

int value() default View.NO_ID;

}

@Retention(RetentionPolicy.RUNTIME)//运行时生效

@Target(ElementType.METHOD)//描述方法

public @interface RuntimeBindClick {

int[] value();

}1.2反射实现

以下代码是用反射实现的注解功能,其中ClassInfo是一个能解析处类的各种成员和方法的工具类, 源码见github.com/huangbei199… 其实逻辑很简单,就是从Activity里面取出指定的注解,然后再调用相应的方法,如取出RuntimeBindView描述类的注解,然后得到这个注解的返回值,接着调用activity的setContentView将layout的id设置进去就可以了。

public static void bindId(Activity obj){

ClassInfo clsInfo = new ClassInfo(obj.getClass());

//处理类

if(obj.getClass().isAnnotationPresent(RuntimeBindView.class)) {

RuntimeBindView bindView = (RuntimeBindView)clsInfo.getClassAnnotation(RuntimeBindView.class);

int id = bindView.value();

clsInfo.executeMethod(clsInfo.getMethod("setContentView",int.class),obj,id);

}

//处理类成员

for(Field field : clsInfo.getFields()){

if(field.isAnnotationPresent(RuntimeBindView.class)){

RuntimeBindView bindView = field.getAnnotation(RuntimeBindView.class);

int id = bindView.value();

Object view = clsInfo.executeMethod(clsInfo.getMethod("findViewById",int.class),obj,id);

clsInfo.setField(field,obj,view);

}

}

//处理点击事件

for (Method method : clsInfo.getMethods()) {

if (method.isAnnotationPresent(RuntimeBindClick.class)) {

int[] values = method.getAnnotation(RuntimeBindClick.class).value();

for (int id : values) {

View view = (View) clsInfo.executeMethod(clsInfo.getMethod("findViewById", int.class), obj, id);

view.setOnClickListener(v -> {

try {

method.invoke(obj, v);

} catch (Exception e) {

e.printStackTrace();

}

});

}

}

}

}1.3使用

如下所示,将我们定义好的注解写到相应的位置,然后调用BindApi的bind函数,就可以了。很简单吧

@RuntimeBindView(R.layout.first)//类

public class MainActivity extends AppCompatActivity {

@RuntimeBindView(R.id.jump)//成员

public Button jump;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

BindApi.bindId(this);//调用反射

}

@RuntimeBindClick({R.id.jump,R.id.jump2})//方法

public void onClick(View view){

Intent intent = new Intent(this,SecondActivity.class);

startActivity(intent);

}

}2.编译时注解

编译时注解就是在编译期间帮你自动生成代码,其实原理也不难。

2.1定义注解

我们可以看到,编译时注解定义的时候Retention的值和运行时注解不同。

@Retention(RetentionPolicy.CLASS)//编译时生效

@Target({ElementType.FIELD,ElementType.TYPE})//描述变量和类

public @interface CompilerBindView {

int value() default -1;

}

@Retention(RetentionPolicy.CLASS)//编译时生效

@Target(ElementType.METHOD)//描述方法

public @interface CompilerBindClick {

int[] value();

}2.2根据注解生成代码

1)准备工作

首先我们要新建一个java的lib库,因为接下需要继承AbstractProcessor类,这个类Android里面没有。

然后我们需要引入两个包,javapoet是帮助我们生成代码的包,auto-service是帮助我们自动生成META-INF等信息,这样我们编译的时候就可以执行我们自定义的processor了。

apply plugin: 'java-library'

dependencies {

implementation fileTree(dir: 'libs', include: ['*.jar'])

api 'com.squareup:javapoet:1.9.0'

api 'com.google.auto.service:auto-service:1.0-rc2'

}

sourceCompatibility = "1.8"

targetCompatibility = "1.8"2)继承AbstractProcessor

如下所示,我们需要自定义一个类继承子AbstractProcessor并复写他的方法,并加上AutoService的注解。 ClassElementsInfo是用来存储类信息的类,这一步先暂时不用管,下一步会详细说明。 其实从函数的名称就可以看出是什么意思,init初始化,getSupportedSourceVersion限定所支持的jdk版本,getSupportedAnnotationTypes需要处理的注解,process我们可以在这个函数里面拿到拥有我们需要处理注解的类,并生成相应的代码。

3)搜集注解

首先我们看下ClassElementsInfo这个类,也就是我们需要搜集的信息。 TypeElement为类元素,VariableElement为成员元素,ExecutableElement为方法元素,从中我们可以获取到各种注解信息。 classSuffix为前缀,例如原始类为MainActivity,注解生成的类名就为MainActivity+classSuffix

public class ClassElementsInfo {

//类

public TypeElement mTypeElement;

public int value;

public String packageName;

//成员,key为id

public Map<Integer,VariableElement> mVariableElements = new HashMap<>();

//方法,key为id

public Map<Integer,ExecutableElement> mExecutableElements = new HashMap<>();

//后缀

public static final String classSuffix = "proxy";

public String getProxyClassFullName() {

return mTypeElement.getQualifiedName().toString() + classSuffix;

}

public String getClassName() {

return mTypeElement.getSimpleName().toString() + classSuffix;

}

......

}然后我们就可以开始搜集注解信息了, 如下所示,按照注解类型一个一个的搜集,可以通过roundEnvironment.getElementsAnnotatedWith函数拿到注解元素,拿到之后再根据注解元素的类型分别填充到ClassElementsInfo当中。 其中ClassElementsInfo是存储在Map当中,key是String是classPath。

private void collection(RoundEnvironment roundEnvironment){

//1.搜集compileBindView注解

Set<? extends Element> set = roundEnvironment.getElementsAnnotatedWith(CompilerBindView.class);

for(Element element : set){

//1.1搜集类的注解

if(element.getKind() == ElementKind.CLASS){

TypeElement typeElement = (TypeElement)element;

String classPath = typeElement.getQualifiedName().toString();

String className = typeElement.getSimpleName().toString();

String packageName = mElementUtils.getPackageOf(typeElement).getQualifiedName().toString();

CompilerBindView bindView = element.getAnnotation(CompilerBindView.class);

if(bindView != null){

ClassElementsInfo info = classElementsInfoMap.get(classPath);

if(info == null){

info = new ClassElementsInfo();

classElementsInfoMap.put(classPath,info);

}

info.packageName = packageName;

info.value = bindView.value();

info.mTypeElement = typeElement;

}

}

//1.2搜集成员的注解

else if(element.getKind() == ElementKind.FIELD){

VariableElement variableElement = (VariableElement) element;

String classPath = ((TypeElement)element.getEnclosingElement()).getQualifiedName().toString();

CompilerBindView bindView = variableElement.getAnnotation(CompilerBindView.class);

if(bindView != null){

ClassElementsInfo info = classElementsInfoMap.get(classPath);

if(info == null){

info = new ClassElementsInfo();

classElementsInfoMap.put(classPath,info);

}

info.mVariableElements.put(bindView.value(),variableElement);

}

}

}

//2.搜集compileBindClick注解

Set<? extends Element> set1 = roundEnvironment.getElementsAnnotatedWith(CompilerBindClick.class);

for(Element element : set1){

if(element.getKind() == ElementKind.METHOD){

ExecutableElement executableElement = (ExecutableElement) element;

String classPath = ((TypeElement)element.getEnclosingElement()).getQualifiedName().toString();

CompilerBindClick bindClick = executableElement.getAnnotation(CompilerBindClick.class);

if(bindClick != null){

ClassElementsInfo info = classElementsInfoMap.get(classPath);

if(info == null){

info = new ClassElementsInfo();

classElementsInfoMap.put(classPath,info);

}

int[] values = bindClick.value();

for(int value : values) {

info.mExecutableElements.put(value,executableElement);

}

}

}

}

}4)生成代码

如下所示使用javapoet生成代码,使用起来并不复杂。

public class ClassElementsInfo {

......

public String generateJavaCode() {

ClassName viewClass = ClassName.get("android.view","View");

ClassName clickClass = ClassName.get("android.view","View.OnClickListener");

ClassName keepClass = ClassName.get("android.support.annotation","Keep");

ClassName typeClass = ClassName.get(mTypeElement.getQualifiedName().toString().replace("."+mTypeElement.getSimpleName().toString(),""),mTypeElement.getSimpleName().toString());

//构造方法

MethodSpec.Builder builder = MethodSpec.constructorBuilder()

.addModifiers(Modifier.PUBLIC)

.addParameter(typeClass,"host",Modifier.FINAL);

if(value > 0){

builder.addStatement("host.setContentView($L)",value);

}

//成员

Iterator<Map.Entry<Integer,VariableElement>> iterator = mVariableElements.entrySet().iterator();

while(iterator.hasNext()){

Map.Entry<Integer,VariableElement> entry = iterator.next();

Integer key = entry.getKey();

VariableElement value = entry.getValue();

String name = value.getSimpleName().toString();

String type = value.asType().toString();

builder.addStatement("host.$L=($L)host.findViewById($L)",name,type,key);

}

//方法

Iterator<Map.Entry<Integer,ExecutableElement>> iterator1 = mExecutableElements.entrySet().iterator();

while(iterator1.hasNext()){

Map.Entry<Integer,ExecutableElement> entry = iterator1.next();

Integer key = entry.getKey();

ExecutableElement value = entry.getValue();

String name = value.getSimpleName().toString();

MethodSpec onClick = MethodSpec.methodBuilder("onClick")

.addAnnotation(Override.class)

.addModifiers(Modifier.PUBLIC)

.addParameter(viewClass,"view")

.addStatement("host.$L(host.findViewById($L))",value.getSimpleName().toString(),key)

.returns(void.class)

.build();

//构造匿名内部类

TypeSpec clickListener = TypeSpec.anonymousClassBuilder("")

.addSuperinterface(clickClass)

.addMethod(onClick)

.build();

builder.addStatement("host.findViewById($L).setOnClickListener($L)",key,clickListener);

}

TypeSpec typeSpec = TypeSpec.classBuilder(getClassName())

.addModifiers(Modifier.PUBLIC)

.addAnnotation(keepClass)

.addMethod(builder.build())

.build();

JavaFile javaFile = JavaFile.builder(packageName,typeSpec).build();

return javaFile.toString();

}

}最终使用了注解之后生成的代码如下

package com.android.hdemo;

import android.support.annotation.Keep;

import android.view.View;

import android.view.View.OnClickListener;

import java.lang.Override;

@Keep

public class MainActivityproxy {

public MainActivityproxy(final MainActivity host) {

host.setContentView(2131296284);

host.jump=(android.widget.Button)host.findViewById(2131165257);

host.findViewById(2131165258).setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View view) {

host.onClick(host.findViewById(2131165258));

}

});

host.findViewById(2131165257).setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View view) {

host.onClick(host.findViewById(2131165257));

}

});

}

}5)让注解生效

我们生成了代码之后,还需要让原始的类去调用我们生成的代码

public class BindHelper {

static final Map<Class<?>,Constructor<?>> Bindings = new HashMap<>();

public static void inject(Activity activity){

String classFullName = activity.getClass().getName() + ClassElementsInfo.classSuffix;

try{

Constructor constructor = Bindings.get(activity.getClass());

if(constructor == null){

Class proxy = Class.forName(classFullName);

constructor = proxy.getDeclaredConstructor(activity.getClass());

Bindings.put(activity.getClass(),constructor);

}

constructor.setAccessible(true);

constructor.newInstance(activity);

}catch (Exception e){

e.printStackTrace();

}

}

}2.3调试

首先在gradle.properties里面加入如下的代码

android.enableSeparateAnnotationProcessing = true

org.gradle.daemon=true

org.gradle.jvmargs=-agentlib:jdwp=transport=dt_socket,server=y,suspend=n,address=8888然后点击Edit Configurations

新建一个remote

然后填写相关的参数,127.0.0.1表示本机,port与刚才gradle.properties里面填写的保持一致,然后点击ok

然后将Select Run/Debug Configuration选项调整到刚才新建的Configuration上,然后点击Build--Rebuild Project,就可以开始调试了。

2.4使用

如下所示为原始的类

@CompilerBindView(R.layout.first)

public class MainActivity extends AppCompatActivity {

@CompilerBindView(R.id.jump)

public Button jump;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

BindHelper.inject(this);

}

@CompilerBindClick({R.id.jump,R.id.jump2})

public void onClick(View view){

Intent intent = new Intent(this,SecondActivity.class);

startActivity(intent);

}

}以下为生成的类

package com.android.hdemo;

import android.support.annotation.Keep;

import android.view.View;

import android.view.View.OnClickListener;

import java.lang.Override;

@Keep

public class MainActivityproxy {

public MainActivityproxy(final MainActivity host) {

host.setContentView(2131296284);

host.jump=(android.widget.Button)host.findViewById(2131165257);

host.findViewById(2131165258).setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View view) {

host.onClick(host.findViewById(2131165258));

}

});

host.findViewById(2131165257).setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View view) {

host.onClick(host.findViewById(2131165257));

}

});

}

}3.总结

注解框架看起来很高大上,其实弄懂之后也不难,都是一个套路。

作者:我是黄大仙

来源:juejin.cn/post/7180166142093656120

这可能是中国最“恨”地铁的高校,甚至写了篇论文反对地铁经过

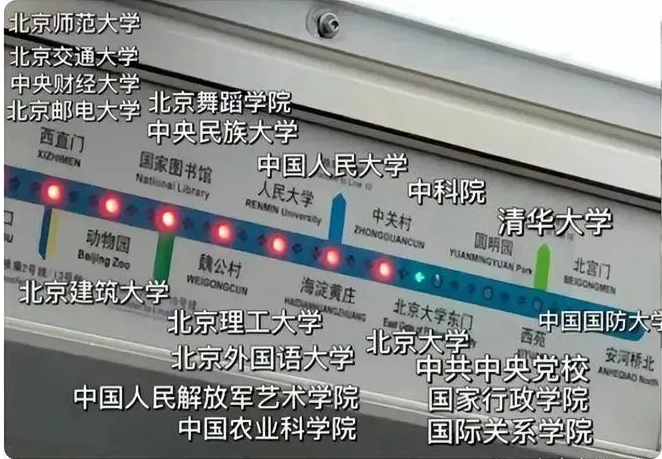

常坐北京地铁4号线的人可能听过这样一句调侃 “坐4号线的学生谁先下车谁就输了,坚持到最后的都是学霸中的学霸。”

因为这一路会经过十多所高校,全都是名校。

虽然是个玩笑话,但很多地方的地铁都喜爱用高校名做站名。

比如2022年11月28日,深圳地铁6号线支线正式通车,其中,“深理工站”就以正在筹建的深圳理工大学来作为站名。

另一方面,大多数的高校也会有意的去争夺地铁站,一方面是方便学生出行,另一方面,地铁站命名也是一次对学校的宣传。

甚至在2021年,西安还曾发生过两高校掐架“争夺”地铁站命名的事,当时,西安地铁官网发布了14号线相关站点初步命名信息。

其中在西安北郊大学城的一站,暂被命名为“西安工业大学”。此站距离西安工业大学正门,陕西科技大学南门都非常近,仅200米左右。

这立刻引起了陕西科技大学的强烈不满。为了争取命名权,陕西科技大学先后两次和西安工业大学的校领导进行了沟通,并提出一些条件。

因为两所高校谈崩了,陕西科技大学要求旗下幼儿园方3月24日起不再接受西安工业大学子女入托。

最后,在被媒体和舆论痛批后,两所高校握手言和,解决了幼儿园不让孩子入园事件,同时,西安地铁14号线也更改了地铁站名,修改为 “西安工大·武德路站”

虽然只是一件小事,但高校间争夺地铁站命名确实不是第一次,有时候,地铁方面也会一碗水端平,把大家的校名都列上去。

比如 西工程大●西科大(临潼校区)站、

南医大●江苏经贸学院站 等。

但凡事都有例外,也有那么一些学校为了让地铁“远离”自己,还有学者专门写了论文来论证理由。

这可能真是中国最“恨”地铁的一所高校。

1 地铁和北大那些事

2018年,北京地铁4号线列车在13.5米深的地下呼啸而过,100米外北京大学信息科学技术学院大楼中,一台电子显微镜内“仿佛刮起了一阵飓风”。

用肉眼看,这台1米多高的白色金属镜筒安稳立在桌上。将它调至最高精度却会发现,显示屏上的黑白图像长了“毛刺”,原本纤毫毕现的原子图案因为振动变得模糊不清。

在北大校园内,因地铁运行受到影响的精密仪器,远不止这台价值数百万元的电镜。4号线开通时,北大有价值11亿元的精密仪器,其中4亿元的仪器受到影响。

地图上与地铁线路相邻的北京大学校园

原因很简单——交通微振动。**虽然这种振动几乎不易察觉,但对高校内的精密仪器来说,地铁几乎意味着“灾难性打击”。**

北大环境振动监测与评估实验室主任雷军,曾和学生拎着地震仪,测量过北京多条地铁线路,他们发现,在精密仪器更敏感的低频范围内,离地铁100米内地表振动强度比没有列车通过时高了30~100倍。

许多仪器的使用者并不知晓地铁振动会影响仪器。曾有同事找到雷军,抱怨实验室一台测量岩石年龄的精密仪器突然不正常了。这位老师叫来厂家,左调右调,愣是修不好,厂家也摸不着头脑。

事实上,并非仪器坏了,而是地铁4号线开通后,振动干扰了仪器。

实际上,当年在地铁4号线线路规划出来后,北大就曾和地铁公司为两个方案反复争论。

● 北大拒绝4号线地铁经过,想让地铁改线。

● 地铁公司表示,北大也可以整个搬走。

直至最后一次研讨会,双方仍僵持不下。那次会议由北京市一位副市长主持,邀请了一位院士和多位北大校外专家。

最后大家采取了一个折中方案,4号线经过北大的789米轨道段,将采用世界上最先进的轨道减振技术,也就是在钢轨下铺设钢弹簧浮置板。这种浮置板由一家德国公司发明,上面是约50厘米厚的钢筋混凝土板,下面是支撑着的钢弹簧,能将列车的振动与道床隔离。

最后北大做了妥协,这才有了后来的【北京大学东门站】。

图片来源:北京大学新闻中心

不过,4号线真的开通后,北大学者发现虽然轨道减振有用,但也不算完全有用,很多精密仪器还是会受到干扰。

最后,北大自己一合计,决定在受地铁振动影响最小的西南边的校医院旧址那盖综合科研楼,将部分受影响的仪器搬过来。在此之前,很多科研人为了能正常做实验,只能选择在地铁停运的深夜开始运行精密仪器。

谁知道一波未平一波又起,北大综合科研楼地基刚打好,正在施工时,北京地铁16号线的规划出来了,好家伙,地铁16号线将绕经北大西门,离综合科研楼仅200米。

这一次可把北大气坏了,由于校内精密仪器已无处可挪,北大开始了强烈抗议。

后面才知道,因为地铁4号线的成功,地铁方面以为减振成功了,北大也没有把自己准备盖科研楼挪仪器的事告诉地铁方,这才有了擦着北大西边而过的地铁16号线规划。

这一次,北大再次重拳出击,首先论文论证是不能少的。

北京市为此还拨出上千万元专项资金,让大家拿出一个合理的解决方案,包括地铁轨道减振、重新设计综合科研楼,考虑在低层装减振平台等等。

最后,双方谁也不愿意退让的时候,项目戛然而止。据说北大领导和一位市领导在某个会议碰面,双方握手言好。地铁16号退后一步,往西绕开300多米,甩掉两座车站,北大也不再提要求。

就这样,这场北大和地铁的交锋,双方鸣鼓收兵。

2 高校与地铁的对抗

不过,高校和地铁的对抗,北大也绝不是个例。

与北大相似的还有清华,但是在拒绝这件事上,清华更强硬了一点。

早在1955年,清华大学就曾让铁路改过线。那时候,京张铁路位于清华校园同侧,振动曾严重干扰科研,在清华的争取下,铁路线向东迁了800米。

后面,地铁15号线原计划下穿清华大学,遭清华极力反对。最终,15号线只进入清华校内120米,没与4号线相连,形成换乘站。

受地铁影响的高校还有复旦大学、南京大学、中国科学院、首都医科大学、郑州大学医学院等。

不过并不是所有的高校都拥有强大的谈判能力。要知道,一个地铁线路方案如果已落成,再挪动位置几乎是不可能的。

因此,有的985高校没太多考虑,直接在同意文件上盖了章。有的高校遭遇了损失,却不愿意公开化。

中国电子工程设计院有限公司曾表示,给复旦大学、南京大学等多个受地铁影响的高校做过减振方案。

没想到一个小小的振动,也能引起如此大的漩涡,这可能就是“地铁蝴蝶效应”吧~

本文选自募格学术。参考资料:人民资讯、中科院深圳理工大学、潇湘晨报、人民日报等。

收起阅读 »Android 字节码插桩全流程解析

1 准备工作

但凡涉及到gradle开发,我一般都是会在buildSrc文件夹下进行,还有没有伙伴不太了解buildSrc的,其实buildSrc是Android中默认的插件工程,在gradle编译的时候,会编译这个项目并配置到classpath下。这样的话在buildSrc中创建的插件,每个项目都可以引入。

在buildSrc中可以创建groovy目录(如果对groovy或者kotlin了解),也可以创建java目录,对于插件开发个人更便向使用groovy,因为更贴近gradle。

1.1 创建插件

创建插件,需要实现Plugin接口,在引入这个插件后,项目编译的时候,就会执行apply方法。

class ASMPlugin implements Plugin<Project>{

@Override

void apply(Project project) {

def ext = project.extensions.getByType(AppExtension)

if (ext != null){

ext.registerTransform(new ASMTransform())

}

}

}在apply方法中,可以执行自定义的Task,也可以执行自定义的Transform(其实也可以看做是一种特殊的Task),这里我们自定义了插桩相关的Transform。

1.2 创建Transform

什么是Transform呢?就是在class文件打包生成dex文件的过程中,对class字节码做处理,最终生成新的dex文件,那么有什么方式能够对字节码操作呢?ASM是一种方式,使用Javassist也可以织入字节码。

class ASMTransform extends Transform {

@Override

String getName() {

return "ASMTransform"

}

@Override

Set<QualifiedContent.ContentType> getInputTypes() {

return TransformManager.CONTENT_CLASS

}

@Override

Set<QualifiedContent.Scope> getScopes() {

return TransformManager.SCOPE_FULL_PROJECT

}

@Override

boolean isIncremental() {

return false

}

@Override

void transform(Context context, Collection<TransformInput> inputs, Collection<TransformInput> referencedInputs, TransformOutputProvider outputProvider, boolean isIncremental) throws IOException, TransformException, InterruptedException {

inputs.each { input ->

input.directoryInputs.each { dic ->

/**这里会拿到两个路径,分别是java代码编译后的javac/debug/classes,以及kotlin代码编译后的 tmp/kotlin-classes/debug */

println("dic path == >${dic.file.path}")

/**所有的class文件的根路径,我们已经拿到了,接下来就是分析这些文件夹下的class文件*/

findAllClass(dic.file)

/**这里一定不能忘记写*/

def dest = outputProvider.getContentLocation(dic.name, dic.contentTypes, dic.scopes, Format.DIRECTORY)

FileUtils.copyDirectory(dic.file, dest)

}

input.jarInputs.each { jar ->

/**这里也一定不能忘记写*/

def dest = outputProvider.getContentLocation(jar.name,jar.contentTypes,jar.scopes,Format.JAR)

FileUtils.copyFile(jar.file,dest)

}

}

}

/**

* 查找class文件

* @param file 可能是文件也可能是文件夹

*/

private void findAllClass(File file) {

if (file.isDirectory()) {

file.listFiles().each {

findAllClass(it)

}

} else {

modifyClass(file)

}

}

/**

* 进行字节码插桩

* @param file 需要插桩的字节码文件

*/

private void modifyClass(File file) {

println("最终的class文件 ==> ${file.absolutePath}")

/**如果不是.class文件,抛弃*/

if (!file.absolutePath.endsWith(".class")) {

return

}

/**BuildConfig.class文件以及R文件都抛弃*/

if (file.absolutePath.contains("BuildConfig.class") || file.absolutePath.contains("R")) {

return

}

doASM(file)

}

/**

* 进行ASM字节码插桩

* @param file 需要插桩的class文件

*/

private void doASM(File file) {

def fis = new FileInputStream(file)

def cr = new ClassReader(fis)

def cw = new ClassWriter(ClassWriter.COMPUTE_MAXS)

cr.accept(new ASMClassVisitor(Opcodes.ASM9, cw), ClassReader.SKIP_FRAMES | ClassReader.SKIP_DEBUG)

/**重新覆盖*/

def bytes = cw.toByteArray()

def fos = new java.io.FileOutputStream(file.absolutePath)

fos.write(bytes)

fos.flush()

fos.close()

}

}如果想要使用Transform,那么需要引入transform-api,其实在transform 1.5之后gradle就支持Transform了。

implementation 'com.android.tools.build:transform-api:1.5.0'

当执行Transform任务的时候,最终会执行到transform方法,在这个方法中可以获取TransformInput的输入,主要包括两种:文件夹和Jar包;对于Jar包,我们不需要处理,只需要拷贝到目标文件夹下即可。

对于文件夹我们是需要处理的,因为这里包含了我们要处理的.class文件,对于Java编译后的class文件是存在javac/debug/classes根文件夹下,对于kotlin编译后的class文件是存在temp/classes根文件下。

所以在整个编译的过程中,只要是.class文件都会执行doASM这个方法,在这个方法中就是我们在上节提到的对于字节码的插桩。

1.3 ASM字节码插桩

class ASMClassVisitor extends ClassVisitor {

ASMClassVisitor(int api) {

super(api)

}

@Override

MethodVisitor visitMethod(int access, String name, String descriptor, String signature, String[] exceptions) {

println("visitMethod==>$name")

/**所有的方法都会在ASMMethodVisitor中插入字节码*/

def method = super.visitMethod(access, name, descriptor, signature, exceptions)

return new ASMMethodVisitor(api, method, access, name, descriptor)

}

ASMClassVisitor(int api, ClassVisitor classVisitor) {

super(api, classVisitor)

}

@Override

FieldVisitor visitField(int access, String name, String descriptor, String signature, Object value) {

return super.visitField(access, name, descriptor, signature, value)

}

@Override

AnnotationVisitor visitAnnotation(String descriptor, boolean visible) {

return super.visitAnnotation(descriptor, visible)

}

}class ASMMethodVisitor extends AdviceAdapter {

private def methodName

/**

* Constructs a new {@link AdviceAdapter}.

*

* @param api the ASM API version implemented by this visitor. Must be one of {@link

* Opcodes#ASM4}, {@link Opcodes#ASM5}, {@link Opcodes#ASM6} or {@link Opcodes#ASM7}.

* @param methodVisitor the method visitor to which this adapter delegates calls.

* @param access the method's access flags (see {@link Opcodes}).

* @param name the method's name.

* @param descriptor the method's descriptor (see {@link Type Type}).

*/

protected ASMMethodVisitor(int api, MethodVisitor methodVisitor, int access, String name, String descriptor) {

super(api, methodVisitor, access, name, descriptor)

this.methodName = name

}

@Override

protected void onMethodEnter() {

super.onMethodEnter()

visitFieldInsn(GETSTATIC,

"com/lay/learn/base_net/LoggUtils",

"INSTANCE",

"Lcom/lay/learn/base_net/LoggUtils;")

visitMethodInsn(INVOKEVIRTUAL, "com/lay/learn/base_net/LoggUtils", "start", "()V", false)

}

@Override

protected void onMethodExit(int opcode) {

super.onMethodExit(opcode)

visitFieldInsn(GETSTATIC,

"com/lay/learn/base_net/LoggUtils",

"INSTANCE",

"Lcom/lay/learn/base_net/LoggUtils;")

visitLdcInsn(methodName)

visitMethodInsn(INVOKEVIRTUAL, "com/lay/learn/base_net/LoggUtils", "end", "(Ljava/lang/String;)V",false)

}

}这里就不再细说了,贴上源码大家可以借鉴一下哈。

最终在编译的过程中,对所有的方法插入了我们自己的耗时计算逻辑,当运行之后

class MainActivity : AppCompatActivity() {

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

setContentView(R.layout.activity_main)

}

}虽然我们没有显示地在MainActivity的onCreate中插入耗时检测代码,但是在控制台中我们可以看到,onCreate方法耗时180ms

2022-12-28 19:50:19.243 13665-13665/com.lay.learn.asm E/LoggUtils: <init> 耗时==>0

2022-12-28 19:50:19.458 13665-13665/com.lay.learn.asm E/LoggUtils: onCreate 耗时==>180

1.4 插件配置

当我们完成一个插件之后,需要在META-INF文件夹下创建一个gradle-plugins文件夹,并在properties文件中声明插件全类名。

implementation-class=com.lay.asm.ASMPlugin

要注意插件id就是properties文件的名字。

这样只要某个工程中需要字节码插桩,只需要引入asm_plugin这个插件即可在编译的时候扫描整个工程。

plugins {

id 'com.android.application'

id 'org.jetbrains.kotlin.android'

id 'asm_plugin'

}附上buildSrc中的gradle配置文件

plugins{

id 'groovy'

}

repositories {

google()

mavenCentral()

}

dependencies {

implementation gradleApi()

implementation localGroovy()

implementation 'org.apache.commons:commons-io:1.3.2'

implementation "com.android.tools.build:gradle:7.0.3"

implementation 'com.android.tools.build:transform-api:1.5.0'

implementation 'org.ow2.asm:asm:9.1'

implementation 'org.ow2.asm:asm-util:9.1'

implementation 'org.ow2.asm:asm-commons:9.1'

}

java {

sourceCompatibility = JavaVersion.VERSION_1_8

targetCompatibility = JavaVersion.VERSION_1_8

}

最后需要说一点就是,在Transform任务执行时,一定要将文件夹或者jar包传递到下一级的Transform中,否则会导致apk打包时缺少文件导致apk无法运行。

链接:https://juejin.cn/post/7182178552207376421

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Kotlin 惰性集合操作-序列 Sequence

集合操作函数 和 序列

在了解 Kotlin 惰性集合之前,先看一下 Koltin 标准库中的一些集合操作函数。

定义一个数据模型 Person 和 Book 类:

data class Person(val name: String, val age: Int)

data class Book(val title: String, val authors: List<String>)

filter 和 map 操作:

val people = listOf<Person>(

Person("xiaowang", 30),

Person("xiaozhang", 32),

Person("xiaoli", 28)

)

//大于 30 岁的人的名字集合列表

people.filter { it.age >= 30 }.map(Person::name)

count 操作:

val people = listOf<Person>(

Person("xiaowang", 30),

Person("xiaozhang", 32),

Person("xiaoli", 28)

)

//小于 30 岁人的个数

people.count { it.age < 30 }

flatmap 操作:

val books = listOf<Book>(

Book("Java 语言程序设计", arrayListOf("xiaowang", "xiaozhang")),

Book("Kotlin 语言程序设计", arrayListOf("xiaoli", "xiaomao")),

)

// 所有书的名字集合列表

books.flatMap { it.authors }.toList()

在上面这些函数,每做一步操作,都会创建中间集合,也就是每一步的中间结果都被临时存储在一个临时集合中。

filter 函数源码:

public inline fun <T> Iterable<T>.filter(predicate: (T) -> Boolean): List<T> {

//创建一个新的集合列表

return filterTo(ArrayList<T>(), predicate)

}

public inline fun <T, C : MutableCollection<in T>> Iterable<T>.filterTo(destination: C, predicate: (T) -> Boolean): C {

for (element in this) if (predicate(element)) destination.add(element)

return destination

}map 函数源码:

public inline fun <T, R> Iterable<T>.map(transform: (T) -> R): List<R> {

//创建一个新的集合列表

return mapTo(ArrayList<R>(collectionSizeOrDefault(10)), transform)

}

public inline fun <T, R, C : MutableCollection<in R>> Iterable<T>.mapTo(destination: C, transform: (T) -> R): C {

for (item in this)

destination.add(transform(item))

return destination

}

如果被操作的元素过多,假设 people 或 books 超过 50个、100个,那么 函数链式调用 如:fliter{}.map{} 就会变得低效,且浪费内存。

Kotlin 为解决上面这种问题,提供了惰性集合操作 Sequence 接口。这个接口表示一个可以逐个列举的元素列表。Sequence 只提供了一个 方法, iterator,用来从序列中获取值。

public interface Sequence<out T> {

/**

* Returns an [Iterator] that returns the values from the sequence.

*

* Throws an exception if the sequence is constrained to be iterated once and `iterator` is invoked the second time.

*/

public operator fun iterator(): Iterator<T>

}

public inline fun <T> Sequence(crossinline iterator: () -> Iterator<T>): Sequence<T> = object : Sequence<T> {

override fun iterator(): Iterator<T> = iterator()

}

/**

* Creates a sequence that returns all elements from this iterator. The sequence is constrained to be iterated only once.

*

* @sample samples.collections.Sequences.Building.sequenceFromIterator

*/

public fun <T> Iterator<T>.asSequence(): Sequence<T> = Sequence { this }.constrainOnce()

序列中的元素求值是惰性的。因此,可以使用序列更高效地对集合元素执行链式操作,而不需要创建额外的集合来保存过程中产生的中间结果。关于这个惰性是怎么来的,后面再详细解释。

可以调用扩展函数 asSequence 把任意集合转换成序列,调用 toList 来做反向的转换。

val people = listOf<Person>(

Person("xiaowang", 30),

Person("xiaozhang", 32),

Person("xiaoli", 28)

)

people.asSequence().filter { it.age >= 30 }.map(Person::name).toList()

val books = listOf<Book>(

Book("Java 语言程序设计", arrayListOf("xiaowang", "xiaozhang")),

Book("Kotlin 语言程序设计", arrayListOf("xiaoli", "xiaomao")),

)

books.asSequence().flatMap { it.authors }.toList()

序列中间和末端操作

序列操作分为两类:中间的和末端的。一次中间操作返回的是另一个序列,这个新序列知道如何变换原始序列中的元素。而一次末端返回的是一个结果,这个结果可能是集合、元素、数字,或者其他从初始集合的变换序列中获取的任意对象。

中间操作始终是惰性的。

下面从例子来理解这个惰性:

listOf(1, 2, 3, 4).asSequence().map {

println("map${it}")

it * it

}.filter {

println("filter${it}")

it % 2 == 0

}上面这段代码在控制台不会输出任何内容(因为没有末端操作)。

listOf(1, 2, 3, 4).asSequence().map {

println("map${it}")

it * it

}.filter {

println("filter${it}")

it % 2 == 0

}.toList()

控制台输出:

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: map1

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: filter1

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: map2

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: filter4

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: map3

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: filter9

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: map4

2023-01-01 20:23:05.071 17000-17000/com.wangjiang.example D/TestSequence: filter16

在末端操作 .toList()的时候,map 和 filter 变换才被执行,而且元素是被逐个执行的。并不是所有元素经在 map 操作执行完成后,再执行 filter 操作。

为什么元素是逐个被执行,首先看下 toList() 方法:

public fun <T> Sequence<T>.toList(): List<T> {

return this.toMutableList().optimizeReadOnlyList()

}

public fun <T> Sequence<T>.toMutableList(): MutableList<T> {

return toCollection(ArrayList<T>())

}

public fun <T, C : MutableCollection<in T>> Sequence<T>.toCollection(destination: C): C {

for (item in this) {

destination.add(item)

}

return destination

}最后的 toCollection 方法中的 for (item in this),其实就是调用 Sequence 中的迭代器 Iterator 进行元素迭代。其中这个 this 来自于 filter,也就是使用 filter 的 Iterator 进行元素迭代。来看下 filter :

public fun <T> Sequence<T>.filter(predicate: (T) -> Boolean): Sequence<T> {

return FilteringSequence(this, true, predicate)

}

internal class FilteringSequence<T>(

private val sequence: Sequence<T>,

private val sendWhen: Boolean = true,

private val predicate: (T) -> Boolean

) : Sequence<T> {

override fun iterator(): Iterator<T> = object : Iterator<T> {

val iterator = sequence.iterator()

var nextState: Int = -1 // -1 for unknown, 0 for done, 1 for continue

var nextItem: T? = null

private fun calcNext() {

while (iterator.hasNext()) {

val item = iterator.next()

if (predicate(item) == sendWhen) {

nextItem = item

nextState = 1

return

}

}

nextState = 0

}

override fun next(): T {

if (nextState == -1)

calcNext()

if (nextState == 0)

throw NoSuchElementException()

val result = nextItem

nextItem = null

nextState = -1

@Suppress("UNCHECKED_CAST")

return result as T

}

override fun hasNext(): Boolean {

if (nextState == -1)

calcNext()

return nextState == 1

}

}

}filter 中又会使用上一个 Sequence 的 sequence.iterator() 进行元素迭代。再看下 map :

public fun <T, R> Sequence<T>.map(transform: (T) -> R): Sequence<R> {

return TransformingSequence(this, transform)

}

internal class TransformingSequence<T, R>

constructor(private val sequence: Sequence<T>, private val transformer: (T) -> R) : Sequence<R> {

override fun iterator(): Iterator<R> = object : Iterator<R> {

val iterator = sequence.iterator()

override fun next(): R {

return transformer(iterator.next())

}

override fun hasNext(): Boolean {

return iterator.hasNext()

}

}

internal fun <E> flatten(iterator: (R) -> Iterator<E>): Sequence<E> {

return FlatteningSequence<T, R, E>(sequence, transformer, iterator)

}

}也是使用上一个 Sequence 的 sequence.iterator() 进行元素迭代。所以以此类推,最终会使用转换为 asSequence() 的源 iterator()。

下面自定义一个 Sequence 来验证上面的猜想:

listOf(1, 2, 3, 4).asSequence().mapToString {

Log.d("TestSequence","mapToString${it}")

it.toString()

}.toList()

fun <T> Sequence<T>.mapToString(transform: (T) -> String): Sequence<String> {

return TransformingStringSequence(this, transform)

}

class TransformingStringSequence<T>

constructor(private val sequence: Sequence<T>, private val transformer: (T) -> String) : Sequence<String> {

override fun iterator(): Iterator<String> = object : Iterator<String> {

val iterator = sequence.iterator()

override fun next(): String {

val next = iterator.next()

Log.d("TestSequence","next:${next}")

return transformer(next)

}

override fun hasNext(): Boolean {

return iterator.hasNext()

}

}

}

控制台输出:

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: next:1

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: mapToString1

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: next:2

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: mapToString2

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: next:3

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: mapToString3

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: next:4

2023-01-01 20:43:43.899 21797-21797/com.wangjiang.example D/TestSequence: mapToString4

所以这就是 Sequence 为什么在获取结果的时候才会被应用,也就是末端操作被调用的时候,才会依次处理每个元素,这也是 被称为惰性集合操作的原因。

经过一系列的 序列操作,每个元素逐个被处理,那么优先处理 filter 序列,其实可以减少变换的总次数。因为每个序列都是使用上一个序列的 sequence.iterator() 进行元素迭代。

创建序列

在集合操作上,可以使用集合直接调用 asSequence() 转换为序列。那么不是集合,有类似集合一样的变换,该怎么操作呢。

下面以求 1到100 的所有自然数之和为例子:

val naturalNumbers = generateSequence(0) { it + 1 }

val numbersTo100 = naturalNumbers.takeWhile { it <= 100 }

val sum = numbersTo100.sum()

println(sum)

控制台输出:

5050先看下 generateSequence 源码:

public fun <T : Any> generateSequence(seed: T?, nextFunction: (T) -> T?): Sequence<T> =

if (seed == null)

EmptySequence

else

GeneratorSequence({ seed }, nextFunction)

private class GeneratorSequence<T : Any>(private val getInitialValue: () -> T?, private val getNextValue: (T) -> T?) : Sequence<T> {

override fun iterator(): Iterator<T> = object : Iterator<T> {

var nextItem: T? = null

var nextState: Int = -2 // -2 for initial unknown, -1 for next unknown, 0 for done, 1 for continue

private fun calcNext() {

//getInitialValue 获取的到就是 generateSequence 的第一个参数 0

//getNextValue 获取到的就是 generateSequence 的第二个参数 it+1,这个it 就是 nextItem!!

nextItem = if (nextState == -2) getInitialValue() else getNextValue(nextItem!!)

nextState = if (nextItem == null) 0 else 1

}

override fun next(): T {

if (nextState < 0)

calcNext()

if (nextState == 0)

throw NoSuchElementException()

val result = nextItem as T

// Do not clean nextItem (to avoid keeping reference on yielded instance) -- need to keep state for getNextValue

nextState = -1

return result

}

override fun hasNext(): Boolean {

if (nextState < 0)

calcNext()

return nextState == 1

}

}

}上面代码其实就是创建一个 Sequence 接口实现类,并实现它的 iterator 接口方法,返回一个 Iterator 迭代器。

public fun <T> Sequence<T>.takeWhile(predicate: (T) -> Boolean): Sequence<T> {

return TakeWhileSequence(this, predicate)

}

internal class TakeWhileSequence<T>

constructor(

private val sequence: Sequence<T>,

private val predicate: (T) -> Boolean

) : Sequence<T> {

override fun iterator(): Iterator<T> = object : Iterator<T> {

val iterator = sequence.iterator()

var nextState: Int = -1 // -1 for unknown, 0 for done, 1 for continue

var nextItem: T? = null

private fun calcNext() {

if (iterator.hasNext()) {

//iterator.next() 调用的就是上一个 GeneratorSequence 的 next 方法,而返回值就是它的 it+1

val item = iterator.next()

//判断条件,也就是 it <= 100 -> item <= 100

if (predicate(item)) {

nextState = 1

nextItem = item

return

}

}

nextState = 0

}

override fun next(): T {

if (nextState == -1)

calcNext() // will change nextState

if (nextState == 0)

throw NoSuchElementException()

@Suppress("UNCHECKED_CAST")

val result = nextItem as T

// Clean next to avoid keeping reference on yielded instance

nextItem = null

nextState = -1

return result

}

override fun hasNext(): Boolean {

if (nextState == -1)

calcNext() // will change nextState

return nextState == 1

}

}

}在 TakeWhileSequence 的 next 方法中,会优先调用内部方法 calcNext,而这个方法内部又是调用 GeneratorSequence的 next方法,这样就 拿到了当前值 it+1(上一个是0+1,下一个就是1+1),拿到值后再判断 it <= 100 -> item <= 100。

public fun Sequence<Int>.sum(): Int {

var sum: Int = 0

for (element in this) {

sum += element

}

return sum

}sum 方法是序列的末端操作,也就是获取结果。for (element in this) ,调用上一个 Sequence 中的迭代器 Iterator 进行元素迭代,以此类推,直到调用 源 Sequence 中的迭代器 Iterator 进行元素迭代。

总结

Kotlin 标准库提供的集合操作函数:filter,map, flatmap 等,在操作的时候会创建存储中间结果的临时列表,当集合元素较多时,这种链式操作就会变得低效。为了解决这种问题,Kotlin 提供了惰性集合操作 Sequence 接口,只有在 末端操作被调用的时候,也就是获取结果的时候,序列中的元素才会被逐个执行,处理完第一个元素后,才会处理第二个元素,这样中间操作是被延期执行的。而且因为是顺序地去执行每一个元素,所以可以先做 filter 变换,再做 map 变换,这样有助于减少变换的总次数。

链接:https://juejin.cn/post/7184250146933178405

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

深入flutter布局约束原理

刚开始接触flutter的时候,Container组件是用得最多的。它就像HTML中的div一样普遍,专门用来布局页面的。

但是使用Container嵌套布局的时候,经常出现一些令人无法理解的问题。就如下面代码,在一个固定的容器中,子组件却铺满了全屏。

/// 例一

@override

Widget build(BuildContext context) {

return Container(

width: 300,

height: 300,

color: Colors.amber,

child: Container(width: 50, height: 50, color: Colors.red,),

);

}然后要加上alignment属性,子组件正常显示了,但容器还是铺满全屏。

/// 例二

@override

Widget build(BuildContext context) {

return Container(

width: 300,

height: 300,

color: Colors.amber,

alignment: Alignment.center,

child: Container(width: 50, height: 50, color: Colors.red,),

);

}而在容器外层添加一个Scaffold组件,它就正常显示了。

/// 例三

@override

Widget build(BuildContext context) {

return Scaffold(

body: Container(

width: 300,

height: 300,

color: Colors.amber,

alignment: Alignment.center,

child: Container(width: 50, height: 50, color: Colors.red,),

),

);

}这一切的怪异行为困扰了我很久,直到我深入了flutter布局的学习,才渐渐解开这些疑惑。

1、flutter的widget类型

flutter的widget可以分为三类,组合类ComponentWidget、代理类ProxyWidget和绘制类RenderObjectWidget

组合类:如Container、Scaffold、MaterialApp还有一系列通过继承StatelessWidget和StatefulWidget的类。组合类是我们开发过程中用得最多的组件。

代理类:InheritedWidget,功能型组件,它可以高效快捷的实现共享数据的跨组件传递。如常见的Theme、MediaQuery就是InheritedWidget的应用。

绘制类:屏幕上看到的UI几乎都会通过RenderObjectWidget实现。通过继承它,可以进行界面的布局和绘制。如Align、Padding、ConstrainedBox等都是通过继承RenderObjectWidget,并通过重写createRenderObject方法来创建RenderObject对象,实现最终的布局(layout)和绘制(paint)。

2、Container是个组合类

显而易见Container继承StatelessWidget,它是一个组合类,同时也是一个由DecoratedBox、ConstrainedBox、Transform、Padding、Align等组件组合的多功能容器。可以通过查看Container类,看出它实际就是通过不同的参数判断,再进行组件的层层嵌套来实现的。

@override

Widget build(BuildContext context) {

Widget? current = child;

if (child == null && (constraints == null || !constraints!.isTight)) {

current = LimitedBox(

maxWidth: 0.0,

maxHeight: 0.0,

child: ConstrainedBox(constraints: const BoxConstraints.expand()),

);

} else if (alignment != null) {

current = Align(alignment: alignment!, child: current);

}

final EdgeInsetsGeometry? effectivePadding = _paddingIncludingDecoration;

if (effectivePadding != null) {

current = Padding(padding: effectivePadding, child: current);

}

if (color != null) {

current = ColoredBox(color: color!, child: current);

}

if (clipBehavior != Clip.none) {

assert(decoration != null);

current = ClipPath(

clipper: _DecorationClipper(

textDirection: Directionality.maybeOf(context),

decoration: decoration!,

),

clipBehavior: clipBehavior,

child: current,

);

}

if (decoration != null) {

current = DecoratedBox(decoration: decoration!, child: current);

}

if (foregroundDecoration != null) {

current = DecoratedBox(

decoration: foregroundDecoration!,

position: DecorationPosition.foreground,

child: current,

);

}

if (constraints != null) {

current = ConstrainedBox(constraints: constraints!, child: current);

}

if (margin != null) {

current = Padding(padding: margin!, child: current);

}

if (transform != null) {

current = Transform(transform: transform!, alignment: transformAlignment, child: current);

}

return current!;

}

组合类基本不参与ui的绘制,都是通过绘制类的组合来实现功能。

3、flutter布局约束

flutter中有两种布局约束BoxConstraints盒约束和SliverConstraints线性约束,如Align、Padding、ConstrainedBox使用的是盒约束。

BoxConstraints盒约束是指flutter框架在运行时遍历整个组件树,在这过程中 「向下传递约束,向上传递尺寸」,以此来确定每个组件的尺寸和大小。

BoxConstraints类由4个属性组成,最小宽度minWidth、最大宽度maxWidth、最小高度minHeight、最大高度maxHeight。

BoxConstraints({

this.minWidth,

this.maxWidth,

this.minHeight,

this.maxHeight,

});根据这4个属性的变化,可以分为“紧约束(tight)”、“松约束(loose)”、“无界约束”、“有界约束”。

紧约束:最小宽(高)度和最大宽(高)度值相等,此时它是一个固定宽高的约束。

BoxConstraints.tight(Size size)

: minWidth = size.width,

maxWidth = size.width,

minHeight = size.height,

maxHeight = size.height;

松约束:最小宽(高)值为0,最大宽(高)大于0,此时它是一个约束范围。

BoxConstraints.loose(Size size)

: minWidth = 0.0,

maxWidth = size.width,

minHeight = 0.0,

maxHeight = size.height;

无界约束:最小宽(高)和最大宽(高)值存在double.infinity(无限)。

BoxConstraints.expand({double? width, double? height})

: minWidth = width ?? double.infinity,

maxWidth = width ?? double.infinity,

minHeight = height ?? double.infinity,

maxHeight = height ?? double.infinity;

有界约束:最小宽(高)和最大宽(高)值均为固定值。

BoxConstraints(100, 300, 100, 300)

4、Container布局行为解惑

了解了BoxConstraints布局约束,回到本文最开始的问题。

/// 例一

@override

Widget build(BuildContext context) {

return Container(

width: 300,

height: 300,

color: Colors.amber,

child: Container(width: 50, height: 50, color: Colors.red,),

);

}例一中,两个固定宽高的Container,为什么子容器铺满了全屏?

根据BoxConstraints布局约束,遍历整个组件树,最开始的root是树的起点,它向下传递的是一个紧约束。因为是移动设备,root即是屏幕的大小,假设屏幕宽414、高896。于是整个布局约束如下:

这里有个问题,就是Container分明已经设置了固定宽高,为什么无效?

因为父级向下传递的约束,子组件必须严格遵守。这里Container容器设置的宽高超出了父级的约束范围,就会自动被忽略,采用符合约束的值。

例一两上Container都被铺满屏幕,而最底下的红色Container叠到了最上层,所以最终显示红色。

/// 例二

@override

Widget build(BuildContext context) {

return Container(

width: 300,

height: 300,

color: Colors.amber,

alignment: Alignment.center,

child: Container(width: 50, height: 50, color: Colors.red,),

);

}例二也同样可以根据布局约束求证,如下图:

这里Container为什么是ConstrainedBox和Align组件?前面说过Container是一个组合组件,它是由多个原子组件组成的。根据例二,它是由ConstrainedBox和Align嵌套而成。

Align提供给子组件的是一个松约束,所以容器自身设置50宽高值是在合理范围的,因此生效,屏幕上显示的就是50像素的红色方块。ConstrainedBox受到的是紧约束,所以自身的300宽高被忽略,显示的是铺满屏幕的黄色块。

/// 例三

@override

Widget build(BuildContext context) {

return Scaffold(

body: Container(

width: 300,

height: 300,

color: Colors.amber,

alignment: Alignment.center,

child: Container(width: 50, height: 50, color: Colors.red,),

),

);

}例三中Scaffold向下传递的是一个松约束,所以黄色Container的宽高根据自身设置的300,在合理的范围内,有效。Container再向下传递的也是松约束,最终红色Container宽高为50。

这里还有个问题,怎么确定组件向下传递的是紧约束还是松约束?

这就涉及到组件的内部实现了,这里通过Align举个例。

Align是一个绘制组件,它能够进行界面的布局和绘制,这是因为Align的继承链为:

Align -> SingleChildRenderObjectWidget -> RenderObjectWidget

Align需要重写createRenderObject方法,返回RenderObject的实现,这里Align返回的是RenderPositionedBox,所以核心内容就在这个类中

class Align extends SingleChildRenderObjectWidget {

/// ...

@override

RenderPositionedBox createRenderObject(BuildContext context) {

return RenderPositionedBox(

alignment: alignment,

widthFactor: widthFactor,

heightFactor: heightFactor,

textDirection: Directionality.maybeOf(context),

);

}

/// ...

}而RenderPositionedBox类中,重写performLayout方法,该方法用于根据自身约束条件,计算出子组件的布局,再根据子组件的尺寸设置自身的尺寸,形成一个至下而上,由上到下的闭环,最终实现界面的整个绘制。

RenderPositionedBox -> RenderAligningShiftedBox -> RenderShiftedBox -> RenderBox

class RenderPositionedBox extends RenderAligningShiftedBox {

/// ...

@override

void performLayout() {

final BoxConstraints constraints = this.constraints; // 自身的约束大小

final bool shrinkWrapWidth = _widthFactor != null || constraints.maxWidth == double.infinity;

final bool shrinkWrapHeight = _heightFactor != null || constraints.maxHeight == double.infinity;

/// 存在子组件

if (child != null) {

/// 开始布局子组件

child!.layout(constraints.loosen(), parentUsesSize: true);

/// 根据子组件的尺寸设置自身尺寸

size = constraints.constrain(Size(

shrinkWrapWidth ? child!.size.width * (_widthFactor ?? 1.0) : double.infinity,

shrinkWrapHeight ? child!.size.height * (_heightFactor ?? 1.0) : double.infinity,

));

/// 计算子组件的位置

alignChild();

} else {

/// 不存在子组件

size = constraints.constrain(Size(

shrinkWrapWidth ? 0.0 : double.infinity,

shrinkWrapHeight ? 0.0 : double.infinity,

));

}

}

/// ...

}根据Align中performLayout方法的实现,可以确定该组件最终会给子组件传递一个怎么样的约束。

/// constraints.loosen提供的是一个松约束

child!.layout(constraints.loosen(), parentUsesSize: true);

/// loosen方法

BoxConstraints loosen() {

assert(debugAssertIsValid());

/// BoxConstraints({double minWidth = 0.0, double maxWidth = double.infinity, double minHeight = 0.0, double maxHeight = double.infinity})

return BoxConstraints(

maxWidth: maxWidth,

maxHeight: maxHeight,

);

}其它绘制类的组件基本跟Align大同小异,只要重点看performLayout方法的实现,即可判断出组件提供的约束条件。

总结

1、flutter的widget分为,组合类、代理类和绘制类。

2、Container是一个组合类,由DecoratedBox、ConstrainedBox、Transform、Padding、Align等绘制组件组合而成。

3、flutter中有两种布局约束BoxConstraints盒约束和SliverConstraints线性约束。

4、BoxConstraints的约束原理是: 「向下传递约束,向上传递尺寸」。

5、BoxConstraints的约束类型为:紧约束、松约束、无界约束、有界约束。

6、判断一个绘制组件的约束行为可以通过查看performLayout方法中layout传入的约束值。

链接:https://juejin.cn/post/7183549888406224955

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

IM会话列表刷新优化思考

背景

脱离业务场景讲技术方案都是耍流氓

最近接手了IM的业务,一上来就来了几个大需求,搞得有点手忙脚乱。在做需求的过程中发现,我们的会话列表(RecyclerView)居然每次更新都是notifyDataSetChanged(),因为IM的刷新频率是非常高的

大家可以想象一下微信消息列表,每来1条消息,就全局调用notifyDataSetChanged。

这里瞎猜一下,可能由于历史原因,之前设计的同学也是不得已而为之。既然发现了这个问题,那么我们如何来进行优化呢?

IM列表跟普通列表的区别

有序性:列表中的Item按时间排序,或者其他规则(置顶也是修改时间实现)

唯一性:每个会话都是唯一的,不存在重复

单item更新频率高:可以参考微信的会话列表

DiffUtil

首先想到的是DiffUtil,它用来比较两个数据集,寻找出旧数据集->新数据集的最小变化量

实现思路:

获取原始会话数据,进行排序,去重操作

采用DiffUtil自动计算新老数据集差异,自动完成定向刷新

这里只摘取DiffUtil关键使用部分,至于高级用法和更高级的用法不再赘述

class DiffMsgCallBack: DiffUtil.Callback() {

private val oldData: MutableList<MsgItem> = mutableListOf()

private val newData: MutableList<MsgItem> = mutableListOf()

//老数据集size

override fun getOldListSize(): Int {

return oldData.size

}

//新数据集size

override fun getNewListSize(): Int {

return newData.size

}

/**

* 比较的是position,被DiffUtil调用,用来判断两个对象是否是相同的Item

* 例如,如果你的Item有唯一的id字段,这个方法就 判断id是否相等

*/

override fun areItemsTheSame(oldItemPosition: Int, newItemPosition: Int): Boolean {

return oldData[oldItemPosition].id == newData[newItemPosition].id

}

/**

* 用来检查 两个item是否含有相同的数据,当前item的内容是否发生了变化,这个方法仅仅在areItemsTheSame()返回true时,才调用

*/

override fun areContentsTheSame(oldItemPosition: Int, newItemPosition: Int): Boolean {

if (oldData[oldItemPosition].id != newData[newItemPosition].id){

return false

}

if (oldData[oldItemPosition].content != newData[newItemPosition].content){

return false

}

if (oldData[oldItemPosition].time != newData[newItemPosition].time){

return false

}

return true

}

/**

* 高级用法:实现部分(partial)绑定的方法,需要配合onBindViewHolder的3个参数的方法

* 更高级用法:AsyncListDiffer+ListAdapter

*

*/

override fun getChangePayload(oldItemPosition: Int, newItemPosition: Int): Any? {

return super.getChangePayload(oldItemPosition, newItemPosition)

}SortedList

当我以为DiffUtil已经可以满足需求的时候,无意间又发现了一个SortedList。

SortedList是一个有序列表(数据集)的实现,可以保持ItemData都是有序的,并(自动)通知列表(RecyclerView)(数据集)中的更改。

搭配RecyclerView使用,去重,有序,自动定向刷新

这里也只摘取关键使用部分,具体用法不再详解

class SortListCallBack(adapter: RecyclerView.Adapter<*>?) : SortedListAdapterCallback<MsgItem>(adapter) {

/**

* 排序条件,实现排序的逻辑

*/

override fun compare(o1: MsgItem?, o2: MsgItem?): Int {

o1 ?: return -1

o2 ?: return -1

return o1.time - o2.time

}

/**

* 和DiffUtil方法一致,用来判断 两个对象是否是相同的Item。

*/

override fun areItemsTheSame(item1: MsgItem?, item2: MsgItem?): Boolean {

return item1?.id == item2?.id

}

/**

* 和DiffUtil方法一致,返回false,代表Item内容改变。会回调mCallback.onChanged()方法;

* 相同:areContentsTheSame+areItemsTheSame

*/

override fun areContentsTheSame(oldItem: MsgItem?, newItem: MsgItem?): Boolean {

if (oldItem?.id != newItem?.id){

return false

}

if (oldItem?.content != newItem?.content){

return false

}

if (oldItem?.time != newItem?.time){

return false

}

return true

}

/**

* 高级用法:实现部分绑定的方法,需要配合onBindViewHolder的3个参数的方法

*/

override fun getChangePayload(item1: MsgItem?, item2: MsgItem?): Any? {

return super.getChangePayload(item1, item2)

}

}对比

DiffUtil和SortedList是非常相似的,修改过数据后,内部持有的回调接口都是同一个:androidx.recyclerview.widget.ListUpdateCallback

/**

* An interface that can receive Update operations that are applied to a list.

* <p>

* This class can be used together with DiffUtil to detect changes between two lists.

*/

public interface ListUpdateCallback {

void onInserted(int position, int count);

void onRemoved(int position, int count);

void onMoved(int fromPosition, int toPosition);

void onChanged(int position, int count, @Nullable Object payload);DiffUtil计算出Diff或者SortedList察觉出数据集有改变后,会回调ListUpdateCallback接口的这四个方法,DiffUtil和SortedList提供的默认Callback实现中,都会通知Adapter完成定向刷新。 这就是自动定向刷新的原理

总结

DiffUtil比较两个数据源(一般是List)的差异(Diff),Callback中比对时传递的参数是 position

SortedList能完成数据集的排序和去重,Callback中比对时,传递的参数是ItemData

都能完成自动定向刷新 + 部分绑定,一种自动定向刷新的手段

DiffUtil: 检测不出重复的,会被认为是新增的

DiffUtil高级用法支持子线程中处理数据,而SortList不支持

理想与现实

2种方案都有了,是不是可以进行IM会话列表的优化了呢,答案是不能

业务需求迭代,牵一发而动全身

祖传代码,无人敢动,更别说优化了

有时候我们写代码会想着后面再优化一下,然而很多时候都不会给你优化的机会,除非重大需求变动,所以一开始设计框架的时候就要结合业务场景尽量设计的更加合理

参考文章:blog.csdn.net/zxt0601/art…

作者:掀乱书页的风

来源:juejin.cn/post/7183517773790707769

前端白屏的检测方案,让你知道自己的页面白了

前言

页面白屏,绝对是让前端开发者最为胆寒的事情,特别是随着 SPA 项目的盛行,前端白屏的情况变得更为复杂且棘手起来( 这里的白屏是指页面一直处于白屏状态 )

要是能检测到页面白屏就太棒了,开发者谁都不想成为最后一个知道自己页面白的人😥

web-see 前端监控方案,提供了 采样对比+白屏修正机制 的检测方案,兼容有骨架屏、无骨架屏这两种情况,来解决开发者的白屏之忧

知道页面白了,然后呢?

web-see 前端监控,会给每次页面访问生成一个唯一的uuid,当上报页面白屏后,开发者可以根据白屏的uuid,去监控后台查询该id下对应的代码报错、资源报错等信息,定位到具体的源码,帮助开发者快速解决白屏问题

白屏检测方案的实现流程

采样对比+白屏修正机制的主要流程:

1、页面中间取17个采样点(如下图),利用 elementsFromPoint api 获取该坐标点下的 HTML 元素

2、定义属于容器元素的集合,如 ['html', 'body', '#app', '#root']

3、判断17这个采样点是否在该容器集合中。说白了,就是判断采样点有没有内容;如果没有内容,该点的 dom 元素还是容器元素,若17个采样点都没有内容则算作白屏

4、若初次判断是白屏,开启轮询检测,来确保白屏检测结果的正确性,直到页面的正常渲染

采样点分布图(蓝色为采样点):

如何使用

import webSee from 'web-see';

Vue.use(webSee, {

dsn: 'http://localhost:8083/reportData', // 上报的地址

apikey: 'project1', // 项目唯一的id

userId: '89757', // 用户id

silentWhiteScreen: true, // 开启白屏检测

skeletonProject: true, // 项目是否有骨架屏

whiteBoxElements: ['html', 'body', '#app', '#root'] // 白屏检测的容器列表

});下面聊一聊具体的分析与实现

白屏检测的难点

1) 白屏原因的不确定

从问题推导现象虽然能成功,但从现象去推导问题却走不通。白屏发生时,无法和具体某个报错联系起来,也可能根本没有报错,比如关键资源还没有加载完成

导致白屏的原因,大致分两种:资源加载错误、代码执行错误

2) 前端渲染方式的多样性

前端页面渲染方式有多种,比如 客户端渲染 CSR 、服务端渲染 SSR 、静态页面生成 SSG 等,每种模式各不相同,白屏发生的情况也不尽相同

很难用一种统一的标准去判断页面是否白了

技术方案调研

如何设计出一种,在准确性、通用型、易用性等方面均表现良好的检测方案呢?

本文主要讨论 SPA 项目的白屏检测方案,包括有无骨架屏的两种情况

方案一:检测根节点是否渲染

原理很简单,在当前主流 SPA 框架下,DOM 一般挂载在一个根节点之下(比如 <div id="app"></div> ),发生白屏后通常是根节点下所有 DOM 被卸载,该方法通过检测根节点下是否挂载 DOM,若无则证明白屏

这是简单明了且有效的方案,但缺点也很明显:其一切建立在 白屏 === 根节点下 DOM 被卸载 成立的前提下,缺点是通用性较差,对于有骨架屏的情况束手无策

方案二:Mutation Observer 监听 DOM 变化

通过此 API 监听页面 DOM 变化,并告诉我们每次变化的 DOM 是被增加还是删除

但这个方案有几个缺陷

1)白屏不一定是 DOM 被卸载,也有可能是压根没渲染,且正常情况也有可能大量 DOM 被卸载

2)遇到有骨架屏的项目,若页面从始至终就没变化,一直显示骨架屏,这种情况 Mutation Observer 也束手无策

方案三:页面截图检测

这种方式是基于原生图片对比算法处理白屏检测的 web 实现

整体流程:对页面进行截图,将截图与一张纯白的图片做对比,判断两者是否足够相似

但这个方案有几个缺陷:

1、方案较为复杂,性能不高;一方面需要借助 canvas 实现前端截屏,同时需要借助复杂的算法对图片进行对比

2、通用性较差,对于有骨架屏的项目,对比的样张要由纯白的图片替换成骨架屏的截图

方案四:采样对比

该方法是对页面取关键点,进行采样对比,在准确性、易用性等方面均表现良好,也是最终采用的方案

对于有骨架屏的项目,通过对比前后获取的 dom 元素是否一致,来判断页面是否变化(这块后面专门讲解)

采样对比代码:

// 监听页面白屏

function whiteScreen() {

// 页面加载完毕

function onload(callback) {

if (document.readyState === 'complete') {

callback();

} else {

window.addEventListener('load', callback);

}

}

// 定义外层容器元素的集合

let containerElements = ['html', 'body', '#app', '#root'];

// 容器元素个数

let emptyPoints = 0;

// 选中dom的名称

function getSelector(element) {

if (element.id) {

return "#" + element.id;

} else if (element.className) {// div home => div.home

return "." + element.className.split(' ').filter(item => !!item).join('.');

} else {

return element.nodeName.toLowerCase();

}

}

// 是否为容器节点

function isContainer(element) {

let selector = getSelector(element);

if (containerElements.indexOf(selector) != -1) {

emptyPoints++;

}

}

onload(() => {

// 页面加载完毕初始化

for (let i = 1; i <= 9; i++) {

let xElements = document.elementsFromPoint(window.innerWidth * i / 10, window.innerHeight / 2);

let yElements = document.elementsFromPoint(window.innerWidth / 2, window.innerHeight * i / 10);

isContainer(xElements[0]);

// 中心点只计算一次

if (i != 5) {

isContainer(yElements[0]);

}

}

// 17个点都是容器节点算作白屏

if (emptyPoints == 17) {

// 获取白屏信息

console.log({

status: 'error'

});

}

}

}白屏修正机制

若首次检测页面为白屏后,任务还没有完成,特别是手机端的项目,有可能是用户网络环境不好,关键的JS资源或接口请求还没有返回,导致的页面白屏

需要使用轮询检测,来确保白屏检测结果的正确性,直到页面的正常渲染,这就是白屏修正机制

白屏修正机制图例:

轮询代码:

// 采样对比

function sampling() {

let emptyPoints = 0;

……

// 页面正常渲染,停止轮询

if (emptyPoints != 17) {

if (window.whiteLoopTimer) {

clearTimeout(window.whiteLoopTimer)

window.whiteLoopTimer = null

}

} else {

// 开启轮询

if (!window.whiteLoopTimer) {

whiteLoop()

}

}

// 通过轮询不断修改之前的检测结果,直到页面正常渲染

console.log({

status: emptyPoints == 17 ? 'error' : 'ok'

});

}

// 白屏轮询

function whiteLoop() {

window.whiteLoopTimer = setInterval(() => {

sampling()

}, 1000)

}骨架屏

对于有骨架屏的页面,用户打开页面后,先看到骨架屏,然后再显示正常的页面,来提升用户体验;但如果页面从始至终都显示骨架屏,也算是白屏的一种

骨架屏示例:

骨架屏的原理

无论 vue 还是 react,页面内容都是挂载到根节点上。常见的骨架屏插件,就是基于这种原理,在项目打包时将骨架屏的内容直接放到 html 文件的根节点中

有骨架屏的html文件:

骨架屏的白屏检测

上面的白屏检测方案对有骨架屏的项目失灵了,虽然页面一直显示骨架屏,但判断结果页面不是白屏,不符合我们的预期

需要通过外部传参明确的告诉 SDK,该页面是不是有骨架屏,如果有骨架屏,通过对比前后获取的 dom 元素是否一致,来实现骨架屏的白屏检测

完整代码:

/**

* 检测页面是否白屏

* @param {function} callback - 回到函数获取检测结果

* @param {boolean} skeletonProject - 页面是否有骨架屏

* @param {array} whiteBoxElements - 容器列表,默认值为['html', 'body', '#app', '#root']

*/

export function openWhiteScreen(callback, { skeletonProject, whiteBoxElements }) {

let _whiteLoopNum = 0;

let _skeletonInitList = []; // 存储初次采样点

let _skeletonNowList = []; // 存储当前采样点

// 项目有骨架屏

if (skeletonProject) {

if (document.readyState != 'complete') {

sampling();

}

} else {

// 页面加载完毕

if (document.readyState === 'complete') {

sampling();

} else {

window.addEventListener('load', sampling);

}

}

// 选中dom点的名称

function getSelector(element) {

if (element.id) {

return '#' + element.id;

} else if (element.className) {

// div home => div.home

return ('.' + element.className.split(' ').filter(item => !!item).join('.'));

} else {

return element.nodeName.toLowerCase();

}

}

// 判断采样点是否为容器节点

function isContainer(element) {

let selector = getSelector(element);

if (skeletonProject) {

_whiteLoopNum ? _skeletonNowList.push(selector) : _skeletonInitList.push(selector);

}

return whiteBoxElements.indexOf(selector) != -1;

}

// 采样对比

function sampling() {

let emptyPoints = 0;

for (let i = 1; i <= 9; i++) {

let xElements = document.elementsFromPoint(

(window.innerWidth * i) / 10,

window.innerHeight / 2

);

let yElements = document.elementsFromPoint(

window.innerWidth / 2,

(window.innerHeight * i) / 10

);

if (isContainer(xElements[0])) emptyPoints++;

// 中心点只计算一次

if (i != 5) {

if (isContainer(yElements[0])) emptyPoints++;

}

}

// 页面正常渲染,停止轮训

if (emptyPoints != 17) {

if (skeletonProject) {

// 第一次不比较

if (!_whiteLoopNum) return openWhiteLoop();

// 比较前后dom是否一致

if (_skeletonNowList.join() == _skeletonInitList.join())

return callback({

status: 'error'

});

}

if (window._loopTimer) {

clearTimeout(window._loopTimer);

window._loopTimer = null;

}

} else {

// 开启轮训

if (!window._loopTimer) {

openWhiteLoop();

}

}

// 17个点都是容器节点算作白屏

callback({

status: emptyPoints == 17 ? 'error' : 'ok',

});

}

// 开启白屏轮训

function openWhiteLoop() {

if (window._loopTimer) return;

window._loopTimer = setInterval(() => {

if (skeletonProject) {

_whiteLoopNum++;

_skeletonNowList = [];

}

sampling();

}, 1000);

}

}如果不通过外部传参,SDK 能否自己判断是否有骨架屏呢? 比如在页面初始的时候,根据根节点上有没有子节点来判断

因为这套检测方案需要兼容 SSR 服务端渲染的项目,对于 SSR 项目来说,浏览器获取 html 文件的根节点上已经有了 dom 元素,所以最终采用外部传参的方式来区分

总结

这套白屏检测方案是从现象推导本质,可以覆盖绝大多数 SPA 项目的应用场景

小伙们若有其他检测方案,欢迎多多讨论与交流 💕

作者:海阔_天空

来源:juejin.cn/post/7176206226903007292

Android App封装 —— 实现自己的EventBus

背景

在项目中我们经常会遇到跨页面通信的需求,但传统的EventBus都有各自的缺点,如EventBus和RxBus需要自己管理生命周期,比较繁琐,基于LiveData的Bus切线程比较困难等。于是我参考了一些使用Flow实现EventBus的文章,结合自身需求,实现了极简的EventBus。

EventBus

EventBus是用于 Android 和 Java 的发布/订阅事件总线。Publisher可以将事件Event post给每一个订阅者Subscriber中接收,从而达到跨页面通信的需求。

可以看出EventBus本身就是一个生产者消费者模型,而在我们第一篇搭建MVI框架的时候,用到的Flow天然就支持生产者和消费者模型,所以我们可以自己用Flow搭建一个自己的EventBus

基于Flow搭建EventBus

根据EventBus的架构图,我们来用Flow搭建,需要定义一下几点

- 定义事件Event

- 发送者 Publisher 如何发送事件

- 如何存储Event并且分发

- 如何订阅事件

1. 定义事件

sealed class Event {

data class ShowInit(val msg: String) : Event()

}这个和之前搭建MVI框架类似,用一个sleaed class和data class或者object来定义事件,用来传递信息

2. 发送事件

fun post(event: Event, delay: Long = 0) {

...

}发送事件定义一个这样的函数就可以了,传入事件和延迟时间

3. 存储Event并且分发

对于同一种Event,我们可以用一个SharedFlow来存储,依次发送给订阅方。而在整个App中,我们会用到各种不同种类的Event,所以这时候我们就需要用到HashMap去存储这些Event了。数据结构如下:

private val flowEvents = ConcurrentHashMap<String, MutableSharedFlow<Event>>()

4. 订阅事件

inline fun <reified T : Event> observe(

lifecycleOwner: LifecycleOwner,

minState: Lifecycle.State = Lifecycle.State.CREATED,

dispatcher: CoroutineDispatcher = Dispatchers.Main,

crossinline onReceived: (T) -> Unit

)lifecycleOwner,用来定义订阅者的生命周期,这样我们就不需要额外管理注册与反注册了minState,定义执行订阅的生命周期Statedispatcher,定义执行所在的线程onReceived,收到Event后执行的Lamda

使用

//任何地方

FlowEventBus.post(Event.ShowInit("article init"))

// Activity或者Fragment中

FlowEventBus.observe<Event.ShowInit>(this, Lifecycle.State.STARTED) {

binding.button.text = it.msg

}完整代码

object FlowEventBus {

//用HashMap存储SharedFlow

private val flowEvents = ConcurrentHashMap<String, MutableSharedFlow<Event>>()

//获取Flow,当相应Flow不存在时创建

fun getFlow(key: String): MutableSharedFlow<Event> {

return flowEvents[key] ?: MutableSharedFlow<Event>().also { flowEvents[key] = it }

}

// 发送事件

fun post(event: Event, delay: Long = 0) {

MainScope().launch {

delay(delay)

getFlow(event.javaClass.simpleName).emit(event)

}

}

// 订阅事件

inline fun <reified T : Event> observe(

lifecycleOwner: LifecycleOwner,

minState: Lifecycle.State = Lifecycle.State.CREATED,

dispatcher: CoroutineDispatcher = Dispatchers.Main,

crossinline onReceived: (T) -> Unit

) = lifecycleOwner.lifecycleScope.launch(dispatcher) {

getFlow(T::class.java.simpleName).collect {

lifecycleOwner.lifecycle.whenStateAtLeast(minState) {

if (it is T) onReceived(it)

}

}

}

}链接:https://juejin.cn/post/7182399245859684412

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Android App封装 —— DI框架 Hilt?Koin?

背景

前面的项目Github wanandroid例子我们可以看到,我们创建Repository和ViewModel的时候,都是直接创建的

class MainViewModel : BaseViewModel<MainState, MainIntent>() {

private val mWanRepo = HomeRepository()

...

}

class MainActivity : BaseActivity<ActivityMainBinding>() {

override fun onCreate(savedInstanceState: Bundle?) {

mViewModel = ViewModelProvider(this).get(MainViewModel::class.java)

}

}但是一般一个repository会被多个viewModel使用,我们不想创建多个同样类型的repository实例,这时候我们需要将WanRepository设置为单例。但是当代码越来越多,对象的共享、依赖关系以及生命周期越来越复杂的时候,我们全部自己手写显然是比较复杂的。

所以Goolge强推我们使用DI(Dependency Injection)依赖注入来管理对象的创建,之前推出了强大的Dagger,但是由于难学难用,很少有人用到这个框架。后面又推出了Hilt,基于Dagger实现,针对于Android平台简化了使用方式,原理和Dagger是一致的。

本来准备将Hilt引用到项目中,后来发现了一个轻量级的DI框架koin,两者学习对比了一下之后还是决定使用Koin这个轻量级的框架,koin和Hilt的详细对比就不在此展开了,网上有很多文章。

那么就开始动工,准备在项目中集成koin吧。

koin

koin官网,官网永远是学习一个东西的最佳途径

1. 依赖

网上看到很多koin的使用案例,我看依赖的都是2.X的包

implementation "org.koin:koin-android:$koin_version"

implementation "org.koin:koin-android-viewmodel:$koin_version"

后面我去官网看了下文档,发现koin已经升级到3.x了,合并所有 Scope/Fragment/ViewModel API,只需要引用一个包就可以了

implementation "io.insert-koin:koin-android:$koin_version" //3.3.1

2. 启动

添加好依赖后,可以在Application中启动koin,初始化koin的配置,代码如下

class App : Application() {

override fun onCreate() {

super.onCreate()

startKoin {

//开始启动koin

androidLogger()

androidContext(this@App)//这边传Application对象,这样你注入的类中,需要app对象的时候,可以直接使用

modules(appModule)//这里面传各种被注入的模块对象,支持多模块注入

}

}

}3. 模块Module

上文中的modules(appModule),是用来配置koin使用的Module有哪些,那么Module是什么呢?

Koin是以Module的形式组织依赖项,我们可以将可能用到的依赖项定义在Module中,也就是对象的提供者

val repoModule = module {

single { HomeRepository() }

}

val viewModelModule = module {

viewModel { MainViewModel(get()) }

}

val appModule = listOf(viewModelModule, repoModule)

上面这段代码就是定义了两个Module,一个我专门用来定义repository,一个专门用来定义viewModel。

然后通过get()、inject(),表示在需要注入依赖项,也就是对象的使用者,这时就会在Module里面检索对应的类型,然后自动注入。

所以之前Repository的创建变为

val mWanRepo: HomeRepository by inject(HomeRepository::class.java)

并且依据single定义为了单例

进一步简化可以将repository写到ViewModel的构造方法中

class MainViewModel(private val homeRepo: HomeRepository) : BaseViewModel<MainState, MainIntent>() {

...

}

根据viewModel { MainViewModel(get()) }的定义,在构造MainViewModel的时候会自动因为get()填充HomeRepository对象

4. Activity中使用ViewModel

class MainActivity : BaseActivity<ActivityMainBinding>() {

private val mViewModel by viewModel<MainViewModel>()

}总结

koin和Hilt,大家可以看自己的习惯使用,Hilt的特点主要是利用注解生成代码,使用方便,效率也挺高的。koin我主要是看中它比较轻量级,可以快速入门使用。

项目地址:Github wanandroid。

链接:https://juejin.cn/post/7179151577864175671

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Android App封装 —— ViewBinding

一、背景

在前面的Github wanandroid项目中可以看到,我获取控件对象还是用的findviewbyId

button = findViewById(R.id.button)

viewPager = findViewById(R.id.view_pager)

recyclerView = findViewById(R.id.recycler_view)

现在肯定是需要对这个最常用的获取View的findViewById代码进行优化,主要是有两个原因

过于冗余

findViewById对应所有的View都要书写findViewById(R.id.xxx)的方法,代码过于繁琐

不安全

强制转换不安全,findViewById获取到的是一个View对象,是需要强转的,一旦类型给的不对则会出现异常,比如将TextView错转成ImageView

所以我们需要一个框架解决这个问题,大致是有三个方案

二、方案

方案一 butterkniife

这个应该很多人都用过,由大大佬JakeWharton开发,通过注解生成findViewById的代码来获取对应的View。

@BindView(R.id.button)

EditText mButton;但是2020年3月份,大佬已在GitHub上说明不再维护,推荐使用 ViewBinding了。

方案二 kotlin-android-extensions(KAE)

kotlin-android-extensions只需要直接引入布局可以直接使用资源Id访问View,节省findviewbyid()。

import kotlinx.android.synthetic.main.<布局>.*

button.setOnClickListener{...} 但是这个插件也已经被Google废弃了,会影响效率并且安全性和兼容性都不太友好,Google推荐ViewBinding替代

方案三 ViewBinding

既然都推荐ViewBinding,那现在来看看ViewBinding是啥。官网是这么说的

通过ViewBinding功能,您可以更轻松地编写可与视图交互的代码。在模块中启用视图绑定之后,系统会为该模块中的每个 XML 布局文件生成一个绑定类。绑定类的实例包含对在相应布局中具有 ID 的所有视图的直接引用。在大多数情况下,视图绑定会替代 findViewById。

简而言之就是就是替代findViewById来获取View的。那我们来看看ViewBinding如何使用呢?

三、ViewBinding使用

1. 条件

确保你的Android Studio是3.6或更高的版本

ViewBinding在 Android Studio 3.6 Canary 11 及更高版本中可用

2. 启用ViewBinding

在模块build.gradle文件android节点下添加如下代码

android {

viewBinding{

enabled = true

}

}Android Studio 4.0 中,viewBinding 变成属性被整合到了 buildFeatures 选项中,所以配置要改成:

// Android Studio 4.0

android {

buildFeatures {

viewBinding = true

}