求知 | 聊聊Android资源加载那些事 - Resource的初始化

Hi ,你好 :)

引言

在上一篇,求知 | 聊聊Android资源加载的那些事 - 小试牛刀 中,我们通过探讨 Resource.getx() 等方法,从而解释了相关方法的背后实现。

那么,不知道你有没有好奇 context.resources 与 Resource.getSystem() 有什么不同呢?前者又是在什么时候被初始化的呢?

如果你对上述问题依然存疑,或者你想在复杂中找到一个较清晰的脉络,那本文可能会对你有所帮助。本篇将与你一同探讨关于 Resources 初始化的那些事。

本篇定位中等,主要通过伪源码的方式探索

Resources的初始化过程📌

导航

学完本篇,你将明白以下内容:

Resource(Activity)、Resource(App)初始化流程Context.resource与Resource.getSystem()的不同之处

基础概念

开始本篇前,我们先了解一些必备的基础概念:

ActivityResource

用于持有

Activity或者WindowContext相关联的Resources;

ActivityResources

用于管理

Acitivty的config和其所有ActivityResource,以及当前正在显示的屏幕id;

ResourceManager

用于管理

App所有的resources,内部有一个mActivityResourceReferencesmap保存着所有activity或者windowsToken对应的Resources对象。

Resource(Activity)

在 Activity 中调用 getX() 相关方法时,点进源码不难发现,内部都是调用的 getResource().x ,而 getResource() 又是来自 Context ,所以一切的源头也即从这里开始。

了解 context 的小伙伴应该有印象, context 作为一个顶级抽象类,无论是 Activity 还是 Application 都是其的子类, Context 的实现类又是 ContextImpl,所以当我们要找 Activity 中 resource 在哪里被初始化时🧐,也即是在找:

->

ContextImpl.resource在哪里被初始化? ➡️

顺藤摸瓜,我们去看看 ContextImpl.createActivityContext()。

该方法的调用时机是在构建我们 Activity 之前调用,目的是用于创建 context 实例。

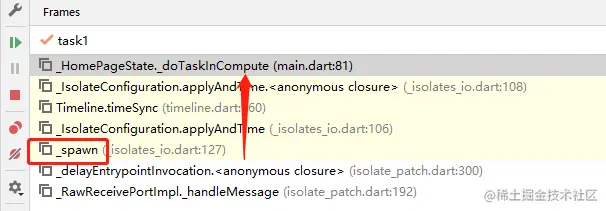

流程分析

具体如下:

ContextImpl.createActivityContext ->

上述总结如下:

内部会获取当前的 分辨率 、

classLoader等配置信息,并调用ResourcesManager.getInstance()从而获取ResourcesManager的单例对象,然后使用其的createBaseTokenResources()去创建最终的Resources。

接着 将resource对象保存到

context中,即赋值给ContextImpl.mResources。

ps: 如果 sdk>=26 ,还会做

CompatResources的判断。

了解了上述流程,我们接着去看 resourcesManager.createBaseTokenResources() 。

ResourceManager.createBaseTokenResources()

上述总结如下:

该方法用于创建当前

activity相对应的resources,内部会经历如下步骤:

先查找或创建当前 token(activity) 所对应的

resources;

Yes -> 什么都不做;

No -> 创建一个

ActivityResources,并将其添加到mActivityResourceReferencesmap中;

接着再去更新该

activity对应resources(内部会再次执行第一步);

再次查找当前的

resources,如果找到,则直接返回;

如果找不到,则重新创建一个

resources(内部又会再执行第一步);

具体的步骤如下所示:

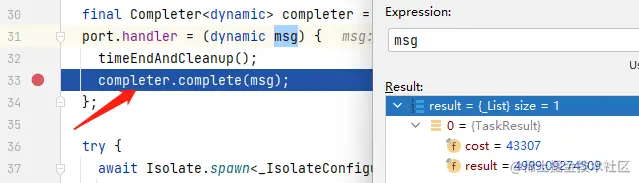

-1. getOrCreateActivityResourcesStructLocked()

ResourcesManager.getOrCreateActivityResourcesStructLocked()

private ActivityResources getOrCreateActivityResourcesStructLocked(

IBinder activityToken) {

// 先从map获取

ActivityResources activityResources = mActivityResourceReferences.get(activityToken);

// 不存在,则创建新的,并以token为key保存到map中,并返回新创建的ActivityResources

if (activityResources == null) {

activityResources = new ActivityResources();

mActivityResourceReferences.put(activityToken, activityResources);

}

return activityResources;

}如题所示,获取或创建 ActivityResources 。如果存在则返回,否则创建并保存到 ResourcesManager.mActivityResourceReferences中。

-2. updateResourcesForActivity()

ResourcesManager.updateResourcesForActivity()

流程如下:

内部会先获取当前

activity对应的resources(如果不存在,则创建),如果当前传入的配置与之前一致,则直接返回。

否则先使用当前 activity 对应的配置 创建一个 [旧]配置对象,接着去更新该 activity 所有的 resources 具体实现类impl。每次更新时会先与先前的配置进行差异更新并返回新的 ReourcesKey ,并使用这个 key 获取其对应的 impl (如果没有则创建),获取到的 resource 实现类 impl 如果与当前的不一致,则更新当前 resources 的 impl。

-3. findResourcesForActivityLocked()

ResourcesManager.findResourcesForActivityLocked()

流程如下:

当通过 findResourcesForActivityLocked() 获取指定的 resources 时,内部会先获取当前 token 对应的 activityResources ,从而拿到其所有的 resources ;然后遍历所有 resources ,如果某个 resouces 对应的 key(ResourcesKey) 与当前查找的一致并且符合其他规则,则直接返回,否则无符合条件时返回null。

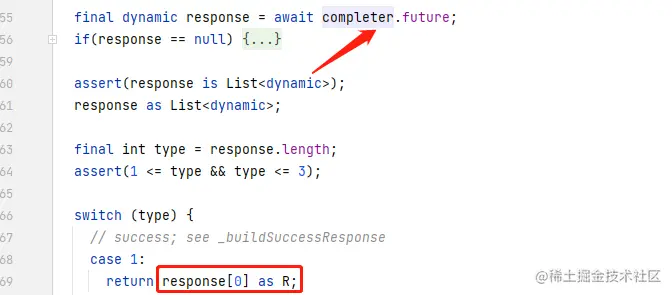

–4.createResourcesForActivity()

ResourcesManager.createResourcesForActivity()

流程如下:

在创建

Resources时,内部会先使用key查找相应的ResourcesImpl,如果没找到,则直接返回null,否则调用createResourcesForActivityLocked()创建新的Resources.

总结

当我们在 Activity、Fragment 中调用 getX() 相关方法时,由于 context 只是一个代理,提供了获取 Resources 的 getx() 方法,具体实现在 ContextImpl。所以在我们的 Activity 被创建之前,会先创建 contextImpl,从而调用 createActivityContext() 这个方法内部完成了对 resources 的初始化。内部会先拿到 ResourcesManager(用于管理我们所有resources),从而调用其的createBaseTokenResources() 去创建所需要的 resources ,然后将其赋值给 contextImpl。

在具体的创建过程中分为如下几步:

- 先从

ResourcesManager缓存 (mActivityResourceReferences) 中去找当前 token(Ibinder) 所对应的ActivityResources,如果没找到则重新创建一个,并将其添加到map中; - 接着再去更新当前

token所关联ActivityResources内部(activityResource)所有的resources,如果现有的配置参数与当前要更新的一致,则跳过更新,否则遍历更新所有resources; - 再去获取所需要的

resources,如果找到则返回,否则开始创建新的resources; - 内部会先去获取

ResourcesImpl,如果不存在则会创建一个新的,然后带上所有配置以及 token 去创建相应的resources,内部也同样会执行一遍第一步,然后再创建ActivityResource,并将其添加到第一步创建的activityResouces中。

Resrouces(Application)

Application 级别的,我们应该从哪里找入口呢?🧐

既然是 Application 级别,那就找找 Application 什么时候初始化?而 Resources 来自 Context ,所以我们要寻找的位置又自然是 ContextImpl 了。故此,我们去看看

->

ContexntImpl.createSystemContext()

该方法用于创建 App 的第一个上下文对象,即也就是 AppContext。

流程分析

ContexntImpl.createSystemContext()

fun createSystemContext(mainThread:ActivityThread) {

// 创建和系统包有关的资源信息

val packageInfo = LoadedApk(mainThread)

...

val context = ContextImpl(xxx)

➡️

context.setResources(packageInfo.getResources())

...

return context

}如上所示,当创建系统 Context 时,会先初始化一个 LoadedApk ,用于管理我们系统包相关信息,然后再创建 ContextImpl ,然后调用创建好的 LoadedApk 的 getResources() 方法获取系统资源对象,并将其设置给我们的 ContextImpl 。

➡️ LoadedApk.getResources()

当我们获取 resources 时,内部会先判断是否存在,如果不存在,则调用 ResourcesManager.getResources() 去获取新的 resources 并返回,否则直接返回现有的。相应的,我们再去看看 ResourcesManager.getResources() 。

➡️➡️ ResourcesManager.getResources()

如上所示,内部会对传入的 activityToken 进行判断,如果为 null ,则调用 createResourceForActivity() 去创建;否则调用 createResources() 去创建,具体内部的逻辑和最开始相似,内部会先使用 key 查找相应的 ResourcesImpl ,如果没找到,则分别调用相关方法再去创建 Resources 。

关于 createResourceLocked() ,我们再看一眼,如下所示:

这个方法内部创建了一个新的resources, 最终将其add到了ResourcesManager.mResourceReferences这个List中,以便复用。

总结

当我们的 App 启动后,初始化 Application 时,会调用到 ContexntImpl.createSystemContext() ,该方法内部同时也会完成对我们Resources 的初始化。内部流程如下:

- 先初始化

LoadedApk对象(其用于管理app的信息),再调用其的getResources()方法获取具体的Resources; - 在上述方法内部,会先判断当前

resources是否为 null。 如果为null,则使用ResourcesManager.getResources()去获取,因为这是application的初始化,所以不存在activityToken,故内部会直接调用ResourceManager.createResource()方法,内部会创建一个新的Resources并将其添加到mResourceReferences缓存中。

Resources(System)

大家都应该见过这样的代码,比如 Resources.getSystem().getX() , 而他内部的实现也非常简单,如下所示:

Tips

当我们使用 Resources.getSystem() 时,其实也就是在调用当前 framework 层的资源对象,内部会先判断是否为 null,然后进行初始化,初始化的过程中,因为系统框架层的资源,所以实际的资源管理器直接调用了 AssetManager.getSystem() ,这个方法内部会使用当前系统框架层的apk作为资源路径。所以我们自然也无法用它去加载我们 Apk 内部的资源文件。

小问题

在了解了上述流程后,如果你存在以下问题(就是这么倔强🫡),那么不妨鼓励鼓励自己,[你没掉队]!

- 为什么要存在 ActivityResources 与 ActivityResource ? 我们一直调用的不都是Resources吗?

首先说说

ActivityResource,见名知意,它是作为Resources的包装类型出现,内部持有当前要加载的配置,以及真正的Resources,以便配置变更时更新 resources。

又因为一个

Activity可能关联多个Resources,所以ActivityResources是一个activity(或者windowsContext) 的所有resources合集,内部用一个List维护,而ActivityResources又被ResourcesManager缓存着。

当我们每次初始化Act时,内部都会创建相应的

ActResources,并将其添加到manager中作为缓存。最终的resources 只是一个代理对象,从而供开发者调用, 真正的实现者ResourcesImpl则被全局缓存。

- Resources.getSystem() 获取应用drawable,为什么会报错?

原因也很简单啊,因为

resources相应的AssetManager对应的资源路径时frameWork啊,你让它获取当前应用资源,它不造啊。🥲

结语

最终,让我们反推上去,总体再来回顾一下 Resources 初始化的相关👨🔧:

- 原来我们的

resources都是在context创建时初始化,而且我们所调用的resources实际上被ActivityResource所包装; - 原来我们的

Resources只是一个代理,最终的调用其实是ResourcesImpl,并且被ResourcesManager所缓存。 - 原来每当我们初始化一个

Activity,我们所有的resources都会被刷新,为什么呢,因为我们的 config 配置可能会改变,比如深色模式切换等。 - 原来

Resource.getSystem()无法加载应用资源的原因只是因为AssetManager对应的资源路径是frameWork.apk。

本篇中,我们专注于一个概念,即:resources 到底从何而来,并且从原理上分析了不同context

resources的初始化流程,也明白了他们之间的区别与差异。

细心的小伙伴会发现,从上一篇,我们从应用层

Resources.getx()开始,到现在Resources初始化。我们沿着开发者的使用习惯由浅入深,去探索底层设计,逐渐理清 Android Resources 的整体脉络。

下一篇我将同大家分析

ResourcesManager,并且解释诸多为什么,从而探索其背后的设计思想 :)

关于我

我是 Petterp ,一个 Android工程师 ,如果本文对你有所帮助,欢迎点赞支持,你的支持是我持续创作的最大鼓励!

链接:https://juejin.cn/post/7166243062077718535

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Android面试题-2022

1 wait和 sleep 的区别

wait是Object的方法,wait是对象锁,锁定方法不让继续执行,当执行notify方法后就会继续执行,sleep 是Thread的方法,sleep 是使线程睡眠,让出cpu,结束后自动继续执行

2 View和SurfaceView的区别

View基于主线程刷新UI,SurfaceView子线程又可以刷新UI

3. View的绘制原理

View为所有图形控件的基类,View的绘制由3个函数完成

measure,计算视图的大小

layout,提供视图要显示的位置

draw,绘制

4. 简述TCP,UDP,Socket

TCP是经过3次握手,4次挥手完成一串数据的传送

UDP是无连接的,知道IP地址和端口号,向其发送数据即可,不管数据是否发送成功

Socket是一种不同计算机,实时连接,比如说传送文件,即时通讯

5.进程和线程的区别

概念:进程包括多个线程,一个程序一个进程,多线程的优点可以提高执行效率,提高资源利用率

创建:Thread类和Runnable接口,

常用方法有:

start()用于启动线程

run()调用线程对象中的run方法

join()合并插队到当前线程

sellp()睡眠释放cpu资源

setPriority()设置线程优先级

6.RecyclerView和ListView的区别

缓存上:前者缓存的是View+ViewHolder+flag,不用每次调用findViewById,后者则只是缓存View

刷新数据方面,前者提供了局部刷新,后者则全部刷新

7.MVC ,MVP,MVVM

MVC:View是可以直接访问Model的!从而,View里会包含Model信息,不可避免的还要包括一些 业务逻辑。 在MVC模型里,更关注的Model的不变,而同时有多个对Model的不同显示,及View。所以,在MVC模型里,Model不依赖于View,但是 View是依赖于Model的。不仅如此,因为有一些业务逻辑在View里实现了,导致要更改View也是比较困难的,至少那些业务逻辑是无法重用的。

MVP:MVP 是从经典的模式MVC演变而来,它们的基本思想有相通的地方:Controller/Presenter负责逻辑的处理,Model提供数据,View负 责显示。作为一种新的模式,MVP与MVC有着一个重大的区别:在MVP中View并不直接使用Model,它们之间的通信是通过Presenter (MVC中的Controller)来进行的,所有的交互都发生在Presenter内部,而在MVC中View会从直接Model中读取数据而不是通过 Controller。

MVVM:数据双向绑定,通过数据驱动UI,M提供数据,V视图,VM即数据驱动层

8.说下 Activity 跟 跟 window , view 之间的关系?

Activity 创建时通过 attach()初始化了一个 Window 也就是PhoneWindow,一个 PhoneWindow 持有一个DecorView 的实例,DecorView 本身是一个 FrameLayout,继承于 View,Activty 通过setContentView 将xml 布局控件不断 addView()添加到 View 中,最终显示到 Window 于我们交互;

9.Java中堆和栈的理解

在Java中内存分为两种,一种是栈内存,另一种是堆内存

堆内存:用于存储Java中的对象和数组,当我们new一个对象或创建一个数组的时候,就会在堆内存中开辟一段空间给它,用于存放,堆内存的特点:先进先出,后今后出,②可以动态的分配内存的大小,生存期不必告诉编译器,但存取速度较慢;

栈内存:主要用来执行程序用,比如基本类型的变量和对象的引用变量,其特点:①先进后出,后进后出,②存取速度比堆快,仅次于寄存器,栈数据可以共享,但其在栈中的数据大小和生存期必须是确定的;

栈内存和堆内存都属于Java内存的一种,系统会自动去回收它,但对于堆内存开发人员一般会自动回收。

栈是一块和线程紧密相关的内存区域,每个线程都有自己的栈内存,用于存储本地变量、方法参数和栈调用一个线程中存储的变量,对于其他线程是不可见的,而堆是所有线程共享的一个公用内存区域,对象都在堆里创建,但为了提升效率,线程会从堆中拷贝一个缓存到自己的栈中,如果多个线程使用该变量,就可能引发问题,这是volatile修饰变量就可以发挥作用,他要求线程从主存中读取变量的值。

10.Android常用的数据存储方式(4种)

使用SharedPreference存储:保存基于xml文件存储的key-value键值对数据,通常用来存储一些简单的配置信息;

文件存储方式:Context提供了两个方法来打开数据文件的文件IO流;

SQLite存储数据:SQLite是轻量级的嵌入式数据库引擎,支持SQL语言;

网络存储数据:通过网络存储数据;

11.Activity生命周期中的7个方法:

onCreate( ):当Activity被创建时调用;

onStart( ):当Activity被创建后将可见时调用;

onResume( ):(继续开始)当Activity位于设备最前端,对用户可见时调用;

onPause( ):(暂停)当另一个Activity遮挡当前Activity,当前Activity被切换到后台时调用;

onRestart( ):(重新启动)当另一个Activity执行完onStop()方法,又被用户打开时调用;

onStop( ):如果另一个Activity完全遮挡了当前Activity时,该方法被调用;

onDestory( ):当Activity被销毁时调用;

12.Activity的四种启动模式

standard、singleTop、singleTask和singleInstance,他们是在配置文件中通过android:LauchMode属性配置;

standard:默认的启动模式,每次启动会在任务栈中新建一个启动的Activity的实例;

SingleTop:如果要启动的Activity实例已位于栈顶,则不会重新创建该Activity的实例,否则会产生一个新的运行实例;

SingleTask:如果栈中有该Activity实例,则直接启动,中间的Activity实例将会被关闭,关闭的顺序与启动的顺序相同;

SingleInstance:该启动模式会在启动一个Activity时,启动一个新的任务栈,将该Activity实例放置在这个任务栈中,并且该任务栈中不会再保存其他的Activity实例;

Activity任务栈:即存放Activity任务的栈,每打开一个Activity时就会往Activity栈中压入一个Activity

任务,每当销毁一个Activity的时候,就会从Activity任务栈中弹出一个Activity任务,

由于安卓手机的限制,只能从手机屏幕获取当前一个Activity的焦点,即栈顶元素(

最上面的Activity),其余的Activity会暂居后台等待系统的调用;

13.View的绘制原理

View为所有图形控件的基类,View的绘制由3个函数完成

measure,计算视图的大小

layout,提供视图要显示的位置

draw,绘制

14.Okhttp连接池复用机制

15. Rxjava里面有几个角色

Observable:俗称被订阅者,被订阅者是事件的来源,接收订阅者(Observer)的订阅,然后通过发射器(Emitter)发射数据给订阅者。

Observer:俗称订阅者,注册过程传给被订阅者,订阅者监听开始订阅,监听订阅过程中会把Disposable传给订阅者,然后在被订阅者中的发射器(Emitter)发射数据给订阅者(Observer)。

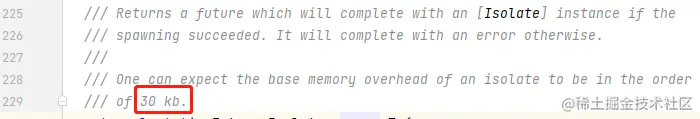

Emitter:俗称发射器,在发射器中会接收下游的订阅者(Observer),然后在发射器相应的方法把数据传给订阅者(Observer)。

Consumer:俗称消费器,消费器其实是Observer的一种变体,Observer的每一个方法都会对应一个Consumer,比如Observer的onNext、onError、onComplete、onSubscribe都会对应一个Consumer。

Disposable:是释放器,通常有两种方式会返回Disposable,一个是在Observer的onSubscribe方法回调回来,第二个是在subscribe订阅方法传consumer的时候会返回

16.RxJava操作符包含的操作符类型有如下几种:

1、创建操作符 :创建被观察者(Observable)对象&发送事件

2、转换操作符:变换被观察者(Observable)发送的事件。将Observable发送的数据按照一定的规则做一些变换,然后再将变换的数据发射出去。变换的操作符有map,flatMap,concatMap,switchMap,buffer,groupBy等等。

3、 合并操作符:组合多个被观察者(Observable)&合并需要发送的事件。包含:concatMap(),concat(), merge(),mergeArray(),concateArray(),reduce(),collect(),startWith(),zip(),count()等

4、功能操作符:辅助被观察者(Observable) 发送事件时实现一些功能性需求,如错误处理,线程调度。

5、过滤操作符:用于将Observable发送的数据进行过滤和选择。让Observable返回我们所需要的数据。过滤操作符有buffer(),filter(),skip(),take(),skipLast(),takeLast(),throttleFirst(),distainctUntilChange()。

链接:https://juejin.cn/post/7166415061089517582

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

如何优雅地校验后端接口数据,不做前端背锅侠

背景

最近新接手了一批项目,还没来得及接新需求,一大堆bug就接踵而至,仔细一看,应该返回数组的字段返回了 null,或者没有返回,甚至返回了字符串 "null"???

这我能忍?我立刻截图发到群里,用红框加大加粗重点标出。后端同学也积极响应,答应改正。

第二天,同样的事情又在其他的项目上演,我只是一个小前端,为什么什么错都找我啊!!

日子不能再这样下去,于是我决定写一个工具来解决遇到 bug 永远在找前端的困境。

TypeScript 运行时校验

如何对接口数据进行校验呢,因为我们的项目是 React+TypeScript 写的,所以第一时间就想到了使用 TypeScript 进行数据校验。但是众所周知,TypeScript 用于编译时校验,有没有办法作用到运行时呢?

我还真找到了一些运行时类型校验的库:typescript-needs-types,大部分需要使用指定格式编写代码,相当于对项目进行重构,拿其中 star 最多的 zod 举例,代码如下。

import { z } from "zod";

const User = z.object({

username: z.string(),

});

User.parse({ username: "Ludwig" });

// extract the inferred type

type User = z.infer<typeof User>;

// { username: string }我宁可查 bug 也不可能重构手里一大堆项目啊。此种方案 ❎。

此时看到了 typescript-json-schema 可以把 TypeScript 定义转为 JSON Schema ,然后再使用 JSON Schema 对数据进行校验就可以啦。这种方案比较灵活,且对代码入侵性较小。

搭建一个项目测试一下!

使用 npx create-react-app my-app --template typescript 快速创建一个 React+TS 项目。

首先安装依赖 npm install typescript-json-schema

创建类型文件 src/types/user.ts

export interface IUserInfo {

staffId: number

name: string

email: string

}然后创建 src/types/index.ts 文件并引入刚才的类型。

import { IUserInfo } from './user';

interface ILabel {

id: number;

name: string;

color: string;

remark?: string;

}

type ILabelArray = ILabel[];

type IUserInfoAlias = IUserInfo;接下来在 package.json 添加脚本

"scripts": {

// ...

"json": "typescript-json-schema src/types/index.ts '*' -o src/types/index.json --id=api --required --strictNullChecks"

}然后运行 npm run json 可以看到新建了一个 src/types/index.json 文件(此步在已有项目中可能会报错报错,可以尝试在 json 命令中添加 --ignoreErrors 参数),打开文件可以看到已经成功转成了 JSON Schema 格式。

{

"$id": "api",

"$schema": "http://json-schema.org/draft-07/schema#",

"definitions": {

"ILabel": {

"properties": {

"color": {

"type": "string"

},

"id": {

"type": "number"

},

"name": {

"type": "string"

},

"remark": {

"type": "string"

}

},

"required": [

"color",

"id",

"name"

],

"type": "object"

},

"ILabelArray": {

"items": {

"$ref": "api#/definitions/ILabel"

},

"type": "array"

},

"IUserInfoAlias": {

"properties": {

"email": {

"type": "string"

},

"name": {

"type": "string"

},

"staffId": {

"type": "number"

}

},

"required": [

"email",

"name",

"staffId"

],

"type": "object"

}

}

}使用 JSON Schema 校验数据

至于如何使用JSON Schema 校验数据,我找到了现成的库 ajv,至于为什么选择 ajv,主要是因为它说它很快,详见:github.com/ebdrup/json…

接下来尝试一下。我找到了中文版文档,有兴趣的可以去看下 http://www.febeacon.com/ajv-docs-zh…

先安装依赖 npm install ajv,然后创建文件 src/validate.ts

import Ajv from 'ajv';

import schema from './types/index.json';

const ajv = new Ajv({ schemas: [schema] });

export function validateDataByType(type: string, data: unknown) {

console.log(`开始校验,类型:${type}, 数据:`, data);

var validate = ajv.getSchema(`api#/definitions/${type}`);

if (validate) {

const valid = validate(data);

if (!valid) {

console.log('校验失败', validate.errors);

}

else {

console.log('校验成功');

}

}

}接下来在 src/index.tsx 添加下面代码来测试一下。

validateDataByType('IUserInfoAlias', {

email: 'idonteatcookie@gmail.com',

name: 'idonteatcookie',

staffId: 12306

})

validateDataByType('IUserInfoAlias', {

email: 'idonteatcookie@gmail.com',

staffId: 12306

})

validateDataByType('IUserInfoAlias', {

email: 'idonteatcookie@gmail.com',

name: 'idonteatcookie',

staffId: '12306'

})可以在控制台看到成功打印如下信息:

拦截请求

因为项目中发送请求都是调用统一封装的函数,所以我首先想到的是在函数中增加一层校验逻辑。但是这样的话就与项目代码耦合严重,换一个项目又要再写一份。我真的有好多项目QAQ。

那干脆拦截所有请求统一处理好了。

很容易的找到了拦截所有 XMLHttpRequest 请求的库 ajax-hook,可以非常简单地对请求做处理。

首先安装依赖 npm install ajax-hook,然后创建 src/interceptTool.ts:

import { proxy } from 'ajax-hook';

export function intercept() {

// 获取 XMLHttpRequest 发送的请求

proxy({

onResponse: (response: any, handler: any) => {

console.log('xhr', response.response)

handler.next(response);

},

});

}这样就拦截了所有的 XMLHttpRequest 发送的请求,但是我突然想到我们的项目,好像使用 fetch 发送的请求来着???

好叭,那就再拦截一遍 fetch 发送的请求。

export function intercept() {

// ...

const { fetch: originalFetch } = window;

// 获取 fetch 发送的请求

window.fetch = async (...args) => {

const response = await originalFetch(...args);

response.json().then((data: { result: any }) => {

console.log('window.fetch', args, data);

return data;

});

return response;

};

}为了证明拦截成功,使用 json-server 搭建一个本地 mock 服务器。首先安装 npm install json-server,然后在根目录创建文件 db.json:

{

"user": { "staffId": 1, "name": "cookie1", "email": "cookie@cookie.com" },

"labels": [

{

"id": 1,

"name": "ck",

"color": "red",

"remark": "blabla"

},

{

"id": 2,

"color": "green"

}

]

}再在 package.json 添加脚本

"scripts": {

"serve": "json-server --watch db.json -p 8000"

},现在执行 npm run serve 就可以启动服务器了。在 src/index.tsx 增加调用接口的代码,并引入 src/interceptTool.ts。

import { intercept } from './interceptTool';

// ... other code

intercept();

fetch('http://localhost:8000/user');

const xhr = new XMLHttpRequest();

xhr.open('GET', 'http://localhost:8000/labels');

xhr.send();可以看到两种请求都拦截成功了。

校验接口返回数据

胜利在望,只差最后一步,校验返回数据。我们校验数据需要提供两个关键信息,数据本身和对应的类型名,为了将两者对应起来,需要再创建一个映射文件,把 url 和类型名对应起来。

我们在 src/validate.ts 新增函数 validateDataByUrl

export function validateDataByUrl(url: string, data: unknown) {

const type = urlMapType[url as keyof typeof urlMapType];

if (!type) {

// 没有定义对应格式不进行校验

return;

}

console.log(`==== 开始校验 === url ${url}`);

validateDataByType(type, data);

}然后在 src/interceptTool.ts 文件中引用

import { proxy } from 'ajax-hook';

import { validateDataByUrl } from './validate';

export function intercept() {

// 获取 XMLHttpRequest 发送的请求

proxy({

onResponse: (response, handler: any) => {

validateDataByUrl(response.config.url, JSON.parse(response.response));

handler.next(response);

},

});

const { fetch: originalFetch } = window;

// 获取 fetch 发送的请求

window.fetch = async (...args) => {

const response = await originalFetch(...args);

response.json().then((data: any) => {

validateDataByUrl(args[0] as string, data);

return data;

});

return response;

};

}现在可以在控制台看到接口数据校验的接口辣~ ✿✿ヽ(°▽°)ノ✿

总结下流程图

后续规划

目前所做的事情,准确的说不是拦截,只是获取返回数据,然后对比打印校验结果,因为初步目标不涉及数据的处理。

后续会考虑对不合法的数据进行处理,比如应该返回数组但是返回了 null 的情况,如果能自动赋值 [],就可以防止前端页面崩溃的情况了。

参考资料

作者:我不吃饼干

来源:juejin.cn/post/7166061734803963917

原生 canvas 如何实现大屏?

前言

可视化大屏该如何做?有可能一天完成吗?废话不多说,直接看效果,线上 Demo 地址 lxfu1.github.io/large-scree…。

看完这篇文章(这个项目),你将收获:

全局状态真的很简单,你只需 5 分钟就能上手

如何缓存函数,当入参不变时,直接使用缓存值

千万节点的图如何分片渲染,不卡顿页面操作

项目单测该如何写?

如何用 canvas 绘制各种图表,如何实现 canvas 动画

如何自动化部署自己的大屏网站

实现

项目基于 Create React App --template typescript搭建,包管理工具使用的 pnpm ,pnpm 的优势这里不多介绍(快+节省磁盘空间),之前在其它平台写过相关文章,后续可能会搬过来。由于项目 package.json 里面有限制包版本(最新版本的 G6 会导致 OOM,官方短时间能应该会修复),如果使用的 yarn 或 npm 的话,改为对应的 resolutions 即可。

"pnpm": {

"overrides": {

"@antv/g6": "4.7.10"

}

}

"resolutions": {

"@antv/g6": "4.7.10"

},启动

clone项目

git clone https://github.com/lxfu1/large-screen-visualization.gitpnpm 安装

npm install -g pnpm启动:

pnpm start即可,建议配置 alias ,可以简化各种命令的简写 eg:p start,不出意外的话,你可以通过 http://localhost:3000/ 访问了测试:

p test构建:

p build

强烈建议大家先 clone 项目!

分析

全局状态

全局状态用的 valtio ,位于项目 src/models目录下,强烈推荐。

优点:数据与视图分离的心智模型,不再需要在 React 组件或 hooks 里用 useState 和 useReducer 定义数据,或者在 useEffect 里发送初始化请求,或者考虑用 context 还是 props 传递数据。

缺点:兼容性,基于 proxy 开发,对低版本浏览器不友好,当然,大屏应该也不会考虑 IE 这类浏览器。

import { proxy } from "valtio";

import { NodeConfig } from "@ant-design/graphs";

type IState = {

sliderWidth: number;

sliderHeight: number;

selected: NodeConfig | null;

};

export const state: IState = proxy({

sliderWidth: 0,

sliderHeight: 0,

selected: null,

});状态更新:

import { state } from "src/models";

state.selected = e.item?.getModel() as NodeConfig;状态消费:

import { useSnapshot } from "valtio";

import { state } from "src/models";

export const BarComponent = () => {

const snap = useSnapshot(state);

console.log(snap.selected)

}当我们选中图谱节点的时候,由于 BarComponent 组件监听了 selected 状态,所以该组件会进行更新。有没有感觉非常简单?一些高级用法建议大家去官网查看,不再展开。

函数缓存

为什么需要函数缓存?当然,在这个项目中函数缓存比较鸡肋,为了用而用,试想,如果有一个函数计算量非常大,组件内又有多个 state 频繁更新,怎么确保函数不被重复调用呢?可能大家会想到 useMemo``useCallback等手段,这里要介绍的是 React 官方的 cache 方法,已经在 React 内部使用,但未暴露。实现上借鉴(抄袭)ReactCache,通过缓存的函数 fn 及其参数列表来构建一个 cacheNode 链表,然后基于链表最后一项的状态来作为函数 fn 与该组参数的计算缓存结果。

代码位于 src/utils/cache

interface CacheNode {

/**

* 节点状态

* - 0:未执行

* - 1:已执行

* - 2:出错

*/

s: 0 | 1 | 2;

// 缓存值

v: unknown;

// 特殊类型(object,fn),使用 weakMap 存储,避免内存泄露

o: WeakMap<Function | object, CacheNode> | null;

// 基本类型

p: Map<Function | object, CacheNode> | null;

}

const cacheContainer = new WeakMap<Function, CacheNode>();

export const cache = (fn: Function): Function => {

const UNTERMINATED = 0;

const TERMINATED = 1;

const ERRORED = 2;

const createCacheNode = (): CacheNode => {

return {

s: UNTERMINATED,

v: undefined,

o: null,

p: null,

};

};

return function () {

let cacheNode = cacheContainer.get(fn);

if (!cacheNode) {

cacheNode = createCacheNode();

cacheContainer.set(fn, cacheNode);

}

for (let i = 0; i < arguments.length; i++) {

const arg = arguments[i];

// 使用 weakMap 存储,避免内存泄露

if (

typeof arg === "function" ||

(typeof arg === "object" && arg !== null)

) {

let objectCache: CacheNode["o"] = cacheNode.o;

if (objectCache === null) {

objectCache = cacheNode.o = new WeakMap();

}

let objectNode = objectCache.get(arg);

if (objectNode === undefined) {

cacheNode = createCacheNode();

objectCache.set(arg, cacheNode);

} else {

cacheNode = objectNode;

}

} else {

let primitiveCache: CacheNode["p"] = cacheNode.p;

if (primitiveCache === null) {

primitiveCache = cacheNode.p = new Map();

}

let primitiveNode = primitiveCache.get(arg);

if (primitiveNode === undefined) {

cacheNode = createCacheNode();

primitiveCache.set(arg, cacheNode);

} else {

cacheNode = primitiveNode;

}

}

}

if (cacheNode.s === TERMINATED) return cacheNode.v;

if (cacheNode.s === ERRORED) {

throw cacheNode.v;

}

try {

const res = fn.apply(null, arguments as any);

cacheNode.v = res;

cacheNode.s = TERMINATED;

return res;

} catch (err) {

cacheNode.v = err;

cacheNode.s = ERRORED;

throw err;

}

};

};如何验证呢?我们可以简单看下单测,位于src/__tests__/utils/cache.test.ts:

import { cache } from "src/utils";

describe("cache", () => {

const primitivefn = jest.fn((a, b, c) => {

return a + b + c;

});

it("primitive", () => {

const cacheFn = cache(primitivefn);

const res1 = cacheFn(1, 2, 3);

const res2 = cacheFn(1, 2, 3);

expect(res1).toBe(res2);

expect(primitivefn).toBeCalledTimes(1);

});

});可以看出,即使我们调用了 2 次 cacheFn,由于入参不变,fn 只被执行了一次,第二次直接返回了第一次的结果。

项目里面在做 circle 动画的时候使用了,因为该动画是绕圆周无限循环的,当循环过一周之后,后的动画和之前的完全一致,没必要再次计算对应的 circle 坐标,所以我们使用了 cache ,位于src/components/background/index.tsx。

const cacheGetPoint = cache(getPoint);

let p = 0;

const animate = () => {

if (p >= 1) p = 0;

const { x, y } = cacheGetPoint(p);

ctx.clearRect(0, 0, 2 * clearR, 2 * clearR);

createCircle(aCtx, x, y, circleR, "#fff", 6);

p += 0.001;

requestAnimationFrame(animate);

};

animate();分片渲染

你有审查元素吗?项目背景图是通过 canvas 绘制的,并不是背景图片!通过 canvas 绘制如此多的小圆点,会不会阻碍页面操作呢?当数据量足够大的时候,是会阻碍的,大家可以把 NodeMargin 设置为 0.1 ,同时把 schduler 调用去掉,直接改为同步绘制。当节点数量在 500 W 的时候,如果没有开启切片,页面白屏时间在 MacBook Pro M1 上白屏时间大概是 8.5 S;开启分片渲染时页面不会出现白屏,而是从左到右逐步绘制背景图,每个任务的执行时间在 16S 左右波动。

const schduler = (tasks: Function[]) => {

const DEFAULT_RUNTIME = 16;

const { port1, port2 } = new MessageChannel();

let isAbort = false;

const promise: Promise<any> = new Promise((resolve, reject) => {

const runner = () => {

const preTime = performance.now();

if (isAbort) {

return reject();

}

do {

if (tasks.length === 0) {

return resolve([]);

}

const task = tasks.shift();

task?.();

} while (performance.now() - preTime < DEFAULT_RUNTIME);

port2.postMessage("");

};

port1.onmessage = () => {

runner();

};

});

// @ts-ignore

promise.abort = () => {

isAbort = true;

};

port2.postMessage("");

return promise;

};分片渲染可以不阻碍用户操作,但延迟了任务的整体时长,是否开启还是取决于数据量。如果每个分片实际执行时间大于 16ms 也会造成阻塞,并且会堆积,并且任务执行的时候没有等,最终渲染状态和预期不一致,所以 task 的拆分也很重要。

单测

这里不想多说,大家可以运行 pnpm test看看效果,环境已经搭建好;由于项目里面用到了 canvas 所以需要 mock 一些环境,这里的 mock 可以理解为“我们前端代码跑在浏览器里运行,依赖了浏览器环境以及对应的 API,但由于单测没有跑在浏览器里面,所以需要 mock 浏览器环境”,例如项目里面设置的 jsdom、jest-canvas-mock 以及 worker 等,更多推荐直接访问 jest 官网。

// jest-dom adds custom jest matchers for asserting on DOM nodes.

import "@testing-library/jest-dom";

Object.defineProperty(URL, "createObjectURL", {

writable: true,

value: jest.fn(),

});

class Worker {

onmessage: () => void;

url: string;

constructor(stringUrl) {

this.url = stringUrl;

this.onmessage = () => {};

}

postMessage() {

this.onmessage();

}

terminate() {}

onmessageerror() {}

addEventListener() {}

removeEventListener() {}

dispatchEvent(): boolean {

return true;

}

onerror() {}

}

window.Worker = Worker;自动化部署

开发过项目的同学都知道,前端编写的代码最终是要进行部署的,目前比较流行的是前后端分离,前端独立部署,通过 proxy 的方式请求后端服务;或者是将前端构建产物推到后端服务上,和后端一起部署。如何做自动化部署呢,对于一些不依赖后端的项目来说,我们可以借助 github 提供的 gh-pages 服务来做自动化部署,CI、CD 仅需配置对应的 actions 即可,在仓库 settings/pages 下面选择对应分支即可完成部署。

例如项目里面的.github/workflows/gh-pages.yml,表示当 master 分支有代码提交时,会执行对应的 jobs,并借助 peaceiris/actions-gh-pages@v3将构建产物同步到 gh-pages 分支。

name: github pages

on:

push:

branches:

- master # default branch

env:

CI: false

PUBLIC_URL: '/large-screen-visualization'

jobs:

deploy:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- run: yarn

- run: yarn build

- name: Deploy

uses: peaceiris/actions-gh-pages@v3

with:

github_token: ${{ secrets.GITHUB_TOKEN }}

publish_dir: ./build总结

写文档不易,如果看完有收获,记得给个小星星!欢迎大家 PR!

作者:小丑竟然是我

来源:juejin.cn/post/7165564571128692773

收起阅读 »Flutter如何将文本与图片混合编辑?(功能扩展篇)

前言

一个优秀的富文本,应该包含优秀的排版算法、丰富的功能和渲染的高性能。在上一篇中,我们实现了可扩展的、基础的富文本编辑器。那么在本文中,让我们对富文本进行更多功能的扩展。

注:

— 为了在阅读本文时有更好的体验,请先阅读本专栏第一篇,前文涉及到的知识点,本文不再赘述。(摸鱼的朋友请忽略)

— 完整代码太多, 文章只分析核心代码,需要源码请到 代码仓库

文本与图片混排

在有关富文本的业务需求中,或其他文章渲染中,图文混排的功能是十分重要的。在Flutter中,为了解决这个图文混排的问题,有一个很方便的组件:WidgetSpan。而在本专栏的第一篇的文本基础知识中,已经分析了TextSpan在文本渲染过程中的作用。那么WidgetSpan是如何被渲染的呢,Flutter又是如何将TextSpan与WidgetSpan混合渲染在一起的呢?

—— 效果图完整代码在仓库demo/image_text

因为Flutter提供了WidgetSpan,所以效果图中的布局十分简单:

Widget _widgetSpan() {

return Text.rich(TextSpan(

children: <InlineSpan>[

const TextSpan(text: 'Hello'),

WidgetSpan(

child:

...

//显示本地图片

Image.file(

_image!,

width: width,

height: height,

),

...

),

const TextSpan(text: 'Taxze!'),

],

));

}在之前的文章中,我们已经知道RichText实际上是需要一个InlineSpan,而TextSpan和WidgetSpan(中间还有个PlaceholderSpan)都是InlineSpan的子类实现。RichText最后会将InlineSpan传入RenderParagraph中。那么这个InlineSpan是一个什么样的呢?

InlineSpan树的结构

现在将目光先移到Text()和Text.rich()的构造函数上,我们可以看到,在Text()组件中,它的构造函数只有一个必要参数:data,且textSpan = null,而在Text.rich()的构造函数中,也只有一个必要参数:textSpan。

const Text(

String this.data, {

super.key,

...

}) : textSpan = null;

const Text.rich(

InlineSpan this.textSpan, {

super.key,

...

}) : data = null;然后将目光移到build上,在其主要逻辑中,我们可以发现,RichText在构造时传入的text是一个TextSpan,当采用data作为必要参数传入时,text参数才会有值,当采用textSpan作为参数传入时,children才不会为null。

@override

Widget build(BuildContext context) {

Widget result = RichText(

...

text: TextSpan(

style: effectiveTextStyle,

text: data,

children: textSpan != null ? <InlineSpan>[textSpan!] : null,

),

);

...

return result;

}经过上面的分析之后,我们可以将树的结构总结为两张图:

- 当采用

data作为必要参数传入时,树中只会存在一个根节点

- 当采用

textSpan作为参数传入时,树中会存在多个子树

树中的每一个TextSpan都包含text和style,其中的style是文本样式,如果没有设置某一个节点的样式,那么它会继承父节点中的样式。若根节点也没有自定义样式,那么就会采用默认的样式值。

WidgetSpan混入InlineSpan树结构

将目光移到RichText的createRenderObject方法上,可以看到RichText创建的渲染对象为RenderParagraph,并且将InlineSpan传入。

@override

RenderParagraph createRenderObject(BuildContext context) {

return RenderParagraph(

text, //InlineSpan

...

);

}再将目光移到RenderParagraph的performLayout函数上,它是RenderParagraph的重要逻辑,用于计算RenderParagraph的尺寸和child的绘制位置。

@override

void performLayout() {

final BoxConstraints constraints = this.constraints;

_placeholderDimensions = _layoutChildren(constraints);

_layoutTextWithConstraints(constraints);

_setParentData();

final Size textSize = _textPainter.size;

final bool textDidExceedMaxLines = _textPainter.didExceedMaxLines;

size = constraints.constrain(textSize);

...

}但是,这里计算的child不是TextSpan,而是PlaceholderSpan。通过_extractPlaceholderSpans挑选出所有的PlaceholderSpan,visitChildren是InlineSpan中的方法,通过该方法能遍历InlineSpan树。

late List<PlaceholderSpan> _placeholderSpans;

void _extractPlaceholderSpans(InlineSpan span) {

_placeholderSpans = <PlaceholderSpan>[];

span.visitChildren((InlineSpan span) {

//判断是否为PlaceholderSpan

if (span is PlaceholderSpan) {

_placeholderSpans.add(span);

}

return true;

});

}到这里,对于InlineSpan树的结构已经清晰了,在树中,除了TextSpan,还存在着PlaceholderSpan类型的节点,而WidgetSpan又是继承于PlaceholderSpan的。

不过,PlaceholderSpan只是一个占位节点,RenderParagraph并不会对其进行绘制,RenderParagraph只负责确定它的大小和需要绘制的位置。RenderParagraph只需在布局的时候,将这个绘制的区域预留给WidgetSpan,这样绘制时就不会改变树的结构。

计算WidgetSpan的绘制区域

performLayout是RenderParagraph的布局函数,performLayout内部主要调用了三个函数:

final BoxConstraints constraints = this.constraints;

_placeholderDimensions = _layoutChildren(constraints);

_layoutTextWithConstraints(constraints);

_setParentData();

_layoutChildren函数主要是用于计算确认PlaceholderSpan占位节点的大小。

List<PlaceholderDimensions> _layoutChildren(BoxConstraints constraints, {bool dry = false}) {

final List<PlaceholderDimensions> placeholderDimensions = List<PlaceholderDimensions>.filled(childCount, PlaceholderDimensions.empty);

while (child != null) {

if (!dry) {

...

childSize = child.size;

} else {

childSize = child.getDryLayout(boxConstraints);

}

placeholderDimensions[childIndex] = PlaceholderDimensions(

size: childSize,

alignment: _placeholderSpans[childIndex].alignment,

baseline: _placeholderSpans[childIndex].baseline,

baselineOffset: baselineOffset,

);

child = childAfter(child);

childIndex += 1;

}

return placeholderDimensions;

}

_setParentData此函数用于将父节点的设置给子节点,具体的计算(尺寸计算、偏移计算)都在_layoutTextWithConstraints函数中完成。

void _setParentData() {

...

while (child != null && childIndex < _textPainter.inlinePlaceholderBoxes!.length) {

final TextParentData textParentData = child.parentData! as TextParentData;

textParentData.offset = Offset(

_textPainter.inlinePlaceholderBoxes![childIndex].left,

_textPainter.inlinePlaceholderBoxes![childIndex].top,

);

textParentData.scale = _textPainter.inlinePlaceholderScales![childIndex];

child = childAfter(child);

childIndex += 1;

}

}

_layoutTextWithConstraints此函数包含主要的布局逻辑。其中的_textPainter是RichText将text传入RenderParagraph时,RenderParagraph将text保存在_textPainter中。setPlaceholderDimensions方法用于设置InlineSpan树中每个占位符的尺寸。

void _layoutTextWithConstraints(BoxConstraints constraints) {

_textPainter.setPlaceholderDimensions(_placeholderDimensions);

_layoutText(minWidth: constraints.minWidth, maxWidth: constraints.maxWidth);

}

在

setPlaceholderDimensions将各占位节点尺寸设置完成之后,会调用_layoutText来进行 布局。

void _layoutText({ double minWidth = 0.0, double maxWidth = double.infinity }) {

final bool widthMatters = softWrap || overflow == TextOverflow.ellipsis;

//_textPainter包含节点的尺寸。

_textPainter.layout(

minWidth: minWidth,

maxWidth: widthMatters ?

maxWidth :

double.infinity,

);

}

调用

layout方法,就代表着进入了TextPainter,开始创建ParagraphBuilder,然后进入引擎层开始绘制。

到这里,我们已经了解了图文混排中的图,是如何被混入文本一起渲染的了。下面让我们开始探索,如何将文本与图片放在一起编辑。

文本与图片混合编辑

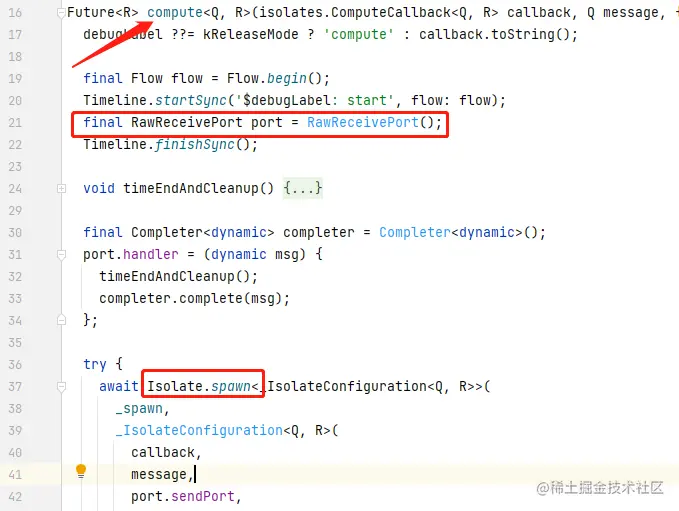

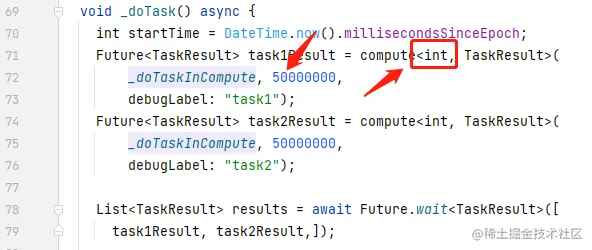

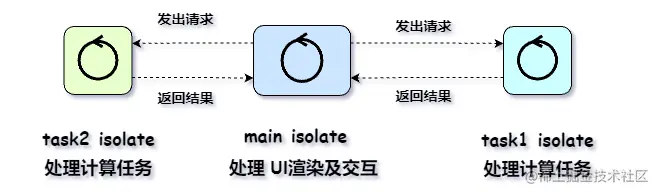

要想将文本与图片混合编辑,就要在构建InlineSpan树时,在Image()外嵌套一层WidgetSpan,并将其混入InlineSpan树。而其中较为复杂的是对TextRange的位置改变的计算(添加图片、删除图片)。接下让我们一起探索,文本与图片混合编辑的秘密。

输入为图像时的Style处理

若用户操作为插入图片,则该操作不存入Style,若为文本的插入,根据TextRange,判断所需要的Style。

List<TextStyle> getReplacementsAtSelection(TextSelection selection) {

// 只有[left replacement]才会被记录

final List<TextStyle> stylesAtSelection = <TextStyle>[];

for (final TextEditingInlineSpanReplacement replacement in replacements!) {

if (replacement.isWidget == true) {

//若为非编辑文本操作,则暂不处理。

} else {

...

///保存style

stylesAtSelection

.add(replacement.generator('', replacement.range).style!);

...

}

return stylesAtSelection;

}构建InlineSpan树

定义行为添加函数,将用户行为通过该函数保存。

void applyReplacement(TextEditingInlineSpanReplacement replacement) {

if (replacements == null) {

replacements = [];

replacements!.add(replacement);

} else {

replacements!.add(replacement);

}

}

将用户行为映射到生成的

InlineSpan

static void _addToMappingWithOverlaps(

InlineSpanGenerator generator,

TextRange matchedRange,

Map<TextRange, InlineSpan> rangeSpanMapping,

String text,

//非文本编辑行为

{bool? isWidget}) {

// 在某些情况下,应该允许重叠。

// 例如在两个TextSpan匹配相同的替换范围的情况下,

// 尝试合并到一个TextStyle的风格,并建立一个新的TextSpan。

bool overlap = false;

List<TextRange> overlapRanges = <TextRange>[];

//遍历索引

for (final TextRange range in rangeSpanMapping.keys) {

if (math.max(matchedRange.start, range.start) <=

math.min(matchedRange.end, range.end)) {

overlap = true;

overlapRanges.add(range);

}

}

...

//更新TextRanges到InlineSpan的映射。

rangeSpanMapping[uniqueRange] =

TextSpan(text: uniqueRange.textInside(text), style: mergedStyles);

...

}

构建InlineSpan树

@override

TextSpan buildTextSpan({

required BuildContext context,

TextStyle? style,

required bool withComposing,

}) {

//该函数其他逻辑在上一篇文章中已分析

}

通过image_picker插件,实现插入图片

getImage(BuildContext context) async {

//获取Editable的controller

final ReplacementTextEditingController controller =

_data.replacementsController;

//定义当前行为TextRange

final TextRange replacementRange = TextRange(

start: controller.selection.start,

end: controller.selection.end,

);

File? image;

//默认尺寸

double width = 100.0;

double height = 100.0;

//从相册获取图片

var getImage = await ImagePicker().pickImage(source: ImageSource.gallery);

image = File(getImage!.path);

//调用applyReplacement函数,保存用户行为

controller.applyReplacement(

TextEditingInlineSpanReplacement(

replacementRange,

(string, range) => WidgetSpan(

child: GestureDetector(

onTap: () {

...

},

child: Image.file(

image!,

width: width,

height: height,

),

)),

true,

isWidget: true),

);

_data = _data.copyWith(replacementsController: controller);

setState(() {});

}尾述

在这篇文章中,我们实现了将文本与图片混合编辑的功能,其他需要插入的模块也能举一反三实现,例如插入视频。本专栏实现的富文本编辑器对于真实的复杂需求也只是一个小玩意,也有着较多的缺陷,依靠我一个人的力量也是很难实现标题中说的《高性能、多功能的富文本编辑器》,本专栏旨在于引领大家走入Flutter富文本编辑器的世界,而不单单只是学会使用已有的插件,却不了解其中的实现原理,当然这是一个超级大坑🤣。例如文本与图片的排版问题...这些缺陷都需要很多的时间一点点处理解决,也希望在将来能有更多的朋友与我一起探索文本的世界。而在后续的系列文章中,将会把富文本更加的完善,完成一个笔记的Demo,也会有对富文本性能的优化与分析。希望这篇文章能对你有所帮助,有问题欢迎在评论区留言讨论~

参考

关于我

Hello,我是Taxze,如果您觉得文章对您有价值,希望您能给我的文章点个❤️,有问题需要联系我的话:我在这里 ,也可以通过掘金的新的私信功能联系到我。如果您觉得文章还差了那么点东西,也请通过关注督促我写出更好的文章——万一哪天我进步了呢?😝

链接:https://juejin.cn/post/7164162875727020069

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Kotlin 标准库随处可见的 contract 到底是什么?

Kotlin 的标准库提供了不少方便的实用工具函数,比如 with, let, apply 之流,这些工具函数有一个共同特征:都调用了 contract() 函数。

@kotlin.internal.InlineOnly

public inline fun <T, R> with(receiver: T, block: T.() -> R): R {

contract {

callsInPlace(block, InvocationKind.EXACTLY_ONCE)

}

return receiver.block()

}

@kotlin.internal.InlineOnly

public inline fun repeat(times: Int, action: (Int) -> Unit) {

contract { callsInPlace(action) }

for (index in 0 until times) {

action(index)

}

}contract?协议?它到底是起什么作用?

函数协议

contract 其实就是一个顶层函数,所以可以称之为函数协议,因为它就是用于函数约定的协议。

@ContractsDsl

@ExperimentalContracts

@InlineOnly

@SinceKotlin("1.3")

@Suppress("UNUSED_PARAMETER")

public inline fun contract(builder: ContractBuilder.() -> Unit) { }用法上,它有两点要求:

- 仅用于顶层方法

- 协议描述须置于方法开头,且至少包含一个「效应」(Effect)

可以看到,contract 的函数体为空,居然没有实现,真是一个神奇的存在。这么一来,此方法的关键点就只在于它的参数了。

ContractBuilder

contract的参数是一个将 ContractBuilder 作为接受者的lambda,而 ContractBuilder 是一个接口:

@ContractsDsl

@ExperimentalContracts

@SinceKotlin("1.3")

public interface ContractBuilder {

@ContractsDsl public fun returns(): Returns

@ContractsDsl public fun returns(value: Any?): Returns

@ContractsDsl public fun returnsNotNull(): ReturnsNotNull

@ContractsDsl public fun <R> callsInPlace(lambda: Function<R>, kind: InvocationKind = InvocationKind.UNKNOWN): CallsInPlace

}其四个方法分别对应了四种协议类型,它们的功能如下:

returns:表明所在方法正常返回无异常returns(value: Any?):表明所在方法正常执行,并返回 value(其值只能是 true、false 或者 null)returnsNotNull():表明所在方法正常执行,且返回任意非 null 值callsInPlace(lambda: Function<R>, kind: InvocationKind = InvocationKind.UNKNOWN):声明 lambada 只在所在方法内执行,所在方法执行完毕后,不会再被其他方法调用;可通过 kind 指定调用次数

前面已经说了,contract 的实现为空,所以作为接受着的 ContractBuilder 类型,根本没有实现类 —— 因为没有地方调用,就不需要啊。它的存在,只是为了声明所谓的协议代编译器使用。

InvocationKind

InvocationKind 是一个枚举类型,用于给 callsInPlace 协议方法指定执行次数的说明:

@ContractsDsl

@ExperimentalContracts

@SinceKotlin("1.3")

public enum class InvocationKind {

// 函数参数执行一次或者不执行

@ContractsDsl AT_MOST_ONCE,

// 函数参数至少执行一次

@ContractsDsl AT_LEAST_ONCE,

// 函数参数执行一次

@ContractsDsl EXACTLY_ONCE,

// 函数参数执行次数未知

@ContractsDsl UNKNOWN

}InvocationKind.UNKNOWN,次数未知,其实就是指任意次数。标准工具函数中,repeat 就指定的此类型,因为其「重复」次数由参数传入,确实未知;而除它外,其余像 let、with 这些,都是用的InvocationKind.EXACTLY_ONCE,即单次执行。

Effect

Effect 接口类型,表示一个方法的执行协议约定,其不同子接口,对应不同的协议类型,前面提到的 Returns、ReturnsNotNull、CallsInPlace 均为它的子类型。

public interface Effect

public interface ConditionalEffect : Effect

public interface SimpleEffect : Effect {

public infix fun implies(booleanExpression: Boolean): ConditionalEffect

}

public interface Returns : SimpleEffect

public interface ReturnsNotNull : SimpleEffect

public interface CallsInPlace : Effect简单明了,全员接口!来看一个官方使用,以便理解下这些接口的意义和使用:

public inline fun Array<*>?.isNullOrEmpty(): Boolean {

contract {

returns(false) implies (this@isNullOrEmpty != null)

}

return this == null || this.isEmpty()

}这里涉及到两个 Effect:Returns 和 ConditionalEffect。此方法的功能为:判断数组为 null 或者是无元素空数组。它的 contract 约定是这样的:

- 调用

returns(value: Any?)获得Returns协议(当然也就是SimpleEffect协议),其传入值是 false - 第1步的

Returns调用implies方法,条件是「本对象非空」,得到了一个ConditionalEffect - 于是,最终协议的意思是:函数返回 false 意味着 接受者对象非空

isNullOrEmpty() 的功能性代码给出了返回值为 true 的条件。虽然反过来说,不满足该条件,返回值就是 false,但还是通过 contract 协议里首先说明了这一点。

协议的意义

讲到这里,contract 协议涉及到的基本类型及其使用已经清楚了。回过头来,前面说到,contract() 的实现为空,即函数体为空,没有实际逻辑。这说明,这个调用是没有实际执行效果的,纯粹是为编译器服务。

不妨模仿着 let 写一个带自定义 contract 测试一下这个结论:

// 类比于ContractBuilder

interface Bonjour {

// 协议方法

fun <R> parler(f: Function<R>) {

println("parler something")

}

}

// 顶层协议声明工具,类比于contract

inline fun bonjour(b: Bonjour.() -> Unit) {}

// 模仿let

fun<T, R> T.letForTest(block: (T) -> R): R {

println("test before")

bonjour {

println("test in bonjour")

parler<String> {

""

}

}

println("test after")

return block(this)

}

fun main(args: Array<String>) {

"abc".letForTest {

println("main: $it called")

}

}letForTest() 是类似于 let 的工具方法(其本身功能逻辑不重要)。执行结果:

test before

test after

main: abc called如预期,bonjour 协议以及 Bonjour 协议构造器中的所有日志都未打印,都未执行。

这再一次印证,contract 协议仅为编译器提供信息。那协议对编码来说到底有什么意义呢?来看看下面的场景:

fun getString(): String? {

TODO()

}

fun String?.isAvailable(): Boolean {

return this != null && this.length > 0

}getString() 方法返回一个 String 类型,但是有可能为 null。isAvailable 是 String? 类型的扩展,用以判断是否一个字符串非空且长度大于 0。使用如下:

val target = getString()

if (target.isAvailable()) {

val result: String = target

}按代码的设计初衷,上述调用没问题,target.isAvailable() 为 true,证明 target 是非空且长度大于 0 的字符串,然后内部将它赋给 String 类型 —— 相当于 String? 转换成 String。

可惜,上述代码,编译器不认得,报错了:

Type mismatch.

Required:

String

Found:

String?编译器果然没你我聪明啊!要解决这个问题,自然就得今天的主角上场了:

fun String?.isAvailable(): Boolean {

contract {

returns(true) implies (this@isAvailable != null)

}

return this != null && this.length > 0

}使用 contract 协议指定了一个 ConditionalEffect,描述意思为:如果函数返回true,意味着 Receiver 类型非空。然后,编译器终于懂了,前面的错误提示消失。

这就是协议的意义所在:让编译器看不懂的代码更加明确清晰。

小结

函数协议可以说是写工具类函数的利器,可以解决很多因为编译器不够智能而带来的尴尬问题。不过需要明白的是,函数协议还是实验性质的,还没有正式发布为 stable 功能,所以是有可能被 Kotlin 官方 去掉的。

链接:https://juejin.cn/post/7128258776376803359

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Compose 状态保存:rememberSaveable 原理分析

前言

我曾经在一篇介绍 Compose Navigation 的文章 中提到了 Navigation 的状态保存实际是由 rememberSaveable 实现的,有同学反馈希望单独介绍一下 rememberSaveable 的功能及实现原理。

我们都知道 remember 可以保存数据、避免状态因重组而丢失,但它依然无法避免在 ConfigurationChanged 时的数据丢失。想要在横竖屏切换等场景下依然保存状态,就需要使用 rememberSavable。

从一个报错说起

首先,在代码使用上 rememberSaveable 和 remember 没有区别:

//保存列表状态

val list = rememberSaveable {

mutableListOf<String>()

}

//保存普通状态

var value by rememberSaveable {

mutableStateOf("")

}如上,只要将 remember 改为 rememberSaveable,我们创建的状态就可以跨越横竖屏切换甚至跨越进程持续保存了。不过 rememberSaveable 中并非任何类型的值都可以存储:

data class User(

val name: String = ""

)

val user = rememberSaveable {

User()

}上面代码运行时会发生错误:

java.lang.IllegalArgumentException: User(name=) cannot be saved using the current SaveableStateRegistry. The default implementation only supports types which can be stored inside the Bundle. Please consider implementing a custom Saver for this class and pass it to rememberSaveable().

User 无法存入 Bundle。这非常合理,因为 rememberSaveable 中数据的持久化最终在 ComponentActivity#onSaveInstanceState 中执行,这需要借助到 Bundle 。

rememberSaveable 源码分析

那么,rememberSaveable 是如何关联到 onSaveInstanceState 的呢?接下来简单分析一下内部实现

@Composable

fun <T : Any> rememberSaveable(

vararg inputs: Any?,

saver: Saver<T, out Any> = autoSaver(),

key: String? = null,

init: () -> T

): T {

//...

// 通过 CompositionLocal 获取 SaveableStateRegistry

val registry = LocalSaveableStateRegistry.current

// 通过 init 获取需要保存的数据

val value = remember(*inputs) {

// registry 根据 key 恢复数据,恢复的数据是一个 Saveable

val restored = registry?.consumeRestored(finalKey)?.let {

// 使用 Saver 将 Saveable 转换为业务类型

saver.restore(it)

}

restored ?: init()

}

// 用一个 MutableState 保存 Saver,主要是借助 State 的事务功能避免一致性问题发生

val saverHolder = remember { mutableStateOf(saver) }

saverHolder.value = saver

if (registry != null) {

DisposableEffect(registry, finalKey, value) {

//ValueProvider:通过 Saver#save 存储数据

val valueProvider = {

with(saverHolder.value) { SaverScope { registry.canBeSaved(it) }.save(value) }

}

//试探数值是否可被保存

registry.requireCanBeSaved(valueProvider())

//将ValueProvider 注册到 registry ,等到合适的时机被调用

val entry = registry.registerProvider(finalKey, valueProvider)

onDispose {

entry.unregister()

}

}

}

return value

}如上,逻辑很清晰,主要是围绕 registry 展开的:

- 通过 key 恢复持久化的数据

- 基于 key 注册 ValueProvider,等待合适时机执行数据持久化

- 在 onDispose 中被注销注册

registry 是一个 SaveableStateRegistry 。

恢复 key 的数据

rememberSaveable 是加强版的 remember,首先要具备 remember 的能力,可以看到内部也确实是调用了 remember 来创建数据同时缓存到 Composition 中。init 提供了 remember 数据的首次创建。被创建的数据在后续某个时间点进行持久化,下次执行 rememberSaveable 时会尝试恢复之前持久化的数据。具体过程分为以下两步:

- 通过 registry.consumeRestored 查找 key 获取 Saveable,

- Saveable 经由 saver.restore 转换为业务类型。

上述过程涉及到两个角色:

- SaveableStateRegistry:通过 CompositionLocal 获取,它负责将 Bundle 中的数据反序列化后,返回一个 Saveable

- Saver:Saver 默认有 autoSaver 创建,负责 Saveable 与业务数据之间的转换。

Saveable 并不是一个在具体类型,它可以是可被持久化(写入 Bundle)的任意类型。对于 autoSaver 来说, 这个 Saveable 就是业务数据类型本身。

private val AutoSaver = Saver<Any?, Any>(

save = { it },

restore = { it }

)对于一些复杂的业务结构体,有时并非是所有字段都需要持久化。Saver 为我们提供了这样一个机会机会,可以按照需要将业务类型转化为可序列化类型。Compose 也提供了两个预置的 Saver:ListSaver 和 MapSaver,可以用来转换成 List 或者 Map。

关于恢复数据的 Key :可以看到数据的保存和恢复都依赖一个 key,按道理 key 需要在保存和恢复时严格保持一致 ,但我们平日调用 rememberSaveable 时并没有指定具体的 key,那么在横竖屏切换甚至进程重启后是如何恢复数据的呢?其实这个 key 是 Compose 自动帮我们设置的,它就是编译期插桩生成的基于代码位置的 key ,所以可以保证每次进程执行到此处都保持不变

注册 ValueProvider

SaveableStateRegistry 在 DisposableEffect 中关联 key 注册 ValueProvider。

ValueProvider 是一个 lambda,内部会调用 Saver#save 将业务数据转化为 Saveable。

Saver#save 是 SaverScope 的扩展函数,所以这里需要创建一个 SaverScope 来调用 save 方法。SaverScope 主要用来提供 canBeSaved 方法,我们在自定义 Saver 时可以用来检查类型是否可被持久化

ValueProvider 创建好后紧接着会调用 registry.registerProvider 进行注册,等待合适的时机(比如 Activity 的 onSaveInstanceState)被调用。在注册之前,先调用 requireCanBeSaved 判断数据类型是否可以保存,这也就是文章前面报错的地方。先 mark 一下,稍后我们看一下具体检查的实现。

注销 registry

最后在 onDispose 中调用 unregister 注销之前的注册 。

rememberSaveable 的基本流程理清楚了,可以看见主角就是 registry,因此有必要深入 SaveableStateRegistry 去看一下。我们顺着 LocalSaveableStateRegistry 可以很容易找到 registry 的出处。

DisposableSavableStateRegistry 源码分析

override fun setContent(content: @Composable () -> Unit) {

//...

ProvideAndroidCompositionLocals(owner, content)

//...

}

@Composable

@OptIn(ExperimentalComposeUiApi::class)

internal fun ProvideAndroidCompositionLocals(

owner: AndroidComposeView,

content: @Composable () -> Unit

) {

val view = owner

val context = view.context

//...

val viewTreeOwners = owner.viewTreeOwners ?: throw IllegalStateException(

"Called when the ViewTreeOwnersAvailability is not yet in Available state"

)

val saveableStateRegistry = remember {

DisposableSaveableStateRegistry(view, viewTreeOwners.savedStateRegistryOwner)

}

//...

CompositionLocalProvider(

//...

LocalSaveableStateRegistry provides saveableStateRegistry,

//...

) {

ProvideCommonCompositionLocals(

owner = owner,

//...

content = content

)

}

}如上,我们在 Activity 的 setContent 中设置各种 CompositionLocal,其中就有 LocalSaveableStateRegistry,所以 registry 不仅是一个 SaveableStateRegistry,更是一个 DisposableSaveableStateRegistry 。

接下来看一下 DisposableSaveableStateRegistry 的创建过程 。

saveableStateRegistry 与 SavedStateRegistry

注意下面这个 DisposableSaveableStateRegistry 不是真正的构造函数,它是同名构造函数的一个 Wrapper,在调用构造函数创建实例之前,先调用 androidxRegistry 进行了一系列处理:

internal fun DisposableSaveableStateRegistry(

id: String,

savedStateRegistryOwner: SavedStateRegistryOwner

): DisposableSaveableStateRegistry {

//基于 id 创建 key

val key = "${SaveableStateRegistry::class.java.simpleName}:$id"

// 基于 key 获取 bundle 数据

val androidxRegistry = savedStateRegistryOwner.savedStateRegistry

val bundle = androidxRegistry.consumeRestoredStateForKey(key)

val restored: Map<String, List<Any?>>? = bundle?.toMap()

// 创建 saveableStateRegistry,传入 restored 以及 canBeSaved

val saveableStateRegistry = SaveableStateRegistry(restored) {

canBeSavedToBundle(it)

}

val registered = try {

androidxRegistry.registerSavedStateProvider(key) {

//调用 register#performSave 并且转为 Bundle

saveableStateRegistry.performSave().toBundle()

}

true

} catch (ignore: IllegalArgumentException) {

false

}

return DisposableSaveableStateRegistry(saveableStateRegistry) {

if (registered) {

androidxRegistry.unregisterSavedStateProvider(key)

}

}

}androidxRigistry 跟 rememberSaveable 中的 registry 做的事情类似:

- 基于 key 恢复 bundle 数据,

- 基于 key 注册 SavedStateProvider。

但 androidxRegistry 不是一个 SaveableStateRegistry 而是一个 SavedStateRegistry。名字上有点绕,后者来自 androidx.savedstate ,属于平台代码,而 SaveableStateRegistry 属于 compose-runtime 的平台无关代码。可见这个构造函数的同名 Wrapper 很重要,他就像一个桥梁,解耦和关联了平台相关和平台无关代码。

DisposableSaveableStateRegistry 与 SaveableStateRegistryImpl

DisposableSaveableStateRegistry 真正的构造函数定义如下:

internal class DisposableSaveableStateRegistry(

saveableStateRegistry: SaveableStateRegistry,

private val onDispose: () -> Unit

) : SaveableStateRegistry by saveableStateRegistry {

fun dispose() {

onDispose()

}

}这里用了参数 saveableStateRegistry 作为 SaveableStateRegistry 接口的代理。saveableStateRegistry 实际是一个 SaveableStateRegistryImpl 对象,它像这样创建:

val saveableStateRegistry = SaveableStateRegistry(restored) {

canBeSavedToBundle(it)

}

fun SaveableStateRegistry(

restoredValues: Map<String, List<Any?>>?,

canBeSaved: (Any) -> Boolean

): SaveableStateRegistry = SaveableStateRegistryImpl(restoredValues, canBeSaved)

SaveableStateRegistryImpl 被创建时传入两个参数:

- restoredValues:androidxRegistry 恢复的 bundle 数据,是一个 Map 对象。

- canBeSaved : 用来检查数据是否可持久化,可以的看到这里实际调用了 canBeSavedToBundle。

canBeSavedToBundle

文章开头的报错就是 requireCanBeSaved -> canBeSavedToBundle 检查出来的,通过 canBeSavedToBundle 看一下 rememberSaveable 支持的持久化类型:

private fun canBeSavedToBundle(value: Any): Boolean {

// SnapshotMutableStateImpl is Parcelable, but we do extra checks

if (value is SnapshotMutableState<*>) {

if (value.policy === neverEqualPolicy<Any?>() ||

value.policy === structuralEqualityPolicy<Any?>() ||

value.policy === referentialEqualityPolicy<Any?>()

) {

val stateValue = value.value

return if (stateValue == null) true else canBeSavedToBundle(stateValue)

} else {

return false

}

}

for (cl in AcceptableClasses) {

if (cl.isInstance(value)) {

return true

}

}

return false

}

private val AcceptableClasses = arrayOf(

Serializable::class.java,

Parcelable::class.java,

String::class.java,

SparseArray::class.java,

Binder::class.java,

Size::class.java,

SizeF::class.java

)首先, SnapshotMutableState 允许被持久化,因为我们需要在 rememberSaveable 中调用 mutableStateOf;其次,SnapshotMutableState 的泛型必须是 AcceptableClasses 中的类型,我们自定义的 User 显然不符合要求,因此报了开头的错误。

SaveableStateRegistryImpl 源码分析

前面理清了几个 Registry 类型的关系,整理如下图

SaveableStateRegistry 接口的各主要方法都由 SaveableStateRegistryImpl 代理的:

- consumeRestored:根据 key 恢复数据

- registerProvider:注册 ValueProvider

- canBeSaved:用来检查数据是否是可保存类型

- performSave:执行数据保存

canBeSaved 前面介绍过,其实会回调 canBeSavedToBundle。接下来看一下 SaveableStateRegistryImpl 中其他几个方法是如何实现的:

consumeRestored

override fun consumeRestored(key: String): Any? {

val list = restored.remove(key)

return if (list != null && list.isNotEmpty()) {

if (list.size > 1) {

restored[key] = list.subList(1, list.size)

}

list[0]

} else {

null

}

}我们知道 restored 是从 Bundle 中恢复的数据,实际是一个 Map了类型。而 consumeRestored 就是在 restored 中通过 key 查找数据。restore 的 Value 是 List 类型。当恢复数据时,只保留最后一个只。顺便吐槽一下 consumeRestored 这个名字,将 restore 这个 private 成员信息暴露给了外面,有些莫名其妙。

registerProvider

override fun registerProvider(key: String, valueProvider: () -> Any?): Entry {

require(key.isNotBlank()) { "Registered key is empty or blank" }

@Suppress("UNCHECKED_CAST")

valueProviders.getOrPut(key) { mutableListOf() }.add(valueProvider)

return object : Entry {

override fun unregister() {

val list = valueProviders.remove(key)

list?.remove(valueProvider)

if (list != null && list.isNotEmpty()) {

// if there are other providers for this key return list back to the map

valueProviders[key] = list

}

}

}

}将 ValueProvider 注册到 valueProviders ,valueProviders 也是一个值为 List 的 Map,同一个 Key 可以对应多个 Value。返回的 Entry 用于 onDispose 中调用 unregister。

DisposableSaveableStateRegistry 是一个 CompositionLocal 单例,所以需要 unregister 避免不必要的泄露。注意这里要确保同一个 key 中的 List 中的其它值不被移除

不解:什么情况下同一个 key 会 registerProvider 多个值呢?

performSave

override fun performSave(): Map<String, List<Any?>> {

val map = restored.toMutableMap()

valueProviders.forEach { (key, list) ->

if (list.size == 1) {

val value = list[0].invoke()

if (value != null) {

check(canBeSaved(value))

map[key] = arrayListOf<Any?>(value)

}

} else {

map[key] = List(list.size) { index ->

val value = list[index].invoke()

if (value != null) {

check(canBeSaved(value))

}

value

}

}

}

return map

}在这里调用了 ValueProvider 获取数据后存入 restored ,这里也是有针对 Value 是 List 类型的特别处理。performSave 的调用时机前面已经出现了,是 androidxRegistry 注册的 Provider 中调用:

androidxRegistry.registerSavedStateProvider(key) {

//调用 register#performSave 并且转为 Bundle

saveableStateRegistry.performSave().toBundle()

}SavedStateProvider 会在 onSaveInstance 时被执行。

至此, rememberSaveable 持久化发生的时机与平台进行了关联。

最后回看 androidxRegistry

最后我们再回看一下 DisposableSavableStateRegistry,主要是使用 androidxRegistry 获取 key 对应的数据,并注册 key 对应的 Provider。那么 androidxRegistry 和 key 是怎么来的?

internal fun DisposableSaveableStateRegistry(

id: String,

savedStateRegistryOwner: SavedStateRegistryOwner

): DisposableSaveableStateRegistry {

val key = "${SaveableStateRegistry::class.java.simpleName}:$id"

val androidxRegistry = savedStateRegistryOwner.savedStateRegistry

//...

}先说 key 。key 由 id 唯一决定,而这个 id 其实是 ComposeView 的 layoutId。我们知道 ComposeView 是 Activity/Fragment 承载 Composable 的容器,rememberSaveable 会按照 ComposeView 为单位来持久化数据。

因为你 ComposeView 的 id 决定了 rememberSaveable 存储数据的位置,如果 Activity/Fragment 范围内如果有多个 ComposeView 使用了同一个 id,则只有第一个 ComposeView 能正常恢复数据,这一点要特别注意

再看一下 androidxRegistry,他由 SavedStateRegistryOwner 提供,而这个 owner 是ComposeView 被 attach 到 Activity 时赋的值,就是 Activity 本身:

public class ComponentActivity extends androidx.core.app.ComponentActivity implements

ContextAware,

LifecycleOwner,

ViewModelStoreOwner,

HasDefaultViewModelProviderFactory,

SavedStateRegistryOwner, // ComponentActivity 是一个 SavedStateRegistryOwner

OnBackPressedDispatcherOwner,

ActivityResultRegistryOwner,

ActivityResultCaller {

//...

public final SavedStateRegistry getSavedStateRegistry() {

return mSavedStateRegistryController.getSavedStateRegistry();

}

//...

}mSavedStateRegistryController 会在 Activity 重建时 onCreate 中调用 performRestore;在 onSaveInstanceState 时执行 performSave。

protected void onCreate(@Nullable Bundle savedInstanceState) {

mSavedStateRegistryController.performRestore(savedInstanceState);

//...

}

protected void onSaveInstanceState(@NonNull Bundle outState) {

//...

mSavedStateRegistryController.performSave(outState);

}mSavedStateRegistryController 最终调用到 SavedStateRegistry 的同名方法,看一下 SavedStateRegistry#performSave:

fun performSave(outBundle: Bundle) {

//...

val it: Iterator<Map.Entry<String, SavedStateProvider>> =

this.components.iteratorWithAdditions()

while (it.hasNext()) {

val (key, value) = it.next()

components.putBundle(key, value.saveState())

}

if (!components.isEmpty) {

outBundle.putBundle(SAVED_COMPONENTS_KEY, components)

}

}components 是注册 SavedStateProvider 的 Map。 performSave 中调用 Provider 的 saveState 方法获取到 rememberSaveable 中保存的 bundle,然后存入 outBundle 进行持久化。

至此,rememberSaveable 在 Android 平台完成了横竖屏切换时的状态保存。

最后我们用一个图收尾,红色是保存数据时的数据流流向,绿色是恢复数据时的数据流流向:

链接:https://juejin.cn/post/7166043043651387406

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Flutter 如何优雅地阻止系统键盘弹出

前言

开篇先吐槽一下,输入框和文本,一直都是官方每个版本改动的重点,先不说功能上全不全的问题,每次版本升级,必有 breaking change 。对于 extended_text_field | Flutter Package (flutter-io.cn) 和 extended_text | Flutter Package (flutter-io.cn) 来说,新功能都是基于官方的代码,每次版本升级,merge 代码就一个字,头痛,已经有了躺平的想法了。(暂时不 merge 了,能运行就行,等一个稳定点的官方版本,准备做个重构,重构一个相对更好 merge 代码的结构。)

系统键盘弹出的原因

吐槽完毕,我们来看一个常见的场景,就是自定义键盘。要想显示自己自定义的键盘,那么必然需要隐藏系统的键盘。方法主要有如下:

- 在合适的时机调用,

SystemChannels.textInput.invokeMethod<void>('TextInput.hide')。 - 系统键盘为啥会弹出来,是因为某些代码调用了

SystemChannels.textInput.invokeMethod<void>('TextInput.show'),那么我们可以魔改官方代码, 把TextField和EditableText的代码复制出来。

EditableTextState 代码中有一个 TextInputConnection? _textInputConnection;,它会在有需要的时候调用 show 方法。

TextInputConnection 中 show,如下。

/// Requests that the text input control become visible.

void show() {

assert(attached);

TextInput._instance._show();

}TextInput 中 _show,如下。

void _show() {

_channel.invokeMethod<void>('TextInput.show');

}那么问题就简单了,把 TextInputConnection 调用 show 方法的地方全部注释掉。这样子确实系统键盘就不会再弹出来了。

在实际开发过程中,两种方法都有自身的问题:

第一种方法会导致系统键盘上下,会造成布局闪烁,而且调用这个方法的时机也很容易造成额外的 bug 。

第二种方法,就跟我吐槽的一样,复制官方代码真的是吃力不讨好的一件事情,版本迁移的时候,没人愿意再去复制一堆代码。如果你使用的是三方的组件,你可能还需要去维护三方组件的代码。

拦截系统键盘弹出信息

实际上,系统键盘是否弹出,完全是因为 SystemChannels.textInput.invokeMethod<void>('TextInput.show') 的调用,但是我们不可能去每个调用该方法地方去做处理,那么这个方法执行后续,我们有办法拦截吗? 答案当然是有的。

Flutter 的 Framework 层发送信息 TextInput.show 到 Flutter 引擎是通过 MethodChannel, 而我们可以通过重载 WidgetsFlutterBinding 的 createBinaryMessenger 方法来处理Flutter 的 Framework 层通过 MethodChannel 发送的信息。

mixin TextInputBindingMixin on WidgetsFlutterBinding {

@override

BinaryMessenger createBinaryMessenger() {

return TextInputBinaryMessenger(super.createBinaryMessenger());

}

}在 main 方法中初始化这个 binding 。

class YourBinding extends WidgetsFlutterBinding with TextInputBindingMixin,YourBindingMixin {

}

void main() {

YourBinding();

runApp(const MyApp());

}BinaryMessenger 有 3 个方法需要重载.

class TextInputBinaryMessenger extends BinaryMessenger {

TextInputBinaryMessenger(this.origin);

final BinaryMessenger origin;

@override

Future<ByteData?>? send(String channel, ByteData? message) {

// TODO: implement send

throw UnimplementedError();

}

@override

void setMessageHandler(String channel, MessageHandler? handler) {

// TODO: implement setMessageHandler

}

@override

Future<void> handlePlatformMessage(String channel, ByteData? data,

PlatformMessageResponseCallback? callback) {

// TODO: implement handlePlatformMessage

throw UnimplementedError();

}

}- send

Flutter 的 Framework 层发送信息到 Flutter 引擎,会走这个方法,这也是我们需要的处理的方法。

- setMessageHandler

Flutter 引擎 发送信息到 Flutter 的 Framework 层的回调。在我们的场景中不用处理。

- handlePlatformMessage

把 send 和 setMessageHandler 二和一,看了下注释,似乎是服务于 test 的

static const MethodChannel platform = OptionalMethodChannel(

'flutter/platform',

JSONMethodCodec(),

);对于不需要处理的方法,我们做以下处理。

class TextInputBinaryMessenger extends BinaryMessenger {

TextInputBinaryMessenger(this.origin);

final BinaryMessenger origin;

@override

Future<ByteData?>? send(String channel, ByteData? message) {

// TODO: 处理我们自己的逻辑

return origin.send(channel, message);

}

@override

void setMessageHandler(String channel, MessageHandler? handler) {

origin.setMessageHandler(channel, handler);

}

@override

Future<void> handlePlatformMessage(String channel, ByteData? data,

PlatformMessageResponseCallback? callback) {

return origin.handlePlatformMessage(channel, data, callback);

}

}接下来我们可以根据我们的需求处理 send 方法了。当 channel 为 SystemChannels.textInput 的时候,根据方法名字来拦截 TextInput.show。

static const MethodChannel textInput = OptionalMethodChannel(

'flutter/textinput',

JSONMethodCodec(),

); @override

Future<ByteData?>? send(String channel, ByteData? message) async {

if (channel == SystemChannels.textInput.name) {

final MethodCall methodCall =

SystemChannels.textInput.codec.decodeMethodCall(message);

switch (methodCall.method) {

case 'TextInput.show':

// 处理是否需要滤过这次消息。

return SystemChannels.textInput.codec.encodeSuccessEnvelope(null);

default:

}

}

return origin.send(channel, message);

}现在交给我们最后问题就是怎么确定这次消息需要被拦截?当需要发送 TextInput.show 消息的时候,必定有某个 FocusNode 处于 Focus 的状态。那么可以根据这个 FocusNode 做区分。

我们定义个一个特别的 FocusNode,并且定义好一个属性用于判断(也有那种需要随时改变是否需要拦截信息的需求)。

class TextInputFocusNode extends FocusNode {

/// no system keyboard show

/// if it's true, it stop Flutter Framework send `TextInput.show` message to Flutter Engine

bool ignoreSystemKeyboardShow = true;

}这样子,我们就可以根据以下代码进行判断。

Future<ByteData?>? send(String channel, ByteData? message) async {

if (channel == SystemChannels.textInput.name) {

final MethodCall methodCall =

SystemChannels.textInput.codec.decodeMethodCall(message);

switch (methodCall.method) {

case 'TextInput.show':

final FocusNode? focus = FocusManager.instance.primaryFocus;

if (focus != null &&

focus is TextInputFocusNode &&

focus.ignoreSystemKeyboardShow) {

return SystemChannels.textInput.codec.encodeSuccessEnvelope(null);

}

break;

default:

}

}

return origin.send(channel, message);

}最后我们只需要为 TextField 传入这个特殊的 FocusNode。

final TextInputFocusNode _focusNode = TextInputFocusNode()..debugLabel = 'YourTextField';

@override

Widget build(BuildContext context) {

return TextField(

focusNode: _focusNode,

);

}画自己的键盘

这里主要讲一下,弹出和隐藏键盘的时机。你可以通过当前焦点的变化的时候,来显示或者隐藏自定义的键盘。

当你的自定义键盘能自己关闭,并且保存焦点不丢失的,你那还应该在 [TextField]

的 onTap 事件中,再次判断键盘是否显示。比如我写的例子中使用的是 showBottomSheet 方法,它是能通过 drag 来关闭自己的。

下面为一个简单的例子,完整的例子在 extended_text_field/no_keyboard.dart at master · fluttercandies/extended_text_field (github.com)

PersistentBottomSheetController<void>? _bottomSheetController;

final TextInputFocusNode _focusNode = TextInputFocusNode()..debugLabel = 'YourTextField';

@override

void initState() {

super.initState();

_focusNode.addListener(_handleFocusChanged);

}

@override

Widget build(BuildContext context) {

return Scaffold(

body: TextField(

// you must use TextInputFocusNode

focusNode: _focusNode,

),

);

}

void _onTextFiledTap() {

if (_bottomSheetController == null) {

_handleFocusChanged();

}

}

void _handleFocusChanged() {

if (_focusNode.hasFocus) {

// just demo, you can define your custom keyboard as you want

_bottomSheetController = showBottomSheet<void>(

context: FocusManager.instance.primaryFocus!.context!,

// set false, if don't want to drag to close custom keyboard

enableDrag: true,

builder: (BuildContext b) {

// your custom keyboard

return Container();

});

// maybe drag close

_bottomSheetController?.closed.whenComplete(() {

_bottomSheetController = null;

});

} else {

_bottomSheetController?.close();

_bottomSheetController = null;

}

}

@override

void dispose() {

_focusNode.removeListener(_handleFocusChanged);

super.dispose();

}当然,怎么实现自定义键盘,可以根据自己的情况来决定,比如如果你的键盘需要顶起布局的话,你完全可以写成下面的布局。

Column(

children: <Widget>[

// 你的页面

Expanded(child: Container()),

// 你的自定义键盘

Container(),

],

);结语

通过对 createBinaryMessenger 的重载,我们实现对系统键盘弹出的拦截,避免我们对官方代码的依赖。其实 SystemChannels 当中,还有些其他的系统的 channel,我们也能通过相同的方式去对它们进行拦截,比如可以拦截按键。

static const BasicMessageChannel<Object?> keyEvent = BasicMessageChannel<Object?>(

'flutter/keyevent',

JSONMessageCodec(),

);本文相关代码都在 extended_text_field | Flutter Package (flutter-io.cn) 。

爱 Flutter,爱糖果,欢迎加入Flutter Candies,一起生产可爱的Flutter小糖果

链接:https://juejin.cn/post/7166046328609308685

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

【Ktor挖坑日记】还在用Retrofit网络请求吗?试试Ktor吧!

Ktor官方对Ktor的描述是:

Create asynchronous client and server applications. Anything from microservices to multiplatform HTTP client apps in a simple way. Open Source, free, and fun!

创建异步客户端和和服务器应用,从微服务到多平台HTTP客户端应用程序都可以用一种简单的方式完成。开源、免费、有趣!

它具有轻量级+可扩展性强+多平台+异步的特性。

轻量级和可扩展性是因为它的内核比较简单,并且当需要一些功能的时候可以加入别的插件到项目中,并不会造成功能冗余。并且Ktor的扩展是使用插拔的方式,使用起来非常简单!

异步,Ktor内部是使用Kotlin协程来实现异步,这对于熟悉Kotlin的Android开发非常友好。

看到这里可能一头雾水,下面将用一个比较简单的例子来带大家入坑Ktor!等看完这篇文章之后就会对Ktor的这些特性有进一步的了解。

小例子 —— 看猫咪

引入依赖

在app模块的gradle中引入依赖

plugins {

...

id 'org.jetbrains.kotlin.plugin.serialization' version "1.7.10" // 跟Kotlin版本一致

}

dependencies {

...

// Ktor

def ktor_version = "2.1.0"

implementation "io.ktor:ktor-client-core:$ktor_version"

implementation "io.ktor:ktor-client-android:$ktor_version"

implementation "io.ktor:ktor-client-content-negotiation:$ktor_version"

implementation "io.ktor:ktor-serialization-kotlinx-json:$ktor_version"

}稍微解释一下这两个依赖

Ktor的客户端内核

由于本APP是部署在Android上的,因此需要引入一个Android依赖,Android平台和其他平台的不同点在于Android具有主线程的概念,Android不允许在主线程发送网络请求,而在Kotlin协程中就是主调度器的概念,其内部是post任务到主线程Handler中,这里就不展开太多。当然如果要使用OkHttp也是可以的!

implementation "io.ktor:ktor-client-okhttp:$ktor_version"

如果想应用到其他客户端平台可以使用CIO

第三个简单来说就是数据转换的插件,例如将远端发送来的数据(可以是CBOR、Json、Protobuf)转换成一个个数据类。

而第四个就是第三个的衍生插件,相信用过

kotlin-serialization的人会比较熟悉,是Kotlin序列化插件,本次引用的是json,类似于Gson,可以将json字符串转换成数据类。

当然,如果需要其他插件可以到官网上看看,例如打印日志Logging

implementation "ch.qos.logback:logback-classic:$logback_version"

implementation "io.ktor:ktor-client-logging:$ktor_version"创建HttpClient

首先创建一个HttpClient实例

val httpClient = HttpClient(Android) {

defaultRequest {

url {

protocol = URLProtocol.HTTP

host = 你的host

port = 你的端口

}

}

install(ContentNegotiation) {

json()

}

}创建的时候是使用DSL语法的,这里解释一下其中使用的两个配置

defaultRequest:给每个HTTP请求加上BaseUrl

例如请求

"/get-cat"就会向"http://${你的host}:${你的端口}/get-cat"发起HTTP请求。

ContentNegotiation:引入数据转换插件。

json:引入自动将json转换数据类的插件。

定义数据类

@Serializable

data class Cat(

val name: String,

val description: String,

val imageUrl: String

)

此处给猫咪定义名字、描述和图片url,需要注意的是需要加上@Serializable注解,这是使用kotlin-serialization的前提条件,而需要正常使用kotlin-serialization,需要在app模块的build.gradle加上以下plugin

plugins {

...

id 'org.jetbrains.kotlin.plugin.serialization' version "1.7.10" // 跟Kotlin版本一致

}创建API

interface CatSource {

suspend fun getRandomCat(): Result<Cat>

companion object {

val instance = CatSourceImpl(httpClient)

}

}

class CatSourceImpl(

private val client: HttpClient

) : CatSource {

override suspend fun getRandomCat(): Result<Cat> = runCatching {

client.get("random-cat").body()

}

}

此处声明一个CatSource接口,接口中声明一个获取随机小猫咪的函数,并且对该接口进行实现。

suspend:HttpClient的方法大多数为suspend函数,例如例子中的get为suspend函数,因此接口也要定义成suspend函数。

Result:Result为Kotlin官方包装类,具有success和failure两个方法,可以包装成功和失败两种数据,可以简单使用runCatching来返回Result

@InlineOnly

@SinceKotlin("1.3")

public inline fun <T, R> T.runCatching(block: T.() -> R): Result<R> {

return try {

Result.success(block())

} catch (e: Throwable) {

Result.failure(e)

}

}

body:获取返回结果,由于内部协程实现,因此不用担心阻塞主线程的问题,由于引入了ContentNegotiation,因此获取到结果之后可以对其进行转换,转换成实际数据类。

展示

ViewModel

class MainViewModel : ViewModel() {

private val catSource = CatSource.instance

private val _catState = MutableStateFlow<UiState<Cat>>(UiState.Loading)

val catState = _catState.asStateFlow()

init {

getRandomCat()

}

fun getRandomCat() {

viewModelScope.launch {

_catState.value = UiState.Loading

// fold 方法可以用来对 Result 的结果分情况处理

catSource.getRandomCat().fold(

onSuccess = {

_catState.value = UiState.Success(it)

}, onFailure = {

_catState.value = UiState.Failure(it)

}

)

}

}

}

sealed class UiState<out T> {

object Loading: UiState<Nothing>()

data class Success<T>(val value: T): UiState<T>()

data class Failure(val exc: Throwable): UiState<Nothing>()

}

inline fun <T> UiState<T>.onState(

onSuccess: (T) -> Unit,

onFailure: (Throwable) -> Unit = {},

onLoading: () -> Unit = {}

) {

when(this) {

is UiState.Failure -> onFailure(this.exc)

UiState.Loading -> onLoading()

is UiState.Success -> onSuccess(this.value)

}

}Activity

界面比较简单,因此用Compose实现

class MainActivity : ComponentActivity() {

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

setContent {

KittyTheme {

Column(

modifier = Modifier

.fillMaxWidth()

.padding(32.dp)

) {

val viewModel: MainViewModel = viewModel()

val catState by viewModel.catState.collectAsState()

catState.onState(

onSuccess = { cat ->

AsyncImage(model = cat.imageUrl, contentDescription = cat.name)

Spacer(modifier = Modifier.height(8.dp))

Text(

text = cat.name,

fontWeight = FontWeight.SemiBold,

fontSize = 20.sp

)

Spacer(modifier = Modifier.height(8.dp))

Text(text = cat.description)

},

onFailure = {

Text(text = "Loading Failure!")

},

onLoading = {

CircularProgressIndicator()

}

)

Button(

onClick = viewModel::getRandomCat,

modifier = Modifier.align(Alignment.End)

) { Text(text = "Next Cat!") }

Spacer(modifier = Modifier.height(8.dp))

}

}

}

}

}

对state分情况展示

加载中就展示转圈圈。

成功就展示猫咪图片、猫咪名字、猫咪描述。

失败就展示加载失败。

展示图片的

AsyncImage来自于Coil展示库,传入imageUrl就好啦,使用Kotlin编写,内部使用协程实现异步。

我们运行一下吧!

总结一下

是不是很简单捏!看起来好像很多,其实核心用法就三个

实例HttpClient

在HttpClient中配置插件

调用

get或者post方法

由于内部使用了协程来进行异步,因此不用担心主线程阻塞!令我觉得比较香的是数据转换插件,可以再也不用担心数据转换了。并且支持例如XML、CBOR、Json等等,也不会担心后端会给我们发来什么数据格式了。

还有一个文中没有用到的是Logging插件,可以在logcat打印给服务端发了什么,服务端给客户端发了什么,调试API起来也很方便,跟后端拉扯起来也很有底气!

另外,Android插件不支持WebSocket,但是Okhttp和CIO支持!实际使用中可以用后者创建httpClient!

服务端

创建项目

服务端不是重点就简单提一下,贴一下代码,使用IntelliJ IDEA Ultimate可以直接创建Ktor工程,要是用社区版就去ktor.io/create/创建。

- 工程名字。

2. 配置插件,官方很多插件,不用想着一下子就添加完,需要用的时候再像客户端一样引入依赖就好。

3. 创建项目,下载打开。

编写代码

到Application.kt看一下主函数

fun main() {

embeddedServer(Netty, port = 你的端口, host = "0.0.0.0") {

configureRouting()

configureSerialization()

}.start(wait = true)

}

配置Routing插件

fun Application.configureRouting() {

routing {

randomCat()

static {

resources("static")

}

}

}

fun Route.randomCat() {

get("/random-cat") {

// 随便回一直猫咪给客户端

call.respond(cats.random())

}

}

//本地IPV4地址

private const val BASE_URL = "http://${你的host}:${你的端口}"

private val cats = listOf(

Cat("夺宝1号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat1.jpg"),

Cat("夺宝2号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat2.jpg"),

Cat("夺宝3号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat3.jpg"),

Cat("夺宝4号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat4.jpg"),

Cat("夺宝5号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat5.jpg"),

Cat("夺宝6号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat6.jpg"),

Cat("夺宝7号", "这是一只可爱的小猫咪", "$BASE_URL/cats/cat7.jpg"),

)

@Serializable

data class Cat(

val name: String,

val description: String,

val imageUrl: String

)

配置Serialization插件

fun Application.configureSerialization() {

install(ContentNegotiation) {

json()

}

}

放入图片资源,我放了七只猫咪图片。

然后跑起来就好啦!去手机上看看效果吧!

又总结一次

客户端和服务端使用方式是比较相似的,这也非常友好,由于也是使用Kotlin作为后端,那很多代码都可以拷贝了,例如文中的数据类Cat甚至可以直接拷贝过来。Ktor用起来非常方便,由于其Okhttp插件的存在,在全Kotlin的Android项目中甚至可以考虑Ktor而不是Retrofit(当然Retrofit也是非常优秀的网络请求库)。关于Ktor的坑先开到这啦!

参考

链接:https://juejin.cn/post/7136829279903416333

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

六年安卓开发的技术回顾和展望

本文字数:7190 字,阅读完需:约 5 分钟

大家好,我是 shixin。

一转眼,我从事安卓开发工作已经六年有余,对安卓开发甚至软件开发的价值,每年都有更进一步的认识。对未来的方向,也从刚入行的迷茫到现在逐渐清晰。我想是时候做一个回顾和展望了。

这篇文章会先回顾我从入行至今的一些关键点,然后讲一下经过这些年,我对软件开发的认知变化,最后分享一下后面的规划。

回顾

人太容易在琐碎生活中迷失,我们总是需要记住自己从哪里来,才能清楚要到哪里去。

入行至今的一些关键节点

2014~2015:开始安卓开发之旅

说起为什么做安卓开发,我很有感慨,差一点就“误入歧途”😄。

当初在大学时,加入了西电金山俱乐部,俱乐部里有很多方向:后端、前端、安卓、Windows Phone 等。

由于我当时使用的是三星 i917,WindowsPhone,所以就选了 WinPhone 方向。

当时还是 iOS、安卓、WinPhone、塞班四足鼎立的时代,WinPhone 的磁贴式设计我非常喜欢,加上设备的流畅性、像素高,一度让我觉得它可能会统治移动市场。

结果在学习不到 2 个月以后,我的 WinPhone 意外进水了!我当时非常难过,一方面是对手机坏了的伤痛,另一方面也是对无法继续做 WinPhone 开发很遗憾。对于当时的我来说,再换一台 WinPhone 过于昂贵,只好换一台更加便宜的安卓机,因此也就转向学习安卓开发。

后面的故事大家都知道了,因为 WindowsPhone 缺乏良好的开发生态,支持应用很少,所以用户也少,用户少导致开发者更少,恶性循环,如今市场份额已经少的可怜。

现在回想起来,对于这件事还很有感慨,有些事当时觉得是坏事,拉长时间线去看,未必是这样。

当时还有一件目前看来非常重要的决定:开始写博客,记录自己的所学所得。

在开发项目时,我经常需要去网上搜索解决方案,后来搜索的多了,觉得总不能一直都是索取,我也可以尝试去写一下。于是在 CSDN 注册了账号,并于 2014 年 10 月发布了我的第一篇原创文章。

后来工作学习里新学到什么知识,我都会尽可能地把它转换成别人看得懂的方式,写到播客里。这个不起眼的开始,让我逐渐有了解决问题后及时沉淀、分享的习惯,受益匪浅。

2015~2017:明白项目迭代的全流程

在学习安卓开发时,我先看了一本明日科技的《Android 从入门到精通》,然后看了些校内网的视频,逐渐可以做一些简单的应用。安卓开发所见即所得的特点,让我很快就可以得到正反馈。后来又去参加一些地方性的比赛,获得一些名次,让我逐渐加强了从事这个行业的信心。

在 2015 年时,偶然参加了一家公司的招聘会,在面试时,面试官问了一些简单的 Java 、安卓和算法问题。其中印象最深的就是会不会使用四大组件和 ListView。在当时移动互联网市场飞速发展时,招聘要求就是这么低。以至于现在很多老安卓回忆起当初,都很有感慨:“当初会个 ListView 就能找工作了,现在都是八股文” 哈哈。

到公司实习后,我感触很多,之前都是自己拍脑袋写一些简单的功能,没有开发规范、发布规范,也没有工程结构设计、系统设计,更没有考虑性能是否有问题。真正的去开发一个商业项目,让我发现自己不足的太多了。

因此在完成工作的同时,我观察并记录了项目迭代的各个流程,同时对自己的技术点做查漏补缺,输出了一些 Java 源码分析、Android 进阶、设计模式文章,也是从那个时候开始,养成了定期复盘的习惯,每次我想回顾下过去,都会看看我的成长专栏。

2017~2020:提升复杂项目的架构能力和做事意识

第一个项目中我基本掌握了从 0 到 1 开发一个安卓应用的流程,但对安卓项目架构还只停留在表面,没有足够实践。

在 2017 年,我开始做喜马拉雅直播项目,由于喜马拉雅在当时已经有比较多年的技术积累,加上业务比较复杂,在架构设计、编译加速、快速迭代相关都做了比较多的工作,让我大饱眼福。

同时直播业务本身也是比较复杂的,在一个页面里会集成 IM、推拉流等功能,同时还有大量的消息驱动 UI 刷新操作,要保证业务快速迭代,同时用户体验较好,需要下不少功夫。

为了能够提升自己的技术,在这期间我学习了公司内外很多框架的源码,通过分析这些框架的优缺点、核心机制、架构层级、设计模式,对如何开发一个框架算是有了基本的认识,也输出了一些文章,比如 《Android 进阶之路:深入理解常用框架实现原理》。

有了这些知识,再去做复杂业务需求、基础框架抽取、内部 SDK 和优化,就容易多了。

在开发一些需求或者遇到复杂的问题时,我会先想想,之前看的这些三方框架或者系统源码里有没有类似的问题,它们是怎么解决的? 比如开发 PK 功能,这个需求的复杂性在于业务流程很多,分很多状态,咋一看好像很复杂,但如果了解了状态机模式,就会发现很简单。借用其他库的设计思路帮我解决了很多问题,这让我确信了学习优秀框架源码的价值。

除了技术上的提升,在这几年里,我的项目全局思考能力也提升很多。

由于我性格外向,和各个职能的同学沟通交流比较顺畅,领导让我去做一个十人小组的敏捷组长,负责跟进需求的提出、开发、测试、上线、运营各个环节,保证项目及时交付并快速迭代。

一开始我还有些不习惯,写代码时总是被不同的人打断,比如产品需求评审、测试 bug 反馈、运营反馈线上数据有问题等等,经常刚想清楚代码怎么写,正准备动手,就被叫去开会,回来后重新寻找思路。

后来在和领导沟通、看一些书和分享后,逐渐对写代码和做事,有了不同的认识。代码只是中间产物,最终我们还是要拿到对用户有价值、给公司能带来收入的产品,要做到这个,眼里除了代码,还需要关注很多。

2020~至今:深入底层技术

在进入字节做基础技术后,我的眼界再一次被打开。

字节有多款亿级用户的产品,复杂的业务常常会遇到各种意想不到的问题,这些问题需要深入底层,对安卓系统的整个架构都比较熟悉,才能够解决。

上图是安卓系统架构图,之前我始终停留在一二层,在这一时期,终于有了纵深的实践经验。

比如帮业务方解决一个内存问题,除了要了解内存指标监控方式,还要知道分析不同类型内存使用的工具及基本原理,最后知道是哪里出了问题后,还要想如何进行体系化的工具,降低学习成本,提升排查效率。

问题驱动是非常好的学习方式。每次帮助业务解决一个新问题,我的知识库都会多一个点,这让我非常兴奋。之前不知道学来干什么的 Linux 编程、Android 虚拟机,终于在实际问题中明白了使用场景,学起来效率也高了很多。

对软件开发的认识

前面讲了个人的一些经历,包括我怎么入的行,做了什么项目,过程中有什么比较好的实践。下面讲一下我从这些具体的事里面,沉淀出哪些东西有价值的结论。

主要聊下对这两点的认识:

职业发展的不同阶段

技术的价值

职业发展的不同阶段

第一点是对职业发展的认识。我们在工作时,要对自己做的事有一个清晰的认识,它大概属于哪一个阶段,怎样做可以更好。

结合我这些年的工作内容、业内大佬所做的事情,我把软件开发者的职业发展分这几个阶段:

使用某个技术方向的一个点开发简单项目

使用某个技术方向的多个点及某条线,开发一个较为复杂的业务或系统

掌握某个方向的通用知识,有多个线的实践,可以从整体上认识和规划

不限于该方向,能从产品指标方面出发,提供全方位的技术支持业务角度,端到端关注指标

第一个阶段就是使用某个技术方向的一个点完成业务需求。拿安卓开发者来说,比如使用 Android SDK 自定义布局,完成产品要求的界面功能。这个阶段比较简单,只要能够仔细学习官方文档或者看一些书即可胜任。拿后端来说,比如刚接手一个小项目,日常工作就是使用 Spring 等库开发简单的接口,不涉及到上下游通信、数据库优化等。