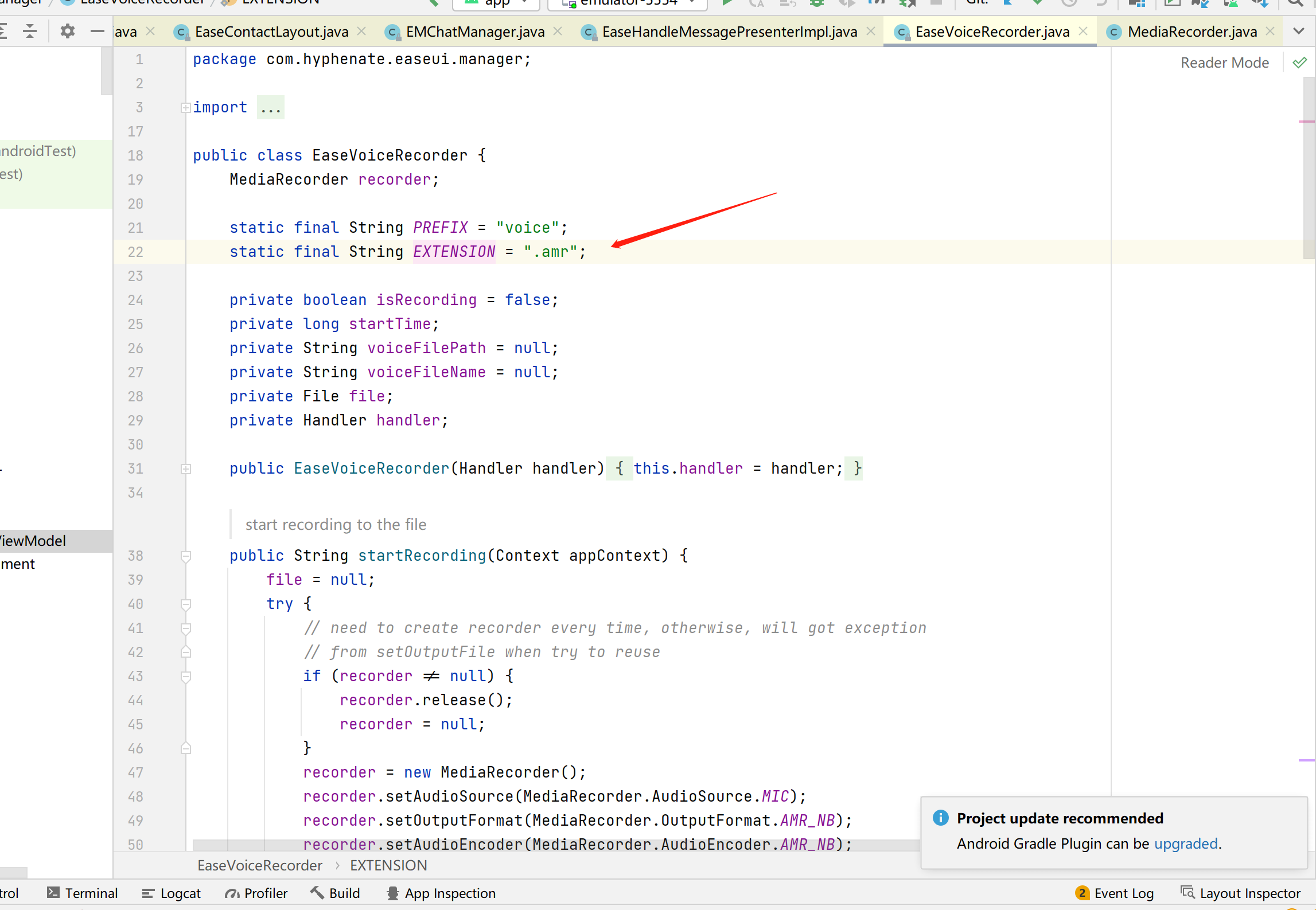

1.环信3.9.3 sdk登录慢的问题

通过axios请求拦截器,在每次请求前把请求信息和请求的取消方法放到一个map对象当中,并且判断map对象当中是否已经存在该请求信息的请求,如果存在取消上传请求

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Document</title>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/vue/2.6.14/vue.min.js" type="application/javascript"></script>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript"></script>

<script src="https://lf3-cdn-tos.bytecdntp.com/cdn/expire-1-M/qs/6.10.3/qs.js" type="application/javascript"></script>

</head>

<body>

<div id="app">

<button @click="onClick1" ref="btn1">请求1</button>

<button @click="onClick2" ref="btn2">请求2</button>

</div>

</body>

<script>

//存储请求信息和取消方法的的map对象

const pendingRequest = new Map();

//根据请求的信息(请求方式,url,请求get/post数据),产生map的key

function getRequestKey(config){

const { method, url, params, data } = config;

return [method, url, Qs.stringify(params), Qs.stringify(data)].join("&");

}

//请求拦截器

axios.interceptors.request.use(

function (config) {

//根据请求的信息(请求方式,url,请求get/post数据),产生map的key

let requestKey = getRequestKey(config)

//判断请求是否重复

if(pendingRequest.has(requestKey)){

//取消上次请求

let cancel = pendingRequest.get(requestKey)

cancel()

//删除请求信息

pendingRequest.delete(requestKey)

}

//把请求信息,添加请求到map当中

// 生成取消方法

config.cancelToken = config.cancelToken || new axios.CancelToken(cancel => {

// 把取消方法添加到map

if (!pendingRequest.has(requestKey)) {

pendingRequest.set(requestKey, cancel)

}

})

return config;

},

(error) => {

return Promise.reject(error);

}

);

let sendPost = function(data){

return axios({

url: 'http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test',

method: 'post',

data

})

}

new Vue({

el: '#app',

mounted() {

this.$refs.btn1.click()

this.$refs.btn2.click()

},

methods: {

// 使用lodash对请求方法做防抖

//这里有问题,只是对每个按钮的点击事件单独做了防抖,但是两个按钮之间做不到防抖的效果

onClick1: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求1的结果', res.data)

},

onClick2: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求2的结果', res.data)

},

},

})

</script>

</html>通过axios的响应拦截器,在请求成功后在map对象当中,删除该请求信息的数据

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Document</title>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/vue/2.6.14/vue.min.js" type="application/javascript"></script>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript"></script>

<script src="https://lf3-cdn-tos.bytecdntp.com/cdn/expire-1-M/qs/6.10.3/qs.js" type="application/javascript"></script>

</head>

<body>

<div id="app">

<button @click="onClick1" ref="btn1">请求1</button>

<button @click="onClick2" ref="btn2">请求2</button>

</div>

</body>

<script>

//存储请求信息和取消方法的的map对象

const pendingRequest = new Map();

//根据请求的信息(请求方式,url,请求get/post数据),产生map的key

function getRequestKey(config){

const { method, url, params, data } = config;

return [method, url, Qs.stringify(params), Qs.stringify(data)].join("&");

}

//请求拦截器

axios.interceptors.request.use(

function (config) {

//根据请求的信息(请求方式,url,请求get/post数据),产生map的key

let requestKey = getRequestKey(config)

//判断请求是否重复

if(pendingRequest.has(requestKey)){

//取消上次请求

let cancel = pendingRequest.get(requestKey)

cancel()

//删除请求信息

pendingRequest.delete(requestKey)

}

//把请求信息,添加请求到map当中

// 生成取消方法

config.cancelToken = config.cancelToken || new axios.CancelToken(cancel => {

// 把取消方法添加到map

if (!pendingRequest.has(requestKey)) {

pendingRequest.set(requestKey, cancel)

}

})

return config;

},

(error) => {

return Promise.reject(error);

}

);

//响应拦截器

axios.interceptors.response.use(

(response) => {

//请求成功

//删除请求的信息

let requestKey = getRequestKey(response.config)

if(pendingRequest.has(requestKey)){

pendingRequest.delete(requestKey)

}

return response;

},

(error) => {

return Promise.reject(error);

}

);

let sendPost = function(data){

return axios({

url: 'http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test',

method: 'post',

data

})

}

new Vue({

el: '#app',

mounted() {

this.$refs.btn1.click()

this.$refs.btn2.click()

},

methods: {

// 使用lodash对请求方法做防抖

//这里有问题,只是对每个按钮的点击事件单独做了防抖,但是两个按钮之间做不到防抖的效果

onClick1: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求1的结果', res.data)

},

onClick2: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求2的结果', res.data)

},

},

})

</script>

</html>通过axios的响应拦截器,在请求失败后在map对象当中,删除该请求信息的数据

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Document</title>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/vue/2.6.14/vue.min.js" type="application/javascript"></script>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript"></script>

<script src="https://lf3-cdn-tos.bytecdntp.com/cdn/expire-1-M/qs/6.10.3/qs.js" type="application/javascript"></script>

</head>

<body>

<div id="app">

<button @click="onClick1" ref="btn1">请求1</button>

<button @click="onClick2" ref="btn2">请求2</button>

</div>

</body>

<script>

//存储请求信息和取消方法的的map对象

const pendingRequest = new Map();

//根据请求的信息(请求方式,url,请求get/post数据),产生map的key

function getRequestKey(config){

const { method, url, params, data } = config;

return [method, url, Qs.stringify(params), Qs.stringify(data)].join("&");

}

//请求拦截器

axios.interceptors.request.use(

function (config) {

//根据请求的信息(请求方式,url,请求get/post数据),产生map的key

let requestKey = getRequestKey(config)

//判断请求是否重复

if(pendingRequest.has(requestKey)){

//取消上次请求

let cancel = pendingRequest.get(requestKey)

cancel()

//删除请求信息

pendingRequest.delete(requestKey)

}

//把请求信息,添加请求到map当中

// 生成取消方法

config.cancelToken = config.cancelToken || new axios.CancelToken(cancel => {

// 把取消方法添加到map

if (!pendingRequest.has(requestKey)) {

pendingRequest.set(requestKey, cancel)

}

})

return config;

},

(error) => {

return Promise.reject(error);

}

);

//删除请求信息

function delPendingRequest(config){

let requestKey = getRequestKey(config)

if(pendingRequest.has(requestKey)){

pendingRequest.delete(requestKey)

}

}

//响应拦截器

axios.interceptors.response.use(

(response) => {

//请求成功

//删除请求的信息

delPendingRequest(response.config)

return response;

},

(error) => {

//请求失败

//不是取消请求的错误

if (!axios.isCancel(error)){

//服务器报400,500报错,删除请求信息

delPendingRequest(error.config || {})

}

return Promise.reject(error);

}

);

let sendPost = function(data){

return axios({

url: 'http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test',

method: 'post',

data

})

}

new Vue({

el: '#app',

mounted() {

this.$refs.btn1.click()

this.$refs.btn2.click()

},

methods: {

// 使用lodash对请求方法做防抖

//这里有问题,只是对每个按钮的点击事件单独做了防抖,但是两个按钮之间做不到防抖的效果

onClick1: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求1的结果', res.data)

},

onClick2: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求2的结果', res.data)

},

},

})

</script>

</html>作者:黄金林

来源:juejin.cn/post/7189231050806001719

项目当中前端代码会遇到同一个请求向服务器发了多次的情况,我们要避免服务器资源浪费,同一个请求一定时间只允许发一次请求

(1)如果业务简单,例如同一个按钮防止多次点击,我们可以用定时器做防抖处理

(2)如果业务复杂,例如多个组件通过代码,同一个请求发多次,这个时候防抖已经不好处理了,最好是对重复的ajax请求统一做取消操作

效果:当用户连续点击多次同一个按钮,最后一次点击之后,过小段时间后才发起一次请求

原理:每次调用方法后都产生一个定时器,定时器结束以后再发请求,如果重复调用方法,就取消当前的定时器,创建新的定时器,等结束后再发请求,工作当中可以用第三方封装的工具函数例如lodash的debounce方法来简化防抖的代码

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Documenttitle>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/lodash.js/4.17.21/lodash.min.js" type="application/javascript">script>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/vue/2.6.14/vue.min.js" type="application/javascript">script>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript">script>

head>

<body>

<div id="app">

<button @click="onClick">请求button>

div>

body>

<script>

// 定义请求接口

function sendPost(data){

return axios({

url: 'https://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test',

method: 'post',

data

})

}

new Vue({

el: '#app',

methods: {

// 调用lodash的防抖方法debounce,实现连续点击按钮多次,0.3秒后调用1次接口

onClick: _.debounce(async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求的结果', res.data)

}, 300),

},

})

script>

html>无法解决多个按钮件的重复请求的发送问题,例如下面两种情况

按钮事件间是相互独立的,调用的是不同方法,做不到按钮间防抖效果

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Documenttitle>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/lodash.js/4.17.21/lodash.min.js" type="application/javascript">script>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/vue/2.6.14/vue.min.js" type="application/javascript">script>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript">script>

head>

<body>

<div id="app">

<button @click="onClick1" ref="btn1">请求1button>

<button @click="onClick2" ref="btn2">请求2button>

div>

body>

<script>

let sendPost = function(data){

return axios({

url: 'http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test',

method: 'post',

data

})

}

new Vue({

el: '#app',

mounted() {

this.$refs.btn1.click()

this.$refs.btn2.click()

},

methods: {

// 使用lodash对请求方法做防抖

//这里有问题,只是对每个按钮的点击事件单独做了防抖,但是两个按钮之间做不到防抖的效果

onClick1: _.debounce(async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求1的结果', res.data)

}, 300),

onClick2: _.debounce(async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求2的结果', res.data)

}, 300),

},

})

script>

html>按钮间调用的方法是相同的,是可以对方法做防抖处理,但是处理本身对方法做了一次封装,会影响到之前方法的返回值接收,需要对之前的方法做更多处理,变得更加复杂,不推荐

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Documenttitle>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/lodash.js/4.17.21/lodash.min.js" type="application/javascript">script>

<script src="https://lf26-cdn-tos.bytecdntp.com/cdn/expire-1-M/vue/2.6.14/vue.min.js" type="application/javascript">script>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript">script>

head>

<body>

<div id="app">

<button @click="onClick1" ref="btn1">请求1button>

<button @click="onClick2" ref="btn2">请求2button>

div>

body>

<script>

// 使用lodash对请求方法做防抖,

let sendPost = _.debounce(function(data){

//这里有问题,这里的返回值不能作为sendPost方法执行的返回值,因为debounce内部包裹了一层

return axios({

url: 'http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test',

method: 'post',

data

})

}, 300)

new Vue({

el: '#app',

mounted() {

this.$refs.btn1.click()

this.$refs.btn2.click()

},

methods: {

onClick1: async function(){

//这里有问题,sendPost返回值不是promise,而是undefined

let res = await sendPost({username:'zs', age: 20})

console.log('请求1的结果', res)

},

onClick2: async function(){

let res = await sendPost({username:'zs', age: 20})

console.log('请求2的结果', res)

},

},

})

script>

html>直接对请求方法做处理,通过ajax库的api方法把重复的请求给取消掉

通过调用XMLHttpRequest对象实例的abort方法把请求给取消掉

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Documenttitle>

head>

<body>

body>

<script>

//原生ajax的语法

let xhr = new XMLHttpRequest();

xhr.open("GET", "http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test?username=zs&age=20", true);

xhr.onload = function(){

console.log(xhr.responseText)

}

xhr.send();

//在谷歌浏览器的低速3g下面测试

//通过XMLHttpRequest实例的abort方法取消请求

setTimeout(() => xhr.abort(), 100);

script>

html>通过axios的CancelToken对象实例cancel方法把请求给取消掉

<html lang="en">

<head>

<meta charset="UTF-8">

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Documenttitle>

<script src="https://lf9-cdn-tos.bytecdntp.com/cdn/expire-1-M/axios/0.26.0/axios.min.js" type="application/javascript">script>

head>

<body>

body>

<script>

/*axios的取消的语法*/

// 方式1-通过axios.CancelToken.source产生cancelToken和cancel方法

/*

const source = axios.CancelToken.source();

axios.get('http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test', {

params: {username: 'zs', age: 20},

cancelToken: source.token

}).then(res=>{

console.log('res', res.data)

}).catch(err=>{

console.log('err', err)

})

//在谷歌浏览器的低速3g下面测试

//通过调用source的cancel方法取消

setTimeout(() => source.cancel(), 100);

*/

/**/

// 方式2-通过new axios.CancelToken产生cancelToken和cancel方法

let cancelFn

const cancelToken = new axios.CancelToken(cancel=>{

cancelFn = cancel

});

axios.get('http://nodejs-cloud-studio-demo-bkzxs.nodejs-cloud-studio-demo.50185620.cn-hangzhou.fc.devsapp.net/test', {

params: {username: 'zs', age: 20},

cancelToken: cancelToken

}).then(res=>{

console.log('res', res.data)

}).catch(err=>{

console.log('err', err)

})

//在谷歌浏览器的低速3g下面测试

//通过调用cancelFn方法取消

setTimeout(() => cancelFn(), 100);

script>

html>作者:黄金林

来源:juejin.cn/post/7189231050806001719

原本已经基于系统方案适配了暗黑主题,实现了白/黑两套皮肤,以及跟随系统。后来老板研究学习友商时,发现友商 App 有三套皮肤可选,除了常规的亮白和暗黑,还有一套暗蓝色。并且在跟随系统暗黑模式下,用户可选暗黑还是暗蓝。这不,新的需求马上就来了。

其实我们之前两个 App 的换肤方案都是使用 Android-skin-support 来做的,在此基础上再加套皮肤也不是难事。但在新的 App 实现多皮肤时,由于前两个 App 做了这么久都只有两套皮肤,而且新的 App 需要实现跟随系统,为了更好的体验和较少的代码实现,就采用了系统方案进行适配暗黑模式。

以 Android-skin-support 和系统两种方案适配经验来看,系统方案适配改动的代码更少,所花费的时间当然也就更少了。所以在需要新添一套皮肤的时候,也不可能再去切方案了。那么在使用系统方案的情况下,如何再加一套皮肤呢?来,先看源码吧。

以下源码基于 android-31

首先,在代码中获取资源一般通过 Context 对象的一些方法,例如:

// Context.java

@ColorInt

public final int getColor(@ColorRes int id) {

return getResources().getColor(id, getTheme());

}

@Nullable

public final Drawable getDrawable(@DrawableRes int id) {

return getResources().getDrawable(id, getTheme());

}可以看到 Context 是通过 Resources 对象再去获取的,继续看 Resources:

// Resources.java

@ColorInt

public int getColor(@ColorRes int id, @Nullable Theme theme) throws NotFoundException {

final TypedValue value = obtainTempTypedValue();

try {

final ResourcesImpl impl = mResourcesImpl;

impl.getValue(id, value, true);

if (value.type >= TypedValue.TYPE_FIRST_INT

&& value.type <= TypedValue.TYPE_LAST_INT) {

return value.data;

} else if (value.type != TypedValue.TYPE_STRING) {

throw new NotFoundException("Resource ID #0x" + Integer.toHexString(id) + " type #0x" + Integer.toHexString(value.type) + " is not valid");

}

// 这里调用 ResourcesImpl#loadColorStateList 方法获取颜色

final ColorStateList csl = impl.loadColorStateList(this, value, id, theme);

return csl.getDefaultColor();

} finally {

releaseTempTypedValue(value);

}

}

public Drawable getDrawable(@DrawableRes int id, @Nullable Theme theme)

throws NotFoundException {

return getDrawableForDensity(id, 0, theme);

}

@Nullable

public Drawable getDrawableForDensity(@DrawableRes int id, int density, @Nullable Theme theme) {

final TypedValue value = obtainTempTypedValue();

try {

final ResourcesImpl impl = mResourcesImpl;

impl.getValueForDensity(id, density, value, true);

// 看到这里

return loadDrawable(value, id, density, theme);

} finally {

releaseTempTypedValue(value);

}

}

@NonNull

@UnsupportedAppUsage(maxTargetSdk = Build.VERSION_CODES.R, trackingBug = 170729553)

Drawable loadDrawable(@NonNull TypedValue value, int id, int density, @Nullable Theme theme)

throws NotFoundException {

// 这里调用 ResourcesImpl#loadDrawable 方法获取 drawable 资源

return mResourcesImpl.loadDrawable(this, value, id, density, theme);

}到这里我们知道在代码中获取资源时,是通过 Context -> Resources -> ResourcesImpl 调用链实现的。

先看 ResourcesImpl.java:

/**

* The implementation of Resource access. This class contains the AssetManager and all caches

* associated with it.

*

* {@link Resources} is just a thing wrapper around this class. When a configuration change

* occurs, clients can retain the same {@link Resources} reference because the underlying

* {@link ResourcesImpl} object will be updated or re-created.

*

* @hide

*/

public class ResourcesImpl {

...

}虽然是 public 的类,但是被 @hide 标记了,意味着想通过继承后重写相关方法这条路行不通了,pass。

再看 Resources.java,同样是 public 类,但没被 @hide 标记。我们就可以通过继承 Resources 类,然后重写 Resources#getColor 和 Resources#getDrawableForDensity 等方法来改造获取资源的逻辑。

先看相关代码:

// SkinResources.kt

class SkinResources(context: Context, res: Resources) : Resources(res.assets, res.displayMetrics, res.configuration) {

val contextRef: WeakReference<Context> = WeakReference(context)

override fun getDrawableForDensity(id: Int, density: Int, theme: Theme?): Drawable? {

return super.getDrawableForDensity(resetResIdIfNeed(contextRef.get(), id), density, theme)

}

override fun getColor(id: Int, theme: Theme?): Int {

return super.getColor(resetResIdIfNeed(contextRef.get(), id), theme)

}

private fun resetResIdIfNeed(context: Context?, resId: Int): Int {

// 非暗黑蓝无需替换资源 ID

if (context == null || !UIUtil.isNightBlue(context)) return resId

var newResId = resId

val res = context.resources

try {

val resPkg = res.getResourcePackageName(resId)

// 非本包资源无需替换

if (context.packageName != resPkg) return newResId

val resName = res.getResourceEntryName(resId)

val resType = res.getResourceTypeName(resId)

// 获取对应暗蓝皮肤的资源 id

val id = res.getIdentifier("${resName}_blue", resType, resPkg)

if (id != 0) newResId = id

} finally {

return newResId

}

}

}主要原理与逻辑:

所有资源都会在 R.java 文件中生成对应的资源 id,而我们正是通过资源 id 来获取对应资源的。

Resources 类提供了 getResourcePackageName/getResourceEntryName/getResourceTypeName 方法,可通过资源 id 获取对应的资源包名/资源名称/资源类型。

过滤掉无需替换资源的场景。

Resources 还提供了 getIdentifier 方法来获取对应资源 id。

需要适配暗蓝皮肤的资源,统一在原资源名称的基础上加上 _blue 后缀。

通过 Resources#getIdentifier 方法获取对应暗蓝皮肤的资源 id。如果没找到,改方法会返回 0。

现在就可以通过 SkinResources 来获取适配多皮肤的资源了。但是,之前的代码都是通过 Context 直接获取的,如果全部替换成 SkinResources 来获取,那代码改动量就大了。

我们回到前面 Context.java 的源码,可以发现它获取资源时,都是通过 Context#getResources 方法先得到 Resources 对象,再通过其去获取资源的。而 Context#getResources 方法也是可以重写的,这意味着我们可以维护一个自己的 Resources 对象。Application 和 Activity 也都是继承自 Context 的,所以我们在其子类中重写 getResources 方法即可:

// BaseActivity.java/BaseApplication.java

private Resources mSkinResources;

@Override

public Resources getResources() {

if (mSkinResources == null) {

mSkinResources = new SkinResources(this, super.getResources());

}

return mSkinResources;

}到此,基本逻辑就写完了,马上 build 跑起来。

咦,好像有点不太对劲,有些 color 或 drawable 没有适配成功。

经过一番对比,发现 xml 布局中的资源都没有替换成功。

那么问题在哪呢?还是先从源码着手,先来看看 View 是如何从 xml 中获取并设置 background 属性的:

// View.java

public View(Context context, @Nullable AttributeSet attrs, int defStyleAttr, int defStyleRes) {

this(context);

// AttributeSet 是 xml 中所有属性的集合

// TypeArray 则是经过处理过的集合,将原始的 xml 属性值("@color/colorBg")转换为所需的类型,并应用主题和样式

final TypedArray a = context.obtainStyledAttributes(

attrs, com.android.internal.R.styleable.View, defStyleAttr, defStyleRes);

...

Drawable background = null;

...

final int N = a.getIndexCount();

for (int i = 0; i < N; i++) {

int attr = a.getIndex(i);

switch (attr) {

case com.android.internal.R.styleable.View_background:

// TypedArray 提供一些直接获取资源的方法

background = a.getDrawable(attr);

break;

...

}

}

...

if (background != null) {

setBackground(background);

}

...

}再接着看 TypedArray 是如何获取资源的:

// TypedArray.java

@Nullable

public Drawable getDrawable(@StyleableRes int index) {

return getDrawableForDensity(index, 0);

}

@Nullable

public Drawable getDrawableForDensity(@StyleableRes int index, int density) {

if (mRecycled) {

throw new RuntimeException("Cannot make calls to a recycled instance!");

}

final TypedValue value = mValue;

if (getValueAt(index * STYLE_NUM_ENTRIES, value)) {

if (value.type == TypedValue.TYPE_ATTRIBUTE) {

throw new UnsupportedOperationException(

"Failed to resolve attribute at index " + index + ": " + value);

}

if (density > 0) {

// If the density is overridden, the value in the TypedArray will not reflect this.

// Do a separate lookup of the resourceId with the density override.

mResources.getValueForDensity(value.resourceId, density, value, true);

}

// 看到这里

return mResources.loadDrawable(value, value.resourceId, density, mTheme);

}

return null;

}TypedArray 是通过 Resources#loadDrawable 方法来加载资源的,而我们之前写 SkinResources 的时候并没有重写该方法,为什么呢?那是因为该方法是被 @UnsupportedAppUsage 标记的。所以,这就是 xml 布局中的资源替换不成功的原因。

这个问题又怎么解决呢?

之前采用 Android-skin-support 方案做换肤时,了解到它的原理,其会替换成自己的实现的 LayoutInflater.Factory2,并在创建 View 时替换生成对应适配了换肤功能的 View 对象。例如:将 View 替换成 SkinView,而 SkinView 初始化时再重新处理 background 属性,即可完成换肤。

AppCompat 也是同样的逻辑,通过 AppCompatViewInflater 将普通的 View 替换成带 AppCompat- 前缀的 View。

其实我们只需能操作生成后的 View,并且知道 xml 中写了哪些属性值即可。那么我们完全照搬 AppCompat 这套逻辑即可:

定义类继承 LayoutInflater.Factory2,并实现 onCreateView 方法。

onCreateView 主要是创建 View 的逻辑,而这部分逻辑完全 copy AppCompatViewInflater 类即可。

在 onCreateView 中创建 View 之后,返回 View 之前,实现我们自己的逻辑。

通过 LayoutInflaterCompat#setFactory2 方法,设置我们自己的 Factory2。

相关代码片段:

public class SkinViewInflater implements LayoutInflater.Factory2 {

@Nullable

@Override

public View onCreateView(@Nullable View parent, @NonNull String name, @NonNull Context context, @NonNull AttributeSet attrs) {

// createView 方法就是 AppCompatViewInflater 中的逻辑

View view = createView(parent, name, context, attrs, false, false, true, false);

onViewCreated(context, view, attrs);

return view;

}

@Nullable

@Override

public View onCreateView(@NonNull String name, @NonNull Context context, @NonNull AttributeSet attrs) {

return onCreateView(null, name, context, attrs);

}

private void onViewCreated(@NonNull Context context, @Nullable View view, @NonNull AttributeSet attrs) {

if (view == null) return;

resetViewAttrsIfNeed(context, view, attrs);

}

private void resetViewAttrsIfNeed(Context context, View view, AttributeSet attrs) {

if (!UIUtil.isNightBlue(context)) return;

String ANDROID_NAMESPACE = "http://schemas.android.com/apk/res/android";

String BACKGROUND = "background";

// 获取 background 属性值的资源 id,未找到时返回 0

int backgroundId = attrs.getAttributeResourceValue(ANDROID_NAMESPACE, BACKGROUND, 0);

if (backgroundId != 0) {

view.setBackgroundResource(resetResIdIfNeed(context, backgroundId));

}

}

}

// BaseActivity.java

@Override

public void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

SkinViewInflater inflater = new SkinViewInflater();

LayoutInflater layoutInflater = LayoutInflater.from(this);

// 生成 View 的逻辑替换成我们自己的

LayoutInflaterCompat.setFactory2(layoutInflater, inflater);

}至此,这套方案已经可以解决目前的换肤需求了,剩下的就是进行细节适配了。

上面只对 background 属性进行了处理,其他需要进行换肤的属性也是同样的处理逻辑。如果是自定义的控件,可以在初始化时调用 TypedArray#getResourceId 方法先获取资源 id,再通过 context 去获取对应资源,而不是使用 TypedArray#getDrawable 类似方法直接获取资源对象,这样可以确保换肤成功。而第三方控件也可通过 background 属性同样的处理逻辑进行适配。

<shape> 的处理<!-- bg.xml -->

<shape xmlns:android="http://schemas.android.com/apk/res/android">

<corners android:radius="8dp" />

<solid android:color="@color/background" />

</shape>上面的 bg.xml 文件内的 color 并不会完成资源替换,根据上面的逻辑,需要新增以下内容:

<!-- bg_blue.xml -->

<shape xmlns:android="http://schemas.android.com/apk/res/android">

<corners android:radius="8dp" />

<solid android:color="@color/background_blue" />

</shape>如此,资源替换才会成功。

这次对第三款皮肤的适配还是蛮轻松的,主要是有以下基础:

在适配暗黑主题的时候,设计有出设计规范,后续开发按照设计规范来。

暗黑和暗蓝共用一套图片资源,大大减少适配工作量。

暗黑和暗蓝部份共用颜色值含透明度,同样减少了工作量,仅少量颜色需要新增。

这次适配的主要工作量还是来自 <shape> 的替换。

我知道很多换肤方案都会将皮肤资源制作成皮肤包,但是这个方案没有这么做。一是没有那么多需要替换的资源,二是为了减少相应的工作量。

我新建了一个资源文件夹,与 res 同级,取名 res-blue。并在 gradle 配置文件中配置它。编译后系统会自动将它们合并,同时也能与常规资源文件隔离开来。

// build.gradle

sourceSets {

main {

java {

srcDir 'src/main/java'

}

res.srcDirs += 'src/main/res'

res.srcDirs += 'src/main/res-blue'

}

}版本上线后,发现有 android.content.res.Resources$NotFoundException 异常上报,具体异常堆栈信息:

android.content.res.ResourcesImpl.getValue(ResourcesImpl.java:321)

android.content.res.Resources.getInteger(Resources.java:1279)

org.chromium.ui.base.DeviceFormFactor.b(chromium-TrichromeWebViewGoogle.apk-stable-447211483:4)

org.chromium.content.browser.selection.SelectionPopupControllerImpl.n(chromium-TrichromeWebViewGoogle.apk-stable-447211483:1)

N7.onCreateActionMode(chromium-TrichromeWebViewGoogle.apk-stable-447211483:8)

Gu.onCreateActionMode(chromium-TrichromeWebViewGoogle.apk-stable-447211483:2)

com.android.internal.policy.DecorView$ActionModeCallback2Wrapper.onCreateActionMode(DecorView.java:3255)

com.android.internal.policy.DecorView.startActionMode(DecorView.java:1159)

com.android.internal.policy.DecorView.startActionModeForChild(DecorView.java:1115)

android.view.ViewGroup.startActionModeForChild(ViewGroup.java:1087)

android.view.ViewGroup.startActionModeForChild(ViewGroup.java:1087)

android.view.ViewGroup.startActionModeForChild(ViewGroup.java:1087)

android.view.ViewGroup.startActionModeForChild(ViewGroup.java:1087)

android.view.ViewGroup.startActionModeForChild(ViewGroup.java:1087)

android.view.ViewGroup.startActionModeForChild(ViewGroup.java:1087)

android.view.View.startActionMode(View.java:7716)

org.chromium.content.browser.selection.SelectionPopupControllerImpl.I(chromium-TrichromeWebViewGoogle.apk-stable-447211483:10)

Vc0.a(chromium-TrichromeWebViewGoogle.apk-stable-447211483:10)

Vf0.i(chromium-TrichromeWebViewGoogle.apk-stable-447211483:4)

A5.run(chromium-TrichromeWebViewGoogle.apk-stable-447211483:3)

android.os.Handler.handleCallback(Handler.java:938)

android.os.Handler.dispatchMessage(Handler.java:99)

android.os.Looper.loopOnce(Looper.java:233)

android.os.Looper.loop(Looper.java:334)

android.app.ActivityThread.main(ActivityThread.java:8333)

java.lang.reflect.Method.invoke(Native Method)

com.android.internal.os.RuntimeInit$MethodAndArgsCaller.run(RuntimeInit.java:582)

com.android.internal.os.ZygoteInit.main(ZygoteInit.java:1065)经查才发现在 WebView 中长按文本弹出操作菜单时,就会引发该异常导致 App 闪退。

这是其他插件化方案也踩过的坑,我们只需在创建 SkinResources 之前将外部 WebView 的资源路径添加进来即可。

@Override

public Resources getResources() {

if (mSkinResources == null) {

WebViewResourceHelper.addChromeResourceIfNeeded(this);

mSkinResources = new SkinResources(this, super.getResources());

}

return mSkinResources;

}具体问题分析可参考

这个方案在原本使用系统方式适配暗黑主题的基础上,通过拦截 Resources 相关获取资源的方法,替换换肤后的资源 id,以达到换肤的效果。针对 XML 布局换肤不成功的问题,复制 AppCompatViewInflater 创建 View 的代码逻辑,并在 View 创建成功后重新设置需要进行换肤的相关 XML 属性。同一皮肤资源使用单独的资源文件夹独立存放,可以与正常资源进行隔离,也避免了制作皮肤包而增加工作量。

目前来说这套方案是改造成本最小,侵入性最小的选择。选择适合自身需求的才是最好的。

作者:ONEW

来源:https://juejin.cn/post/7187282270360141879

点赞的数字增加和减少并不是整个替换,而是差异化替换。再加上动画效果就看的很舒服。

下面用一张图来展示我的思路:

现在只需要根据这张图,写出对应的动画即可。 分为2种场景:

数字+1:

差异化的数字从3号区域由渐变动画(透明度 0- 255) + 偏移动画 (3号区域绘制文字的基线,2号区域绘制文字的基线),将数字移动到2号位置处

差异化的数字从2号区域由渐变动画(透明度 255- 0) + 偏移动画(2号区域绘制文字的基线,1号区域绘制文字的基线),将数字移动到1号位置处

数字-1

差异化的数字从1号区域由渐变动画(透明度 0- 255) + 偏移动画 (1号区域绘制文字的基线,2号区域绘制文字的基线),将数字移动到2号位置处

差异化的数字从2号区域由渐变动画(透明度 255- 0) + 偏移动画(2号区域绘制文字的基线,3号区域绘制文字的基线),将数字移动到3号位置处

公共部分就是: 不变的文字不需要做任何处理,绘制在2号区域就行。绘制差异化文字时,需要加上不变的文字的宽度就行。

class LikeView @JvmOverloads constructor(

context: Context, attrs: AttributeSet? = null, defStyleAttr: Int = 0

) : View(context, attrs, defStyleAttr) {

private val paint = Paint().also {

it.isAntiAlias = true

it.textSize = 200f

}

private val textRect0 = Rect(300, 100, 800, 300)

private val textRect1 = Rect(300, 300, 800, 500)

private val textRect2 = Rect(300, 500, 800, 700)

private var nextNumberAlpha: Int = 0

set(value) {

field = value

invalidate()

}

private var currentNumberAlpha: Int = 255

set(value) {

field = value

invalidate()

}

private var offsetPercent = 0f

set(value) {

field = value

invalidate()

}

private val fontMetrics: FontMetrics = paint.fontMetrics

private var currentNumber = 99

private var nextNumber = 0

private var motionLess = currentNumber.toString()

private var currentMotion = ""

private var nextMotion = ""

private val animator: ObjectAnimator by lazy {

val nextNumberAlphaAnimator = PropertyValuesHolder.ofInt("nextNumberAlpha", 0, 255)

val offsetPercentAnimator = PropertyValuesHolder.ofFloat("offsetPercent", 0f, 1f)

val currentNumberAlphaAnimator = PropertyValuesHolder.ofInt("currentNumberAlpha", 255, 0)

val animator = ObjectAnimator.ofPropertyValuesHolder(

this,

nextNumberAlphaAnimator,

offsetPercentAnimator,

currentNumberAlphaAnimator

)

animator.duration = 200

animator.interpolator = DecelerateInterpolator()

animator.addListener(

onEnd = {

currentNumber = nextNumber

}

)

animator

}

override fun onDraw(canvas: Canvas) {

paint.alpha = 255

paint.color = Color.LTGRAY

canvas.drawRect(textRect0, paint)

paint.color = Color.RED

canvas.drawRect(textRect1, paint)

paint.color = Color.GREEN

canvas.drawRect(textRect2, paint)

paint.color = Color.BLACK

if (motionLess.isNotEmpty()) {

drawText(canvas, motionLess, textRect1, 0f)

}

if (nextMotion.isEmpty() || currentMotion.isEmpty()) {

return

}

val textHorizontalOffset =

if (motionLess.isNotEmpty()) paint.measureText(motionLess) else 0f

if (nextNumber > currentNumber) {

paint.alpha = currentNumberAlpha

drawText(canvas, currentMotion, textRect1, textHorizontalOffset, -offsetPercent)

paint.alpha = nextNumberAlpha

drawText(canvas, nextMotion, textRect2, textHorizontalOffset, -offsetPercent)

} else {

paint.alpha = nextNumberAlpha

drawText(canvas, nextMotion, textRect0, textHorizontalOffset, offsetPercent)

paint.alpha = currentNumberAlpha

drawText(canvas, currentMotion, textRect1, textHorizontalOffset, offsetPercent)

}

}

private fun drawText(

canvas: Canvas,

text: String,

rect: Rect,

textHorizontalOffset: Float = 0f,

offsetPercent: Float = 0f

) {

canvas.drawText(

text,

rect.left.toFloat() + textHorizontalOffset,

rect.top + (rect.bottom - rect.top) / 2f - (fontMetrics.bottom + fontMetrics.top) / 2f + offsetPercent * 200,

paint

)

}

override fun onDetachedFromWindow() {

super.onDetachedFromWindow()

animator.end()

}

fun plus() {

if (currentNumber == Int.MAX_VALUE) {

return

}

nextNumber = currentNumber + 1

processText(findEqualsStringIndex())

if (animator.isRunning) {

return

}

animator.start()

}

fun minus() {

if (currentNumber == 0) {

return

}

nextNumber = currentNumber - 1

processText(findEqualsStringIndex())

if (animator.isRunning) {

return

}

animator.start()

}

private fun findEqualsStringIndex(): Int {

var equalIndex = -1

val nextNumberStr = nextNumber.toString()

val currentNumberStr = currentNumber.toString()

val endIndex = min(currentNumberStr.length, nextNumberStr.length) - 1

for (index in 0..endIndex) {

if (nextNumberStr[index] != currentNumberStr[index]) {

break

}

equalIndex = index

}

return equalIndex

}

private fun processText(index: Int) {

val currentNumberStr = currentNumber.toString()

val nextNumberStr = nextNumber.toString()

if (index == -1) {

motionLess = ""

currentMotion = currentNumberStr

nextMotion = nextNumberStr

} else {

motionLess = currentNumberStr.substring(0, index + 1)

currentMotion = currentNumberStr.substring(index + 1)

nextMotion = nextNumberStr.substring(index + 1)

}

}

}作者:timer

来源:juejin.cn/post/7179181214530551867

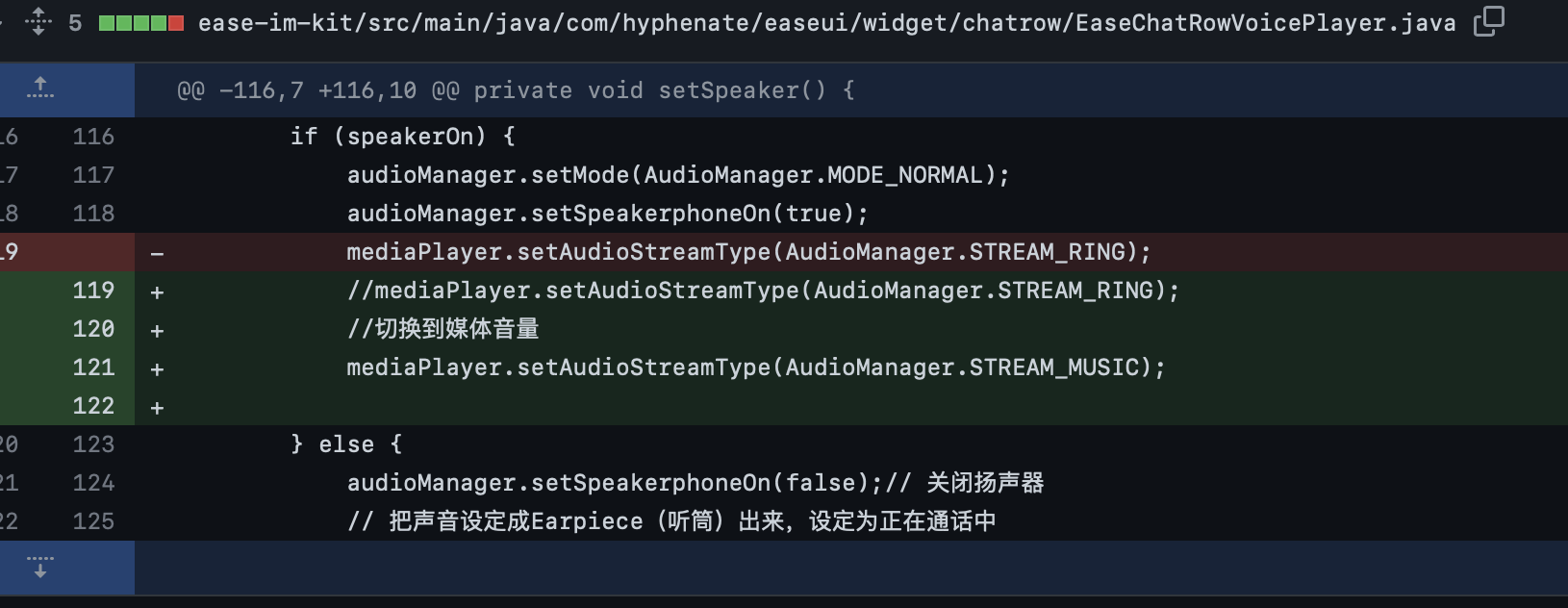

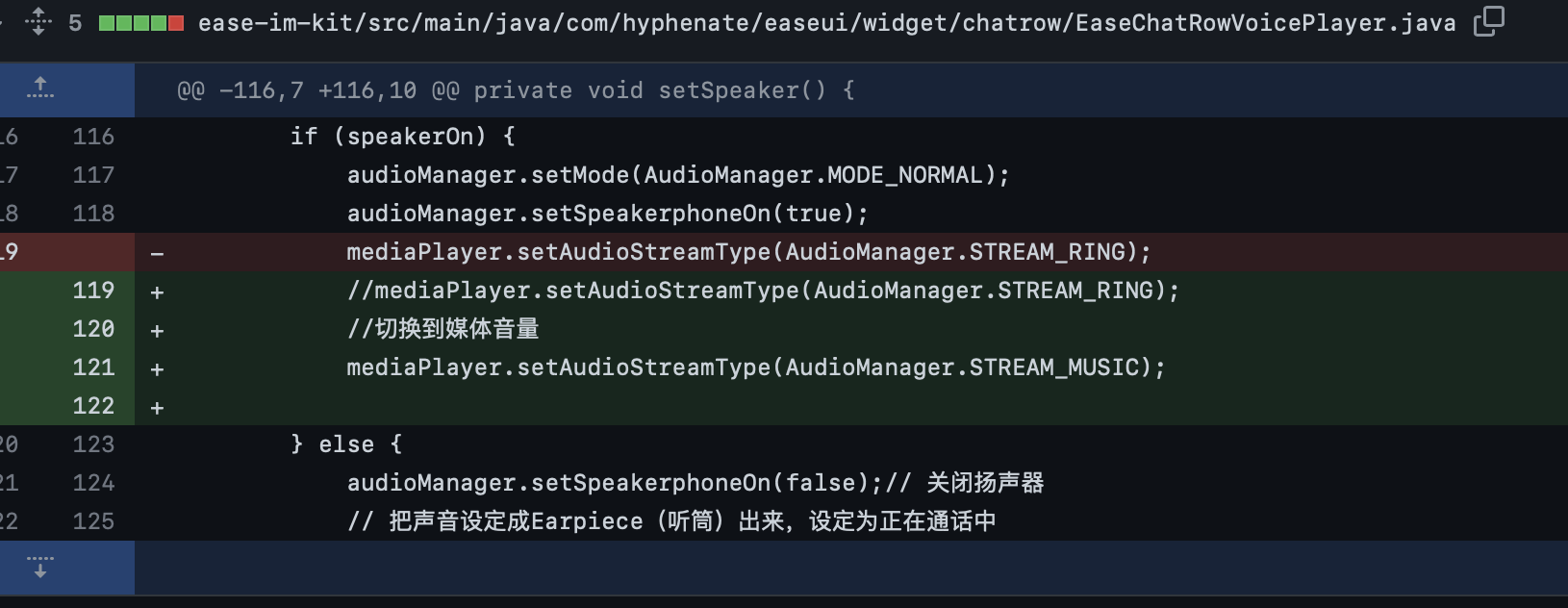

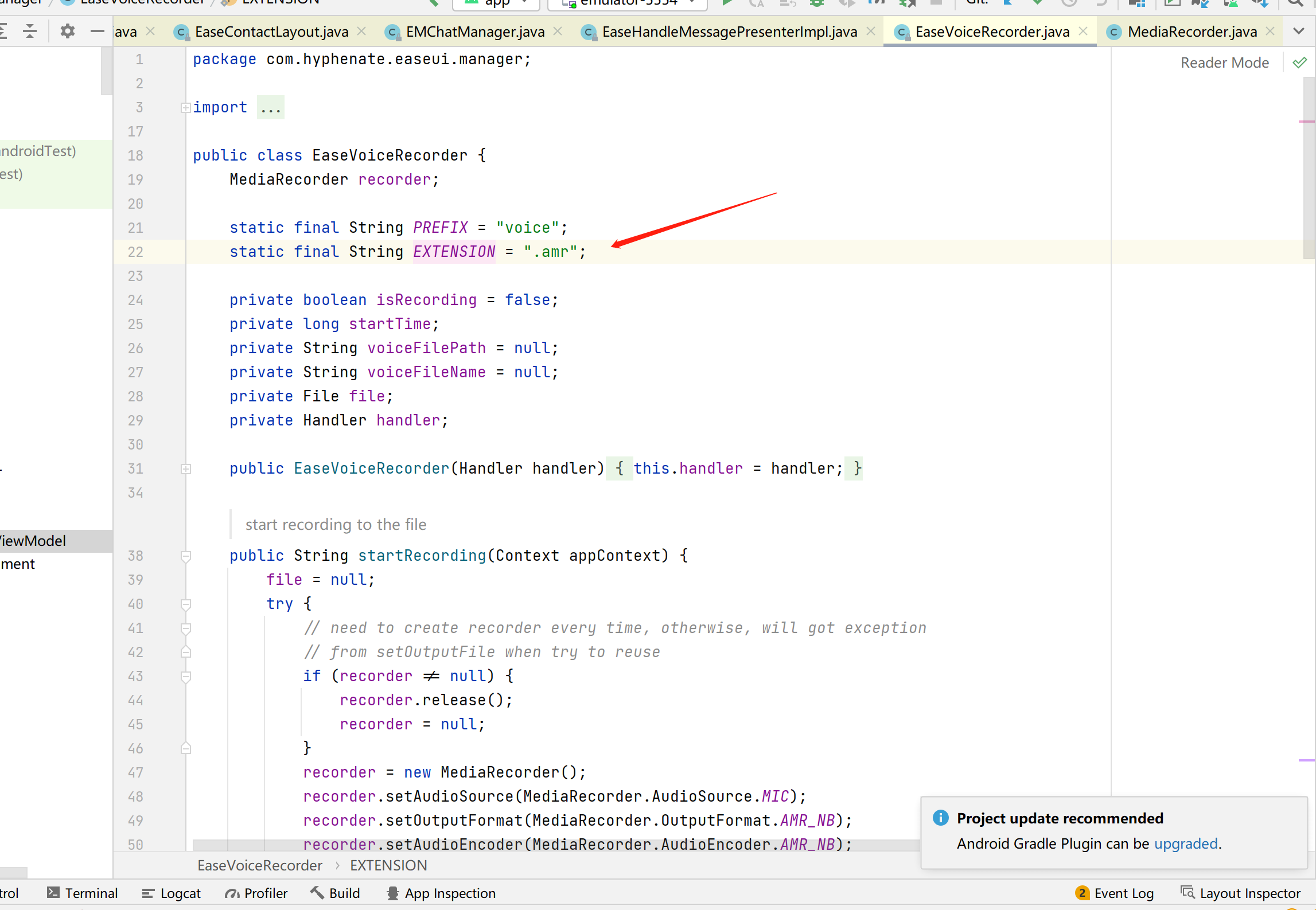

接到一个开发需求,需要定制化开发一个安全音量功能;此前有了解过为了符合欧盟等有关国家和地区的规定,原生Android是有自带一个安全音量功能的,想要定制则先要了解这个功能原先长什么样子,下面我们就从一个系统工程师的角度出发去探寻一下,原生Android的安全音量功能是如何实现的。

安全音量的相关配置都在framework的config.xml里面,可以直接修改或者overlay配置修改其默认值。

<!-- Whether safe headphone volume is enabled or not (country specific). -->

<bool name="config_safe_media_volume_enabled">true</bool>

<!-- Safe headphone volume index. When music stream volume is below this index

the SPL on headphone output is compliant to EN 60950 requirements for portable music

players. -->

<integer name="config_safe_media_volume_index">10</integer>

config_safe_media_volume_enabled是安全音量功能的总开关,config_safe_media_volume_index则是表明触发安全音量弹框的音量大小值。

安全音量的主要流程都在AudioService里面,其大致流程如下图所示:

系统启动过程略去不表,在系统启动完成后会调用onSystemReady;在onSystemReady中,service会发送一个MSG_CONFIGURE_SAFE_MEDIA_VOLUME_FORCED的msg,强制配置安全音量。

public void onSystemReady() {

...

sendMsg(mAudioHandler,

MSG_CONFIGURE_SAFE_MEDIA_VOLUME_FORCED,

SENDMSG_REPLACE,

0,

0,

TAG,

SystemProperties.getBoolean("audio.safemedia.bypass", false) ?

0 : SAFE_VOLUME_CONFIGURE_TIMEOUT_MS);

...

}发送的MSG_CONFIGURE_SAFE_MEDIA_VOLUME_FORCED会调用onConfigureSafeVolume()来进行安全音量的配置

private void onConfigureSafeVolume(boolean force, String caller) {

synchronized (mSafeMediaVolumeStateLock) {

//Mobile contry code,国家代码,主要用来区分不同国家,部分国家策略可能会不一致

int mcc = mContext.getResources().getConfiguration().mcc;

if ((mMcc != mcc) || ((mMcc == 0) && force)) {

//从config_safe_media_volume_index中获取回来的安全音量触发阈值

mSafeMediaVolumeIndex = mContext.getResources().getInteger(

com.android.internal.R.integer.config_safe_media_volume_index) * 10;

mSafeUsbMediaVolumeIndex = getSafeUsbMediaVolumeIndex();

//根据audio.safemedia.force属性值或者value配置的值来决定是否使能安全音量

boolean safeMediaVolumeEnabled =

SystemProperties.getBoolean("audio.safemedia.force", false)

|| mContext.getResources().getBoolean(

com.android.internal.R.bool.config_safe_media_volume_enabled);

//确认是否需要bypass掉安全音量功能

boolean safeMediaVolumeBypass =

SystemProperties.getBoolean("audio.safemedia.bypass", false);

// The persisted state is either "disabled" or "active": this is the state applied

// next time we boot and cannot be "inactive"

int persistedState;

if (safeMediaVolumeEnabled && !safeMediaVolumeBypass) {

persistedState = SAFE_MEDIA_VOLUME_ACTIVE; //这个值只能是disable或者active,不能是inactive,主要用于下次启动。

// The state can already be "inactive" here if the user has forced it before

// the 30 seconds timeout for forced configuration. In this case we don't reset

// it to "active".

if (mSafeMediaVolumeState != SAFE_MEDIA_VOLUME_INACTIVE) {

if (mMusicActiveMs == 0) { //mMusicActiveMs主要用于计数,当安全音量弹框弹出时,如果按了确定,这个值便开始递增,当其达到UNSAFE_VOLUME_MUSIC_ACTIVE_MS_MAX时,则重新使能安全音量

mSafeMediaVolumeState = SAFE_MEDIA_VOLUME_ACTIVE;

enforceSafeMediaVolume(caller);

} else {

//跑到这里则表示已经弹过安全音量警示了,并且按了确定,所以把值设置为inactive

// We have existing playback time recorded, already confirmed.

mSafeMediaVolumeState = SAFE_MEDIA_VOLUME_INACTIVE;

}

}

} else {

persistedState = SAFE_MEDIA_VOLUME_DISABLED;

mSafeMediaVolumeState = SAFE_MEDIA_VOLUME_DISABLED;

}

mMcc = mcc;

//持久化当前安全音量的状态

sendMsg(mAudioHandler,

MSG_PERSIST_SAFE_VOLUME_STATE,

SENDMSG_QUEUE,

persistedState,

0,

null,

0);

}

}

}由上可知,onConfigureSafeVolume()主要用于配置和使能安全音量功能,并且通过发送MSG_PERSIST_SAFE_VOLUME_STATE来持久化安全音量配置的值,这个持久化的值只能是active或者disabled。

case MSG_PERSIST_SAFE_VOLUME_STATE:

onPersistSafeVolumeState(msg.arg1);

break;

....

....

private void onPersistSafeVolumeState(int state) {

Settings.Global.putInt(mContentResolver,

Settings.Global.AUDIO_SAFE_VOLUME_STATE,

state);

}

从实际操作可知,安全音量触发条件是:音量增大到指定值。

从调节音量的代码出发,在调用mAudioManager.adjustStreamVolume和mAudioManager.setStreamVolume时,最终会调用到AudioService中的同名方法,在执行该方法的内部:

protected void adjustStreamVolume(int streamType, int direction, int flags,

String callingPackage, String caller, int uid) {

...

...

...

} else if ((direction == AudioManager.ADJUST_RAISE) &&

!checkSafeMediaVolume(streamTypeAlias, aliasIndex + step, device)) {

Log.e(TAG, "adjustStreamVolume() safe volume index = " + oldIndex);

mVolumeController.postDisplaySafeVolumeWarning(flags);

....

...

private void setStreamVolume(int streamType, int index, int flags, String callingPackage,

String caller, int uid) {

....

....

if (!checkSafeMediaVolume(streamTypeAlias, index, device)) {

mVolumeController.postDisplaySafeVolumeWarning(flags);

mPendingVolumeCommand = new StreamVolumeCommand(

streamType, index, flags, device);

} else {

onSetStreamVolume(streamType, index, flags, device, caller);

index = mStreamStates[streamType].getIndex(device);

}

....

....由以上代码可以看出,其安全音量弹框警告的触发地方就在checkSafeMediaVolume方法附近处,并且都是通过mVolumeController这个远程服务去调用UI显示安全音量弹框警告,但两种调节音量的方法,触发效果略有不同:

private boolean checkSafeMediaVolume(int streamType, int index, int device) {

synchronized (mSafeMediaVolumeStateLock) {

if ((mSafeMediaVolumeState == SAFE_MEDIA_VOLUME_ACTIVE) &&

(mStreamVolumeAlias[streamType] == AudioSystem.STREAM_MUSIC) &&

((device & mSafeMediaVolumeDevices) != 0) &&

(index > safeMediaVolumeIndex(device))) {

return false;

}

return true;

}

}以上是安全音量判断条件checkSafeMediaVolume,可以看出其判断主要根据以下条件:

/*package*/ final int mSafeMediaVolumeDevices = AudioSystem.DEVICE_OUT_WIRED_HEADSET

| AudioSystem.DEVICE_OUT_WIRED_HEADPHONE

| AudioSystem.DEVICE_OUT_USB_HEADSET;

由上可知,只针对耳机播放或者USB耳机才做安全音量功能,如有需要系统工程师可自行配置其他设备;

上面有提到,当满足安全音量警示框的触发条件时,会通过mVolumeController这个远程服务去调用UI显示安全音量弹框警告,其调用链条有点长,中途略过不表,其最终会走到VolumeDialogImpl.java的showSafetyWarningH,如下:

public class VolumeDialog {

...

private void showSafetyWarningH(int flags) {

if ((flags & (AudioManager.FLAG_SHOW_UI | AudioManager.FLAG_SHOW_UI_WARNINGS)) != 0

|| mShowing) {

synchronized (mSafetyWarningLock) {

if (mSafetyWarning != null) {

return;

}

mSafetyWarning = new SafetyWarningDialog(mContext, mController.getAudioManager()) {

@Override

protected void cleanUp() {

synchronized (mSafetyWarningLock) {

mSafetyWarning = null;

}

recheckH(null);

}

};

mSafetyWarning.show();

}

recheckH(null);

}

rescheduleTimeoutH();

}

...

}UI配置部分主要在SafetyWarningDialog.java,代码就不贴了,可自行查看,其本质是一个对话框,在弹出时会抢占UI焦点,如果不点击确定或取消,则无法操作其他UI;点击确定后,会调用mAudioManager.disableSafeMediaVolume()来暂时关闭安全音量警告功能,但上面有提到,当点击确定之后其实是启动了一个变量mMusicActiveMs的计数,当这个计数到达一定值(默认是20个小时),安全音量会重新启动;但如果点击了取消,再继续调大音量时,安全音量弹框还是会继续弹出;

上面有提到,在安全音量弹框弹出后,点击确定可以暂时关闭安全音量警告功能,其实最终会调用到AudioService中的disableSafeMediaVolume(),代码如下:

public void disableSafeMediaVolume(String callingPackage) {

enforceVolumeController("disable the safe media volume");

synchronized (mSafeMediaVolumeStateLock) {

setSafeMediaVolumeEnabled(false, callingPackage);

if (mPendingVolumeCommand != null) {

onSetStreamVolume(mPendingVolumeCommand.mStreamType,

mPendingVolumeCommand.mIndex,

mPendingVolumeCommand.mFlags,

mPendingVolumeCommand.mDevice,

callingPackage);

mPendingVolumeCommand = null;

}

}

}一方面是调用setSafeMediaVolumeEnabled来暂时关闭安全音量功能,另一方面会把此前临时挂起的设置音量mPendingVolumeCommand重新设置回去。

简单来讲,Android原生的安全音量功能默认强制打开,在插入耳机后,音量调节到指定阈值时,会触发音量警告弹框,该弹框会抢走焦点,不点击确定或取消无法进行其他操作;在点击确定后,默认操作者本人允许设备音量继续往上调,但此时系统会开始一个默认为20分钟的倒计时,在这20分钟内音量随意调节都不会触发安全音量弹框,但20分钟结束后,音量大于阈值时会继续触发安全音量弹框,提醒使用者注意。

各个团队多少都有一些自己的代码规范,但制定代码规范简单,困难的是如何落地。如果完全依赖人力Code Review难免有所遗漏。

这个时候就需要通过静态代码检查工具在每次提交代码时自动检查,本文主要介绍如何使用DeteKt落地Kotlin代码规范,主要包括以下内容

DeteKt?IDE接入DeteKt插件CLI命令行方式接入DeteKtGradle方式接入DeteKtDetekt检测规则Github Action集成Detekt检测DeteKt?说起静态代码检查,大家首先想起来的可能是lint,相比DeteKt只支持Kotlin代码,lint不仅支持Kotlin,Java代码,也支持资源文件规范检查,那么我们为什么不使用Lint呢?

在我看来,Lint在使用上主要有两个问题:

IDE集成不够好,自定义lint规则的警告只有在运行./gradlew lint后才会在IDE上展示出来,在clean之后又会消失lint检查速度较慢,尤其是大型项目,只对增量代码进行检查的逻辑需要自定义而DeteKt提供了IDE插件,开启后可直接在IDE中查看警告,这样可以在第一时间发现问题,避免后续检查发现问题后再修改流程过长的问题

同时Detekt支持CLI命令行方式接入与Gradle方式接入,支持只检查新增代码,在检查速度上比起lint也有一定的优势

IDE接入DeteKt插件如果能在IDE中提示代码中存在的问题,应该是最快发现问题的方式,DeteKt也贴心的为我们准备了插件,如下所示:

主要可以配置以下内容:

DeteKt开关DeteKt直接使用了ktlint的规则Configuration file:规则配置文件,可以在其中配置各种规则的开关与参数,默认配置可见:default-detekt-config.ymlBaseline file:基线文件,跳过旧代码问题,有了这个基线文件,下次扫描时,就会绕过文件中列出的基线问题,而只提示新增问题。Plugin jar: 自定义规则jar包,在自定义规则后打出jar包,在扫描时就可以使用自定义规则了DeteKt IDE插件可以实时提示问题(包括自定义规则),如下图所示,我们添加了自定义禁止使用kae的规则:

对于一些支持自动修复的格式问题,DeteKt插件支持自动格式化,同时也可以配置快捷键,一键自动格式化,如下所示:

CLI命令行方式接入DeteKtDeteKt支持通过CLI命令行方式接入,支持只检测几个文件,比如本次commit提交的文件

我们可以通过如下方式,下载DeteKt的jar然后使用

curl -sSLO https://github.com/detekt/detekt/releases/download/v1.22.0-RC1/detekt-cli-1.22.0-RC1.zip

unzip detekt-cli-1.22.0-RC1.zip

./detekt-cli-1.22.0-RC1/bin/detekt-cli --help

DeteKt CLI支持很多参数,下面列出一些常用的,其他可以参见:Run detekt using Command Line Interface

Usage: detekt [options]

Options:

--auto-correct, -ac

支持自动格式化的规则自动格式化,默认为false

Default: false

--baseline, -b

如果传入了baseline文件,只有不在baseline文件中的问题才会掘出来

--classpath, -cp

实验特性:传入依赖的class路径和jar的路径,用于类型解析

--config, -c

规则配置文件,可以配置规则开关及参数

--create-baseline, -cb

创建baseline,默认false,如果开启会创建出一个baseline文件,供后续使用

--input, -i

输入文件路径,多个路径之间用逗号连接

--jvm-target

EXPERIMENTAL: Target version of the generated JVM bytecode that was

generated during compilation and is now being used for type resolution

(1.6, 1.8, 9, 10, 11, 12, 13, 14, 15, 16 or 17)

Default: 1.8

--language-version

为支持类型解析,需要传入java版本

--plugins, -p

自定义规则jar路径,多个路径之间用,或者;连接

在命令行可以直接通过如下方式检查

java -jar /path/to/detekt-cli-1.21.0-all.jar # detekt-cli-1.21.0-all.jar所在路径

-c /path/to/detekt_1.21.0_format.yml # 规则配置文件所在路径

--plugins /path/to/detekt-formatting-1.21.0.jar # 格式化规则jar,主要基于ktlint封装

-ac # 开启自动格式化

-i $FilePath$ # 需要扫描的源文件,多个路径之间用,或者;连接

通过如上方式进行代码检查速度是非常快的,根据经验来说一般就是几秒之内可以完成,因此我们完成可以将DeteKt与git hook结合起来,在每次提交commit的时候进行检测,而如果是一些比较耗时的工具比如lint,应该是做不到这一点的

上面我们提到了,DeteKt的--classpth参数与--language-version参数,这些是用于类型解析的。

类型解析是DeteKt的一项功能,它允许 Detekt 对您的 Kotlin 源代码执行更高级的静态分析。

通常,Detekt 在编译期间无法访问编译器语义分析的结果,我们只能获取Kotlin源代码的抽象语法树,却无法知道语法树上符号的语义,这限制了我们的检查能力,比如我们无法判断符号的类型,两个符号究竟是不是同一个对象等

通过启用类型解析,Detekt 可以获取Kotlin编译器语义分析的结果,这让我们可以自定义一些更高级的检查。

而要获取类型与语义,当然要传入依赖的class,也就是classpath,比如android项目中常常需要传入android.jar与kotlin-stdlib.jar

Gradle方式接入DeteKtCLI方式检测虽然快,但是需要手动传入classpath,比较麻烦,尤其是有时候自定义规则需要解析我们自己的类而不是kotlin-stdlib.jar中的类时,那么就需要将项目中的代码的编译结果传入作为classpath了,这样就更麻烦了

DeteKt同样支持Gradle插件方式接入,这种方式不需要我们另外再配置classpath,我们可以将CLI命令行方式与Gradle方式结合起来,在本地通过CLI方式快速检测,在CI上通过Gradle插件进行完整的检测

// 1. 引入插件

plugins {

id("io.gitlab.arturbosch.detekt").version("[version]")

}

repositories {

mavenCentral()

}

// 2. 配置插件

detekt {

config = files("$projectDir/config/detekt.yml") // 规则配置

baseline = file("$projectDir/config/baseline.xml") // baseline配置

parallel = true

}

// 3. 自定义规则

dependencies {

detektPlugins "io.gitlab.arturbosch.detekt:detekt-formatting:1.21.0"

detektPlugins project(":customRules")

}

// 4. 配置 jvmTarget

tasks.withType(Detekt).configureEach {

jvmTarget = "1.8"

}

// DeteKt Task用于检测,DetektCreateBaselineTask用于创建Baseline

tasks.withType(DetektCreateBaselineTask).configureEach {

jvmTarget = "1.8"

}

// 5. 只分析指定文件

tasks.withType<io.gitlab.arturbosch.detekt.Detekt>().configureEach {

// include("**/special/package/**") // 只分析 src/main/kotlin 下面的指定目录文件

exclude("**/special/package/internal/**") // 过滤指定目录

}

如上所示,接入主要需要做这么几件事:

config与baseline,即规则开关与老代码过滤detekt-formatting与自定义规则的依赖JvmTarget,用于类型解析,但不用再配置classpath了。baseline之外,也可以通过include与exclude的方式指定只扫描指定文件的方式来实现增量检测通过以上方式就接入成功了,运行./gradlew detektDebug就可以开始检测了,扫描结果可在终端直接查看,并可以直接定位到问题代码处,也可以在build/reprots/路径下查看输出的报告文件:

Detekt检测规则要落地自己制定的代码规范,不可避免的需要自定义规则,当然我们首先要看下DeteKt自带的规则,是否已经有我们需要的,只需把开关打开即可.

DeteKt自带规则DeteKt自带的规则都可以通过开关配置,如果没有在 Detekt 闭包中指定 config 属性,detekt 会使用默认的规则。这些规则采用 yaml 文件描述,运行 ./gradlew detektGenerateConfig 会生成 config/detekt/detekt.yml 文件,我们可以在这个文件的基础上制定代码规范准则。

detekt.yml 中的每条规则形如:

complexity: # 大类

active: true

ComplexCondition: # 规则名

active: true # 是否启用

threshold: 4 # 有些规则,可以设定一个阈值

# ...更多关于配置文件的修改方式,请参考官方文档-配置文件

Detekt 的规则集划分为 9 个大类,每个大类下有具体的规则:

| 规则大类 | 说明 |

|---|---|

| comments | 与注释、文档有关的规范检查 |

| complexity | 检查代码复杂度,复杂度过高的代码不利于维护 |

| coroutines | 与协程有关的规范检查 |

| empty-blocks | 空代码块检查,空代码应该尽量避免 |

| exceptions | 与异常抛出和捕获有关的规范检查 |

| formatting | 格式化问题,detekt直接引用的 ktlint 的格式化规则集 |

| naming | 类名、变量命名相关的规范检查 |

| performance | 检查潜在的性能问题 |

| potentail-bugs | 检查潜在的BUG |

| style | 统一团队的代码风格,也包括一些由 Detekt 定义的格式化问题 |

表格引用自:cloud.tencent.com/developer/a…

更细节的规则说明,请参考:官方文档-规则集说明

接下来我们自定义一个检测KAE使用的规则,如下所示:

// 入口

class CustomRuleSetProvider : RuleSetProvider {

override val ruleSetId: String = "detekt-custom-rules"

override fun instance(config: Config): RuleSet = RuleSet(

ruleSetId,

listOf(

NoSyntheticImportRule(),

)

)

}

// 自定义规则

class NoSyntheticImportRule : Rule() {

override val issue = Issue(

"NoSyntheticImport",

Severity.Maintainability,

"Don’t import Kotlin Synthetics as it is already deprecated.",

Debt.TWENTY_MINS

)

override fun visitImportDirective(importDirective: KtImportDirective) {

val import = importDirective.importPath?.pathStr

if (import?.contains("kotlinx.android.synthetic") == true) {

report(

CodeSmell(

issue,

Entity.from(importDirective),

"'$import' 不要使用kae,推荐使用viewbinding"

)

)

}

}

}代码其实并不复杂,主要做了这么几件事:

CustomRuleSetProvider作为自定义规则的入口,并将NoSyntheticImportRule添加进去NoSyntheticImportRule类,主要包括issue与各种visitXXX方法issue属性用于定义在控制台或任何其他输出格式上打印的ID、严重性和提示信息visitImportDirective即通过访问者模式访问语法树的回调,当访问到import时会回调,我们在这里检测有没有添加kotlinx.android.synthetic,发现存在则报告异常上面的规则没有用到类型解析,也就是说不传入classpath也能使用,我们现在来看一个需要使用类型解析的自定义规则

比如我们需要在项目中禁止直接使用android.widget.Toast.show,而是使用我们统一封装的工具类,那么我们可以自定义如下规则:

class AvoidToUseToastRule : Rule() {

override val issue = Issue(

"AvoidUseToastRule",

Severity.Maintainability,

"Don’t use android.widget.Toast.show",

Debt.TWENTY_MINS

)

override fun visitReferenceExpression(expression: KtReferenceExpression) {

super.visitReferenceExpression(expression)

if (expression.text == "makeText") {

// 通过bindingContext获取语义

val referenceDescriptor = bindingContext.get(BindingContext.REFERENCE_TARGET, expression)

val packageName = referenceDescriptor?.containingPackage()?.asString()

val className = referenceDescriptor?.containingDeclaration?.name?.asString()

if (packageName == "android.widget" && className == "Toast") {

report(

CodeSmell(

issue, Entity.from(expression), "禁止直接使用Toast,建议使用xxxUtils"

)

)

}

}

}

}可以看出,我们在visitReferenceExpression回调中检测表达式,我们不仅需要判断是否存在Toast.makeTest表达式,因为可能存在同名类,更需要判断Toast类的具体类型,而这就需要获取语义信息

我们这里通过bindingContext来获取表达式的语义,这里的bindingContext其实就是Kotlin编译器存储语义信息的表,详细的可以参阅:K2 编译器是什么?世界第二高峰又是哪座?

当我们获取了语义信息之后,就可以获取Toast的具体类型,就可以判断出这个Toast是不是android.widget.Toast,也就可以完成检测了

Github Action集成Detekt检测在完成了DeteKt接入与自定义规则之后,接下来就是每次提交代码时在CI上进行检测了

一些大的开源项目每次提交PR都会进行一系列的检测,我们也用Github Action来实现一个

我们在.github/workflows目录添加如下代码

name: Android CI

on:

push:

branches: [ "main" ]

pull_request:

branches: [ "main" ]

jobs:

detekt-code-check:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: set up JDK 11

uses: actions/setup-java@v3

with:

java-version: '11'

distribution: 'temurin'

cache: gradle

- name: Grant execute permission for gradlew

run: chmod +x gradlew

- name: DeteKt Code Check

run: ./gradlew detektDebug

这样在每次提交PR的时候,就都会自动调用该workflow进行检测了,检测不通过则不允许合并,如下所示:

点进去也可以看到详细的报错,具体是哪一行代码检测不通过,如图所示:

本文主要介绍了DeteKt的接入与如何自定义规则,通过IDE集成,CLI命令行方式与Gradle插件方式接入,以及CI自动检测,可以保证代码规范,IDE提示,CI检测三者的统一,方便提前暴露问题,提高代码质量。

如果本文对你有所帮助,欢迎点赞~

最近我观察到一个现象,当服务的请求量突发的增长一下时,服务的有效QPS会下降很多,有时甚至会降到0,这种现象网上也偶有提到,但少有解释得清楚的,所以这里来分享一下问题成因及解决方案。

目前的Web服务器,如Tomcat,请求处理过程大概都类似如下:

这是Tomcat请求处理的过程,如下:

这里不用太关心Acceptor与Poller线程,这是nio编程时常见的线程模型,我们将重点放在exec线程池上,虽然Tomcat做了一些优化,但它还是从Java原生线程池扩展出来的,即有一个任务队列与一组线程。

当请求量突发增长时,会发生如下的情况:

可是,exec线程们还是在一刻不停歇的处理着请求的呀,按理说服务QPS是不会减少的呀!

简单想想的确如此,但调用端一般是有超时时间设置的,不会无限等待下去,当客户端等待超时的时候,这个请求实际上Tomcat就不用再处理了,因为就算处理了,客户端也不会再去读响应数据的。

因此,当队列比较长时,队列后面的请求,基本上都是不用再处理的,但exec线程池不知道啊,它还是会一如既往地处理这些请求。

当exec线程执行这些已超时的请求时,若又有新请求进来,它们也会排在队尾,这导致这些新请求也会超时,所以在流量突发的这段时间内,请求的有效QPS会下降很多,甚至会降到0。

这种超时也叫做队列延迟,但队列在软件系统中应用得太广泛了,比如操作系统调度器维护了线程队列,TCP中有backlog连接队列,锁中维护了等待队列等等。

因此,很多系统也会存在这种现象,平时响应时间挺稳定的,但偶尔耗时很高,这种情况有很多都是队列延迟导致的。

知道了问题产生的原因,要优化它就比较简单了,我们只需要让队列中那些长时间未处理的请求暂时让路,让线程去执行那些等待时间不长的请求即可,毕竟这些长时间未处理的请求,让它们再等等也无防,因为客户端可能已经超时了而不需要请求结果了,虽然这破坏了队列的公平性,但这是我们需要的。

对于Tomcat,在springboot中,我们可以如下修改:

使用WebServerFactoryCustomizer自定义Tomcat的线程池,如下:

@Component

public class TomcatExecutorCustomizer implements WebServerFactoryCustomizer<TomcatServletWebServerFactory> {

@Resource

ServerProperties serverProperties;

@Override

public void customize(TomcatServletWebServerFactory factory) {

TomcatConnectorCustomizer tomcatConnectorCustomizer = connector -> {

ServerProperties.Tomcat.Threads threads = serverProperties.getTomcat().getThreads();

TaskQueue taskqueue = new SlowDelayTaskQueue(1000);

ThreadPoolExecutor executor = new org.apache.tomcat.util.threads.ThreadPoolExecutor(

threads.getMinSpare(), threads.getMax(), 60L, TimeUnit.SECONDS,

taskqueue, new CustomizableThreadFactory("http-nio-8080-"));

taskqueue.setParent(executor);

ProtocolHandler handler = connector.getProtocolHandler();

if (handler instanceof AbstractProtocol) {

AbstractProtocol<?> protocol = (AbstractProtocol<?>) handler;

protocol.setExecutor(executor);

}

};

factory.addConnectorCustomizers(tomcatConnectorCustomizer);

}

}注意,这里还是使用的Tomcat实现的线程池,只是将任务队列TaskQueue扩展为了SlowDelayTaskQueue,它的作用是将长时间未处理的任务移到另一个慢队列中,待当前队列中无任务时,再把慢队列中的任务移回来。

为了能记录任务入队列的时间,先封装了一个记录时间的任务类RecordTimeTask,如下:

@Getter

public class RecordTimeTask implements Runnable {

private Runnable run;

private long createTime;

private long putQueueTime;

public RecordTimeTask(Runnable run){

this.run = run;

this.createTime = System.currentTimeMillis();

this.putQueueTime = this.createTime;

}

@Override

public void run() {

run.run();

}

public void resetPutQueueTime() {

this.putQueueTime = System.currentTimeMillis();

}

public long getPutQueueTime() {

return this.putQueueTime;

}

}然后队列的扩展实现如下:

public class SlowDelayTaskQueue extends TaskQueue {

private long timeout;

private BlockingQueue<RecordTimeTask> slowQueue;

public SlowDelayTaskQueue(long timeout) {

this.timeout = timeout;

this.slowQueue = new LinkedBlockingQueue<>();

}

@Override

public boolean offer(Runnable o) {

// 将任务包装一下,目的是为了记录任务放入队列的时间

if (o instanceof RecordTimeTask) {

return super.offer(o);

} else {

return super.offer(new RecordTimeTask(o));

}

}

public void pullbackIfEmpty() {

// 如果队列空了,从慢队列中取回来一个

if (this.isEmpty()) {

RecordTimeTask r = slowQueue.poll();

if (r == null) {

return;

}

r.resetPutQueueTime();

this.add(r);

}

}

@Override

public Runnable poll(long timeout, TimeUnit unit) throws InterruptedException {

pullbackIfEmpty();

while (true) {

RecordTimeTask task = (RecordTimeTask) super.poll(timeout, unit);

if (task == null) {

return null;

}

// 请求在队列中长时间等待,移入慢队列中

if (System.currentTimeMillis() - task.getPutQueueTime() > this.timeout) {

this.slowQueue.offer(task);

continue;

}

return task;

}

}

@Override

public Runnable take() throws InterruptedException {

pullbackIfEmpty();

while (true) {

RecordTimeTask task = (RecordTimeTask) super.take();

// 请求在队列中长时间等待,移入慢队列中

if (System.currentTimeMillis() - task.getPutQueueTime() > this.timeout) {

this.slowQueue.offer(task);

continue;

}

return task;

}

}

}逻辑其实挺简单的,如下:

为了将请求的队列延迟记录在access.log中,我又修改了一下Task,并加了一个Filter,如下:

@Getter

public class RecordTimeTask implements Runnable {

private static final ThreadLocal<Long> WAIT_IN_QUEUE_TIME = new ThreadLocal<>();

private Runnable run;

private long createTime;

private long putQueueTime;

public RecordTimeTask(Runnable run){

this.run = run;

this.createTime = System.currentTimeMillis();

this.putQueueTime = this.createTime;

}

@Override

public void run() {

try {

WAIT_IN_QUEUE_TIME.set(System.currentTimeMillis() - this.createTime);

run.run();

} finally {

WAIT_IN_QUEUE_TIME.remove();

}

}

public void resetPutQueueTime() {

this.putQueueTime = System.currentTimeMillis();

}

public long getPutQueueTime() {

return this.putQueueTime;

}

public static long getWaitInQueueTime(){

return ObjectUtils.defaultIfNull(WAIT_IN_QUEUE_TIME.get(), 0L);

}

}@WebFilter

@Component

public class WaitInQueueTimeFilter extends HttpFilter {

@Override

public void doFilter(HttpServletRequest request, HttpServletResponse response, FilterChain chain) throws

IOException,

ServletException {

long waitInQueueTime = RecordTimeTask.getWaitInQueueTime();

// 将等待时间设置到request的attribute中,给access.log使用

request.setAttribute("waitInQueueTime", waitInQueueTime);

// 如果请求在队列中等待了太长时间,客户端大概率已超时,就没有必要再执行了

if (waitInQueueTime > 5000) {

response.sendError(503, "service is busy");

return;

}

chain.doFilter(request, response);

}

}server:

tomcat:

accesslog:

enabled: true

directory: /home/work/logs/applogs/java-demo

file-date-format: .yyyy-MM-dd

pattern: '%h %l %u %t "%r" %s %b %Dms %{waitInQueueTime}rms "%{Referer}i" "%{User-Agent}i" "%{X-Forwarded-For}i"'

注意,在access.log中配置%{xxx}r表示取请求xxx属性的值,所以,%{waitInQueueTime}r就是队列延迟,后面的ms是毫秒单位。

我使用接口压测工具wrk压了一个测试接口,此接口执行时间100ms,使用1000个并发去压,1s的超时时间,如下:

wrk -d 10d -T1s --latency http://localhost:8080/sleep -c 1000

然后,用arthas看一下线程池的队列长度,如下:

[arthas@619]$ vmtool --action getInstances \

--classLoaderClass org.springframework.boot.loader.LaunchedURLClassLoader \

--className org.apache.tomcat.util.threads.ThreadPoolExecutor \

--express 'instances.{ #{"ActiveCount":getActiveCount(),"CorePoolSize":getCorePoolSize(),"MaximumPoolSize":getMaximumPoolSize(),"QueueSize":getQueue().size()} }' \

-x 2

可以看到,队列长度远小于1000,这说明队列中积压得不多。

再看看access.log,如下:

可以发现,虽然队列延迟任然存在,但被控制在了1s以内,这样这些请求就不会超时了,Tomcat的有效QPS保住了。

而最后面那些队列延迟极长的请求,则是被不公平对待的请求,但只能这么做,因为在请求量超出Tomcat处理能力时,只能牺牲掉它们,以保全大局。

2023年到来,今年过年格外早,没几天就要迎新年了,因为是兔年,所以我创建了一个Rabbit为主题的App,里面以兔子为主题而添加各种相关内容,目前仅有十条2023兔年祝福语,后面会增加其他功能,下面,我们看看这个App的样子。

首先,这个App因为这两天才创建的,所以只是UI上看起来和兔子相关,内容并不是很充实。主要是找了一张兔子的图片做App的logo,以及找了几张动态图作为app内部的装饰UI,如下:

内部我是利用LottieAnimation去展示动图(让UI忙碌的安卓Lottie动画渲染库(一) - 掘金 (juejin.cn) & 让UI忙碌的安卓Lottie动画渲染库(二) - 掘金 (juejin.cn)),然后使用之前掘友推荐的刘强东写的列表神器BRV(liangjingkanji/BRV: [文档详细] Android上最好的RecyclerView框架, 比 BRVAH 更简单强大 (github.com)),琢磨了半天最后还是没有成功使用库作者推荐的DataBinding方式,我使用RecyclerView中使用BRV去加载10条祝福语。

这是使用作者推荐方式后运行不起来的截图:

看文档上的解决方法依次尝试还是没成功,所以还是采用ViewBinding的方式了。

部分XML布局如下,我虽然启用了DataBinding但目前还不会用,所以我也同时启用了ViewBinding:

<?xml version="1.0" encoding="utf-8"?>

<layout xmlns:android="http://schemas.android.com/apk/res/android"

xmlns:app="http://schemas.android.com/apk/res-auto"

xmlns:tools="http://schemas.android.com/tools">

<data>

</data>

<LinearLayout

android:layout_width="match_parent"

android:layout_height="match_parent"

android:orientation="vertical"

tools:context=".MainActivity">

...

...

<com.airbnb.lottie.LottieAnimationView

android:id="@+id/rabbit_easter_egg_slider"

android:layout_width="match_parent"

android:layout_height="100dp"

android:layout_gravity="center"

app:lottie_autoPlay="true"

app:lottie_fileName="lottie/rabbit_easter_egg_slider.json"

app:lottie_loop="true"

app:lottie_repeatMode="restart" />

<androidx.core.widget.NestedScrollView

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:layout_gravity="center"

tools:ignore="SpeakableTextPresentCheck">

<LinearLayout

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:orientation="vertical">

...

...

<com.airbnb.lottie.LottieAnimationView

android:id="@+id/rabbit_2023"

android:layout_width="200dp"

android:layout_height="200dp"

android:layout_gravity="center"

app:lottie_autoPlay="true"

app:lottie_fileName="lottie/rabbit_2023.json"

app:lottie_loop="true"

app:lottie_repeatMode="restart" />

</LinearLayout>

</androidx.core.widget.NestedScrollView>

<androidx.recyclerview.widget.RecyclerView

android:id="@+id/vMainList"

android:layout_width="match_parent"

android:layout_height="wrap_content" >

</androidx.recyclerview.widget.RecyclerView>

</LinearLayout>

</layout>我的activity中部分代码如下,很笨拙地使用列表的方式存了10条祝福语,后面还会优化一下并加上复制按钮:

...

...

class MainActivity : AppCompatActivity() {

private lateinit var binding: ActivityMainBinding

private var text = arrayOf("兔年!...",

...

....,

....,

....")

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

binding = ActivityMainBinding.inflate(layoutInflater)

setContentView(binding.root)

window.attributes.softInputMode = WindowManager.LayoutParams.SOFT_INPUT_ADJUST_PAN

binding.vMainList.linear().setup {

addType<SimpleModel>(R.layout.item_simple)

setAnimation(AnimationType.SLIDE_BOTTOM)

onBind {

val binding = getBinding<ItemSimpleBinding>() // 使用ViewBinding/DataBinding都可以使用本方法

binding.tvName.text = getModel<SimpleModel>().name

}

}.models = getData()

}

private fun getData(): MutableList<Any> {

// 在Model中也可以绑定数据

return mutableListOf<Any>().apply {

for (i in 1..10) {

val simpleModel = SimpleModel(

"$i、${text[i-1]}"

, i)

add(simpleModel)

// add(SimpleModel())

}

}

}

}运行后目前只可以滑动查看列表:

总之就是这个App目前还非常简陋,但是已经放到了GitHub上了,后续会逐渐添加优化一些功能和代码。

项目地址:ObliviateOnline/RabbitApp: 2023 rabbit app (github.com)

本来是想做一个搜索类的App,结果发现做着做着就偏离了方向,但是本来就是为了新年添个彩头,又是自己弄着玩的,加之看起来还是像那么回事,所以就这么直接发出来献丑了,希望大家喜欢!

在 App 的运营中,活跃度是一个重要的指标,日活/月活……为了提高活跃度,就发明了小红点,然后让强迫症用户“没法活”。

小红点虽然很讨厌,但是为了 KPI,程序员也不得不屈从运营同学的逼迫(讨好),得想办法实现。这一篇,来介绍一个徽标(Badge)组件,能够快速搞定应用内的小红点。

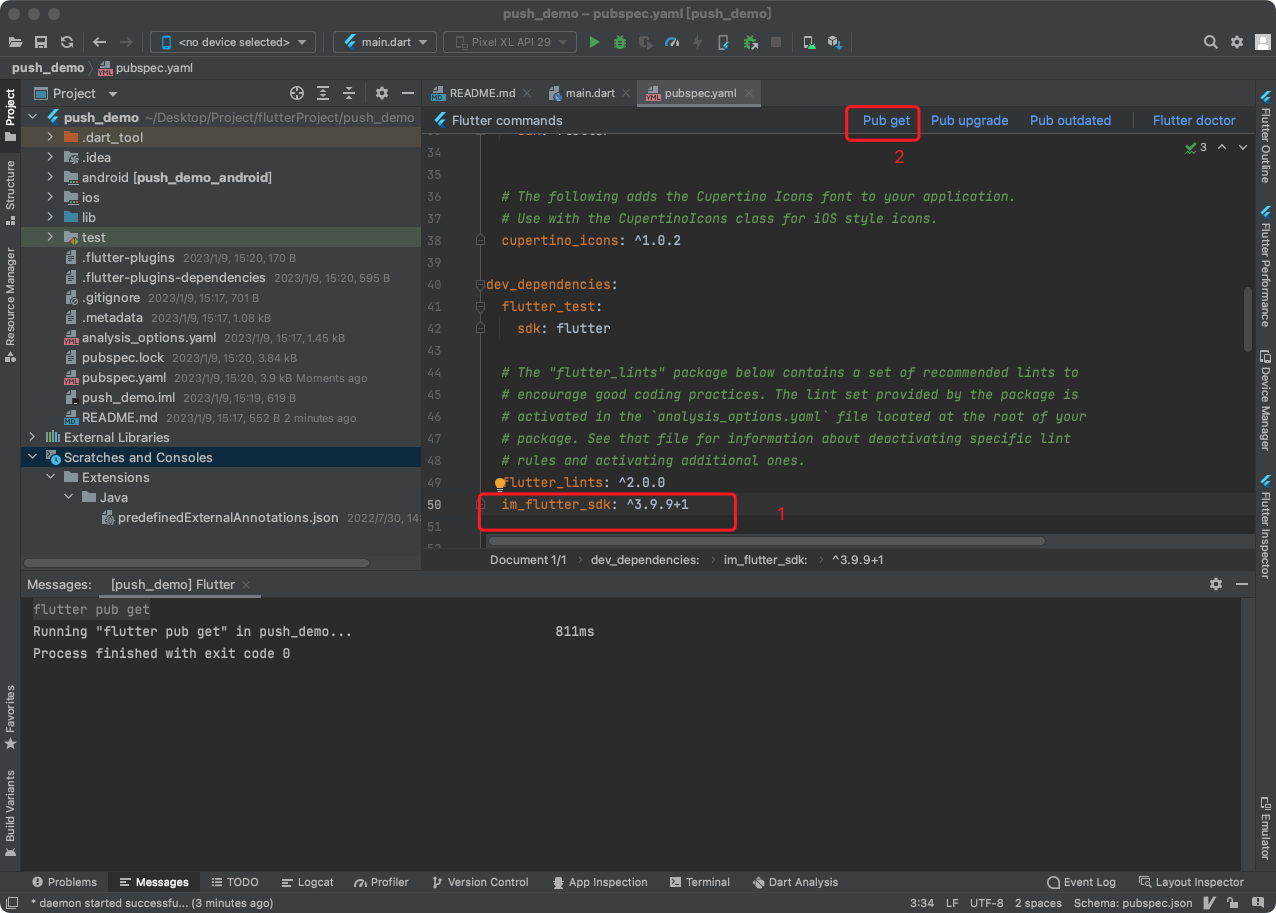

Badge 组件被 Flutter 官方推荐,利用它让小红点的实现非常轻松,只需要2个步骤就能搞定。

在 pubspec.yaml文件种引入相应版本的依赖,如下所示。

badges: ^2.0.3Badge(

badgeContent: Text('3'),

position: BadgePosition.topEnd(top: -10, end: -10),

badgeColor: Colors.blue,

child: Icon(Icons.settings),

)position可以设置徽标在组件的相对位置,包括右上角(topEnd)、右下角(bottomEnd)、左上角(topStart)、左下角(bottomStart)和居中(center)等位置。并可以通过调整垂直方向和水平方向的相对位置来进行位置的细微调整。当然,Badge 组件考虑了很多应用场景,因此还有其他的一些参数:

elevation:阴影偏移量,默认为2,可以设置为0消除阴影;gradient:渐变色填充背景;toAnimate:徽标内容改变后是否启用动效哦,默认有动效。shape:徽标的形状,默认是原型,也可以设置为方形,设置为方形的时候可以使用 borderRadius 属性设置圆角弧度。borderRadius:圆角的半径。animationType:内容改变后的动画类型,有渐现(fade)、滑动(slide)和缩放(scale)三种效果。showBadge:是否显示徽标,我们可以利用这个控制小红点的显示与否,比如没有提醒的时候该值设置为 false 即可隐藏掉小红点。总的来说,这些参数能够满足所有需要使用徽标的场景了。

我们来看一个实例,我们分别在导航栏右上角、内容区和底部导航栏使用了三种类型的徽标,实现效果如下。

其中导航栏的代码如下,这是 Badge 最简单的实现方式了。

AppBar(

title: const Text('Badge Demo'),

actions: [

Badge(

showBadge: _badgeNumber > 0,

padding: const EdgeInsets.all(4.0),

badgeContent: Text(

_badgeNumber < 99 ? _badgeNumber.toString() : '99+',

textAlign: TextAlign.center,

style: const TextStyle(

color: Colors.white,

fontSize: 11.0,

),

),

position: BadgePosition.topEnd(top: 4, end: 4),

child: IconButton(

onPressed: () {},

icon: const Icon(

Icons.message_outlined,

color: Colors.white,

),

),

),

],

),内容区的徽标代码如下,这里使用了渐变色填充,动画形式为缩放,并且将徽标放到了左上角,注意如果使用了渐变色那么会覆盖 badgeColor 指定的背景色。

Badge(

showBadge: _badgeNumber > 0,

padding: const EdgeInsets.all(6.0),

badgeContent: Text(

_badgeNumber < 99 ? _badgeNumber.toString() : '99+',

textAlign: TextAlign.center,

style: const TextStyle(

color: Colors.white,

fontSize: 10.0,

),

),

position: BadgePosition.topStart(top: -10, start: -10),

badgeColor: Colors.blue,

animationType: BadgeAnimationType.scale,

elevation: 0.0,

gradient: const LinearGradient(

begin: Alignment.topCenter,

end: Alignment.bottomCenter,

colors: [

Colors.red,

Colors.orange,

Colors.green,

],

),

child: Image.asset(

'images/girl.jpeg',

width: 200,

height: 200,

),

),底部导航栏的代码如下所示,这里需要注意,Badge 组件会根据内容区的尺寸自动调节大小,底部导航栏的显示控件有限,推荐使用小红点(不用数字标识)即可。

BottomNavigationBar(items: [

BottomNavigationBarItem(

icon: Badge(

showBadge: _badgeNumber > 0,

padding: const EdgeInsets.all(2.0),

badgeContent: Text(

_badgeNumber < 99 ? _badgeNumber.toString() : '99+',

textAlign: TextAlign.center,

style: const TextStyle(

color: Colors.white,

fontSize: 11.0,

),

),

position: BadgePosition.topEnd(top: -4, end: -6),

animationType: BadgeAnimationType.fade,

child: const Icon(Icons.home_outlined)),

label: '首页',

),

const BottomNavigationBarItem(

icon: Icon(

Icons.star_border,

),

label: '推荐',

),

const BottomNavigationBarItem(

icon: Icon(

Icons.account_circle_outlined,

),

label: '我的',

),

]),本篇介绍了使用 Badge 组件实现小红点徽标组件。可以看到,Badge 组件的使用非常简单,相比我们自己从零写一个 Badge 组件来说,使用它可以让我们省时省力、快速地完成运营同学要的小红点。本篇源码已上传至:实用组件相关代码。

最近公司的项目用Flutter技术栈比较多,有些需求可能还需要一些Android原生的支持,所以我做了一些Android原生混合Flutter开发的尝试,参考了一些文章,也遇到了一些问题,这里把总结的经验分享出来。

本文是针对 Android 项目添加 Flutter 模块的情况编写的。

Android项目直接贴图带过了哈,这步应该都熟练的吧

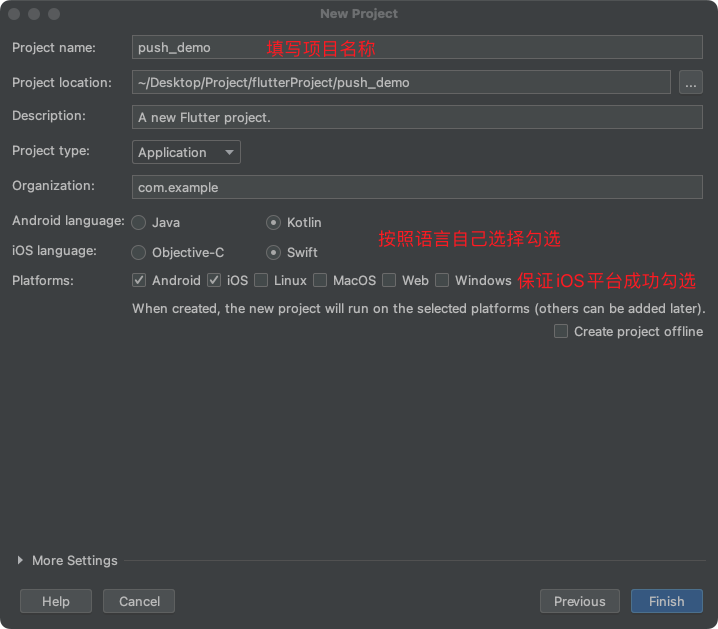

Flutter模块这里就有区别了,较新版的AS中提供直接创建Flutter模块的模板,但是我的北极狐版本没有,因此这里演示两种方式:

AS模板创建在你的当前项目中,使用AS菜单中的 File > New > New Module… 创建一个新的Flutter模块,或者选择一个此前就已准备好的Flutter模块。

如果你选择创建一个新的模块,你可以使用向导来帮助你设置模块的名称,模块存放的位置之类的配置项。

AS,所以我并未实践官方提供的模板创建方式,按照官方的说法,它会自动帮你配置好依赖关系,但我也不确定会不会遇到问题,没有最好,有的话应该也都和手动创建的方式差不多。Flutter模块在Terminal执行下方命令

```

flutter create -t module --org com.randalldev fluttermodule

```

复制代码然后官方提供了两种方式添加依赖关系:

AAR依赖模式

AAR模式有个好处就是团队中的其他成员不需要安装Flutter SDK,最少只需要一个人输出AAR即可。

但是我个人不喜欢这种方式,我更倾向于git submodule的项目管理方式,并且安装Flutter SDK的成本实在算不上高,因此,这种方式,我按下不表。

模块代码依赖模式

这种方式确保了一步完成Android项目和Flutter模块的编译。这种方式对于你的开发同时涉及两个部分并且快速迭代很方便,但这需要团队的每个人成员都安装Flutter SDK来确保顺利编译这个混合app。

在主项目的settings.gradle中将Flutter模块作为子项目引入。

// Include the host app project.

include ':app' // 默认已有的配置

setBinding(new Binding([gradle: this])) // 新增

evaluate(new File( // 新增

settingsDir.parentFile, // 新增

'${root_project}/fluttermodule/.android/include_flutter.groovy' // 新增

)) // 新增

此时

AS会提示你gradle配置变更了,需要重新sync,别急,先别点!

假设fluttermodule是和app目录同层级的。

在app的build.gradle中添加flutter模块的依赖

dependencies {

implementation project(':flutter')

}

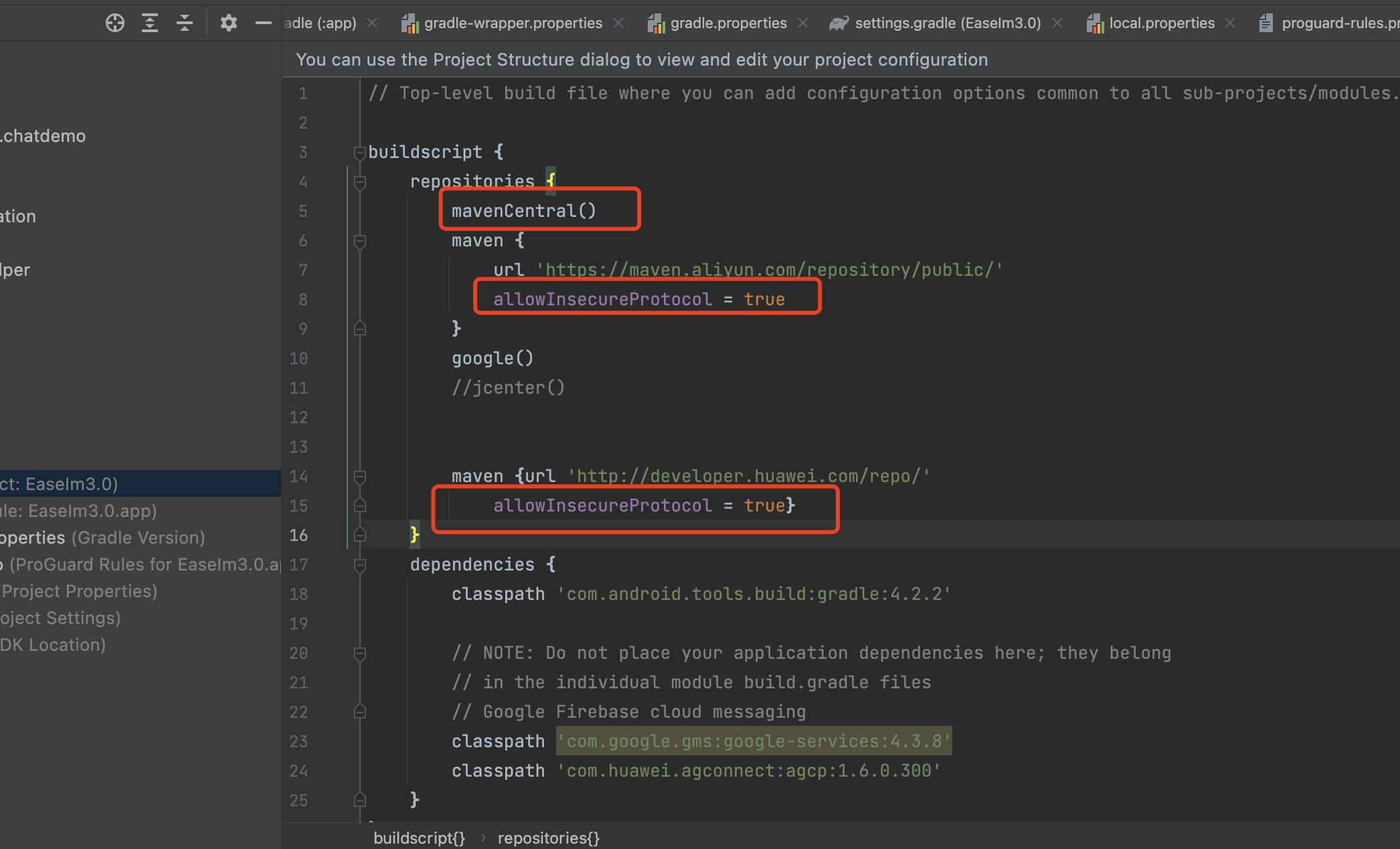

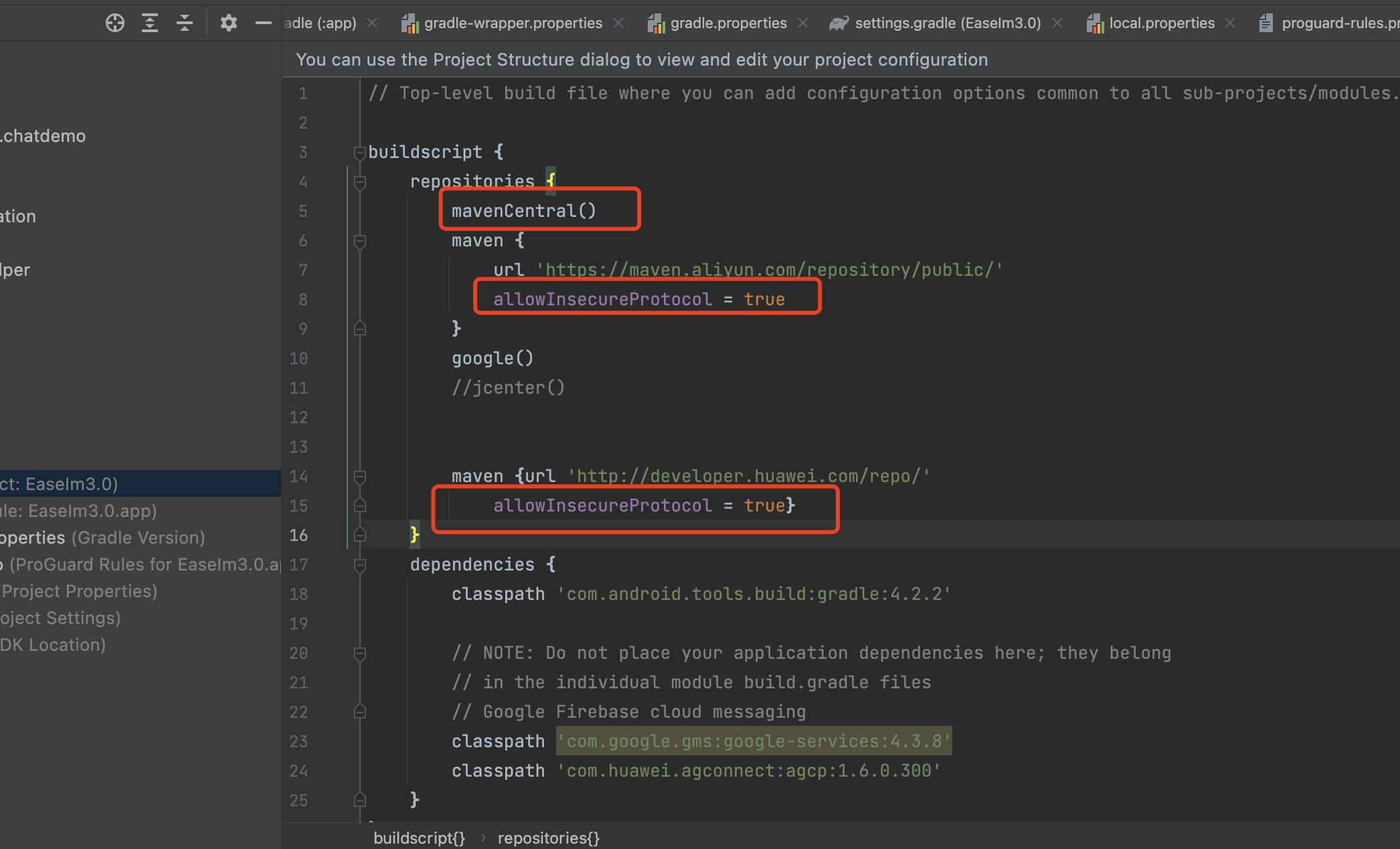

官方的指南就到此为止了,与此同时,坑也来了/doge

sync会出现如下报错* What went wrong:

A problem occurred evaluating script.

> Failed to apply plugin class 'FlutterPlugin'.

> Build was configured to prefer settings repositories over project repositories but repository 'maven' was added by plugin class 'FlutterPlugin'

将project的setting.gradle的

dependencyResolutionManagement {

repositoriesMode.set(RepositoriesMode.FAIL_ON_PROJECT_REPOS)

repositories {

google()

mavenCentral()

jcenter() // Warning: this repository is going to shut down soon

}

}

改为

dependencyResolutionManagement {

repositoriesMode.set(RepositoriesMode.PREFER_PROJECT)

repositories {

google()

mavenCentral()

jcenter() // Warning: this repository is going to shut down soon

}

}

sync会出现如下报错A problem occurred evaluating project ':app'.

> Project with path ':fluttermodule' could not be found in project ':app'.

在project的setting.gradle的末尾添加

include ':fluttermodule'

sync编译大概率能成功,但是会有很严重的警告Failed to resolve: androidx.core:core-ktx:1.9.0

Add Google Maven repository and sync project

Show in Project Structure dialog

Affected Modules: app

在project的build.gradle的

task clean(type: Delete) {

delete rootProject.buildDir

}上方添加

allprojects {

repositories {

google()

mavenCentral()

maven { url 'https://jitpack.io' }

}

}至此,大体上一个混合的Android原生+Flutter项目的初步构建就完成了。

Android原生打开Flutter页面默认的跳转方式会出现明显的白屏,体验上很不好,这里直接给出优化后的方式

FlutterEngine缓存并复用在app的AndroidManifest.xml中注册FlutterActivity

<activity

android:name="io.flutter.embedding.android.FlutterActivity"

android:configChanges="orientation|keyboardHidden|keyboard|screenSize|locale|layoutDirection|fontScale|screenLayout|density|uiMode"

android:hardwareAccelerated="true"

android:theme="@style/Theme.HybridFlutter"

android:windowSoftInputMode="adjustResize" >

</activity>

在app中创建一个App.kt继承Application并在AndroidManifest.xml中配置给application节点的name属性

class App : Application() {

···

}<manifest xmlns:android="http://schemas.android.com/apk/res/android"

package="com.randalldev.hybridflutter">

<application

android:name=".App"

···

</manifest>在App.kt中准备好FlutterEngine

创建FlutterEngine实例

private val flutterEngine by lazy {

FlutterEngine(this).apply {

dartExecutor.executeDartEntrypoint(DartExecutor.DartEntrypoint.createDefault())

}

}重写onCreate()并将实例存储在FlutterEngineCache中

override fun onCreate() {

super.onCreate()

FlutterEngineCache.getInstance().put("your_engine_id", flutterEngine)

}重写onTerminate()并将实例销毁

override fun onTerminate() {

super.onTerminate()

flutterEngine.destroy()

}在业务需要的地方使用FlutterEngine中的Intent实例进行跳转

findViewById<TextView>(R.id.textView).setOnClickListener {

startActivity(FlutterActivity.withCachedEngine("your_engine_id").build(this))

}选择app进行run

如果遇到如下Java版本问题,请进行如下配置变更

A problem occurred evaluating project ':flutter'.

> Failed to apply plugin 'com.android.internal.library'.

> Android Gradle plugin requires Java 11 to run. You are currently using Java 1.8.

You can try some of the following options:

- changing the IDE settings.

- changing the JAVA_HOME environment variable.

- changing `org.gradle.java.home` in `gradle.properties`.

选择 Project Structure > SDK location > Gradle Settings 设置Gradle JDK为11

在./gradle.properties中添加上文中对应的java.home路径

# replace with your own jdk11 or above

org.gradle.java.home=C\:\\Softwares\\Google\\Android\\Android_Studio\\jre

sync后应该就可以顺利的run了

最近接触系统App相关的开发,刚开始得知在系统源码中,开发系统应用,As 引用库的时候,居然不能代码联想,布局也不能预览,实在不习惯。后面搜了下网上的资源,有一些介绍,也不是特别完整,于是自己把这些零碎的点,整理出来,方面后续自己看看。

本文主要解决以下几个问题:

这一步,就是把系统App的代码拷贝出来(例如:/packages/apps/Settings),相当于移植到一个新的项目。创建一个新的 As 工程,然后按照源码的目录层级创建,记得包名跟源码一致,尽可能保存目录层级一致,接着就是各种 copy 操作了,把 src、res 等目录都搬过去新项目中。在移植的过程,需要将 Android.bp 文件里面依赖的库,按照 gradle 的方式来依赖进去。例如:

static_libs: [

"com.google.android.material_material",

"androidx.transition_transition",

"androidx-constraintlayout_constraintlayout",

"androidx.core_core",

"androidx.media_media",

"androidx.legacy_legacy-support-core-utils",

"androidx.legacy_legacy-support-core-ui",

"androidx.fragment_fragment",

"androidx.appcompat_appcompat",

"androidx.preference_preference",

"androidx.recyclerview_recyclerview",

"androidx.legacy_legacy-preference-v14",

"androidx.leanback_leanback",

"androidx.leanback_leanback-preference",

"androidx.lifecycle_lifecycle-extensions",

"androidx.lifecycle_lifecycle-common-java8",

"kotlin-stdlib",

"kotlinx-coroutines-android",

"androidx.navigation_navigation-common-ktx",

"androidx.navigation_navigation-fragment-ktx",

"androidx.navigation_navigation-runtime-ktx",

"androidx.navigation_navigation-ui-ktx",

]对应到 gradle 代码,这个过程十分麻烦,因为很多资源缺失,需要一个个的寻找,以及代码的移植还会关联其他工程代码。而且库的版本也是需要注意的。所以需要耐心解决。

compileOnly files('libs/framework.jar')

implementation "org.jetbrains.kotlin:kotlin-stdlib:$kotlin_version"

implementation 'org.jetbrains.kotlinx:kotlinx-coroutines-core:1.1.1'

implementation 'org.jetbrains.kotlinx:kotlinx-coroutines-android:1.1.1'

implementation 'androidx.core:core-ktx:1.6.0'

implementation 'androidx.appcompat:appcompat:1.3.1'

implementation 'com.google.android.material:material:1.4.0'

implementation 'com.android.support:multidex:1.0.0'

implementation 'androidx.constraintlayout:constraintlayout:2.1.1'

implementation "com.google.protobuf:protobuf-javalite:3.13.0"

def nav_version = "2.3.5"

// Java language implementation

implementation "androidx.navigation:navigation-fragment-ktx:$nav_version"

implementation "androidx.navigation:navigation-ui-ktx:$nav_version"

// Feature module Support

implementation "androidx.navigation:navigation-dynamic-features-fragment:$nav_version"

def lifecycle_version = "2.3.1"

def arch_version = "2.1.0"

// ViewModel

implementation "androidx.lifecycle:lifecycle-viewmodel-ktx:$lifecycle_version"

// LiveData

implementation "androidx.lifecycle:lifecycle-livedata-ktx:$lifecycle_version"

// Lifecycles only (without ViewModel or LiveData)

implementation "androidx.lifecycle:lifecycle-runtime-ktx:$lifecycle_version"

// ???

implementation "android.arch.lifecycle:extensions:1.1.1"

// Saved state module for ViewModel

implementation "androidx.lifecycle:lifecycle-viewmodel-savedstate:$lifecycle_version"

// Annotation processor

kapt "androidx.lifecycle:lifecycle-compiler:$lifecycle_version"

// alternately - if using Java8, use the following instead of lifecycle-compiler

implementation "androidx.lifecycle:lifecycle-common-java8:$lifecycle_version"

// optional - helpers for implementing LifecycleOwner in a Service

implementation "androidx.lifecycle:lifecycle-service:$lifecycle_version"

// optional - ProcessLifecycleOwner provides a lifecycle for the whole application process

implementation "androidx.lifecycle:lifecycle-process:$lifecycle_version"

// optional - ReactiveStreams support for LiveData

implementation "androidx.lifecycle:lifecycle-reactivestreams-ktx:$lifecycle_version"

// optional - Test helpers for LiveData

testImplementation "androidx.arch.core:core-testing:$arch_version"

def leanback_version = "1.2.0-alpha01"

implementation "androidx.leanback:leanback:$leanback_version"

// leanback-preference is an add-on that provides a settings UI for TV apps.

implementation "androidx.leanback:leanback-preference:$leanback_version"

// leanback-paging is an add-on that simplifies adding paging support to a RecyclerView Adapter.

implementation "androidx.leanback:leanback-paging:1.1.0-alpha08"

// leanback-tab is an add-on that provides customized TabLayout to be used as the top navigation bar.

implementation "androidx.leanback:leanback-tab:1.1.0-beta01"

如果项目源码存在多个 src 目录,需要在 gradle 中指定 java 目录

sourceSets {

main {

java.srcDirs = ['src/main/src', 'src/main/src2', 'src/main/src_gen']

// 定义proto文件目录

proto {

// srcDir 'src/main/java'

srcDir 'src/main/src'

include '**/*.proto'

}

}

}系统源码编译之后,找到/out/target/common/obj/JAVA_LIBRARIES/framework_intermediates 目录下的 classes.jar 文件,更名为 framework.jar ,按照jar包的引用方式,依赖进去工程。

同时需要更改jar的加载顺序,在工程目录的 gradle 添加如下代码

allprojects {

repositories {

google()

jcenter()

}

gradle.projectsEvaluated {

tasks.withType(JavaCompile) {

options.compilerArgs << "-Xlint:unchecked" << "-Xlint:deprecation"

// options.compilerArgs.add('-Xbootclasspath/p:app/libs/framework.jar')

Set<File> fileSet = options.bootstrapClasspath.getFiles()

List<File> newFileList = new ArrayList<>();

//"../framework.jar" 为相对位置,需要参照着修改,或者用绝对位置

// 我这里用的是绝对路径,注意区分 linux 系统与 window 系统的反斜杠

newFileList.add(new File("/xxx/framework.jar"))

newFileList.addAll(fileSet)

options.bootstrapClasspath = files(newFileList.toArray())

// options.bootstrapClasspath.getFiles().forEach(new Consumer<File>() {

// @Override

// void accept(File file) {

// println(file.name)

// }

// })