浅谈开发中对数据的编码和封装

前言

前几天写了一篇对跨端通讯的思考,当时顺便想到了数据这一块,所以也可以整理一下,单独拿出来说说平时开发中涉及到哪些对数据的处理方式。

Base64

之前详细写过一篇关于Base64的文章

简单来说,Base64就是把你的数据转成只有64个无特殊符号的字符,主要常用于加密后之类的生成的字节数组,转成Base64方便进行数据传输,如果不转的话就会是乱码,会看得很难受,这些乱码在某些编码下展示出来的是豆腐块,有点扯远了。

还有就是比如中文啊,emoji啊这类的字符,在某些情况下也需要转成Base64进行传输。

缺点就是只用64个字符表示,还有我之前分析过base64的转换原理,通过其原理能很容易看出,最终的转换结果相比转换前的数据更加长。

JSON/XML

这些就比较常见了,对数据按照一定的格式进行封装。为什么要说这个呢?因为他这些封装是约定熟成的方式,和上面的Base64的转换方式就不同,相当于是大家约定好按照这个格式包装数据,然后传输,自己再按照这个格式去解开拿到数据。

多数用于跨端传输,像客户端请求服务端拿数据,那不也就是跨端嘛,其实这个所有人都用到,但为什么说这个呢?还是那个跨端通信的问题,跨端通信没办法直接传对象,实际传对象的效果是转json传的String,然后另外一端再创建一个自己端的对象,解析json,把json数据填充进去。

还有,既然是约定的,那其实我们自己也可以按照我们自己的约定去做跨端的数据传送,只不过json这种格式,是已经设计得很好了,你很难再去约定一种比这个格式更好的封装。

PS:不要觉得json大家都在用,都形成肌肉记忆了,没有什么难的。其实比如像gson\fastjson这些,人家去研究解析json的算法,也是一个技术点。你觉得简单,那是因为你在使用,但让你从0去做,你不一定能做出来。

URL编码

又叫做urlencode,顾名思义用于url连接中的一种对数据的操作。

它将特殊字符转成16进制并且在前面加%,那同理解析拿数据的时候也是根据%去做判断。

为什么会出现这种编码呢?主要是为了防止冲突,我们都知道比如get请求都会在url链接后面拼参数,防止在传输中出现问题,所以把特殊字符都进行编码。

比如http://www.baidu.com/?aaaaaaa 会编码成https%3A%2F%2Fwww.baidu.com%2F%3Faaaaaaa

该编码主要用于对url的处理。

驼峰和下划线

这其实是一个命名方式,不同的端有不同的命名习惯,比如java习惯就是用驼峰,但是还是跨端问题,有些时候存在写死的情况,当然这个代码不是你写的,也可能是前人留下的(我没有暗示什么)。但如果你的代码中出现两种命名方式会让代码看着比较乱。没关系我们可以做个转换,我这里以下划线转驼峰为例

private String lineToHump(String str) {

if (TextUtils.isEmpty(str)) {

return str;

}

String[] strs = str.split("_");

if (strs.length < 2) {

return str;

}

StringBuilder result = new StringBuilder(strs[0]);

for (int i = 1; i < strs.length; i++) {

String upper = (strs[i].charAt(0) + "").toUpperCase();

if (strs[i].length() > 1) {

result.append(upper).append(strs[i].substring(1));

} else {

result.append(upper);

}

}

return result.toString();

}可以写个转换方法,我这里只是随便写个Demo,这段代码是还能进行优化的,主要大概就是这个意思。

上面说的json主要是为了说数据的封装和解封,这里主要是说数据的转换,我的意思是在开发中,我们也会出现不同端的数据形式不同,我们不需要在代码中向其它端进行妥协,只用写个方法去做数据的转换,在本端还是正常写本端的代码就行。

摘要

摘要算法,简单来说就是将原数据以一种算法生成一段很小的新数据,这段新数据主要是用来标识这段原数据。怎么还有点绕,总之就是生成一个字符串来标识原数据 。对任意一组输入数据进行计算,得到一个固定长度的输出。

也可称之为哈希算法,最重要的是它取决于它的这个设计思想,它是一个不可能逆的过程,一般不能根据摘要拿到原数据,注意我用了一般,因为这个世界上存在很多老六。

摘要算法中当前最经典的是SHA算法和MD算法,SHA-1、SHA-256和MD5。其中他们加密过程可以单独写一篇文章来说,这里就不过多解释。

摘要算法最主要的运用场景是校验数据的完整性和是否有被篡改。比如CA证书的校验,android签名的校验,会拿原数据做摘要和传过来的摘要相对比,是否一样,如果不一样说明数据有被篡改过。再比如我本地有个视频,我怎么判断后台这个视频是不是更新了,要不要下载,可以对视频文件做MD5,然后和后台文件的MD5进行对比,如果一样说明视频没有更新,如果不一样说明视频有更新或者本地的视频不完整(PS:对文件做摘要可是一个耗时的过程。)

加密

讲完摘要可以趁热打铁说说加密,加密顾名思义就是把明文数据转成密文,然后另一方拿到密文之后再转成明文。

加密和摘要不同在于,它们的本质都不同,摘要是为了验证数据,加密是为了安全传输数据。它们在表现上的不同体现在,摘要是不可逆,加密是可逆的。

加密在当前的设计上又分为对称加密和非对称加密,主流的对称加密是AES算法,主流的非对称加密是RSA算法。对称加密的加密和解密使用的密钥是相同的,非对称是不同的 ,所以非对称加密更为安全,但是也会更耗时。

当然你也可以不用这些算法,如果你是直接接触这些算法,好像是要付专利费的,每年给多少钱别人才给你用这个算法,资本家不就喜欢搞这种东西吗?扯远了。你也可以使用自己约定的算法,只不过在高手面前可能你的算法相当于裸奔,要是你真能设计出和这些算法旗鼓相当的算法,你也不会来看我这么捞的文章。

所以加密,是为了保证数据的安全,如果你传输的数据觉得被看了也无所谓,那就不用加密,因为它耗时。如果你只是为了防止数据被改,也不用加密,用摘要就行。如果你是为了传输seed,那我建议你加密[狗头]

通信协议

json那里我们有说,它就是双方约定好的数据格式。以小见大,通信协议也是双方约定的一种数据传输的过程。通信协议会更为严谨,而且会很多不同,各家有各家的通信协议,不是像json这种就是大家都用一样的。

比如我们的网络传输,就有很多协议,http协议、tcpip协议等,这些在网络中是规定好的,大家都用这一套。再比如蓝牙协议,也是要按照同一个规范去使用。但是硬件的协议就多种多样了,不同的硬件厂商会定义不同的通信协议。

二维码

二维码也是对数据封装的一种形式,可以通过把数据变成图像,然后是扫码后再获取到数据,这么一种模式我感觉能想出这个法子的人挺牛逼的。

它所涉及的内容很多,具体可以参考这篇文章,我觉得这个大佬写得挺好的 二维码生成原理 - 知乎 (zhihu.com)

我之前自己去用java实现,最终没画出来,感觉原理是没问题的,应该是我哪里细节没处理好,这里就简单介绍一下就行。其实简单来说,它就是有一个模板的情况下,把数据填充到模板里面。

这里借大佬的图,模板就是这样的

然后按照规则去填充数据

这样去填充,其实会让黑点分布不均匀,填充之后还会做一个转换。

但是二维码也有缺点,缺点就是数据量大的时候,你的二维码很难被识别出,但是不得不说能想出这个方法,能设计出这个东西的人,确实牛逼。

链接:https://juejin.cn/post/7199862924830670904

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

七道Android面试题,先来简单热个身

马上就要到招(tiao)聘(cao)旺季金三银四了,一批一批的社会精英在寻找自己的下一家的同时,也开始着手为面试做准备,回想起自己这些年,也大大小小经历过不少面试,有被面试过,也有当过面试官,其中也总结出了两个观点,一个就是不花一定的时间背些八股文还真的不行,一些扯皮的话别去听,都是在害人,另一个就是面试造火箭,入职拧螺丝毕竟都是少数,真正一场合格的面试问的东西,都是实际开发过程中会遇到的,下面我就说几个我遇到过的面试题吧

为什么ArrayMap比HashMap更适合Android开发

我们一般习惯在项目当中使用HashMap去存储键值队这样的数据,所以往往在android面试当中HashMap是必问环节,但有次面试我记得被问到了有没有有过ArrayMap,我只能说有印象,毕竟用的最多的还是HashMap,然后那个面试官又问我,觉得Android里面更适合用ArrayMap还是HashMap,我就说不上来了,因为也没看过ArrayMap的源码,后来回去看了下才给弄明白了,现在就简单对比下ArrayMap与HashMap的特点

HashMap

- HashMap的数据结构为数组加链表的结构,jdk1.8之后改为数组加链表加红黑树的结构

- put的时候,会先计算key的hashcode,然后去数组中寻找这个hashcode的下标,如果数据为空就先resize,然后检查对应下标值(下标值=(数组长度-1)&hashcode)里面是否为空,空则生成一个entry插入,否就判断hascode与key值是否分别都相等,如果相等则覆盖,如果不等就发生哈希冲突,生成一个新的entry插入到链表后面,如果此时链表长度已经大于8且数组长度大于64,则先转成树,将entry添加到树里面

- get的时候,也是先去查找数组对应下标值里面是否为空,如果不为空且key与hascode都相等,直接返回value,否就判断该节点是否为一个树节点,是就在树里面返回对应entry,否就去遍历整个链表,找出key值相等的entry并返回

ArrayMap

- 内部维护两个数组,一个是int类型的数组(mHashes)保存key的hashcode,另一个是Object的数组(mArray),用来保存与mHashes对应的key-value

- put数据的时候,首先用二分查找法找出mHashes里面的下标index来存放hashcode,在mArray对应下标index<<1与(index<<1)+1的位置存放key与value

- get数据的时候,同样也是用二分查找法找出与key值对应的下标index,接着再从mArray的(index<<1)+1位置将value取出

对比

- HashMap在存放数据的时候,无论存放的量是多少,首先是会生成一个Entry对象,这个就比较浪费内存空间,而ArrayMap只是把数据插入到数组中,不用生成新的对象

- 存放大量数据的时候,ArrayMap性能上就不如HashMap,因为ArrayMap使用的是二分查找法找的下标,当数据多了下标值找起来时间就花的久,此外还需要将所有数据往后移再插入数据,而HashMap只要插入到链表或者树后面即可

所以这就是为什么,在没有那么大的数据量需求下,Android在性能角度上比较适合用ArrayMap

为什么Arrays.asList后往里add数据会报错

这个问题我当初问过不少人,不缺乏一些资历比较深的大佬,但是他们基本都表示不清楚,这说明平时我们研究Glide,OkHttp这样的三方库源码比较多,而像一些比较基础的往往会被人忽略,而有些问题如果被忽略了,往往会产生一些捉摸不透的问题,比如有的人喜欢用Arrays.asList去生成一个List

val dataList = Arrays.asList(1,2,3)

dataList.add(4)但是当我们往这个List里面add数据的时候,我们会发现,crash了,看到的日志是

不被支持的操作,这让首次遇到这样问题的人肯定是一脸懵,List不让添加数据了吗?之前明明可以的啊,但是之前我们创建一个List是这样创建的

它所在的包是java.util.ArrayList里面,我们看下里面的代码

public boolean add(E e) {

ensureCapacityInternal(size + 1); // Increments modCount!!

elementData[size++] = e;

return true;

}

public void add(int index, E element) {

if (index > size || index < 0)

throw new IndexOutOfBoundsException(outOfBoundsMsg(index));

ensureCapacityInternal(size + 1); // Increments modCount!!

System.arraycopy(elementData, index, elementData, index + 1,

size - index);

elementData[index] = element;

size++;

}是存在add方法的,我们再回头再去看看asList生成的List

是在java.util.Arrays包里面的,而这里面的ArrayList我们看到了,并没有去实现List接口,所以也就没有add,get等方法,另外在kotlin里面,我们会看到一个细节,当你敲完Arrays.asList的时候,编译器会提示你,可以转换成listof函数,而这个还是我们知道生成的list都是只能读取,不能往里写数据

Thread.sleep(0)到底“睡没睡”

记得在上上家公司,接手的第一个需求就是做一个动画,这个动画需要一个延迟启动的功能,我那个时候想都没想加了个Thread.sleep(3000),后来被领导批了,不可以用Thread.sleep实现延迟功能,那会还不太明白,后来知道了,Thread.sleep(3000)不一定真的暂停三秒,我们来举个例子

println("start:${System.currentTimeMillis()}")

Thread(Runnable {

Thread.sleep(3000)

println("end:${System.currentTimeMillis()}")

}).start()我们在主线程先打印一条数据展示时间,然后开启一个子线程,在里面sleep三秒以后在打印一下时间,我们看下结果如何

start:1675665421590

end:1675665424591好像对了又好像没对,为什么是过了3001毫秒才打印出来呢?有的人会说,1毫秒而已,忽略嘛,那我们把上面的代码改下再试试

println("start:${System.currentTimeMillis()}")

Thread(Runnable {

Thread.sleep(0)

println("end:${System.currentTimeMillis()}")

}).start()现在sleep了0毫秒,那是不是两条打印日志应该是一样的呢,我们看看结果

start:1675666764475

end:1675666764477这下子给整不会了,明明sleep0毫秒,那么多出来的2毫秒是怎么回事呢?其实在Android操作系统中,每个线程使用cpu资源都是有优先级的,优先级高的才有资格使用,而操作系统则是在一个线程释放cpu资源以后,重新计算所有线程的优先级来重新分配cpu资源,所以sleep真正的意义不是暂停,而是在接下去的时间内不参与cpu的竞争,等到cpu重新分配完资源以后,如果优先级没变,那么继续执行,所以sleep(0)秒的真正含义是触发cpu资源重新分配

View.post为什么可以获取控件的宽高

我们都知道在onCreate里面想要获取一个控件的宽高,如果直接获取是拿不到的

val mWith = bindingView.mainButton.width

val mHeight = bindingView.mainButton.height

println("按钮宽:$mWith,高:$mHeight")

......

按钮宽:0,高:0而如果想要获取宽高,则必须调用View.post的方法

bindingView.mainButton.post {

val mWith = bindingView.mainButton.width

val mHeight = bindingView.mainButton.height

println("按钮宽:$mWith,高:$mHeight")

}

......

按钮宽:979,高:187很神奇,加个post就可以在同样的地方获取控件宽高了,至于为什么呢?我们来分析一下

简单的来说

Activity生命周期,onCreate方法里面视图还在绘制过程中,所以没法直接获取宽高,而在post方法中执行,就是在线程里面获取宽高,这个线程会在视图没有绘制完成的时候放在一个等待队列里面,等到视图绘制执行完毕以后再去执行队列里面的线程,所以在post里面也可以获取宽高

复杂的来说

我们首先从View.post方法里面开始看

这个代码里面的两个框子,说明了post方法做了两件事情,当mAttachInfo不为空的时候,直接让mHandler去执行线程action,当mAttachInfo为空的时候,将线程放在了一个队列里面,从注释里面的第一个单词Postpone就可以知道,这个action是要推迟进行,什么时候进行呢,我们在慢慢看,既然是判断当mAttachInfo不为空才去执行线程,那我们找找什么时候对mAttachInfo赋值,整个View的源码里面只有一处是对mAttachInfo赋值的,那就是在dispatchAttachedToWindow

这个方法里面,我们看下

void dispatchAttachedToWindow(AttachInfo info, int visibility) {

mAttachInfo = info;

...省略部分源码...

// Transfer all pending runnables.

if (mRunQueue != null) {

mRunQueue.executeActions(info.mHandler);

mRunQueue = null;

}

}当走到dispatchAttachedToWindow这个方法的时候,mAttachInfo才不为空,也就是从这里开始,我们就可以获取控件的宽高等信息了,另外我们顺着这个方法往下看,可以发现,之前的那个队列在这里开始执行了,现在就关键在于,什么时候执行dispatchAttachedToWindow这个方法,这个时候就要去ViewRootIml类里面查看,发现只有一处调用了这个方法,那就是在performTraversals这个方法里面

private void performTraversals() {

...省略部分源码...

host.dispatchAttachedToWindow(mAttachInfo, 0);

...省略部分源码...

// Ask host how big it wants to be

performMeasure(childWidthMeasureSpec, childHeightMeasureSpec);

...省略部分源码...

performLayout(lp, mWidth, mHeight);

...省略部分源码...

performDraw();

}performTraversals这个方法我们就很熟悉了,整个View的绘制流程都在里面,所以只有当mAttachInfo在这个环节赋值了,才可以得到视图的信息

IdleHandler到底有啥用

Handler是面试的时候必问的环节,除了问一下那四大组件之外,有的面试官还会问一下IdleHandler,那IdleHandler到底是什么呢,它是干什么用的呢,我们来看看

Message next() {

...省略部分代码...

synchronized (this) {

// If first time idle, then get the number of idlers to run.

// Idle handles only run if the queue is empty or if the first message

// in the queue (possibly a barrier) is due to be handled in the future.

if (pendingIdleHandlerCount < 0

&& (mMessages == null || now < mMessages.when)) {

pendingIdleHandlerCount = mIdleHandlers.size();

}

if (pendingIdleHandlerCount <= 0) {

// No idle handlers to run. Loop and wait some more.

mBlocked = true;

continue;

}

if (mPendingIdleHandlers == null) {

mPendingIdleHandlers = new IdleHandler[Math.max(pendingIdleHandlerCount, 4)];

}

mPendingIdleHandlers = mIdleHandlers.toArray(mPendingIdleHandlers);

}

// Run the idle handlers.

// We only ever reach this code block during the first iteration.

for (int i = 0; i < pendingIdleHandlerCount; i++) {

final IdleHandler idler = mPendingIdleHandlers[i];

mPendingIdleHandlers[i] = null; // release the reference to the handler

boolean keep = false;

try {

keep = idler.queueIdle();

} catch (Throwable t) {

Log.wtf(TAG, "IdleHandler threw exception", t);

}

if (!keep) {

synchronized (this) {

mIdleHandlers.remove(idler);

}

}

}

}只有在MessageQueue中的next方法里面出现了IdleHandler,作用也很明显,当消息队列在遍历队列中的消息的时候,当消息已经处理完了,或者只存在延迟消息的时候,就会去处理mPendingIdleHandlers里面每一个idleHandler的事件,而这些事件都是通过方法addIdleHandler注册进去的

Looper.myQueue().addIdleHandler {

false

}addIdlehandler接受的参数是一个返回值为布尔类型的函数类型参数,至于这个返回值是true还是false,我们从next()方法中就能了解到,当为false的时候,事件处理完以后,这个IdleHandler就会从数组中删除,下次再去遍历执行这个idleHandler数组的时候,该事件就没有了,如果为true的话,该事件不会被删除,下次依然会被执行,所以我们按需设置。现在我们可以利用idlehandler去解决上面讲到的在onCreate里面获取控件宽高的问题

Looper.myQueue().addIdleHandler {

val mWith = bindingView.mainButton.width

val mHeight = bindingView.mainButton.height

println("按钮宽:$mWith,高:$mHeight")

false

}当MessageQueue中的消息处理完的时候,我们的视图绘制也完成了,所以这个时候肯定也能获取控件的宽高,我们在IdleHandler里面执行了同样的代码之后,运行后的结果如下

按钮宽:979,高:187除此之外,我们还可以做点别的事情,比如我们常说的不要在主线程里面做一些耗时的工作,这样会降低页面启动速度,严重的还会出现ANR,这样的场景除了开辟子线程去处理耗时操作之外,我们现在还可以用IdleHandler,这里举个例子,我们在主线程中给sp塞入一些数据,然后在把这些数据读取出来,看看耗时多久

println(System.currentTimeMillis())

val testData = "aabbbbakjsdhjkahsjkasdjasdhjakshdjkahsdjkhasjdkhjaskhdjkashdjkhasjkhas" +

"jkhdaabbbbakjsdhjkahsjkasdjasdhjakshdjkahsdjkhasjdkhjaskhdjkashdjkhasjkhasjkhd" +

"aabbbbakjsdhjkahsjkasdjasdhjakshdjkahsdjkhasjdkhjaskhdjkashdjkhasjkhasjkhd" +

"aabbbbakjsdhjkahsjkasdjasdhjakshdjkahsdjkhasjdkhjaskhdjkashdjkhasjkhasjkhd" +

"aabbbbakjsdhjkahsjkasdjasdhjakshdjkahsdjkhasjdkhjaskhdjkashdjkhasjkhasjkhd" +

"aabbbbakjsdhjkahsjkasdjasdhjakshdjkahsdjkhasjdkhjaskhdjkashdjkhasjkhasjkhd"

sharePreference = getSharedPreferences(packageName, MODE_PRIVATE)

for (i in 1..5000) {

sharePreference.edit().putString("test$i", testData).commit()

}

for (i in 1..5000){

sharePreference.getString("test$i","")

}

println(System.currentTimeMillis())

......运行结果

1676260921617

1676260942770我们看到在塞入5000次数据,再读取5000次数据之后,一共耗时大概20秒,同时也阻塞了主线程,导致的现象是页面一片空白,只有等读写操作结束了,页面才展示出来,我们接着把读写操作的代码用IdleHandler执行一下看看

Looper.myQueue().addIdleHandler {

sharePreference = getSharedPreferences(packageName, MODE_PRIVATE)

val editor = sharePreference.edit()

for (i in 1..5000) {

editor.putString("test$i", testData).commit()

}

for (i in 1..5000){

sharePreference.getString("test$i","")

}

println(System.currentTimeMillis())

false

}

......运行结果

1676264286760

1676264308294运行结果依然耗时二十秒左右,但区别在于这个时候页面不会受到读写操作的阻塞,很快就展示出来了,说明读写操作的确是等到页面渲染完才开始工作,上面过程没有放效果图主要是因为时间太长了,会影响gif的体验,有兴趣的可以自己试一下

如何让指定视图不被软键盘遮挡

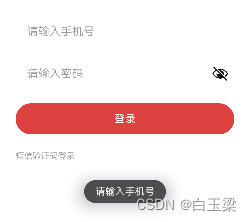

我们通常使用android:windowSoftInputMode属性来控制软键盘弹出之后移动界面,让输入框不被遮挡,但是有些场景下,键盘永远都会挡住一些我们使用频次比较高的控件,比如现在我们有个登录页面,大概的样子长这样

它的布局文件是这样

<RelativeLayout

android:id="@+id/mainroot"

android:layout_width="match_parent"

android:layout_height="match_parent">

<ImageView

android:layout_width="200dp"

android:layout_height="200dp"

android:layout_centerHorizontal="true"

android:layout_marginTop="100dp"

android:src="@mipmap/ic_launcher_round" />

<androidx.appcompat.widget.LinearLayoutCompat

android:id="@+id/ll_view1"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:layout_alignParentBottom="true"

android:layout_marginBottom="120dp"

android:gravity="center"

android:orientation="vertical">

<EditText

android:id="@+id/main_edit"

android:layout_width="match_parent"

android:layout_height="40dp"

android:hint="请输入用户名"

android:textColor="@color/black"

android:textSize="15sp" />

<EditText

android:id="@+id/main_edit2"

android:layout_width="match_parent"

android:layout_height="40dp"

android:layout_marginTop="30dp"

android:hint="请输入密码"

android:textColor="@color/black"

android:textSize="15sp" />

<Button

android:layout_width="match_parent"

android:layout_height="50dp"

android:layout_marginHorizontal="10dp"

android:layout_marginTop="20dp"

android:text="登录" />

</androidx.appcompat.widget.LinearLayoutCompat>

</RelativeLayout>在这样一个页面里面,由于输入框与登录按钮都比较靠页面下方,导致当输入完内容想要点击登录按钮时候,必须再一次关闭键盘才行,这样的操作在体验上就比较大打折扣了

现在希望可以键盘弹出之后,按钮也展示在键盘上面,这样就不用收起弹框以后才能点击按钮了,这样一来,windowSoftInputMode这一个属性已经不够用了,我们要想一下其他方案

- 首先,需要让按钮也展示在键盘上方,那只能让布局整体上移把按钮露出来,在这里我们可以改变LayoutParam的bottomMargin参数来实现

- 其次,需要知道键盘什么时候弹出,我们都知道android里面并没有提供任何监听事件来告诉我们键盘什么时候弹出,我们只能从其他角度入手,那就是监听根布局可视区域大小的变化

ViewTreeObserver

我们先获取视图树的观察者,使用addOnGlobalLayoutListener去监听全局视图的变化

bindingView.mainroot.viewTreeObserver.addOnGlobalLayoutListener {

}接下去就是要获取根视图的可视化区域了,如何来获取呢?View里面有这么一个方法,那就是getWindowVisibleDisplayFrame,我们看下源码注释就知道它是干什么的了

一大堆英文没必要都去看,只需要看最后一句就好了,大概意思就是获取能够展示给用户的可用区域,所以我们在监听器里面加上这个方法

bindingView.mainroot.viewTreeObserver.addOnGlobalLayoutListener {

val rect = Rect()

bindingView.mainroot.getWindowVisibleDisplayFrame(rect)

}当键盘弹出或者收起的时候,rect的高度就会跟着变化,我们就可以用这个作为条件来改变bottomMargin的值,现在我们增加一个变量oldDelta来保存前一个rect变化的高度值,用来做比较,完整的代码如下

var oldDelta = 0

val params:RelativeLayout.LayoutParams = bindingView.llView1.layoutParams as RelativeLayout.LayoutParams

val originBottom = params.bottomMargin

bindingView.mainroot.viewTreeObserver.addOnGlobalLayoutListener {

val rect = Rect()

bindingView.mainroot.getWindowVisibleDisplayFrame(rect)

val deltaHeight = r.height()

if (oldDelta != deltaHeight) {

if (oldDelta != 0) {

if (oldDelta > deltaHeight) {

params.bottomMargin = oldDelta - deltaHeight

} else if (oldDelta < deltaHeight) {

params.bottomMargin = originBottom

}

bindingView.llView1.layoutParams = params

}

oldDelta = deltaHeight

}

}最终效果如下

弹出后页面有个抖动是因为本身有个页面平移的效果,然后再去计算layoutparam,如果不想抖动可以在布局外层套个scrollView,用smoothScrollTo把页面滑上去就可以了,有兴趣的可以业余时间试一下

为什么LiveData的postValue会丢失数据

LiveData已经问世好多年了,大家都很喜欢用,因为它上手方便,一般知道塞数据用setValue和postValue,监听数据使用observer就可以了,然而实际开发中我遇到过好多人,一会这里用setValue一会那里用postValue,或者交替着用,这种做法也不能严格意义上说错,毕竟运行起来的确没问题,但是这种做法确实是存在风险隐患,那就是连续postValue会丢数据,我们来做个实验,连续setValue十个数据和连续postValue十个数据,收到的结果都分别是什么

var testData = MutableLiveData<Int>()

fun play(){

for (i in 1..10) {

testData.value = i

}

}

mainViewModel.testData.observe(this) {

println("收到:$it")

}

//执行结果

收到:1

收到:2

收到:3

收到:4

收到:5

收到:6

收到:7

收到:8

收到:9

收到:10setValue十次数据都可以收到,现在把setValue改成postValue再来试试

var testData = MutableLiveData<Int>()

fun play(){

for (i in 1..10) {

testData.postValue(i)

}

}得到的结果是

收到:10只收到了最后一条数据10,这是为什么呢?我们进入postValue里面看看里面的源码就知道了

主要看红框里面,有一个synchronized同步锁锁住了一个代码块,我们称为代码块1,锁的对象是mDataLock,代码块1做的事情先是给postTask这个布尔值赋值,接着把传进来的值赋给mPendingData,那我们知道了,postTask除了第一个被执行的时候,值是true,结下去等mPendingData有值了以后就都为false,前提是mPendingData没有被重置为NOT_SET,然后我们顺着代码往下看,会看到代码接下来就要到一个mPostValueRunnable的线程里面去了,我们看下这个线程

发现同样的锁,锁住了另一块代码块,我们称为代码块2,这个代码块里面恰好是把mPendingData的值赋给newValue以后,重置为NOT_SET,这样一来,postValue又可以接受新的值了,所以这也是正常情况下每次postValue都可以接受到值的原因,但是我们想想连续postValue的场景,我们知道如果synchronized如果修饰一段代码块,那么当这段代码块获取到锁的时候,就具有优先级,只有当全部执行完以后才会释放锁,所以当代码块1连续被访问时候,代码块2是不会被执行的,只有等到代码块1执行完,释放了锁,代码块2才会被执行,而这个时候,mPendingData已经是最新的值了,之前的值已经全部被覆盖了,所以我们说的postValue会丢数据,其实说错了,应该是postValue只会发送最新数据

总结

这篇文章讲到的面试题还仅仅只是过去几年遇到的,现在面试估计除了一些常规问题之外,比重会更倾向于Kotlin,Compose,Flutter的知识点,所以只有不断的日积月累,让自己的知识点更加的全面,才能在目前竞争激烈的行情趋势下逆流而上,不会被拍打在沙滩上

链接:https://juejin.cn/post/7199537072302374969

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

你还在傻傻的npm run serve吗?快来尝尝这个!

背景

大家在日常开发中应该经常会有需要切换不同环境地址的情况。当一个项目代码切换环境地址时,vue-cli没有能够感知文件的变化,所以代理的还是旧的地址,所以通常我们需要执行npm run serve进行项目重跑,而项目重跑往往意味着长时间的等待,非常痛苦!

方案调研

事实上,其实我们只是需要重启webpack为我们启动的proxy代理服务,或许能够从webpack的代理服务插件中找到解决方法。

从webpack官网可以看到proxy服务其实是由

http-proxy-middleware提供的,或许我们能够从中找到解决方法。

初步方案

在http-proxy-middleware的配置选项中,除了我们常见的target,还有router。router返回一个字符串的服务地址,当两个选项都配置了的情况下,会优先使用router函数的返回值,只有当router的返回值不可用时,才会使用target的值。

我们可以利用这一点来重新配置我们的项目代码。参考文档在这里

// vue.config.js

const { defineConfig } = require('@vue/cli-service')

const { proxy } = require('./environments/proxy.js')

module.exports = defineConfig({

devServer:{

proxy

},

})

复制代码// proxy.js

const fs = require('fs')

const path = require('path')

const encoding = 'utf-8'

const getContent = filename => {

const dir = path.resolve(process.cwd(), 'environments')

return fs.readFileSync(path.resolve(dir, filename), { encoding })

}

const jsonParse = obj => { return Function('"use strict";return (' + obj + ')')() }

const getConfig = () => { try {

return jsonParse(getContent('proxy-config.json'))

} catch (e) { return {} } }

module.exports = {

proxy: {

// 接口匹配规则自行修改

'/api': {

// 这里必须要有字符串来进行占位

// 如果报错Invaild Url,将target改成有效的url字符串即可,如http://localhost:9001

target: 'that must have a empty placeholder',

changeOrigin: true,

router: () => (getConfig() || {}).target || ''

}

}

}

复制代码// proxy-config.json

{ "target": "http://localhost:9001" }

复制代码自此,当我们需要修改环境地址时,只需要修改proxy-config.json文件便能够实时生效,不再需要npm run serve!

重点代码分析

实现代码中其实最主要的就是getContent这个方法,我们项目在每次发起http请求时都会调用router中的函数,而getContent则会通过node的fs服务,对我们的环境地址文件进行实时读取,从而指向我们最新修改的环境地址。

方案总结

在按照参考文档配置了项目代码之后,我们发现确实能够及时指向新的环境地址,再也不需要重启代码,不需要长时间的等待了。但是,我们多了两个需要维护的文件,每次我们修改环境地址时,不仅需要修改config中的api,还需要修改proxy-config.json中的target!

有没有可能在只需要修改config文件的情况下,实现代理地址动态修改呢?

方案优化

从上面的重点代码分析中,可以看到只要我们可以在router函数执行时,拿到正确的config文件中导出的api属性的值,也可以实现同样的效果!

这是不是意味着只要我们在函数中对config文件进行require请求,读取api的值,再return出去就能及时修改代理指向了呢?

没错,你会发现无论你怎么修改,函数内require取到的api永远是不变的,还是服务刚启动时的环境地址。

参考源码可以知道,这是因为我们在使用require请求文件信息时,node会解析出我们传入的字符串的文件路径的绝对路径,并且以绝对路径为键值,对该文件进行缓存。

因此,如果我们在执行require函数时打断点进行观察的话,会发现require上面有一个cache缓存了已经加载过的文件。

这也恰恰说明了只要我们能够删除掉文件保存在require中的缓存,我们就能够拿到最新的文件内容,那么我们也可以据此得出我们的最终优化方案。

// vue.config.js

const hotRequire = modulePath => {

// require.resolve可以通过相对路径获取绝对路径

// 以绝对路径为键值删除require中的对应文件的缓存

delete require.cache[require.resolve(modulePath)]

// 重新获取文件内容

const target = require(modulePath)

return target

}

...

proxy: {

'/api': {

// 如果router有效优先取router返回的值

target: 'that must have a empty placeholder',

changeOrigin: true,

// 每次发起http请求都会执行router函数

router: () => (hotRequire('./src/utils/config') || {}).api || '',

ws: true,

pathRewrite: {

'^/api': ''

}

}

}

复制代码自此,我们项目修改环境地址将不在需要重启项目,也不需要维护额外的文件夹,再也不需要痛苦等待了!

来源:https://juejin.cn/post/7198696282336313400

终于理解~Android 模块化里的资源冲突

本文翻译自 Understanding resource conflicts in Android,原作者:Adam Campbell

⚽ 前言

作为 Android 开发者,我们常常需要去管理非常多不同的资源文件,编译时这些资源文件会被统一地收集和整合到同一个包下面。根据官方的《Configure your build》文档介绍的构建过程可以总结这个过程:

编译器会将源码文件转换成包含了二进制字节码、能运行在 Android 设备上的 DEX 文件,而其他文件则被转换成编译后资源。

APK 打包工具则会将 DEX 文件和编译后资源组合成独立的 APK 文件。

但如果资源的命名发生了碰撞、冲突,会对编译产生什么影响?

事实证明这个影响是不确定的,尤其是涉及到构建外部 Library。

本文将探究一些不同的资源冲突案例,并逐个说明怎样才能安全地命名资源。

🇦🇷 App module 内资源冲突

先来看个最简单的资源冲突的案例:同一个资源文件中出现两个命名、类型一样的资源定义,比如:

<!--strings.xml-->

<resources>

<string name="hello_world">Hello World!</string>

<string name="hello_world">Hello World!</string>

</resources>试图去编译的话,会导致显而易见的错误提示:

FAILURE: Build failed with an exception.

* What went wrong:

Execution failed for task ':app:mergeDebugResources'.

> /.../strings.xml: Error: Found item String/hello_world more than one time类似的,另一种常见冲突是在多个文件里定义冲突的资源:

<!--strings.xml-->

<resources>

<string name="hello_world">Hello World!</string>

</resources>

<!--other_strings.xml-->

<resources>

<string name="hello_world">Hello World!</string>

</resources>我们会收到类似的编译错误,而这次的错误将列出所有发生冲突的具体文件位置。

FAILURE: Build failed with an exception.

* What went wrong:

Execution failed for task ':app:mergeDebugResources'.

> [string/hello_world] /.../other_strings.xml

[string/hello_world] /.../strings.xml: Error: Duplicate resourcesAndroid 平台上资源的运作方式变得愈加清晰。我们需要为 App module 指定在类型、名称、设备配置等限定组合下的唯一资源。也就是说,当 App module 引用 string/hello_world 资源的时候,有且仅有一个值被解析出来。开发者们必须解决发生的资源冲突,可以选择删除那些内容重复的资源、重命名仍然需要的资源、亦或移动到其他限定条件下的资源文件。

更多关于资源和限定的信息可以参考官方的《App resources overview》 文档。

🇩🇪 Library 和 App module 的资源冲突

下面这个案例,我们将研究 Library module 定义了一个和 App module 重复的资源而引发的冲突。

<!--app/../strings.xml-->

<resources>

<string name="hello">Hello from the App!</string>

</resources>

<!--library/../strings.xml-->

<resources>

<string name="hello">Hello from the Library!</string>

</resources>当你编译上面的代码的时候,发现竟然通过了。从我们上个章节的发现来看,我们可以推测 Android 肯定采用了一个规则,去确保在这种场景下仍能够找到一个独有的 string/hello 资源值。

根据官方的《Create an Android library》文档:

编译工具会将来自 Library module 的资源和独立的 App module 资源进行合并。如果双方均具备一个资源 ID 的话,将采用 App 的资源。

这样的话,将会对模块化的 App 开发造成什么影响?比如我们在 Library 中定义了这么一个 TextView 布局:

<!--library/../text_view.xml-->

<TextView

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:text="@string/hello"

xmlns:android="http://schemas.android.com/apk/res/android" />AS 中该布局的预览是这样的。

现在我们决定将这个 TextView 导入到 App module 的布局中:

<!--app/../activity_main.xml-->

<LinearLayout

xmlns:android="http://schemas.android.com/apk/res/android"

xmlns:tools="http://schemas.android.com/tools"

android:layout_width="match_parent"

android:layout_height="match_parent"

android:gravity="center"

tools:context=".MainActivity"

>

<include layout="@layout/text_view" />

</LinearLayout>无论是 AS 中预览还是实际运行,我们可以看到下面的一个显示结果:

不仅是通过布局访问 string/hello 的 App module 会拿到 “Hello from the App!”,Library 本身拿到的也是如此。基于这个原因,我们需要警惕不要无意覆盖 Lbrary 中的资源定义。

🇧🇷 Library 之间的资源冲突

再一个案例,我们将讨论下当多个 Library 里定义了冲突的资源,会发生什么。

首先来看下如下的布局,如果这样写的话会产生什么结果?

<!--library1/../strings.xml-->

<resources>

<string name="hello">Hello from Library 1!</string>

</resources>

<!--library2/../strings.xml-->

<resources>

<string name="hello">Hello from Library 2!</string>

</resources>

<!--app/../activity_main.xml-->

<TextView

xmlns:android="http://schemas.android.com/apk/res/android"

android:layout_width="wrap_content"

android:layout_height="wrap_content"

android:text="@string/hello" />string/hello 将会被显示成什么?

事实上这取决于 App build.gradle 文件里依赖这些 Library 的顺序。再次到官方的《Create an Android library》文档里找答案:

如果多个 AAR 库之间发生了冲突,依赖列表里第一个列出(在依赖关系块的顶部)的资源将会被使用。

假使 App module 有这样的依赖列表:

dependencies {

implementation project(":library1")

implementation project(":library2")

...

}最后 string/hello 的值将会被编译成 Hello from Library 1!。

那么如果这两个 implementation 代码调换顺序,比如 implementation project(":library2") 在前、 implementation project(":library1") 在后,资源值则会被编译成 Hello from Library 2!。

从这种微妙的变化可以非常直观地看到,依赖顺序可以轻易地改变 App 的资源展示结果。

🇪🇸 自定义 Attributes 的资源冲突

目前为止讨论的示例都是针对 string 资源的使用,然而需要特别留意的是自定义 attributes 这种有趣的资源类型。

看下如下的 attr 定义:

<!--app/../attrs.xml-->

<resources>

<declare-styleable name="CustomStyleable">

<attr name="freeText" format="string"/>

</declare-styleable>

<declare-styleable name="CustomStyleable2">

<attr name="freeText" format="string"/>

</declare-styleable>

</resources>大家可能都认为上面的写法能通过编译、不会报错,而事实上这种写法必将导致下面的编译错误:

Execution failed for task ':app:mergeDebugResources'.

> /.../attrs.xml: Error: Found item Attr/freeText more than one time但如果 2 个 Library 也采用了这样的自定义 attr 写法:

<!--library1/../attrs.xml-->

<resources>

<declare-styleable name="CustomStyleable">

<attr name="freeText" format="string"/>

</declare-styleable>

</resources>

<!--library2/../attrs.xml-->

<resources>

<declare-styleable name="CustomStyleable2">

<attr name="freeText" format="string"/>

</declare-styleable>

</resources>事实上它却能够通过编译。

然而,如果我们进一步将 Library2 的 attr 做些调整,比如改为 <attr name="freeText" format="boolean"/>。再次编译,它竟然又失败了,而且出现了更多令人费解的错误:

* What went wrong:

Execution failed for task ':app:mergeDebugResources'.

> A failure occurred while executing com.android.build.gradle.internal.tasks.Workers$ActionFacade

> Android resource compilation failed

/.../library2/build/intermediates/packaged_res/debug/values/values.xml:4:5-6:25: AAPT: error: duplicate value for resource 'attr/freeText' with config ''.

/.../library2/build/intermediates/packaged_res/debug/values/values.xml:4:5-6:25: AAPT: error: resource previously defined here.

/.../app/build/intermediates/incremental/mergeDebugResources/merged.dir/values/values.xml: AAPT: error: file failed to compile.上面错误的一个重点是: mergeDebugResources/merged.dir/values/values.xml: AAPT: error: file failed to compile。

到底是怎么回事呢?

事实上 values.xml 的编译指的是为 App module 生成 R 类。编译期间,AAPT 会尝试在 R 类里为每个资源属性生成独一无二的值。而对于 styleable 类型里的每个自定义 attr,都会在 R 类里生成 2 个的属性值。

第一个是 styleable 命名空间属性值(位于 R.styleable 包下),第二个是全局的 attr 属性值(位于 R.attr 包下)。对于这个探讨的特殊案例,我们则遇到了全局属性值的冲突,并且由于此冲突造成存在 3 个属性值:

R.styleable.CustomStyleable_freeText:来自 Library1,用于解析string格式的、名称为freeText的 attrR.styleable.CustomStyleable2_freeText:来自 Library2,用于解析boolean格式的、名称为freeText的 attrR.attr.freeText:无法被成功解析,源自我们给它赋予了来自 2 个 Library 的数值,而它们的格式不同,造成了冲突

前面能通过编译的示例是因为 Library 间同名的 R.attr.freeText 格式也相同,最终为 App module 编译到的是独一无二的数值。需要注意:每个 module 具备自己的 R 类,我们不能总是指望属性的数值在 Library 间保持一致。

再次看下官方的《Create an Android library》文档的建议:

当你构建依赖其他 Library 的 App module 时,Library module 们将会被编译成 AAR 文件再添加到 App module 中。所以,每个 Library 都会具备自己的

R类,用 Library 的包名进行命名。所有包都会创建从 App module 和 Library module 生成的R类,包括 App module 的包和 Library moudle 的包。

📝 结语

所以我们能从上面的这些探讨得到什么启发?

是资源编译过程的复杂和微妙吗?

确实是的。但是作为开发者,我们能为自己和团队做的是:解释清楚定义的资源想要做什么,也就是说可以加上名称前缀。我们最喜欢的官方文档《Create an Android library》也提到了这宝贵的一点:

通用的资源 ID 应当避免发生资源冲突,可以考虑使用前缀或其他一致的、对 module 来说独一无二的命名方案(抑或是整个项目都是独一无二的命名)。

根据这个建议,比较好的做法是在我们的项目和团队中建立一个模式:在 module 中的所有资源前加上它的 module 名称,例如library_help_text。

这将带来两个好处:

大大降低了名称冲突的概率。

明确资源覆盖的意图。

比如也在 App module 中创建

library_help_text的话,则表明开发者是有意地覆盖 Library module 中的某些定义。有的时候我们的确会想去覆盖一些其他资源,而这样的编码方式可以明确地告诉自己和团队,在编译的时候会发生预期的覆盖。

抛开内部开发不谈,至少是所有公开的资源都应该加上前缀,尤其是作为一个供应商或者开源项目去发布我们的 library。

可以往的经验来看,Google 自己的 library 也没有对所有的资源进行恰当地前缀命名。这将导致意外的副作用:依赖我们发行的 library 可能会因为命名冲突引发 App 编译失败。

Not a great look!

例如,我们可以看到 Material Design library 会给它们的颜色资源统一地添加 mtrl 的前缀。可是 styleable 下嵌套的 attribute resources 却没有使用 material 之类的前缀。

所以你会看到:假使一个 module 依赖了 Material library,同时依赖的另一个 library 中包含了与 Material library 一样名称的 attribute,那么在为这个 moudle 生成 R 类的时候,会发生冲突的可能。

🙏 鸣谢

本篇文章受到了下面文章或文档的启发和帮助:

📚 原文

作者:TechMerger

来源:juejin.cn/post/7170562275374268447

由浅入深,聊聊OkHttp的那些事(很长,很细节)

引言

在 Android 开发的世界中,有一些组件,无论应用层技术再怎么迭代,作为基础支持,它们依然在那里。

比如当我们提到网络库时,总会下意识想到一个名字,即 OkHttp 。

尽管对于大多数开发者而言,通常情况下使用的是往往它的封装版本 Retrofit ,不过其底层依然离不开 Okhttp 作为基础支撑。而无论是自研网络库的二次封装,还是个人使用,OkHttp 也往往都是不二之选。

故本篇将以最新视角开始,用力一瞥 OkHttp 的设计魅力。

本文对应的 OkHttp 版本: 4.10.0

本篇定位 中高难度,将从背景到使用方式,再到设计思想与源码解析,尽可能全面、易懂。

背景

每一个技术都有其变迁的历史背景与特性,本小节,我们将聊一聊 Android网络库 的迭代史,作为开篇引语,润润眼。 🔖

关于 Android网络库 的迭代历史,如下图所示:

具体进展如下:

HttpClient

Android1.0时推出。但存在诸多问题,比如内存泄漏,频繁的GC等。5.0后,已被弃用;

HttpURLConnection

Android2.2时推出,比HttpClient更快更稳定,Android4.4 之后底层已经被Okhttp替代;

Google 2013年开源,基于

HttpURLConnection的封装,具有良好的扩展性和适用性,不过对于复杂请求或者大量网络请求时,性能较差。目前依然有不少项目使用(通常是老代码的维护);

Square 2013年开源,基于 原生Http 的底层设计,具有 快速 、 稳定 、节省资源 等特点。是目前诸多热门网络请求库的底层实现,比如

Retrofit、RxHttp等;

Square 2013年开源,基于

OkHttp的封装,目前 主流 的网络请求库。

通过注解方式配置网络请求、REST风格 api、解耦彻底、经常会搭配 Rx等 实现 框架联动;

…

上述的整个过程,也正是伴随了 Android 开发的各个时期,如果将上述分为 5个阶段 的话,那么则为:

HttpClient->HttpURLConnection->volley->okhttp->Retrofit*

通过 Android网络库 的迭代历史,我们不难发现,技术变迁越来越趋于稳定,而 OkHttp 也已经成为了基础组件中不可所缺的一员。

设计思想

当聊到OkHttp的设计思想,我们想知道什么?

从应用层去看,熟练的开发者会直接喊出拦截器,巴拉巴拉…

而作为初学者,可能更希望的事广度与解惑,

OkHttp到底牛在了什么地方,或者说常说的 拦截器到底是什么 ? 🧐

在官方的描述中,OkHttp 是一个高效的 Http请求框架 ,旨在 简化 客户端网络请求,提高 请求效率。

具体设计思想与特性如下:

- 连接复用 :避免在每个请求之间重新建立连接。

- 连接池 降低了请求延迟 (HTTP/2不可用情况下);

- 自动重试 :在请求失败时自动重试请求,从而提高请求可靠性。

- 自动处理缓存 :会按照预定的缓存策略处理缓存,以便最大化网络效率。

- 支持HTTP/2, 并且允许对同一个主机的所有请求共享一个套接字(HTTP/2);

- 简化Api:Api设计简单明了,易于使用,可以轻松发起请求获取响应,并处理异常。

- 支持gzip压缩 :OkHttp支持gzip压缩,以便通过减少网络数据的大小来提高网络效率。

特别的,如果我们的服务器或者域名有 多个IP地址 ,OkHttp 将在 第一次 连接失败时尝试替代原有的地址(对于 IPv4+IPv6 和托管在冗余数据中心的服务是必需的)。并且支持现代 TLS 功能(TLS 1.3、ALPN、证书固定)。它可以配置为回退以实现广泛的连接。

总的来说,其设计思想是通过 简化请求过程 、提高请求效率、提高请求可靠性,从而提供 更快的响应速度 。

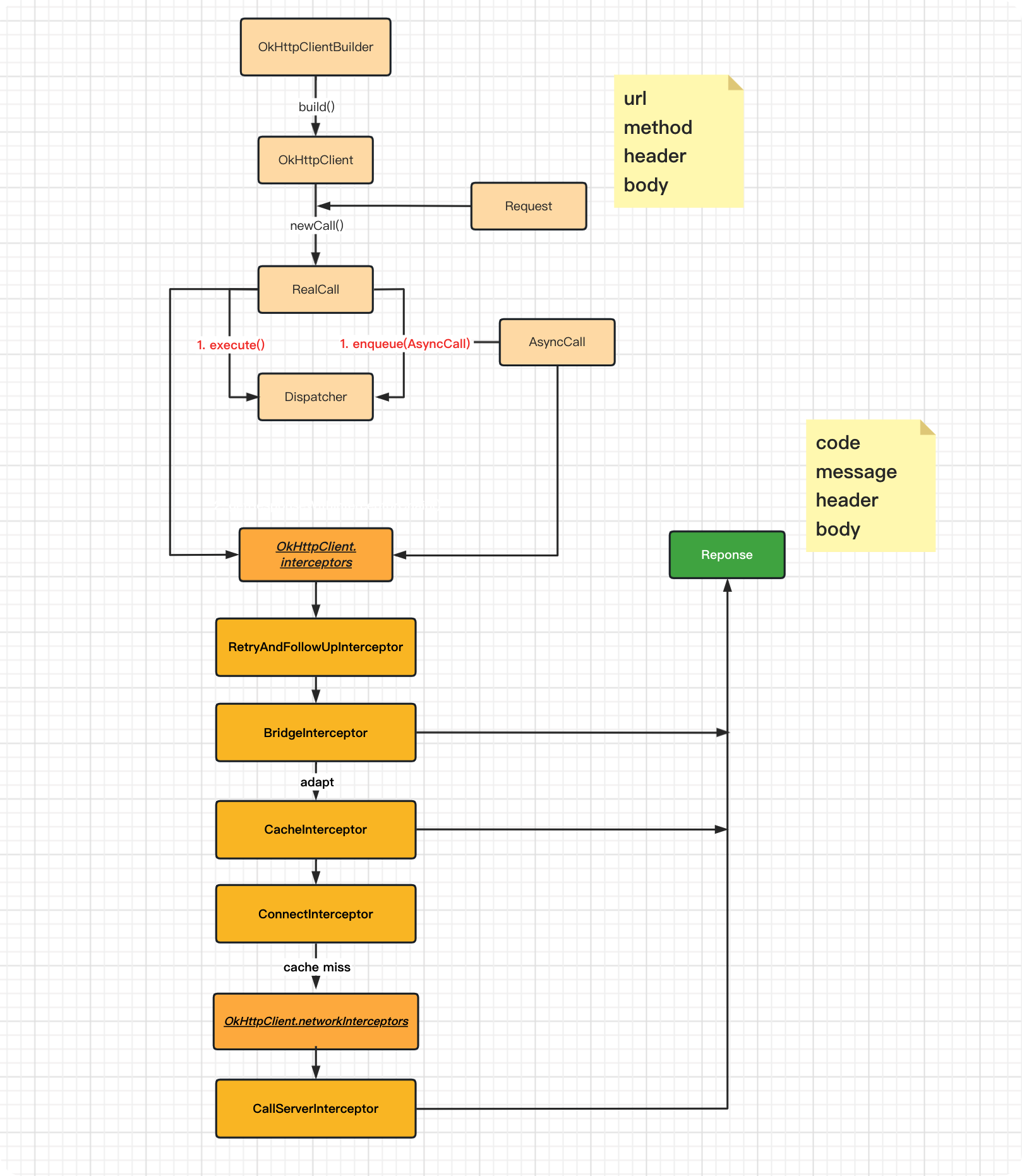

应用层的整个请求框架图如下:

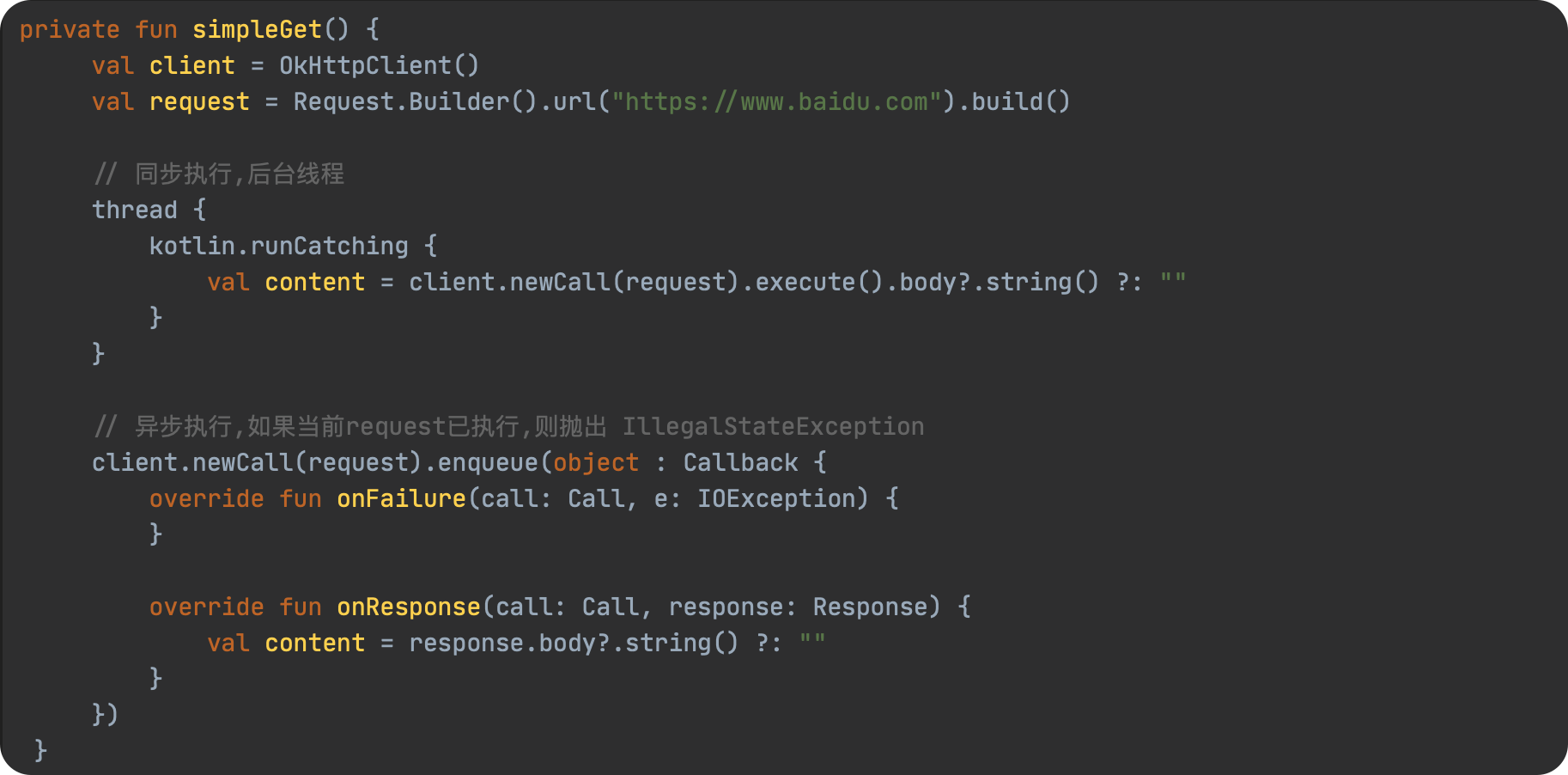

使用方式

在开始探究设计原理与思想之前,我们还是要先看看最基础的使用方式,以便为后续做一些铺垫。

// build.gradle

implementation "com.squareup.okhttp3:okhttp:4.10.0"

复制代码// Android Manifest

<uses-permission android:name="android.permission.INTERNET" />

复制代码发起一个get请求

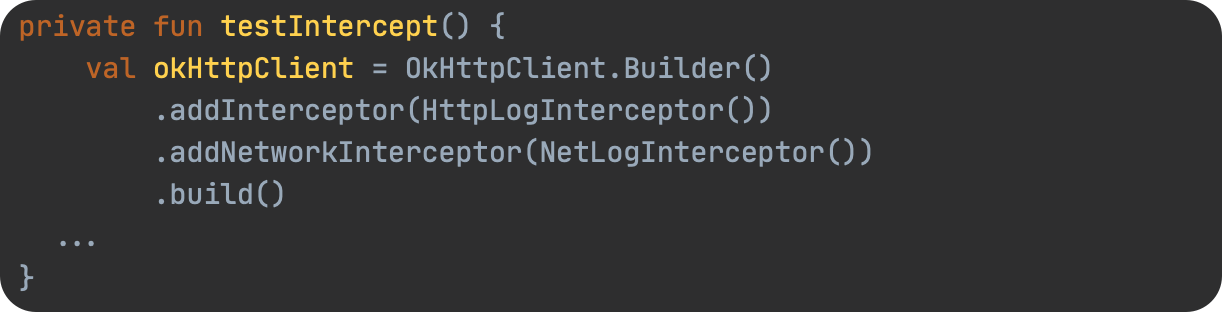

拦截器的使用

总结起来就是下面几步:

- 创建

OkHttpClient对象;

- 构建

Request;

- 调用

OkHttpClient执行request请求 ;

- 同步阻塞 或者 异步回调 方式接收结果;

更多使用方式,可以在搜索其他同学的教程,这里仅仅只是作为后续解析原理时的必要基础支撑。

源码分析

基础配置

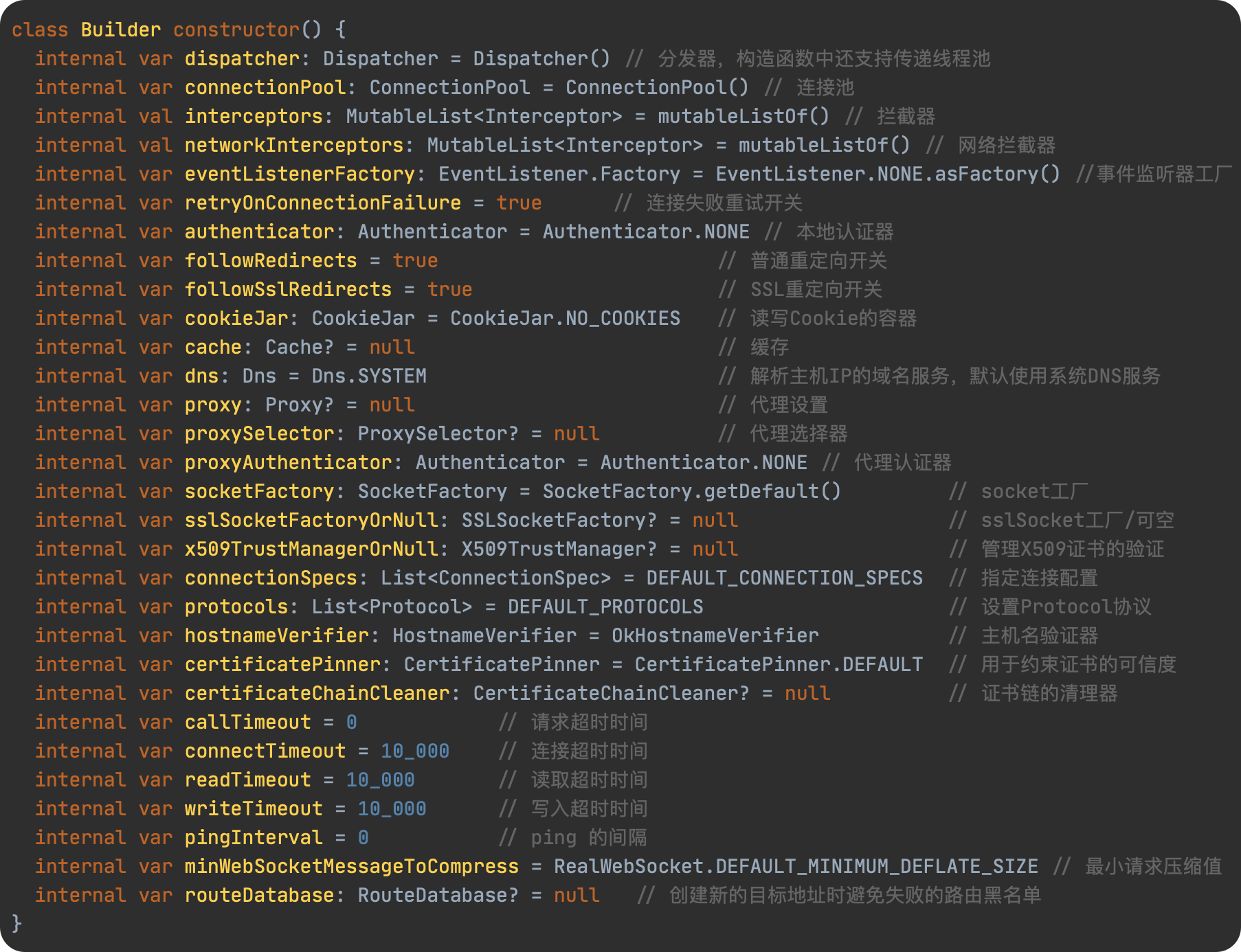

OkHttpClient

val client = OkHttpClient.Builder().xxx.build()

复制代码由上述调用方式,我们便可以猜出,这里使用了 构建者模式 去配置默认的参数,所以直接去看 OkHttpClient.Builder 支持的参数即可,具体如下:

具体的属性意思在代码中也都有注释,这里我们就不在多提了。

需要注意的是,在使用过程中,对于 OkHttpClient 我们还是应该缓存下来或者使用单例模式以便后续复用,因为其相对而言还是比较重。

Request

指客户端发送到服务器的 HTTP请求。

在 OkHttp 中,可以使用 Request 对象来构建请求,然后使用 OkHttpClient 对象来发送请求。

通常情况下,一个请求包括了 请求头、请求方法、请求路径、请求参数、url地址 等信息。主要是用来请求服务器返回某些资源,如网页、图片、数据等。

具体源码如下所示:

Request.Builder().url("https://www.baidu.com").build()

复制代码open class Builder {

// url地址

internal var url: HttpUrl? = null

// 请求方式

internal var method: String

// 请求头

internal var headers: Headers.Builder

// 请求体

internal var body: RequestBody? = null

// 请求tag

internal var tags: MutableMap<Class<*>, Any>

}

复制代码发起请求

execute()

用于执行 同步请求 时调用,具体源码如下:

client.newCall(request).execute()

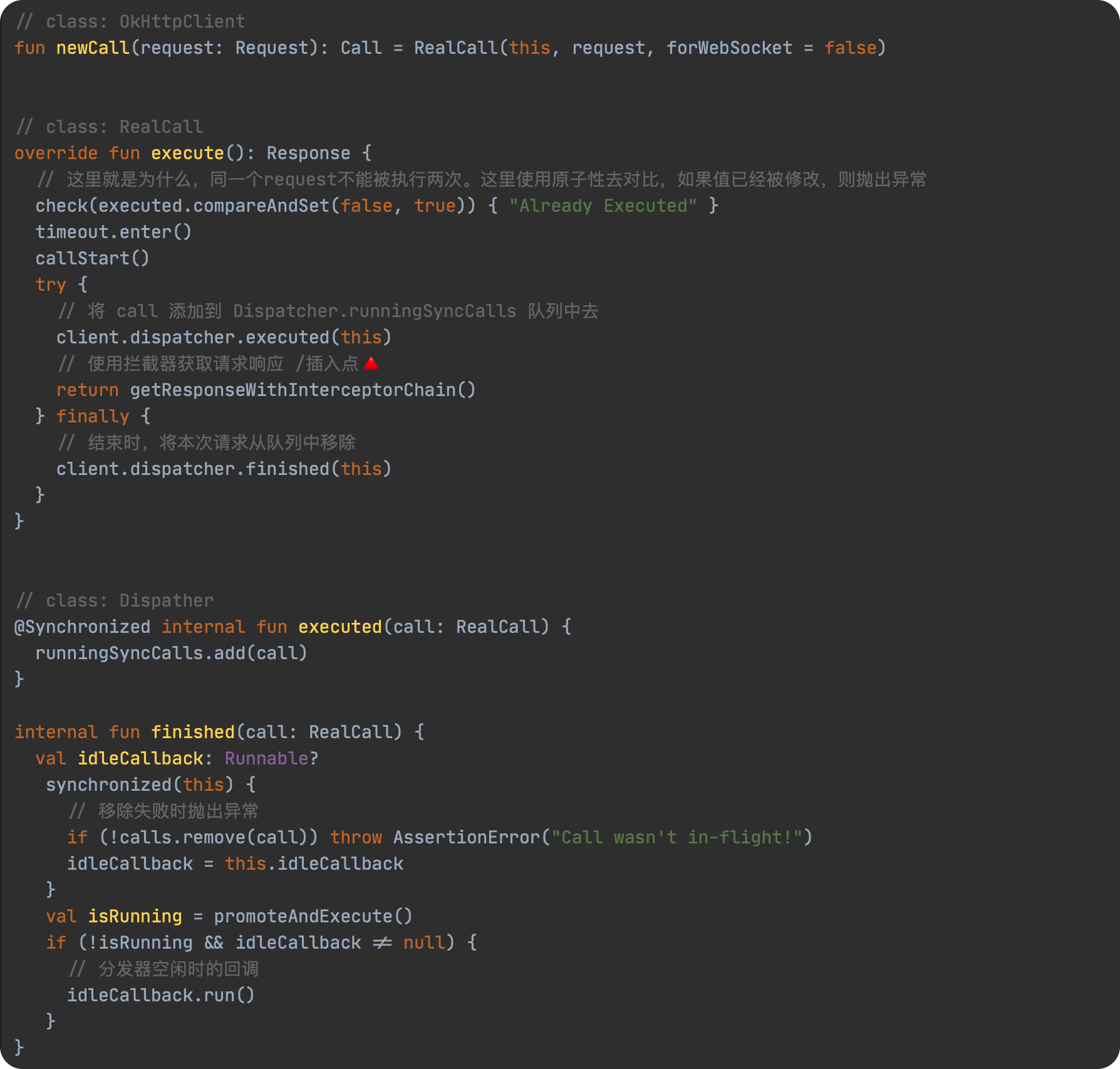

复制代码接下来我们再去看看 client.newCall() , 即请求发起时的逻辑。

当我们使用 OkHttpClient.newCall() 方法时,实际是创建了一个新的 RealCall 对象,用于 应用层与网络层之间的桥梁,用于处理连接、请求、响应以及流 ,其默认构造函数中需要传递 okhttpClient 对象以及 request 。

接着,使用了 RealCall 对象调用了其 execute() 方法开始发起请求,该方法内部会将当前的 call 加入我们 Dispatcher 分发器内部的 runningSyncCalls 队列中取,等待被执行。接着调用 getResponseWithInterceptorChain() ,使用拦截器获取本次请求响应的内容,这也即我们接下来要关注的步骤。

enqueue()

执行 异步请求 时调用,具体源码如下:

client.newCall(request).enqueue(CallBack)

复制代码当我们调用 RealCall.enqueue() 执行异步请求时,会先将本次请求加入 Dispather.readyAsyncCalls 队列中等待执行,如果当前请求是 webSocket 请求,则查找与当前请求是同一个 host 的请求,如果存在一致的请求,则复用先前的请求。

接下来调用 promoteAndExecute() 将所有符合条件可以请求的 Call 从等待队列中添加到 可请求队列 中,再遍历该请求队列,将其添加到 线程池 中去执行。

继续沿着上面的源码,我们去看 asyncCall.executeOn(executorService) ,如下所示:

上述逻辑也很简单,当我们将任务添加到线程池后,当任务被执行时,即触发 run() 方法的调用。该方法中会去调用 getResponseWithInterceptorChain() 从而使用拦截器链获取服务器响应,从而完成本次请求。请求成功后则调用我们开始时的 callback对象 的 onResponse() 方法,异常(即失败时)则调用 onFailure() 方法。

拦截器链

在上面我们知道,他们最终都走到了 RealCall.getResponseWithInterceptorChain() 方法,即使用 拦截器链 获取本次请求的响应内容。不过对于初看OkHttp源码的同学,这一步应用会有点迷惑,拦截器链 是什么东东👾?

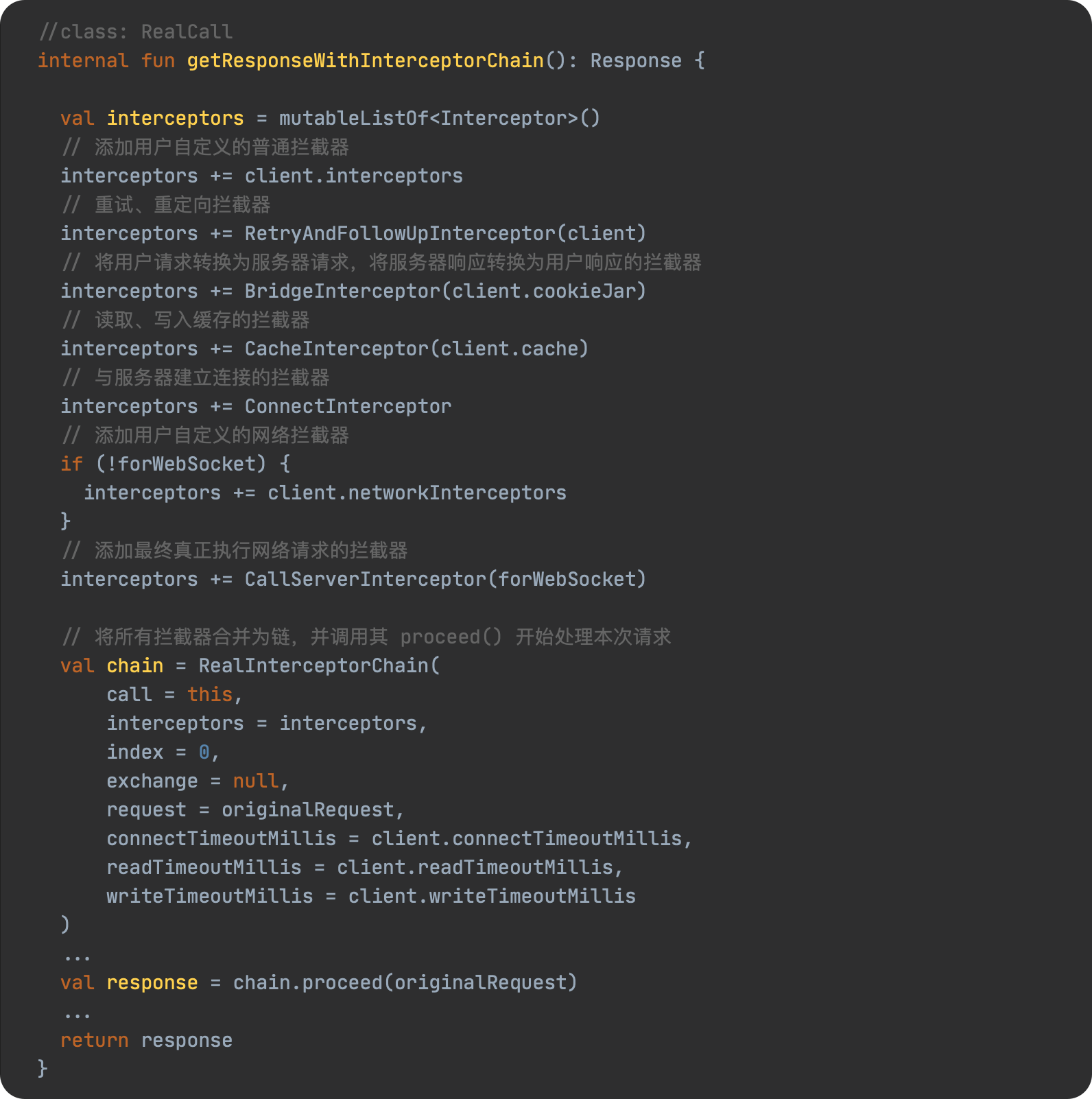

在解释 拦截器链 之前,我们不妨先看一下 RealCall.getResponseWithInterceptorChain() 方法对应的源码实现,然后再去解释为什么,也许更容易理解。

具体源码如下:

上述的逻辑非常简单,内部会先创建一个局部拦截器集合,然后将我们自己设置的普通拦截器添加到该集合中,然后添加核心的5大拦截器,接着再将我们自定义的网络拦截器也添加到该集合中,最终才添加了真正用于执行网络请求的拦截器。接着创建了一个拦截器责任链 RealInterceptorChain ,并调用其 proceed() 方法开始执行本次请求。

责任链模式

在上面我们说到了,要解释 OkHttp 的拦截器链,我们有必要简单聊一下什么是责任链模式?

责任链模式(Chain of Responsibility)是一种处理请求的模式,它让多个处理器都有机会处理该请求,直到其中某个处理成功为止。责任链模式把多个处理器串成链,然后让请求在链上传递。

摘自 责任链模式 @廖雪峰

以 Android 中常见的事件分发为例:当我们的手指点击屏幕开始,用户的触摸事件从 Activity 开始分发,接着从 windows 开始分发到具体的 contentView(ViewGroup) 上,开始调用其 dispatchTouEvent() 方法进行事件分发。在这个方法内,如果当前 ViewGroup 不进行拦截,则默认会继续向下分发,寻找当前 ViewGroup 下对应的触摸位置 View ,如果该 View 是一个 ViewGroup ,则重复上述步骤。如果事件被某个 view 拦截,则触发其 onTouchEvent() 方法,接着交由该view去消费该事件。而如果事件传递到最上层 view 还是没人消费,则该事件开始按照原路返回,先交给当前 view 自己的 onTouchEvent() ,因为自己不消费,则调用其 父ViewGroup 的 onTouchEvent() ,如此层层传递,最终又交给了 Act 自行处理。上述这个流程,就是 责任链模式 的一种体现。

如下图所示:

上图来自 Android事件分发机制三:事件分发工作流程 @一只修仙的猿

看完什么是责任链模式,让我们将思路转回到 OkHttp 上面,我们再去看一下 RealInterceptorChain 源码。

上述逻辑如下:

当

getResponseWithInterceptorChain()方法内部最终调用RealInterceptorChain.proceed()时,内部传入了一个默认的index ,这个 index 就代表了当前要调用的 拦截器item ,并在方法内部每次创建一个新的RealInterceptorChain链,index+1,再调用当前拦截器intercept()方法时,然后将下一个链传入;

最开始调用的是用户自定义的 普通拦截器,如果上述我们添加了一个

CustomLogInterceptor的拦截器,当获取response时,我们需要调用Interceptor.Chain.proceed(),而此时的chain正是下一个拦截器对应的RealInterceptorChain;

上述流程里,index从0开始,以此类推,一直到链条末尾,即 拦截器集合长度-1处;

当遇到最后一个拦截器

CallServerInterceptor时,此时因为已经是最后一个拦截器,链条肯定要结束了,所以其内部肯定也不会调用proceed()方法。

相应的,为什么我们在前面说 它 是真正执行与服务器建立实际通讯的拦截器?

因为这个里会获取与服务器通讯的

response,即最初响应结果,然后将其返回上一个拦截器,即我们的网络拦截器,再接着又向上返回,最终返回到我们的普通拦截器处,从而完成整个链路的路由。

参照上面的流程,即大致思路图如下:

拦截器

RetryAndFollowUpInterceptor

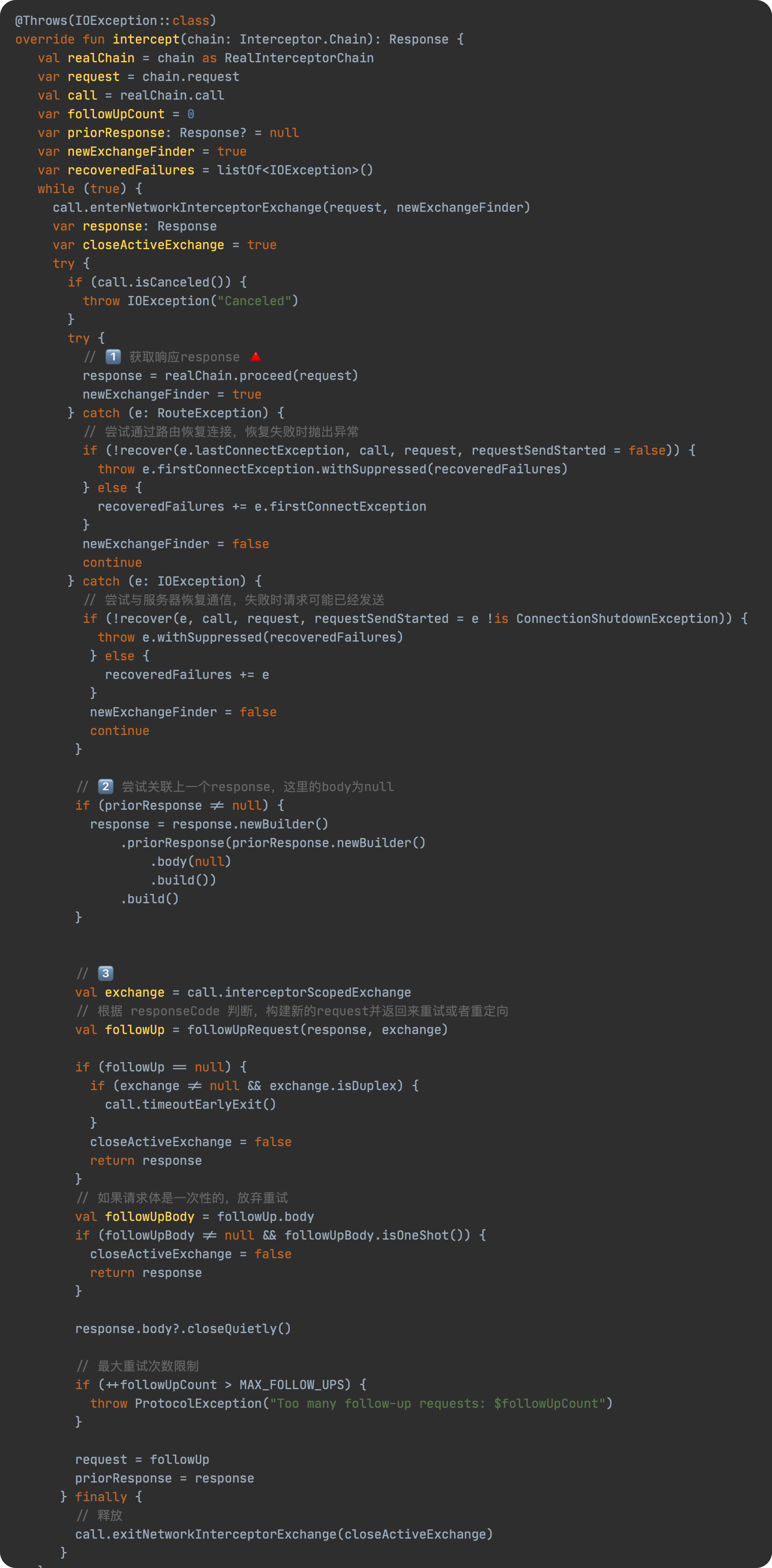

见名知意,用于 请求失败 的 重试 工作以及 重定向 的后续请求工作,同时还会对 连接 做一些初始化工作。

上述的逻辑,我们分为四段进行分析:

- 请求时如果遇到异常,则根据情况去尝试恢复,如果不能恢复,则抛出异常,跳过本次请求;如果请求成功,则在

finally里释放资源; - 如果请求是重试之后的请求,那么将重试前请求的响应体设置为null,并添加到当前响应体的

priorResponse字段中; - 根据当前的responseCode判断是否需要重试,若不需要,则返回

response;若需要,则返回request,并在后续检查当前重试次数是否达到阈值; - 重复上述步骤,直到步骤三成功。

在第一步时,获取 response 时,需要调用 realChain.proceed(request) ,如果你还记得上述的责任链,所以这里触发了下面的拦截器执行,即 BridgeInterceptor 。

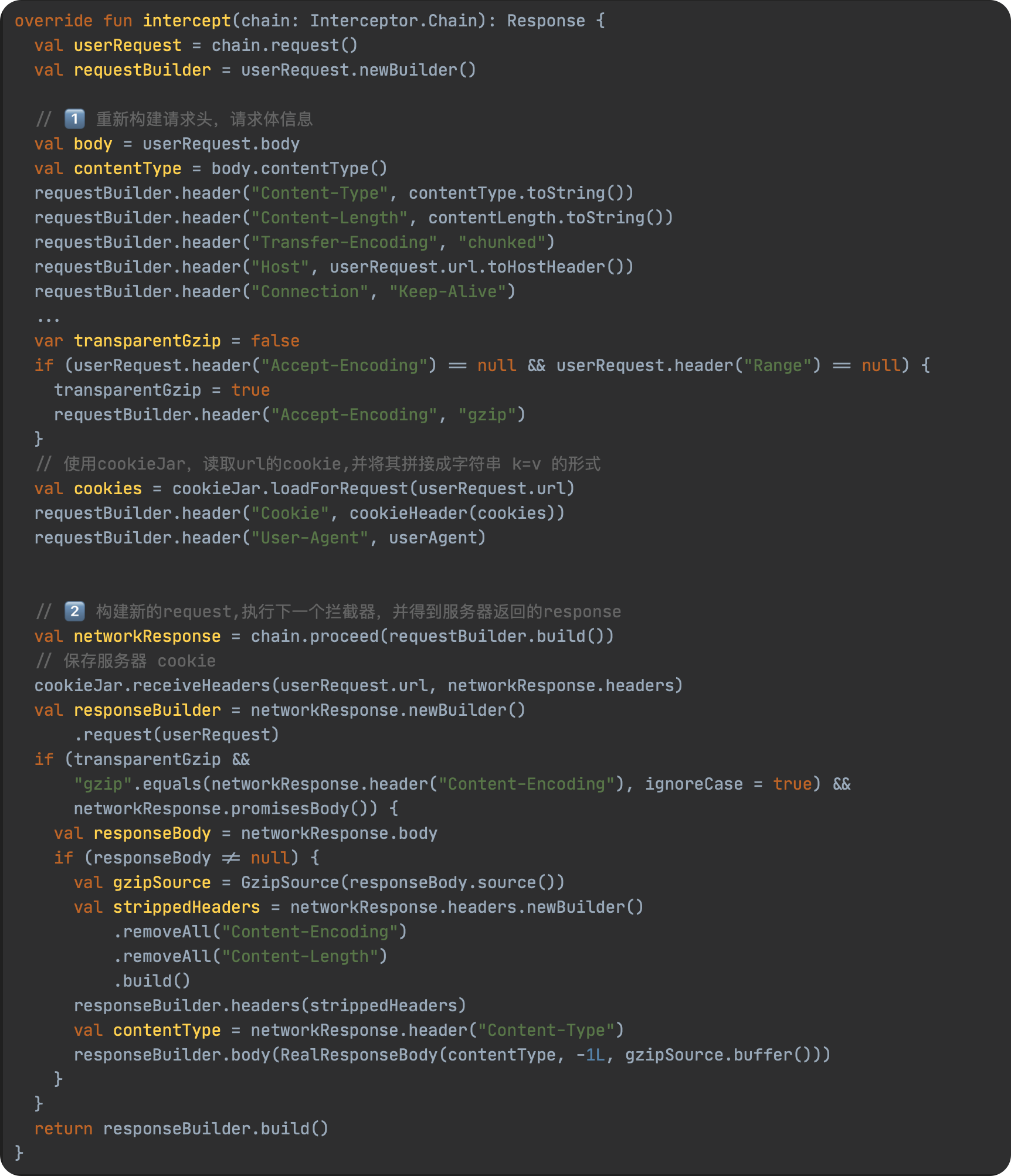

BridgeInterceptor

用于 客户端和服务器 之间的沟通 桥梁 ,负责将用户构建的请求转换为服务器需要的请求。比如添加 content-type、cookie 等,再将服务器返回的 response 做一些处理,转换为客户端所需要的 response,比如移除 Content-Encoding ,具体见下面源码所示:

上述逻辑如下:

- 首先调用

chain.request()获取原始请求数据,然后开始重新构建请求头,添加header以及cookie等信息; - 将第一步构建好的新的

request传入chain.proceed(),从而触发下一个拦截器的执行,并得到 服务器返回的response。然后保存response携带的cookie,并移除header中的Content-Encoding和Content-Length,并同步修改body。

CacheInterceptor

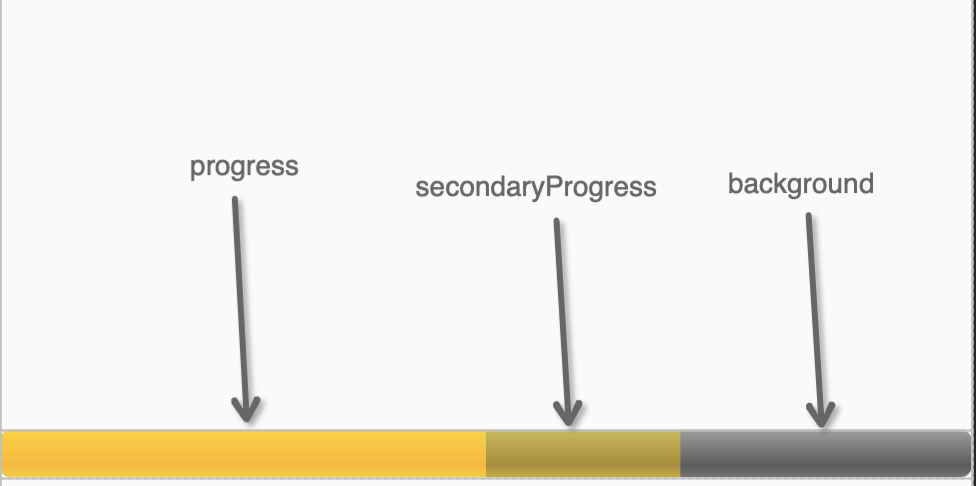

见名知意,其用于网络缓存,开发者可以通过 OkHttpClient.cache() 方法来配置缓存,在底层的实现处,缓存拦截器通过 CacheStrategy 来判断是使用网络还是缓存来构建 response。具体的 cache 策略采用的是 DiskLruCache 。

Cache的策略如下图所示:

具体源码如下所示:

具体的逻辑如上图所示,具体可以参照上述的 Cache 流程图,这里我们再说一下 CacheStrategy 这个类,即决定何时使用 网络请求、响应缓存。

CacheStrategy

ConnectInterceptor

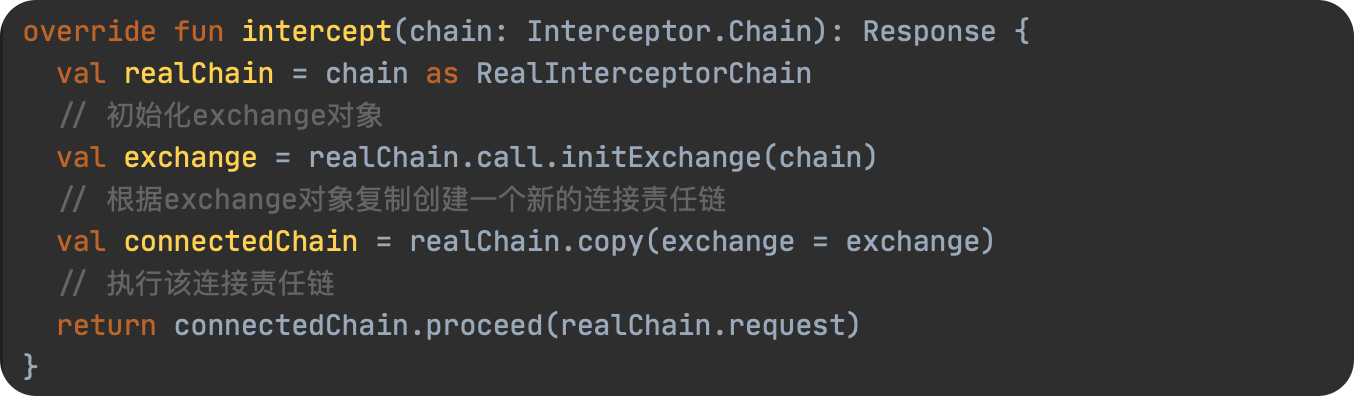

实现与服务器真正的连接。

上述流程如下:

- 初始化 一个

exchange对象; - 根据

exchange对象来复制创建一个新的连接责任链; - 执行该连接责任链。

那 Exchange 是什么呢?

在官方的解释里,其用于 传递单个

HTTP请求和响应对,在ExchangeCode的基础上担负了一些管理及事件分发的作用。

具体而言,

Exchange与Request相对应,新建一个请求时就会创建一个Exchange,该Exchange负责将这个请求发送出去并读取到响应数据,而具体的发送与接收数据使用的则是ExchangeCodec。

相应的,ExchangeCode 又是什么呢?

ExchangeCodec负责对request编码及解码Response,即写入请求及读取响应,我们的请求及响应数据都是通过它来读写。

通俗一点就是,ExchangeCodec 是请求处理器,它内部封装了

OkHttp中执行网络请求的细节实现,其通过接受一个Request对象,并在内部进行处理,最终生成一个符合HTTP协议标准的网络请求,然后接受服务器返回的HTTP响应,并生成一个Response对象,从而完成网络请求的整个过程。

额外的,我们还需要再提一个类,ExchangeFinder 。

用于寻找可用的

Exchange,然后发送下一个请求并接受下一个响应。

虽然上述流程看起来似乎很简单,但我们还是要分析下具体的流程,源码如下所示:

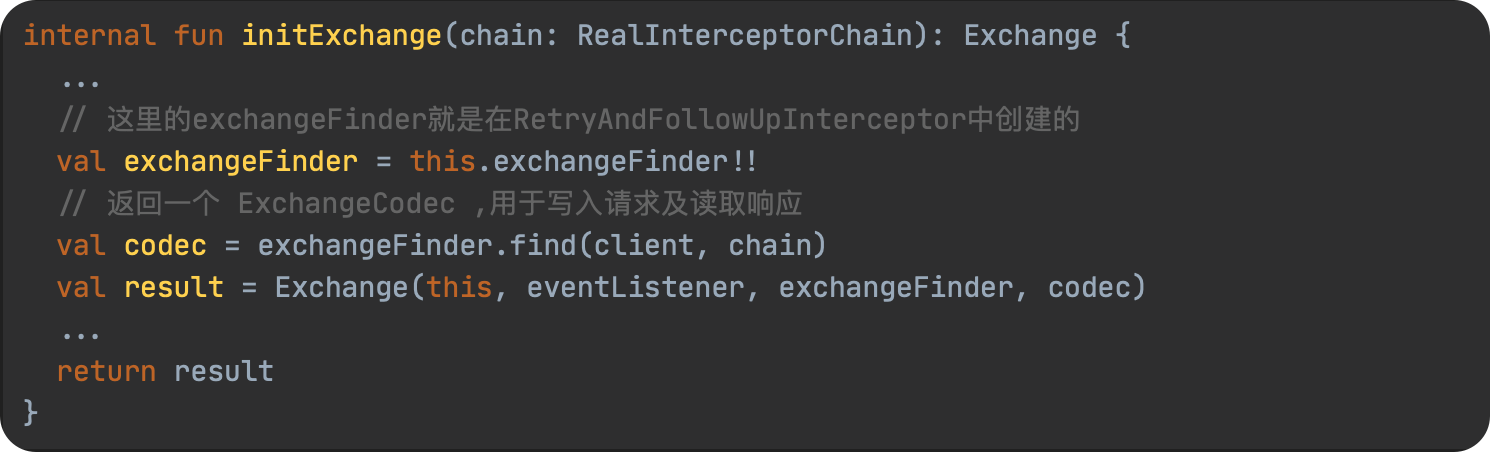

RealCall.initExchange()

初始化 Exchage 的过程。

从 ExchangeFinder 找到一个新的或者已经存在的 ExchangeCodec,然后初始化 Exchange ,以此来承载接下来的HTTP请求和响应对。

ExchangeFinder.find()

查找 ExchangeCodec(请求响应编码器) 的过程。

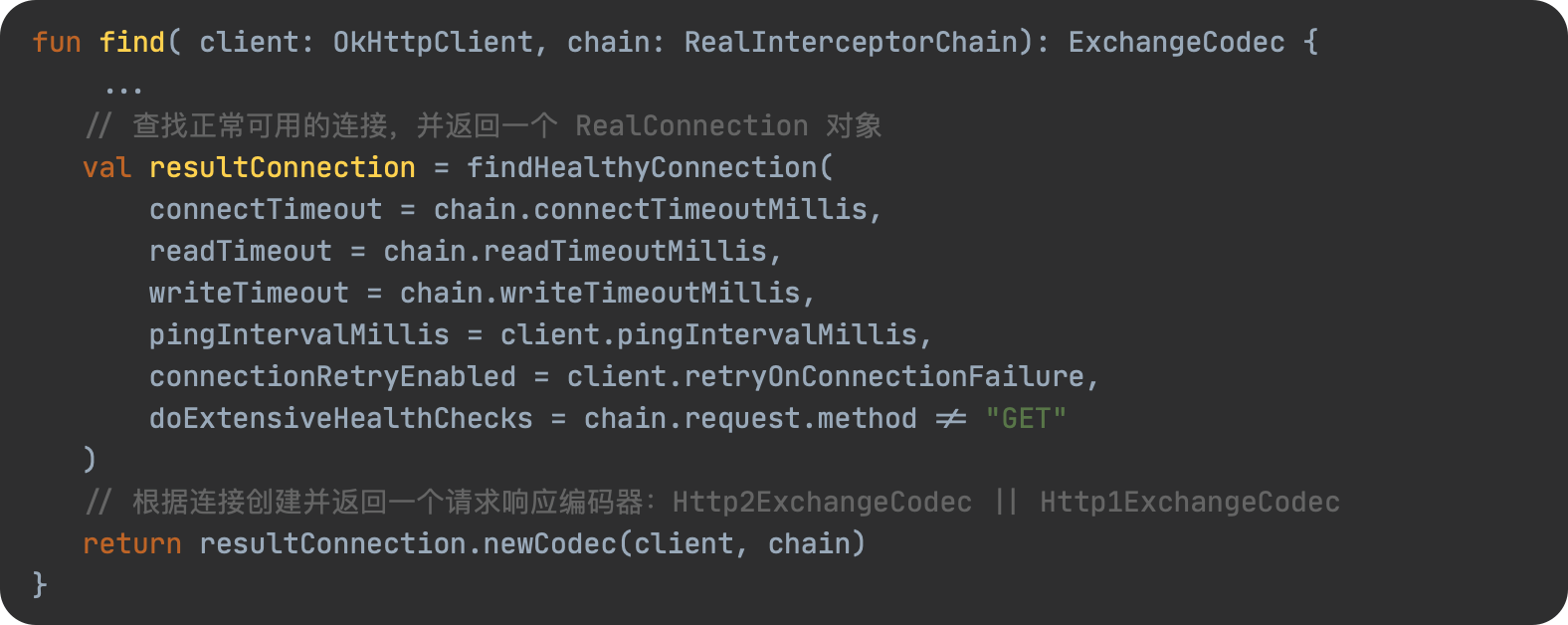

接下来我们看看查找 RealConnection 的具体过程:

上述的整个流程如下:

上述会先通过 ExchangeFinder 去 RealConnecionPool 中尝试寻找已经存在的连接,未找到则会重新创建一个 RealConnection(连接) 对象,并将其添加到连接池里,开始连接。然后根据找到或者新创建 RealConnection 对象,并根据当前请求协议创建不同的 ExchangeCodec 对象并返回,最后初始化一个 Exchange 交换器并返回,从而实现了 Exchange 的初始化过程。

在具体找寻 RealConnection 的过程中,一共尝试了5次,具体如下:

- 尝试重连

call中的connection,此时不需要重新获取连接; - 尝试从连接池中获取一个连接,不带路由与多路复用;

- 再次尝试从连接池中获取一个连接,带路由,不带多路复用;

- 手动创建一个新连接;

- 再次尝试从连接池中获取一个连接,带路由与多路复用;

当 Exchange 初始化完成后,再复制该对象创建一个新的 Exchange ,并执行下一个责任链,从而完成连接的建立。

networkInterceptors

网络拦截器,即 client.networkInterceptors 中自定义拦截器,与普通的拦截器 client.interceptors 不同的是:

由于网络拦截器处于倒数第二层,在 RetryAndFollowUpInterceptor 失败或者 CacheInterceptor 返回缓存的情况下,网络拦截器无法被执行。而普通拦截器由于第一步就被就执行到,所以不受这个限制。

CallServerInterceptor

链中的最后一个拦截器,也即与服务器进行通信的拦截器,利用 HttpCodec 进行数据请求、响应数据的读写。

具体源码如下:

先写入要发送的请求头,然后根据条件判断是否写入要发送的请求体。当请求结束后,解析服务器返回的响应头,构建一个新的 response 并返回;如果 response.code 为 100,则重新读取响应体并构建新的 response。因为这是最底层的拦截器,所以这里肯定不会再调用 proceed() 再往下执行。

小结

至此,关于 OkHttp 的分析,到这里就结束了。为了便于理解,我们再串一遍整个思路:

在 OkHttp 中,RealCall 是 Call 的实现类,其负责 执行网络请求 。其中,请求 request 由 Dispatcher 进行调度,其中 异步调用 时,会将请求放到到线程池中去执行; 而同步的请求则只是会添加到 Dispatcher 中去管理,并不会有线程池参与协调执行。

在具体的请求过程中,网络请求依次会经过下列拦截器组成的责任链,最后发送到服务器。

- 普通拦截器,

client.interceptors(); - 重试、重定向拦截器

RetryAndFollowUpInterceptor; - 用于客户端与服务器桥梁,将用户请求转换为服务器请求,将服务器响应转换为用户响应的的

BridgeInterceptor; - 决定是否需要请求服务器并写入缓存再返回还是直接返回服务器响应缓存的

CacheInterceptor; - 与服务器建立连接的

ConnectInterceptor; - 网络拦截器,

client.networkInterceptors(); - 执行网络请求的

CallServerInterceptor;

而相应的服务器响应体则会从 CallServerInterceptor 开始依次往前开始返回,最后由客户端进行处理。

需要注意的是,当我们

RetryAndFollowUpInterceptor异常或者CacheInterceptor拦截器直接返回了有效缓存,后续的拦截器将不会执行。

常见问题

OkHttp如何判断缓存有效性?

这里其实主要说的是 CacheInterceptor 拦截器里的逻辑,具体如下:

OkHttp 使用 HTTP协议 中的 缓存控制机制 来判断缓存是否有效。如果请求头中包含 "Cache-Control" 和 "If-None-Match" / "If-Modified-Since" 字段,OkHttp 将根据这些字段的值来决定是否使用缓存或从网络请求响应。

Cache-Control指 包含缓存控制的指令,例如 "no-cache" 和 "max-age" ;

If-None-Match指 客户端缓存的响应的ETag值,如果服务器返回相同的 ETag 值,则说明响应未修改,缓存有效;

If-Modified-Since指 客户端缓存的响应的最后修改时间,如果服务器确定响应在此时间后未更改,则返回304 Not Modified状态码,表示缓存有效。

相应的,OkHttp 也支持自定义缓存有效性控制,开发者可以创建一个 CacheControl 对象,并将其作为请求头添加到 Request 中,如下所示:

// 禁止OkHttp使用缓存

val cacheControl = CacheControl.Builder()

.noCache()

.build()

val request = Request.Builder()

.cacheControl(cacheControl)

.url("https://www.baidu.com")

.build()

复制代码OkHttp如何复用TCP连接?

这个其实主要说的是 ConnectInterceptor 拦截器中初始化 Exchange 时内部做的事,具体如下:

OkHttp 使用连接池 RealConnectionPool 管理所有连接,连接池将所有活动的连接存储在池中,并维护了一个空闲的连接列表(TaskQueue),当需要新的连接时,优先尝试从这个池中找,如果没找到,则 重新创建 一个 RealConnection 连接对象,并将其添加到连接池中。在具体的寻找连接的过程中,一共进行了下面5次尝试:

- 尝试重连

RealCall中的connection,此时不需要重新获取连接; - 尝试从连接池中获取一个连接,不带路由与多路复用;

- 再次尝试从连接池中获取一个连接,带路由,不带多路复用;

- 手动创建一个新连接;

- 再次尝试从连接池中获取一个连接,带路由与多路复用;

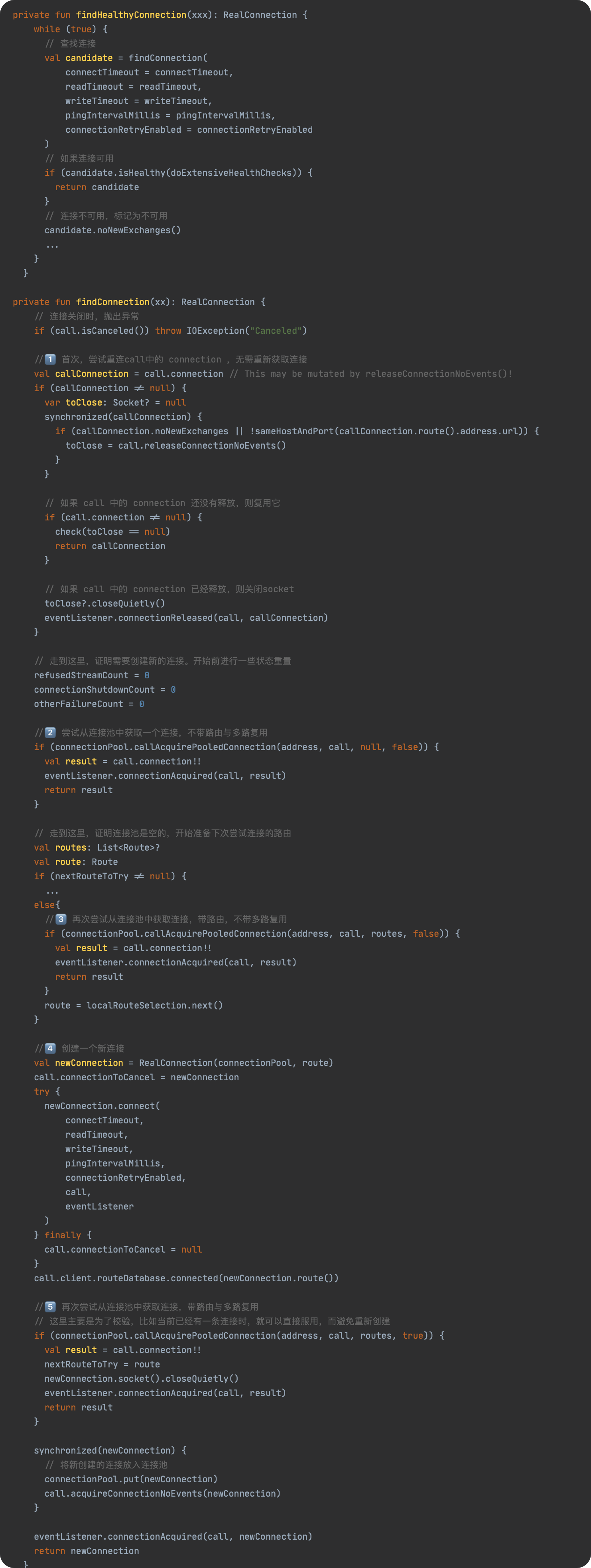

当然 OkHttp 也支持自定义连接池,具体如下:

上述代码中,创建了一个新的连接池,并设置其保留最多 maxIdleConnections 个空闲连接,并且连接的存活期为 keepAliveDuration 分钟。

OKHttp复用TCP连接的好处是什么?

OkHttp 是由连接池管理所有连接,通过连接池,从而可以限制连接的 最大数量,并且对于空闲的连接有相应的 存活期限 ,以便在长时间不使用后关闭连接。当请求结束时,并且将保留该连接,便于后续 复用 。从而实现了在多个请求之间共享连接,避免多次建立和关闭TCP连接的开销,提高请求效率。

OkHttp中的请求和响应 与 网络请求和响应,这两者有什么不同?

OkHttp 中的的请求和响应指的是客户端创建的请求对象 Request 和 服务端返回的响应对象 Response,这两个对象用于定义请求和响应的信息。网络请求和响应指的是客户端向服务端发送请求,服务端返回相应的过程。

总的来说就是,请求和响应是应用程序内部自己的事,网络请求和响应则是发生在网络上的请求和响应过程。

OkHttp 应用拦截器和网络拦截器的区别?

- 从调用方式上而言,应用拦截器指的是

OkhttpClient.intercetors,网络拦截器指的是OkHttpClient.netIntercetors。 - 从整个责任链的调用来看,应用拦截器一定会被执行一次,而网络拦截器不一定会执行或者执行多次情况,比如当我们

RetryAndFollowUpInterceptor异常或者CacheInterceptor拦截器直接返回了有效缓存,后续的拦截器将不会执行,相应的网络拦截器也自然不会执行到;当我们发生 错误重试 或者 网络重定向 时,网络拦截器此时可能就会执行多次。 - 其次,除了

CallServerInterceptor与CacheIntercerceptor缓存有效之外,每个拦截器都应该至少调用一次realChain.proceed()方法。但应用拦截器可以调用多次processed()方法,因为其在请求流程中是可以递归调用;而网络拦截器只能调用一次processed()方法,否则将导致请求重复提交,影响性能,另外,网络拦截器没有对请求做修改的可能性,因此不需要再次调用processed()方法。 - 从 使用方式的 本质而言,应用拦截器可以 拦截和修改请求和响应 ,但 不能修改网络请求和响应 。比如使用应用拦截器添加请求参数、缓存请求结果;网络拦截器可以拦截和修改网络请求和响应。例如使用网络拦截器添加请求头、修改请求内容、检查响应码等。

- 在相应的执行顺序上,网络拦截器是

先进先出(FIFO),应用拦截器是先进后出(FILO)的方式执行。

结语

本篇中,我们从网络库的迭代历史,一直到 OkHttp 的使用方式、设计思想、源码探索,最后又聊了聊常见的一些问题,从而较系统的了解了 OkHttp 的方方面面,也解释了 OkHttp应用层 的相关问题,当然这些问题我相信也仅仅只是冰山一角🧩。 更多面试相关,或者实际问题,仍需要我们自己再进行完善,从而形成全面的透析力。

这篇文章断断续续写了将近两周,其中肯定有不少部分存在缺陷或者逻辑漏洞,如果您发现了,也可以告诉我。

通过这篇文章,于我个人而言,也是完成了对于 OkHttp应用层 一次较系统的了解,从而也完善了知识拼图中重要的一块,期待作为读者的你也能有如此或者更深的体会。🏃🏻

更多

这是 解码系列 - OkHttp 篇,如果你觉得这个系列写的还不错,不妨点个关注催更一波,当然也可以看看其他篇:

参阅

链接:https://juejin.cn/post/7199431845367922745

来源:稀土掘金

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Android电量优化,让你的手机续航更持久

节能减排,从我做起。一款Android应用如果非常耗电,是一定会被主人嫌弃的。自从Android手机的主人用了你开发的app,一天下来,也没干啥事,电就没了。那么他就会想尽办法找出耗电量杀手,当他找出后,很有可能你开发的app就被无情的卸载了。为了避免这种事情发生,我们就要想想办法让我们的应用不那么耗电,电都用在该用的时候和地方。

通过power_profile.xml查看各个手机硬件的耗电量

Google要求手机硬件生产商都要放入power_profile.xml文件到ROM里面。有些不太负责的手机生产商,就乱配,也没有真正测试过。但我们还是可以大概知道耗电的硬件都有哪些。

先从ibotpeaches.github.io/Apktool/ 下载apktool反编译工具,然后执行adb命令,将手机framework的资源apk拉取出来。

adb pull /system/framework/framework-res.apk ./然后我们用下载好的反编译工具,将framework-res.apk进行反编译。

java -jar apktool_2.7.0.jar d framework-res.apkapktool_2.7.0.jar换成你下载的具体的jar包名称。 power_profile.xml文件的目录如下:

framework-res/res/xml/power_profile.xml

<?xml version="1.0" encoding="utf-8"?>

<device name="Android">

<item name="ambient.on">0.1</item>

<item name="screen.on">0.1</item>

<item name="screen.full">0.1</item>

<item name="bluetooth.active">0.1</item>

<item name="bluetooth.on">0.1</item>

<item name="wifi.on">0.1</item>

<item name="wifi.active">0.1</item>

<item name="wifi.scan">0.1</item>

<item name="audio">0.1</item>

<item name="video">0.1</item>

<item name="camera.flashlight">0.1</item>

<item name="camera.avg">0.1</item>

<item name="gps.on">0.1</item>

<item name="radio.active">0.1</item>

<item name="radio.scanning">0.1</item>

<array name="radio.on">

<value>0.2</value>

<value>0.1</value>

</array>

<array name="cpu.active">

<value>0.1</value>

</array>

<array name="cpu.clusters.cores">

<value>1</value>

</array>

<array name="cpu.speeds.cluster0">

<value>400000</value>

</array>

<array name="cpu.active.cluster0">

<value>0.1</value>

</array>

<item name="cpu.idle">0.1</item>

<array name="memory.bandwidths">

<value>22.7</value>

</array>

<item name="battery.capacity">1000</item>

<item name="wifi.controller.idle">0</item>

<item name="wifi.controller.rx">0</item>

<item name="wifi.controller.tx">0</item>

<array name="wifi.controller.tx_levels" />

<item name="wifi.controller.voltage">0</item>

<array name="wifi.batchedscan">

<value>.0002</value>

<value>.002</value>

<value>.02</value>

<value>.2</value>

<value>2</value>

</array>

<item name="modem.controller.sleep">0</item>

<item name="modem.controller.idle">0</item>

<item name="modem.controller.rx">0</item>

<array name="modem.controller.tx">

<value>0</value>

<value>0</value>

<value>0</value>

<value>0</value>

<value>0</value>

</array>

<item name="modem.controller.voltage">0</item>

<array name="gps.signalqualitybased">

<value>0</value>

<value>0</value>

</array>

<item name="gps.voltage">0</item>

</device>抓到不负责任的手机生产商一枚,好家伙,这么多0.1,明眼人一看就知道这是为了应付Google。尽管这样,我们还是可以从中知道,耗电的有Screen(屏幕亮屏)、Bluetooth(蓝牙)、Wi-Fi(无线局域网)、Audio(音频播放)、Video(视频播放)、Radio(蜂窝数据网络)、Camera的Flashlight(相机闪光灯)和GPS(全球定位系统)等。

电量杀手简介

Screen

屏幕是非常耗电的一个硬件,不要问我为什么。屏幕主要有LCD和OLED两种。LCD屏幕白色光线从屏幕背后的灯管发出,尽管屏幕显示黑屏,依旧耗电,这种屏幕逐渐被淘汰,如果你翻出个早点的功能机,或许能看到。那么大部分Android手机都是OLED的屏幕,每个像素点都是独立的发光单元,屏幕黑屏时,所有像素都不发光。有必要时,让屏幕息屏很重要,当然手机也有自动息屏的时间设置,这个不太需要我们操心。

Radio数据网络和Wi-Fi无线网络

网络也是非常耗电的,其中又以数据网络的耗电更多于Wi-Fi的耗电。所以请尽量引导用户使用Wi-Fi网络使用app的部分功能,比如下载文件。

GPS

GPS也是很耗电的硬件,所以不要动不动就请求地理位置,GPS平常是要关闭的,除非你在使用定位和导航等功能,这样你的手机续航会更好。

WakeLock

如果使用了WakeLock,是可以有效防止息屏情况下的CPU休眠,但是如果不用了,你不释放掉锁的话,则会带来很大的电量的开销。

查看手机耗电的历史记录

// 上次拔掉电源到现在的耗电情况

adb shell dumpsys batterystats --unplugged你在逗我?让我看命令行的输出?后面我们来使用Battery Historian的图表进行分析。

使用Battery Historian分析手机耗电量

安装Docker

Docker下载网址 docs.docker.com/desktop/ins…

使用Docker容器编排

docker run -p 9999:9999 gcr.io/android-battery-historian/stable:3.0 --port 9999获取bugreport文件

Android7.0及以上

adb bugreport bugreport.zipAndroid6.0及以下

adb bugreport > bugreport.txt上传bugreport文件进行分析

在浏览器地址栏输入http://localhost:9999

点击Browse按钮并上传bugreport.zip或bugreport.txt生成分析图表。

我们可以通过时间轴来分析应用当下的电池使用情况,比较耗电的是哪部分硬件。

使用JobScheduler来合理执行后台任务

JobScheduler是Android5.0版本推出的API,允许开发者在符合某些条件时创建执行在后台的任务。比如接通电源的情况下才执行某些耗电量大的操作,也可以把一些不紧急的任务在合适的时候批量处理,还可以避开低电量的情况下执行某些任务。

作者:dora

来源:juejin.cn/post/7196321890301575226

安卓开发基础——弱引用的使用

前言

起因

今天开发遇到一个问题,就是在快速点击带点击事件的控件,如果控件里面写的是Dialog弹窗就有概率出现弹窗连续在界面上出现两次,也就是你关闭弹窗后发现还有一个一样的弹窗在界面,这样就会带来不好的体验。

结果

2月9日

在网上查了许多解决方法,就有提到将该Dialog变成类的成员变量,不用每次都new就可能避免这种情况出现,但我着实不清楚为什么以及具体怎么做,于是请教了组里的大哥,大哥和我说他之前也处理过这种问题,使用了弱引用,可我还是不知道具体的实现方式,于是便找到大哥的代码,并在网上了解了弱引用的具体作用。

2月10日

今天我请教了我们掘金开发群的Java大佬,他告诉我,我这个写法仍然避免不了弹两次Dialog的,并给出意见,可以使用共享状态,推荐我创建一个共享的ReentrantLock,不过我还没去实现,等有时间再看看。

下面就让我们看看弱引用到底是什么。

正篇

弱引用的概念

想知道弱引用,那就得知道几个名词:

强引用

软引用

弱引用

虚引用

首先我们来看看这些词的概念:

强引用

强引用(StrongReference):最传统的“引用”的定义,是指在程序代码之中普遍存在的引用赋值,即类似“Object obj = new Object()”这种引用关系。无论任何情况下,只要强引用关系还存在,垃圾收集器就永远不会回收掉被引用的对象。

软引用

软引用(SoftReference):在系统将要发生内存溢出之前,将会把这些对象列入回收范围之中进行第二次回收。如果这次回收后还没有足够的内存,才会抛出内存流出异常。

弱引用

弱引用(WeakReference):被弱引用关联的对象只能生存到下一次垃圾收集之前。当垃圾收集器工作时,无论内存空间是否足够,都会回收掉被弱引用关联的对象。

虚引用

虚引用(PhantomReference):一个对象是否有虚引用的存在,完全不会对其生存时间构成影响,也无法通过虚引用来获得一个对象的实例。为一个对象设置虚引用关联的唯一目的就是能在这个对象被收集器回收时收到一个系统通知。

以上定义都是参考自知乎回答 :强引用、软引用、弱引用、虚引用有什么区别?具体使用场景是什么? - 知乎 (zhihu.com),从这我们可以了解到其实我们Java中new对象就是强引用,强引用的对象是可触及的,垃圾收集器就永远不会回收掉被引用的对象,也就简而言之对象在引用时,不回收,上面说的文章中也举例说明了强引用的特点:

而我们本篇说的弱引用,则是发现即回收,它通常是用来描述那些非必需对象,只被弱引用关联的对象只能生存到下一次垃圾收集发生为止。在系统GC时,只要发现弱引用,不管系统堆空间使用是否充足,都会回收掉只被弱引用关联的对象。

但是,又因为垃圾回收器的线程通常优先级很低,所以,一般并不一定能很快地发现持有弱引用的对象,而在这种情况下,弱引用对象就可以存在较长的时间。

而如何使用弱引用,我们接着往下看:

使用方法

前言提到我们使用了弱引用在开发中大哥已经使用过,所以我就跟着后面仿写一下就好,而知乎的那篇文章也提到:

这就基本是弱引用的定义方法,因为之前前言说的Dialog问题弱引用并没有真正起效果,所以我们换一种方法去展示他在安卓上的使用,那就是在使用Bitmap时防止OOM,写法如下:

ImageView imageView = findViewById(R.id.vImage);

Bitmap bitmap = BitmapFactory.decodeResource(getResources(),R.drawable.ic_launcher_background);

Drawable drawable = new BitmapDrawable(getResources(), bitmap);

WeakReference<Drawable> weakDrawable = new WeakReference<>(drawable);

Drawable bgDrawable = weakDrawable.get();

if(bgDrawable != null) {

imageView.setBackground(drawable);

}我们再对比一下普通的强引用方法:

ImageView imageView = findViewById(R.id.vImage);

Bitmap bitmap = BitmapFactory.decodeResource(getResources(),R.drawable.ic_launcher_background);

Drawable drawable = new BitmapDrawable(getResources(), bitmap);

imageView.setBackground(drawable);其实,就是对drawable对象从强引用转为弱引用,这样一旦出现内存不足,不会直接去使用drawable对象,让JVM自动回收这些缓存图片对象所占用的空间,从而有效地避免了OOM的问题。

总结

其实这块内容需要对GC机制很熟悉,我不是很熟,所以使用可能也出现不对,希望读者可以积极指正,谢谢观看!

作者:ObliviateOnline

来源:juejin.cn/post/7198519499867815997

Flutter Android多窗口方案落地(下)

插件层封装。插件层就很简单了,创建好

MethodCallHandler之后,直接持有单例的EngineManager就可以了。

class FlutterMultiWindowsPlugin : FlutterPlugin, MethodCallHandler {

companion object {

private const val TAG = "MultiWindowsPlugin"

}

• @SuppressLint("LongLogTag")

• override fun onAttachedToEngine(@NonNull flutterPluginBinding: FlutterPlugin.FlutterPluginBinding) {

• Log.i(TAG, "onMessage: onAttachedToEngine")

• Log.i(TAG, "onAttachedToEngine: ${Thread.currentThread().name}")

• MessageHandle.init(flutterPluginBinding.applicationContext)

• MethodChannel(

• flutterPluginBinding.binaryMessenger,

• "flutter_multi_windows.messageChannel",

• ).setMethodCallHandler(this)

• }

• override fun onDetachedFromEngine(@NonNull binding: FlutterPlugin.FlutterPluginBinding) {

• Log.i(TAG, "onDetachedFromEngine: ${Thread.currentThread().name}")

• }

• override fun onMethodCall(call: MethodCall, result: MethodChannel.Result) {

• Log.i(TAG, "onMethodCall: thread : ${Thread.currentThread().name}")

• MessageHandle.onMessage(call, result)

• }

}

@SuppressLint("StaticFieldLeak")

internal object MessageHandle {

private const val TAG = "MessageHandle"

• private var context: Context? = null

• private var manager: EngineManager? = null

• fun init(context: Context) {

• this.context = context

• if (manager != null)

• return

• // 必须单例调用

• manager = EngineManager.getInstance(this.context!!)

• }

• // 处理消息,所有管道通用。需要共享Flutter Activity

• fun onMessage(

• call: MethodCall, result: MethodChannel.Result

• ) {

• val params = call.arguments as Map<*, *>

• when (call.method) {

• "open" -> {

• Log.i(TAG, "onMessage: open")

• val map: HashMap<String, Any> = HashMap()

• map["needShowWindow"] = true

• map["name"] = params["name"] as String

• map["entryPoint"] = params["entryPoint"] as String

• map["width"] = (params["width"] as Double).toInt()

• map["height"] = (params["height"] as Double).toInt()

• map["gravityX"] = params["gravityX"] as Int

• map["gravityY"] = params["gravityY"] as Int

• map["paddingX"] = params["paddingX"] as Double

• map["paddingY"] = params["paddingY"] as Double

• map["draggable"] = params["draggable"] as Boolean

• map["type"] = params["type"] as String

• if (params["params"] != null) {

• map["params"] = params["params"] as ArrayList<String>

• }

• result.success(manager?.showWindow(map, object : EngineCallback {

• override fun onEngineDestroy(id: String) {

• }

• }))

• }

• "close" -> {

• val windowId = params["windowId"] as String

• manager?.dismissWindow(windowId)

• }

• "executeTask" -> {

• Log.i(TAG, "onMessage: executeTask")

• val map: HashMap<String, Any> = HashMap()

• map["name"] = params["name"] as String

• map["entryPoint"] = params["entryPoint"] as String

• map["type"] = params["type"] as String

• result.success(manager?.executeTask(map))

• }

• "finishTask" -> {

• manager?.finishTask(params["taskId"] as String)

• }

• "setPosition" -> {

• val res = manager?.setPosition(

• params["windowId"] as String,

• params["x"] as Int,

• params["y"] as Int

• )

• result.success(res)

• }

• "setAlpha" -> {

• val res = manager?.setAlpha(

• params["windowId"] as String,

• (params["alpha"] as Double).toFloat(),

• )

• result.success(res)

• }

• "resize" -> {

• val res = manager?.resetWindowSize(

• params["windowId"] as String,

• params["width"] as Int,

• params["height"] as Int

• )

• result.success(res)

• }

• else -> {

• }

• }

• }

}

同时需要清楚,Engine通过传入的entryPoint,就可以找到Flutter层中的方法入口点,在入口点中runApp即可。

实现过程中的坑

在实现过程中我们遇到的值得分享的坑,就是Flutter GestureDetector和Window滑动事件的冲突。 由于悬浮窗是需要可滑动的,因此在原生层需要监听对应的事件;而Flutter的事件,是Android层分发给FlutterView的,两者形成冲突,导致Flutter内部滑动的时候,原生层也会捕获到,最终造成冲突。

如何解决?

从需求上来看,悬浮窗是否需要滑动,应该交给调用方决定,也就是由Flutter层来决定是否Android是否要对Flutter的滑动事件进行监听,即flutterView.setOnTouchListener。这里我们使用一种更轻量级的操作,FlutterView的监听默认加上,然后在事件处理中,我们通过变量来做处理;而Flutter通过MethodChannel改变这个变量,加快了通信速度,避免了事件来回监听和销毁。

flutterView.setOnTouchListener { _, event ->

when (event.action) {

MotionEvent.ACTION_MOVE -> {

if (dragging) {

setPosition(

initialX + (event.rawX - startX).roundToInt(),

initialY + (event.rawY - startY).roundToInt()

)

}

}

MotionEvent.ACTION_UP -> {

dragEnd()

}

MotionEvent.ACTION_DOWN -> {

startX = event.rawX

startY = event.rawY

initialX = layoutParams.x

initialY = layoutParams.y

dragStart()

windowManager.updateViewLayout(rootView, layoutParams)

}

}

false

}dragging则是通过Flutter层去驱动的:FlutterMultiWindowsPlugin().dragStart();

private fun dragStart() {

dragging = true

}

private fun dragEnd() {

dragging = false

}使用方式

目前我们内部已在4个应用落地了这个方案。应用方式有两种:一种是Flutter通过插件调用,也可以直接通过后台Service打开。效果尚佳,目的都是为了让Flutter的UI跨端使用。

另外,Flutter的方法入口点必须声明@pragma('vm:entry-point')。

写在最后

目前来看这种方式可以完美支持Flutter在Android上开启多窗口,且能精准控制。但由于一个engine对应一个窗口,过多engine带来的内存隐患还是不可忽视的。我们希望Flutter官方能尽快的支持engine对应多个入口点,并且共享内存,只不过目前来看还是有点天方夜谭~~

这篇文章,需要有一定原生基础的同学才能看懂。只讲基础原理,代码不全,仅供参考! 另外多窗口的需求,不知道大家需求量如何,热度可以的话我再出个windows的多窗口实现!

作者:Karl_wei

来源:juejin.cn/post/7198824926722949179

Flutter Android多窗口方案落地(上)

前言

Flutter在桌面端的多窗口需求,一直是个历史巨坑。随着Flutter的技术在我们windows、android桌面设备落地,我们发现多窗口需求必不可少,突破这个技术壁垒已经刻不容缓。

实现原理

1. 基本原理

对于Android移动设备来说,多窗口的应用大多是用于直播/音视频的悬浮弹窗,让用户离开应用后还能在小窗口中观看内容。实现原理是通过WindowManager创建和管理窗口,包括视图内容、拖拽、事件等操作。

我们都清楚Flutter只是一个可以做业务逻辑的UI框架,在Flutter中想要实现多窗口,也必须依赖Android的窗口管理机制。基于原生的Window,显示Flutter绘制的UI,从而实现跨平台的视图交互和业务逻辑。

2. 具体步骤

Android端基于Window Manager创建Window,管理窗口的生命周期和拖拽逻辑;使用FlutterEngineGroup来管理Flutter Engine,通过引擎吸附Flutter的UI,加入到原生的FlutterView;把FlutterView通过addView的方式加入到Window上。

3. 原理图

插件实现

基于上述原理,可以在Android的窗口显示Flutter的UI。但要真正提供给Flutter层使用,还需要再封装一个插件层。

通过单例管理多个窗口 由于是多窗口,可能项目中多个地方都会调用到,因此需要使用单例来统一管理所有窗口的生命周期,保证准确创建、及时销毁。

//引擎生命钩子回调,让调用方感知引擎状态

interface EngineCallback {

fun onCreate(id:String)

fun onEngineDestroy(id: String)

}

class EngineManager private constructor(context: Context) {

// 单例对象

companion object :

SingletonHolder<EngineManager, Context>(::EngineManager)

// 窗口类型;如果是单一类型,那么同名窗口将返回上一次的未销毁的实例。

private val TYPE_SINGLE: String = "single"

init {

Log.d("EngineManager", "EngineManager init")

}

data class Entry(

val engine: FlutterEngine,

val window: AndroidWindow?

)

private var myContext: Context = context

private var engineGroup: FlutterEngineGroup = FlutterEngineGroup(myContext)

// 每个窗口对应一个引擎,基于引擎ID和名称存储多窗口的信息,以及查找

private val engineMap = ConcurrentHashMap<String, Entry>() //搜索引擎,用作消息分发

private val name2IdMap = ConcurrentHashMap<String, String>() //判断是否存在了任务

private val id2NameMap = ConcurrentHashMap<String, String>() //根据任务获取name并清除

private val engineCallback =

ConcurrentHashMap<String, EngineCallback>() //通知调用方引擎状态 0-create 1-attach 2-destroy

fun showWindow(

params: HashMap<String, Any>,

engineStatusCallback: EngineCallback

): String? {

val entry: String?

if (params.containsKey("entryPoint")) {

entry = params["entryPoint"] as String

} else {

return null

}

val name: String?

if (params.containsKey("name")) {

name = params["name"] as String

} else {

return null

}

val type = params["type"]

if (type == TYPE_SINGLE && name2IdMap[name] != null) {

return name2IdMap[name]

}

val windowUid = UUID.randomUUID().toString()

if (type == TYPE_SINGLE) {

name2IdMap[name] = windowUid

id2NameMap[windowUid] = name

engineCallback[windowUid] = engineStatusCallback

}

val dartEntrypoint = DartExecutor.DartEntrypoint(findAppBundlePath(), entry)

val args = mutableListOf(windowUid)

var user: List<String>? = null

if (params.containsKey("params")) {

user = params["params"] as List<String>

}

if (user != null) {

args.addAll(user)

}

// 把调用方传递的参数回调给Flutter

val option =

FlutterEngineGroup.Options(myContext).setDartEntrypoint(dartEntrypoint)

.setDartEntrypointArgs(

args

)

val engine = engineGroup.createAndRunEngine(option)

val draggable = params["draggable"] as Boolean? ?: true

val width = params["width"] as Int? ?: 0

val height = params["height"] as Int? ?: 0

val config = GravityConfig()

config.paddingX = params["paddingX"] as Double? ?: 0.0

config.paddingY = params["paddingY"] as Double? ?: 0.0

config.gravityX = GravityForX.values()[params["gravityX"] as Int? ?: 1]

config.gravityY = GravityForY.values()[params["gravityY"] as Int? ?: 1]

// 把创建好的引擎传给AndroidWindow,由其去创建窗口

val androidWindow =

AndroidWindow(myContext, draggable, width, height, config, engine)

engineMap[windowUid] = Entry(engine, androidWindow)

androidWindow.open()

engine.platformViewsController.attach(

myContext,

engine.renderer,

engine.dartExecutor

)

return windowUid

}

fun setPosition(id: String?, x: Int, y: Int): Boolean {

id ?: return false

val entry = engineMap[id]

entry ?: return false

entry.window?.setPosition(x, y)

return true

}

fun setSize(id: String?, width: double, height: double): Boolean {

// ......

}

}通过代码我们可以看到,每个窗口都对应一个engine,通过name和生成的UUID做唯一标识,然后把engine传给AndroidWindow,在那里加入WindowManger,以及Flutter UI的获取。

AndroidWindow的实现;通过

context.getSystemService(Service.WINDOW_SERVICE) as WindowManager获取窗口管理器;同时创建FlutterView和LayoutInfalter,通过engine拿到视图吸附到FlutterView,把FlutterView加到Layout中,最后把Layout通过addView加到WindowManager中显示。

class AndroidWindow(

private val context: Context,

private val draggable: Boolean,

private val width: Int,

private val height: Int,

private val config: GravityConfig,

private val engine: FlutterEngine

) {

private var startX = 0f

private var startY = 0f

private var initialX = 0

private var initialY = 0

private var dragging = false

private lateinit var flutterView: FlutterView

private var windowManager = context.getSystemService(Service.WINDOW_SERVICE) as WindowManager

private val inflater =

context.getSystemService(Service.LAYOUT_INFLATER_SERVICE) as LayoutInflater

private val metrics = DisplayMetrics()

@SuppressLint("InflateParams")

private var rootView = inflater.inflate(R.layout.floating, null, false) as ViewGroup

private val layoutParams = WindowManager.LayoutParams(

dip2px(context, width.toFloat()),

dip2px(context, height.toFloat()),

WindowManager.LayoutParams.TYPE_SYSTEM_ALERT, // 系统应用才可使用此类型

WindowManager.LayoutParams.FLAG_NOT_FOCUSABLE,

PixelFormat.TRANSLUCENT

)

fun open() {

@Suppress("Deprecation")

windowManager.defaultDisplay.getMetrics(metrics)

layoutParams.gravity = Gravity.START or Gravity.TOP

selectMeasurementMode()

// 设置位置

val screenWidth = metrics.widthPixels

val screenHeight = metrics.heightPixels

when (config.gravityX) {

GravityForX.Left -> layoutParams.x = config.paddingX!!.toInt()

GravityForX.Center -> layoutParams.x =

((screenWidth - layoutParams.width) / 2 + config.paddingX!!).toInt()

GravityForX.Right -> layoutParams.x =

(screenWidth - layoutParams.width - config.paddingX!!).toInt()

null -> {}

}

when (config.gravityY) {

GravityForY.Top -> layoutParams.y = config.paddingY!!.toInt()

GravityForY.Center -> layoutParams.y =

((screenHeight - layoutParams.height) / 2 + config.paddingY!!).toInt()

GravityForY.Bottom -> layoutParams.y =

(screenHeight - layoutParams.height - config.paddingY!!).toInt()

null -> {}

}

windowManager.addView(rootView, layoutParams)

flutterView = FlutterView(inflater.context, FlutterSurfaceView(inflater.context, true))

flutterView.attachToFlutterEngine(engine)

if (draggable) {

@Suppress("ClickableViewAccessibility")

flutterView.setOnTouchListener { _, event ->

when (event.action) {

MotionEvent.ACTION_MOVE -> {

if (dragging) {

setPosition(

initialX + (event.rawX - startX).roundToInt(),

initialY + (event.rawY - startY).roundToInt()

)

}

}

MotionEvent.ACTION_UP -> {

dragEnd()

}

MotionEvent.ACTION_DOWN -> {

startX = event.rawX

startY = event.rawY

initialX = layoutParams.x

initialY = layoutParams.y

dragStart()

windowManager.updateViewLayout(rootView, layoutParams)

}

}

false

}

}

@Suppress("ClickableViewAccessibility")

rootView.setOnTouchListener { _, event ->

when (event.action) {

MotionEvent.ACTION_DOWN -> {

layoutParams.flags =

layoutParams.flags or WindowManager.LayoutParams.FLAG_NOT_FOCUSABLE

windowManager.updateViewLayout(rootView, layoutParams)

true

}

else -> false

}

}

engine.lifecycleChannel.appIsResumed()

rootView.findViewById<FrameLayout>(R.id.floating_window)

.addView(

flutterView,

ViewGroup.LayoutParams(

ViewGroup.LayoutParams.MATCH_PARENT,

ViewGroup.LayoutParams.MATCH_PARENT

)

)

windowManager.updateViewLayout(rootView, layoutParams)

}

// .....续:Flutter Android多窗口方案落地(下)

作者:Karl_wei

来源:juejin.cn/post/7198824926722949179

AndroidQQ登录接入详细介绍

一、前言

由于之前自己项目的账号系统不是非常完善,所以考虑接入QQ这个强大的第三方平台的接入,目前项目暂时使用QQ登录的接口进行前期的测试,这次从搭建到完善花了整整两天时间,不得不吐槽一下QQ互联的官方文档,从界面就可以看出了,好几年没维修了,示例代码也写的不是很清楚,翻了好多源代码和官方的demo,这个demo可以作为辅助参考,官方文档的api失效了可以从里面找相应的替代,但它的代码也太多了,一个demo 一万行代码,心累,当时把demo弄到可以运行就花了不少时间,很多api好像是失效了,笔者自己做了一些处理和完善,几乎把sdk功能列表的登录相关的api都尝试了一下,真的相当的坑,正文即将开始,希望这篇文章能够给后来者一些参考和帮助。

二、环境配置

1.获取应用ID

这个比较简单,直接到QQ互联官网申请一个即可,官网地址

https://connect.qq.com申请应用的时候需要注意应用名字不能出现违规词汇,否则可能申请不通过

应用信息的填写需要当前应用的包名和签名,这个腾讯这边提供了一个获取包名和签名的app供我们开发者使用,下载地址

https://pub.idqqimg.com/pc/misc/files/20180928/c982037b921543bb937c1cea6e88894f.apk未通过审核只能使用调试的QQ号进行登录,通过就可以面向全部用户了,以下为审核通过的图片

2.官网下载相关的sdk

下载地址

https://tangram-1251316161.file.myqcloud.com/qqconnect/OpenSDK_V3.5.10/opensdk_3510_lite_2022-01-11.zip推荐直接下载最新版本的,不过着实没看懂最新版本的更新公告,说是修复了retrofit冲突的问题,然后当时新建的项目没有用,结果报错,最后还是加上了,才可以

3. jar的引入

将jar放入lib包下,然后在app 同级的 build.gradle添加以下代码即完成jar的引用

dependencies {

...

implementation fileTree(dir: 'libs', include: '*.jar')

...

}4.配置Manifest

在AndroidManifest.xml中的application结点下增加以下的activity和启动QQ应用的声明,这两个activity无需我们在另外创建文件,引入的jar已经处理好了

<application

...

<!--这里的权限为开启网络访问权限和获取网络状态的权限,必须开启,不然无法登录-->

<uses-permission android:name="android.permission.INTERNET" />

<uses-permission android:name="android.permission.ACCESS_NETWORK_STATE" />

<activity

android:name="com.tencent.tauth.AuthActivity"

android:exported="true"

android:launchMode="singleTask"

android:noHistory="true">

<intent-filter>

<action android:name="android.intent.action.VIEW" />

<category android:name="android.intent.category.DEFAULT" />

<category android:name="android.intent.category.BROWSABLE" />

<data android:scheme="tencent你的appId" />

</intent-filter>

</activity>

<activity

android:name="com.tencent.connect.common.AssistActivity"

android:configChanges="orientation|keyboardHidden"

android:screenOrientation="behind"

android:theme="@android:style/Theme.Translucent.NoTitleBar" />

<provider

android:name="androidx.core.content.FileProvider"

android:authorities="com.tencent.login.fileprovider"

android:exported="false"

android:grantUriPermissions="true">

<meta-data

android:name="android.support.FILE_PROVIDER_PATHS"

android:resource="@xml/file_paths" />

</provider>

...

</application>上面的哪个代码的最后提供了一个provider用于访问 QQ 应用的,需要另外创建一个 xml 文件,其中的 authorities 是自定义的名字,确保唯一即可,这边最下面那个provider是翻demo找的,文档没有写,在res文件夹中新增一个包xml,里面添加文件名为file_paths的 xml ,其内容如下

<?xml version="1.0" encoding="utf-8"?>

<paths>

<external-files-path name="opensdk_external" path="Images/tmp"/>

<root-path name="opensdk_root" path=""/>

</paths>三、初始化配置

1.初始化SDK

加入以下代码在创建登录的那个activtiy下,不然无法拉起QQ应用的登录界面,至于官方文档所说的需要用户选择是否授权设备的信息的说明,这里通用的做法是在应用内部声明一个第三方sdk的列表,然后在里面说明SDK用到的相关设备信息的权限

Tencent.setIsPermissionGranted(true, Build.MODEL)2.创建实例

这部分建议放在全局配置,这样可以实现登录异常强制退出等功能

/**

* 其中APP_ID是申请到的ID

* context为全局context

* Authorities为之前provider里面配置的值

*/

val mTencent = Tencent.createInstance(APP_ID, context, Authorities)3.开启登录

在开启登录之前需要自己创建一个 UIListener 用来监听回调结果(文档没讲怎么创建的,找了好久的demo)这里的代码为基础的代码,比较容易实现,目前还没写回调相关的代码,主要是为了快速展示效果

open class BaseUiListener(private val mTencent: Tencent) : DefaultUiListener() {

private val kv = MMKV.defaultMMKV()

override fun onComplete(response: Any?) {

if (response == null) {

"返回为空,登录失败".showToast()

return

}

val jsonResponse = response as JSONObject

if (jsonResponse.length() == 0) {

"返回为空,登录失败".showToast()

return

}

"登录成功".showToast()

doComplete(response)

}

private fun doComplete(values: JSONObject?) {

}

override fun onError(e: UiError) {

Log.e("fund", "onError: ${e.errorDetail}")

}

override fun onCancel() {

"取消登录".showToast()

}

}建立一个按钮用于监听,这里进行登录操作

button.setOnClickListener {

if (!mTencent.isSessionValid) {

//判断会话是否有效

when (mTencent.login(this, "all",iu)) {

//下面为login可能返回的值的情况

0 -> "正常登录".showToast()

1 -> "开始登录".showToast()

-1 -> "异常".showToast()

2 -> "使用H5登陆或显示下载页面".showToast()

else -> "出错".showToast()

}

}

}这边对mTencent.login(this, "all",iu)中login的参数做一下解释说明

mTencent.login(this, "all",iu)

//这里Tencent的实例mTencent的login函数的三个参数

//1.为当前的context,

//2.权限,可选项,一般选择all即可,即全部的权限,不过目前好像也只有一个开放的权限了

//3.为UIlistener的实例对象还差最后一步,获取回调的结果的代码,activity的回调,这边显示方法已经废弃了,本来想改造一下的,后面发现要改造的话需要动sdk里面的源码,有点麻烦就没有改了,等更新

override fun onActivityResult(requestCode: Int, resultCode: Int, data: Intent?) {

super.onActivityResult(requestCode, resultCode, data)

//腾讯QQ回调,这里的iu仍然是相关的UIlistener

Tencent.onActivityResultData(requestCode, resultCode, data,iu)

if (requestCode == Constants.REQUEST_API) {

if (resultCode == Constants.REQUEST_LOGIN) {

Tencent.handleResultData(data, iu)

}

}

}至此,已经可以正常登录了,但还有一件我们开发者最关心的事情没有做,获取的用户的数据在哪呢?可以获取QQ号吗?下面将为大家解答这方面的疑惑。

四、接入流程以及相关代码

首先回答一下上面提出的问题,可以获得两段比较关键的json数据,一个是 login 的时候获取的,主要是token相关的数据,还有一段就是用户的个人信息的 json 数据,这些都在 UIListener 中进行处理和获取。第二个问题能不能获取QQ号,答案是不能,我们只能获取与一个与QQ号一样具有唯一标志的id即open_id,显然这是出于用户的隐私安全考虑的,接下来简述一下具体的登录流程

1.登录之前检查是否有token缓存

有,直接启动主activity

无,进入登录界面

判断是否具有登录数据的缓存

//这里采用微信的MMKV进行储存键值数据

MMKV.initialize(this)

val kv = MMKV.defaultMMKV()

kv.decodeString("qq_login")?.let{

val gson = Gson()

val qqLogin = gson.fromJson(it, QQLogin::class.java)

QQLoginTestApplication.mTencent.setAccessToken(qqLogin.access_token,qqLogin.expires_in.toString())

QQLoginTestApplication.mTencent.openId = qqLogin.openid

}检查token和open_id是否有效和token是否过期,这里采取不同于官方的推荐的用法,主要是api失效了或者是自己没用对方法,总之官方提供的api进行缓存还不如MMKV键值存login json来的实在,也很方便,这里建议多多使用日志,方便排查错误

//这里对于uiListener进行了重写,object的作用有点像java里面的匿名类

//用到了checkLogin的方法

mTencent.checkLogin(object : DefaultUiListener() {

override fun onComplete(response: Any) {

val jsonResp = response as JSONObject

if (jsonResp.optInt("ret", -1) == 0) {

val jsonObject: String? = kv.decodeString("qq_login")

if (jsonObject == null) {

"登录失败".showToast()

} else {

//启动主activity

}

} else {

"登录已过期,请重新登录".showToast()

//启动登录activity

}

}

override fun onError(e: UiError) {

"登录已过期,请重新登录".showToast()

//启动登录activity

}

override fun onCancel() {

"取消登录".showToast()

}

})2.进入登录界面

在判断session有效的情况下,进入登录界面,对login登录可能出现的返回码做一下解释说明

Login.setOnClickListener {

if (!QQLoginTestApplication.mTencent.isSessionValid) {

when (QQLoginTestApplication.mTencent.login(this, "all",iu)) {

0 -> "正常登录".showToast()

1 -> "开始登录".showToast()

-1 -> {

"异常".showToast()

QQLoginTestApplication.mTencent.logout(QQLoginTestApplication.context)

}

2 -> "使用H5登陆或显示下载页面".showToast()

else -> "出错".showToast()

}

}

}1:正常登录

这个就无需做处理了,直接在回调那里做相关的登录处理即可

0:开始登录

同正常登录

-1:异常登录

这个需要做一点处理,当时第一次遇到这个情况就是主activity异常消耗退回登录的activity,此时在此点击登录界面的按钮导致了异常情况的出现,不过这个处理起来还是比较容易的,执行强制下线操作即可

"异常".showToast()

mTencent.logout(QQLoginTestApplication.context)2:使用H5登陆或显示下载页面

通常情况下是未安装QQ等软件导致的,这种情况无需处理,SDK自动封装好了,这种情况会自动跳转QQ下载界面

同样的有出现UIListener就需要调用回调进行数据的传输

override fun onActivityResult(requestCode: Int, resultCode: Int, data: Intent?) {

super.onActivityResult(requestCode, resultCode, data)

//腾讯QQ回调

Tencent.onActivityResultData(requestCode, resultCode, data,iu)

if (requestCode == Constants.REQUEST_API) {

if (resultCode == Constants.REQUEST_LOGIN) {

Tencent.handleResultData(data, iu)

}

}

}3.进入主activity

这里需要放置一个按钮执行下线操作,方便调试,同时这里需要将之前的token移除重新获取token等数据的缓存

button.setOnClickListener {

mTencent.logout(this)

val kv = MMKV.defaultMMKV()

kv.remove("qq_login")

//返回登录界面的相关操作

"退出登录成功".showToast()

}至此,其实还有一个很重要的东西没有说明,那就是token数据的缓存和个人信息数据的获取,这部分我写的登录的那个UIlistener里面了,登录成功的同时,获取login的response的json数据和个人信息的json数据

4.获取两段重要的json数据

login 的json数据

这个比较容易,当我们登录成功的时候,oncomplete里面的response即我们想要的数据

override fun onComplete(response: Any?) {

if (response == null) {

"返回为空,登录失败".showToast()

return

}

val jsonResponse = response as JSONObject

if (jsonResponse.length() == 0) {

"返回为空,登录失败".showToast()

return

}

//这个即利用MMKV进行缓存json数据

kv.encode("qq_login",response.toString())

"登录成功".showToast()

}个人信息的数据

这个需要在login有效的前提下才能返回正常的数据

//首先需要用上一步获取的json数据对mTencent进行赋值,这部分放在doComplete方法中执行

private fun doComplete(values: JSONObject?) {

//利用Gson进行格式化成对象

val gson = Gson()

val qqLogin = gson.fromJson(values.toString(), QQLogin::class.java)

mTencent.setAccessToken(qqLogin.access_token, qqLogin.expires_in.toString())

mTencent.openId = qqLogin.openid

Log.e("fund",values.toString())

}创建一个get_info方法进行获取,注意这里需要对mTencent设置相关的属性才能获取正常获取数据

private fun getQQInfo(){

val qqToken = mTencent.qqToken

//这里的UserInfo是sdk自带的类,传入上下文和token即可

val info = UserInfo(context,qqToken)

info.getUserInfo(object :BaseUiListener(mTencent){

override fun onComplete(response: Any?){

//这里对数据进行缓存

kv.encode("qq_info",response.toString())

}

})

}

5.踩坑系列

这里主要吐槽一下关于腾讯的自带的session缓存机制,当时是抱着不用自己实现缓存直接用现成的机制去看的,很遗憾这波偷懒失败,这部分session的设置不知道具体的缓存机制,只知道大概是用share preference实现的,里面有saveSession,initSession,loadSession这三个方法,看上去很容易的样子,然后抱着这种心态去尝试了一波,果然不出意外空指针异常,尝试修改了一波回调的顺序仍然空指针异常,折腾了大概三个多小时,放弃了,心态给搞崩了,最终释然了,为什么要用腾讯提供的方法,这个缓存自己实现也是相当的容易,这时想到了MMKV,两行代码完成读取,最后只修改了少数的代码完成了登录的token的缓存机制,翻看demo里面的实现,里面好像是用这三种方法进行实现的,可能是某个实现机制没有弄明白,其实也不想明白,自己的思路比再去看demo容易多了,只是多了一个json的转对象的过程,其他的没有差别。所以建议后来者直接自己实现缓存,不用管sdk提供的那些方法,真的有点难用。

五、总结

总之这次完成QQ接入踩了许多的坑,不过幸好最终还是实现了,希望腾讯互联这个sdk能够上传github让更多的人参与和提供反馈,不然这个文档说是最差sdk体验也不为过。下面附上这次实现QQ登录的demo的github地址以及相关的demo apk供大家进行参考,大概总共就400行代码左右比官方的demo好很多,有问题欢迎留言

https://github.com/xyh-fu/QQLoginTest.git作者:wresource

来源:juejin.cn/post/7072878774261383176

2022年终总结——迷茫摆烂

前言

如果要用两个关键词来概括2022全年,我认为是“迷茫”和“摆烂”。迫于对未来的迷茫无措,我写下了这些文字。原本没有打算发出来,但是仔细想想,这又何尝不是一种逃避?所以我发了出来,希望老哥们可以在看完文章后帮我指引前路,不在迷茫。标志性事件太多,麻烦认出来的哥哥,可以给我个面子。

求助

我有两个路线,不知道走哪个。一个是考研,一个是学习,来年跳槽。求指导。

考研的话,北京的学校难度咋样?非全日制的会被承认吗?毕业后大约29岁了,还来得及吗?

学习的话,应该学什么技术呀?应该深入还是全栈?

流水账

关于工作

我在2021年毕业,在年底进入公司,是安卓开发岗位。一直到2月过年那段时间,我摸清了自己的工作内容,接手了以往的项目。我们部门只有我一个安卓开发,其他部门不熟,但是好像也没有安卓岗。没有人教,所以我一直都是靠前任的代码和百度来学习的。我的定位就是应对项目可能会出现的安卓需求,不涉及核心。看似多余,不过工资低(6000),公司养得起。

公司氛围很轻松,朝九晚六。我们同事一直都在忙项目,有点顾不上我。偶尔有人给我派发学习任务,我简单学完之后,面对大把时间就开始手足无措。好多事想干,又不知道先干什么,于是我开始摆烂逃避。看资讯、看小说、刷论坛、刷贴吧,一混就是一天,很爽,深陷其中。

日子就这样混到了三月底。部长看我太闲了,让我跟其中一个项目。这是和安卓风马牛不相及的项目,我也很慌,就开始百度教程学习,慢慢不再混日子。后来正式上手,太难,摸不到门路。只好向同事要了一份他们的做参考,慢慢的上手了,越做越快。于是,在知道截止日期的情况下,我开始摆烂了。玩一会儿,做一点儿。但我还是在截止前一天完成了,耗时一个月。

四月底,部长好像觉得我做的很可以,又给我派了一部分任务。这部分更难,更多。我一开始遇到了点难题,卡了我好久。在百度疯狂的cv了一周之后才解决。然后我又开始摆烂了,这次摆烂的更狠。再加上后面因为疫情开始居家,于是越加肆无忌惮。发觉的时候已经过了20多天了,也居家半个月了。然后我就只能疯狂加班补,最终还是在截止那天完成了,耗时一个半月。

那是六月初,我们刚结束隔离,重新上班。我感到很内疚,因为其他人的工作量是我的两倍,而且部长也催过我。然后我决定发愤图强,然后接过了学习任务。学习完了之后,开始摆烂。后面给我安排了新的任务,需要用到上面学习的内容,然后我就一边学习,一边做,一边摸鱼。

然后就摸鱼摸到了八月,两个月过去了。这时候给我安排了一个安卓项目,我当时真的差点喜极而泣。但是同时,我也真的很慌。因为我除了毕设,就没有再单独开发一个安卓项目了。然后我就结束摆烂,一边偶尔摸鱼,一边努力干活。

一直努力到十月,我终于完成了。其实现在仔细想想,难度也不是很难。之所以耗费两个月时间,多半是因为我经常前半天摸鱼,后半天干活吧。然后就又没事了,放假回来之后就提了点意见让我修改。然后我就又不知道干啥了,就继续摸鱼摆烂。

摆烂到十一月,我们又因为疫情被迫居家了,我直接毫无顾忌的开始疯玩了。后面有新冠什么的,写在生活里了。总之,一直摆烂到现在,偶尔完成一下工作。

总结

总的来说,基本上就是有任务的时候就干活,不忙的时候就迷茫摆烂。

每天都过得浑浑噩噩的,白天迷茫摆烂,夜里焦虑失眠。在公司也没什么师傅来指导,东学一点西学一点的。整个技术成长过程特别碎片化,知识结构不成体系,技术深度严重不足。稍微遇到一些开放性的有难度的问题,就没有足够的信心搞定,产生明显的畏难情绪和自卑心理,觉得自己技不如人,开始逃避,继而摆烂。

每次开会,同事的任务都很高深,到了我就是学习***,感觉自己像个边缘人。

我看不清前面的路该怎么走,未来的技术路线该怎么制定,最近几个月要关注什么,学习什么,自己身上那么多的问题,要优先解决哪一个。

关于生活

因为公司朝九晚六,所以我空闲时间还不少。基本上就是下班回家打游戏、做饭、看小说。我几乎没有自控能力,所以一玩就玩到半夜两三点再睡,因此经常迟到。不过因为公司制度,所以还没有扣过钱。但是睡的太少,前半天只能靠摸鱼看论坛来维持精神。然后午休睡2个小时,后半天在工作。这个状态会在有任务的时候减轻,在没任务的时候加重。

在四月份的时候换了房子。原先住的隔断,虽然双方都很安静,但是因为不隔音,对自控能力极差的我来说简直是折磨(对方是女的,色色不方便)。所以我搬到了离公司很近,房租1800的7平米厨房改的小房间。之前地铁通勤要300元,起床要7:30,这次我血赚。

换了房子之后就更加没有节制了。因为房间小,也就不再做饭了,每天都是打游戏、看小说、刷视频来回换。但是,每当很晚的时候,我好像没事做了该睡觉了,我就感觉空虚茫然。感觉之前做的那些都没有让我真的快乐起来。明明到了该睡觉的时间了,可是心里却很慌,觉得我还没有真的放松一下,可是我不知道做什么。然后就只能继续干刚才那些,等我不知不觉的睡着为止。所以我第二天就经常起不来床,一天都很累,可是回到家里又不知道干什么才能真正地放松自己,只能重复以前的生活,恶性循环了。

打游戏、看小说、刷视频,在一开始确实是快乐的,但是时间长了就开始坐牢了。我明明已经感觉不到快乐了,却不舍得离去,总会觉得接下来一定还有地方可以继续获得快乐,下一个视频、故事情节一定更有趣。因为,如果我退出去了,我就又会迷茫空虚,不知所措。我下意识的想要逃避,不想面对,因为逃避真的有用。但是也因为没有解决根本问题而恶性循环,这都是自己的决定导致的结果。尼采说所有过去的事情是你的意志选择的结果,积极接受,因为这是你的命运。

转而到了六月,中介给我埋得雷爆了。我看房的时候是毛坯房,中介说后面都会给安装空调的,但是房东没给安。一整个夏天我都是靠两个风扇熬过去的。偶尔受不了了,就去隔壁屋蹭一蹭空调。

我在家里读小说只读长度100到200章之间的,因为我会控制不住一直读下去,沉浸于人物中无法自拔,导致晚睡。我一开始喜欢读言情重生种田爽文,毕竟我从小从农村长大,很有代入感。后面也开始读其他类型的,但是也逃不过言情种田爽文这一块。对于从小贫穷吃不起饭,社交能力有问题的我来说,我真的需要飞黄腾达,也需要一个住在心里的人。我一直都梦想有个像小说主角一样有能力的人,带我走出泥潭。后来读的小说多了,我也走出来了,知道自己为什么沉迷了。现实做不到的,只能靠小说了。

我走出小说是七月份的事情了。因为迷茫却又不再读小说,所以我只能多开游戏。我那时候手里在玩三款游戏,玩完正好0点,奖励一下正好睡觉。但是现实不会这么如人愿。一开始还好,时间一长,游戏玩的和上班一样了。玩完还是很累,想休息。可是不知道咋休息,只能刷短视频到3点。

后来我加入了一个游戏交流群,群里人好多都是成年土豪,却又很和善。他们每天当黑奴带本,却没有怨言。人的成长来源,或是经历,或是社交,或是阅读。在高中之后,我终于迎来了一个稳定且长期的社交途径。我跟着一起谈论游戏,也会谈论自己的生活,以求指点。但是成长是缓慢的,我还没有摆脱困境,就进入了一个更大的困境。

一切的转折点是十二月初,我被诈骗了。

具体经过很蠢,我就不发了。我攒了几年的积蓄全没了,还背上了1万的网贷。虽然第一时间就报了警,但是我知道,我这4万多,回不来了。出了警察局我才发现,我要交下个季度的房租了。我之前经常有朋友向我借钱,我圣母心蛮重的,看不得别人受苦,所以我陆陆续续的借出去了2万。所以事发之后,我第一时间联系他们。但是,就要回来一千,甚至有些垃圾人都不回消息了。

我很难过,不敢和家里说,只能看看能不能靠12月要发的工资撑过去,实在不行就网贷。

过了几天,我例行和父母打微信视频。这时候我才知道我爸爸和几个亲戚来北京的工地干活了,而且阳了。他们买不到药,只能困在工地里面干熬着。我很心疼,第二天就很早去楼下药铺排队买药,想着给他们送过去。买完药已经十一点了,想着先回家吃点饭,顺便问问地址。结果正吃着饭呢,突然就感觉特别难受,特别冷,还十分不清醒。我爸爸也说不用给他们送药,他们都快好了。我赶紧给自己贴了好多的暖宝宝,盖着被子睡觉了。虽然措施不少,但还是觉得冷的不行。我以为我是排队的时候,穿的少了,被冻着了。好不容易睡着,再醒来还是冷。我觉得不对了,一看体温计,39.5度。我居然就这么阳了。刚买的药,全给自己用了。

我躺在床上,很委屈,难受的想哭。我到手就6000块钱,我在这刚工作一年攒下4万容易吗?我除了房租水电等必要的花销,几乎不消费的。之前借我钱的那些人,有些还是在大学的时候借的。我家里在农村也是最底下的那一档了,我大学四年努力打零工去实习,省吃俭用才存下了一点儿钱。我穿着高中买的烂衣服,他们还向我借钱,我以为他们可能真缺钱,才借给他们的。谁知道他们转头拿去买苹果,花天酒地了。在我真的需要帮助的时候,却只有一个人还了钱。

我把我被诈骗、要不回钱、阳了这些事说在了群里,求到了许多的指点。我之后就去要钱了。也不是没有进展,要回来一部分。只是,我说话的时候,他们苹果手机的灵动岛一直在跳动,很刺眼。仿佛在嘲笑我,我现在吃饭的工具,用的还是2017年花4000买的电脑。手机也是三年前花了2000买的。我对自己并不好,对别人那么好干嘛,又不是土豪。人不为己天诛地灭。

我不敢乱消费。我知道我看不清自己,现在消费主义盛行,谁知道这些需求到底是不是真正的自己的需求。就像是,我已经单身26年了,早就分不清自己是真的喜欢,还是只想色色了。更何况,我家里真的穷,在我毕业挣钱之后才搬离我住了20多年的土坯房。我爸爸已经50多了,也去不了几天工地搬砖了,我只能指望我自己。

我经常在想,我死了之后会发生什么。我死了以后,这世界的所有事情全都和我无关了。我的后事如何处理,亲人会不会难过,过了几年他们还会不会记得我?我的后代会如何发展,会越来越好还是最终都消散了?我们国家呢,会越来越昌盛,还是功亏一篑,全族消失?那地球呢,会不会最终被太阳吞噬?那银河最终会不会被黑洞吞噬?那宇宙最终会不会热寂呢?还是宇宙最终会变成一个互相吞噬而成的大黑洞,最终大爆炸?