浏览器缓存方案

一、浏览器缓存的核心作用与分类

作用:减少网络请求,提升页面加载速度,降低服务器压力。

分类:

- 强缓存:浏览器直接从本地缓存获取资源,不发请求到服务器;

- 协商缓存:发送请求到服务器验证缓存是否有效,有效则返回304状态码,浏览器使用本地缓存。

二、强缓存实现方案(Cache-Control/Expires)

1. Cache-Control(HTTP/1.1,推荐)

- 核心指令:

Cache-Control: max-age=31536000 // 缓存1年(单位:秒)

Cache-Control: no-cache // 强制协商缓存

Cache-Control: no-store // 禁止缓存

Cache-Control: public/private // 缓存可见范围

- 示例配置(Nginx):

location ~* \.(js|css|png|jpg|jpeg|gif|svg)$ {

expires 1y; // 等价于Cache-Control: max-age=31536000

add_header Cache-Control "public";

}

2. Expires(HTTP/1.0,兼容性好)

- 格式:

Expires: Thu, 01 Jan 2024 00:00:00 GMT // 绝对过期时间

- 与Cache-Control的优先级:

- 若同时存在,

Cache-Control优先级更高(因Expires依赖服务器时间)。

- 若同时存在,

三、协商缓存实现方案(Last-Modified/ETag)

1. ETag(推荐,更精准)

- 原理:服务器为资源生成唯一标识(如文件哈希值),浏览器请求时通过

If--Match发送标识,服务器对比后返回304(未修改)或200(修改)。 - 示例流程:

- 首次请求:服务器返回资源+

ETag: "abc123"; - 再次请求:浏览器发送

If--Match: "abc123"; - 服务器对比标识,未修改则返回304,否则返回新资源。

- 首次请求:服务器返回资源+

2. Last-Modified/If-Modified-Since

- 原理:服务器返回资源最后修改时间(

Last-Modified),浏览器下次请求时通过If-Modified-Since发送时间,服务器对比后判断是否更新。 - 缺点:

- 精度有限(仅精确到秒);

- 无法检测文件内容未变但修改时间变更的情况(如编辑器自动保存)。

四、缓存策略对比表

| 策略 | 强缓存 | 协商缓存 |

|---|---|---|

| 核心字段 | Cache-Control/Expires | ETag/Last-Modified |

| 是否发请求 | 否(直接读本地) | 是(验证缓存有效性) |

| 服务器压力 | 低 | 中(需验证请求) |

| 更新及时性 | 差(需等max-age过期) | 好(每次请求验证) |

五、各类资源的缓存策略

1. 静态资源(JS/CSS/图片)

- 策略:

- 强缓存(

max-age=31536000)+ 版本号(如app.v1.0.0.js); - 版本更新时修改文件名,强制浏览器加载新资源。

- 强缓存(

- Nginx配置:

location ~* \.(js|css|png|jpg|jpeg|gif|svg|woff|woff2|ttf|eot)$ {

expires 1y;

add_header Cache-Control "public, max-age=31536000";

add_header ETag on; // 开启ETag协商缓存

}

2. HTML页面

- 策略:

- 不缓存或短缓存(

max-age=0)+ 协商缓存(ETag); - 因HTML常包含动态内容,避免强缓存导致页面不更新。

- 不缓存或短缓存(

- 配置:

location / {

expires 0;

add_header Cache-Control "no-cache, no-store, must-revalidate";

add_header Pragma "no-cache";

}

3. 动态接口(API)

- 策略:

- 禁止缓存(

Cache-Control: no-cache); - 或根据业务需求设置短缓存(如5分钟)。

- 禁止缓存(

六、问题

1. 问:强缓存和协商缓存的执行顺序?

- 答:

- 浏览器先检查强缓存(

Cache-Control/Expires),有效则直接使用本地缓存; - 强缓存失效后,发送请求到服务器验证协商缓存(

ETag/Last-Modified),有效则返回304; - 协商缓存失效后,服务器返回新资源(200 OK)。

- 浏览器先检查强缓存(

2. 问:如何强制浏览器更新缓存?

- 答:

- 前端:修改资源URL(如加版本号

?v=2.0); - 后端:

- 发送

Cache-Control: no-cache强制协商缓存; - 更改

ETag或Last-Modified值,使协商缓存失效。

- 发送

- 前端:修改资源URL(如加版本号

3. 问:ETag和Last-Modified的优缺点?

- 答:

- ETag:

✅ 优点:精准检测资源变化(基于内容哈希);

❌ 缺点:计算哈希有性能开销,资源量大时影响服务器效率。 - Last-Modified:

✅ 优点:实现简单,服务器压力小;

❌ 缺点:精度低,无法检测内容未变但修改时间变更的情况。

- ETag:

4. 问:如何处理缓存导致的登录状态失效?

- 答:

- 在响应头中添加

Cache-Control: private(仅客户端可缓存); - 或对包含登录状态的资源设置

Cache-Control: no-cache,强制每次请求验证; - 前端路由跳转时,通过

window.location.reload(true)强制刷新(跳过强缓存)。

- 在响应头中添加

七、缓存调试与优化工具

- Chrome DevTools:

- Network面板:查看请求的缓存状态(

from disk cache/from memory cache/304 Not Modified); - 禁用缓存:勾选

Disable cache可临时关闭缓存,方便开发调试。

- Network面板:查看请求的缓存状态(

- Lighthouse:

- 审计缓存策略是否合理,给出优化建议(如“可缓存的资源未设置缓存”)。

- 服务器日志:

- 分析

304请求比例,评估缓存命中率(理想情况下静态资源命中率应>80%)。

- 分析

来源:juejin.cn/post/7522093523966197812

这种小工具居然也能在某鱼卖钱?我用Python一天能写100个,纯干货!

前两天在某鱼闲逛,本来想找个二手机械键盘,结果刷着刷着突然看到有人在卖——Word 批量转 PDF 小工具,还挺火,价格也不高,但销量出奇地高,评论里一堆人在夸“好用”、“终于不用一篇篇点了”啥的。

说实话,当时我人都愣住了——

这个功能我用 Python 十分钟能写完啊!

然后我又搜了其它小工具,pdf转Word,Word转图片,Word加水印什么的……好多

好家伙,花姐以前教大家做的办公自动化小工具原来都能卖钱呀!

那咱今天先复刻一个Word 批量转 PDF 小工具,顺便升级点功能,做个更丝滑的版本。

保准你看完就能自己写个卖钱去。

💡思路先摆明:Word 转 PDF,其实没那么复杂

你别看这功能听起来挺“高端”的,其实本质上干的事就是——

把一堆 Word 文档用程序打开,然后保存为 PDF 格式。

换句话说,这活本质就是个“批处理”。用 Python 来干,简直再合适不过。

我们需要的工具是 python-docx?NoNoNo——这个库不支持保存为 PDF。真正的主角其实是:

win32com.client:用来操作 Word 应用(需要 Windows 系统+装了 Office)- 或者跨平台一点的玩法,用 LibreOffice + subprocess,不过今天我们先来讲讲最稳最简单的方式:用 Word 本尊来干活。

🔧上代码:几行就能跑起来的 Word 转 PDF 脚本

好,开门见山,先上最基础的版本:

import os

import win32com.client

def word_to_pdf(input_path, output_path):

word = win32com.client.Dispatch("Word.Application")

word.Visible = False # 不弹窗,后台运行

doc = word.Documents.Open(input_path)

doc.SaveAs(output_path, FileFormat=17) # 17 是 PDF 格式

doc.Close()

word.Quit()

# 示例用法

word_to_pdf("C:/Users/你的用户名/Desktop/测试文档.docx",

"C:/Users/你的用户名/Desktop/测试文档.pdf")

✍️几句解释:

Dispatch("Word.Application")就是打开 Word 应用;FileFormat=17是告诉它“嘿,我要存成 PDF”;- 结尾的

Quit()很重要,不然 Word 可能会在后台一直挂着,占资源。 - 如果你电脑里安装的是WPS,

Dispatch("Word.Application")这里改成Dispatch("kwps.Application"),不然会报错

是不是很简单?连我猫都看懂了。

📂扩展:支持批量转换,一次性把一整个文件夹干掉!

很多人痛苦的点是“文档太多,一个个转太麻烦”。

那好说,我们搞个批量版本,让它一口气全转了:

def batch_convert(folder_path):

word = win32com.client.Dispatch("Word.Application")

word.Visible = False

for file in os.listdir(folder_path):

if file.endswith(".doc") or file.endswith(".docx"):

doc_path = os.path.join(folder_path, file)

pdf_path = os.path.splitext(doc_path)[0] + ".pdf"

try:

doc = word.Documents.Open(doc_path)

doc.SaveAs(pdf_path, FileFormat=17)

doc.Close()

print(f"✅ 转换成功:{file}")

except Exception as e:

print(f"❌ 转换失败:{file},原因:{e}")

word.Quit()

使用方式:

batch_convert(r"C:\Users\你的用户名\Desktop\word文件夹")

🧐常见坑点,花姐来帮你避一避

写得简单不难,难的是兼容和细节。

✅1. 系统必须是 Windows,而且得装了 MS Office

这玩意底层其实就是用 COM 调用了 Word 的功能,所以没有装 Word 是用不了的。

✅2. 文档里有宏的、被保护的,可能转不了

有些文档打开会弹窗提示宏或者密码,那个得手动改设置,程序跑不过去。

✅3. 文件名不要太长、路径不要有中文/空格

有时候路径太奇怪,Word 会打不开,转不了,建议统一放到纯英文文件夹里。

🎁额外加点料

- 自动生成时间戳文件夹 + 输出日志

- 自动获取脚本所在目录下的 Word 文件(不需要用户手动输路径)

- 判断电脑里是否装了 Office(Word)或 WPS,并自动选对的调用方式

- 打包售卖

⏱️ 一、生成时间戳文件夹

def gen_output_folder():

folder = os.path.dirname(os.path.abspath(__file__))

timestamp = datetime.datetime.now().strftime("%Y%m%d_%H%M%S")

output_folder = os.path.join(folder, f"pdf_{timestamp}")

os.makedirs(output_folder, exist_ok=True)

return output_folder

📁 二、自动获取当前脚本目录下的 Word 文件

这太简单了:

import os

def get_word_files_from_current_folder():

folder = os.path.dirname(os.path.abspath(__file__))

word_files = []

for file in os.listdir(folder):

if file.endswith(".doc") or file.endswith(".docx"):

word_files.append(os.path.join(folder, file))

return word_files

🔍 三、检测 Office 和 WPS 的方法

我们可以尝试用 win32com.client.gencache.EnsureDispatch() 去判断这两个程序是否存在。

import win32com.client

def detect_office_or_wps():

try:

word = win32com.client.gencache.EnsureDispatch("Word.Application")

return "office"

except:

try:

wps = win32com.client.gencache.EnsureDispatch("Kwps.Application")

return "wps"

except:

return

🔄 三、自动选择引擎并批量转换

import os

import win32com.client

def convert_word_to_pdf_auto(input_path, output_path, engine):

if engine == "office":

app = win32com.client.Dispatch("Word.Application")

elif engine == "wps":

app = win32com.client.Dispatch("Kwps.Application")

else:

print("❌ 没有检测到可用的 Office 或 WPS")

return

app.Visible = False

try:

doc = app.Documents.Open(input_path)

doc.SaveAs(output_path, FileFormat=17)

doc.Close()

print(f"✅ 转换成功:{input_path}")

except Exception as e:

print(f"❌ 转换失败:{input_path},原因:{e}")

try:

app.Quit()

except:

print("⚠️ 当前环境不支持 Quit,跳过退出。")

🚀 四、整合所有内容,一键搞定脚本所在目录下的所有 Word 文件

def batch_convert_here():

engine = detect_office_or_wps()

if not engine:

print("😭 系统里没有安装 Office 或 WPS,没法转换")

return

folder = os.path.dirname(os.path.abspath(__file__))

word_files = get_word_files_from_current_folder()

if not word_files:

print("🤷♀️ 当前文件夹没有发现 Word 文件")

return

output_folder = os.path.join(folder, "pdf输出")

os.makedirs(output_folder, exist_ok=True)

for word_file in word_files:

filename = os.path.splitext(os.path.basename(word_file))[0]

pdf_path = os.path.join(output_folder, f"{filename}.pdf")

convert_word_to_pdf_auto(word_file, pdf_path, engine)

print("🎉 所有文件转换完成啦!PDF 都在 'pdf输出' 文件夹里")

🧪 运行方式(放在脚本结尾):

if __name__ == "__main__":

batch_convert_here()

📦五、 做成 EXE 给小白用户用(pyinstaller)

最后一步,把咱的脚本打包成 .exe,丢到某鱼卖钱(手动狗头🐶)

命令就一句话:

pyinstaller -F word2pdf.py

生成的 dist/word2pdf.exe 就是可执行文件,随便拿给谁用都行(当然系统要有 Word)。

完整代码

import os

import win32com.client

import sys

import datetime

def get_real_path():

"""兼容开发与打包环境的路径获取"""

if getattr(sys, 'frozen', False):

base_dir = os.path.dirname(sys.executable) # EXE文件所在目录[1,7](@ref)

else:

base_dir = os.path.dirname(os.path.abspath(__file__))

return base_dir

# 生成时间戳文件夹

def gen_output_folder(folder):

# folder = os.path.dirname(os.path.abspath(__file__))

timestamp = datetime.datetime.now().strftime("%Y%m%d_%H%M%S")

output_folder = os.path.join(folder, f"pdf_{timestamp}")

os.makedirs(output_folder, exist_ok=True)

return output_folder

# 自动获取当前脚本目录下的 Word 文件

def get_word_files_from_current_folder(folder):

# folder = os.path.dirname(os.path.abspath(__file__))

word_files = []

for file in os.listdir(folder):

if file.endswith(".doc") or file.endswith(".docx"):

word_files.append(os.path.join(folder, file))

return word_files

# 检测 Office 和 WPS 的方法

def detect_office_or_wps():

try:

word = win32com.client.gencache.EnsureDispatch("Word.Application")

return "office"

except:

try:

wps = win32com.client.gencache.EnsureDispatch("Kwps.Application")

return "wps"

except:

return

# 自动选择引擎并批量转换

def convert_word_to_pdf_auto(input_path, output_path, engine):

if engine == "office":

app = win32com.client.Dispatch("Word.Application")

elif engine == "wps":

app = win32com.client.Dispatch("Kwps.Application")

else:

print("没有检测到可用的 Office 或 WPS")

return

app.Visible = False

try:

doc = app.Documents.Open(input_path)

doc.SaveAs(output_path, FileFormat=17)

doc.Close()

print(f"转换成功:{input_path}")

except Exception as e:

print(f"转换失败:{input_path},原因:{e}")

try:

app.Quit()

except:

print("当前环境不支持 Quit,跳过退出。")

# 主函数

def batch_convert_here():

engine = detect_office_or_wps()

if not engine:

print("系统里没有安装 Office 或 WPS,没法转换")

return

folder = get_real_path()

word_files = get_word_files_from_current_folder(folder)

if not word_files:

print("当前文件夹没有发现 Word 文件")

return

output_folder = gen_output_folder(folder)

for word_file in word_files:

filename = os.path.splitext(os.path.basename(word_file))[0]

pdf_path = os.path.join(output_folder, f"{filename}.pdf")

convert_word_to_pdf_auto(word_file, pdf_path, engine)

print("所有文件转换完成啦!PDF 都在 'output_folder' 文件夹里")

if __name__ == "__main__":

try:

batch_convert_here()

print("按 Enter 键退出...")

input() # 等待用户按 Enter 键

except Exception as e:

print(e)

print("程序运行错误,按 Enter 键退出...")

input() # 等待用户按 Enter 键

你可能觉得:“这不就是几十行代码嘛,卖这个会有人买吗?”

我一开始也这么想。后来我想通了,某鱼上很多买家,根本不懂技术,他们在意的是:

✅ 能不能一键搞定?

✅ 会不会太复杂?

✅ 省不省事?

所以啊,写工具 + 提供说明 + 包装打包,这些就构成了“产品”。

我们程序员有时候太低估自己的能力了——其实你随手写的脚本,真的能解决很多人的问题。

来源:juejin.cn/post/7501221695550914575

Go实现超时控制

应用场景

交易、金融等事务系统往往会有各种下游,绝大多数时候我们会以同步方式进行访问,如调用RPC、HTTP等。

这些下游在通常延时相对稳定,但有时可能出现极端的超大延时,这些极端case可能具备特定的业务特征,也有可能单纯是硬件、网络的问题造成,最终表现在系统P99或者P999的延时出现了突刺,如果是面向C端的场景,也会向用户报出一些系统错误,造成用户体验的下降。

一种简易的解决方案是,针对关键的下游节点增加超时控制。在特定时间内,如果下游到期还未返回,不再暴露系统级错误,而是做特殊化处理,比如返回「处理中」状态。

Go实现方案

设计一个方法,使用闭包,传入时间和执行的任务,如果任务执行完未到时间,则直接返回,否则通知调用者超时。

为了保证代码简介和使用简单,我们仅定义一个Wrapper方法,方法定义如下

func TimeoutControlWrapper(duration time.Duration, fn func()) (timeout bool)

官方包time有一个After方法,可以在指定时间内,返回一个channel,基于此来判断是否超时。

另外,在Wrapper方法里异步化执行目标方法,执行完成后写入一个finish信号通知。

同时监听这两个channel,判断是否超时,代码如下

func TimeoutControlWrapper(duration time.Duration, fn func()) (timeout bool) {

finish := make(chan struct{})

go func() {

fn()

finish <- struct{}{}

}()

select {

case <-finish:

return false

case <-time.After(duration):

return true

}

}

结合场景,假设系统会调用一个支付系统的接口,接口本身延时不稳定,因此我们套用TimeoutControlWrapper

func CallPaymentSystem(param PayParam) (payStatus PayStatus) {

var payStatus PayStatus

timeout := TimeoutControlWrapper(time.Second, func() {

payStatus = PaymentSystemRPC.Pay(param)

})

if timeout {

warn() // WARN告警

return PROCESSING // 返回处理中

}

return payStatus

}

延伸思考

上述通过一个简单的Wrapper,来实现调用下游时的超时控制。但在引入的场景里,实现上是不严谨的。哪怕不增加超时控制,我们也无法确认请求是否真实到达了下游系统,这本质上是一个分布式事务的问题,需要我们设计更加健全的系统能力保证一致性,比如通过消息的方式、补偿机制、增加对账系统。

来源:juejin.cn/post/7524615282490441779

前端文件下载全攻略:从单文件到批量下载,哪种方法最优?

小张是一名刚入职的前端开发工程师,某天,他的领导给他布置了一个看似简单的任务:

让用户能够通过文件链接下载多个文件

小张信心满满,觉得这不过是个小问题。然而,当他真正动手时,才发现这个需求并不简单。不同的下载方式各有优缺点,甚至有些方法会带来意想不到的问题,他决定一一尝试,探索最优解。

方案一:window.open——简单粗暴,但会打开新标签页

小张首先想到的是 window.open(url),它可以让浏览器直接打开下载链接。

window.open('https://example.com/file.pdf');

优点:

- 代码简单,直接调用即可。

- 适用于单个文件的下载。

缺点:

- 每次下载都会打开一个新的浏览器标签页,影响用户体验。

- 部分浏览器可能会拦截

window.open,导致下载失败。

方案二:window.location.href 简单有效,但不能同时下载多个文件

小张发现,window.location.href 也可以实现下载,且不会打开新标签页。

window.location.href = 'https://example.com/file.pdf';

优点:

- 适用于单文件下载。

- 不会像

window.open那样打开新页面。

缺点:

- 无法循环下载多个文件。如果连续多次赋值

window.location.href,后一个请求会覆盖前一个,导致只能下载最后一个文件。

方案三:iframe 支持多文件下载,但无法监听完成状态

为了让多个文件能够顺利下载,小张尝试用 iframe。

function downloadFile(url) {

const iframe = document.createElement('iframe');

iframe.style.display = 'none';

iframe.src = url;

document.body.appendChild(iframe);

setTimeout(() => {

document.body.removeChild(iframe);

}, 5000); // 延迟移除 iframe,防止影响下载

}

优点:

- 适用于多文件下载。

缺点:

iframe无法监听文件下载是否完成。- 需要在合适的时机移除

iframe,否则可能会影响页面性能。

方案四:fetch + blob——最优雅的下载方式

小张最终发现,fetch 可以获取文件数据,再通过 Blob 处理并使用 a 标签下载。

async function downloadFile(url, fileName) {

const response = await fetch(url);

if (!response.ok) throw new Error('Download failed');

const blob = await response.blob();

const blobUrl = URL.createObjectURL(blob);

const a = document.createElement('a');

a.href = blobUrl;

a.download = fileName;

document.body.appendChild(a);

a.click();

document.body.removeChild(a);

URL.revokeObjectURL(blobUrl);

}

function download(fileList){

for(const file of fileList) {

await downloadFile(file.url,file.name)

}

}

优点:

- 不会打开新标签页。

- 可以同时下载多个文件。

- 适用于现代浏览器,兼容性较好。

缺点:

- 需要处理异步

fetch请求。 - 服务器必须支持跨域资源共享(CORS),否则

fetch请求会失败。 - 多次文件下载会导致多个浏览器下载图标:每次调用

a.click()时,浏览器都会显示一个下载图标,影响用户体验。

方案五:jsZip 打包多个文件为 ZIP 下载——避免多次下载图标

为了进一步优化方案四,避免浏览器每次下载时显示多个下载图标,小张决定使用 jsZip 插件将多个文件打包成一个 ZIP 文件下载。

import JSZip from 'jszip';

async function downloadFilesAsZip(files) {

const zip = new JSZip();

// 循环遍历多个文件,获取每个文件的数据

for (const file of files) {

const response = await fetch(file.url);

if (!response.ok) throw new Error(`Failed to fetch ${file.name}`);

const blob = await response.blob();

zip.file(file.name, blob); // 将文件添加到 ZIP 包中

}

// 生成 ZIP 文件并触发下载

zip.generateAsync({ type: "blob" })

.then(function(content) {

const a = document.createElement('a');

const blobUrl = URL.createObjectURL(content);

a.href = blobUrl;

// 给压缩包设置下载文件名

a.download = 'files.zip';

document.body.appendChild(a);

a.click();

document.body.removeChild(a);

// 释放 URL 对象

URL.revokeObjectURL(blobUrl);

});

}

优点:

- 提升用户体验:用户下载一个压缩包后,只需解压就可以获取所有文件,避免了多次点击和等待的麻烦。

- 适用于多文件下载:非常适合需要批量下载的场景。

缺点:

- 浏览器对大文件的支持:如果要下载的文件非常大,或者文件总大小很大,可能会导致内存消耗过高,甚至在浏览器中崩溃。

- 下载速度受限于压缩处理:打包文件为 ZIP 需要时间,尤其是文件较多时,会稍微影响压缩的速度,只适用于文件不是很大且数量不是很多的时候

结语:小张的最终选择

经过一番探索,小张最终选择了 jsZip 打包文件的方案,因为它不仅解决了多个文件下载时图标显示的问题,还提高了用户体验,让下载更加流畅,没有哪个方案比另外一个方案好,只有最适合的方案,根据实际的场景能满足需求最优解就是最好的。

来源:juejin.cn/post/7488172786692685835

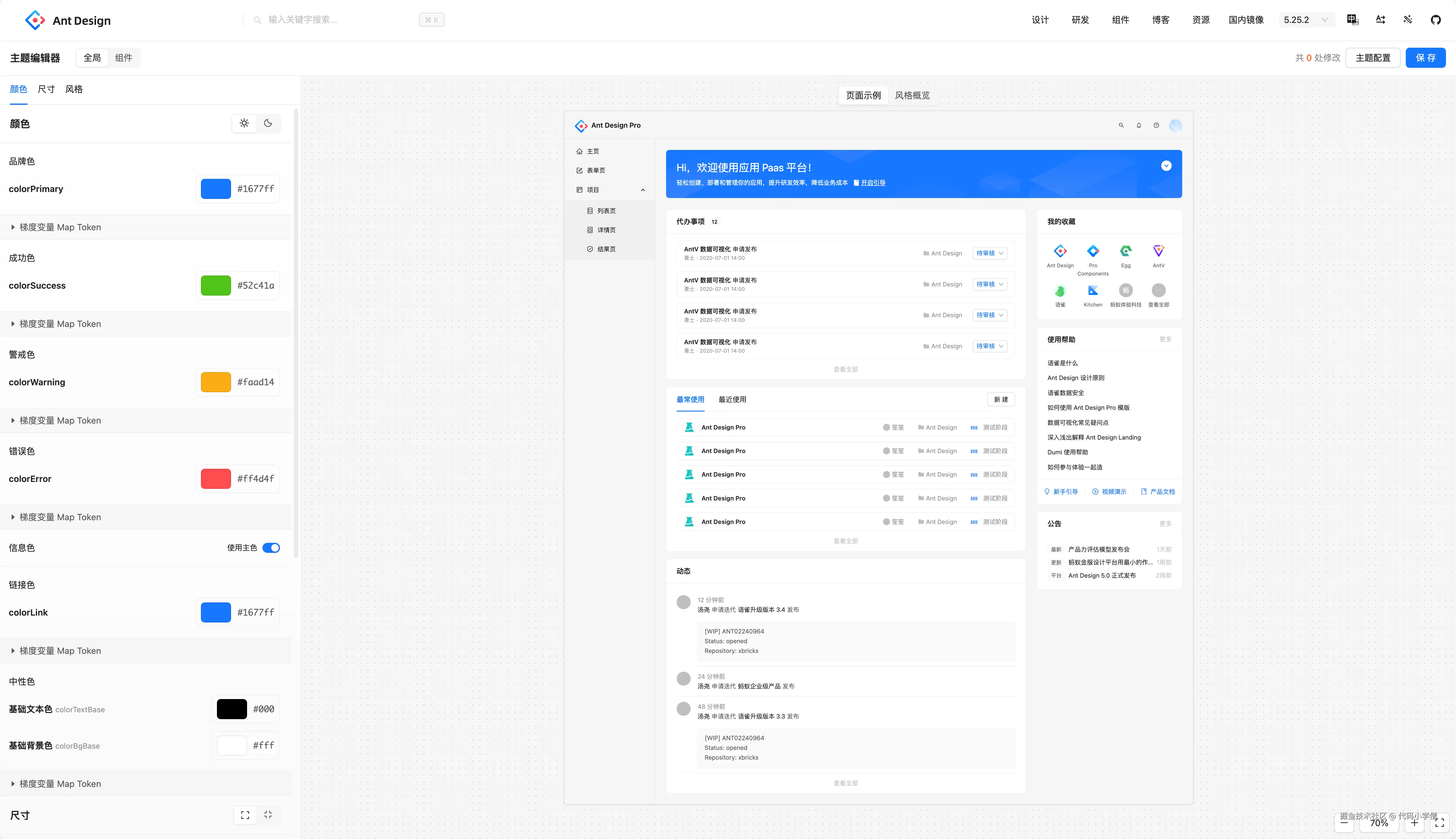

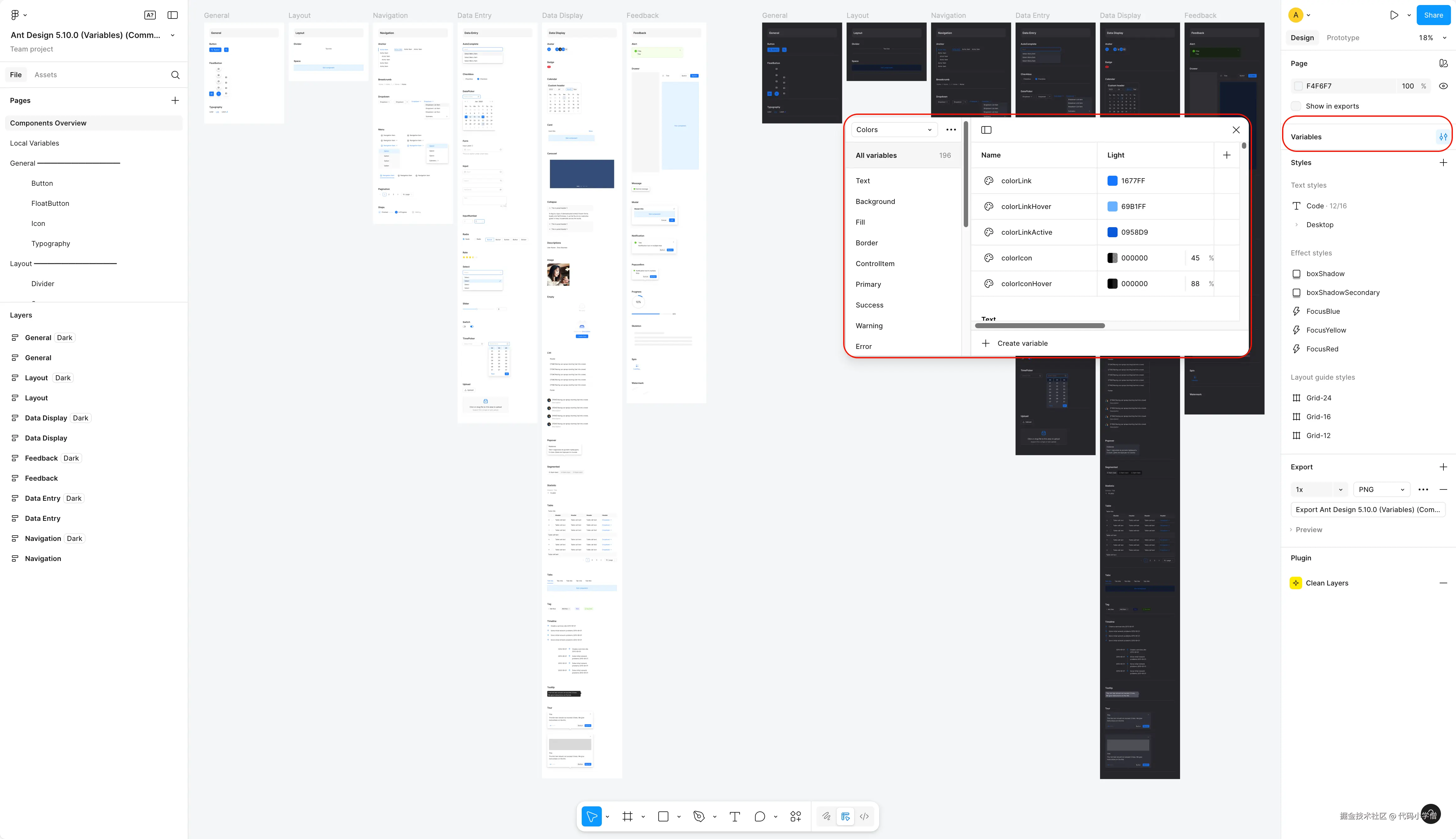

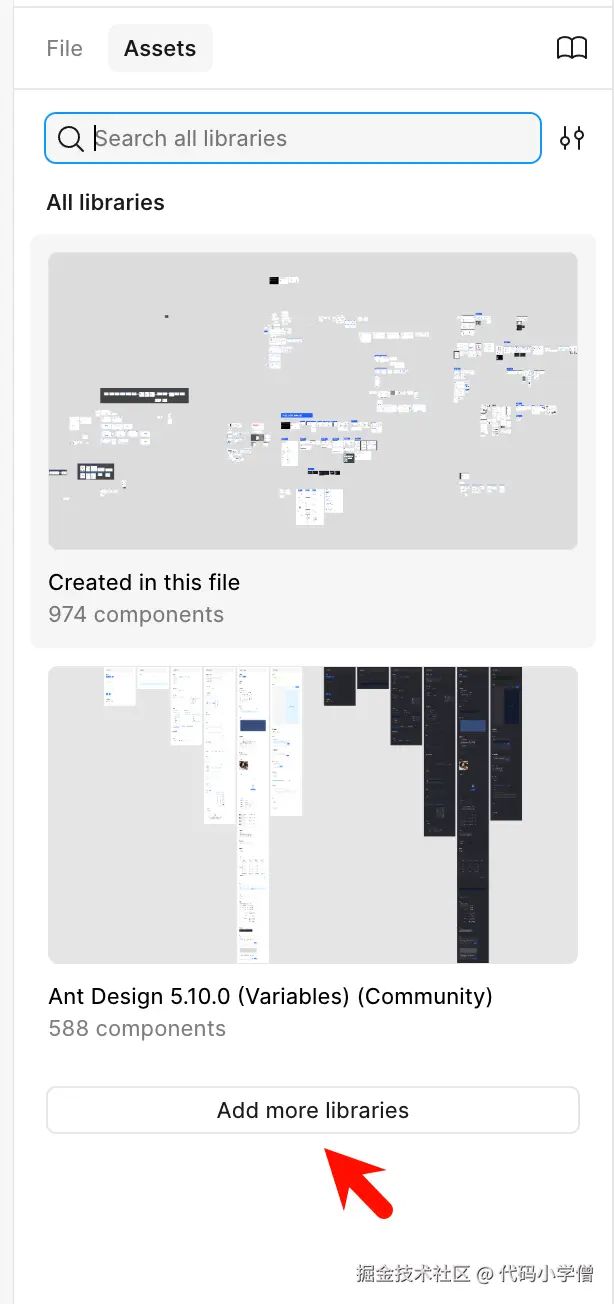

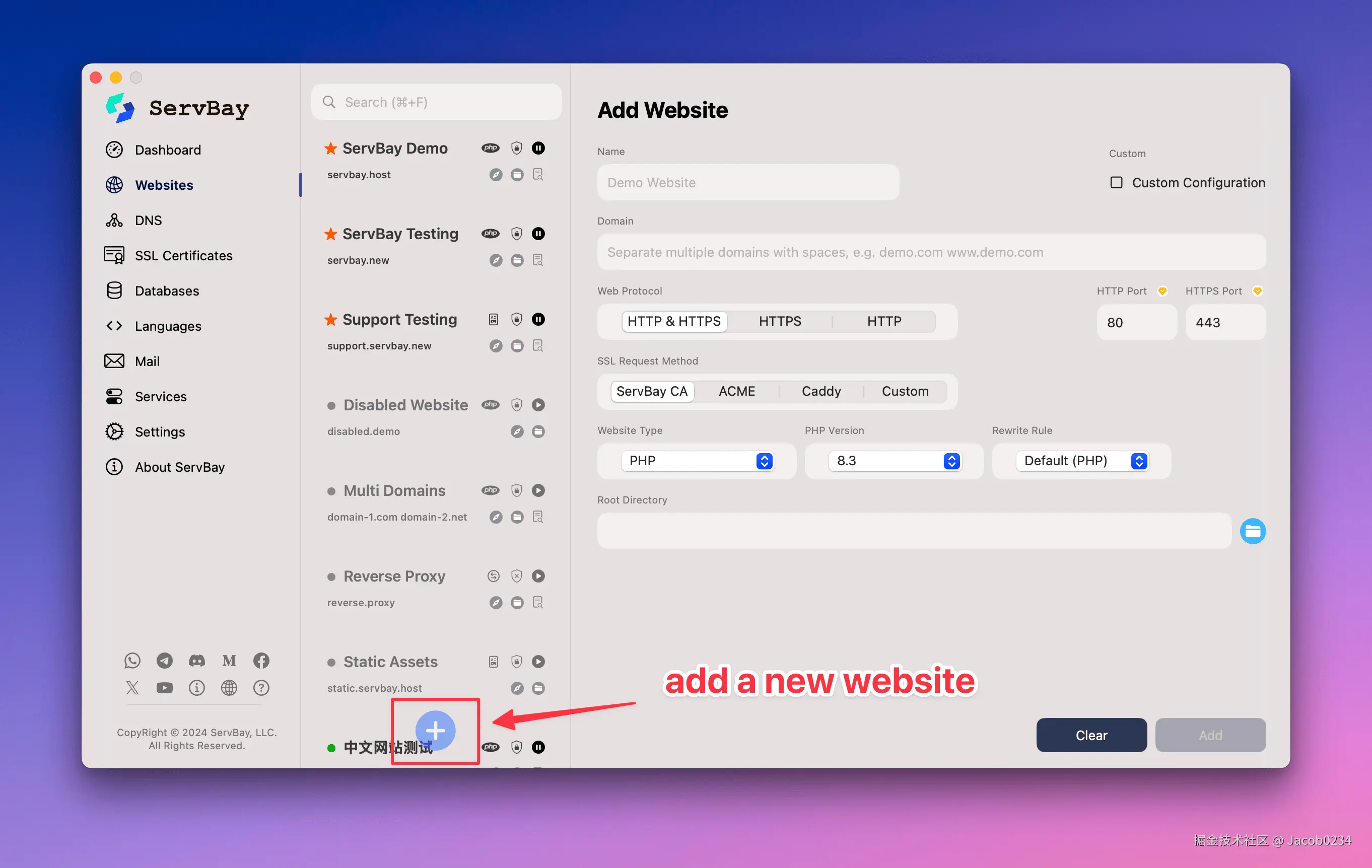

赋能大模型:ant-design系列组件的文档知识库搭建

引言

在当今组件化开发时代,知识库建设已成为提升开发效率的重要环节。然而传统爬虫方式在获取结构化组件文档时往往面临诸多挑战。为此,开发了 antd-doc-gen 工具,用来快速生成 antd 系列组件库的文档,将其作为大模型补充的知识库,生成的文档可以非常方便的导入到 像 ima,cursor,Obsidian 等支持知识库的工具。本文将解析其技术实现与设计理念。

npm 地址:http://www.npmjs.com/package/ant…

github 仓库:github.com/xuanxuan321…

一、核心功能概览

antd-doc-gen 作为专业的命令行工具,具备以下核心能力:

- 多库支持:原生支持 Ant Design 主库、Mobile、Mini、Web3 及 X 系列组件库

- 智能文档解析:自动识别组件文档结构,合并主文档与示例代码

- 格式标准化:生成统一格式的 Markdown 文档,并创建索引目录

- 远程协作:支持从 GitHub 仓库直接下载代码并处理

二、使用指南

快速安装

npm install -g antd-doc-gen

典型用例

生成 antd 文档

antd-doc-gen -d -r https://github.com/ant-design/ant-design

生成 antd-mobile 文档

antd-doc-gen -d -r https://github.com/ant-design/ant-design-mobile

生成 antd-mini 文档

antd-doc-gen -d -r https://github.com/ant-design/ant-design-mini

生成 antd-x 文档

antd-doc-gen -d -r https://github.com/ant-design/x

生成 antd-web3 文档

antd-doc-gen -d -r https://github.com/ant-design/ant-design-web3

三、技术实现解析

智能文档处理流程

工具通过五层处理流程实现文档自动化生成:

- 命令行解析:使用 commander 库处理参数,支持多路径输入

- 代码下载:基于 simple-git 实现多协议下载(HTTPS/SSH),含分支容错机制

- 文档定位:针对不同仓库类型采用差异化路径策略(如 antd 使用 components/*/index.zh-CN.md)

- 内容整合:通过正则表达式提取示例代码,自动补全扩展名(.tsx → .ts)

- 输出生成:按组件名称生成 Markdown 文件,并创建字母序索引

其他:

● 智能路径处理:支持跨平台路径分隔符自动转换,兼容绝对/相对路径

● 文档格式统一:保留原始结构,将示例代码以 Markdown 代码块嵌入

● 容错机制:提供分支/协议降级策略,支持无示例文档的直接复制

技术栈与扩展性

核心技术栈

● Node.js 生态:fs/path 模块实现文件操作,readline 处理用户交互

● 第三方库:commander(命令行)、simple-git(Git 操作)、ora(加载动画)

扩展能力

工具支持通过代码修改实现:

- 新组件库类型适配

- 自定义文档输出格式

- 新增文档处理逻辑

适用场景

需要 antd 系列组件库文档作为知识库的场景

局限性与优化方向

当前版本依赖特定文档结构(需包含 index.md 及 code 标签),未来计划:

● 增强非标准文档的兼容性

● 支持更多文档格式输出

● 集成文档预览功能

结语

antd-doc-gen 通过自动化文档处理流程,显著提升了组件库文档的维护效率。文档可以直接导入像 ima,cursor,Obsidian 等知识库工具,进一步提升大模型的能力

来源:juejin.cn/post/7479814468601085986

技术多久没有进步了?

很久没有写东西了,这个选题正好聊一下。

对于这个问题,我的答案是 1 年左右——我进外包的日子。

在外包中,我的工作日常就是搞业务,天天 CRUD,有人会讲,CRUD 也能玩出花来,只能是你自己对技术没有了追求。我承认,也确实是这样,外包的业务很多,每天 CRUD,很简单,但还是很忙,忙到不想敲代码了,忙到对技术没啥追求了。

外包确实不适合自控力太差的人,不适合自我调节能力不行的人。

为什么这样说呢?我待的外包,说它加班很多吗?其实并没有,至少工作日 5.30 下班最多也就待到 5.45 就走了,周末加班也只有比较着急的时候,次数不多,所以很少的加班,甚至比我之前待着的两家自研加班都少,为啥下班就走的的我,没有时间去深造技术了呢?

我也还在思考。目前我的答案大概还是跟业务有关。

自研会有一种成就感,尤其在我第一家公司尤甚,那时候对自己做的第一个产品确实非常上心,项目上要做的功能和遇到的问题都会进行深度思考,去结合成熟的方案来形成自己的实现方案和解决方案,但是在外包呢,天天各种项目组的人来找你,自己手里有好多个“外包前辈”的项目,继承它们的“代码遗产”,鄙视他们的代码并有优化的心思,但突如其来的项目和很少能自己评开发时间的原因,让我也“放纵”和“加入”了“他们”,每天完成了任务也仅仅是完成了任务,很少有自己的思考,也变没有了什么成就感,对代码变成了“贤者”,没有了“兴趣”,下班后的生活变成了综艺/游戏/抖音,沉浸在这样的“快乐”中。

写到这里了,也想说一下,你技术突飞猛进的时候是一个什么样的时期或状态呢?

上面也说到了,就是第一家公司,除了对自己的“初恋”产品认真外,还有就是那时候是刚从培训班出来,刚找到的第一家公司,怕过不了试用期,所以刚开始每天回家自己敲代码敲到晚上,技术成长非常快,还有就是第二家公司,用的 React 技术栈,当时我是 Vue 技术栈找的 React 技术栈,虽然当时第二家公司说给时间从 Vue 过渡到 React,但也有一种紧迫感,还有也是很想学 React 了,所以技术上也有很大进步。

技术这么久没长进了,是外包公司的问题吗?

其实不是,上面也说了,虽然都是 CRUD,虽然业务比较多,但其实加班都不多,这些都不是理由,下班后的时间其实是比较多的,都是我能掌控的,只是我没有调整好心态,对自己太过放纵罢了,游戏,小说,综艺,抖音填满了我下班后的生活,沉浸在一种虚假的快乐中,其实并不快乐。

把想说的都说出来了,挺好,后面,如果自己不想继续这么混的话,就一块一块改吧。一下全改我都不相信我能做到(三分钟的热度更可怕),一块一块来,不把自己逼的太紧,养成习惯最好,就先这样。

来源:juejin.cn/post/7494489664385548297

JavaScript 数据扁平化方法大全

前言

数据扁平化是指将多维数组转换为一维数组的过程。由于嵌套数据结构增加了访问和操作数据的复杂度,所以·我们可以将嵌套数据变成一维的数据结构,下面就是我搜集到的一些方法,希望可以给你带来帮助!!

1. 使用 Array.prototype.flat()(推荐)

ES2019 引入的专门方法:

const nestedArr = [1, [2, [3, [4]], 5]];

// 默认只扁平化一层

const flattened1 = nestedArr.flat();

console.log(flattened1); // [1, 2, [3, [4]], 5]

// 指定深度为2

const flattened2 = nestedArr.flat(2);

console.log(flattened2); // [1, 2, 3, [4], 5]

// 完全扁平化

const fullyFlattened = nestedArr.flat(Infinity);

console.log(fullyFlattened); // [1, 2, 3, 4, 5]

解析:

flat(depth)方法创建一个新数组,所有子数组元素递归地连接到指定深度- 参数

depth指定要提取嵌套数组的结构深度,可选的参数,默认为1 - 使用

Infinity可展开任意深度的嵌套数组,Infinity是一个特殊的数值,表示无穷大。

2. 使用 reduce() 和 concat() 递归

function flatten(arr) {

// 使用 reduce 方法遍历数组元素

return arr.reduce((acc, val) => {

// 如果当前元素是数组,则递归调用 flatten 继续展开,并拼接到累积数组 acc

if (Array.isArray(val)) {

return acc.concat(flatten(val));

}

// 如果当前元素不是数组,直接拼接到累积数组 acc

else {

return acc.concat(val);

}

}, []); // 初始累积值是一个空数组 []

}

// 测试用例

const nestedArr = [1, [2, [3, [4]], 5]];

console.log(flatten(nestedArr)); // 输出: [1, 2, 3, 4, 5]

解析:

- 递归处理嵌套数组

- 遇到子数组时,递归调用

flatten(val)继续展开,直到所有层级都被展开为单层。

- 遇到子数组时,递归调用

reduce方法的作用

- 遍历数组,通过

acc(累积值)逐步拼接结果,初始值设为[](空数组)。

- 遍历数组,通过

Array.isArray(val)检查

- 判断当前元素是否为数组,决定是否需要递归展开。

concat拼接结果

- 将非数组元素或递归展开后的子数组拼接到累积数组

acc中。

- 将非数组元素或递归展开后的子数组拼接到累积数组

3. 使用 concat() 和扩展运算符递归

function flatten(arr) {

// 使用扩展运算符 (...) 展开数组的第一层,并合并成一个新数组

const flattened = [].concat(...arr);

// 检查当前展开后的数组中是否仍然包含嵌套数组

// 如果存在嵌套数组,则递归调用 flatten 继续展开

// 如果所有元素都是非数组类型,则直接返回展开后的数组

return flattened.some(item => Array.isArray(item))

? flatten(flattened)

: flattened;

}

// 测试用例

const nestedArr = [1, [2, [3, [4]], 5]];

console.log(flatten(nestedArr)); // 输出: [1, 2, 3, 4, 5]

解析:

[].concat(...arr)展开一层数组

- 使用扩展运算符

...展开arr的最外层,并通过concat合并成一个新数组。 - 例如:

[].concat(...[1, [2, [3]]])→[1, 2, [3]](仅展开一层)。

- 使用扩展运算符

flattened.some(Array.isArray)检查嵌套

- 使用 Array.prototype.some() 检查当前数组是否仍然包含子数组。

- 如果存在,则递归调用

flatten继续展开。

- 递归终止条件

- 当

flattened不再包含任何子数组时,递归结束,返回最终结果。

- 当

4. 使用 toString() 方法(仅适用于数字数组)

const nestedArr = [1, [2, [3, [4]], 5]];

const flattened = nestedArr.toString().split(',').map(Number);

console.log(flattened); // [1, 2, 3, 4, 5]

解析:

toString()的隐式转换

- JavaScript 的

Array.prototype.toString()会自动展开嵌套数组,并用逗号连接所有元素。 - 例如:

[1, [2, [3]]].toString()→"1,2,3"。

- JavaScript 的

split(',')分割字符串

- 将字符串按逗号拆分成字符串数组,但所有元素会是字符串类型(如

"2")。

- 将字符串按逗号拆分成字符串数组,但所有元素会是字符串类型(如

map(Number)类型转换

- 通过

Number构造函数将字符串元素转换为数字类型。 - 注意:如果原数组包含非数字(如

['a', [2]]),结果会变成[NaN, 2]。

- 通过

优缺点:

- 优点:代码极其简洁,适合纯数字的嵌套数组。

- 缺点:

- 仅适用于数字数组(其他类型会被强制转换,如

true→1,null→0)。 - 无法保留原数据类型(如字符串

'3'会被转成数字3)。

- 仅适用于数字数组(其他类型会被强制转换,如

适用场景:

- 快速展开纯数字的嵌套数组,且不关心中间过程的性能损耗(

toString和split会有临时字符串操作)。

5. 使用 JSON.stringify() 和正则表达式

function flatten(arr) {

// 1. 使用 JSON.stringify 将数组转换为字符串表示

// 例如:[1, [2, [3]], 'a'] → "[1,[2,[3]],\"a\"]"

const jsonString = JSON.stringify(arr);

// 2. 使用正则表达式移除所有的 '[' 和 ']' 字符

// 例如:"[1,[2,[3]],\"a\"]" → "1,2,3,\"a\""

const withoutBrackets = jsonString.replace(/[\[\]]/g, '');

// 3. 按逗号分割字符串,生成字符串数组

// 例如:"1,2,3,\"a\"" → ["1", "2", "3", "\"a\""]

const stringItems = withoutBrackets.split(',');

// 4. 尝试将每个字符串解析回原始数据类型

// - 数字会变成 Number 类型(如 "1" → 1)

// - 字符串会保留(如 "\"a\"" → "a")

// - 其他 JSON 可解析类型也会被正确处理

return stringItems.map(item => {

try {

// 尝试 JSON.parse 解析(处理字符串、数字等)

return JSON.parse(item);

} catch (e) {

// 如果解析失败(如空字符串或非法 JSON),返回原始字符串

return item;

}

});

}

// 测试用例

const nestedArr = [1, [2, [3, [4]], 5, 'a', { b: 6 }];

console.log(flatten(nestedArr));

// 输出: [1, 2, 3, 4, 5, "a", { b: 6 }]

解析:

JSON.stringify的作用

- 将整个数组(包括嵌套结构)转换为 JSON 字符串,保留所有数据类型信息。

- 正则替换

/[[]]/g

- 移除所有方括号字符

[和],只保留逗号分隔的值。

- 移除所有方括号字符

split(',')分割字符串

- 生成一个字符串数组,但每个元素可能仍是被 JSON 字符串化的(如

""a"")。

- 生成一个字符串数组,但每个元素可能仍是被 JSON 字符串化的(如

- JSON.parse() 尝试恢复数据类型

- 通过

JSON.parse将字符串转换回原始类型(数字、字符串、对象等)。 - 使用

try-catch处理不合法的 JSON 字符串(如空字符串或格式错误的情况)。

- 通过

优缺点:

- 优点:

- 支持任意数据类型(数字、字符串、对象等)。

- 能正确处理嵌套对象(如

{ b: 6 })。

- 缺点:

- 性能较低(涉及 JSON 序列化、正则替换、解析等操作)。

- 如果原始数组包含特殊字符串(如

"[1]") ,可能会被错误解析。

适用场景:

- 需要处理混合数据类型(非纯数字)的嵌套数组。

- 对性能要求不高,但需要代码简洁的场景。

6. 使用堆栈的非递归实现

function flatten(arr) {

// 创建栈并初始化(使用扩展运算符浅拷贝原数组)

const stack = [...arr];

const result = [];

// 循环处理栈中的元素

while (stack.length) {

// 从栈顶取出一个元素

const next = stack.pop();

if (Array.isArray(next)) {

// 如果是数组,展开后压回栈中(保持顺序)

stack.push(...next);

} else {

// 非数组元素,添加到结果数组前端(保持原顺序)

result.unshift(next);

}

}

return result;

}

const nestedArr = [1, [2, [3, [4]], 5]];

console.log(flatten(nestedArr)); // [1, 2, 3, 4, 5]

解析:

- 栈结构初始化

- 使用扩展运算符

[...arr]创建原数组的浅拷贝作为初始栈 - 避免直接修改原数组

- 使用扩展运算符

- 栈处理循环

- 使用

while循环处理栈直到为空 - 每次从栈顶

pop()一个元素进行处理

- 使用

- 元素类型判断

- 使用

Array.isArray()检查元素是否为数组 - 如果是数组则展开后重新压入栈

- 非数组元素则添加到结果数组

- 使用

- 顺序保持

- 使用

unshift()将元素添加到结果数组前端,当然这样比较费性能,可以改用push()+reverse()替代unshift() - 确保最终结果的顺序与原数组一致

- 使用

优缺点

- 优点:

- 支持任意数据类型(不限于数字)

- 可以处理深层嵌套结构(无递归深度限制)

- 相比递归实现,不易导致栈溢出

- 缺点:

- 使用 unshift() 导致时间复杂度较高(O(n²))

- 需要额外空间存储栈结构

- 相比原生

flat()方法性能稍差 - 无法控制扁平化深度(总是完全扁平化)

适用场景

- 需要处理混合数据类型的深层嵌套数组

- 需要避免递归导致的栈溢出风险

7. 使用 Array.prototype.some() 和扩展运算符

function flatten(arr) {

// 循环检测数组中是否还包含数组元素

while (arr.some(item => Array.isArray(item))) {

// 使用扩展运算符展开当前层级的所有数组

// 并通过concat合并为一层

arr = [].concat(...arr);

}

return arr;

}

const nestedArr = [1, [2, [3, [4]], 5]];

console.log(flatten(nestedArr)); // [1, 2, 3, 4, 5]

解析:

- 循环条件检测

- 使用

arr.some()方法检测数组中是否还存在数组元素 Array.isArray(item)判断每个元素是否为数组

- 使用

- 层级展开

- 使用扩展运算符

...arr展开当前层级的数组 - 通过

[].concat()将展开的元素合并为新数组

- 使用扩展运算符

- 迭代处理

- 每次循环处理一层嵌套

- 重复直到没有数组元素存在

性能比较

对于大多数现代应用:

- 优先使用

flat(Infinity)(最简洁且性能良好) - 对于深度嵌套的大数组,考虑非递归的堆栈实现

- 递归方法在小数据集上表现良好且代码简洁

- 避免

toString()方法除非确定只有数字数据

总结

JavaScript 提供了多种扁平化数组的方法,从简单的内置 flat() 方法到各种手动实现的递归、迭代方案。选择哪种方法取决于:

- 运行环境是否支持 ES2019+

- 数据结构的复杂程度

- 对性能的要求

- 代码可读性需求

在大多数现代应用中,flat(Infinity) 是最佳选择,因为它简洁、高效且语义明确。

来源:juejin.cn/post/7522371045652578356

LangGraph深度解析:从零构建大模型工作流的终极指南

一. LangGraph简介

LangGraph 是基于 LangChain 的扩展框架,专为构建有状态(Stateful) 的大模型工作流而设计。它通过图结构(Graph)定义多个执行节点(Node)及其依赖关系,支持复杂任务编排,尤其适合多智能体协作、长对话管理等场景。

1.1 核心优势

- 状态持久化:自动维护任务执行过程中的上下文状态

- 灵活编排:支持条件分支、循环、并行等控制流

- 容错机制:内置错误重试、回滚策略

- 可视化调试:自动生成执行流程图

二. LangGraph最佳实践

2.1 基础代码结构

from langgraph.graph import StateGraph, END

from typing import TypedDict, Annotated

import operator

# 定义状态结构

class AgentState(TypedDict):

input: str

result: Annotated[list, operator.add] # 自动累积结果

# 初始化图

graph = StateGraph(AgentState)

# 添加节点与边(后续章节详解)

...

# 编译并运行

app = graph.compile()

result = app.invoke({"input": "任务描述"})

2.2 开发原则

模块化设计:每个节点只完成单一职责

状态最小化:仅保留必要数据,避免内存膨胀

幂等性保证:节点可安全重试

三. 状态设计(State Design)

3.1 状态定义规范

使用 Pydantic模型 或 TypedDict 明确状态结构:

from pydantic import BaseModel

class ProjectState(BaseModel):

requirements: str

draft_versions: list[str]

current_step: int

# 初始化状态

initial_state = ProjectState(

requirements="开发一个聊天机器人",

draft_versions=[],

current_step=0

)

3.2 状态自动管理

LangGraph通过注解(Annotation) 实现状态字段的自动更新:

from langgraph.graph import add_messages

class DialogState(TypedDict):

history: Annotated[list, add_messages] # 自动追加消息

def user_node(state: DialogState):

return {"history": ["用户: 你好"]}

def bot_node(state: DialogState):

return {"history": ["AI: 您好,有什么可以帮您?"]}

四. 节点函数(Node Functions)

4.1 节点定义标准

节点是工作流的基本单元,接收状态并返回更新:

from langchain_core.runnables import RunnableLambda

# 简单节点

def data_loader(state: dict):

return {"data": load_dataset(state["input"])}

# 包含LLM调用的节点

llm_node = RunnableLambda(

lambda state: {"answer": chat_model.invoke(state["question"])}

)

# 注册节点

graph.add_node("loader", data_loader)

graph.add_node("llm", llm_node)

4.2 多智能体协作

def designer_agent(state):

return {"design": "界面草图"}

def developer_agent(state):

return {"code": "实现代码"}

# 并行执行

graph.add_node("designer", designer_agent)

graph.add_node("developer", developer_agent)

graph.add_edge("designer", "reviewer")

graph.add_edge("developer", "reviewer")

五. 边的设计(Edge Design)

5.1 条件分支(Conditional Edges)

根据状态值动态路由:

from langgraph.graph import conditional_edge

def should_continue(state):

return "continue" if state["step"] < 5 else "end"

graph.add_conditional_edges(

source="decision_node",

path_map={"continue": "next_node", "end": END},

condition=should_continue

)

5.2 循环结构

graph.add_edge("start", "process")

graph.add_conditional_edges(

"process",

lambda s: "loop" if s["count"] < 3 else "end",

{"loop": "process", "end": END}

)

六. 错误处理(Error Handling)

6.1 重试机制

from langgraph.retry import RetryPolicy

policy = RetryPolicy(

max_retries=3,

backoff_factor=1.5,

retry_on=(Exception,)

)

graph.add_node(

"api_call",

api_wrapper.with_retry(policy)

)

6.2 回滚策略

def compensation_action(state):

# 执行补偿操作

rollback_transaction(state["tx_id"])

return {"status": "rolled_back"}

graph.add_edge("failed_node", "compensation")

graph.add_edge("compensation", END)

注:本文代码基于LangGraph 0.1+版本实现,需预先安装依赖:

pip install langgraph langchain pydantic

更多AI大模型应用开发学习内容,尽在聚客AI学院。

来源:juejin.cn/post/7501990822805618688

5 个理由告诉你为什么有了 JS 还要需要 TypeScript

在前端开发圈,JavaScript(简称JS)几乎无处不在。但你有没有发现,越来越多的大型项目和团队都在用 TypeScript(简称TS)?明明 JS 已经这么强大,为什么还要多此一举用 TS 呢?今天就用通俗易懂的语言,结合具体例子,带你彻底搞懂这个问题!🌟

1. JS的弱类型让大型项目“踩坑”不断

JavaScript 是一种弱类型语言,也就是说,变量的类型可以随时变化。虽然这让 JS 写起来很灵活,但在大型项目中却容易埋下隐患。

举个例子:

// JS 代码

function sum(a, b) {

return a + b;

}

console.log(sum(1, 2)); // 输出 3

console.log(sum('1', 2)); // 输出 '12',字符串拼接

console.log(sum(true, [])); // 输出 'true',奇怪的结果

在 JS 里,sum 函数参数类型完全不受限制,传什么都行。小项目还好,项目一大,团队一多,类型混乱就会导致各种难以发现的bug,甚至上线后才暴雷,影响开发效率和用户体验。

2. TS的类型检查让错误“消灭在摇篮里”

TypeScript 是 JS 的超集,在 JS 的基础上增加了类型系统。这意味着你可以在写代码时就发现类型错误,而不是等到运行时才发现。

同样的例子,用 TS 改写:

// TS 代码

function sum(a: number, b: number): number {

return a + b;

}

sum(1, 2); // 正常

sum('1', 2); // ❌ 报错:参数类型不匹配

TS 会在你写代码时就提示错误,防止类型不一致带来的 bug。这样,开发效率和代码质量都大大提升!

3. TS的类型推断让开发更智能

你可能担心,TS 要写很多类型声明,会不会很麻烦?其实不用担心,TS 有类型推断功能,能根据你的代码自动判断类型。

例子:

let age = 18; // TS 自动推断 age 是 number 类型

age = '二十'; // ❌ 报错:不能把 string 赋值给 number

你只需要在关键地方声明类型,其他地方 TS 会帮你自动推断,大大减少了重复劳动。

4. TS让团队协作更高效

在多人协作的大型项目中,TS 的类型系统就像一份“契约”,让每个人都能清楚知道每个函数、对象、变量的类型,极大减少沟通成本和踩坑概率。

例子:

// 定义一个工具函数

function formatUser(user: { name: string; age: number }) {

return `${user.name} (${user.age})`;

}

// 调用时,TS 会自动检查参数类型

formatUser({ name: '小明', age: 20 }); // 正常

formatUser({ name: '小红', age: '二十' }); // ❌ 报错

有了类型约束,团队成员只要看类型定义就能明白怎么用,不用再靠口头说明或文档补充,协作效率大大提升。

5. TS支持现代开发工具,体验更丝滑

TS 的类型信息可以被编辑器和IDE(如 VSCode)利用,带来更智能的自动补全、跳转、重构、查找引用等功能,让开发体验飞升!

例子:

- 输入对象名时,编辑器会自动提示有哪些属性;

- 修改类型定义,相关代码会自动高亮出错,方便全局重构;

- 查找函数引用时,TS 能精确定位所有用到的地方。

这些功能在 JS 里是做不到的,TS 让开发更高效、更安全、更快乐! 😄

TS的常见类型一览表

| 类型 | 说明 | 示例 |

|---|---|---|

| any | 任意类型 | let a: any |

| unknown | 未知类型 | let b: unknown |

| never | 永不存在的类型 | function error(): never { throw new Error() } |

| string | 字符串 | let s: string |

| number | 数字 | let n: number |

| boolean | 布尔 | let b: boolean |

| null | 空 | let n: null |

| undefined | 未定义 | let u: undefined |

| symbol | 符号 | let s: symbol |

| bigint | 大整数 | let b: bigint |

| object | 狭义对象类型 | let o: object |

| Object | 广义对象类型 | let O: Object |

小贴士:

any虽然灵活,但会失去类型检查,不推荐使用;unknown更安全,推荐用来接收不确定类型的数据。

TS的安装与使用

TypeScript 的安装和使用也非常简单:

npm install -g typescript

npm install -g ts-node

typescript用于编译.ts文件, 在当前目录生成一个同名的.js文件;ts-node可以直接运行 TS 文件,开发更方便。

总结

有了 JS,为什么还要用 TS?

归根结底,TS 让代码更安全、开发更高效、协作更顺畅、体验更丝滑。尤其是在大型项目和团队协作中,TS 的优势会越来越明显。

5个理由再回顾:

- JS 弱类型,容易埋坑,TS 静态类型,提前发现错误;

- TS 类型检查,bug 消灭在摇篮里;

- TS 类型推断,开发更智能;

- TS 类型约束,团队协作更高效;

- TS 支持现代开发工具,体验更丝滑。

如果你还没用过 TypeScript,不妨试试,相信你会爱上它!💙

来源:juejin.cn/post/7525660078722154511

你不会使用css函数 clamp()?那你太low了😀

我们做前端的,为了让网站在不同设备上都好看,天天都在和“响应式”打交道。其中最常见的一个场景,就是处理字体大小。

通常,我们是这么做的:

/* 手机上是16px */

h1 {

font-size: 16px;

}

/* 平板上大一点 */

@media (min-width: 768px) {

h1 {

font-size: 24px;

}

}

/* 电脑上再大一点 */

@media (min-width: 1200px) {

h1 {

font-size: 32px;

}

}

这套代码能用,但它有一个问题:字体大小的变化,是“跳跃式”的,像在走楼梯。 当你的屏幕宽度从767px变成768px时,字体会“Duang”地一下突然变大。这种体验,不够平滑。

今天,我想聊一个能让我们告别大部分这种繁琐媒体查询的CSS函数:clamp()。它能让我们的元素尺寸,像在走一个平滑的斜坡一样,实现真正的 “流体式”缩放。

clamp() 到底是个啥?

clamp() 的中文意思是“夹子”或“钳子”,非常形象。它的作用就是把一个值的范围,“夹”在一个最大值和一个最小值之间。

它的语法极其简单:

width: clamp(最小值, 理想值, 最大值);

你可以把它理解成,你在设定一个规则:

最小值(MIN) :这是“下限”。不管怎么样,这个值都不能比它更小了。最大值(MAX) :这是“上限”。不管怎么样,这个值都不能比它更大了。理想值(IDEAL) :这是“首选值”。它通常是一个根据视口变化的相对单位,比如vw。浏览器会先尝试使用这个值。

它的工作逻辑是:

- 如果“理想值”小于“最小值”,那就取“最小值”。

- 如果“理想值”大于“最大值”,那就取“最大值”。

- 如果“理想值”在两者之间,那就取“理想值”。

使用场景:流体字号(Fluid Typography)

这是clamp()最经典,也是最强大的用途。我们来改造一下文章开头的那个例子。

以前(媒体查询版):

h1 { font-size: 16px; }

@media (min-width: 768px) { h1 { font-size: 24px; } }

@media (min-width: 1200px) { h1 { font-size: 32px; } }

现在(clamp()版):

h1 {

/* 最小值是16px,

理想值是视口宽度的4%,

最大值是32px。

*/

font-size: clamp(16px, 4vw, 32px);

}

看,一行代码,代替了原来的一堆媒体查询。

现在你拖动浏览器窗口,会发现标题的大小是在平滑地、线性地变化,而不是“阶梯式”地跳变。它在小屏幕上不会小于16px,在大屏幕上不会大于32px,而在中间的尺寸,它会根据4vw这个值自动调整。

使用场景:动态间距(Dynamic Spacing)

clamp() 不仅仅能用在font-size上,任何需要长度值的地方,比如margin, padding, gap,它都能大显身手。

我们可以用它来创建一个“呼吸感”更强的布局。

.grid-container {

display: grid;

/* 网格间距最小15px,最大40px,中间根据视口宽度5%来缩放 */

gap: clamp(15px, 5vw, 40px);

}

.section {

/* section的上下内边距,最小20px,最大100px */

padding-top: clamp(20px, 10vh, 100px);

padding-bottom: clamp(20px, 10vh, 100px);

}

这样做的好处是,你的布局在任何尺寸的屏幕上,都能保持一个和谐的、自适应的间距,不再需要为不同断点去写多套padding和gap的值。

结合 calc() 实现更精准的控制

有时候,我们不希望缩放是纯线性的vw,而是希望它有一个“基础值”,然后再根据vw去微调。这时候,clamp()可以和calc()结合使用。

h1 {

/* 理想值不再是单纯的3vw,

而是 1rem + 3vw。

这意味着它有一个1rem的基础大小,然后再叠加上与视口相关的部分。

*/

font-size: clamp(1.5rem, calc(1rem + 3vw), 3rem);

}

这个calc(1rem + 3vw)的公式,是一个非常流行和实用的流体排版计算方法。它能让你对字体大小的缩放速率有更精细的控制,是一个非常值得收藏的技巧。

兼容性如何呢?

你可能会担心浏览器的兼容性。

好消息是,在2025年的今天,clamp()已经在所有主流现代浏览器(Chrome, Firefox, Safari, Edge)中获得了良好支持。除非你的项目需要兼容非常古老的浏览器,否则完全可以放心在生产环境中使用。

下次,当你又准备写一堆媒体查询来控制字号或间距时,不妨先停下来,问问自己:

“这个场景,是不是用clamp()一行代码就能搞定?”

希望你试试看😀。

参考:

来源:juejin.cn/post/7527576206695776302

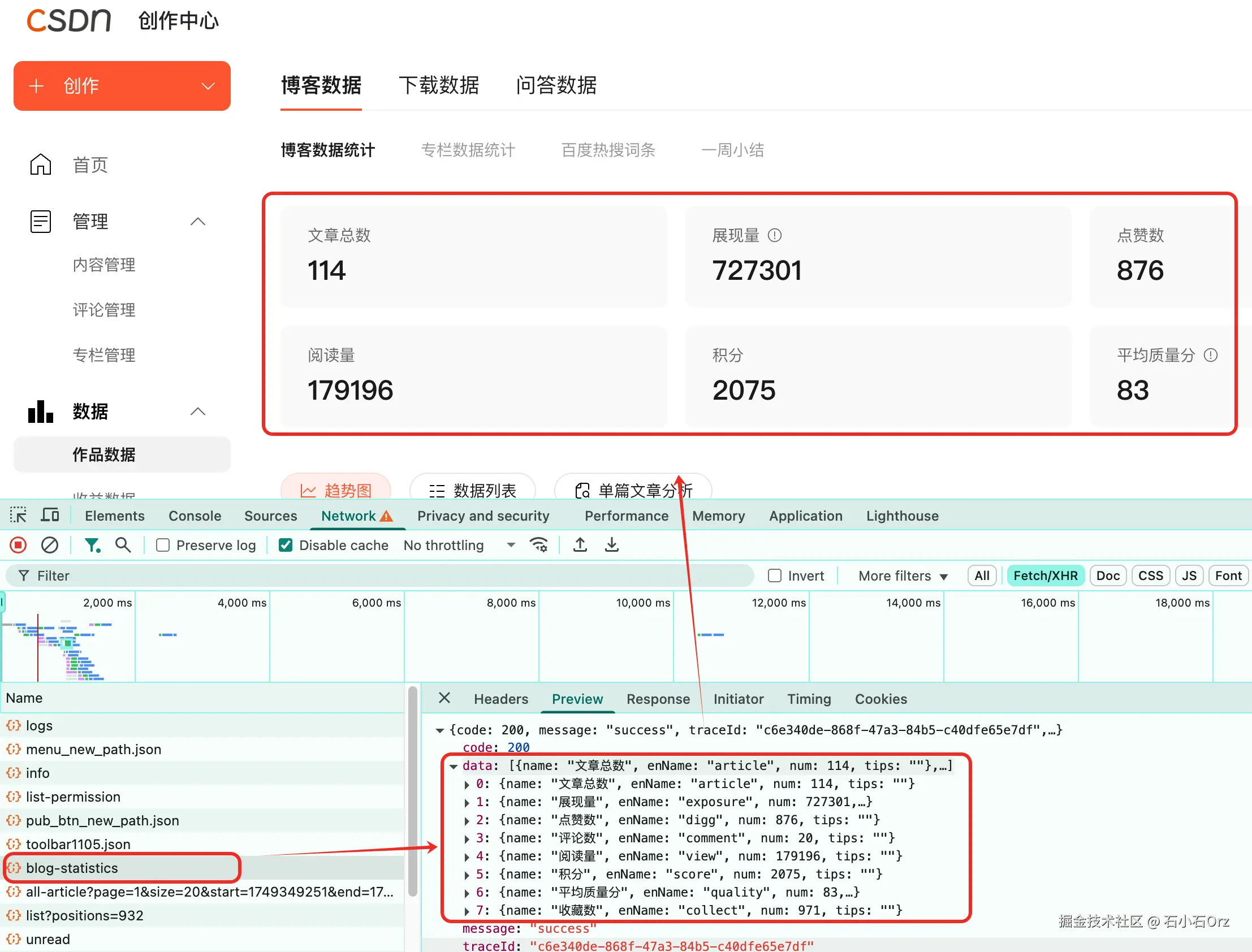

调试 WebView 旧资源缓存问题:一次从偶发到复现的实战经历

移动端 WebView 与浏览器最大的差异之一就是缓存机制:浏览器支持 DevTools 清理缓存、更新资源非常便利;而 WebView 在 App 中受系统 WebView 组件和应用缓存策略影响,经常会出现资源更新后,部分用户仍加载老版本 JS/CSS,引发奇怪的线上问题。

这类问题难点在于:不是所有用户都能复现,只有特定设备/网络环境/升级路径才会触发。以下是我们在一个活动页迭代中解决用户加载到老版本脚本的问题记录。

背景:活动页面更新后部分用户功能异常

活动页面上线后,我们修复了一个按钮点击无效的 bug,并发布了新 JS 资源。大部分用户恢复正常,但个别用户仍反馈点击无响应。

通过埋点数据统计,这类异常只占总 PV 的 1~2%,但因影响实际参与,必须解决。

第一步:判断用户是否加载到新资源

通过后端接口返回的页面版本号,我们在埋点中发现异常用户请求的是最新页面 HTML,但 HTML 中引用的 JS 文件版本却是旧文件。

我们用 Charles 配合 WebDebugX,在问题设备上连接调试,确认请求路径:

https://cdn.example.com/activity/v1.2.0/main.js

服务器早已上线 v1.3.0 文件,但部分设备仍强制加载 v1.2.0。这说明浏览器或 WebView 从缓存中读取了过期资源。

第二步:复现问题与验证缓存机制

通过 Charles 的 Map Local 功能,我们在真机上强制模拟返回旧版 main.js,验证页面表现是否与用户反馈一致。结果按钮再次失效,证明旧资源是问题根源。

然后用 WebDebugX 查看资源请求的响应 header,确认服务器已正确返回 Cache-Control:

Cache-Control: no-cache, max-age=0

理论上应强制重新拉取最新资源,但部分 Android WebView 未执行 no-cache,而是优先使用 local cache。

第三步:排查 WebView 缓存策略差异

我们协助移动端团队通过 Logcat 查看 WebView 请求日志,发现部分机型仍启用了 LOAD_DEFAULT 缓存模式,该模式下只要缓存有效期内,就会使用本地缓存资源,即便服务器指示不缓存也无法生效。

而大部分新系统使用了 LOAD_NO_CACHE 或 LOAD_CACHE_ELSE_NETWORK,能更好地遵循服务器缓存头。

第四步:修复方案设计

针对缓存策略问题,我们制定了双向修复方案:

短期前端方案

- 在资源引用 URL 中增加强制更新参数:

<script src="https://cdn.example.com/activity/main.js?v=20240601"></script>

- 每次版本发布更新

v参数,确保请求路径变化,从而绕开缓存。

中期后端方案

- 通过 CDN 配置给静态文件加上不可缓存策略,确保 CDN 节点不会继续提供过期资源。

长期客户端方案

- 移动端团队将 WebView 缓存策略统一改为

LOAD_NO_CACHE模式,彻底解决旧资源被缓存的问题。

第五步:验证全流程有效性

修复完成后,我们用以下方法进行多角度验证:

- 使用 Charles 观察请求地址是否携带新版本参数;

- 在 WebDebugX 中查看页面是否加载了最新资源;

- 在 QA 部门用多台低端机和慢网环境回归测试,模拟网络断开重连、App 冷启动后资源拉取表现;

- 监控埋点数据中页面版本和资源版本是否完全一致,确认没有用户再加载到老资源。

最终确认异常用户比例下降到 0%。

工具与协作流程

此次缓存问题排查中,我们的调试和分工是:

| 工具 | 用途 | 使用人 |

|---|---|---|

| WebDebugX | 查看资源加载路径、响应 header | 前端 / QA |

| Charles | 模拟缓存场景、观察真实请求 | 前端 |

| Logcat | 验证 WebView 缓存模式 | 移动端 |

| Vysor | 复现低端设备表现、录制操作过程 | QA |

总结:缓存问题的解决要从端到端出发

缓存问题不是“前端清理一下”就能解决,它涉及:

浏览器/WebView 端缓存策略;

后端或 CDN 返回的缓存头;

前端 URL 版本控制;

不同系统/厂商 WebView 兼容性。

要彻底消除老资源顽固缓存,必须让服务器、前端、客户端配置形成闭环。

调试工具(WebDebugX、Charles、Logcat)可以帮助我们还原资源加载链条,但核心是对缓存机制的整体认知与各端的配合。

来源:juejin.cn/post/7522187483762966579

用 Tauri + FFmpeg + Whisper.cpp 从零打造本地字幕生成器

背景:

最近开始尝试做自媒体,录点视频。刚开始就遇到了字幕的问题,于是想先搞个字幕生成工具(为了这点醋才包的这顿饺子😄):SubGen。

这个工具用 Tauri + Rust 做外壳,把 FFmpeg 和 Whisper.cpp 集成进去,能一键把视频转成 SRT 字幕。

这篇文章记录下笔者做这个工具的过程,也分享下用到的核心组件和代码结构。

架构设计

SubGen 采用分层架构,核心组件的交互关系如下:

┌─────────────┐ ┌──────────────┐

│ React UI │ │ Rust Core │

│ (TypeScript)│ <----> │ (Tauri API) │

└─────────────┘ └─────┬────────┘

│

┌─────────────┴───────────────┐

│ │

┌────▼────┐ ┌────▼────┐

│ FFmpeg │ │Whisper │

│ 提取音频 │ │ 离线识别 │

└─────────┘ └─────────┘

为什么用 Tauri?

最开始笔者也考虑过 Electron,但它打包太大了(动辄 100MB 起步),而且资源占用高。后来发现 Tauri,它用 Rust 做后端,前端还是用 React 或者任意 Web 技术,这样:

- 打包后体积很小(十几 MB)。

- 跨平台方便(Windows / macOS / Linux)。

- Rust 调用本地二进制(FFmpeg 和 Whisper)非常顺手。

笔者主要是用 React + TypeScript 写了一个简单的 UI,用户选视频、点按钮,剩下的活就交给 Rust。

FFmpeg:用它来“扒”音频

FFmpeg 是老牌的音视频处理工具了,笔者直接内置了一个编译好的 ffmpeg.exe/ffmpeg 到资源目录,调用它来:

- 从视频里抽出音频。

- 统一格式(16kHz,单声道 WAV),让 Whisper 可以直接处理。

Rust 这边的调用很简单:

use std::process::Command;

Command::new("resources/ffmpeg")

.args(["-i", &video_path, "-ar", "16000", "-ac", "1", "audio.wav"])

.status()

.expect("FFmpeg 执行失败");

这样一行命令就能把视频转成标准 WAV。

Whisper.cpp:核心的离线识别

笔者选的是 Whisper.cpp,因为它比 Python 版 Whisper 更轻量,直接编译一个 whisper-cli 就能用,不需要装乱七八糟的依赖。

更重要的一点是支持CPU运行,默认4个线程,即使用 ggml-large-v3 也可以跑出来结果,只是稍微慢点。这对于没有好的显卡的童鞋很有用!

调用命令大概是这样:

whisper-cli -m ggml-small.bin -f audio.wav -osrt -otxt

最后会输出一个 output.srt,直接能用。

Rust 里调用也是 Command::new() 一把梭:

Command::new("resources/whisper-cli")

.args(["-m", "resources/models/ggml-small.bin", "-f", "audio.wav", "-l", "zh", "--output-srt"])

.status()

.expect("Whisper 执行失败");

代码结构和流程

笔者的项目大概是这样分层的:

subgen/

├── src/ # 前端 React + TypeScript

│ └── main.tsx # UI入口

├── src-tauri/ # Tauri + Rust

│ ├── commands.rs # Rust命令逻辑

│ ├── resources/ # ffmpeg、whisper二进制、模型文件

│ └── main.rs # 程序入口

前端用 @tauri-apps/api 的 invoke 调 Rust:

import { invoke } from '@tauri-apps/api';

async function handleGenerate(videoPath: string) {

const result = await invoke<string>('extract_subtitles', { videoPath });

console.log('字幕生成完成:', result);

}

Rust 后端的核心命令:

#[tauri::command]

fn extract_subtitles(video_path: String) -> Result<String, String> {

// 1. 调 FFmpeg

// 2. 调 Whisper.cpp

// 3. 返回 SRT 路径

Ok("output.srt".to_string())

}

用下来的感受

整个工具现在已经能做到“拖进视频 → 等几十秒 → 出字幕”这种体验了。

几个感受:

- Tauri 真香:比 Electron 清爽太多,Rust 后端很适合做这些底层调用。

- FFmpeg 是万能的,直接抽音频,性能还不错。

- Whisper.cpp 虽然 CPU 跑慢点,但好在准确率挺高,还不用联网。

后续想做的事

- 支持批量处理视频。

- 集成一个简单的字幕编辑功能。

- 尝试 GPU 加速 Whisper(Metal / Vulkan)。

截图

主界面:

生成的 SRT:

如果你也想做个自己的字幕工具,可以直接参考 SubGen 的架构,自己改改就能用。

代码已开源:github.com/byteroycai/…

来源:juejin.cn/post/7528457291697012774

jwt,过滤器,拦截器用法和介绍

jwt,过滤器,拦截器介绍

JWT令牌

JWT介绍

JWT全称 JSON Web Token 。

jwt可以将原始的json数据格式进行安全的封装,这样就可以直接基于jwt在通信双方安全的进行信息传输了。

JWT全称 JSON Web Token 。

jwt可以将原始的json数据格式进行安全的封装,这样就可以直接基于jwt在通信双方安全的进行信息传输了。

JWT的组成

JWT令牌由三个部分组成,三个部分之间使用英文的点来分割

- 第一部分:Header(头), 记录令牌类型、签名算法等。 例如:{"alg":"HS256","type":"JWT"}

- 第二部分:Payload(有效载荷),携带一些自定义信息、默认信息等。 例如:{"id":"1","username":"Tom"}

- 第三部分:Signature(签名),防止Token被篡改、确保安全性。将header、payload,并加入指定秘钥,通过指定签名算法计算而来。

JWT令牌由三个部分组成,三个部分之间使用英文的点来分割

- 第一部分:Header(头), 记录令牌类型、签名算法等。 例如:{"alg":"HS256","type":"JWT"}

- 第二部分:Payload(有效载荷),携带一些自定义信息、默认信息等。 例如:{"id":"1","username":"Tom"}

- 第三部分:Signature(签名),防止Token被篡改、确保安全性。将header、payload,并加入指定秘钥,通过指定签名算法计算而来。

JWT将原始的JSON格式数据转变为字符串的方式:

- 其实在生成JWT令牌时,会对JSON格式的数据进行一次编码:进行base64编码

- Base64:是一种基于64个可打印的字符来表示二进制数据的编码方式。既然能编码,那也就意味着也能解码。所使用的64个字符分别是A到Z、a到z、 0- 9,一个加号,一个斜杠,加起来就是64个字符。任何数据经过base64编码之后,最终就会通过这64个字符来表示。当然还有一个符号,那就是等号。等号它是一个补位的符号

- 需要注意的是Base64是编码方式,而不是加密方式。

- 其实在生成JWT令牌时,会对JSON格式的数据进行一次编码:进行base64编码

- Base64:是一种基于64个可打印的字符来表示二进制数据的编码方式。既然能编码,那也就意味着也能解码。所使用的64个字符分别是A到Z、a到z、 0- 9,一个加号,一个斜杠,加起来就是64个字符。任何数据经过base64编码之后,最终就会通过这64个字符来表示。当然还有一个符号,那就是等号。等号它是一个补位的符号

- 需要注意的是Base64是编码方式,而不是加密方式。

生成和校验

1.要想使用JWT令牌,需要先引入JWT的依赖:

<dependency>

<groupId>io.jsonwebtokengroupId>

<artifactId>jjwtartifactId>

<version>0.9.1version>

dependency>

引入完JWT来赖后,就可以调用工具包中提供的API来完成JWT令牌的生成和校验。

2.生成JWT代码实现:

@Test

public void testGenJwt() {

Map<String, Object> claims = new HashMap<>();

claims.put("id", 10);

claims.put("username", "itheima");

String jwt = Jwts.builder().signWith(SignatureAlgorithm.HS256, "aXRjYXN0")

.addClaims(claims)

.setExpiration(new Date(System.currentTimeMillis() + 12 * 3600 * 1000))

.compact();

System.out.println(jwt);

}

- 实现了JWT令牌的生成,下面我们接着使用Java代码来校验JWT令牌(解析生成的令牌):

@Test

public void testParseJwt() {

Claims claims = Jwts.parser().setSigningKey("aXRjYXN0")

.parseClaimsJws("eyJhbGciOiJIUzI1NiJ9.eyJpZCI6MTAsInVzZXJuYW1lIjoiaXRoZWltYSIsImV4cCI6MTcwMTkwOTAxNX0.N-MD6DmoeIIY5lB5z73UFLN9u7veppx1K5_N_jS9Yko")

.getBody();

System.out.println(claims);

}

1.要想使用JWT令牌,需要先引入JWT的依赖:

<dependency>

<groupId>io.jsonwebtokengroupId>

<artifactId>jjwtartifactId>

<version>0.9.1version>

dependency>

引入完JWT来赖后,就可以调用工具包中提供的API来完成JWT令牌的生成和校验。

2.生成JWT代码实现:

@Test

public void testGenJwt() {

Map<String, Object> claims = new HashMap<>();

claims.put("id", 10);

claims.put("username", "itheima");

String jwt = Jwts.builder().signWith(SignatureAlgorithm.HS256, "aXRjYXN0")

.addClaims(claims)

.setExpiration(new Date(System.currentTimeMillis() + 12 * 3600 * 1000))

.compact();

System.out.println(jwt);

}

- 实现了JWT令牌的生成,下面我们接着使用Java代码来校验JWT令牌(解析生成的令牌):

@Test

public void testParseJwt() {

Claims claims = Jwts.parser().setSigningKey("aXRjYXN0")

.parseClaimsJws("eyJhbGciOiJIUzI1NiJ9.eyJpZCI6MTAsInVzZXJuYW1lIjoiaXRoZWltYSIsImV4cCI6MTcwMTkwOTAxNX0.N-MD6DmoeIIY5lB5z73UFLN9u7veppx1K5_N_jS9Yko")

.getBody();

System.out.println(claims);

}

篡改令牌中的任何一个字符,在对令牌进行解析时都会报错,所以JWT令牌是非常安全可靠的。

JWT令牌过期后,令牌就失效了,解析的为非法令牌。

过滤器Filter

Filter介绍

- Filter表示过滤器,是 JavaWeb三大组件(Servlet、Filter、Listener)之一。

- 过滤器可以把对资源的请求拦截下来,从而实现一些特殊的功能

- 使用了过滤器之后,要想访问web服务器上的资源,必须先经过滤器,过滤器处理完毕之后,才可以访问对应的资源。

- 过滤器一般完成一些通用的操作,比如:登录校验、统一编码处理、敏感字符处理等。

- 使用了过滤器之后,要想访问web服务器上的资源,必须先经过滤器,过滤器处理完毕之后,才可以访问对应的资源。

定义过滤器

public class DemoFilter implements Filter {

//初始化方法, web服务器启动, 创建Filter实例时调用, 只调用一次

public void init(FilterConfig filterConfig) throws ServletException {

System.out.println("init ...");

}

//拦截到请求时,调用该方法,可以调用多次

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain chain) throws IOException, ServletException {

System.out.println("拦截到了请求...");

}

//销毁方法, web服务器关闭时调用, 只调用一次

public void destroy() {

System.out.println("destroy ... ");

}

}

public class DemoFilter implements Filter {

//初始化方法, web服务器启动, 创建Filter实例时调用, 只调用一次

public void init(FilterConfig filterConfig) throws ServletException {

System.out.println("init ...");

}

//拦截到请求时,调用该方法,可以调用多次

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain chain) throws IOException, ServletException {

System.out.println("拦截到了请求...");

}

//销毁方法, web服务器关闭时调用, 只调用一次

public void destroy() {

System.out.println("destroy ... ");

}

}

配置过滤器

在定义完Filter之后,Filter其实并不会生效,还需要完成Filter的配置,Filter的配置非常简单,只需要在Filter类上添加一个注解:@WebFilter,并指定属性urlPatterns,通过这个属性指定过滤器要拦截哪些请求

@WebFilter(urlPatterns = "/*") //配置过滤器要拦截的请求路径( /* 表示拦截浏览器的所有请求 )

public class DemoFilter implements Filter {

//初始化方法, web服务器启动, 创建Filter实例时调用, 只调用一次

public void init(FilterConfig filterConfig) throws ServletException {

System.out.println("init ...");

}

//拦截到请求时,调用该方法,可以调用多次

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain chain) throws IOException, ServletException {

System.out.println("拦截到了请求...");

}

//销毁方法, web服务器关闭时调用, 只调用一次

public void destroy() {

System.out.println("destroy ... ");

}

}

在Filter类上面加了@WebFilter注解之后,还需要在启动类上面加上一个注解@ServletComponentScan,通过这个@ServletComponentScan注解来开启SpringBoot项目对于Servlet组件的支持。

@ServletComponentScan //开启对Servlet组件的支持

@SpringBootApplication

public class TliasManagementApplication {

public static void main(String[] args) {

SpringApplication.run(TliasManagementApplication.class, args);

}

}

在过滤器Filter中,如果不执行放行操作,将无法访问后面的资源。 放行操作:chain.doFilter(request, response);

过滤器的执行流程

过滤器当中我们拦截到了请求之后,如果希望继续访问后面的web资源,就要执行放行操作,放行就是调用 FilterChain对象当中的doFilter()方法,在调用doFilter()这个方法之前所编写的代码属于放行之前的逻辑。

测试代码:

@WebFilter(urlPatterns = "/*")

public class DemoFilter implements Filter {

@Override //初始化方法, 只调用一次

public void init(FilterConfig filterConfig) throws ServletException {

System.out.println("init 初始化方法执行了");

}

@Override

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain filterChain) throws IOException, ServletException {

System.out.println("DemoFilter 放行前逻辑.....");

//放行请求

filterChain.doFilter(servletRequest,servletResponse);

System.out.println("DemoFilter 放行后逻辑.....");

}

@Override //销毁方法, 只调用一次

public void destroy() {

System.out.println("destroy 销毁方法执行了");

}

}

过滤器的拦截路径配置

| 拦截路径 | urlPatterns值 | 含义 |

|---|---|---|

| 拦截具体路径 | /login | 只有访问 /login 路径时,才会被拦截 |

| 目录拦截 | /emps/* | 访问/emps下的所有资源,都会被拦截 |

| 拦截所有 | /* | 访问所有资源,都会被拦截 |

测试代码:

@WebFilter(urlPatterns = "/login") //拦截/login具体路径

public class DemoFilter implements Filter {

@Override

public void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain filterChain) throws IOException, ServletException {

System.out.println("DemoFilter 放行前逻辑.....");

//放行请求

filterChain.doFilter(servletRequest,servletResponse);

System.out.println("DemoFilter 放行后逻辑.....");

}

@Override

public void init(FilterConfig filterConfig) throws ServletException {

Filter.super.init(filterConfig);

}

@Override

public void destroy() {

Filter.super.destroy();

}

}

过滤器链

过滤器链指的是在一个web应用程序当中,可以配置多个过滤器,多个过滤器就形成了一个过滤器链。

过滤器链上过滤器的执行顺序:注解配置的Filter,优先级是按照过滤器类名(字符串)的自然排序。 比如:

- AbcFilter

- DemoFilter

这两个过滤器来说,AbcFilter 会先执行,DemoFilter会后执行。

拦截器Interceptor

- 拦截器是一种动态拦截方法调用的机制,类似于过滤器。

- 拦截器是Spring框架中提供的,用来动态拦截控制器方法的执行。

- 拦截器的作用:拦截请求,在指定方法调用前后,根据业务需要执行预先设定的代码。

自定义拦截器

实现HandlerInterceptor接口,并重写其所有方法

//自定义拦截器

@Component

public class DemoInterceptor implements HandlerInterceptor {

//目标资源方法执行前执行。 返回true:放行 返回false:不放行

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

System.out.println("preHandle .... ");

return true; //true表示放行

}

//目标资源方法执行后执行

@Override

public void postHandle(HttpServletRequest request, HttpServletResponse response, Object handler, ModelAndView modelAndView) throws Exception {

System.out.println("postHandle ... ");

}

//视图渲染完毕后执行,最后执行

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

System.out.println("afterCompletion .... ");

}

}

- preHandle方法:目标资源方法执行前执行。 返回true:放行 返回false:不放行

- postHandle方法:目标资源方法执行后执行

- afterCompletion方法:视图渲染完毕后执行,最后执行

注册配置拦截器

在 com.itheima下创建一个包,然后创建一个配置类 WebConfig, 实现 WebMvcConfigurer 接口,并重写 addInterceptors 方法

@Configuration

public class WebConfig implements WebMvcConfigurer {

//自定义的拦截器对象

@Autowired

private DemoInterceptor demoInterceptor;

@Override

public void addInterceptors(InterceptorRegistry registry) {

//注册自定义拦截器对象

registry.addInterceptor(demoInterceptor).addPathPatterns("/**");//设置拦截器拦截的请求路径( /** 表示拦截所有请求)

}

}

拦截器的拦截路径配置

首先我们先来看拦截器的拦截路径的配置,在注册配置拦截器的时候,我们要指定拦截器的拦截路径,通过addPathPatterns("要拦截路径")方法,就可以指定要拦截哪些资源。

在入门程序中我们配置的是/**,表示拦截所有资源,而在配置拦截器时,不仅可以指定要拦截哪些资源,还可以指定不拦截哪些资源,只需要调用excludePathPatterns("不拦截路径")方法,指定哪些资源不需要拦截。

@Configuration

public class WebConfig implements WebMvcConfigurer {

//拦截器对象

@Autowired

private DemoInterceptor demoInterceptor;

@Override

public void addInterceptors(InterceptorRegistry registry) {

//注册自定义拦截器对象

registry.addInterceptor(demoInterceptor)

.addPathPatterns("/**")//设置拦截器拦截的请求路径( /** 表示拦截所有请求)

.excludePathPatterns("/login");//设置不拦截的请求路径

}

}

在拦截器中除了可以设置/**拦截所有资源外,还有一些常见拦截路径设置:

| 拦截路径 | 含义 | 举例 |

|---|---|---|

| /* | 一级路径 | 能匹配/depts,/emps,/login,不能匹配 /depts/1 |

| /** | 任意级路径 | 能匹配/depts,/depts/1,/depts/1/2 |

| /depts/* | /depts下的一级路径 | 能匹配/depts/1,不能匹配/depts/1/2,/depts |

| /depts/** | /depts下的任意级路径 | 能匹配/depts,/depts/1,/depts/1/2,不能匹配/emps/1 |

拦截器的执行流程

- 当我们打开浏览器来访问部署在web服务器当中的web应用时,此时我们所定义的过滤器会拦截到这次请求。拦截到这次请求之后,它会先执行放行前的逻辑,然后再执行放行操作。而由于我们当前是基于springboot开发的,所以放行之后是进入到了spring的环境当中,也就是要来访问我们所定义的controller当中的接口方法。

- Tomcat并不识别所编写的Controller程序,但是它识别Servlet程序,所以在Spring的Web环境中提供了一个非常核心的Servlet:DispatcherServlet(前端控制器),所有请求都会先进行到DispatcherServlet,再将请求转给Controller。

- 当我们定义了拦截器后,会在执行Controller的方法之前,请求被拦截器拦截住。执行

preHandle()方法,这个方法执行完成后需要返回一个布尔类型的值,如果返回true,就表示放行本次操作,才会继续访问controller中的方法;如果返回false,则不会放行(controller中的方法也不会执行)。 - 在controller当中的方法执行完毕之后,再回过来执行

postHandle()这个方法以及afterCompletion() 方法,然后再返回给DispatcherServlet,最终再来执行过滤器当中放行后的这一部分逻辑的逻辑。执行完毕之后,最终给浏览器响应数据。

preHandle()方法,这个方法执行完成后需要返回一个布尔类型的值,如果返回true,就表示放行本次操作,才会继续访问controller中的方法;如果返回false,则不会放行(controller中的方法也不会执行)。postHandle()这个方法以及afterCompletion() 方法,然后再返回给DispatcherServlet,最终再来执行过滤器当中放行后的这一部分逻辑的逻辑。执行完毕之后,最终给浏览器响应数据。过滤器和拦截器之间的区别:

- 接口规范不同:过滤器需要实现Filter接口,而拦截器需要实现HandlerInterceptor接口。

- 拦截范围不同:过滤器Filter会拦截所有的资源,而Interceptor只会拦截Spring环境中的资源。

作者:丧心病狂汤姆猫

来源:juejin.cn/post/7527869985345339392

来源:juejin.cn/post/7527869985345339392

从HTTP到HTTPS

当你在浏览器里输入 http://www.example.com 并按下回车,看似平平无奇的一次访问,其实暗藏着 SSL/TLS 的三次握手、对称与非对称加密的轮番上阵、CA 证书的“身份核验”以及防中间人攻击的多重机关。

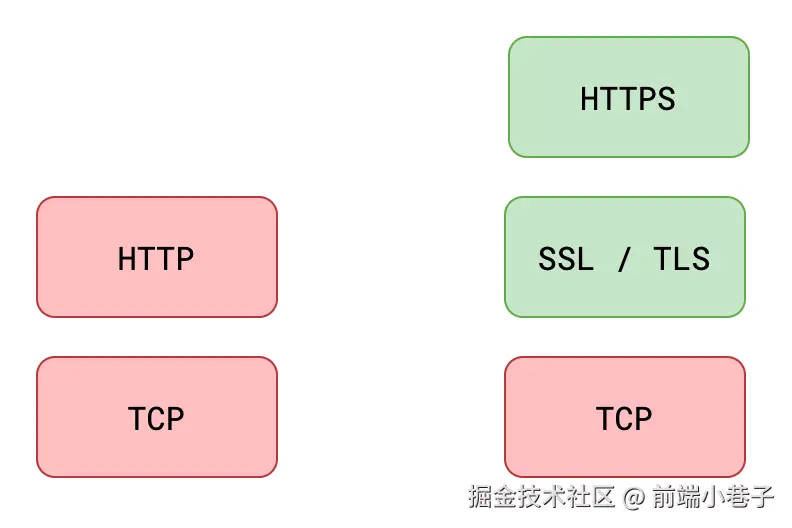

一、SSL、TLS、HTTPS 到底是什么关系?

- SSL(Secure Sockets Layer):早期网景公司设计的加密协议,1999 年后停止更新。

- TLS(Transport Layer Security):SSL 的直系升级版,目前主流版本为 TLS 1.2/1.3。

- HTTPS:把 HTTP 报文塞进 TLS 的“安全信封”里,再交给 TCP 传输。简而言之,HTTPS = HTTP + TLS/SSL。

二、HTTPS 握手

- ClientHello

浏览器把支持的加密套件、随机数 A、TLS 版本号一起发给服务器。 - ServerHello + 证书

服务器挑一套加密算法,返回随机数 B,并附上自己的数字证书(含公钥)。 - 验证证书 + 生成会话密钥

浏览器先给证书“验明正身”——颁发机构是否可信、证书是否被吊销、域名是否匹配。

验证通过后,浏览器生成随机数 C(Pre-Master-Secret),用服务器证书里的公钥加密后发送。双方根据 A、B、C 算出同一把对称密钥。 - Finished

双方都用这把对称密钥加密一条“Finished”消息互发,握手完成。之后的所有 HTTP 数据都用这把对称密钥加解密,速度快、强度高。

三、为什么必须有 CA?

没有 CA,任何人都可以伪造公钥,中间人攻击将防不胜防。CA 通过可信第三方背书,把“公钥属于谁”这件事写死在证书里,浏览器才能放心地相信“这就是真正的服务器”。

四、证书到底怎么防伪?

证书 = 域名 + 公钥 + 有效期 + CA 数字签名。

CA(Certificate Authority)用自己的私钥对整个证书做哈希签名。浏览器内置 CA 公钥,可解密签名并对比哈希值,一旦被篡改就立即报警。

没有 CA 签名的自签证书?浏览器会毫不留情地显示“红色警告”。

五、对称与非对称加密的分工

- 非对称加密(RSA/ECC):只在握手阶段用一次,解决“如何安全地交换对称密钥”。

- 对称加密(AES/ChaCha20):握手完成后,所有 HTTP 报文都用对称密钥加解密,性能高、延迟低。

一句话:非对称加密“送钥匙”,对称加密“锁大门”。

六、中间人攻击的两张面孔

- SSL 劫持

攻击者伪造证书、偷梁换柱。浏览器会提示证书错误,但不少用户习惯性点击“继续访问”,于是流量被窃听。 - SSL 剥离

攻击者把用户的 HTTPS 请求降级成 HTTP,服务器以为在加密,客户端却在明文裸奔。HSTS(HTTP Strict Transport Security)能强制浏览器只走 HTTPS,遏制这种降级。

总结

- 证书是身-份-证,CA 是公安局。

- 非对称握手送钥匙,对称加密跑数据。

- 没有 CA 的 HTTPS,就像没有钢印的合同——谁都能伪造。

下次当你在地址栏看到那把绿色小锁时,背后是一场涉及四次握手、两把密钥、一张证书和全球信任链的加密大戏。

来源:juejin.cn/post/7527578862054899754

掌握 requestFullscreen:网页全屏功能的实用指南与技巧

想让网页上的图片、视频或者整个界面铺满用户屏幕?浏览器的 requestFullscreen api 是开发者实现这个功能的关键。

它比你想象的要强大,但也藏着一些需要注意的细节。本文将详细介绍如何正确使用它,并分享一些提升用户体验的实用技巧。

一、 开始使用 requestFullscreen:基础与常见问题

直接调用 element.requestFullscreen() 是最简单的方法,但有几个关键点容易出错:

并非所有元素都能直接全屏:

、 等媒体元素通常可以直接全屏。

浏览器兼容性问题:

老版本浏览器(特别是 Safari)需要使用带前缀的方法 webkitRequestFullscreen。安全起见,最好检测并调用正确的方法。

必须在用户操作中触发:

浏览器出于安全考虑,要求全屏请求必须在用户点击、触摸等交互事件(如 click、touchstart)的处理函数里直接调用。不能放在 setTimeout 或者异步回调里直接调用,否则会被浏览器阻止。

二、 控制全屏时的样式

全屏状态下,你可以使用特殊的 css 选择器为全屏元素或其内部的元素定制样式:

/* 为处于全屏状态的 <video> 元素设置黑色背景 */

video:fullscreen {

background-color: #000;

}

/* 当某个具有 id="controls" 的元素在全屏模式下时,默认半透明,鼠标移上去变清晰 */

#controls:fullscreen {

opacity: 0.3;

transition: opacity 0.3s ease;

}

#controls:fullscreen:hover {

opacity: 1;

}

:-webkit-full-screen (WebKit 前缀) : 针对老版本 WebKit 内核浏览器(如旧 Safari)

:fullscreen (标准) : 现代浏览器支持的标准写法。优先使用这个。

三、 实用的进阶技巧

在多个元素间切换全屏:

创建一个管理器能方便地在不同元素(如图库中的图片)之间切换全屏状态,并记住当前全屏的是哪个元素。

const fullscreenManager = {

currentElement: null, // 记录当前全屏的元素

async toggle(element) {

// 如果点击的元素已经是全屏元素,则退出全屏

if (document.fullscreenElement && this.currentElement === element) {

try {

awaitdocument.exitFullscreen();

this.currentElement = null;

} catch (error) {

console.error('退出全屏失败:', error);

}

} else {

// 否则,尝试让新元素进入全屏

try {

await element.requestFullscreen();

this.currentElement = element; // 更新当前元素

} catch (error) {

console.error('进入全屏失败:', error);

// 可以在这里提供一个后备方案,比如模拟全屏的CSS类

element.classList.add('simulated-fullscreen');

}

}

}

};

// 给图库中所有图片绑定点击事件

document.querySelectorAll('.gallery-img').forEach(img => {

img.addEventListener('click', () => fullscreenManager.toggle(img));

});

在全屏模式下处理键盘事件:

全屏时,你可能想添加自定义快捷键(如切换滤镜、截图)。

functionhandleFullscreenHotkeys(event) {

// 保留 Escape 键退出全屏的功能

if (event.key === 'Escape') return;

// 自定义快捷键

if (event.key === 'f') toggleFilter(); // 按 F 切换滤镜

if (event.ctrlKey && event.key === 'p') enterPictureInPicture(); // Ctrl+P 画中画

if (event.shiftKey && event.key === 's') captureScreenshot(); // Shift+S 截图

// 阻止这些键的默认行为(比如防止F键触发浏览器查找)

event.preventDefault();

}

// 监听全屏状态变化

document.addEventListener('fullscreenchange', () => {

if (document.fullscreenElement) {

// 进入全屏,添加自定义键盘监听

document.addEventListener('keydown', handleFullscreenHotkeys);

} else {

// 退出全屏,移除自定义键盘监听

document.removeEventListener('keydown', handleFullscreenHotkeys);

}

});

记住用户的全屏状态:

如果用户刷新页面,可以尝试自动恢复他们之前全屏查看的元素。

// 页面加载完成后检查是否需要恢复全屏

window.addEventListener('domContentLoaded', () => {

const elementId = localStorage.getItem('fullscreenElementId');

if (elementId) {

const element = document.getElementById(elementId);

if (element) {

setTimeout(() => element.requestFullscreen().catch(console.error), 100); // 稍延迟确保元素就绪

}

}

});

// 监听全屏变化,保存当前全屏元素的ID

document.addEventListener('fullscreenchange', () => {

if (document.fullscreenElement) {

localStorage.setItem('fullscreenElementId', document.fullscreenElement.id);

} else {

localStorage.removeItem('fullscreenElementId');

}

});

处理嵌套全屏(沙盒内全屏):

在已经全屏的容器内的 中再次触发全屏是可能的(需要 allow="fullscreen" 属性)。

<divid="main-container">

<iframeid="nested-content"src="inner.html"allow="fullscreen"></iframe>

</div>

<script>

const mainContainer = document.getElementById('main-container');

const iframe = document.getElementById('nested-content');

// 主容器全屏后,可以尝试触发iframe内部元素的全屏(需内部配合)

mainContainer.addEventListener('fullscreenchange', () => {

if (document.fullscreenElement === mainContainer) {

// 假设iframe内部有一个id为'innerVideo'的视频元素

// 注意:这需要在iframe加载完成后,且iframe内容同源或允许跨域操作

const innerDoc = iframe.contentDocument || iframe.contentWindow.document;

const innerVideo = innerDoc.getElementById('innerVideo');

if (innerVideo) {

setTimeout(() => innerVideo.requestFullscreen().catch(console.error), 500);

}

}

});

</script>

四、 实际应用场景

媒体展示: 图片画廊、视频播放器(隐藏浏览器UI获得更好沉浸感 { navigationUI: 'hide' })。

数据密集型应用: 全屏表格、图表或数据看板,提供更大的工作空间。

游戏与交互: WebGL 游戏、交互式动画、全景图查看器(结合陀螺仪 API),全屏能提升性能和体验。

演示模式: 在线文档、幻灯片展示。

专注模式: 写作工具、代码编辑器。

安全措施: 在全屏内容上添加低透明度水印(使用 ::before / ::after 伪元素),增加录屏难度。

五、 开发者需要注意的问题与解决建议

| 问题描述 | 解决方案 |

|---|---|

| iOS Safari 全屏视频行为 | 为 添加 playsinline 属性防止自动横屏。提供手动旋转按钮。 |

| 全屏导致滚动位置丢失 | 进入全屏前记录 scrollTop,退出后恢复。或使用 scroll-snap 等布局技术。 |

| 全屏触发页面重排/抖动 | 提前给目标元素设置 width: 100%; height: 100%; 或固定尺寸。 |

| 全屏时难以打开开发者工具 | 在开发环境,避免拦截 F12 或右键菜单快捷键。使用 console 调试。 |

| 全屏元素内 iframe 权限 | 为 添加 allow="fullscreen" 属性。 |

| 检测用户手动全屏 (F11) | 比较 window.outerHeight 和 screen.height 有一定参考价值,但非绝对可靠。通常建议引导用户使用应用内的全屏按钮。 |

六、 兼容性处理封装(推荐使用)

下面是一个更健壮的工具函数,处理了不同浏览器的前缀问题:

/**

* 全屏工具类 (简化版,展示核心功能)

*/

const FullscreenHelper = {

/**

* 请求元素进入全屏模式

* @param {HTMLElement} [element=document.documentElement] 要全屏的元素,默认是整个页面

* @returns {Promise<boolean>} 是否成功进入全屏

*/

async enter(element = document.documentElement) {

const reqMethods = [

'requestFullscreen', // 标准

'webkitRequestFullscreen', // Safari, Old Chrome/Edge

'mozRequestFullScreen', // Firefox

'msRequestFullscreen'// Old IE/Edge

];

for (const method of reqMethods) {

if (element[method]) {

try {

// 可以传递选项,例如隐藏导航UI: { navigationUI: 'hide' }

await element[method]({ navigationUI: 'hide' });

returntrue; // 成功进入全屏

} catch (error) {

console.warn(`${method} 失败:`, error);

// 继续尝试下一个方法

}

}

}

returnfalse; // 所有方法都失败

},

/**

* 退出全屏模式

* @returns {Promise<boolean>} 是否成功退出全屏

*/

async exit() {

const exitMethods = [

'exitFullscreen', // 标准

'webkitExitFullscreen', // Safari, Old Chrome/Edge

'mozCancelFullScreen', // Firefox

'msExitFullscreen'// Old IE/Edge

];

for (const method of exitMethods) {

if (document[method]) {

try {

awaitdocument[method]();

returntrue; // 成功退出全屏

} catch (error) {

console.warn(`${method} 失败:`, error);

}

}

}

returnfalse; // 所有方法都失败或不在全屏状态

},

/**

* 检查当前是否有元素处于全屏状态

* @returns {boolean} 是否在全屏状态

*/

isFullscreen() {

return !!(

document.fullscreenElement || // 标准

document.webkitFullscreenElement || // Safari, Old Chrome/Edge

document.mozFullScreenElement || // Firefox

document.msFullscreenElement // Old IE/Edge

);

},

/**

* 添加全屏状态变化监听器

* @param {Function} callback 状态变化时触发的回调函数

*/

onChange(callback) {

const events = [

'fullscreenchange', // 标准

'webkitfullscreenchange', // Safari, Old Chrome/Edge

'mozfullscreenchange', // Firefox

'MSFullscreenChange'// Old IE/Edge

];

// 为每种可能的事件添加监听,确保兼容性

events.forEach(eventName => {

document.addEventListener(eventName, callback);

});

}

};

// 使用示例

const myButton = document.getElementById('fullscreen-btn');

const myVideo = document.getElementById('my-video');

myButton.addEventListener('click', async () => {

if (FullscreenHelper.isFullscreen()) {

await FullscreenHelper.exit();

} else {

await FullscreenHelper.enter(myVideo); // 让视频全屏

}

});

// 监听全屏变化

FullscreenHelper.onChange(() => {

console.log('全屏状态变了:', FullscreenHelper.isFullscreen() ? '进入全屏' : '退出全屏');

});

总结

requestFullscreen API 是实现网页元素全屏展示的核心工具。理解其基础用法、兼容性处理、样式控制和状态管理是第一步。

通过掌握切换控制、键盘事件处理、状态持久化和嵌套全屏等进阶技巧,以及规避常见的陷阱,你可以为用户创建更流畅、功能更丰富的全屏体验。

上面的 FullscreenHelper 工具类封装了兼容性细节,推荐在实际项目中使用。现在就去尝试在你的网页中应用这些技巧吧!

来源:juejin.cn/post/7527612394044850227

半数清华,8 位华人 AI 天团集体投奔 Meta!奥特曼:砸钱抢人不如培养死忠

【新智元导读】硅谷挖角戏码升级!相比 Meta3 亿美元「血本挖角」,OpenAI 来了波反向操作——选择培养人才,奥特曼悄然推进一个名为「驻留计划」(Residency Program)的项目。这个项目有何神秘之处?奥特曼的底气到底从何而来?

二十一世纪什么最贵?

人才!

最近几个月,Meta 在硅谷发起的、动辄上亿美元签字费的挖角戏码,成了史上最疯狂的人才争夺战。

不得不说,扎克伯格的「氪金」策略相当成功。

一大批来自 OpenAI、谷歌、Anthropic 甚至是 SSI 的核心研究员纷纷投入 Meta 旗下。

OpenAI 的首席研究官 Mark Chen 难掩失落地说:「这感觉就像有人闯进了我们家,偷走了我们的东西。」

面对这种近乎釜底抽薪似的挖角行为,奥特曼的反应则略显轻蔑:「Meta 的行事方式,让人感觉有些不体面」。

那么,奥特曼的底气来自哪里?

当扎克伯格在牌桌上疯狂加码时,奥特曼在牌桌之下,进行着一场完全不同维度的布局。

不挖天才,我们培养天才

当所有人的目光都聚焦在 Meta 的天价支票上时,OpenAI 正在悄然推进一个名为「驻留计划」(Residency Program)的项目。

这个项目,可以说是 OpenAI 应对人才战争的核心战略,也是理解其企业文化的一把钥匙。

OpenAI Residency 是一个为期六个月的全职带薪项目,但它的招生对象,却出人意料。

Residency 项目经理 Jackie Hehir 明确表示,他们寻找的,不是那些正在攻读机器学习或 AI 博士学位的天之骄子,也不是来自其他 AI 实验室的资深员工。

恰恰相反,他们将橄榄枝伸向了那些「邻近领域」的顶尖大脑——比如物理学家、神经科学家、数学家。

虽然没有严格的学历或工作经验要求,但设有一个极高的技术门槛,尤其是在数学和编程方面,其标准与全职员工等同。

你不需要拥有高等数学学位,但必须对高等数学概念非常自如。

「他们对这个领域(AI)充满了真正的热情,」Hehir 说。

这背后是一套极其精明的逻辑。

这场从零培养的战略,至少带来了三个层面的深远优势。

首先就是成本上的「降维打击」。

驻留研究员的年薪是 21 万美元,意味着在这六个月里,OpenAI 的支出大约是 10.5 万美元。

这个数字,足以让参与者跻身美国收入前 5% 的行列。

但在动辄千万、上亿美元签字费的 AI 顶级人才市场,这简直就是白菜价。

用极小的代价,获得了一批拥有顶级科研素养和巨大潜力的「璞玉」。

其次,是对企业文化基因的深度植入。

面对小扎的疯狂抢人,奥特曼就曾评论道:「在我看来,Meta 的所作所为将导致非常深刻的文化问题」。

而在 OpenAI,一位前员工向 Business Insider 透露,他们公司的内部文化是「对创造 AGI 的使命感到痴迷」。

通过驻留计划,OpenAI 可以在一张白纸上,从一开始就将这种使命感深深烙印在这些未来核心员工的脑海里。

他们共同学习、共同攻关,建立的不仅是工作关系,更是对共同事业的「信仰共同体」。

这与简单地用金钱挖来的雇佣兵有着本质区别。

Meta 用金钱这种最直接的外部激励,虽然见效快,但可能存在边际效应递减的风险,并且容易塑造一种唯利是图的文化。

相比之下,OpenAI 的策略则更侧重于构建内在动机:

通过赋予一个宏大的、改变世界的使命(创造 AGI),它满足了员工对归属感的渴望;

通过从零培养,让跨界人才在新领域找到自己的位置,它满足了「胜任感」的成长需求;

通过相对宽松和专注的科研环境,满足了对自主性的追求。

「传教士将打败雇佣兵」,奥特曼在内部备忘录中,写下了这句提振士气的话。

最后,是极高的忠诚度与****转化率。

数据显示,几乎每一个在驻留计划中表现出色的成员,都会收到 OpenAI 全职 offer。

迄今为止,所有收到 offer 的人都选择了接受。

每年,这个项目会迎来大约 30 名新成员,他们就像新鲜的血液,持续不断地为 OpenAI 提供能量。

OpenAI Residency 的「播种」策略,更像是一场耐心的耕耘。

它可能没法像 Meta 那样立即招到顶尖专家,但却可以培养出一片忠于自己使命、文化高度统一、且具备持续造血能力的「人才森林」。

这场发生在硅谷的人才战争,早已超越了商业竞争的范畴。

它是一场关于组织灵魂、动机和未来信念的宏大实验。

而实验的结果,不仅将决定这两家公司的命运,更将深刻地影响我们正在迈入的 AGI 时代。

最后,让我们再来回顾一下 Meta 这两个月的骚操作。

史上最疯狂人才争夺战

据估计全球有能力推动大语言模型和前沿 AI 研究的顶尖人才,只有区区 2000 人左右。

这场人才争夺战的激烈程度,未来只会不断升级。

Meta 为了 AI 顶尖人才可谓是下了「血本」。

被业内人士调侃为,「竞赛之夏的错失恐惧症(summer of comp FOMO)」。

据统计,Meta 在四年间,为 AI 顶尖人才准备了高达 3 亿美元薪酬方案,创下了行业记录。

那 Meta 这「3 亿美元薪酬」到底招了哪些顶尖人才呢?

2025 年 6 月

核心人物:Alexandr Wang(28 岁)

**背景:**2016 年,19 岁的 Alexandr Wang MIT 辍学与 Lucy Guo 共同创立「数据标注」公司 Scale AI,并于同年获得著名创业孵化器 Y Combinator 启动资金支持。顶级 AI 科技巨头:微软、Meta、OpenAI 等提供模型训练数据。

**押注金:**143 亿美元

**原职位:**Scale AI 创始人

**Meta 新职位:**Meta 首席 AI 智能官(Chief AI Officer),负责新设立的「超级智能」部门

重要性:

1、拥有 AI 核心「数据战火库」:Alexandr Wang 手握 Meta 核心竞争对手微软、OpenAI、谷歌等模型训练数据;

2、天生的商业嗅觉者:在还没有 LLM 时,已洞察到「数据」在 AI 领域的重要性,便在 2016 年创办数据标注公司 Scale AI;

**核心人物:**Shengjia Zhao

背景:清华大学本科,斯坦福大学博士,核心聚焦大语言模型和不确定性量化。领导 OpenAI 合成数据项目,是 ChatGPT、GPT-4 模型及各种小型模型等标志性产品的重要贡献者。

**原职位:**前 OpenAI 研究科学家

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

核心人物:Jiahui Yu

背景:中国科学技术大学少年班的毕业生,曾分别任职于在微软、旷视、Adobe、Snap、百度、英伟达和谷歌等。2023 年 10 月领导 OpenAI 感知团队,主导了 o3、o4-mini 和 GPT-4.1 研发;在谷歌 DeepMind 联合领导 Gemini Multimodal。研究核心聚焦深度学习和高性能算力。

**原职位:**前 OpenAI 项目研究负责人

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

核心人物:Shuchao Bi

背景:毕业于浙江大学数学系,随后在加州大学伯克利分校获得了硕士和博士学位。专注于强化学习、训练后优化和 AI 代理。2013 年入职谷歌,通过深度学习模型优化谷歌广告。2024 年 5 月入职 OpenAI,担任多模态后训练主管,为 GPT-4o 的语音模式和 o4-mini 模型做出了贡献。

**原职位:**前 OpenAI 多模态后训练主管

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

核心人物:Hongyu Ren

背景:2018 年毕业于北京大学,2023 年在斯坦福大学完成计算机科学博士学位。在校期间,他曾在微软、英伟达、谷歌和苹果实习。毕业后他加入 OpenAI,曾参与 o1-mini 和 o3-mini 研发,并领导一个专注于后期训练的团队,o1 项目的核心贡献者。

**原职位:**前 OpenAI 后期训练项目负责人

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

**核心人物:**hang Huiwen

背景:毕业于清华大学交叉信息研究院的姚班(这个精英计算机科学项目由图灵奖得主姚期智创立)。随后在普林斯顿大学取得博士学位,研究方向是图像处理。 曾在 Adobe 和 Facebook 实习,后于 2016 年获得微软奖学金。2019 年谷歌工作一段时间后,于 2023 年 6 月转至 OpenAI,参与开发了 GPT-4o 的高级图像生成功能。

**原职位:**前 OpenAI 研究员

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

**核心人物:**Lin Ji

背景:清华大学本科,2023 年在 MIT 获得博士学位。曾在谷歌、Adobe 和英伟达实习,并于 2023 年 1 月加入 OpenAI,专攻多模态推理和合成数据。

**原职位:**前 OpenAI 研究员

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

核心人物:Sun Pei

背景:清华大学本科,卡内基梅隆大学硕士,2011 年就职谷歌。他短暂加入中国数据基础设施公司 Alluxio 后,于 2017 年转至谷歌的 Waymo 部门。后成为谷歌 DeepMind 的首席研究员,在开发 Gemini 人工智能模型方面发挥了关键作用,特别是在后训练和推理等领域。

**原职位:**前谷歌 DeepMind 的首席研究员

**Meta 新职位:**Meta 超级智能部门,具体职位未透露

核心人物:Lucas Beyer

背景:自称 “自学成才黑客」,前谷歌 DeepMind(原 Brain)苏黎世分部的高级研究科学家,联合领导模态研究工作和代码库项目。与 Xiaohua Zhai 和 Alexander Kolesnikov 创立了苏黎世 OpenAI 办公室。

**原职位:**前谷歌 DeepMind(原 Brain)苏黎世分部的高级研究科学家,苏黎世 OpenAI 办公室创始人。

**Meta 新职位:**Meta 超级智能部门研究员,具体职位未透露

核心人物:Alexander Kolesnikov

背景:曾任谷歌「Google Brain」高级研究工程师,「Deepmind」研究科学家。OpenAI 研究员。

**原职位:**前 OpenAI 苏黎世办公室研究员

**Meta 新职位:**Meta 超级智能部门研究员,具体职位未透露

2025 年 7 月

核心人物:Daniel Gross(左一)

背景:「安全超级智能」SSI 三位联创之一(其余两位:Ilya Sutskever、Daniel Levy)。曾试图以 320 亿美元收购 Safe Superintelligence,被拒后反手挖走其联合创始人之一 Daniel Gross。

7 月 3 日,「消失已久」Ilya 罕见现身发文,确认了 Daniel Gross「出局」消息,Daniel Gross 也转发了该条推文。

原职位:「安全超级智能」SSI 联合创始人,OpenAI 前首席科学家

**Meta 新职位:**领导 Meta 超级智能产品部门

**重要性:**与 Nat Friedman 共同创立一家名叫「NFDG」的风险投资公司,该公司已投资了 Coinbase、Figma、CoreWeave、Perplexity 和 Character.ai。

核心人物:Nat Friedman

**背景:**MIT 毕业,Github 前 CEO(2018-2021), 曾任 GNOME 基金会的主席,目前还是 Arc 研究所的董事会成员,并担任 Midjourney 的顾问。

**原职位:**前 Github CEO

Meta 新职位:「与 Alex 合作领导」超级智能团队

**重要性:**辅佐「军师」协助小孩哥 Alexandr Wang 共同领导超级智能团队。

参考资料:

来源:juejin.cn/post/7523519254878437403

马斯克 Neuralink 脑机接口新成果!看完头皮发麻

注意看,这些人正在用意念玩马里奥赛车。

他们的手没有动一下,靠脑电波控制就完成了移动、转弯、吃道具等一系列动作。

帮助他们通过 “心灵感应” 完成游戏操作的,就是马斯克 Neuralink 的脑机接口 N1。

这就是 Neuralink 夏季更新报告会上,马斯克展示的最新成果。

截止目前,N1 已经有七名受试者,他们以视频等形式分享了脑机接口对他们生活的改变。

这一个个真实案例,也获得了网友们的一片赞许。

同时,在这次报告会上,Neuralink 也曝光了未来三年的发展路线——

到 2028 年,Neuralink 计划实现对大脑的全面访问。

让受试者重回生活

这七位受试者当中,有四位是脊髓损伤患者,另外三位是肌萎缩侧索硬化症(渐冻症)患者。

他们接受测试的地点不是在实验室,而是每天在家中使用 Neuralink 脑机接口设备,据统计,他们平均每周使用脑机接口的时间长达 50 小时,峰值甚至超过 100 小时,几乎覆盖了所有的清醒时间。

其中,Noland 是全球第一位 N1 受试者,他因为脊髓损伤瘫痪。

Noland 装上 N1 之后当天,就学会了完全靠意念控制电脑光标,并打破了世界纪录。

现在,Noland 已经学会了仅凭意念畅玩《马里奥赛车》,甚至还能与其他参与者联机玩《使命召唤》等更复杂的游戏。

除了游戏之外,Noland 还在 N1 的帮助下,正在重新学习语言和数学。

同样是脊髓受损的,还有 Alex,他因此失去了手部功能。

但有了 N1,他已经学会了通过意念控制电脑屏幕上的手,和家人玩 “石头剪刀布” 游戏。

而且不仅能控制屏幕上的虚拟影像,还可以操纵特斯拉擎天柱机器人的机械手。

更重要的是,N1 已经帮助 Alex 重新回到工作,通过意念操作 CAD 软件完成设计。

如前所述,N1 的受益者除了脊髓损伤患者,还有渐冻症人士,Bard 是首个植入 N1 的渐冻症患者。

因为渐冻症,Bard 失去了语言能力,只能借助眼动追踪技术来和外界交流。

但现在,他已经可以用思想控制电脑,从而与世界交流,甚至和他的孩子们一起到公园玩耍。

目标是实现 “全脑接口”

此次报告会上,Neuralink 透露其最终目标,是构建一个真正的 “全脑接口”。

顾名思义,“全脑接口” 就是一个能够向任意神经元读取、写入、传输信息的通用平台。

具体来说,其产品路线图中包含了 Telepathy、Blindsight、Deep 三个组成部分。

七名受试者使用的 N1,就是 Telepathy。

Telepathy 通过将 1000 个电极植入运动皮层中负责手部和手臂运动的区域来工作,目的就是帮助因脊髓损伤、渐冻症、中风等导致无法自主控制身体的人士,能够仅凭思想来实现控制电脑、操作鼠标等动作。

Blindsight 则是 Neuralink 的下一个产品,旨在帮助完全失明的人(包括天生失明、失去眼睛或视神经的人)恢复视力。

Blindsight 会通过摄像头捕捉环境场景,然后转换成电信号,传递到植入在视觉皮层的设备中,从而在大脑中产生视觉感知。

最后的 “Deep”,不是一个独立的产品名称,而是指 Neuralink 技术能够深入大脑更深层区域的能力,以及这种能力带来的应用。

这一层次旨在通过将电极插入皮层(cortical layer)以及更深层的脑区,例如脑沟(sulci)和边缘系统(limbic system),来治疗神经系统失调、精神疾病或神经性疼痛。

同时,Neuralink 也公布了未来三年的具体发展计划。

今年下半年,Neuralink 计划在言语皮层(speech cortex)进行植入,从而将大脑中的信息解码为语言。

明年,通道的数量将从 1000 个增加到 3000 个,同时 Neuralink 还计划进行首次 Blindsight 植入。

这次植入,也将成为 Neuralink 验证其向大脑中写入信息能力的关键机会。

到 2027 年,通道数量将继续增加至 10000 个,同时首次实现多植入物操作,即在运动皮层、言语皮层和视觉皮层等多个脑区同时进行植入。

最终的 2028 年,每个植入物拥有超过 25000 个通道,结合多植入物操作,能够实现对大脑的任何部分的访问,从而用于治疗精神疾病、疼痛以及其他神经功能失调。

届时,Neuralink 还将进行脑机接口与 AI 的整合。

参考链接:

http://www.youtube.com/watch?v=FAS…

欢迎在评论区留下你的想法!

— 完 —

来源:juejin.cn/post/7521376266110091298

40岁老前端2025年上半年都学了什么?

前端学习记录第5波,每半年一次。对前四次学习内容感兴趣的可以去我的掘金专栏“每周学习记录”进行了解。

第1周 12.30-1.5

本周学习了一个新的CSS媒体查询prefers-reduced-transparency,如果用户在系统层面选择了降低或不使用半透明,这个媒体查询就能够匹配,此特性与用户体验密切相关的。

更多内容参见我撰写的这篇文章:一个新的CSS媒体查询prefers-reduced-transparency —— http://www.zhangxinxu.com/wordpress/?…

第2周 1.6-1.12

这周新学习了一个名为Broadcast Channel的API,可以实现一种全新的广播式的跨页面通信。

过去的postMessage通信适合点对点,但是广播式的就比较麻烦。

而使用BroadcastChannel就会简单很多。

这里有个演示页面:http://www.zhangxinxu.com/study/20250…

左侧点击按钮发送消息,右侧两个内嵌的iframe页面就能接收到。

此API的兼容性还是很不错的:

更多内容可以参阅此文:“Broadcast Channel API简介,可实现Web页面广播通信” —— http://www.zhangxinxu.com/wordpress/?…

第3周 1.13-1.19

这周学习的是SVG半圆弧语法,因为有个需求是实现下图所示的图形效果,其中几段圆弧的长度占比每个人是不一样的,因此,需要手写SVG路径。

圆弧的SVG指令是A,语法如下:

M x1 y1 A rx ry x-axis-rotation large-arc-flag sweep-flag x2 y2

看起来很复杂,其实深究下来还好:

详见这篇文章:“如何手搓SVG半圆弧,手把手教程” - http://www.zhangxinxu.com/wordpress/?…

第4周-第5周 1.20-2.2

春节假期,学什么学,high起来。

第6周 2.3-2.9

本周学习Array数组新增的with等方法,这些方法在数组处理的同时均不会改变原数组内容,这在Vue、React等开发场景中颇为受用。

例如,在过去,想要不改变原数组改变数组项,需要先复制一下数组:

现在有了with方法,一步到位:

类似的方法还有toReversed()、toSorted()和toSpliced()。

更新内容参见这篇文章:“JS Array数组新的with方法,你知道作用吗?” - http://www.zhangxinxu.com/wordpress/?…

第7周 2.10-2.16

本周学习了两个前端新特性,一个JS的,一个是CSS的。

1. Set新增方法

JS Set新支持了intersection, union, difference等方法,可以实现类似交集,合集,差集的数据处理,也支持isDisjointFrom()是否相交,isSubsetOf()是否被包含,isSupersetOf()是否包含的判断。

详见此文:“JS Set新支持了intersection, union, difference等方法” - http://www.zhangxinxu.com/wordpress/?…

2. font-size-adjust属性

CSS font-size-adjust属性,可以基于当前字形的高宽自动调整字号大小,以便各种字体的字形表现一致,其解决的是一个比较细节的应用场景。

例如,16px的苹方和楷体,虽然字号设置一致,但最终的图形表现楷体的字形大小明显小了一圈:

此时,我们可以使用font-size-adjust进行微调,使细节完美。

p { font-size-adjust: 0.545;}

此时的中英文排版效果就会是这样:

更新细节知识参见我的这篇文章:“不要搞混了,不是text而是CSS font-size-adjust属性” - http://www.zhangxinxu.com/wordpress/?…

第8周 2.17-2.23

本周学习的是HTML permission元素和Permissions API。

这两个都是与Web浏览器的权限申请相关的。

在Web开发的时候,我们会经常用到权限申请,比方说摄像头,访问相册,是否允许通知,又或者地理位置信息等。

但是,如果用户不小心点击了“拒绝”,那么用户就永远没法使用这个权限,这其实是有问题的,于是就有了元素,权限按钮直接暴露在网页中,直接让用户点击就好了。

但是,根据我后来的测试,Chrome浏览器放弃了对元素的支持,因此,此特性大家无需关注。

那Permissions API又是干嘛用的呢?

在过去,不同类型的权限申请会使用各自专门的API去进行,这就会导致开始使用的学习和使用成本比较高。

既然都是权限申请,且系统出现的提示UI都近似,何必来个大统一呢?在这种背景下,Permissions API被提出来了。

所有的权限申请全都使用一个统一的API名称入口,使用的方法是Permissions.query()。

完整的介绍可以参见我撰写的这篇文章:“HTML permission元素和Permissions API简介” - http://www.zhangxinxu.com/wordpress/?…

第9周 2.24-3.2

CSS offset-path属性其实在8年前就介绍过了,参见:“使用CSS offset-path让元素沿着不规则路径运动” - http://www.zhangxinxu.com/wordpress/?…

不过那个时候的offset-path属性只支持不规则路径,也就是path()函数,很多CSS关键字,还有基本形状是不支持的。

终于,盼星星盼月亮。

从Safari 18开始,CSS offset-path属性所有现代浏览器全面支持了。

因此,很多各类炫酷的路径动画效果就能轻松实现了。例如下图的蚂蚁转圈圈动画:

详见我撰写的此文:“终于等到了,CSS offset-path全浏览器全支持” - http://www.zhangxinxu.com/wordpress/?…

第10周 3.3-3.9

CSS @supports规则新增两个特性判断,分别是font-tech()和font-format()函数。

1. font-tech()

font-tech()函数可以检查浏览器是否支持用于布局和渲染的指定字体技术。

例如,下面这段CSS代码可以判断浏览器是否支持COLRv1字体(一种彩色字体技术)技术。

@supports font-tech(color-COLRv1) {}

2. font-format()

font-format()这个比较好理解,是检测浏览器是否支持指定的字体格式的。

@supports font-format(woff2) { /* 浏览器支持woff2字体 */ }

不过这两个特性都不实用。

font-tech()对于中文场景就是鸡肋特性,因为中文字体是不会使用这类技术的,成本太高。

font-format()函数的问题在于出现得太晚了。例如woff2字体的检测,这个所有现代浏览器都已经支持了,还有检测的必要吗,没了,没有意义了。

不过基于衍生的特性还是有应用场景的,具体参见此文:“CSS supports规则又新增font-tech,font-format判断” - http://www.zhangxinxu.com/wordpress/?…

第11周 3.10-3.16

本周学习了一种更好的文字隐藏的方法,那就是使用::first-line伪元素,CSS世界这本书有介绍。

::first-line伪元素可以在不改变元素color上下文的情况下变色。

可以让按钮隐藏文字的时候,里面的图标依然保持和原本的文字颜色一致。

详见这篇文章:“一种更好的文字隐藏的方法-::first-line伪元素” - http://www.zhangxinxu.com/wordpress/?…

第12周 3.17-3.23

本周学习了下attachInternals方法,这个方法很有意思,给任意自定义元素使用,可以让普通元素也有原生表单控件元素一样的特性。

比如浏览器自带的验证提示:

比如说提交的时候的FormData或者查询字符串:

有兴趣的同学可以访问“研究下attachInternals方法,可让普通元素有表单特性”这篇文章继续了解 - http://www.zhangxinxu.com/wordpress/?…

第13周 3.24-3.30

本周学习了一个新支持的HTML属性,名为blocking 属性。

它主要用于控制资源加载时对渲染的阻塞行为。

blocking 属性允许开发者对资源加载的优先级和时机进行精细控制,从而影响页面的渲染流程。浏览器在解析 HTML 文档时,会根据 blocking 属性的值来决定是否等待资源加载完成后再继续渲染页面,这对于优化页面性能和提升用户体验至关重要。

blocking 属性目前支持的HTML元素包括

使用示意:

更多内容参见我撰写的这篇文章:“光速了解script style link元素新增的blocking属性” - http://www.zhangxinxu.com/wordpress/?…

第14周 3.31-4.6

本周学习了JS EditContext API。

EditContext API 是 Microsoft Edge 浏览器提供的一个 Web API,它允许开发者在网页中处理文本输入事件,以便在原生输入事件(如 keydown、keypress 和 input)之外,实现更高级的文本编辑功能。

详见我撰写的这篇文章:“JS EditContext API 简介” - http://www.zhangxinxu.com/wordpress/?…

第15周 4.7-4.13

本周学习一个DOM新特性,名为caretPositionFromPoint API。

caretPositionFromPoint可以基于当前的光标位置,返回光标所对应元素的位置信息,在之前,此特性使用的是非标准的caretRangeFromPoint方法实现的。

和elementsFromPoint()方法的区别在于,前者返回节点及其偏移、尺寸等信息,而后者返回元素。

比方说有一段

元素文字描述信息,点击这段描述的某个文字,caretPositionFromPoint()方法可以返回精确的文本节点以及点击位置的字符偏移值,而elementsFromPoint()方法只能返回当前

元素。

不过此方法的应用场景比较小众,例如点击分词断句这种,大家了解下即可。

详见我撰写的这篇文章:“DOM新特性之caretPositionFromPoint API” - http://www.zhangxinxu.com/wordpress/?…

第16周 4.14-4.20

本周学习的是getHTML(), setHTMLUnsafe()和parseHTMLUnsafe()这三个方法,有点类似于可读写的innerHTML属性,区别在于setHTMLUnsafe()似乎对Shadow DOM元素的设置更加友好。

parseHTMLUnsafe则是个document全局方法,用来解析HTML字符串的。

这几个方法几乎是同一时间支持的,如下截图所示:

具体参见我写的这篇文章:介绍两个DOM新方法setHTMLUnsafe和getHTML - http://www.zhangxinxu.com/wordpress/?…

第17周 4.21-4.27

光速了解HTML shadowrootmode属性的作用。

shadowRoot的mode是个只读属性,可以指定其模式——打开或关闭。

这定义了影子根的内部功能是否可以从JavaScript访问。

当影子根的模式为“关闭”时,影子根的实现内部无法从JavaScript访问且不可更改,就像元素的实现内部不能从JavaScript访问或不可更改一样。

属性值是使用传递给Element.attachShadow()的对象的options.mode属性设置的,或者在声明性创建影子根时使用

来源:juejin.cn/post/7524548909530005540

async/await 必须使用 try/catch 吗?

前言

在 JavaScript 开发者的日常中,这样的对话时常发生:

- 👨💻 新人:"为什么页面突然白屏了?"

- 👨🔧 老人:"异步请求没做错误处理吧?"

async/await 看似优雅的语法糖背后,隐藏着一个关键问题:错误处理策略的抉择。

在 JavaScript 中使用 async/await 时,很多人会问:“必须使用 try/catch 吗?”

其实答案并非绝对,而是取决于你如何设计错误处理策略和代码风格。

接下来,我们将探讨 async/await 的错误处理机制、使用 try/catch 的优势,以及其他可选的错误处理方法。

async/await 的基本原理

异步代码的进化史

// 回调地狱时代

fetchData(url1, (data1) => {

process(data1, (result1) => {

fetchData(url2, (data2) => {

// 更多嵌套...

})

})

})

// Promise 时代

fetchData(url1)

.then(process)

.then(() => fetchData(url2))

.catch(handleError)

// async/await 时代

async function workflow() {

const data1 = await fetchData(url1)

const result = await process(data1)

return await fetchData(url2)

}