实现一个支持@的输入框

近期产品期望在后台发布帖子或视频时,需要添加 @用户 的功能,以便用户收到通知,例如“xxx在xxx提及了您!”。然而,现有的开源库未能满足我们的需求,例如 ant-design 的 Mentions 组件:

但是不难发现跟微信飞书对比下,有两个细节没有处理。

- @用户没有高亮

- 在删除时没有当做一个整体去删除,而是单个字母删除,首先不谈用户是否想要整体删除,在这块有个模糊查询的功能,如果每删一个字母之后去调接口查询数据库造成一些不必要的性能开销,哪怕加上防抖。

然后也是找了其他的库都没达到产品的期望效果,那么好,自己实现一个,先看看最终实现的效果:

封装之后使用:

<AtInput

height={150}

onRequest={async (searchStr) => {

const { data } = await UserFindAll({ nickname: searchStr });

return data?.list?.map((v) => ({

id: v.uid,

name: v.nickname,

wechatAvatarUrl: v.wechatAvatarUrl,

}));

}}

onChange={(content, selected) => {

setAtUsers(selected);

}}

/>

那么实现这么一个输入框大概有以下几个点:

- 高亮效果

- 删除/选中用户时需要整体删除

- 监听@的位置,复制给弹框的坐标,联动效果

- 最后我需要拿到文本内容,并且需要拿到@那些用户,去做表单提交

大多数文本输入框我们会使用input,或者textarea,很明显以上1,2两点实现不了,antd也是使用的textarea,所以也是没有实现这两个效果。所以这块使用富文本编辑,设置contentEditable,将其变为可编辑去做。输入框以及选择器的dom就如下:

<div style={{ height, position: 'relative' }}>

{/* 编辑器 */}

<div

id="atInput"

ref={atRef}

className={'editorDiv'}

contentEditable

onInput={editorChange}

onClick={editorClick}

/>

{/* 选择用户框 */}

<SelectUser

options={options}

visible={visible}

cursorPosition={cursorPosition}

onSelect={onSelect}

/>

</div>

实现思路:

- 监听输入@,唤起选择框。

- 截取@xxx的xxx作为搜素的关键字去查询接口

- 选择用户后需要将原先输入的 @xxx 替换成 @姓名,并且将@的用户缓存起来

- 选择文本框中的姓名时需要变为整体选中状态,这块依然可以给标签设置为不可编辑状态就可实现,contentEditable=false,即可实现整体删除,在删除的同时需要将当前用户从之前缓存的@过的用户数组删除

- 那么可以拿到输入框的文本,@的用户, 最后将数据抛给父组件就完成了

以上提到了监听@文本变化,通常绑定onChange事件就行,但是还有一种用户通过点击移动光标,这块需要绑定change,click两个时间,他们里边的逻辑基本一样,只需要额外处理点击选中输入框中用户时,整体选中g功能,那么代码如下:

const onObserveInput = () => {

let cursorBeforeStr = '';

const selection: any = window.getSelection();

if (selection?.focusNode?.data) {

cursorBeforeStr = selection.focusNode?.data.slice(0, selection.focusOffset);

}

setFocusNode(selection.focusNode);

const lastAtIndex = cursorBeforeStr?.lastIndexOf('@');

setCurrentAtIdx(lastAtIndex);

if (lastAtIndex !== -1) {

getCursorPosition();

const searchStr = cursorBeforeStr.slice(lastAtIndex + 1);

if (!StringTools.isIncludeSpacesOrLineBreak(searchStr)) {

setSearchStr(searchStr);

fetchOptions(searchStr);

setVisible(true);

} else {

setVisible(false);

setSearchStr('');

}

} else {

setVisible(false);

}

};

const selectAtSpanTag = (target: Node) => {

window.getSelection()?.getRangeAt(0).selectNode(target);

};

const editorClick = async (event) => {

onObserveInput();

// 判断当前标签名是否为span 是的话选中当做一个整体

if (e.target.localName === 'span') {

selectAtSpanTag(e.target);

}

};

const editorChange = (event) => {

const { innerText } = event.target;

setContent(innerText);

onObserveInput();

};

每次点击或者文本改变时都会去调用onObserveInput,以上onObserveInput该方法中主要做了以下逻辑:

- 在此之前需要先了解 Selection的一些方法

- 通过getSelection方法可以获取光标的偏移位置,那么可以截取光标之前的字符串,并且使用lastIndexOf从后向前查找最后一个“@”符号,并记录他的下标,那么有了【光标之前的字符串】,【@的下标】就可以拿到到@之后用于过滤用户的关键字,并将其缓存起来。

- 唤起选择器,并通过关键字去过滤用户。这块涉及到一个选择器的位置,直接使用window.getSelection()?.getRangeAt(0).getBoundingClientRect()去获取光标的位置拿到的是光标相对于窗口的坐标,直接用这个坐标会有问题,比如滚动条滚动时,这个选择器发生位置错乱,所以这块同时去拿输入框的坐标,去做一个相减,这样就可以实现选择器跟着@符号联动的效果。

const getCursorPosition = () => {

// 坐标相对浏览器的坐标

const { x, y } = window.getSelection()?.getRangeAt(0).getBoundingClientRect() as any;

// 获取编辑器的坐标

const editorDom = window.document.querySelector('#atInput');

const { x: eX, y: eY } = editorDom?.getBoundingClientRect() as any;

// 光标所在位置

setCursorPosition({ x: x - eX, y: y - eY });

};

选择器弹出后,那么下面就到了选择用户之后的流程了,

/**

* @param id 唯一的id 可以uid

* @param name 用户姓名

* @param color 回显颜色

* @returns

*/

const createAtSpanTag = (id: number | string, name: string, color = 'blue') => {

const ele = document.createElement('span');

ele.className = 'at-span';

ele.style.color = color;

ele.id = id.toString();

ele.contentEditable = 'false';

ele.innerText = `@${name}`;

return ele;

};

/**

* 选择用户时回调

*/

const onSelect = (item: Options) => {

const selection = window.getSelection();

const range = selection?.getRangeAt(0) as Range;

// 选中输入的 @关键字 -> @郑

range.setStart(focusNode as Node, currentAtIdx!);

range.setEnd(focusNode as Node, currentAtIdx! + 1 + searchStr.length);

// 删除输入的 @关键字

range.deleteContents();

// 创建元素节点

const atEle = createAtSpanTag(item.id, item.name);

// 插入元素节点

range.insertNode(atEle);

// 光标移动到末尾

range.collapse();

// 缓存已选中的用户

setSelected([...selected, item]);

// 选择用户后重新计算content

setContent(document.getElementById('atInput')?.innerText as string);

// 关闭弹框

setVisible(false);

// 输入框聚焦

atRef.current.focus();

};

选择用户的时候需要做的以下以下几点:

- 删除之前的@xxx字符

- 插入不可编辑的span标签

- 将当前选择的用户缓存起来

- 重新获取输入框的内容

- 关闭选择器

- 将输入框重新聚焦

最后

在选择的用户或者内容发生改变时将数据抛给父组件

const getAttrIds = () => {

const spans = document.querySelectorAll('.at-span');

let ids = new Set();

spans.forEach((span) => ids.add(span.id));

return selected.filter((s) => ids.has(s.id));

};

/** @的用户列表发生改变时,将最新值暴露给父组件 */

useEffect(() => {

const selectUsers = getAttrIds();

onChange(content, selectUsers);

}, [selected, content]);

完整组件代码

输入框主要逻辑代码:

let timer: NodeJS.Timeout | null = null;

const AtInput = (props: AtInputProps) => {

const { height = 300, onRequest, onChange, value, onBlur } = props;

// 输入框的内容=innerText

const [content, setContent] = useState<string>('');

// 选择用户弹框

const [visible, setVisible] = useState<boolean>(false);

// 用户数据

const [options, setOptions] = useState<Options[]>([]);

// @的索引

const [currentAtIdx, setCurrentAtIdx] = useState<number>();

// 输入@之前的字符串

const [focusNode, setFocusNode] = useState<Node | string>();

// @后关键字 @郑 = 郑

const [searchStr, setSearchStr] = useState<string>('');

// 弹框的x,y轴的坐标

const [cursorPosition, setCursorPosition] = useState<Position>({

x: 0,

y: 0,

});

// 选择的用户

const [selected, setSelected] = useState<Options[]>([]);

const atRef = useRef<any>();

/** 获取选择器弹框坐标 */

const getCursorPosition = () => {

// 坐标相对浏览器的坐标

const { x, y } = window.getSelection()?.getRangeAt(0).getBoundingClientRect() as any;

// 获取编辑器的坐标

const editorDom = window.document.querySelector('#atInput');

const { x: eX, y: eY } = editorDom?.getBoundingClientRect() as any;

// 光标所在位置

setCursorPosition({ x: x - eX, y: y - eY });

};

/**获取用户下拉列表 */

const fetchOptions = (key?: string) => {

if (timer) {

clearTimeout(timer);

timer = null;

}

timer = setTimeout(async () => {

const _options = await onRequest(key);

setOptions(_options);

}, 500);

};

useEffect(() => {

fetchOptions();

// if (value) {

// /** 判断value中是否有at用户 */

// const atUsers: any = StringTools.filterUsers(value);

// setSelected(atUsers);

// atRef.current.innerHTML = value;

// setContent(value.replace(/<\/?.+?\/?>/g, '')); //全局匹配内html标签)

// }

}, []);

const onObserveInput = () => {

let cursorBeforeStr = '';

const selection: any = window.getSelection();

if (selection?.focusNode?.data) {

cursorBeforeStr = selection.focusNode?.data.slice(0, selection.focusOffset);

}

setFocusNode(selection.focusNode);

const lastAtIndex = cursorBeforeStr?.lastIndexOf('@');

setCurrentAtIdx(lastAtIndex);

if (lastAtIndex !== -1) {

getCursorPosition();

const searchStr = cursorBeforeStr.slice(lastAtIndex + 1);

if (!StringTools.isIncludeSpacesOrLineBreak(searchStr)) {

setSearchStr(searchStr);

fetchOptions(searchStr);

setVisible(true);

} else {

setVisible(false);

setSearchStr('');

}

} else {

setVisible(false);

}

};

const selectAtSpanTag = (target: Node) => {

window.getSelection()?.getRangeAt(0).selectNode(target);

};

const editorClick = async (e?: any) => {

onObserveInput();

// 判断当前标签名是否为span 是的话选中当做一个整体

if (e.target.localName === 'span') {

selectAtSpanTag(e.target);

}

};

const editorChange = (event: any) => {

const { innerText } = event.target;

setContent(innerText);

onObserveInput();

};

/**

* @param id 唯一的id 可以uid

* @param name 用户姓名

* @param color 回显颜色

* @returns

*/

const createAtSpanTag = (id: number | string, name: string, color = 'blue') => {

const ele = document.createElement('span');

ele.className = 'at-span';

ele.style.color = color;

ele.id = id.toString();

ele.contentEditable = 'false';

ele.innerText = `@${name}`;

return ele;

};

/**

* 选择用户时回调

*/

const onSelect = (item: Options) => {

const selection = window.getSelection();

const range = selection?.getRangeAt(0) as Range;

// 选中输入的 @关键字 -> @郑

range.setStart(focusNode as Node, currentAtIdx!);

range.setEnd(focusNode as Node, currentAtIdx! + 1 + searchStr.length);

// 删除输入的 @关键字

range.deleteContents();

// 创建元素节点

const atEle = createAtSpanTag(item.id, item.name);

// 插入元素节点

range.insertNode(atEle);

// 光标移动到末尾

range.collapse();

// 缓存已选中的用户

setSelected([...selected, item]);

// 选择用户后重新计算content

setContent(document.getElementById('atInput')?.innerText as string);

// 关闭弹框

setVisible(false);

// 输入框聚焦

atRef.current.focus();

};

const getAttrIds = () => {

const spans = document.querySelectorAll('.at-span');

let ids = new Set();

spans.forEach((span) => ids.add(span.id));

return selected.filter((s) => ids.has(s.id));

};

/** @的用户列表发生改变时,将最新值暴露给父组件 */

useEffect(() => {

const selectUsers = getAttrIds();

onChange(content, selectUsers);

}, [selected, content]);

return (

<div style={{ height, position: 'relative' }}>

{/* 编辑器 */}

<div id="atInput" ref={atRef} className={'editorDiv'} contentEditable onInput={editorChange} onClick={editorClick} />

{/* 选择用户框 */}

<SelectUser options={options} visible={visible} cursorPosition={cursorPosition} onSelect={onSelect} />

</div>

);

};

选择器代码

const SelectUser = React.memo((props: SelectComProps) => {

const { options, visible, cursorPosition, onSelect } = props;

const { x, y } = cursorPosition;

return (

<div

className={'selectWrap'}

style={{

display: `${visible ? 'block' : 'none'}`,

position: 'absolute',

left: x,

top: y + 20,

}}

>

<ul>

{options.map((item) => {

return (

<li

key={item.id}

onClick={() => {

onSelect(item);

}}

>

<img src={item.wechatAvatarUrl} alt="" />

<span>{item.name}</span>

</li>

);

})}

</ul>

</div>

);

});

export default SelectUser;

以上就是实现一个支持@用户的输入框功能,就目前而言,比较死板,不支持自定义颜色,自定义选择器等等,未来,可以进一步扩展功能,例如添加@用户的高亮样式定制、支持键盘快捷键操作等,从而提升用户体验和功能性。

来源:juejin.cn/post/7357917741909819407

Vue.js 自动路由:告别手动配置,让开发更轻松!

在使用 Vue.js 开发项目的时候,我最头疼的就是创建路由,尤其是项目越来越大的时候,管理 route.ts 或 route.js 文件简直是一场噩梦!

我曾经做过一个页面超级多的项目,每新增一个页面就要更新路由,删除页面也要更新路由文件,不然就会报错,真是烦死人了!

所以,我开始寻找自动生成路由的方法。我在网上搜了很久,但大部分结果都是针对 Webpack 和 Vue 2 的,很难找到适合我的方案。最后,我在 Vue 的 GitHub 仓库的讨论区里提问,终于找到了答案!

那就是 Unplugin Vue Router! 它可以为 Vue 3 实现基于文件的自动路由,而且支持 TypeScript,设置起来也超级简单! 虽然官方说它还在实验阶段,但用起来已经很方便了。

创建项目,安装插件

首先,我们创建一个新的 Vue 项目。 相信大家都很熟悉用 Vue CLI 创建项目了,这里就不赘述了,不熟悉的小伙伴可以去看看 Vue.js 官网的快速入门指南。

pnpm create vue@latest

我创建项目的时候选择了 TypeScript 和 Vue Router,这样它就会自动生成一些页面和路由。

然后,进入项目目录,安装依赖。我最近开始用 pnpm 来管理依赖,感觉还不错。

pnpm add -D unplugin-vue-router

接下来,更新 vite.config.ts 文件, 注意要把插件放在第 0 个位置 。

import { fileURLToPath, URL } from "node:url";

import VueRouter from "unplugin-vue-router/vite";

import { defineConfig } from "vite";

import vue from "@vitejs/plugin-vue";

// https://vitejs.dev/config/

export default defineConfig({

plugins: [

VueRouter({

/* options */

}),

// ⚠️ Vue must be placed after VueRouter()

vue(),

],

resolve: {

alias: {

"@": fileURLToPath(new URL("./src", import.meta.url)),

},

},

});

然后,更新 env.d.ts 文件,让编辑器能够识别插件的类型。

/// <reference types="vite/client" />

/// <reference types="unplugin-vue-router/client" />

最后,更新路由文件 src/router/index.ts 。

import { createRouter, createWebHistory } from "vue-router";

import { routes, handleHotUpdate } from "vue-router/auto-routes";

const router = createRouter({

history: createWebHistory(import.meta.env.BASE_URL),

routes,

});

if (import.meta.hot) {

handleHotUpdate(router);

}

export default router;

创建页面,自动生成路由

现在,我们可以创建 src/pages 目录了,在这个目录下创建的 Vue 组件会自动变成路由和页面,就像 Nuxt 一样方便!

我们先在 src\pages\about.vue 创建一个关于页面:

<template>

<div>This is the about page</div>

</template>

然后在 src\pages\index.vue 创建首页:

<template>

<div>This is Home Page</div>

</template>

运行 pnpm dev 启动开发服务器,点击 “Home” 链接就会跳转到首页,点击 “About” 链接就会跳转到关于页面。

怎么样,是不是很方便? 如果你不熟悉路由文件夹结构,可以看看这个文档: uvr.esm.is/guide/file-…

动态路由

我们再来试试创建带参数的动态路由。在 src/pages/blog/[id].vue 创建一个组件,内容如下:

<script setup>

const { id } = useRoute().params;

</script>

<template>

<div>This is the blog post with id: {{ id }}</div>

</template>

再次运行 pnpm dev ,然后访问 http://localhost:5173/blog/6 ,你就会看到以下内容:

是不是很神奇? 希望这篇简短的博客能帮助你在 Vue.js 的旅程中更轻松地创建路由!

来源:juejin.cn/post/7401354593588199465

JS类型判断的四种方法,你掌握了吗?

引言

JavaScript中有七种原始数据类型和几种引用数据类型,本文将清楚地介绍四种用于类型判断的方法,分别是typeOf、instanceOf、Object.prototype.toString.call()、Array.isArray(),并介绍其使用方法和判定原理。

typeof

- 可以准确判断除

null之外的所有原始类型,null会被判定成object function类型可以被准确判断为function,而其他所有引用类型都会被判定为object

let s = '123' // string

let n = 123 // number

let f = true // boolean

let u = undefined // undefined

let nu = null // null

let sy = Symbol(123) // Symbol

let big = 1234n // BigInt

let obj = {}

let arr = []

let fn = function() {}

let date = new Date()

console.log(typeof s); // string typeof后面有无括号都行

console.log(typeof n); // number

console.log(typeof f); // boolean

console.log(typeof u); // undefined

console.log(typeof(sy)); // symbol

console.log(typeof(big)); // bigint

console.log(typeof(nu)); // object

console.log(typeof(obj)); // object

console.log(typeof(arr)); // object

console.log(typeof(date)); // object

console.log(typeof(fn)); // function

判定原理

typeof是通过将值转换为二进制之后,判断其前三位是否为0:都是0则为object,反之则为原始类型。因为原始类型转二进制,前三位一定不都是0;反之引用类型被转换成二进制前三位一定都是0。

null是原始类型却被判定为object就是因为它在机器中是用一长串0来表示的,可以把这看作是一个史诗级的bug。

所以用typeof判断接收到的值是否为一个对象时,还要注意排除null的情况:

function isObject() {

if(typeof(o) === 'object' && o !== null){

return true

}

return false

}

你丢一个值给typeof,它会告诉你这个字值是什么类型,但是它无法准确告诉你这是一个Array或是Date,若想要如此精确地知道一个对象类型,可以用instanceof告诉你是否为某种特定的类型

instanceof

只能精确地判断引用类型,不能判断原始类型

console.log(obj instanceof Object);// true

console.log(arr instanceof Array);// true

console.log(fn instanceof Function);// true

console.log(date instanceof Date);// true

console.log(s instanceof String);// false

console.log(n instanceof Number);// false

console.log(arr instanceof Object);// true

判定原理

instanceof既能把数组判定成Array,又能把数组判定成Object,究其原因是原型链的作用————顺着数组实例 arr 的隐式原型一直找到了 Object 的构造函数,看下面的代码:

arr.__proto__ = Array.prototype

Array.prototype.__proto__ = Object.prototype

所以我们就知道了,instanceof能准确判断出一个对象是否为某种类型,就是依靠对象的原型链来查找的,一层又一层地判断直到找到null为止。

手写instanceOf

根据这个原理,我们可以手写出一个instanceof:

function myinstanceof(L, R) {

while(L != null) {

if(L.__proto__ === R.prototype){

return true;

}

L = L.__proto__;

}

return false;

}

console.log(myinstanceof([], Array)) // true

console.log(myinstanceof({}, Object)) // true

对象的隐式原型 等于 构造函数的显式原型!可看文章 给我三分钟,带你完全理解JS原型和原型链前言

Object.prototype.toString.call()

可以判断任何数据类型

在浏览器上执行这三段代码,会得到'[object Object]','[object Array]','[object Number]'

var a = {}

Object.prototype.toString.call(a)

var a = {}

Object.prototype.toString.call(a)

var a = 123

Object.prototype.toString.call(a)

原型上的toString的内部逻辑

调用Object.prototype.toString的时候执行会以下步骤: 参考官方文档:带注释的 ES5

- 如果此值是

undefined类型,则返回‘[object Undefined]’ - 如果此值是

null类型,则返回‘[object Null]’ - 将 O 作为

ToObject(this)的执行结果。toString执行过程中会调用一个ToObject方法,执行一个类似包装类的过程,我们访问不了这个方法,是JS自己用的 - 定义一个

class作为内部属性[[class]]的值。toString可以读取到这个值并把这个值暴露出来让我们看得见 - 返回由

"[object"和class和"]"组成的字符串

为什么结合call就能准确判断值类型了呢?

① 首先我们要知道Object.prototype.toString(xxx)往括号中不管传递什么返回结果都是'[object Object]',因为根据上面五个步骤来看,它内部会自动执行ToObject()方法,xxx会被执行一个类似包装类的过程然后转变成一个对象。所以单独一个Object.prototype.toString(xxx)不能用来判定值的类型

② 其次了解call方法的核心原理就是:比如foo.call(obj),利用隐式绑定的规则,让obj对象拥有foo这个函数的引用,从而让foo函数的this指向obj,执行完foo函数内部逻辑后,再将foo函数的引用从obj上删除掉。手搓一个call的源码就是这样的:

// call方法只允许被函数调用,所以它应该是放在Function构造函数的显式原型上的

Function.prototype.mycall = function(context) {

// 判断调用我的那个哥们是不是函数体

if (typeof this !== 'function') {

return new TypeError(this+ 'is not a function')

}

// this(函数)里面的this => context对象

const fn = Symbol('key') // 定义一个独一无二的fn,防止使用该源码时与其他fn产生冲突

context[fn] = this // 让对象拥有该函数 context={Symbol('key'): foo}

context[fn]() // 触发隐式绑定

delete context[fn]

}

③ 所以Object.prototype.toString.call(xxx)就相当于 xxx.toString(),把toString()方法放在了xxx对象上调用,这样就能精准给出xxx的对象类型

toString方法有几个版本:

{}.toString()得到由"[object" 和 class 和 "]" 组成的字符串

[].toString()数组的toString方法重写了对象上的toString方法,返回由数组内部元素以逗号拼接的字符串

xx.toString()返回字符串字面量,比如

let fn = function(){};

console.log( fn.toString() ) // "function () {}"

Array.isArray(x)

只能判断是否是数组,若传进去的x是数组,返回true,否则返回false

总结

typeOf:原始类型除了null都能准确判断,引用类型除了function能准确判断其他都不能。依靠值转为二进制后前三位是否为0来判断

instanceOf:只能把引用类型丢给它准确判断。顺着对象的隐式原型链向上比对,与构造函数的显式原型相等返回true,否则false

Object.prototype.toString.call():可以准确判断任何类型。要了解对象原型的toString()内部逻辑和call()的核心原理,二者结合才有精准判定的效果

Array.isArray():是数组则返回true,不是则返回false。判定范围最狭窄

来源:juejin.cn/post/7403288145196580904

学TypeScript必然要了解declare

背景

declare关键字是为了服务TypeScript的。TypeScript是什么在这里就不多介绍了,但是我们要知道ts文件是需要TypeScript编译器转换为js文件才可以执行,并且在编译阶段就会进行类型检查。但是在TypeScript中并不支持js可识别的所有类型,例如我们使用第三方库JQuery,我们通过一下方法获取一个id为‘foo’的标签元素。

$('#foo');

// or

jQuery('#foo');

然而在ts文件中,使用底下就会爆出一条红线提示到:Cannot find name '$'

因此,需要declare来声明,告诉TypeScript编译器该标识符已存在,通过编译时的检查并在开发时提供类型提示。

定义

在 TypeScript 中,declare关键字告诉编译器存在一个对象(并且可以在代码中引用)。它向 TypeScript 编译器声明该对象。简而言之,它允许开发人员使用在其他地方声明的对象。

注:编译器不会将declare语句编译为 JavaScript。对比下面两段代码:

// declare声明了一个名为 myGlobal 的全局变量,并指定其类型为 any。

// 该声明并不会生成真正的 JavaScript 代码,而只是告诉 TypeScript 编译器该变量存在。

declare var myGlobal: any;

// 给 myGlobal 赋值为 42。

myGlobal = 42;

console.log(myGlobal); // 42

// 直接声明了一个名为 myGlobal 的全局变量,并指定其类型为 any。这会生成真正的 JavaScript 代码。

var myGlobal: any;

// 给 myGlobal 赋值为 42。

myGlobal = 42;

console.log(myGlobal); // 42

使用

- declare var 声明全局变量

- declare function 声明全局方法

- declare class 声明全局类

- declare enum 声明全局枚举类型

- declare namespace 声明(含有子属性的)全局对象

- declare global 扩展全局变量

- declare module 扩展模块

声明文件

通常,在使用第三方库或模块时,有两种方式引入声明文件:

- 全局声明:如果第三方库或模块是全局可访问的,你可以在整个项目的任何地方直接使用它们,而无需显式导入。此时,你只需要确保在 TypeScript 项目中正确引入了相应的声明文件。一般情况下,TypeScript 会自动查找并加载全局声明文件。如果没有自动加载,你可以使用 /// 的方式在具体的源文件中将声明文件引入。

- 模块导入:如果第三方库或模块是通过模块化方式提供的,你需要使用 import 语句将其导入到你的代码中,同时也需要确保相应的声明文件被正确引入。在这种情况下,你可以使用 import 或 require 来引入库,并且不需要显式地引入声明文件,因为 TypeScript 编译器会根据模块的导入语句自动查找和加载相应的声明文件。

有很多第三方库提供了声明文件,可以在packages.json文件中查看。types表示类型声明文件是哪一个。

可以使用 @types 统一管理第三方库的声明文件。@types 的使用方式很简单,直接用 npm 安装对应的声明模块即可,以 jQuery 举例:

npm install @types/jquery --save-dev

来源:juejin.cn/post/7402811318816702515

厉害了,不用js就能实现文字中间省略号

今天发现一个特别有意思的效果,并进行解析,就是标题的效果

参考链接

如果要实现这个功能,我想很多人第一时间想到的都是用js去计算dom容器和文字之间是否溢出吧?但今天带来一个用css实现的效果,不用自己计算,只需要寥寥几行(bushi)就可以实现让人头疼的文字中间省略号功能。

实现思路

1. 简单实现

在用css实现的时候我们不妨用这个思路想想,设置一个当前显示文字span伪元素的width为50%,浮动到当前span上面,并且设置direction: rtl; 显示右边文字,不就可以很简单的实现这个功能了?让我们试试:

<style>

.wrap {

width: 200px;

border: 1px solid white;

}

.test-title {

display: block;

color: white;

overflow: hidden;

height: 20px;

}

.test-title::before {

content: attr(title);

width: 50%;

float: right;

white-space: nowrap;

overflow: hidden;

text-overflow: ellipsis;

direction: rtl;

}

</style>

<body>

<div class="wrap">

<span class="test-title" title="这是一行文字文字文字文字文字文字文字文字文字文字文字文字文字">

这是一行文字文字文字文字文字文字文字文字文字文字文字文字文字

</span>

</div>

</body>

💡 此处应有图

2. 优化效果

在上面我们已经看到,其实效果我们已经实现了,现在文字中间已经有了省略号了!但是这其中其实有一个弊端不知道大家有没有发现,那就是文本不溢出的情况呢?伪元素是不是会一直显示在上面?这该怎么办?难道我们需要用js监听文本不溢出的情况然后手动隐藏吗?

既然是用css来进行实现,那么我们当然不能用这种方式了。这里原作者用了一种很取巧,但也很好玩的一种方法,让我们来看看吧!

既然我们上面实现的是文本溢出的情况,那么当文本不溢出的时候我们直接显示文字不就行了?你可能想说:“这不是废话吗?但我现在不就是不知道怎么判断吗? ”。hhhhh对,那我们就要用css来想想,css该怎么判断呢?我就不卖关子了,让我们想想,我们给文本的容器添加一个固定宽度,那么当文本溢出的时候会发生什么呢?是不是会换行,高度变大呢,那么当我们设置两个文本元素,一个是正常样式,一个是我们上方的溢出样式。等文本不溢出没换行的时候,显示正常样式,当文本溢出高度变大的时候显示溢出样式可以吗?让我们试试吧

<!DOCTYPE html>

<html lang="en">

<head>

<style>

body {

background: #333;

height: 100vh;

display: flex;

justify-content: center;

align-items: center;

margin: 0;

font-size: 14px;

}

.wrap {

width: 300px;

background: #333;

/* 设置正常行高,并隐藏溢出画面 */

height: 2em;

overflow: hidden;

line-height: 2;

position: relative;

text-align: -webkit-match-parent;

resize: horizontal;

}

.normal-title {

/* 设置最大高度为双倍行高使其可以换行 */

display: block;

max-height: 4em;

}

.test-title {

position: relative;

top: -4em;

display: block;

color: white;

overflow: hidden;

height: 2em;

text-align: justify;

background: inherit;

overflow: hidden;

}

.test-title::before {

content: attr(title);

width: 50%;

float: right;

white-space: nowrap;

overflow: hidden;

text-overflow: ellipsis;

direction: rtl;

}

</style>

</head>

<body>

<div class="wrap">

<span class="normal-title">这是一行文字文字文字文字文字文字文字文字文字文字文字文字文字</span>

<span class="test-title" title="这是一行文字文字文字文字文字文字文字文字文字文字文字文字文字">

这是一行文字文字文字文字文字文字文字文字文字文字文字文字文字

</span>

</div>

</body>

</html>

大家都试过了吧?那让我们来讲一下这段代码的实现:

实现方式:简单来说这段代码实现的就是一个覆盖的效果,normal-title元素平常是普通高度(1em),等到换行之后就会变成2em,那么我们的溢出样式test-title怎么实现的覆盖呢?这主要依赖于test-title的top属性,让我们这样子想,当normal-title高度为1em的时候,test-title的top为-2em,那么这时候因为wrap的hidden效果,所以test-title是看不到的。那么当normal-title的高度为2em的时候呢?test-title刚好就会覆盖到normal-title上面,所以我们刚好可以看到test-title的省略号效果。

这就是完整的实现过程和方式,css一些取巧的判断方式总会让我们大开眼界,不断学习,方得始终。

来源:juejin.cn/post/7401812292211081226

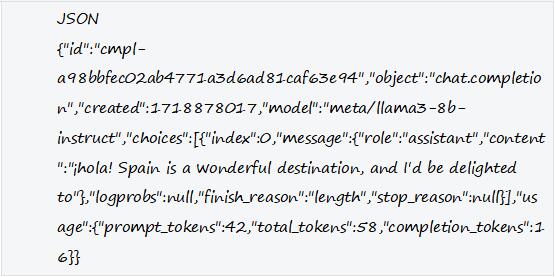

1. 使用openai api实现一个智能前端组件

0. 注意

本文只是提供一个思路,由于现在大模型正在飞速发展,整个生态在不久的将来或许会发生巨大的变化,文章中的代码仅供参考。

1. 一个简单的示例

假设当前时间是2023年12月28日,时间段选择器通过理解用户输入表述,自动设置值。

可以看到组件正确理解了用户想要设置的时间。

2.原理简介

graph TD

输入文字描述 --> 请求语言模型接口 --> 处理语言模型响应 --> 功能操作

其实原理很简单,就是通过代码的方式问模型问题,然后让他回答。这和我们使用chatgpt一样的。

3. 实现

输入描述就不说了,就是输入框。关键在于请求和处理语言模型的接口。

最简单的就是直接使用api请求这些大模型的官方接口,但是我们需要处理各种平台之间的接口差异和一些特殊问题。这里我使用了一个开发语言模型应用的框架LangChain。

3.1. LangChain

简单的说,这是一个面向语言处理模型的编程框架,从如何输入你的问题,到如何处理回答都有规范的工具来实现。

// 这是一个最简单的例子

import { OpenAI } from "langchain/llms/openai";

import { ChatOpenAI } from "langchain/chat_models/openai";

// 初始化openai模型

const llm = new OpenAI({

temperature: 0.9,

});

// 准备一个输入文本

const text =

"What would be a good company name for a company that makes colorful socks?";

// 输入文本,获取响应

const llmResult = await llm.predict(text);

//=> 响应一段文本:"Feetful of Fun"

整个框架主要就是下面三个部分组成:

graph LR

A["输入模板(Prompt templates)"] --- B["语言模型(Language models)"] --- C["输出解释器(Output parsers)"]

Prompt templates:输入模板分一句话(not chat)和对话(chat)模式,区别就是输入一句话和多句话,而且对话模式中每句话有角色区分是谁说的,比如人类、AI、系统。这里简单介绍一下非对话模式下怎么创建输入模板。

import { PromptTemplate } from "langchain/prompts";

// 最简单的模板生成,使用fromTemplate传入一句话

// 可以在句子中加入{}占位符表示变量

const oneInputPrompt = PromptTemplate.fromTemplate(

`You are a naming consultant for new companies.

What is a good name for a company that makes {product}?`

);

// 也可以直接实例化设置

const twoInputPrompt = new PromptTemplate({

inputVariables: ["adjective"],

template: "Tell me a {adjective} joke.",

});

// 如果你想要这样和模型对话

// 先给出几个例子,然后在问问题

Respond to the users question in the with the following format:

Question: What is your name?

Answer: My name is John.

Question: What is your age?

Answer: I am 25 years old.

Question: What is your favorite color?

Answer:

// 可以使用FewShotPromptTemplate

// 创建一些模板,字段名随便你定

const examples = [

{

input:

"Could the members of The Police perform lawful arrests?",

output: "what can the members of The Police do?",

},

{

input: "Jan Sindel's was born in what country?",

output: "what is Jan Sindel's personal history?",

},

];

// 输入模板,包含变量就是模板要填充的

const prompt = `Human: {input}\nAI: {output}`;

const examplePromptTemplate = PromptTemplate.fromTemplate(prompt);

// 创建example输入模板

const fewShotPrompt = new FewShotPromptTemplate({

examplePrompt: examplePromptTemplate,

examples,

inputVariables: [], // no input variables

});

console.log(

(await fewShotPrompt.formatPromptValue({})).toString()

);

// 输出

Human: Could the members of The Police perform lawful arrests?

AI: what can the members of The Police do?

Human: Jan Sindel's was born in what country?

AI: what is Jan Sindel's personal history?

// 还有很多可以查询官网

Language models: 语言模型同样分为LLM(大语言模型)和chat模型,其实两个差不多,就是输入多少和是否可以连续对话的区别。

import { OpenAI } from "langchain/llms/openai";

const model = new OpenAI({ temperature: 1 });

// 可以添加超时

const resA = await model.call(

"What would be a good company name a company that makes colorful socks?",

{ timeout: 1000 } // 1s timeout

);

// 注册一些事件回调

const model = new OpenAI({

callbacks: [

{

handleLLMStart: async (llm: Serialized, prompts: string[]) => {

console.log(JSON.stringify(llm, null, 2));

console.log(JSON.stringify(prompts, null, 2));

},

handleLLMEnd: async (output: LLMResult) => {

console.log(JSON.stringify(output, null, 2));

},

handleLLMError: async (err: Error) => {

console.error(err);

},

},

],

});

// 还有一些配置可以参考文档

Output parsers: 顾名思义就是处理输出的模块,当语言模型回答了一段文字程序是很难提取出有用信息的, 我们通常需要模型返回一个程序可以处理的答案,比如JSON。虽然叫输出解释器,实际上是在输入信息中加入一些额外的提示,让模型能够按照需求格式输出。

// 这里用StructuredOutputParser,结构化输出解释器为例

// 使用StructuredOutputParser创建一个解释器

// 定义了输出有两个字段answer、source

// 字段的值是对这个字段的描述在

const parser = StructuredOutputParser.fromNamesAndDescriptions({

answer: "answer to the user's question",

source: "source used to answer the user's question, should be a website.",

});

// 使用RunnableSequence,批量执行任务

const chain = RunnableSequence.from([

// 输入包含了两个变量,一个是结构化解释器的“格式说明”,一个是用户的问题

PromptTemplate.fromTemplate(

"Answer the users question as best as possible.\n{format_instructions}\n{question}"

),

new OpenAI({ temperature: 0 }),

parser,

]);

// 与模型交互

const response = await chain.invoke({

question: "What is the capital of France?",

format_instructions: parser.getFormatInstructions(),

});

// 响应 { answer: 'Paris', source: 'https://en.wikipedia.org/wiki/Paris' }

// 输入的模板是这样

Answer the users question as best as possible. // 这句话就是prompt的第一句

// 下面一大段是StructuredOutputParser自动加上的,大概就是告诉模型json的标准格式应该是什么

The output should be formatted as a JSON instance that conforms to the JSON schema below.

As an example, for the schema {{"properties": {{"foo": {{"title": "Foo", "description": "a list of strings", "type": "array", "items": {{"type": "string"}}}}}}, "required": ["foo"]}}}}

the object {{"foo": ["bar", "baz"]}} is a well-formatted instance of the schema. The object {{"properties": {{"foo": ["bar", "baz"]}}}} is not well-formatted.

Here is the output schema:

```

{"type":"object","properties":{"answer":{"type":"string","description":"answer to the user's question"},"sources":{"type":"array","items":{"type":"string"},"description":"sources used to answer the question, should be websites."}},"required":["answer","sources"],"additionalProperties":false,"$schema":"http://json-schema.org/draft-07/schema#"}

```

// 这段就是调用的时候传入的问题

What is the capital of France?

// 还有很多不同的解释器

// 如StringOutputParser字符串输出解释器

// JsonOutputFunctionsParser json函数输出解释器等等

除了这三部分,还有一些方便程序操作的一些功能模块,比如记录聊天状态的Memory模块,知识库模块Retrieval等等,这些官网有比较完整的文档,深度的使用后面再来探索。

3.2. 简单版本

// 初始化语言模型

// 这里使用的openai

const llm = new OpenAI({

openAIApiKey: import.meta.env.VITE_OPENAI_KEY,

temperature: 0,

});

function App() {

const [res, setRes] = useState<string>();

const [from] = Form.useForm();

return (

<>

<div>结果:{res}</div>

<Form wrapperCol={{ span: 6 }} form={from}>

<Form.Item label="输入描述">

<Input.Search

onSearch={async (value) => {

setRes("正在请求");

// 直接对话模型

const text =

`现在是${dayjs().format("YYYY-MM-DD")},${value},开始结束时间是什么。请用这个格式回答{startTime: '开始时间', endTime: '结束时间'}`;

// 简单预测文本

const llmResult = await llm.predict(text);

const response = JSON.parse(llmResult)

// 解析

const { startTime, endTime } = response;

// 设置

from.setFieldsValue({

times: [dayjs(startTime), dayjs(endTime)],

});

setRes(llmResult)

}}

enterButton={<Button type="primary">确定</Button>}

/>

</Form.Item>

<Form.Item label="时间段" name="times">

<DatePicker.RangePicker />

</Form.Item>

</Form>

</>

);

}

export default App;

前面虽然能实现功能,但是有很多边界条件无法考虑到,比如有的模型无法理解你这个返回格式是什么意思,或者你有很多个字段那你就要写一大串输入模板。

3.3. 使用结构化输出解释器

// 修改一下onSearch

setRes("正在请求");

// 定义输出有两个字段startTime、endTime

const parser = StructuredOutputParser.fromNamesAndDescriptions({

startTime: "开始时间,格式是YYYY-MM-DD HH:mm:ss",

endTime: "结束时间,格式是YYYY-MM-DD HH:mm:ss",

});

const chain = RunnableSequence.from([

// 输入模板

PromptTemplate.fromTemplate(

`{format_instructions}\n现在是${dayjs().format(

"YYYY-MM-DD"

)},{question},开始结束时间是什么`

),

llm,

parser,

]);

const response = await chain.invoke({

question: value,

// 把输出解释器的提示放入输入模板中

format_instructions: parser.getFormatInstructions(),

});

// 这个时候经过结构化解释器处理,返回的就是json

setRes(JSON.stringify(response));

const { startTime, endTime } = response;

from.setFieldsValue({

times: [dayjs(startTime), dayjs(endTime)],

});

对于大型一点的项目,使用langChain的api可以更规范的组织我们的代码。

// 完整代码

import { OpenAI } from "langchain/llms/openai";

import { useState } from "react";

import {

PromptTemplate,

} from "langchain/prompts";

import { StructuredOutputParser } from "langchain/output_parsers";

import { RunnableSequence } from "langchain/runnables";

import { Button, DatePicker, Form, Input } from "antd";

import "dayjs/locale/zh-cn";

import dayjs from "dayjs";

const llm = new OpenAI({

openAIApiKey: import.meta.env.VITE_OPENAI_KEY,

temperature: 0,

});

function App() {

const [res, setRes] = useState<string>();

const [from] = Form.useForm();

return (

<>

<div>结果:{res}</div>

<Form wrapperCol={{ span: 6 }} form={from}>

<Form.Item label="输入描述">

<Input.Search

onSearch={async (value) => {

setRes("正在请求");

const parser = StructuredOutputParser.fromNamesAndDescriptions({

startTime: "开始时间,格式是YYYY-MM-DD HH:mm:ss",

endTime: "结束时间,格式是YYYY-MM-DD HH:mm:ss",

});

const chain = RunnableSequence.from([

PromptTemplate.fromTemplate(

`{format_instructions}\n现在是${dayjs().format(

"YYYY-MM-DD"

)},{question},开始结束时间是什么`

),

llm,

parser,

]);

const response = await chain.invoke({

question: value,

format_instructions: parser.getFormatInstructions(),

});

setRes(JSON.stringify(response));

const { startTime, endTime } = response;

from.setFieldsValue({

times: [dayjs(startTime), dayjs(endTime)],

});

}}

enterButton={<Button type="primary">确定</Button>}

/>

</Form.Item>

<Form.Item label="时间段" name="times">

<DatePicker.RangePicker />

</Form.Item>

</Form>

</>

);

}

export default App;

4.总结

这篇文章只是我初步使用LangChain的一个小demo,在智能组件上面,大家其实可以发挥更大的想象去发挥。还有很多组件可以变成自然语言驱动的。

随着以后大模型的小型化,专门化,我相信肯定会涌现更多的智能组件。

来源:juejin.cn/post/7317440781588840486

Vue.js 自动路由:告别手动配置,让开发更轻松!

在使用 Vue.js 开发项目的时候,我最头疼的就是创建路由,尤其是项目越来越大的时候,管理 route.ts 或 route.js 文件简直是一场噩梦!

我曾经做过一个页面超级多的项目,每新增一个页面就要更新路由,删除页面也要更新路由文件,不然就会报错,真是烦死人了!

所以,我开始寻找自动生成路由的方法。我在网上搜了很久,但大部分结果都是针对 Webpack 和 Vue 2 的,很难找到适合我的方案。最后,我在 Vue 的 GitHub 仓库的讨论区里提问,终于找到了答案!

那就是 Unplugin Vue Router! 它可以为 Vue 3 实现基于文件的自动路由,而且支持 TypeScript,设置起来也超级简单! 虽然官方说它还在实验阶段,但用起来已经很方便了。

创建项目,安装插件

首先,我们创建一个新的 Vue 项目。 相信大家都很熟悉用 Vue CLI 创建项目了,这里就不赘述了,不熟悉的小伙伴可以去看看 Vue.js 官网的快速入门指南。

pnpm create vue@latest

我创建项目的时候选择了 TypeScript 和 Vue Router,这样它就会自动生成一些页面和路由。

然后,进入项目目录,安装依赖。我最近开始用 pnpm 来管理依赖,感觉还不错。

pnpm add -D unplugin-vue-router

接下来,更新 vite.config.ts 文件, 注意要把插件放在第 0 个位置 。

import { fileURLToPath, URL } from "node:url";

import VueRouter from "unplugin-vue-router/vite";

import { defineConfig } from "vite";

import vue from "@vitejs/plugin-vue";

// https://vitejs.dev/config/

export default defineConfig({

plugins: [

VueRouter({

/* options */

}),

// ⚠️ Vue must be placed after VueRouter()

vue(),

],

resolve: {

alias: {

"@": fileURLToPath(new URL("./src", import.meta.url)),

},

},

});

然后,更新 env.d.ts 文件,让编辑器能够识别插件的类型。

/// <reference types="vite/client" />

/// <reference types="unplugin-vue-router/client" />

最后,更新路由文件 src/router/index.ts 。

import { createRouter, createWebHistory } from "vue-router";

import { routes, handleHotUpdate } from "vue-router/auto-routes";

const router = createRouter({

history: createWebHistory(import.meta.env.BASE_URL),

routes,

});

if (import.meta.hot) {

handleHotUpdate(router);

}

export default router;

创建页面,自动生成路由

现在,我们可以创建 src/pages 目录了,在这个目录下创建的 Vue 组件会自动变成路由和页面,就像 Nuxt 一样方便!

我们先在 src\pages\about.vue 创建一个关于页面:

<template>

<div>This is the about page</div>

</template>

然后在 src\pages\index.vue 创建首页:

<template>

<div>This is Home Page</div>

</template>

运行 pnpm dev 启动开发服务器,点击 “Home” 链接就会跳转到首页,点击 “About” 链接就会跳转到关于页面。

怎么样,是不是很方便? 如果你不熟悉路由文件夹结构,可以看看这个文档: uvr.esm.is/guide/file-…

动态路由

我们再来试试创建带参数的动态路由。在 src/pages/blog/[id].vue 创建一个组件,内容如下:

<script setup>

const { id } = useRoute().params;

</script>

<template>

<div>This is the blog post with id: {{ id }}</div>

</template>

再次运行 pnpm dev ,然后访问 http://localhost:5173/blog/6 ,你就会看到以下内容:

是不是很神奇? 希望这篇简短的博客能帮助你在 Vue.js 的旅程中更轻松地创建路由!

来源:juejin.cn/post/7401354593588199465

学TypeScript必然要了解declare

背景

declare关键字是为了服务TypeScript的。TypeScript是什么在这里就不多介绍了,但是我们要知道ts文件是需要TypeScript编译器转换为js文件才可以执行,并且在编译阶段就会进行类型检查。但是在TypeScript中并不支持js可识别的所有类型,例如我们使用第三方库JQuery,我们通过一下方法获取一个id为‘foo’的标签元素。

$('#foo');

// or

jQuery('#foo');

然而在ts文件中,使用底下就会爆出一条红线提示到:Cannot find name '$'

因此,需要declare来声明,告诉TypeScript编译器该标识符已存在,通过编译时的检查并在开发时提供类型提示。

定义

在 TypeScript 中,declare关键字告诉编译器存在一个对象(并且可以在代码中引用)。它向 TypeScript 编译器声明该对象。简而言之,它允许开发人员使用在其他地方声明的对象。

注:编译器不会将declare语句编译为 JavaScript。对比下面两段代码:

// declare声明了一个名为 myGlobal 的全局变量,并指定其类型为 any。

// 该声明并不会生成真正的 JavaScript 代码,而只是告诉 TypeScript 编译器该变量存在。

declare var myGlobal: any;

// 给 myGlobal 赋值为 42。

myGlobal = 42;

console.log(myGlobal); // 42

// 直接声明了一个名为 myGlobal 的全局变量,并指定其类型为 any。这会生成真正的 JavaScript 代码。

var myGlobal: any;

// 给 myGlobal 赋值为 42。

myGlobal = 42;

console.log(myGlobal); // 42

使用

- declare var 声明全局变量

- declare function 声明全局方法

- declare class 声明全局类

- declare enum 声明全局枚举类型

- declare namespace 声明(含有子属性的)全局对象

- declare global 扩展全局变量

- declare module 扩展模块

声明文件

通常,在使用第三方库或模块时,有两种方式引入声明文件:

- 全局声明:如果第三方库或模块是全局可访问的,你可以在整个项目的任何地方直接使用它们,而无需显式导入。此时,你只需要确保在 TypeScript 项目中正确引入了相应的声明文件。一般情况下,TypeScript 会自动查找并加载全局声明文件。如果没有自动加载,你可以使用 /// 的方式在具体的源文件中将声明文件引入。

- 模块导入:如果第三方库或模块是通过模块化方式提供的,你需要使用 import 语句将其导入到你的代码中,同时也需要确保相应的声明文件被正确引入。在这种情况下,你可以使用 import 或 require 来引入库,并且不需要显式地引入声明文件,因为 TypeScript 编译器会根据模块的导入语句自动查找和加载相应的声明文件。

有很多第三方库提供了声明文件,可以在packages.json文件中查看。types表示类型声明文件是哪一个。

可以使用 @types 统一管理第三方库的声明文件。@types 的使用方式很简单,直接用 npm 安装对应的声明模块即可,以 jQuery 举例:

npm install @types/jquery --save-dev

来源:juejin.cn/post/7402811318816702515

前端如何将git的信息打包进html

为什么要做这件事

- 定制化项目我们没有参与或者要临时更新客户的包的时候,需要查文档才知道哪个是最新分支

- 当测试环境打包的时候,不确定是否是最新的包,需要点下功能看是否是最新的代码,不能直观的看到当前打的是哪个分支

- 多人开发的时候,某些场景下可能被别人覆盖了,需要查下jenkins或者登录服务器看下

实现效果

如下,当打开F12,可以直观的看到打包日期、分支、提交hash、提交时间

如何做

主要是借助 git-revision-webpack-plugin的能力。获取到git到一些后,将这些信息注入到变量中,html读取这个变量即可

1. 安装dev的依赖

npm install --save-dev git-revision-webpack-plugin

2. 引入依赖并且初始化

const { GitRevisionPlugin } = require('git-revision-webpack-plugin')

const gitRevisionPlugin = new GitRevisionPlugin()

3. 注入变量信息

我这里用的是vuecli,可直接在chainWebpack中注入,当然你可以使用DefinePlugin进行声明

config.plugin('html').tap((args) => {

args[0].banner = {

date: dayjs().format('YYYY-MM-DD HH:mm:ss'),

branch: gitRevisionPlugin.branch(),

commitHash: gitRevisionPlugin.commithash(),

lastCommitDateTime: dayjs(gitRevisionPlugin.lastcommitdatetime()).format('YYYY-MM-DD HH:mm:ss'),

}

return args

});

4. 使用变量

在index.html的头部插入注释

<!-- date <%= htmlWebpackPlugin.options.banner.date %> -->

<!-- branch <%= htmlWebpackPlugin.options.banner.branch %> -->

<!-- commitHash <%= htmlWebpackPlugin.options.banner.commitHash %> -->

<!-- lastCommitDateTime <%= htmlWebpackPlugin.options.banner.lastCommitDateTime %> -->

5. 查看页面

6. 假如你用的是vuecli

当你使用的是vuecli,构建完后会发现index.html上这个注释丢失了

原因如下

vueCLi 对html的打包用的html-webpack-plugin,默认在打包的时候会把注释删除掉

修改vuecli的配置如下可以解决,将removeComments设置为false即可

module.exports = {

// 其他配置项...

chainWebpack: config => {

config

.plugin('html')

.tap(args => {

args[0].minify = {

removeComments: false,

// 其他需要设置的参数

};

return args;

});

},

};

7. 假如你想给qiankun的子应用添加一些git的注释信息,可以在meta中添加

<meta name="description"

content="Date:<%= htmlWebpackPlugin.options.banner.date %>,Branch:<%= htmlWebpackPlugin.options.banner.branch %>,commitHash: <%= htmlWebpackPlugin.options.banner.commitHash %>,lastCommitDateTime:<%= htmlWebpackPlugin.options.banner.lastCommitDateTime %>">

渲染在html上如下,也可以快速的看到子应用的构建时间和具体的分支

总结

- 借助git-revision-webpack-plugin的能力读取到git的一些信息

- 将变量注入在html中或者使用DefinePlugin进行声明变量

- 读取变量后显示在html上或者打印在控制台上可以把关键的信息保留,方便我们排查问题

来源:juejin.cn/post/7403185402347634724

码农的畅想:年入10个小目标

本文将以自己真实的创业项目为例,给大家分享如何写一个用于融资的BP(商业计划书)。

使命愿景

我们为小型艺培机构或个体老师提供好用的招生引流工具和教学课件,让老师能够更加专注教学和提升服务体验。

- 使命:让天下没有难做的艺术培训,通过艺术培训提升人类的幸福感。

- 愿景:成为艺培行业的贝壳(线下培训蜗牛艺术中心类似链家,线上平台艺培助理类似贝壳),实现年营收一百亿。

产品及服务

线下业务为蜗牛艺术中心,以提供融合了绘本阅读、艺术创作和图形编程的跨学科美育培训为主,同时也开设书法、舞蹈和音乐等品类的培训。

线上业务为艺培助理,是美术、音乐和舞蹈等培训机构教研、招生及运营的好帮手,引流产品为3D画展,现金产品为海报设计,利润产品为课程加盟。

- 载体:小程序、网页应用和APP。

- 服务:3D展厅、海报设计、拼团招生和课程加盟。

- 策略:移动端优先,通过海报设计和课程研发大赛获取目标用户,借助AIGC技术提升生产力,用产品力说话,靠口碑裂变。

团队

- 陈XX:创始人 CEO 产研负责人 美团技术专家 毕业于交大和某军校 曾在798当过美术馆长 有5年以上线下艺培经验。

- 杨XX:运营合伙人 毕业于交大和暨南大学,和创始人认识了16年 并一起经营了一家跨境电商服务公司,实现年营收500多万。

- 熊XX:教研合伙人 清华美院硕士和美育研究所委员 曾任探月学院美育教研负责人 和创始人认识了10年,三年前就一起尝试过创业,拥有15年艺培经验。

财务顾问:xxx,创始人的亲戚,曾任上市公司董事长助理,北大光华管理学院硕士。

行业背景

从21年底开始,国家大力限制学科培训,并于23年底教育部下发通知要大力推进跨学科美育,艺术教育将迎来大爆发,2025年的市场规模将由之前预期的2000亿增长为3000亿。

虽然新生儿的人口相比高峰下降了近一半,但艺术教育中偏兴趣的低龄目标学生(2到12岁),五年内也能维持在一个亿左右,而偏应试的大龄目标学生(12到19岁),也有一个亿左右,还有正在高速发展的成人艺培培训。

所以,整个艺培市场的规模,还能保持年复20%左右的增长,未来五年至少能达到5000亿(仅考虑低龄艺培市场,若人均5000元,渗透率50%即可达到)。

存在痛点

但由于经济下行,家长对课程和服务体验的要求越来越高,艺培机构普遍招生很难,急需技术赋能传统教育机构,提升产品服务标准程度、提高管理效率和坪效、缩短回本周期,技术的完善应用,将给予连锁教育机构实现标准化、规模化的机会。

相比学科培训,艺培的标准化要难很多,而且做服务的天花板很低,最多只能达到10亿的级别,巨头看不上,小团队又搞不定,目前还没有平台能够给艺培机构,提供系统化的通用解决方案,简化机构的日常工作,让机构能够更多的关注学生及家长,做好最核心的教学服务。

近几年,移动互联网发展已经非常成熟,服务艺培机构招生运营某个环节的软件,在市面上已经有了很多,不论是拼团招生的工具,还是海报设计的平台,或是校区管理的saas软件,都只能部分解决艺培机构的需求。

竞品及我们的优势

从海报设计看,有稿定设计、美图设计室、创客贴、爱设计、图怪兽等知名的设计平台,只有稿定设计的艺培模板素材相对丰富,但都不是专门面向艺培机构的,模板和素材不够丰富,且机构使用海报模板后,还需结合自己的招生运营方案做较大调整。我们提供的海报都是我们线下培训门店真实用于招生的海报,并且通过设计大赛,让用户也能为其他用户提供海报及素材,所以使用海报模板后,只需简单改一改品牌、logo和图片即可投入使用。

从3D展厅看,目前很多公司提供的展厅以面向政府企业的宣传为主,比如党建展览、历史回顾等,多数不支持实时在3D模型中去动态加载图片,使用成本比较高。我们提供3D展厅,是专门面向艺培机构的,可以实时动态修改画展中的作品,只要在后台替换了图片,系统无需上线,用户再次打开,展现的就是最新作品,我们可以做到一个展厅最低只需10元,甚至可以作为免费引流的工具。

从拼团招生看,市面上有很多第三方的招生公司,他们一般提供的方案是198元6次课,学生购买拼团课的钱,机构一分钱也拿不到,并且课次太多,机构的转化率也不高。我通过师训教会机构自己按照流程去组织拼团活动即可,我们的收费不到竞品的十分之一,甚至为了引流,可以完全免费。

从课程加盟看,目前市面美术做的比较好的有本来计画和小央美,但他们提供的都是传统的美术课程,并且软件使用的是第三方的课件系统,用户体验比较差;我们提供的是教育部23年底倡导的跨学科美育课程,不仅课程辨识度高,而且我们将艺术创作与绘本阅读及图形编程结合,其他机构很难模仿。

项目现状及展望

当前,线下培训方向:我们已经在深圳开了一家门店并实现盈利,近期正在郑州和北京各开一家分店(都有一定学生基础,基于已有的店进行跨学科升级),招聘了5个全职的美术老师和3个实习生;线上培训方向:艺培助理的小程序和网站均已上线,海报设计、拼团招生和3D展厅均已正式投入使用,近期正在接入一个合作的课程加盟老师,将带来一千个种子用户,日活突破一千(每天都需使用课件进行备课和上课)。

接下来的计划是,先融资500到1000万,组建10人的产研团队,根据种子用户的反馈,优化系统和收费方案,组织海报设计和课程研发大赛,实现线上业务月营收突破一百万;同时,在多个大城市打造10家线下培训旗舰店,实现月营收突破200万,为开展师训和课程加盟做好准备。

后续将会根据发展进行多轮融资,不断完善艺培助理的功能和服务,比如打造社区、增加招聘板块、提供短视频、支持直播等,为1000万个学生提供个性化的3D展厅(每个每年20元),发展100万个艺培助理会员(年费300元),同时在大城市开设100家直营门店,并为5000家艺培机构提供课程加盟,年营收达到:100020万+ 100300万 + 300100万 + 50004万 = 10亿。

资金及项目规划

- 股权架构:创始人 45% 联合创始人 25% 运营合伙人+技术合伙人20% 其他员工股权池 10%。

- 融资需求:500~1000万,出让20%的股权。

- 资金使用:50%用于搭建产研团队,30%用于为海报设计和课程制作大赛提供奖金,20%用于投放广告。

- 未来融资:一年后实现月营收100万,启动A轮融资2000~5000万,扩大规模,实现月营收一千万,三年后启动B轮融资一到三亿元,实现月营收五千万,五年后启动C轮融资,业务多元化,实现月营收一亿以上。

总结

小富靠勤,大富靠命。要坚信,命运永远掌握在自己手中。

随着这两年大模型技术的突飞猛进,很多简单重复的智力工作将被AI替代,大家将有更多的时间去丰富自己的精神需要,艺培行业的市场规模一定可以超过万亿。

如今,美术在线培训的美术宝和钢琴在线培训的vip陪练,都已经实现了年营收超过20亿,我们作为oMo模式的先行者,未来五年实现年营收10个亿只是个小目标。

我相信,这个商业计划能够实现的可能性很大的,在此分享给大家,即使我没有实现,肯定也会有其他人可以实现。

来源:juejin.cn/post/7376925694613274674

还在用 来当作空格?别忽视他对样式的影响!

许久没有更新博客了,今天就抽空来分享下之前遇到个有意思的现象~

奇怪的现象,被换行的单词

在一次新需求完工之后,进行国际化样式优化时,我发现了一个奇怪的现象:即使页面元素有word-wrap:break-word; 样式属性,单词也照样会被直接裁断换行。

这又是为什么嘞?细细分析页面元素,突然发现或许这与之前的踩过的坑:特殊的不换行空格有关?!

来复现吧!

那我们马上就来试一试!

<style>

.normal_style{

width:70px;

height:200px;

margin-right:150px;

border:1px solid red;

/* 👇表示 如果一个单词超出行长度,要截取换行,其他默认;👇 */

word-wrap:break-word;

}

</style>

<div style="display:flex;">

<div class='normal_style'>This is a long a long sentence</div>

<div class='normal_style'>This is a long a long sentence</div>

</div>

很明显,单词直接被强行换行拆分了!

那会不会是页面解析的时候,把 连同其他单词一起,当作一长串单词来处理了,所以才不换行的嘞?

你知道空格转义符有几种写法吗?

那我们就再来试试!不使用 转而使用其他空格转义符呢?

其实除了 ,还有其他很多种空格转义符。

1. 半角空格

它才是典型的“半角空格”,全称是En Space,en是字体排印学的计量单位,为em宽度的一半。根据定义,它等同于字体度的一半(如16px字体中就是8px)。名义上是小写字母n的宽度。此空格传承空格家族一贯的特性:透明的,此空格有个相当稳健的特性,就是其占据的宽度正好是1/2个中文宽度,而且基本上不受字体影响。

2. 全角空格

从这个符号到下面, 我们就很少见到了, 它叫“全角空格”,全称是Em Space,em是字体排印学的计量单位,相当于当前指定的点数。例如,1 em在16px的字体中就是16px。此空格也传承空格家族一贯的特性:透明的,此空格也有个相当稳健的特性,就是其占据的宽度正好是1个中文宽度,而且基本上不受字体影响。

3. 窄空格

窄空格,全称是Thin Space。我们不妨称之为“瘦弱空格”,就是该空格长得比较瘦弱,身体单薄,占据的宽度比较小。它是em之六分之一宽。

4. 零宽不连字

‌

它叫零宽不连字,全称是Zero Width Non Joiner,简称“ZWNJ”,是一个不打印字符,放在电子文本的两个字符之间,抑制本来会发生的连字,而是以这两个字符原本的字形来绘制。Unicode中的零宽不连字字符映射为“”(zero width non-joiner,U+200C),HTML字符值引用为:

5. 零宽连字

‍

它叫零宽连字,全称是Zero Width Joiner,简称“ZWJ”,是一个不打印字符,放在某些需要复杂排版语言(如阿拉伯语、印地语)的两个字符之间,使得这两个本不会发生连字的字符产生了连字效果。零宽连字符的Unicode码位是U+200D (HTML: )。

再次尝试复现-

<style>

.normal_style{

width:70px;

height:200px;

margin-right:150px;

border:1px solid red;

/* 👇表示 如果一个单词超出行长度,要截取换行,其他默认;👇 */

word-wrap:break-word;

}

</style>

<div style="display:flex;">

<div class='normal_style'>This is a long a long sentence</div>

<div class='normal_style'>This is a long a long sentence</div>

<div class='normal_style'>This is a long a long sentence</div>

</div>

我们可以看到   进行转义的话,单词截取换行是正常的!所以,真凶就是 特殊的不换行空格!

如何修订?

因为这个提示框是使用公司自制的 UI 组件实现的,而之所以使用 进行转义是为了修订XSS注入。(对,这个老东西现在没人维护,还是我去啃源码加上的,使用了公共的转义方法)。最后就简单去修改这个公共方法吧!使用了最贴近 宽度的空格转义符: !

来源:juejin.cn/post/7403953367766859828

数据大屏的解决方案

1. 使用缩放比例适配各种设备(适用16*9比例的屏幕分辨率)

- 封装一个获取缩放比例的工具函数

/**

* 大屏效果需要满足16:9的屏幕比例,才能达到完美的大屏适配效果

* 其他比例的大屏效果,不能铺满整个屏幕

* @param {*} w 设备宽度 默认 1920

* @param {*} h 设备高度 默认 1080

* @returns 返回值是缩放比例

*/

export function getScale(w = 1920, h = 1080) {

const ww = window.innerWidth / w

const wh = window.innerHeight / h

return ww < wh ? ww : wh

}

- 在

vue中使用方案如下

<template>

<div class="full-screen-container">

<div id="screen">

大屏展示的内容

</div>

</div>

</template>

<script>

import { getScale } from "@/utils/tool";

import screenfull from "screenfull";

export default {

name: "cockpit",

mounted() {

if (screenfull && screenfull.enabled && !screenfull.isFullscreen) {

screenfull.request();

}

this.setFullScreen();

},

methods: {

setFullScreen() {

const screenNode = document.getElementById("screen");

// 非标准设备(笔记本小于1920,如:1366*768、mac 1432*896)

if (window.innerWidth < 1920) {

screenNode.style.left = "50%";

screenNode.style.transform = `scale(${getScale()}) translate(-50%, 0)`;

} else if (window.innerWidth === 1920) {

// 标准设备 1920 * 1080

screenNode.style.left = 0;

screenNode.style.transform = `scale(1) translate(0, 0)`;

} else {

// 大屏设备(4K 2560*1600)

screenNode.style.left = "50%";

screenNode.style.transform = `scale(${getScale()}) translate(-50%, 0)`;

}

// 监听视口变化

window.addEventListener("resize", () => {

if (window.innerWidth === 1920) {

screenNode.style.left = 0;

screenNode.style.transform = `scale(1) translate(0, 0)`;

} else {

screenNode.style.left = "50%";

screenNode.style.transform = `scale(${getScale()}) translate(-50%, 0)`;

}

});

},

},

};

</script>

<style lang="scss">

.full-screen-container {

width: 100vw;

height: 100vh;

display: flex;

flex-direction: column;

background-color: #131a2b;

#screen {

position: fixed;

width: 1920px;

height: 1080px;

top: 0;

transform-origin: left top;

color: #fff;

}

}

</style>

- mac设备上的屏幕分辨率,在适配的时候,可能不是那么完美,以短边缩放为准,所以宽度到达百分之百后,高度不会铺满

- 1432*896 13寸mac本

- 2560*1600

4k屏幕

2. 使用第三方插件来实现数据大屏(mac设备会产生布局错落)

- 建议在全屏容器内使用百分比搭配flex进行布局,以便于在不同的分辨率下得到较为一致的展示效果。

- 使用前请注意将

body的margin设为0,否则会引起计算误差,全屏后不能完全充满屏幕。 - 使用方式

1. npm install @jiaminghi/data-view

2. yarn add @jiaminghi/data-view

// 在vue项目中的main.js入口文件,将自动注册所有组件为全局组件

import {fullScreenContainer} from '@jiaminghi/data-view'

Vue.use(fullScreenContainer)

<template>

<dv-full-screen-container>

要展示的数据大屏内容

这里建议高度使用百分比来布局,而且要考虑mac设备适配问题,防止百分比发生布局错乱

需要注意的点是,一个是宽度,一个是字体大小,不产生换行

</dv-full-screen-container>

</template>

<script>

import screenfull from "screenfull";

export default {

name: "cockpit",

mounted() {

if (screenfull && screenfull.enabled && !screenfull.isFullscreen) {

screenfull.request();

}

}

};

</script>

<style lang="scss">

#dv-full-screen-container {

width: 100vw;

height: 100vh;

display: flex;

flex-direction: column;

background-color: #131a2b;

}

</style>

- 插件地址

3. 效果图

来源:juejin.cn/post/7372105071573663763

从编程语言的角度,JS 是不是一坨翔?一个来自社区的暴力观点

给前端以福利,给编程以复利。大家好,我是大家的林语冰。

00. 写在前面

毋庸置疑,JS 的历史包袱确实罄竹难书。用朱熹的话说,天不生 ES6,JS 万古如长夜。

就技术细节而言,ES6 之前,JS 保留了若干臭名昭著的反人类设计,包括但不限于:

typeof null的抽象泄露==的无理要求undefined不是关键词- 其他雷区......

幸运的是,ES5 的“阉割模式”(strict mode)把一大坨 JS 的反人类设计都屏蔽了,后 ES6 时代的 JS 焕然一新。

所以,本期我们就从编程语言的宏观设计来思考,先不纠结 JS 极端情况的技术瑕疵,探讨一下 JS 作为地球上人气最高的编程语言,设计哲学上到底有何魅力?

免责声明:上述统计数据来源于 GitHub 社区,可能存在统计学偏差,仅供粉丝参考。

01. 标准化

编程语言人气排行榜屈居亚军的是 Python,那我们就用 JS 来打败 Python。

根据 MDN 电子书,JS 的核心语言是 ECMAScript,是一门由 ECMA TC39 委员会标准化的编程语言。并不是所有的编程语言都有标准化流程,JS 恰好是“天选之子”,后 ES6 的提案流程也相对稳定,虽然最近突然增加了 stage 2.7,但整体标准化无伤大雅。

值得一提的是,JS 的标准是向下兼容的,用户友好。JS 的大多数技术债务已经诉诸“阉割模式”禁用,而向下兼容则避免了近未来的 ESNext 出现主版本级别的破坏性更新。

举个栗子,ES2024 最新支持的数组分组提案,出于兼容性考虑,提案一度从 Array.prototype.group() 修改为 Object.groupBy()。

可以看到,JS 的向下兼容设计正是为了防止和某些遗留代码库产生命名冲突,降低迁移成本。

换而言之,JS 不会像 Python 2 升级 Python 3 那样,让用户承担语言迭代伴生的兼容性税,学习成本和心智负担相对较小。

02. 动态类型

编程语言人气排行榜屈居季军的是 TS,那我们就用 JS 来打败 TS。

JS 和 TS 都是 ECMAScript 的超集,TS 则是 JS 的超集。简而言之,TS ≈ JS + 静态类型系统。

JS 和 TS 区别在于动态类型 vs 静态类型,不能说孰优孰劣,只能说各有千秋。我的个人心证是,静态类型对于工程化生态而言不可或缺,比如 IDE 或 Linting,但对于编程应用则不一定,因为没有静态类型,JS 也能开发 Web App。

可以看到,因为 TS 是 JS 的超集,所以虽然没有显式的类型注解,上述代码也可作为 TS 代码,只不过 TS 和 JS 类型检查的粒度和时机并不一致。

一个争论点在于,静态类型的编译时检查有利于服务大型项目,但其实在大型项目中,一般会诉诸单元测试保障代码质量和回归测试。严格而言,静态类型之于大型项目的充要条件并不成立。

事实上,剥离静态类型注解的源码,恰恰体现了编程的本质和逻辑,这也是后来的静态类型语言偏爱半自动化的智能类型系统,因为有的类型注解可能是画蛇添足,而诉诸智能的类型推论可以解放程序猿的生产力。

03. 面向对象

编程语言人气排行榜第四名是 Java,那我们就用 JS 来打败 Java。

作为被误解最深的语言,前 ES6 的 JS 有一个普遍的误区:JS 不是面向对象语言,原因在于 ES5 没有 class。

这种“思想钢印”哪里不科学呢?不科学的地方在于,面向对象编程是面向对象,而不是 面向类。换而言之,类不是面向对象编程的充要条件。

作为经典的面向对象语言,Java 不同于 C艹,不支持多继承。如果说多继承的 C艹 是“面向对象完备”的,那么能且仅能支持单继承的 Java,其面向对象也一定有不完备的地方,需要诉诸其他机制来弥补。

JS 的面向对象是不同于经典类式继承的原型机制,为什么无类、原型筑基的 JS 也能实现多继承的 C艹 的“面向对象完备”呢?搞懂这个问题,才能深入理解“对象”的本质。

可以看到,JS 虽然没有类,但也通过神秘机制具备面向对象的三大特征。如果说 JS 不懂类,那么经典面向对象语言可能不懂面向对象编程,只懂“面向类编程”。

JS 虽然全称 JavaScript,但其实和 Java 一龙一猪,原型筑基的 JS 没有类也问题不大。某种意义上,类可以视为 JS 实现面向对象的语法糖。很多人知道封装、继承和多态的面向对象特性,但不知道面向对象的定义和思想,所以才会把类和“面向对象完备”等同起来,认为 JS 不是面向对象的语言。

04. 异步编程

编程语言人气排行榜第五名是 C#,那我们就用 JS 来打败 C#。

一般认为,JS 是一门单线程语言,有且仅有一个主线程。JS 有一个基于事件循环的并发模型,这个模型与 C# 语言等模型一龙一猪。

在 JS 中,当一个函数执行时,只有在它执行完毕后,JS 才会去执行任何其他的代码。换而言之,函数执行不会被抢占,而是“运行至完成”(除了 ES6 的生成器函数)。这与 C 语言不同,在 C 语言中,如果函数在线程中运行,它可能在任何位置被终止,然后在另一个线程中运行其他代码。

单线程的优势在于,大部分情况下,JS 不需要考虑多线程某些让人头大的复杂处理。因为我只会 JS,所以无法详细说明多线程的痛点,比如竞态、死锁、线程间通信(消息、信道、队列)、Actor 模型等。

但 JS 的单线程确实启发了其他支持多线程的语言,比如阮一峰大大的博客提到,Python 的 asyncio 模块只存在一个线程,跟 JS 一样。

在异步编程方面,JS 的并发模型其实算是奇葩,因为主流的编程语言都支持多线程模型,所以学习资料可以跨语言互相借鉴,C# 关于多线程的文档就有 10 页,而单线程的 JS 就像非主流的孤勇者,很多异步的理论都用不上,所以使用起来较为简单。

05. 高潮总结

JS 自诞生以来就是一种混合范式的“多面手语言”,这是 JS 二十年来依然元气满满的根本原因。

举个栗子,你可能已经见识过“三位一体”的神奇函数了:

可以看到,在 ES6 之前,JS 中的函数其实身兼数职,正式由于 JS 是天生支持混合范式导致的。

前 JS 时代的先驱语言部分是单范式语言,比如纯粹的命令式过程语言 C 语言无法直接支持面向对象编程,而 C艹 11、Java 8 等经典面向对象语言则渐进支持函数式编程等。

后 JS 时代的现代编程语言大都直接拥抱混合范式设计,比如 TypeScript 和 Rust 等。作为混合范式语言,JS 是一种原型筑基、动态弱类型的脚本语言,同时支持面向对象编程、函数式编程、异步编程等编程范式或编程风格。

粉丝请注意,你可能偶尔会看到“JS 是一门解释型语言”的说法,其实后 ES6 时代的 JS 已经不再是纯粹的解释型语言了,也可能是 JIT(即时编译)语言,这取决于宿主环境中 JS 引擎或运行时的具体实现。

值得一提的是,混合范式语言的优势在于博采众家之长,有助于塑造攻城狮的开放式编程思维和心智模型;缺陷在于不同于单范式语言,混合范式语言可能支持了某种编程范式,但没有完全支持。(PS:编程范式完备性的判定边界是模糊的,所以偶尔也解读为风格或思维。)

因此,虽然 JS 不像 PHP 一样是地球上最好的语言,但 JS 作为地表人气最高的语言,背后是有深层原因的。

参考文献

- 阮一峰日志:ruanyifeng.com/blog/2019/1…

- MDN:developer.mozilla.org

- C# 异步编程:learn.microsoft.com/zh-cn/dotne…

来源:juejin.cn/post/7392787221097545780

此生最佩服数学家

大家好啊,我是董董灿。

之前在和不少小伙伴聊天时,都时不时的提到,搞人工智能尤其是搞算法,数学是一座很难跨过去的砍,数学太难了。

我本身也不是数学专业的,在搞AI算法的过程中,也确实遇到了很多数学问题。

用大学学的那点线性代数、概率论和微积分的知识,来推一些枯燥的数学公式,就好像是拄着拐杖去跑马拉松,虽然查查资料磨蹭磨蹭也能弄出来,但是感觉很费劲。

数学真的就是算法的基石,数学能力强、抽象能力强的人,有时候在学算法时,就像降维打击,他们会从很不可思议的角度来论证,某某算法确实是好的。

我之前见过一个同事,中科大少年班毕业,数学专业的(数学水平很高,至少比我高),有一次在和他讨论某个算法的实现时,他全程用一种我听不懂的话在说,我当时是记了一些关键字,回到工位查了很久很久。

被打击了。

数学公式和理论对我而言是枯燥的,但是数学故事是有趣的。今天,就说一个与数学相关的故事,号称“数学史上的三次危机”。

很早就听说过这个说法了,前几天在查概率论相关的资料时,突然想起来,分享一下。

在很多数学专业的学生来看,这种说法并不严谨。在中外文献中,并不存在所谓的“数学史上的三次危机”,这种说法更多的出现在科普文章以及流行度较高的民间科学杂志上。

1、第一次数学危机:长方形的对角线是什么?

在古希腊时期,毕达哥拉斯学派统治的年代,人们对于数学的认识就是:一切都是数字,这里说的数字,是我们现在理解的有理数,也就是1、2、3这种。

那时的人们认为,万事万物都可以用有理数来衡量,在一个数轴上,任何一个点都可以用一个确定的有理数字来表示。

可突然有一天,一个人站出来说,边长为 1 的正方形的对角线,在数轴上就表示不出来。

人们慌了,毕达哥拉斯学派更慌了。

对这个问题他们百思不得其解,随着问题传播的越来越广,人们开始担心,引以为傲的“一切都是数字”的数学理论,是不是有可能是错误的。

这引起了第一次数学理论基础的危机。

毕达哥拉斯学派,不允许这种不和谐的声音出现,来诋毁自己的地位,但是,当时的他们又解决不了这个问题。

于是,他们秉着解决不了这个人提出的问题,就解决了这个人的原则,把提出这个问题的人解决了。

这次危机持续了很久,直到人们提出了无理数,并且接受了无理数的存在,第一次数学危机才得以解决。

2、第二次数学危机:兔子到底能不能追上乌龟?

这是关于龟兔赛跑的故事。

有人说,如果乌龟先跑,兔子后跑。

当兔子跑到乌龟已跑出距离的一半时,乌龟又前进了一段距离,而当兔子又跑到这一段距离的时候,乌龟此时又前进了一段距离,就这样无穷无尽的跑下去,兔子永远也追不上乌龟。

这就是“龟兔赛跑”悖论,这个悖论直接导致了当时数学界的恐慌。

悖论很反直觉,但是好像又无懈可击。

人们钻研了很久,却始终找不出问题出在什么地方。

当时的人们认为:数学完了,这么简单的问题都解决不了,数学根本不靠谱。

这就好像现在有人告诉你,高铁永远追不上骑自行车的人,但是你又没办法反驳一样。

明知是错的,我却无能为力。

这便是人们津津乐道的第二次数学危机,并且直接导致了无穷与极限的发展,以及后来微积分思想的发展。

到现在,无穷级数和微积分的数学根基已经很牢固了,但是如果回过头来,如果你想反驳一下这个悖论,你应该怎么说呢?

或许你可以这么说:

世界上没有这样的兔子和乌龟,可以活无穷长的时间,这是因为时间是不可能无穷拆分的。

那如果有人继续反驳问你,你怎么证明时间是不可以无穷拆分的呢?

你就说,那是物理学家的事,不是数学家的事,让物理学家思考去吧。

反正,在无穷与极限的概念的发展中,这次危机也算是渡过了。

3、第三次数学危机:理发师该不该给自己理发

一个村子里有个理发师,突然有一天这个理发师贴了一个公告说:我只给这个村子里不给自己理发的人理发。

然后有个人跑上门问他:那你自己的头发应该谁来理呢?

理发师懵了。

如果他给自己理发,那他就不是不给自己理发的人,他就不应该给自己理发。

如果他不给自己理发,那么他就是不给自己理发的人,他就应该给自己理发。

也就说,如果存在两个互相独立的集合,一个是给自己理发的人,一个是不给自己理发的人,那么理发师属于哪个集合呢?

这就是著名的罗素悖论。

这个悖论的威力在于,当时一个著名的数学家要发表一本数学著作,在收到罗素关于这个悖论的描述后尴尬地说:我以为数学的大厦已经盖好了,没想到地基还这么不牢固。

这个问题通俗点讲就是,你可以说出一件事,如果这件事是真的,那么它就是假的,如果他是假的,那么他就是真的。

数学里的自相矛盾,然而它却符合康托尔关于集合的定义。

这个问题的解决好像是一位大佬级别的数学家,在研究了一段时间后说:不存在这样理发师,他说的话不能当做数学公理,从源头上解决了这个问题。

但是这个悖论促进促进了集合论的进一步发展。

三次数学危机,每一次都让人惶恐不安,但事实却是,每一次都极大的促进了当时数学理论的发展。

好啦,故事就分享到这。

说回AI,AI的发展绝对离不开数学,这也是为什么华为愿意花大价钱雇佣很多数学家、物理学家搞基础研究,阿里每年搞全球数学竞赛,吸纳全球数学精英。

三体里有句话,如果一旦外星文明打来,我们能与之拼一拼的绝对不是火箭大炮,而是基础物理学理论,核弹都得益于数学物理,更何况其他呢。

如果此时你正在高数课堂上,请你打起精神好好听课,没准未来拯救世界的重任就落到了你的肩上。🙃

一直很膜拜数学、物理大佬,如果有数学物理专业的大佬,可在下面留言,让小弟膜拜下~

来源:juejin.cn/post/7294619778987622411

你真的了解圣杯和双飞翼布局吗?

前言

圣杯和双飞翼布局作为面试常考的题目之一,相信大家肯定都会有着自己的一套知识储备,但是,你真的了解这两种经典布局吗?本文将介绍这两种经典布局产生的来龙去脉,以及实现这两种布局的一些方式,希望大家能够喜欢。

为什么需要圣杯和双飞翼布局

大家思考一个问题,这样一种布局,你该怎么处理呢?

常规情况下,我们的布局思路应该这样写,从上到下,从左到右:

<div>header</div>

<div>

<div>left</div>

<div>main</div>

<div>right</div>

</div>

<div>footer</div>

这样的三栏布局也没有什么问题,但是我们要知道一个网站的主要内容就是中间的部分,比如像掘金:

那么对于用户来说,他们当然是希望最中间的部分首先加载出来的,能看到最重要的内容,但是因为浏览器加载dom的机制是按顺序加载的,浏览器从HTML文档的开头开始,逐步解析并构建文档对象模型,所以,我们想让main首先加载出来的话,那就将它前置,然后通过一些CSS的样式,将其继续展示出上面的三栏布局的样式:

<div>header</div>

<div>

<div>main</div>

<div>left</div>

<div>right</div>

</div>

<div>footer</div>

这就是所谓的圣杯布局,最早是Matthew Levine 在2006年1月30日在In Search of the Holy Grail 这篇文章中提出来的;

那么完整的效果、实现代码如下:

<style>

.header,

.footer {

width: 100%;

height: 200px;

background-color: pink;

}

.container {

padding: 0 100px 0 100px;

overflow: hidden;

}

.col {

position: relative;

float: left;

height: 400px;

}

.left {

background-color: green;

width: 100px;

margin-left: -100%;

left: -100px;

}

.main {

width: 100%;

background-color: blue;

}

.right {

width: 100px;

background-color: green;

margin-left: -100px;

right: -100px;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="main col">main</div>

<div class="left col">left</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

如上述代码所示,,使用了相对定位、浮动和负值margin,将left和right装到main的两侧,所以顾名:圣杯;

但是呢,圣杯是有问题的,在某些特殊的场景下,比如说,left和right盒子的宽度过宽的情况下,圣杯就碎掉了,比如将上述代码的left和right盒子的宽度改为以500px为基准:

<style>

.header,

.footer {

width: 100%;

height: 200px;

background-color: pink;

}

.container {

padding: 0 500px 0 500px;

overflow: hidden;

}

.col {

position: relative;

float: left;

height: 400px;

}

.left {

background-color: green;

width: 500px;

margin-left: -100%;

left: -500px;

}

.main {

width: 100%;

background-color: blue;

}

.right {

width: 500px;

background-color: green;

margin-left: -500px;

right: -500px;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="main col">main</div>

<div class="left col">left</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

正常情况下,布局还是依然正常,只是两侧宽了而已:

但是我们将整个窗口缩小,圣杯就碎掉了:

原因是因为 padding: 0 500px 0 500px;,当整个窗口的最大宽度已经小于左右两边的padding共1000px,left和right就被挤下去了;

于是针对这种情况,淘宝UED的玉伯大大提出来了双飞翼布局,效果和圣杯布局一样,只是他将其比作一只鸟,左翅膀、中间、右翅膀;

相比于圣杯布局,双飞翼布局在原有的main盒子再加了一层div:

<div>header</div>

<div>

<div><div>main</div></div>

<div>left</div>

<div>right</div>

</div>

<div>footer</div>

实际的效果和代码如下,哪怕再怎么缩,都不会被挤下去:

<style>

.header,

.footer {

width: 100%;

height: 200px;

background-color: pink;

}

.container {

padding: 0;

overflow: hidden;

}

.col {

float: left;

height: 400px;

}

.left {

background-color: green;

width: 500px;

margin-left: -100%;

}

.main {

width: 100%;

background-color: blue;

}

.main-in {

margin: 0 500px 0 500px;

}

.right {

width: 500px;

background-color: green;

margin-left: -500px;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="main col">

<div class="main-in">main</div>

</div>

<div class="left col">left</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

圣杯布局实现方式补充

上面介绍了一种圣杯布局的实现方式,这里再介绍一种用绝对定位的,这种方法其实也能避免上述说的当左右两侧的盒子过于宽时,圣杯被挤破的情况:

<style>

.header,

.footer {

width: 100%;

height: 200px;

background-color: pink;

}

.container {

position: relative;

padding: 0 100px;

}

.col {

height: 400px;

}

.left {

background-color: green;

width: 100px;

position: absolute;

left: 0;

top: 0;

}

.main {

width: 100%;

background-color: blue;

}

.right {

width: 100px;

background-color: green;

position: absolute;

right: 0;

top: 0;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="main col">main</div>

<div class="left col">left</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

双飞翼布局实现方式补充

也是使用绝对定位的:

<style>

.header,

.footer {

width: 100%;

height: 200px;

background-color: pink;

}

.container {

position: relative;

}

.col {

height: 400px;

}

.left {

background-color: green;

width: 500px;

position: absolute;

top: 0;

left: 0;

}

.main {

width: calc(100% - 1000px);

background-color: blue;

margin-left: 500px;

}

.main-in {

/* margin: 0 500px 0 500px; */

}

.right {

width: 500px;

background-color: green;

position: absolute;

top: 0;

right: 0;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="main col">

<div class="main-in">main</div>

</div>

<div class="left col">left</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

其它普通的三列布局的实现

flex布局实现

<style>

* {

padding: 0;

margin: 0;

}

.header,

.footer {

width: 100%;

height: 200px;

background-color: blue;

}

.container {

display: flex;

}

.left {

width: 100px;

height: 300px;

background-color: pink;

}

.main {

flex: 1;

width: 100%;

height: 300px;

background-color: green;

}

.right {

width: 100px;

height: 300px;

background-color: pink;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="left col">left</div>

<div class="main col">main</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

绝对定位实现

<style>

* {

padding: 0;

margin: 0;

}

.header,

.footer {

width: 100%;

height: 200px;

background-color: blue;

}

.container {

position: relative;

padding: 0 100px;

}

.left {

width: 100px;

height: 300px;

background-color: pink;

position: absolute;

top: 0;

left: 0;

}

.main {

width: 100%;

height: 300px;

background-color: green;

}

.right {

width: 100px;

height: 300px;

background-color: pink;

position: absolute;

top: 0;

right: 0;

}

</style>

<div class="header">header</div>

<div class="container">

<div class="left col">left</div>

<div class="main col">main</div>

<div class="right col">right</div>

</div>

<div class="footer">footer</div>

总结

现在真正了解到圣杯布局、双飞翼布局和普通三列布局的思想了吗?虽然它们三者最终的效果可能一样,但是实际的思路,优化也都不一样,希望能对你有所帮助!!!!感谢支持

来源:juejin.cn/post/7405467437564428299

前端中的“+”连接符,居然有鲜为人知的强大功能!

故事背景:"0"和"1"布尔判断

这几天开发,遇到一个问题:根据后端返回的isCritical判断页面是否展示【关键标签】

很难受的是,后端的isCritical的枚举值是字符串

”0“: 非关键

”1“ :关键

这意味着前端得自己转换一下,于是我写出了这样的代码

// html

<van-icon v-if="getCriticalStatus(it.isCritical)" color="#E68600"/>

// js

const getCriticalStatus = (critical: string) => {

if (critical.value === "1") return true;

return false;

}

我以为我这样写很简单了,没想到同事看到后,说我这样写麻烦了,于是给我改了一下代码

// html

<van-icon v-if="+it.isCritical" color="#E68600"/>

我大惊失色脱水缩合,这就行了?看来,我还是小看"+"运算符了!

"+"的常见使用场景

前端对"+"连字符一定不陌生,它的算术运算符功能和字符串连接功能,我们用脚趾头也能敲出来。

算术运算符

在 JavaScript 中,+ 是最常见的算术运算符之一,可以用来执行加法运算。

let a = 5;

let b = 10;

let sum = a + b;

// sum的值为15

字符串连接符

+ 还可以用来连接字符串。

let firstName = "石";

let lastName = "小石";

let fullName = firstName + " " + lastName; // fullName的值为"石小石"

如果是数字和字符连接,它会把数字转成字符

const a = 1

const b = "2"

const c = a + b; // c的值为字符串"12"

"+"的高级使用场景

除了上述的基本使用场景,其实它还有一些冷门但十分使用的高级使用场景。

URL编码中的空格

在 URL 编码中,+ 字符可以表示空格,尤其是在查询字符串中。

http://shixiaoshi.com/search?query=hello+world

上面的代码中,hello+world 表示查询 hello world,其中的 + 会被解码为一个空格。

但要注意的是,现代 URL 编码规范中推荐使用 %20 表示空格,而不是 +。

一元正号运算符

+ 的高级用法,再下觉得最牛逼的地方就是可以作为一元运算符使用!

+ 作为一元运算符时,可以将一个值转换为数字(如果可能的话)。

let str = "123";

let num = +str;

// num的值为123,类型为number

这一用法在处理表单输入时特别有用,因为表单输入通常是字符串类型。

let inputValue = "42";

let numericValue = +inputValue; // 将字符串转换为数字42

那么回到文章开头的问题,我们看看下面的代码为什么可以生效

// html

<van-icon v-if="getCriticalStatus(it.isCritical)" color="#E68600"/>

// js

const getCriticalStatus = (critical: string) => {

if (critical.value === "1") return true;

return false;

}

// html 优化后的代码

<van-icon v-if="+it.isCritical" color="#E68600"/>

由于it.isCritical的值是字符"0"或"1",通过"+it.isCritical"转换后,其值是数字0或1,而恰好0可以当false使用,1可以当true使用!因此,上述代码可以生效!

JavaScript 中的类型转换规则会将某些值隐式转换为布尔值:

- 假值 :在转换为布尔值时被视为

false的值,包括:false、0(数字零)、-0(负零)、""(空字符串)、null、undefined、NaN(非数字)

- 真值 :除了上述假值外,所有其他值在转换为布尔值时都被视为

true。

一元正号运算符的原理

通过上文,我们知道:当使用 + 操作符时,JavaScript 会尝试把目标值转换为数字,它遵循以下规则:。

转换规则

数字类型:

如果操作数是数字类型,一元正号运算符不会改变其值。

例如:+5 还是 5。

// 数字类型

console.log(+5); // 5(数字)

字符串类型:

如果字符串能够被解析为有效的数字,则返回相应的数字。

如果字符串不能被解析为有效的数字(如含有非数字字符),则返回 NaN(Not-a-Number)。

例如:+"123" 返回 123,+"abc" 返回 NaN。

// 字符串类型

console.log(+"42"); // 42

console.log(+"42abc"); // NaN

布尔类型:

true 会被转换为 1。

false 会被转换为 0。

// 布尔类型

console.log(+true); // 1

console.log(+false); // 0

null:

null 会被转换为 0。

// null

console.log(+null); // 0

undefined:

undefined 会被转换为 NaN。

// undefined

console.log(+undefined); // NaN

对象类型:

对象首先会通过内部的 ToPrimitive 方法被转换为一个原始值,然后再进行数字转换。通常通过调用对象的 valueOf 或 toString 方法来实现,优先调用 valueOf。

// 对象类型

console.log(+{}); // NaN

console.log(+[]); // 0

console.log(+[10]); // 10

console.log(+["10", "20"]); // NaN

底层原理

不重要,简单说说:

在 JS引擎内部,执行一元正号运算符时,实际调用了 ToNumber 抽象操作,这个操作试图将任意类型的值转换为数字。ToNumber 操作依据 ECMAScript 规范中的规则,将不同类型的值转换为数字。

总结

一元正号运算符 + 是一个简便的方法,用于将非数字类型转换为数字。

如果你们后端返回字符串0和1,你需要转换成布尔值,使用"+"简直不要太爽

// isCritical 是字符串"0"或"1"

<van-icon v-if="+isCritical" color="#E68600"/>

或者处理表单输入时用

let inputValue = "42";

let value = +inputValue; // 将字符串转换为数字42

来源:juejin.cn/post/7402076531294863360

还在封装 xxxForm,xxxTable 残害你的同事?试试这个工具

之前写过一篇文章 我理想中的低代码开发工具的形态,已经吐槽了各种封装 xxxForm,xxxTable 的行为,这里就不啰嗦了。今天再来看看我的工具达到了什么程度。

多图预警。。。

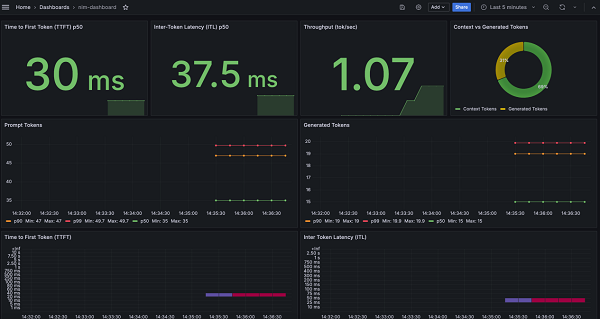

以管理后台一个列表页为例

选择对应的模板

截图查询区域,使用 OCR 初始化查询表单的配置

截图表头,使用 OCR 初始化 table 的配置

使用 ChatGPT 翻译中文字段

生成代码

效果

目前我们没有写一行代码,就已经达到了如下的效果

下面是一部分生成的代码

import { reactive, ref } from 'vue'

import { IFetchTableListResult } from './api'

interface ITableListItem {

/**

* 决算单状态

*/

settlementStatus: string

/**

* 主合同编号

*/

mainContractNumber: string

/**

* 客户名称

*/

customerName: string

/**

* 客户手机号

*/

customerPhone: string

/**

* 房屋地址

*/

houseAddress: string

/**

* 工程管理

*/

projectManagement: string

/**

* 接口返回的数据,新增字段不需要改 ITableListItem 直接从这里取

*/

apiResult: IFetchTableListResult['result']['records'][0]

}

interface IFormData {

/**

* 决算单状态

*/

settlementStatus?: string

/**

* 主合同编号

*/

mainContractNumber?: string

/**

* 客户名称

*/

customerName?: string

/**

* 客户手机号

*/

customerPhone?: string

/**

* 工程管理

*/

projectManagement?: string

}

interface IOptionItem {

label: string

value: string

}

interface IOptions {

settlementStatus: IOptionItem[]

}

const defaultOptions: IOptions = {

settlementStatus: [],

}

export const defaultFormData: IFormData = {

settlementStatus: undefined,

mainContractNumber: undefined,

customerName: undefined,

customerPhone: undefined,

projectManagement: undefined,

}

export const useModel = () => {

const filterForm = reactive<IFormData>({ ...defaultFormData })

const options = reactive<IOptions>({ ...defaultOptions })

const tableList = ref<(ITableListItem & { _?: unknown })[]>([])

const pagination = reactive<{

page: number

pageSize: number

total: number

}>({

page: 1,

pageSize: 10,

total: 0,

})

const loading = reactive<{ list: boolean }>({

list: false,

})

return {

filterForm,

options,

tableList,

pagination,

loading,

}

}

export type Model = ReturnType<typeof useModel>

这就是用模板生成的好处,有规范,随时可以改,而封装 xxxForm,xxxTable 就是一个黑盒。

原理

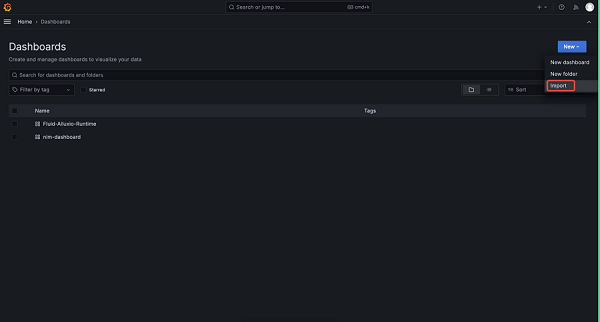

下面大致说一下原理

首先是写好一个个模版,vscode 插件读取指定目录下模版显示到界面上

每个模版下可能包含如下内容:

选择模版后,进入动态表单配置界面

动态表单是读取 config/schema.json 里的内容进行动态渲染的,目前支持 amis、form-render、formily

配置表单是为了生成 JSON 数据,然后根据 JSON 数据生成代码。所以最终还是无法避免的使用私有的 DSL ,但是生成后的代码是没有私有 DSL 的痕迹的。生成代码本质是 JSON + EJS 模版引擎编译 src 目录下的 ejs 文件。

为了加快表单的配置,可以自定义脚本进行操作

这部分内容是读取 config/preview.json 内容进行显示的

选择对应的脚本方法后,插件会动态加载 script/index.js 脚本,并执行里面对应的方法

以 initColumnsFromImage 方法为例,这个方法是读取剪贴板里的图片,然后使用百度 OCR 解析出文本,再使用文本初始化表单

initColumnsFromImage: async (lowcodeContext) => {

context.lowcodeContext = lowcodeContext;

const res = await main.handleInitColumnsFromImage();

return res;

},

export async function handleInitColumnsFromImage() {

const { lowcodeContext } = context;

if (!lowcodeContext?.clipboardImage) {

window.showInformationMessage('剪贴板里没有截图');

return lowcodeContext?.model;

}

const ocrRes = await generalBasic({ image: lowcodeContext!.clipboardImage! });

env.clipboard.writeText(ocrRes.words_result.map((s) => s.words).join('\r\n'));

window.showInformationMessage('内容已经复制到剪贴板');

const columns = ocrRes.words_result.map((s) => ({

slot: false,

title: s.words,

dataIndex: s.words,

key: s.words,

}));

return { ...lowcodeContext.model, columns };

}

反正就是可以根据自己的需求定义各种各样的脚本。比如使用 ChatGPT 翻译 JSON 里的指定字段,可以看我的上一篇文章 TypeChat、JSONSchemaChat实战 - 让ChatGPT更听你的话

再比如要实现把中文翻译成英文,然后英文使用驼峰语法,这样就可以将中文转成英文代码变量,下面是实现的效果

选择对应的命令菜单后 vscode 插件会加载对应模版里的脚本,然后执行里面的 onSelect 方法。

main.ts 代码如下

import { env, window, Range } from 'vscode';

import { context } from './context';

export async function bootstrap() {

const clipboardText = await env.clipboard.readText();

const { selection, document } = window.activeTextEditor!;

const selectText = document.getText(selection).trim();

let content = await context.lowcodeContext!.createChatCompletion({

messages: [

{

role: 'system',

content: `你是一个翻译家,你的目标是把中文翻译成英文单词,请翻译时使用驼峰格式,小写字母开头,不要带翻译腔,而是要翻译得自然、流畅和地道,使用优美和高雅的表达方式。请翻译下面用户输入的内容`,

},

{

role: 'user',

content: selectText || clipboardText,

},

],

});

content = content.charAt(0).toLowerCase() + content.slice(1);

window.activeTextEditor?.edit((editBuilder) => {

if (window.activeTextEditor?.selection.isEmpty) {

editBuilder.insert(window.activeTextEditor.selection.start, content);

} else {

editBuilder.replace(

new Range(

window.activeTextEditor!.selection.start,

window.activeTextEditor!.selection.end,

),

content,

);

}

});

}

使用了 ChatGPT。

再来看看,之前生成管理后台 CURD 页面的时候,连 mock 也一起生成了,主要逻辑放在了 complete 方法里,这是插件的一个生命周期函数。

因为 mock 服务在另一个项目里,所以需要跨目录去生成代码,这里我在 mock 服务里加了个接口返回 mock 项目所在的目录

.get(`/mockProjectPath`, async (ctx, next) => {

ctx.body = {

status: 200,

msg: '',

result: __dirname,

};

})

生成代码的时候请求这个接口,就知道往哪个目录生成代码了

const mockProjectPathRes = await axios

.get('http://localhost:3001/mockProjectPath', { timeout: 1000 })

.catch(() => {

window.showInformationMessage(

'获取 mock 项目路径失败,跳过更新 mock 服务',

);

});

if (mockProjectPathRes?.data.result) {

const projectName = workspace.rootPath

?.replace(/\\/g, '/')

.split('/')

.pop();

const mockRouteFile = path.join(

mockProjectPathRes.data.result,

`${projectName}.js`,

);

let mockFileContent = `

import KoaRouter from 'koa-router';

import proxy from '../middleware/Proxy';

import { delay } from '../lib/util';

const Mock = require('mockjs');

const { Random } = Mock;

const router = new KoaRouter();

router{{mockScript}}

module.exports = router;

`;

if (fs.existsSync(mockRouteFile)) {

mockFileContent = fs.readFileSync(mockRouteFile).toString().toString();

const index = mockFileContent.lastIndexOf(')') + 1;

mockFileContent = `${mockFileContent.substring(

0,

index,

)}{{mockScript}}\n${mockFileContent.substring(index)}`;

}

mockFileContent = mockFileContent.replace(/{{mockScript}}/g, mockScript);

fs.writeFileSync(mockRouteFile, mockFileContent);

try {

execa.sync('node', [

path.join(

mockProjectPathRes.data.result

.replace(/\\/g, '/')

.replace('/src/routes', ''),

'/node_modules/eslint/bin/eslint.js',

),

mockRouteFile,

'--resolve-plugins-relative-to',

mockProjectPathRes.data.result

.replace(/\\/g, '/')

.replace('/src/routes', ''),

'--fix',

]);

} catch (err) {

console.log(err);

}

mock 项目也可以通过 vscode 插件快速创建和使用

上面展示的模版都放在了 github.com/lowcode-sca… 仓库里,照着 README 步骤做就可以使用了。

来源:juejin.cn/post/7315242945454735414

领导:你加的水印怎么还能被删掉的,扣工资!

故事是这样的

领导:小李,你加的水印怎么还能被删掉的?这可是关乎公司信息安全的大事!这种疏忽怎么能不扣工资呢?

小李:领导,请您听我解释一下!我确实按照常规的方法加了水印,可是……

领导:(打断)但是什么?难道这就是你对公司资料的保护吗?

小李:我也不明白,按理说水印是无法删除的,我会再仔细检查一下……

领导:我不能容忍这样的失误。这种安全隐患严重影响了我们的机密性。

小李焦虑地试图解释,但领导的目光如同刀剑一般锐利。他决定,这次一定要找到解决方法,否则,这将是一场职场危机……

水印组件

小李想到antd中有现成的水印组件,便去研究了一下。即使删掉了水印div,水印依然存在,因为瞬间又生成了一个相同的水印div。他一瞬间想到了解决方案,并开始了重构水印组件。

原始代码

//app.vue

<template>

<div>

<Watermark text="前端百事通">

<div class="content"></div>

</Watermark>

</div>

</template>

<script setup>

import Watermark from './components/Watermark.vue';

</script>

<style scoped>

.content{

width: 400px;

height: 400px;

background-color: aquamarine;

}

</style>

//watermark.vue

<template>

<div ref="watermarkRef" class="watermark-container">

<slot>

</slot>

</div>

</template>

<script setup>

import { onMounted, ref } from 'vue';

const watermarkRef=ref(null)

const props = defineProps({

text: {

type: String,

default: '前端百事通'

},

fontSize: {

type: Number,

default: 14

},

gap: {

type: Number,

default: 50

},

rotate: {

type: Number,

default: 45

}

})

onMounted(() => {

addWatermark()

})

const addWatermark = () => {

const { rotate, gap, text, fontSize } = props

const color = 'rgba(0, 0, 0, 0.3)'; // 可以从props中传入

const watermarkContainer = watermarkRef.value;

const canvas = document.createElement('canvas');

const context = canvas.getContext('2d');

const font=fontSize+'px DejaVu Sans Mono'

// 设置水印文字的宽度和高度

const metrics = context.measureText(text);

const canvasWidth=metrics.width+gap

canvas.width=canvasWidth

canvas.height=canvasWidth

// 绘制水印文字

context.translate(canvas.width/2,canvas.height/2)

context.rotate((-1 * rotate * Math.PI / 180));

context.fillStyle = color;

context.font=font

context.textAlign='center'

context.textBaseline='middle'

context.fillText(text,0,0)

// 将canvas转为图片

const url = canvas.toDataURL('image/png');

// 创建水印元素并添加到容器中

const watermarkLayer = document.createElement('div');

watermarkLayer.style.position = 'absolute';

watermarkLayer.style.top = '0';

watermarkLayer.style.left = '0';

watermarkLayer.style.width = '100%';

watermarkLayer.style.height = '100%';

watermarkLayer.style.pointerEvents = 'none';

watermarkLayer.style.backgroundImage = `url(${url})`;

watermarkLayer.style.backgroundRepeat = 'repeat';

watermarkLayer.style.zIndex = '9999';

watermarkContainer.appendChild(watermarkLayer);

}

</script>

<style>