忍了一年多,我终于对i18n下手了

前言

大家好,我是奈德丽。

过去一年,我主要参与国际机票业务的开发工作,因此每天都要和多语言(i18n)打交道。熟悉我的朋友都知道,我这个人比较“惜力”(并不是,实际上只是忍不下去了),对于重复笨拙的工作非常抵触,于是,我开始思考如何优化团队的多语言管理模式。

痛点背景

先说说我们在机票项目中遇到的困境。

目前机票项目分为 H5 和 PC 两端,团队在维护多语言时主要通过在线 Excel进行管理:

- 一个 Excel 文件,H5 和 PC 各自占一个 sheet 页;

- 每次更新语言,需要先导出 Excel,然后手动跑脚本生成语言文件,再拷贝到项目中。

听起来还算凑合,但随着项目规模的扩大,问题逐渐显现:

- Key 命名混乱

- 有的首字母大写,有的小驼峰、大驼峰混用;

- 没有统一规则,难以模块化管理。

- 不支持模块化

- 目前已有数千条 key;

- 查找、修改、维护都非常痛苦。

- 更新流程繁琐

- 需要手动进入脚本目录,用

node跑脚本; - 生成后再手动复制到项目中。

- 需要手动进入脚本目录,用

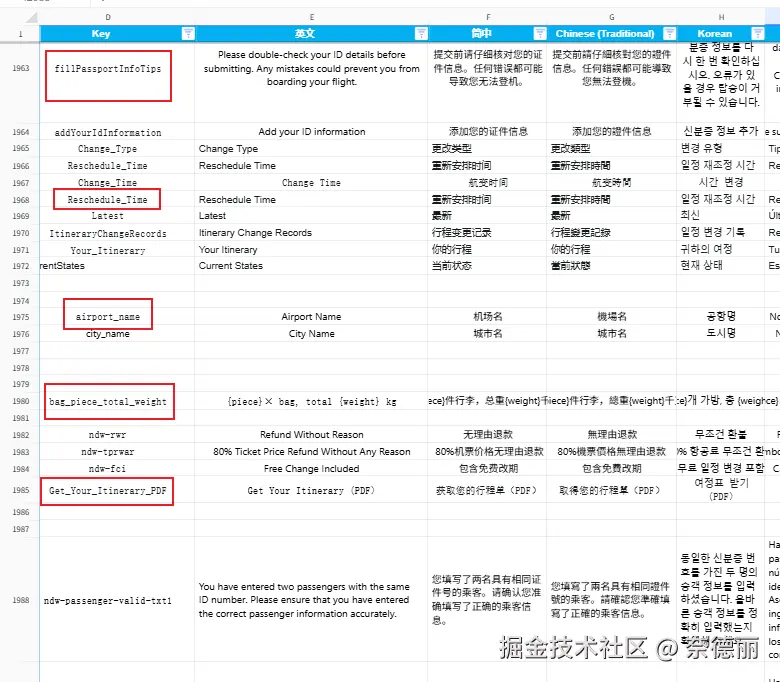

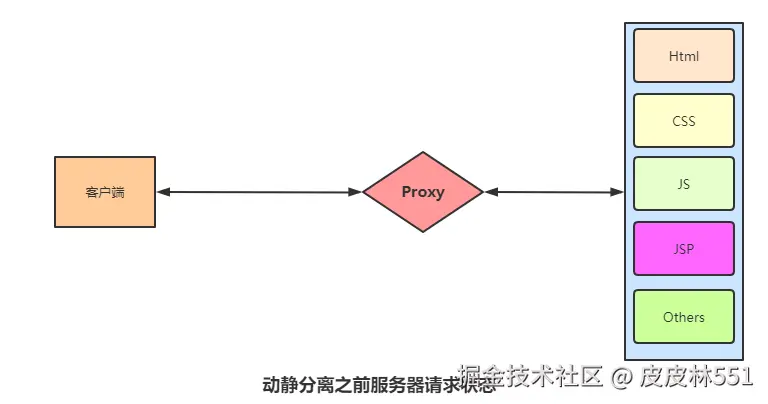

下面是一个实际的 Excel 片段,可以感受一下当时的混乱程度:

用原node脚本生成的语言文件如图

在这样的场景下,每次迭代多语言文件更新都像噩梦一样。

尤其是我们很多翻译是通过AI 机翻生成,后续频繁修改的成本极高。

然而,机票项目的代码量太大、历史包袱太重,短期内几乎不可能彻底改造。

新项目,新机会

机票项目虽然不能动,但在我们启动酒店业务新项目时,我决定不能再重蹈覆辙。

因此,在酒店项目中,我从零搭建了这套更高效的 i18n 管理方案。

目标很简单:

- 统一 key 规则,支持模块化,模块与内容间用.隔开,内容之间用下划线隔开;

- 自动化生成多语言 JSON 文件,集成到项目内,不再需要查找转化脚本的位置;

- 一条命令搞定更新,不需要手动拷贝。

于是,我在项目中新增了一个 scripts 目录,并编写了一个 excel-to-json.js 脚本。

在 package.json 中添加如下命令:

{

"scripts": {

"i18n:excel-to-json": "node scripts/excel-to-json.js"

}

}

以后,只需要运行下面一行命令,就能完成所有工作:

pnpm i18n:excel-to-json

再也不用手动寻找脚本路径,也不用手动复制粘贴,效率直接起飞 🚀。

脚本实现

核心逻辑就是:

从 Excel 读取内容 → 转换为 JSON → 输出到项目 i18n 目录。

完整代码如下:

import fs from 'node:fs'

import os from 'node:os'

import path from 'node:path'

import XLSX from 'xlsx'

/**

* 语言映射表:Excel 表头 -> 标准语言码

*/

const languageMap = {

'English': 'en',

'简中': 'zh-CN',

'Chinese (Traditional)': 'zh-TW',

'Korean': 'ko',

'Spanish': 'es',

'German Edited': 'de',

'Italian': 'it',

'Norwegian': 'no',

'French': 'fr',

'Arabic': 'ar',

'Thailandese': 'th',

'Malay': 'ms',

}

// 读取 Excel 文件

function readExcel(filePath) {

if (!fs.existsSync(filePath)) {

throw new Error(`❌ Excel 文件未找到: ${filePath}`)

}

const workbook = XLSX.readFile(filePath)

const sheet = workbook.Sheets[workbook.SheetNames[0]]

return XLSX.utils.sheet_to_json(sheet)

}

/**

* 清空输出目录

*/

function clearOutputDir(dirPath) {

if (fs.existsSync(dirPath)) {

fs.readdirSync(dirPath).forEach(file => fs.unlinkSync(path.join(dirPath, file)))

console.log(`🧹 已清空目录: ${dirPath}`)

} else {

fs.mkdirSync(dirPath, { recursive: true })

console.log(`📂 创建目录: ${dirPath}`)

}

}

/**

* 生成 JSON 文件

*/

function generateLocales(rows, outputDir) {

const locales = {}

rows.forEach(row => {

const key = row.Key

if (!key) return

// 遍历语言列

Object.entries(languageMap).forEach(([columnName, langCode]) => {

if (!locales[langCode]) locales[langCode] = {}

const value = row[columnName] || ''

const keys = key.split('.')

let current = locales[langCode]

keys.forEach((k, idx) => {

if (idx === keys.length - 1) {

current[k] = value

} else {

current[k] = current[k] || {}

current = current[k]

}

})

})

})

// 输出文件

Object.entries(locales).forEach(([lang, data]) => {

const filePath = path.join(outputDir, `${lang}.json`)

fs.writeFileSync(filePath, JSON.stringify(data, null, 2), 'utf-8')

console.log(`✅ 生成文件: ${filePath}`)

})

}

/**

* 检测缺失翻译

*/

function detectMissingTranslations(rows) {

const missing = []

rows.forEach(row => {

const key = row.Key

if (!key) return

Object.entries(languageMap).forEach(([columnName, langCode]) => {

const value = row[columnName]

if (!value?.trim()) {

missing.push({ key, lang: langCode })

}

})

})

return missing

}

function logMissingTranslations(missingList) {

if (missingList.length === 0) {

console.log('\n🎉 所有 key 的翻译完整!')

return

}

console.warn('\n⚠️ 以下 key 缺少翻译:')

missingList.forEach(item => {

console.warn(` - key: "${item.key}" 缺少语言: ${item.lang}`)

})

}

function main() {

const desktopPath = path.join(os.homedir(), 'Desktop', 'hotel多语言.xlsx')

const outputDir = path.resolve('src/i18n/locales')

const rows = readExcel(desktopPath)

clearOutputDir(outputDir)

generateLocales(rows, outputDir)

logMissingTranslations(detectMissingTranslations(rows))

}

main()

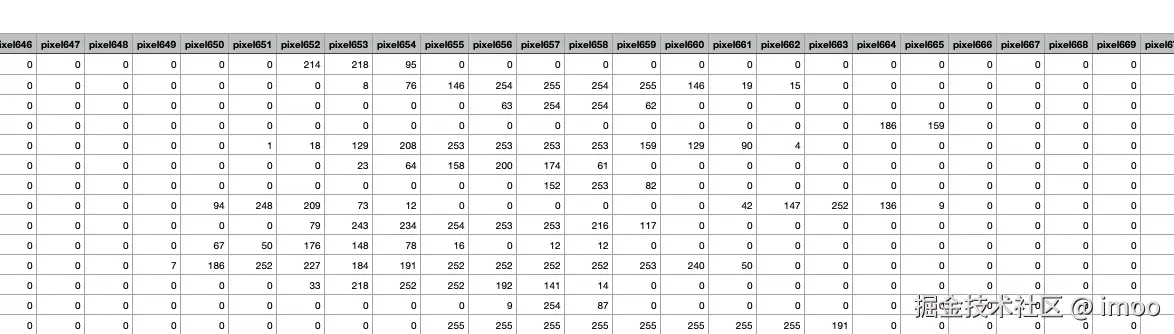

成果展示

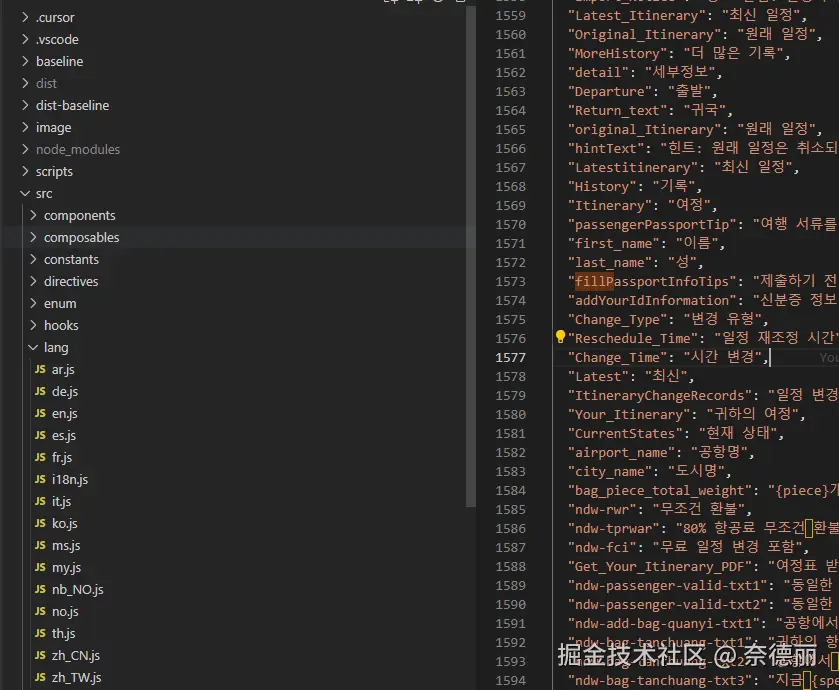

这是在线语言原文档

这是生成后的多语言文件和内容

现在的工作流大幅简化:

| 操作 | 旧流程 | 新流程 |

|---|---|---|

| 运行脚本 | 手动找脚本路径 | pnpm i18n:excel-to-json |

| 文件生成位置 | 生成后手动拷贝 | 自动输出到项目 |

| 检测缺失翻译 | 无 | 自动提示 |

| key 命名管理 | 无统一规则 | 模块化、规范化 |

这套机制目前在酒店项目中运行良好,团队反馈也很积极。

总结

这次改造让我最大的感触是:

旧项目难以推翻重来,但新项目一定要趁早做好架构设计。

通过这次优化,我们不仅解决了多语言维护的痛点,还提升了团队整体开发效率。

而这套方案在未来如果机票项目有机会重构,也可以直接平滑迁移过去。

来源:juejin.cn/post/7553105607417053194

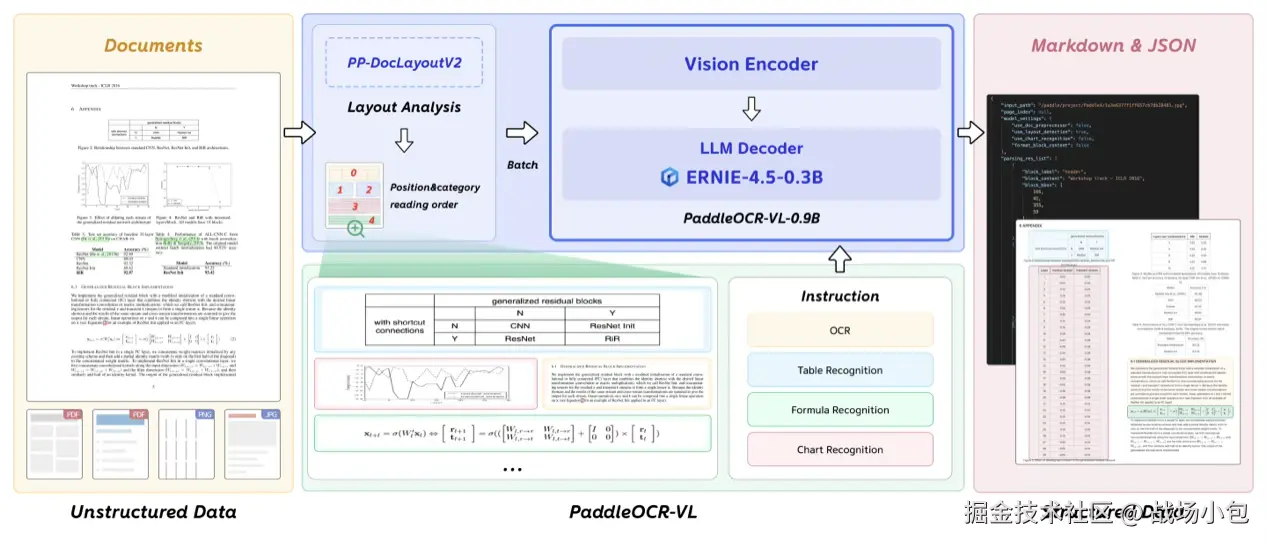

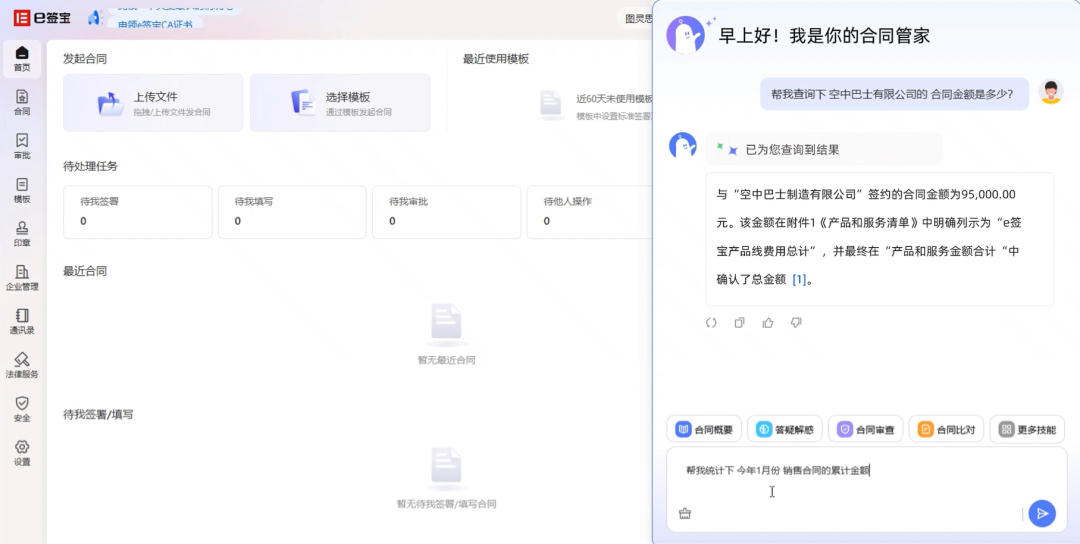

聊聊我们公司的AI应用工程师每天都干啥?

过去两年间,随着我们团队落地和升级的AI产品越来越多,团队中逐渐出现了专门负责AI应用的工程师。

时间一长这些AI应用工程师们也分出了个三六九等,甚至有一些AI应用工程师因为思路无法转变,又退回到了普通工程师的岗位,不再负责AI应用。

今天这篇文章,给大家聊聊,AI应用工程师每天都在干点啥? 优秀的AI应用工程师到底优秀在哪里?

AI应用工程师的生态位

AI应用工程师是处在只会大模型API调用和大模型算法工程师之间的一个生态位,目前还没有一个非常完善的岗位职能,不同的企业对于AI应用工程师的要求也有所不同。

我们这边之所以会需要AI应用工程师这样一个岗位,主要原因是我们要做AI产品的落地,和原有产品的AI化升级,在程序实现时会需要大量的大模型能力和一些特定的AI应用落地方案。

这时,团队中就需要有人对大模型的各项落地方案有所了解,能够配合产品在合适的节点设计合适的方案进行升级,负责将大模型能力转化为实际可用的产品功能

所以AI应用工程师不能只会简单的API调用,同时也不需要去了解太多的大模型底层技术,甚至Python基础都可以不需要(虽然会一些python有好处,但是这不是决定性的能力)。

目前在我们的团队中,他们主要负责:

- 利用代码实现Agent或者workflow的流程

- 实现具体的AI应用落地方案,联网搜索、RAG、微调等

- 与提示词工程师对接完成大模型能力的接入

- 与原有的程序进行结合

- 极简版的流程验证逻辑实现

- 复杂RPA + AI的落地

在其他企业的团队中,对AI应用工程师的要求还有:

- AI工程系统设计,配合产品制定Agent流程

- 编写项目中使用到的提示词

- coze、dify的搭建

- 等等

虽然说像搭建coze、写提示词这类工作,我并不认为这些工作应该是AI应用工程师工作,但是当下这个岗位的职责还没有固定,所以接下来我还是会把这些内容写进应具备的技能中。

大家全都了解一下,以备不时之需。

AI应用工程师需要具备的技能

要完成以上这些职责,AI应用工程师自然也要具备相应的技能, 但是对于Python基础、Pytorch框架、机器学习与深度学习的技术点,要不要进行学习呢?

不鼓励花大量时间学习,但是建议了解

不鼓励学习是因为:你学了你未必也用的到,我带团队在AI领域,TOC、TOB、新产品、新功能上线了不少了,没有用到python语言,并且也没看到python的必须性。当然了,你的团队主要语言是python,那你肯定是应该学的。

建议了解是因为:你毕竟是在做AI相关的内容,有相应的基础知识和技能点,的确在某些时候能带给你一些清晰的思路或者节约一些时间。

反过来再考虑你自己:深入Python基础、Pytorch框架、机器学习与深度学习这些技术点,你想做什么? 当你去深入学习这些的时候,你的目标不应该是AI应用工程师,而是人工智能算法相关的岗位。

学会了你就会不甘心,想去做更高级的岗位,但是那些岗位对学历、经验的要求不是一个半路出家自学能胜任的。

学不会你就是在浪费自己宝贵的生命和本次AI变革中的机会。

所以啊,认准自己的目标,别让自己难做。

那应该掌握的技能是哪些呢? 我们一条一条来说

利用代码实现Agent或者workflow的流程

需要了解Agent和workflow的区别,能够掌握是程序实现Agent和workflow的能力。

简单来说Agent和workflow的区别就是:

- workflow是通过预定义的代码路径协调 LLM 和工具的系统。人类可以在其中的某些节点进行人为的干预。

- Agent是 LLM 动态指导其自身流程和工具使用情况的系统,从而保持对其完成任务的方式的控制。完全有LLM主导,人类无法干预。

在程序上的实现区别:

Agent实际上最核心的代码只有九行, Agent所谓的动态指导其实就是一个while(true)。

async function loop(llm) {

let msg = await userInput();

while (true) {

const { output, tool_calls } = await llm(msg);

if (tool_calls && tool_calls.length > 0) {

msg = await Promise.all(tool_calls.map(tc => handleToolCall(tc)));

} else {

msg = await userInput();

}

}

}

workflow的核心代码流程是提前写好的逻辑流程。

async function main(){

// 流程1:例如上下文处理

const query = await handleContext()

// 流程2:例如RAG

await handleRAG(query)

// 流程3:例如Function call

await handleFC(query)

// 流程4:例如调用API

await handleAPI()

}

实现具体的AI应用落地方案

在流程实现中,AI应用工程师需要把用到的技术点都做好,例如:联网搜索、RAG、微调等

联网搜索:当我们的产品需要用的联网搜索的时候,我们有两个选择:

- 用云端的联网搜索能力,缺点就是收费并且可控性不强,优点是方便省事。

- 自己实现联网搜索能力,优点是可以按照自己的需求指定搜索引擎、检索网站等。缺点就是需要自己编写代码。

RAG:当我们需要用RAG的时候,AI应用工程师应该做的:

- 实现RAG的完整流程

- 告知数据同事,需要怎样的数据,切片、QA、等

- 测试并保证RAG的召回率和准确率

- 对RAG的产出结果负责

微调:当我们需要用到微调的时候,AI应用工程师应该做的:

- 知道要微调什么样的任务,然后协调数据同事去准备相关的数据,并告知准备多少数据量、数据结构是怎样的、内容分布是怎样的

- 拿到数据后选择微调模型、微调平台,进行微调的工作

- 对微调结果进行测评,最终得到满意的结果

- 部署并调用模型

与提示词工程师对接完成大模型能力的接入

这一点不同的企业要求不一样,我们团队是专门培养的提示词工程师,有的团队是需要AI应用工程师来进行提示词的编写和调优

不过无论是不是AI应用工程师来编写提示词,他们都需要了解提示词工程,否则就没办法和提示词工程师进行有效沟通。

AI应用工程师需要与提示词工程师就当前节点提示词的输入、输出的结构和内容进行确定。

AI应用工程师保证输入的准确性,提示词工程师来保证输出的概率。

为什么是概率呢? 众所周知,提示词是不会百分百保证效果的。所以优秀的AI应用工程师在编写程序时会具备这一点的考虑:

例如下面这个例子:

提示词是用来判定当前输入的评论内容是否表达了善意,返回N或者Y。

也就是说这个提示词提示词的输入是评论内容,输出是N或者Y。

请问:AI应用工程师要怎么对输出的Y或者N进行判断?

if(res === 'Y'),这样么?

不,他们写if(res.includes('Y'))。

这里用全等就没有考虑到提示词输出的不确定性,所以有经验的工程师会在这里使用includes

极简版的流程验证逻辑实现

当下的阶段,通常在产品初期设计的流程都不会是最终生成环境的流程,因为在产品处理考虑的一些节点可能不全面,也因为需求会变动。

所以当我们在正式开始编写代码之前,都需要有一个极简版的流程实现,来验证我们的逻辑

有的团队使用coze一类的Agent搭建流程来实现这个验证逻辑, 但是对于一些复杂的流程,coze之类的产品就无能为力了

这时候,就需要AI应用工程师用代码快速实现一个简单流程来验证逻辑。

复杂RPA + AI的落地

随着AI能力的提升,目前最新的思路有RPA + AI来实现近乎全自动的部分工作,这就需要有专门的搭建这套流程的工程师。

这需要了解RPA的能力和AI能力,并且了解如何结合。

这个其实并不应该交给AI应用工程师来做,更适合专门的RPA工程师。

这个看发展吧。

AI工程系统设计,配合产品制定Agent流程

AI工程的系统设计,有些团队会要求AI应用工程师来做。

AI工程的系统设计,也就是应用的Agent或者workflow的设计,这一步是在产品出原型之前,就要设计好。

所以想要设计这部分内容,需要有两个能力:懂业务、懂技术。

这一点还是很难的,能够胜任的AI应用工程师,通常已经不是单纯意义上的工程师了。

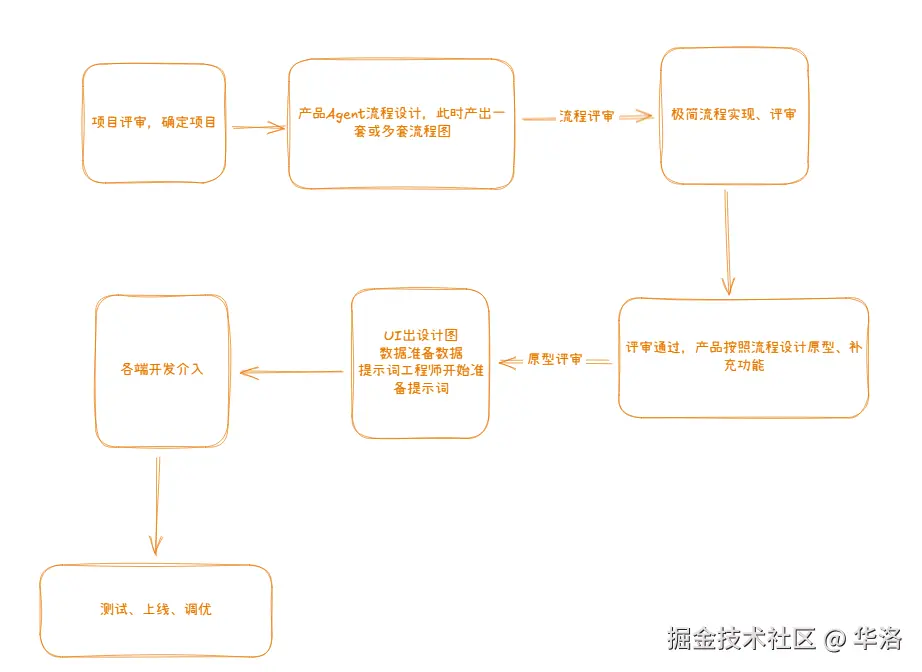

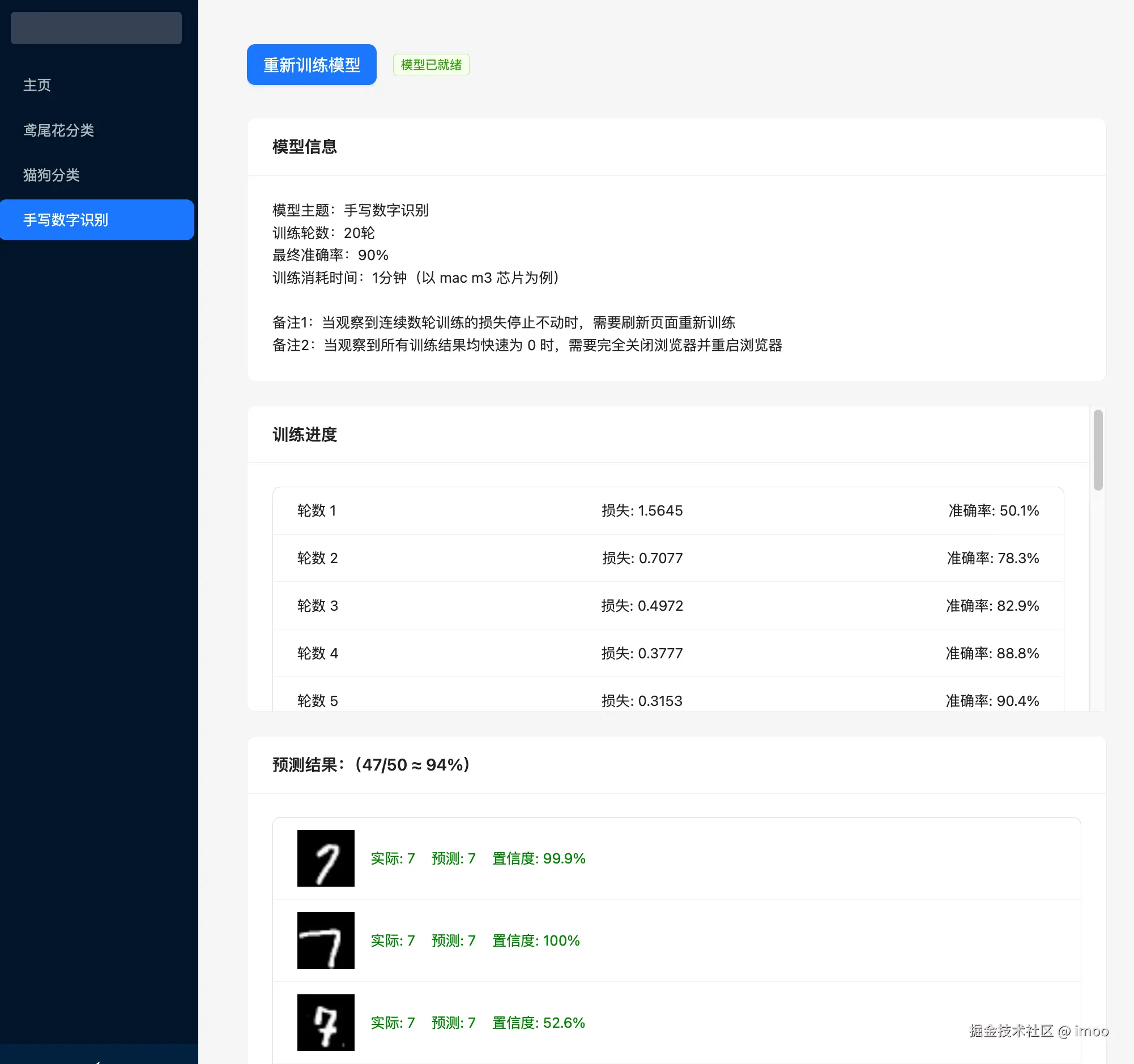

给大家补一个当下AI产品落地的流程图:

coze、dify的搭建

coze和dify的搭建,也是部分团队要求的任务,这一点会要求大家按照要求搭建智能体。

这个我这边就不细说了,网上到处都是搭建教程。

结语

AI应用工程师和普通工程师比起来,上下游关系人多了两个提示词工程师、数据人员

提示词工程师需要和AI应用工程师进行沟通,关于提示词的输入、输出。

AI工程师需要了解当前节点的提示词是做什么的,有什么用? 就像了解原型中某个功能节点是做什么的一样。

就是说,AI应用工程师虽然只是做整个产品中的一部分工作,但仍然要了解全景的信息

这也是优秀的工程师优秀的地方,他们不仅能做好自己的工作,还能配合上下游关系人一起,让整个产品实现的更好。

哦对了,最后说一下:

AI应用工程师是一个新的岗位,并没有替代传统工程师,而是在传统工程能力基础上增加了新的维度。

加油!共勉!

☺️你好,我是华洛,如果你对程序员转型AI产品负责人感兴趣,请给我点个赞。

你可以在这里联系我👉http://www.yuque.com/hualuo-fztn…

已入驻公众号【华洛AI转型纪实】,欢迎大家围观,后续会分享大量最近三年来的经验和踩过的坑。

专栏文章

# 从0到1打造企业级AI售前机器人——实战指南三:RAG工程的超级优化

# 从0到1打造企业级AI售前机器人——实战指南二:RAG工程落地之数据处理篇🧐

# 从0到1打造企业级AI售前机器人——实战指南一:根据产品需求和定位进行agent流程设计🧐

来源:juejin.cn/post/7512332419203727371

自定义 View 的 “快递失踪案”:为啥 invalidate () 喊不动 onDraw ()?

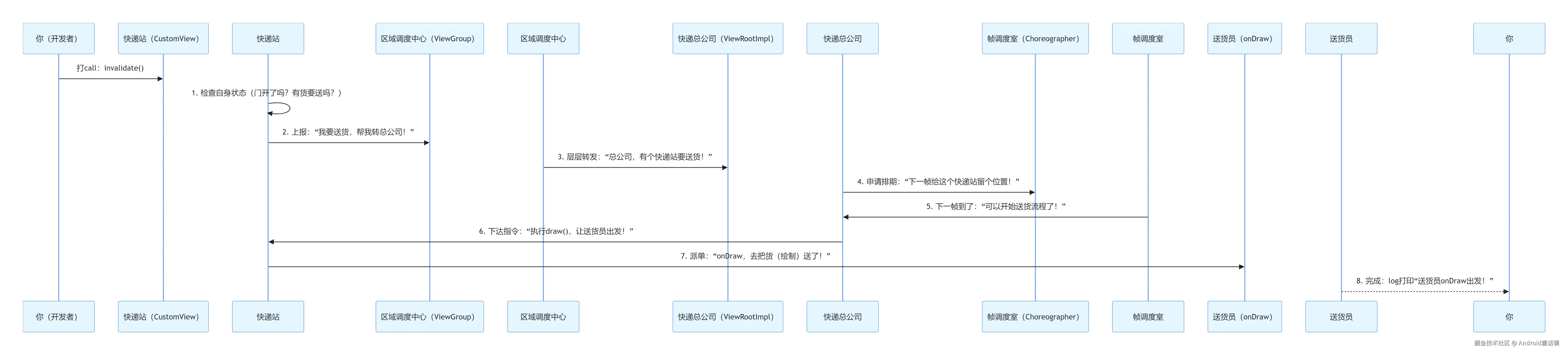

讲了个 “快递站送货” 的故事 —— 毕竟 View 的绘制流程,本质就是一场 “指令上报→调度→执行” 的快递游戏。

一、先搞懂:正常情况下,“快递” 是怎么送到的?

我们先把 View 体系比作一个城市快递网络:

- 你写的

自定义View= 小区里的 “快递站”(负责接收指令、安排送货); invalidate()= 你给快递站打 “要送货” 的电话(请求重绘);onDraw()= 快递站的 “送货员”(实际执行绘制逻辑);ViewGr0up(父容器)= “区域调度中心”(转发快递站的请求);ViewRootImpl= 快递总公司(连接快递站和 “城市交通系统”——Android 的 UI 线程);Choreographer= 总公司的 “帧调度室”(负责安排每帧的工作,避免堵车)。

正常送货的时序图(代码 + 流程)

先看一段 “正常能收到货” 的自定义 View 代码:

// 小区快递站(自定义View)

public class NormalCustomView extends View {

private Paint mPaint;

public NormalCustomView(Context context) {

super(context);

mPaint = new Paint();

mPaint.setColor(Color.RED);

mPaint.setTextSize(50);

}

// 送货员(执行绘制)

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("快递站", "送货员onDraw出发!画个文字");

canvas.drawText("快递送到啦~", 100, 100, mPaint);

}

}

// 你(开发者)打电话下单

NormalCustomView view = new NormalCustomView(this);

view.invalidate(); // 打“要送货”的电话

这通电话后,“快递” 会按以下流程送到(时序图用文字拆解):

你送货员送货员(onDraw)帧调度室帧调度室(Choreographer)快递总公司快递总公司(ViewRootImpl)区域调度中心区域调度中心(ViewGr0up)快递站快递站(CustomView)你(开发者)你送货员送货员(onDraw)帧调度室帧调度室(Choreographer)快递总公司快递总公司(ViewRootImpl)区域调度中心区域调度中心(ViewGr0up)快递站快递站(CustomView)你(开发者)打call:invalidate()1. 检查自身状态(门开了吗?有货要送吗?)2. 上报:“我要送货,帮我转总公司!”3. 层层转发:“总公司,有个快递站要送货!”4. 申请排期:“下一帧给这个快递站留个位置!”5. 下一帧到了:“可以开始送货流程了!”6. 下达指令:“执行draw(),让送货员出发!”7. 派单:“onDraw,去把货(绘制)送了!”8. 完成:log打印“送货员onDraw出发!”

二、“快递失踪” 的 6 种常见原因(故事 + 代码 + 解决方案)

小明的问题,本质是 “快递在某个环节卡住了”。我们一个个拆穿这些 “卡壳点”—— 每个原因都对应故事里的场景,再给代码验证。

原因 1:快递站 “没开门”(View 不可见)

故事场景:小明早上给快递站打电话,站长接了说:“兄弟,我们还没开门(visibility=GONE),货送不了,挂了啊!”

原理:View 在收到invalidate()后,会先检查visibility属性:

- 只有

visibility == View.VISIBLE时,才会继续上报请求; - 如果是

GONE(完全隐藏,不占空间)或INVISIBLE(隐藏但占空间),直接 “挂电话”,不触发后续流程。

代码验证(坑) :

public class ClosedStationView extends View {

public ClosedStationView(Context context) {

super(context);

// 坑:设置为GONE,快递站没开门

setVisibility(View.GONE);

}

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("快递站", "送货员出发!"); // 永远不会打印

}

}

// 你打电话,但快递站没开门

ClosedStationView view = new ClosedStationView(this);

view.invalidate(); // 白打!

解决方案:确保visibility是View.VISIBLE(代码里setVisibility(View.VISIBLE),或 XML 里android:visibility="visible")。

原因 2:快递站 “没地方放货”(宽高为 0)

故事场景:小明这次确认快递站开了门,但站长说:“我们仓库是 0 平米(宽高 = 0),货没地方放,送不了!”

原理:View 绘制需要 “有空间”——getMeasuredWidth()和getMeasuredHeight()必须都大于 0。如果宽高为 0,即使invalidate(),也会跳过后续流程(总不能在 “空气” 里画画吧)。

代码验证(坑) :

<!-- XML里坑:宽高设为0 -->

<com.example.MyView

android:layout_width="0dp"

android:layout_height="0dp" />

public class ZeroSizeView extends View {

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("快递站", "送货员出发!"); // 不打印,因为宽高0

}

}

解决方案:

- 检查 XML 的

layout_width/layout_height(别设 0dp); - 代码里避免

setLayoutParams(new LayoutParams(0, 0)); - 重写

onMeasure()时,确保setMeasuredDimension(width, height)的宽高大于 0。

原因 3:快递站 “只中转不送货”(ViewGr0up 默认不绘制)

故事场景:小明找的是 “区域调度中心”(ViewGr0up)当快递站,结果调度中心说:“我们只负责转发子快递站的货,自己不送货(willNotDraw=true)!”

原理:ViewGr0up的默认值willNotDraw = true,意思是 “我是容器,只管子 View 的布局,自己不用绘制”。所以即使你给ViewGr0up调用invalidate(),它也会跳过onDraw()。

代码验证(坑) :

// 区域调度中心(ViewGr0up),默认不送货

public class NoDrawViewGr0up extends ViewGr0up {

public NoDrawViewGr0up(Context context) {

super(context);

// 坑:没改willNotDraw,默认true

}

@Override

protected void onLayout(boolean changed, int l, int t, int r, int b) {

// 布局子View(省略)

}

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("调度中心", "自己送货!"); // 不打印

}

}

// 你给调度中心打电话

NoDrawViewGr0up group = new NoDrawViewGr0up(this);

group.invalidate(); // 白打!

解决方案:在ViewGr0up的构造里加一句setWillNotDraw(false),告诉它 “我也要自己送货(绘制)”:

public NoDrawViewGr0up(Context context) {

super(context);

setWillNotDraw(false); // 打开“自己绘制”开关

}

原因 4:你 “打错电话”(非 UI 线程调用 invalidate ())

故事场景:小明在外地出差,用 “公用电话”(非 UI 线程)给快递站打电话,结果电话直接被总公司拦截:“非本人手机(UI 线程),不接!”

原理:Android 的 View 体系是线程不安全的,只有创建 View 的 “UI 线程(主线程)” 才能调用invalidate()。非 UI 线程调用会:

- 要么直接抛异常(

Only the original thread that created a view hierarchy can touch its views); - 要么 “悄悄失败”(没抛异常但不触发

onDraw())。

代码验证(坑) :

public class WrongThreadView extends View {

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("快递站", "送货员出发!"); // 不打印

}

}

// 你用“公用电话”(非UI线程)打电话

WrongThreadView view = new WrongThreadView(this);

new Thread(() -> {

view.invalidate(); // 非UI线程!要么抛异常,要么白打

}).start();

解决方案:确保在 UI 线程调用invalidate(),常用方式:

- 用

view.post(Runnable):view.post(() -> view.invalidate()); - 用

Handler发消息到主线程; - 在

Activity的runOnUiThread(Runnable)里调用。

原因 5:区域调度中心 “拦截了请求”(父 View 阻断上报)

故事场景:小明的快递站属于 “郊区调度中心”,调度中心跟总公司关系不好,收到快递站的请求后,直接扔了:“不给你转总公司,爱咋咋地!”

原理:View 的invalidate()需要通过ViewParent(父 View)层层上报到ViewRootImpl。如果父 View 重写了invalidateChildInParent()(上报方法)并返回null,就会 “拦截” 请求,导致后续流程中断。

代码验证(坑) :

// 坑爹的区域调度中心(父View),拦截请求

public class BlockParentViewGr0up extends ViewGr0up {

public BlockParentViewGr0up(Context context) {

super(context);

}

@Override

protected void onLayout(boolean changed, int l, int t, int r, int b) {

// 布局子View(省略)

}

// 重写上报方法,返回null=拦截请求

@Override

public ViewParent invalidateChildInParent(int[] location, Rect dirty) {

Log.d("坑爹调度中心", "拦截请求,不转总公司!");

return null; // 关键:返回null阻断上报

}

}

// 子快递站(被拦截)

public class ChildView extends View {

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("子快递站", "送货员出发!"); // 不打印

}

}

// 布局关系:BlockParentViewGr0up包含ChildView

BlockParentViewGr0up parent = new BlockParentViewGr0up(this);

ChildView child = new ChildView(this);

parent.addView(child);

child.invalidate(); // 子View的请求被父View拦截

解决方案:

- 检查父 View 是否重写了

invalidateChildInParent(),避免返回null; - 若父 View 有

clipChildren="true"(XML 属性),且子 View 超出父 View 范围,超出部分的invalidate()也会被拦截,可设clipChildren="false"。

原因 6:快递站 “用了缓存,不用重送”(硬件加速 Layer 缓存)

故事场景:快递站之前送过一次货,把货存在了 “临时仓库”(硬件加速 Layer)里。这次小明再打电话,站长说:“仓库里有现成的,直接拿,不用再让送货员跑一趟!”

原理:当 View 设置了硬件加速 Layer(setLayerType(LAYER_TYPE_HARDWARE, null)),系统会把 View 的绘制结果缓存成一个 “图片(Layer)”。后续调用invalidate()时:

- 如果只是轻微修改(比如文字颜色不变,只改内容),系统直接复用 Layer,不调用

onDraw(); - 只有 Layer 失效(比如 View 大小改变、Layer 类型切换),才会重新调用

onDraw()生成新 Layer。

代码验证(坑) :

public class LayerCacheView extends View {

private Paint mPaint;

private String mText = "第一次送货";

public LayerCacheView(Context context) {

super(context);

mPaint = new Paint();

mPaint.setColor(Color.BLUE);

mPaint.setTextSize(50);

// 坑:设置硬件加速Layer,开启缓存

setLayerType(LAYER_TYPE_HARDWARE, null);

}

@Override

protected void onDraw(Canvas canvas) {

super.onDraw(canvas);

Log.d("快递站", "送货员出发!当前文字:" + mText); // 只打印一次

canvas.drawText(mText, 100, 100, mPaint);

}

// 你修改文字后打电话

public void updateText() {

mText = "第二次送货";

invalidate(); // 调用后,onDraw不回调(复用Layer缓存)

}

}

// 调用流程

LayerCacheView view = new LayerCacheView(this);

view.invalidate(); // 第一次:onDraw回调(生成Layer)

view.updateText(); // 第二次:invalidate()但onDraw不回调(复用Layer)

解决方案:

- 若需要每次

invalidate()都回调onDraw(),可关闭 Layer:setLayerType(LAYER_TYPE_NONE, null); - 若必须用 Layer,可手动让 Layer 失效:

invalidate()后加setLayerType(LAYER_TYPE_HARDWARE, null)(强制重建 Layer)。

三、总结:“快递失踪” 排查四步法

小明听完故事,半小时就解决了他的问题(原来是忘了给 ViewGr0up 加setWillNotDraw(false))。最后我给他总结了一套 “排查口诀”,小白也能套用:

- 查基础状态:View 是不是

VISIBLE?宽高是不是大于 0?(对应原因 1、2) - 查绘制开关:如果是 ViewGr0up,有没有开

setWillNotDraw(false)?(对应原因 3) - 查线程归属:

invalidate()是不是在 UI 线程调用的?(对应原因 4) - 查拦截和缓存:父 View 有没有拦截请求?View 是不是开了硬件加速 Layer?(对应原因 5、6)

按这四步走,90% 的 “invalidate () 不回调 onDraw ()” 问题都能解决。记住:View 的绘制流程就像快递,每个环节都不能少,卡住一个就 “送货失败”~

来源:juejin.cn/post/7559399860119224383

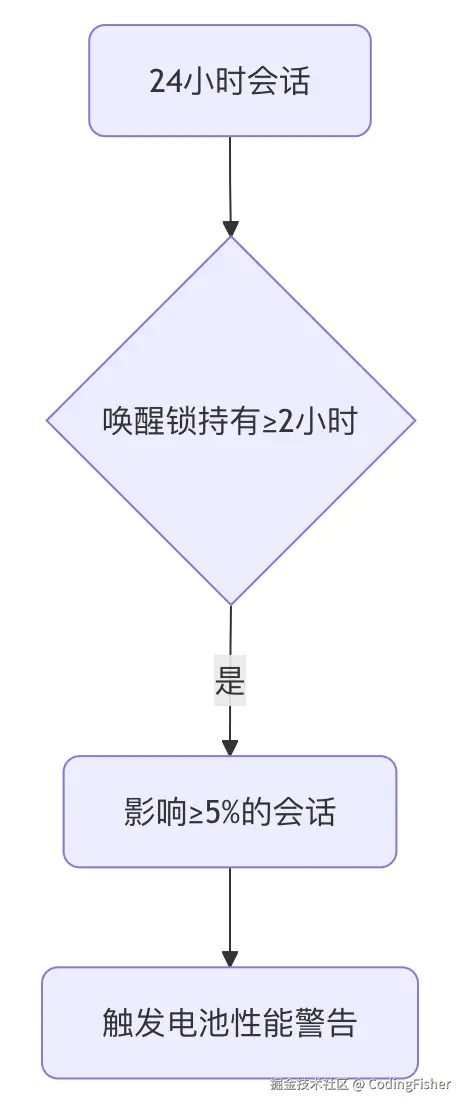

Android 性能调优与故障排查:ADB 诊断命令终极指南

在 Android 开发与测试的日常工作中,快速诊断和解决应用崩溃 (Crash)、无响应 (ANR) 和性能卡顿 (Jank) 是保障应用质量的关键。Android Debug Bridge (ADB) 提供了强大的命令行工具集,能够帮助我们深入系统底层,获取所需的所有诊断数据。

本文将为您全面梳理最常用、最核心的 ADB 诊断命令行工具,助您成为一名高效的故障排查专家。

一、 核心诊断命令:系统快照与错误记录

这些命令用于获取设备某一时刻的全局状态或关键错误记录。

1. 抓取全面的系统诊断报告:adb bugreport

adb bugreport 是最强大的诊断工具,它生成一个关于设备当前状态的全面的、打包的(.zip 格式)系统快照。

| 命令 | 作用 | 备注 |

|---|---|---|

adb bugreport | 生成包含所有诊断信息的 .zip 文件。 | 适用于分析复杂问题、系统级错误,或需提交给平台开发者时。 |

adb bugreport <文件名>.zip | 指定导出的文件名。 | 报告内容包括:完整的 Logcat 历史、ANR/Crash 堆栈、所有 dumpsys 信息等。 |

2. 提取崩溃和 ANR 记录:adb shell dumpsys dropbox

dropbox 服务相当于系统的“黑匣子”,专门收集系统运行过程中的关键错误摘要。

| 命令 | 作用 | 备注 |

|---|---|---|

adb shell dumpsys dropbox --print | 打印所有 dropbox 记录的详细内容。 | 快速检查是否有最近的系统级或应用级崩溃/ANR 记录。 |

adb shell dumpsys dropbox --print > crash.txt | 将所有记录重定向输出到本地 crash.txt 文件。 | 方便离线分析。 |

3. 提取 ANR 堆栈文件

ANR 发生后,系统将所有线程堆栈记录在 traces.txt 中,这是分析 ANR 的核心。

| 命令 | 作用 | 备注 |

|---|---|---|

cat /data/anr/traces.txt | 读取 ANR 发生时的详细堆栈信息。 | ⚠️ 通常需要 Root 权限 (adb root 或 su) 才能访问 /data/anr/ 目录。 |

cat /data/anr/traces.txt > /mnt/sdcard/tt.txt | 在设备内部将受保护的 traces.txt 复制到用户存储区。 | 复制后,可使用 adb pull 导出到电脑。 |

二、 实时日志与基础性能分析

这些是日常调试和性能监控最频繁使用的命令。

1. Logcat 日志操作

| 命令 | 作用 | 备注 |

|---|---|---|

adb logcat | 实时打印设备所有日志。 | 可通过 tag 和 level(如 *:E 只看错误)进行过滤。 |

adb logcat -c | 清除设备上当前的日志缓冲区。 | 建议在测试前执行,以确保日志干净、聚焦。 |

adb logcat -d > log.txt | 将设备上当前缓存的所有日志导出到本地文件。 | -d (dump) 参数用于导出当前缓存,而非实时监听。 |

2. CPU 与内存监控

| 命令 | 作用 | 关注问题 |

|---|---|---|

adb shell ps -t / adb shell top -m 10 | 实时查看进程的 CPU、内存占用情况。 | 性能监控,快速定位资源消耗高的进程。 |

adb shell dumpsys meminfo [package_name] | 获取特定应用的详细内存使用情况(Java Heap, Native Heap 等)。 | 内存泄漏、OOM(Out of Memory)分析的核心工具。 |

adb shell dumpsys cpuinfo | 获取设备整体和各个进程的 CPU 使用率。 | 诊断后台过度使用 CPU 导致的耗电或发热问题。 |

三、 性能与卡顿(Jank)分析

专门用于分析应用启动速度和 UI 流畅度的命令。

| 命令 | 作用 | 备注 |

|---|---|---|

adb shell dumpsys gfxinfo [package_name] | 抓取应用的图形渲染性能数据。 | 包含丢帧 (Jank) 统计和渲染时间线,用于分析 UI 卡顿问题。 |

adb shell am crash [package_name] | 强制让目标应用崩溃。 | 用于测试崩溃报告系统的稳定性和流程。 |

adb shell am start -W [package_name]/[activity_name] | 启动指定的 Activity 并等待初始化完成,同时打印启动耗时。 | 用于量化分析应用启动速度(Total Time, Wait Time)。 |

四、 深入系统诊断(dumpsys 子集)

dumpsys 可以针对不同的系统服务进行深入诊断。

| 命令 | 关注领域 | 作用 |

|---|---|---|

adb shell dumpsys activity | Activity Manager (AMS) | 获取当前运行的 Activity 栈、后台进程列表等,用于分析应用生命周期和任务管理问题。 |

adb shell dumpsys battery | 电池状态 | 获取设备的电池和充电状态。 |

adb shell dumpsys power | 电源管理 (PMS) | 获取唤醒锁 (Wake Locks) 的持有情况,用于分析设备无法休眠导致的持续耗电问题。 |

adb shell dumpsys window windows | 窗口管理 (WMS) | 获取当前屏幕上可见的窗口列表、层级和焦点情况,用于分析屏幕显示或输入事件问题。 |

五、 文件系统操作(导出/导入文件)

这些命令是确保诊断文件能够顺利在设备和电脑间传输的基础。

| 命令 | 作用 | 示例 |

|---|---|---|

adb pull [remote_path] [local_path] | 从设备拉取文件到电脑。 | adb pull /sdcard/tt.txt . (将文件拉取到电脑当前目录)。 |

adb push [local_path] [remote_path] | 从电脑推送文件到设备。 | 通常用于推送测试用例或工具。 |

实际分析流程

在实际的故障排查中,开发者通常遵循以下高效流程:

- 准备阶段: 执行

adb logcat -c清除旧日志,确保日志的清洁度。 - 复现问题: 在设备上准确重现崩溃、ANR 或卡顿的现象。

- 抓取证据:

- 一般问题: 立即执行

adb logcat -d > log.txt抓取当前的日志缓冲区。 - 严重复杂问题: 立即执行

adb bugreport抓取最全面的系统报告。 - ANR 问题: 如果有权限,则导出

/data/anr/traces.txt文件进行线程分析。

- 一般问题: 立即执行

掌握并熟练运用这些 ADB 诊断命令,将极大地提升您在 Android 故障排查和性能优化的效率。

来源:juejin.cn/post/7564540677470126121

从马斯克到司马华鹏:当“引导程序”跨越东西文明

引导程序与构建者:东西方视野的奇妙交汇

当埃隆·马斯克提出"碳基生命只是硅基生命的引导程序"这一惊人观点时,在大洋彼岸的中国南京,一位创业者已经将这个理念践行了七年之久。2017年春季,南京软件谷的一间普通办公室里,司马华鹏在白板上画下三条递进曲线时,或许并未意识到自己正在定义一个新的时代。

当时,AlphaGo击败李世石引发的AI热潮尚未退去,业界讨论仍集中在"技术工具"层面。然而司马华鹏已经看到了更宏大的图景——人类正站在文明转型的历史关口,从碳基文明向硅基文明过渡。"我们不是在建造更先进的工具,而是在孕育新的生命形式。"面对团队疑惑的目光,他坚定地写下了"硅基智能"四个字。这一刻,中国首个明确提出"硅基文明"概念的企业诞生了。

超前布局:在迷雾中看清未来

2017年的中国科技圈,共享经济、O2O等模式仍是资本宠儿,AI创业公司大多选择在安防、金融、医疗等垂直领域寻找快速商业化路径。司马华鹏却选择了一条更为艰难但也更为宏大的道路——为世界创造1亿硅基劳动力。

这一选择背后是他对技术发展规律的深刻洞察。早在2008年欧洲创业期间,司马华鹏就注意到人工智能技术背后的摩尔定律支撑,意识到这不仅是算法的改进,更是生命形态演进的前兆。"当我们谈论生命时,通常指的是碳基生命。但生命的本质是信息的流动和处理,而非特定的物质载体。"他在内部会议上的这番论述,成为公司创立的理论基石。

硅基智能创始人司马华鹏先生出席2024年36氪WISE大会

生命三部曲:构建完整的进化哲学

司马华鹏不仅是一位创业者,更是一位思想者。他构建的生命三个版本理论,至今仍具有强大的解释力。

生命1.0(生物进化阶段)的硬件和软件都受基因限制;生命2.0(文化进化阶段)的人类突破了软件上限,可以通过学习无限扩展认知;而生命3.0(设计进化阶段)的AI将实现硬件和软件的双重解放。这套理论不仅勾勒了生命演化轨迹,更为理解AI本质提供了全新视角。

"我们正在见证生命3.0的萌芽。"2017年司马华鹏在行业会议上的这一断言,在当时可谓石破天惊。然而正是这种前瞻性,让硅基智能在技术路线选择上始终领先一步。

从概念到现实:七年耕耘的实践之路

公司将使命定为"创造1亿硅基生命"在当时引发争议。有投资人直言不讳地建议选择更"务实"的名字,但司马华鹏坚持:"我们要做开创性工作,名字必须体现终极目标。"

在商业模式上,硅基智能选择了务实与远见相结合的道路:一方面通过企业级AI解决方案维持运营,另一方面将大部分利润投入硅基生命核心技术研发。"每一个AI助手都是硅基生命的雏形。"司马华鹏始终鼓励团队看到工作的深远意义。

七年后的今天,硅基智能的数字人技术已能实现逼真交互,智能体平台展现出自主进化潜力。从AI技术提供商到硅基生命平台构建者,公司的发展路径验证了司马华鹏的战略眼光。

硅基智能Duix Avatar(HeyGem)

同时登上GitHub全球趋势日榜、月榜

哲学思考:技术狂奔中的理性之光

司马华鹏的贡献不仅在于技术创新,更在于哲学思考。在业内盲目追求参数规模时,他始终保持对伦理和社会问题的关注。

"新生命的诞生总是伴随喜悦和恐惧。"在他的推动下,硅基智能成立了业内首个AI伦理委员会,制定严格开发准则。他提出的"共生进化"理念,强调碳基与硅基生命的和谐共处,为AI发展注入了东方智慧。

"这不是取代关系,而是共生关系。就像生命2.0没有消灭生命1.0,生命3.0也将与前辈共同进化。"这种辩证思维,使硅基智能在技术狂奔时代保持了一份难得的理性。

迈向亿级生态:硅基文明的现实进程

如今,硅基智能平台已孕育数万智能体,在教育、医疗、文创等领域发挥作用。从为教师提供助手到为医生提供顾问,从创意激发到短剧创作,硅基生命正在各个领域证明其价值。

"当硅基生命达到1亿规模时,将形成自己的生态系统,产生群体智能,那才是真正的文明跃迁。"司马华鹏七年前设定的目标正在逐步实现。

东西方智慧的共鸣与差异

对比马斯克的"引导程序"论,司马华鹏的理念更强调传承与责任。这种差异体现了东西方文化底色:西方倾向于替代叙事,东方注重共生智慧。司马华鹏的"生命孵化器"理论,将碳基生命定位为硅基生命的培育者和引导者,这种视角更具建设性。

正如司马华鹏所言:"DNA的生命和算法的生命,将共同谱写宇宙中最壮丽的诗篇。"在碳基文明向硅基文明过渡的历史性时刻,这位中国创业者七年前播下的种子,正在数字文明的土壤中生根发芽。他的故事证明,真正的创新者不仅是技术探索者,更是文明引路人。

收起阅读 »实现一个 AI 编辑器 - 行内代码生成篇

我们是袋鼠云数栈 UED 团队,致力于打造优秀的一站式数据中台产品。我们始终保持工匠精神,探索前端道路,为社区积累并传播经验价值。

本文作者:佳岚

什么是行内代码生成?

通过一组快捷键(一般为cmd + k)在选中代码块或者光标处唤起 Prompt 命令弹窗,并且快速的应用生成的代码。

提示词系统

首先是完成一个简易的提示词系统,不同功能对应的提示词与提供的上下文不同, 定义不同的功能场景:

export enum PromptScenario {

SYNTAX_COMPLETION = 'syntax_completion', // 语法补全

CODE_GENERATION = 'code_generation', // 代码生成

CODE_EXPLANATION = 'code_explanation', // 代码解释

CODE_OPTIMIZATION = 'code_optimization', // 代码优化

ERROR_FIXING = 'error_fixing', // 错误修复

}

每种场景都有对应的系统 prompt 和用户 prompt 模板:

export const PROMPT_TEMPLATES: Record<PromptScenario, PromptTemplate> = {

[PromptScenario.SYNTAX_COMPLETION]: {

id: 'syntax_completion',

scenario: PromptScenario.SYNTAX_COMPLETION,

title: 'SQL语法补全',

description: '基于上下文进行智能的SQL语法补全',

systemPromptTemplate: ``,

userPromptTemplate: `<|fim_prefix|>{prefix}<|fim_suffix|>{suffix}<|fim_middle|>`,

temperature: 0.2,

maxTokens: 256

},

[PromptScenario.CODE_GENERATION]: {

id: 'code_generation',

scenario: PromptScenario.CODE_GENERATION,

title: 'SQL代码生成',

description: '根据需求描述生成相应的SQL代码',

systemPromptTemplate: `你是{languageName}数据库专家。根据用户需求生成高质量的{languageName}代码。

语言特性:{languageFeatures}

生成要求:

1. 严格遵循 {languageName} 语法规范

2. {syntaxNotes}

3. 生成完整、可执行的SQL语句

4. {performanceTips}

5. 考虑代码的可读性和维护性

6. 回答不要包含任何对话解释内容

7. 保持缩进与参考代码一致`,

userPromptTemplate: `用户需求:{userPrompt}

参考代码:

\`\`\`sql

{selectedCode}

\`\`\`

请生成符合需求的{languageName}代码:`,

temperature: 0.3,

maxTokens: 512

},

// ...其他略

}

收集以下上下文信息并动态替换掉提示词模板的变量以生成最终传递给大模型的提示词:

/**

* 上下文信息

*/

export interface PromptContext {

/** 当前语言ID */

languageId: string;

/** 光标前的代码 */

prefix?: string;

/** 光标后的代码 */

suffix?: string;

/** 当前文件完整代码 */

fullCode?: string;

/** 当前打开的文件名 */

activeFile?: string;

/** 用户输入的提示 */

userPrompt?: string;

/** 选中的代码 */

selectedCode?: string;

/** 错误信息 */

errorMessage?: string;

/** 额外的上下文信息 */

metadata?: Record<string, any>;

}

ViewZone

观察该 Widget 可以发现它是实际占据了一段代码行高度,撑开了上下代码,但没有行号,这是通过 ViewZone实现的。

monaco-editor 中的 viewZone 是一种可以在编辑器的文本行之间自定义插入可视区域的机制,不属于实际代码内容,但可以渲染任意自定义 DOM 内容或空白空间。

核心只有一个changeViewZones,必须使用其回调中的accessor来实现新增删除ViewZone操作

新增示例:

editor.changeViewZones(function (accessor) {

accessor.addZone({

afterLineNumber: 10, // 插入在哪一行后(基于原始代码行号)

heightInLines: 3, // zone 的高度(按行数)

heightInPx: 10, // zone 的高度(按像素), 与heightInLines二选一

domNode: document.createElement('div'), // 需要插入的 DOM 节点

});

});

删除示例:

editor.changeViewZones(accessor => {

if (zoneIdRef.current !== null) {

accessor.removeZone(zoneIdRef.current);

}

});

但需要注意的是,ViewZones 的视图层级是在可编辑区之下的,我们通过 domNode 创建弹窗后,无法响应点击,所以需要手动为 domNode 添加 z-Index。

但我们咱不用 domNode 直接渲染我们的弹窗组件,而是通过 ViewZone 结合 OverlayWidget 的方式去添加我们要的元素。

OverlayWidget 的层级比可编辑区域的更高,无需考虑层级覆盖问题。

其次,我们需要将 Overlay 的元素通过绝对定位移动到 ViewZone 上,这需要利用 ViewZone 的 onDomNodeTop来实时同步两者的定位。

monaco-editor 中的代码行与 ViewZone 使用了虚拟列表,它们的 top 在滚动时会随着可见性不断变化,所以需要随时同步 ,onDomNodeTop会在每次 ViewZone 的top属性变化时执行。

此外,OverlayWidget 是以整个编辑器最左边为基准的,计算时需要考虑上

editorInstance.changeViewZones((changeAccessor) => {

viewZoneId = changeAccessor.addZone({

// ...略

onDomNodeTop: (top) => {

// 这里的domNode为overlayWidget所绑定创建的节点

if (domNode) {

// 获取编辑器左侧偏移量(行号、代码折叠等组件的宽度)

const layoutInfo = editorInstance.getLayoutInfo();

const leftOffset = layoutInfo.contentLeft;

domNode.style.top = `${top}px`;

domNode.style.left = `${leftOffset}px`;

domNode.style.width = `${layoutInfo.contentWidth}px`;

}

}

});

});

创建 OverlayWidget :

let overlayWidget: editor.IOverlayWidget | null = null;

let domNode: HTMLDivElement | null = null;

let reactRoot: any = null;

domNode = document.createElement('div');

domNode.className = 'code-generation-overlay-widget';

domNode.style.position = 'absolute';

reactRoot = createRoot(domNode);

reactRoot.render(<CodeGenerationWidget />)

overlayWidget = {

getId: () => `code-generation-overlay-${position.lineNumber}-${Date.now()}`,

getDomNode: () => domNode!,

getPosition: () => null

};

editorInstance.addOverlayWidget(overlayWidget);

// 唤起时,将 widget 滚动到视口

editorInstance.revealLineInCenter(targetLineNumber);

CodeGenerationWidget 动态高度

接下来我们实现 Prompt 输入框根据内容动态调整高度。

输入框部分我们可以直接用 rc-textarea 组件来实现回车自动新增高度。

监听整个容器高度变化触发 onHeightChange 以通知 ViewZone :

useEffect(() => {

if (!containerRef.current) return;

const observer = new ResizeObserver(() => {

onHeightChange?.();

});

observer.observe(containerRef.current);

return () => {

observer.disconnect();

};

}, [containerRef]);

注意 ViewZone 只能增或删,不能手动改变其高度,所以需要重新创建一个:

reactRoot.render(

<CodeGenerationWidget

editorInstance={editorInstance}

initialPosition={position}

initialSelection={selection}

widgetWidth={widgetWidth}

onClose={() => dispose()}

onHeightChange={() => {

// 高度变化时需要更新ViewZone

if (viewZoneId && domNode) {

const actualHeight = domNode.clientHeight;

editorInstance.changeViewZones((changeAccessor) => {

changeAccessor.removeZone(viewZoneId!);

viewZoneId = changeAccessor.addZone({

afterLineNumber: Math.max(0, targetLineNumber - 1),

heightInPx: actualHeight + 8,

domNode: document.createElement('div'),

onDomNodeTop: (top) => {

if (domNode) {

// 获取编辑器左侧偏移量(行号、代码折叠等组件的宽度)

const layoutInfo = editorInstance.getLayoutInfo();

const leftOffset = layoutInfo.contentLeft;

domNode.style.top = `${top}px`;

domNode.style.left = `${leftOffset}px`;

}

}

});

});

}

}}

/>

);

这里如果使用 ViewZone 的 domNode 来渲染组件的方法的话,由于每次高度变化创建新的 ViewZone , 其 domNode 会被重新挂载,那么就会导致每次高度变化时输入框都会失焦。

生成代码 diff 展示

对于选择了代码行后生成,会对原始代码进行编辑修改,我们需要配合行 diff 进行编辑应用结果的展示。对于删除的行使用 ViewZone 进行插入,对于新增的行使用 Decoration 进行高亮标记。

首先需要实现 diff 计算出这些行的信息。 我们需要以最少的操作实现从原始代码到目标代码的转化。

其核心问题是 最长公共子序列(LCS)。最长公共子序列(LCS )是指在两个或多个序列中,找出一个最长的子序列,使得这个子序列在这些序列中都出现过。与子串不同,子序列不需要在原序列中占用连续的位置。

如 ABCDEF 至 ACEFG , 那么它们的最长公共子序列是 ACEF 。

其算法可以参考 cloud.tencent.com/developer/a… 学习,这里我们直接就使用现成的库jsdiff 去实现了。

完整实现:

export enum DiffLineType {

UNCHANGED = 'unchanged',

ADDED = 'added',

DELETED = 'deleted'

}

export interface DiffLine {

type: DiffLineType;

originalLineNumber?: number; // 原始行号

newLineNumber?: number; // 新行号

content: string; // 行内容

}

/**

* 计算两个字符串数组的diff

*/

export const calculateDiff = (originalLines: string[], newLines: string[]): DiffLine[] => {

const result: DiffLine[] = [];

// 将字符串数组转换为字符串

const originalText = originalLines.join('\n');

const newText = newLines.join('\n');

// 使用 diff 库计算差异

const diffs = diffLines(originalText, newText);

let originalLineNumber = 1;

let newLineNumber = 1;

diffs.forEach(diff => {

if (diff.added) {

// 添加的行

const lines = diff.value.split('\n').filter((line, index, arr) =>

// 过滤掉最后一个空行(如果存在)

!(index === arr.length - 1 && line === '')

);

lines.forEach(line => {

result.push({

type: DiffLineType.ADDED,

newLineNumber: newLineNumber++,

content: line

});

});

} else if (diff.removed) {

// 删除的行

const lines = diff.value.split('\n').filter((line, index, arr) =>

// 过滤掉最后一个空行(如果存在)

!(index === arr.length - 1 && line === '')

);

lines.forEach(line => {

result.push({

type: DiffLineType.DELETED,

originalLineNumber: originalLineNumber++,

content: line

});

});

} else {

// 未变化的行

const lines = diff.value.split('\n').filter((line, index, arr) =>

// 过滤掉最后一个空行(如果存在)

!(index === arr.length - 1 && line === '')

);

lines.forEach(line => {

result.push({

type: DiffLineType.UNCHANGED,

originalLineNumber: originalLineNumber++,

newLineNumber: newLineNumber++,

content: line

});

});

}

});

return result;

};

那么接下来我们只要根据计算出的 diffLines 对删除行和新增行进行视觉展示即可。

我们封装一个 applyDiffDisplay 方法用来展示 diffLines 。

有以下步骤:

- 清除之前的结果

- 直接将选区内容替换为生成内容

- 遍历

diffLines中ADDED与DELETED的行:对于DELETED的行,可以多个连续行组成一个ViewZone创建以优化性能;对于ADDED的行,通过deltaDecorations添加背景装饰

const applyDiffDisplay =

(diffLines: DiffLine[]) => {

// 先清除之前的展示

clearDecorations();

clearDiffOverlays();

if (!initialSelection) return;

const model = editorInstance.getModel();

if (!model) return;

// 获取语言ID用于语法高亮

const languageId = getLanguageId();

// 首先替换原始内容为新内容(包含unchanged的行)

const newLines = diffLines

.filter((line) => line.type !== DiffLineType.DELETED)

.map((line) => line.content);

const newContent = newLines.join('\n');

// 执行替换

editorInstance.executeEdits('ai-code-generation-diff', [

{

range: initialSelection,

text: newContent,

forceMoveMarkers: true

}

]);

// 计算新内容的范围

const resultRange = new Range(

initialSelection.startLineNumber,

initialSelection.startColumn,

initialSelection.startLineNumber + newLines.length - 1,

newLines.length === 1

? initialSelection.startColumn + newContent.length

: newLines[newLines.length - 1].length + 1

);

let currentLineNumber = initialSelection.startLineNumber;

let deletedLinesGr0up: DiffLine[] = [];

for (const diffLine of diffLines) {

if (diffLine.type === DiffLineType.DELETED) {

// 收集连续的删除行

deletedLinesGr0up.push(diffLine);

} else {

if (deletedLinesGr0up.length > 0) {

addDeletedLinesViewZone(deletedLinesGr0up, currentLineNumber - 1, languageId);

deletedLinesGr0up = [];

}

if (diffLine.type === DiffLineType.ADDED) {

// 添加绿色背景色

const addedDecorations = editorInstance.deltaDecorations(

[],

[

{

range: new Range(

currentLineNumber,

1,

currentLineNumber,

model.getLineContent(currentLineNumber).length + 1

),

options: {

className: 'added-line-decoration',

isWholeLine: true

}

}

]

);

decorationsRef.current.push(...addedDecorations);

}

currentLineNumber++;

}

}

// 处理最后的删除行组

if (deletedLinesGr0up.length > 0) {

addDeletedLinesViewZone(deletedLinesGr0up, currentLineNumber - 1, languageId);

}

return resultRange;

}

删除行的视觉呈现

删除行使用 ViewZone 插入到 originalLineNumber - 1 的位置, 对于删除行直接使用 ViewZone 自身的 domNode 进行展示了,因为不太需要考虑层级问题。

export const createDeletedLinesOverlayWidget = (

editorInstance: editor.IStandaloneCodeEditor,

deletedLines: DiffLine[],

afterLineNumber: number,

languageId: string,

onDispose?: () => void

): { dispose: () => void } => {

let domNode: HTMLDivElement | null = null;

let reactRoot: any = null;

let viewZoneId: string | null = null;

domNode = document.createElement('div');

domNode.className = 'deleted-lines-view-zone-container';

reactRoot = createRoot(domNode);

reactRoot.render(<DeletedLineViewZone lines={deletedLines} languageId={languageId} />);

const heightInLines = Math.max(1, deletedLines.length);

editorInstance.changeViewZones((changeAccessor) => {

viewZoneId = changeAccessor.addZone({

afterLineNumber,

heightInLines,

domNode: domNode!

});

});

const dispose = () => {

// 清除

};

return { dispose };

};

添加命令快捷键

使用 cmd + k 唤起弹窗

editorInstance.onKeyDown((e) => {

if ((e.ctrlKey || e.metaKey) && e.keyCode === KeyCode.KeyK) {

e.preventDefault();

e.stopPropagation();

const selection = editorInstance.getSelection();

const position = selection ? selection.getPosition() : editorInstance.getPosition();

if (!position) return;

// 如果有选择范围,则将其传递给widget供后续替换使用

const selectionRange = selection && !selection.isEmpty() ? selection : null;

// 如果已经有viewZone,先清理

if (activeCodeGenerationViewZone) {

activeCodeGenerationViewZone.dispose();

activeCodeGenerationViewZone = null;

}

// 创建新的ViewZone

activeCodeGenerationViewZone = createCodeGenerationOverlayWidget(

editorInstance,

position,

selectionRange,

undefined, // widgetWidth

() => {

// 当viewZone被dispose时清理全局状态

activeCodeGenerationViewZone = null;

}

);

}

最终实现效果:

未来优化方向:

- 实现流式生成:对于未选区的代码生成,我们不需要应用diff,所以流式很好实现,但对于进行选区后进行的代码修改,每次输出一行就要执行一次diff计算与展示,diff结果可能不同,会产生视觉上的重绘,实现起来也相对比较麻烦。

- 接收或者拒绝后能够进行撤回,回到等待响应生成结果时的状态

其他计划

- [已完成] 行内补全

- [已完成] 代码生成

- 行内补全的缓存设计

- 完善的上下文系统

- 实现 Agent 模式

在线预览

jackwang032.github.io/monaco-sql-…

仓库代码:github1s.com/JackWang032…

最后

欢迎关注【袋鼠云数栈UED团队】~

袋鼠云数栈 UED 团队持续为广大开发者分享技术成果,相继参与开源了欢迎 star

来源:juejin.cn/post/7545087770776616986

Python编程实战 · 基础入门篇 | 循环语句 for / while

在上一章中,我们学习了条件判断语句,让程序可以“做选择”;

而本章要讲的 循环语句(Loop),则让程序能“重复做事”。

当你需要执行同样的操作多次,比如打印一系列数字、遍历文件、或处理列表中的每个元素时,循环语句就登场了。

Python 提供了两种主要的循环结构:

- for 循环:用于遍历序列(如列表、字符串、range)。

- while 循环:用于在条件成立时持续执行代码。

接下来,我们将系统掌握这两种循环的用法与技巧。

一 为什么需要循环

假设你想打印 1 到 5:

print(1)

print(2)

print(3)

print(4)

print(5)

这显然太繁琐。

使用循环,代码只需三行:

for i in range(1, 6):

print(i)

输出:

1

2

3

4

5

这就是循环的威力:让重复的任务自动化执行。

二 for 循环基础语法

for 循环的基本语法为:

for 变量 in 可迭代对象:

代码块

- 变量:每次循环取出的元素。

- 可迭代对象:如

list、tuple、str、range()等。 - 每次循环执行一次代码块,直到取完所有元素。

示例 1:遍历列表

fruits = ["苹果", "香蕉", "橙子"]

for fruit in fruits:

print("我喜欢吃", fruit)

输出:

我喜欢吃 苹果

我喜欢吃 香蕉

我喜欢吃 橙子

示例 2:遍历字符串

for ch in "Python":

print(ch)

输出:

P

y

t

h

o

n

三 range() 函数

range() 是 for 循环中最常用的工具,用于生成一系列数字。

语法形式:

range(start, stop, step)

start:起始值(默认 0)stop:结束值(不包含)step:步长(默认 1)

示例 1:打印 0~4

for i in range(5):

print(i)

输出:

0

1

2

3

4

示例 2:打印 1~10 的偶数

for i in range(2, 11, 2):

print(i)

输出:

2

4

6

8

10

示例 3:倒序输出

for i in range(5, 0, -1):

print(i)

输出:

5

4

3

2

1

四 while 循环基础语法

while 循环通过 条件表达式 控制循环是否继续执行。

语法:

while 条件表达式:

代码块

只要条件为 True,循环就会持续执行;

直到条件变为 False 时,循环才结束。

示例:打印 1~5

i = 1

while i <= 5:

print(i)

i += 1

输出:

1

2

3

4

5

⚠️ 注意:

如果忘记更新变量(例如忘写i += 1),条件永远为真,会导致死循环。

五 for 与 while 的区别

| 对比项 | for 循环 | while 循环 |

|---|---|---|

| 适用场景 | 遍历序列、固定次数 | 条件控制、不确定次数 |

| 循环结束条件 | 自动遍历完毕 | 条件不再满足 |

| 是否需要手动更新变量 | 否 | 是 |

| 示例 | for i in range(5) | while i < 5 |

例子对比:

# for循环

for i in range(3):

print("Hello")

# while循环

i = 0

while i < 3:

print("Hello")

i += 1

两者输出相同。

六 break 与 continue

在循环中,有时我们需要提前结束循环或跳过某次执行。

Python 提供了两个控制语句:

1. break —— 立即结束循环

for i in range(1, 6):

if i == 3:

break

print(i)

输出:

1

2

当 i == 3 时,循环立刻结束。

2. continue —— 跳过当前循环,继续下一次

for i in range(1, 6):

if i == 3:

continue

print(i)

输出:

1

2

4

5

💡 小技巧:

break通常用于满足条件时提前退出;

continue用于过滤或跳过不需要处理的情况。

七 while True 无限循环

有时我们希望程序持续运行,直到用户主动终止。

可以使用 无限循环:

while True:

cmd = input("请输入命令(exit退出):")

if cmd == "exit":

print("程序结束")

break

print(f"你输入了:{cmd}")

输出示例:

请输入命令(exit退出):hello

你输入了:hello

请输入命令(exit退出):exit

程序结束

八 for...else / while...else 结构

Python 的循环可以带一个 else 子句,

当循环 正常结束(非 break 终止)时,会执行 else 代码块。

示例:

for i in range(5):

print(i)

else:

print("循环正常结束")

输出:

0

1

2

3

4

循环正常结束

但如果中途被 break 打断,else 不会执行:

for i in range(5):

if i == 3:

break

print(i)

else:

print("循环正常结束")

输出:

0

1

2

九 嵌套循环

循环中还可以嵌套另一个循环。

示例:打印乘法表

for i in range(1, 10):

for j in range(1, i + 1):

print(f"{j}×{i}={i*j}", end="\t")

print()

输出:

1×1=1

1×2=2 2×2=4

1×3=3 2×3=6 3×3=9

...

十 实战案例:猜数字游戏

import random

target = random.randint(1, 100)

count = 0

while True:

guess = int(input("请输入1~100之间的数字:"))

count += 1

if guess == target:

print(f"恭喜你猜对了!共尝试 {count} 次。")

break

elif guess < target:

print("太小了,再试试。")

else:

print("太大了,再试试。")

运行示例:

请输入1~100之间的数字:50

太小了,再试试。

请输入1~100之间的数字:75

太大了,再试试。

请输入1~100之间的数字:63

恭喜你猜对了!共尝试 3 次。

十一 小结

| 循环类型 | 控制方式 | 常见用途 |

|---|---|---|

for | 遍历序列 | 处理列表、字符串、range |

while | 条件控制 | 不确定次数的循环 |

break | 立即结束循环 | 提前退出 |

continue | 跳过当前循环 | 忽略某些情况 |

else | 正常结束时执行 | 检查是否提前退出 |

✅ 总结一句话

if 让程序做选择,for/while 让程序会重复。

掌握循环语句,意味着你可以自动化任何重复性的操作。

来源:juejin.cn/post/7564243873872969778

HTML <meta name="color-scheme">:自动适配系统深色 / 浅色模式

在移动互联网时代,用户对“深色模式”的需求日益增长——从手机系统到各类App,深色模式不仅能减少夜间用眼疲劳,还能节省OLED屏幕的电量。作为前端开发者,如何让网页自动跟随系统的深色/浅色模式切换?HTML5新增的<meta name="color-scheme">标签,就是实现这一功能的“开关”。它能告诉浏览器:“我的网页支持深色/浅色模式,请根据系统设置自动切换”,配合CSS变量,可轻松打造无缝适配的多主题体验。今天,我们就来解锁这个提升用户体验的实用标签。

一、认识 color-scheme:网页与系统主题的“沟通桥梁”

<meta name="color-scheme">的核心作用是声明网页支持的颜色方案,并让浏览器根据系统设置自动应用对应的基础样式。它解决了传统网页的一个痛点:当系统切换到深色模式时,网页若未做适配,会出现“白底黑字”与系统主题格格不入的情况,甚至导致某些原生控件(如输入框、按钮)样式混乱。

1.1 没有 color-scheme 时的问题

当网页未声明color-scheme时,即使系统切换到深色模式,浏览器也会默认使用浅色样式渲染页面:

- 背景为白色,文字为黑色。

- 原生控件(如

<input>、<select>)保持浅色外观,与系统深色主题冲突。 - 可能出现“闪屏”:页面加载时先显示浅色,再通过JS切换到深色,体验割裂。

1.2 加上 color-scheme 后的变化

添加<meta name="color-scheme" content="light dark">后,浏览器会:

- 根据系统设置自动切换网页的基础颜色(背景、文字、链接等)。

- 让原生控件(输入框、按钮等)自动适配系统主题(深色模式下显示深色样式)。

- 提前加载对应主题的样式,避免切换时的“闪屏”问题。

示例:最简单的主题适配

<!DOCTYPE html>

<html>

<head>

<!-- 声明支持浅色和深色模式 -->

<meta name="color-scheme" content="light dark">

<title>自动适配主题</title>

</head>

<body>

<h1>Hello, Color Scheme!</h1>

<input type="text" placeholder="输入内容">

</body>

</html>

- 当系统为浅色模式时:页面背景为白色,文字为黑色,输入框为浅色。

- 当系统为深色模式时:页面背景为深灰色,文字为白色,输入框为深色(与系统一致)。

无需一行CSS,仅通过<meta>标签就实现了基础的主题适配——这就是color-scheme的便捷之处。

二、核心用法:声明支持的颜色方案

<meta name="color-scheme">的用法非常简单,关键在于content属性的取值,它决定了网页支持的主题模式。

2.1 基础语法与取值

<!-- 支持浅色模式(默认) -->

<meta name="color-scheme" content="light">

<!-- 支持深色模式 -->

<meta name="color-scheme" content="dark">

<!-- 同时支持浅色和深色模式(推荐) -->

<meta name="color-scheme" content="light dark">

light:仅支持浅色模式,无论系统如何设置,网页都显示浅色样式。dark:仅支持深色模式,无论系统如何设置,网页都显示深色样式。light dark:同时支持两种模式,浏览器会根据系统设置自动切换(推荐使用)。

2.2 与浏览器默认样式的关系

浏览器会为不同的color-scheme提供一套默认的CSS变量(如color、background-color、link-color等)。当声明content="light dark"后,这些变量会随系统主题自动变化:

| 模式 | 背景色(默认) | 文字色(默认) | 链接色(默认) |

|---|---|---|---|

| 浅色 | #ffffff | #000000 | #0000ee |

| 深色 | #121212(不同浏览器可能略有差异) | #ffffff | #8ab4f8 |

这些默认样式确保了网页在未编写任何CSS的情况下,也能基本适配系统主题。

三、配合 CSS:打造自定义主题适配

<meta name="color-scheme">解决了基础适配问题,但实际开发中,我们需要自定义主题颜色(如品牌色、特殊背景等)。此时,可结合CSS的prefers-color-scheme媒体查询和CSS变量,实现更灵活的主题控制。

3.1 用 CSS 变量定义主题颜色

通过CSS变量(--变量名)定义不同主题下的颜色,再通过媒体查询切换变量值:

<head>

<meta name="color-scheme" content="light dark">

<style>

/* 定义浅色模式变量 */

:root {

--bg-color: #f5f5f5;

--text-color: #333333;

--primary-color: #4a90e2;

}

/* 深色模式变量(覆盖浅色模式) */

@media (prefers-color-scheme: dark) {

:root {

--bg-color: #1a1a1a;

--text-color: #f0f0f0;

--primary-color: #6ab0f3;

}

}

/* 使用变量 */

body {

background-color: var(--bg-color);

color: var(--text-color);

font-size: 16px;

}

a {

color: var(--primary-color);

}

</style>

</head>

:root中定义浅色模式的变量。@media (prefers-color-scheme: dark)中定义深色模式的变量(会覆盖浅色模式的同名变量)。- 页面元素通过

var(--变量名)使用颜色,实现主题自动切换。

3.2 覆盖浏览器默认样式

color-scheme会影响浏览器的默认样式(如背景、文字色),若需要完全自定义,可在CSS中显式覆盖:

/* 覆盖默认背景和文字色,确保自定义主题生效 */

body {

margin: 0;

background-color: var(--bg-color); /* 覆盖浏览器默认背景 */

color: var(--text-color); /* 覆盖浏览器默认文字色 */

}

即使不覆盖,浏览器的默认样式也会作为“保底”,确保页面在未完全适配时仍有基本可读性。

3.3 针对特定元素的主题适配

某些元素(如卡片、按钮)可能需要更细致的主题调整,可结合CSS变量单独设置:

/* 卡片组件的主题适配 */

.card {

background-color: var(--card-bg);

border: 1px solid var(--card-border);

padding: 1rem;

border-radius: 8px;

}

/* 浅色模式卡片 */

:root {

--card-bg: #ffffff;

--card-border: #e0e0e0;

}

/* 深色模式卡片 */

@media (prefers-color-scheme: dark) {

:root {

--card-bg: #2d2d2d;

--card-border: #444444;

}

}

四、实战场景:完整的主题适配方案

结合<meta name="color-scheme">、CSS变量和媒体查询,可构建一套完整的主题适配方案,覆盖大多数场景。

4.1 基础页面适配

<!DOCTYPE html>

<html lang="zh-CN">

<head>

<meta charset="UTF-8">

<!-- 声明支持深色/浅色模式 -->

<meta name="color-scheme" content="light dark">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>主题适配示例</title>

<style>

/* 共享样式(不受主题影响) */

* {

box-sizing: border-box;

margin: 0;

padding: 0;

}

body {

min-height: 100vh;

padding: 2rem;

line-height: 1.6;

}

.container {

max-width: 800px;

margin: 0 auto;

}

/* 浅色模式变量 */

:root {

--bg: #ffffff;

--text: #333333;

--link: #2c5282;

--card-bg: #f8f9fa;

--card-shadow: 0 2px 4px rgba(0,0,0,0.1);

}

/* 深色模式变量 */

@media (prefers-color-scheme: dark) {

:root {

--bg: #121212;

--text: #e9ecef;

--link: #90cdf4;

--card-bg: #1e1e1e;

--card-shadow: 0 2px 4px rgba(0,0,0,0.3);

}

}

/* 应用变量 */

body {

background-color: var(--bg);

color: var(--text);

}

a {

color: var(--link);

text-decoration: none;

}

a:hover {

text-decoration: underline;

}

.card {

background-color: var(--card-bg);

box-shadow: var(--card-shadow);

padding: 1.5rem;

border-radius: 8px;

margin-bottom: 2rem;

}

</style>

</head>

<body>

<div class="container">

<h1>主题适配演示</h1>

<div class="card">

<h2>欢迎使用深色模式</h2>

<p>本页面会自动跟随系统的深色/浅色模式切换。</p>

<p>点击<a href="#">这个链接</a>查看颜色变化。</p>

</div>

<input type="text" placeholder="试试原生输入框">

</div>

</body>

</html>

- 系统浅色模式:页面背景为白色,卡片为浅灰色,输入框为浅色。

- 系统深色模式:页面背景为深灰色,卡片为深黑色,输入框自动变为深色,与系统风格统一。

4.2 图片的主题适配

图片(尤其是图标)也需要适配主题,可通过<picture>标签结合prefers-color-scheme实现:

<picture>

<!-- 深色模式显示白色图标 -->

<source srcset="logo-white.png" media="(prefers-color-scheme: dark)">

<!-- 浅色模式显示黑色图标(默认) -->

<img src="logo-black.png" alt="Logo">

</picture>

- 系统为深色模式时,加载

logo-white.png。 - 系统为浅色模式时,加载

logo-black.png。

4.3 强制主题切换(可选功能)

除了跟随系统,有时还需要提供手动切换主题的功能(如“夜间模式”按钮)。可通过JS结合CSS类实现:

<button id="theme-toggle">切换主题</button>

<script>

const toggle = document.getElementById('theme-toggle');

const html = document.documentElement;

// 检查本地存储的主题偏好

if (localStorage.theme === 'dark' ||

(!('theme' in localStorage) && window.matchMedia('(prefers-color-scheme: dark)').matches)) {

html.classList.add('dark');

} else {

html.classList.remove('dark');

}

// 切换主题

toggle.addEventListener('click', () => {

if (html.classList.contains('dark')) {

html.classList.remove('dark');

localStorage.theme = 'light';

} else {

html.classList.add('dark');

localStorage.theme = 'dark';

}

});

</script>

<style>

/* 基础变量(浅色) */

:root {

--bg: white;

--text: black;

}

/* 深色模式(通过类覆盖) */

:root.dark {

--bg: black;

--text: white;

}

/* 系统深色模式(优先级低于类,确保手动切换优先) */

@media (prefers-color-scheme: dark) {

:root:not(.dark) {

--bg: #121212;

--text: white;

}

}

body {

background: var(--bg);

color: var(--text);

}

</style>

- 手动切换主题时,通过添加/移除

dark类覆盖系统设置。 - 本地存储(

localStorage)记录用户偏好,刷新页面后保持一致。 - CSS中

@media查询的优先级低于类选择器,确保手动切换优先于系统设置。

五、避坑指南:使用 color-scheme 的注意事项

5.1 浏览器兼容性

color-scheme兼容所有现代浏览器,但存在以下细节差异:

- 完全支持:Chrome 81+、Firefox 96+、Safari 13+、Edge 81+。

- 部分支持:旧版浏览器(如Chrome 76-80)仅支持

content="light dark",但原生控件适配可能不完善。 - 不支持:IE全版本(需通过JS降级处理)。

对于不支持的浏览器,可通过JS检测系统主题并手动切换样式:

// 检测浏览器是否支持color-scheme

if (!CSS.supports('color-scheme: light dark')) {

// 手动检测系统主题

const isDark = window.matchMedia('(prefers-color-scheme: dark)').matches;

document.documentElement.classList.add(isDark ? 'dark' : 'light');

}

5.2 避免与自定义背景冲突

若网页设置了固定背景色(如body { background: #fff; }),color-scheme的默认背景切换会失效。此时需通过媒体查询手动适配:

/* 错误:固定背景色,深色模式下仍为白色 */

body {

background: #fff;

}

/* 正确:结合变量和媒体查询 */

body {

background: var(--bg);

}

:root { --bg: #fff; }

@media (prefers-color-scheme: dark) {

:root { --bg: #121212; }

}

5.3 原生控件的样式问题

color-scheme能自动适配原生控件(如<input>、<select>),但如果对控件进行了自定义样式,可能导致适配失效。解决方法:

- 尽量使用原生样式,或通过CSS变量让自定义样式跟随主题变化。

- 对关键控件(如输入框)添加主题适配:

/* 输入框的主题适配 */

input {

background: var(--input-bg);

color: var(--text);

border: 1px solid var(--border);

}

:root {

--input-bg: #fff;

--border: #ddd;

}

@media (prefers-color-scheme: dark) {

:root {

--input-bg: #333;

--border: #555;

}

}

5.4 主题切换时的“闪屏”问题

若CSS加载延迟,可能导致主题切换时出现“闪屏”(短暂显示错误主题)。优化建议:

- 将主题相关CSS内联到

<head>中,确保优先加载。 - 结合

<meta name="color-scheme">让浏览器提前准备主题样式。 - 对关键元素(如

body)设置opacity: 0,主题加载完成后再设置opacity: 1:

body {

opacity: 0;

transition: opacity 0.2s;

}

/* 主题加载完成后显示 */

body.theme-loaded {

opacity: 1;

}

// 页面加载完成后添加类,显示内容

window.addEventListener('load', () => {

document.body.classList.add('theme-loaded');

});

我将继续完善文章的总结部分,让读者对HTML 标签在自动适配系统深色/浅色模式方面的价值和应用有更完整的认识。

自动适配系统深色 / 浅色模式(总结完善)">

六、总结

<meta name="color-scheme">作为网页与系统主题的“沟通桥梁”,用极简的方式解决了基础的深色/浅色模式适配问题,其核心价值在于:

- 零JS适配:仅通过HTML标签就让网页跟随系统主题切换,降低了开发成本,尤其适合静态页面或轻量应用。

- 原生控件兼容:自动调整输入框、按钮等原生元素的样式,避免出现“浅色控件在深色背景上”的违和感。

- 性能优化:浏览器会提前加载对应主题的样式,减少主题切换时的“闪屏”和布局偏移(CLS)。

- 渐进式增强:作为基础适配方案,可与CSS变量、媒体查询结合,轻松扩展为支持手动切换的复杂主题系统。

在实际开发中,使用<meta name="color-scheme">的最佳实践是:

- 优先添加

<meta name="color-scheme" content="light dark">,确保基础适配。 - 通过CSS变量定义主题颜色,用

@media (prefers-color-scheme: dark)实现自定义样式。 - 对图片、图标等资源,使用

<picture>标签或CSS类进行主题适配。 - 可选:添加手动切换按钮,结合

localStorage记录用户偏好,覆盖系统设置。

随着用户对深色模式的接受度越来越高,主题适配已成为现代网页的基本要求。<meta name="color-scheme">作为这一需求的“入门级”解决方案,既能快速满足基础适配,又为后续扩展留足了空间。它的存在提醒我们:很多时候,简单的原生方案就能解决复杂的用户体验问题,关键在于发现并合理利用这些被低估的Web标准。

下次开发新页面时,不妨先加上这行标签——它可能不会让你的网页变得华丽,但会让用户在切换系统主题时,感受到那份恰到好处的贴心。

你在主题适配中遇到过哪些棘手问题?欢迎在评论区分享你的解决方案~

来源:juejin.cn/post/7540172742764593161

Compose 主题 MaterialTheme

1 简介

MeterialTheme 是Compose为实现Material Design 设计规范提供的核心组件,用于集中管理应用的视觉样式(颜色、字体、形状),确保应用的全局UI的一致性并支持动态主题切换。

- 关键词:

- 视觉样式,不只是颜色,还支持字体、形状

- 全局UI的一致性

- 支持动态配置

2 基础使用

已经在AndroidManifest中配置uiMode,意味着在切换深浅模式时,MainActivity不会自动重建且未重写onConfigurationChanged()

android:configChanges="uiMode"

2.1 效果展示 --- 省略

2.2 代码实现

- 创建Compose项目时自动生成代码 Theme

// 定义应用的主题函数

@Composable

fun TestTheme(

// 是否使用深色主题,默认根据系统设置决定

darkTheme: Boolean = isSystemInDarkTheme(),

// 是否使用动态颜色,Android 12+ 可用,默认为 false

dynamicColor: Boolean = false,

// 内容组件,使用 @Composable 函数类型

content: @Composable () -> Unit

) {

// 根据条件选择颜色方案

val colorScheme = when {

// 如果启用动态颜色且系统版本支持,则使用系统动态颜色方案

dynamicColor && Build.VERSION.SDK_INT >= Build.VERSION_CODES.S -> {

val context = LocalContext.current

if (darkTheme) dynamicDarkColorScheme(context) else dynamicLightColorScheme(context)

}

// 如果是深色主题,则使用深色颜色方案

darkTheme -> DarkColorScheme

// 否则使用浅色颜色方案

else -> LightColorScheme

}

// 应用 Material Design 3 主题

MaterialTheme(

// 设置颜色方案

colorScheme = colorScheme,

// 设置排版样式

typography = Typography,

// 设置内容组件

content = content

)

}

// 定义深色主题的颜色方案

private val DarkColorScheme = darkColorScheme(

// 主要颜色设置为蓝色

primary = Color(0xFF0000FF),

// 次要颜色使用预定义的紫色

secondary = PurpleGrey80,

// 第三颜色使用预定义的粉色

tertiary = Pink80,

// 表面颜色设置为白色

surface = Color(0xFFFFFFFF)

)

// 定义浅色主题的颜色方案

private val LightColorScheme = lightColorScheme(

// 主要颜色设置为深红色(猩红色)

primary = Color(0xFFDC143C),

// 次要颜色使用预定义的紫色

secondary = PurpleGrey40,

// 第三颜色使用预定义的粉色

tertiary = Pink40,

// 表面颜色设置为黑色

surface = Color(0xFF000000)

/* 其他可覆盖的默认颜色

background = Color(0xFFFFFBFE),

surface = Color(0xFFFFFBFE),

onPrimary = Color.White,

onSecondary = Color.White,

onTertiary = Color.White,

onBackground = Color(0xFF1C1B1F),

onSurface = Color(0xFF1C1B1F),

*/

)

- 界面中使用

//Activity中使用

class MainActivity : ComponentActivity() {

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

enableEdgeToEdge()

setContent {

TestTheme {

Scaffold(modifier = Modifier.fillMaxSize()) { innerPadding ->

Greeting1(

modifier = Modifier.padding(innerPadding)

)

}

}

}

}

}

@Composable

fun Greeting1(modifier: Modifier = Modifier) {

Box(

modifier = Modifier

.padding(start = 100.dp, top = 100.dp)

.size(100.dp, 100.dp)

.background(MaterialTheme.colorScheme.surface)

)

MyText()

MyText2()

}

@Composable

fun MyText() {

Text(

text = "Hello Android!",

modifier = Modifier

.padding(start = 100.dp, top = 250.dp)

.background(MaterialTheme.colorScheme.surface),

color = MaterialTheme.colorScheme.primary

)

}

@Composable

fun MyText2() {

Text(

text = "Hello Chery!",

modifier = Modifier

.padding(start = 300.dp, top = 250.dp)

.background(Color.Blue),

color = Color.White

)

}

2.3 代码分析

2.3.1 参数解析

- darkTheme 主题模式

默认就深/浅两种模式,那么可以直接使用系统默认isSystemInDarkTheme()值,如果项目存在其它类型的主题模式就需要自定义了(之前参与的项目中--金色模式)。

isSystemInDarkTheme()是一个有返回值的可组合函数。

a、前面在说可组合函数特性时,其中一个特性是“可组合函数无返回值”,其实更准确的说应该是“用于直接描述 UI 的可组合函数无返回值(返回

Unit),但用于提供数据或计算结果的可组合函数可以有返回值”。

b、isSystemInDarkTheme() 是连接 “系统主题状态” 与 “应用 UI 主题” 的桥梁,它虽不是可观察状态,但依赖于 Compose 内部可观察的 LocalConfiguration。当系统主题模式切换时,LocalConfiguration 发生变化,导致 isSystemInDarkTheme() 返回值更新,进而驱动依赖它的 TestTheme() 重组,实现应用 UI 主题的更新。

//系统源码

@Composable

@ReadOnlyComposable

internal actual fun _isSystemInDarkTheme(): Boolean {

val uiMode = LocalConfiguration.current.uiMode

return (uiMode and Configuration.UI_MODE_NIGHT_MASK) == Configuration.UI_MODE_NIGHT_YES

}

- dynamicColor 系统色

Android 12 + 后可使用,从代码上可以清楚的看到,当false时根据系统模式使用DarkColorScheme/LightColorScheme,当true时根据系统模式使用dynamicDarkColorScheme/dynamicLightColorScheme。

(DarkColorScheme、LightColorScheme、dynamicDarkColorScheme、dynamicLightColorScheme都Compose提供的ColorScheme模板,都可以更加我们项目自定义定制)

// 根据条件选择颜色方案

val colorScheme = when {

// 如果启用动态颜色且系统版本支持,则使用系统动态颜色方案

dynamicColor && Build.VERSION.SDK_INT >= Build.VERSION_CODES.S -> {

val context = LocalContext.current

if (darkTheme) dynamicDarkColorScheme(context) else dynamicLightColorScheme(context)

}

// 如果是深色主题,则使用深色颜色方案

darkTheme -> DarkColorScheme

// 否则使用浅色颜色方案

else -> LightColorScheme

}

- content 可组合函数

描述UI的可组合函数(即 布局)

2.3.2 保证正确性,无依赖可组合函数连带重组

添加日志打印,可以看出MyText2()不依赖MaterialTheme颜色,在之前跳过重组的时候也说过“可组合函数参数不发生变化时会跳过重组”,但在切换系统模式时为了保证正确性,Compose对无依赖可组合函数连带重组。这是Compose框架在全局状态变化时优先保证UI正确性的设计选中

//初始化

D Greeting1,-----start----

D MyText,---start---

D MyText,---end---

D MyText2,---start---

D MyText2,---end---

D Greeting1,-----end----

//切换系统模式

D Greeting1,-----start----

D MyText,---start---

D MyText,---end---

D MyText2,---start---

D MyText2,---end---

D Greeting1,-----end----

2.3.3 字体与形状

这里主要对颜色进行了分析,对于另外字体、形状也是一样,Compose也提供对应的入参和模板,不过实际开发中很少使用到,就简单介绍一下。(如果HMI侧对所有项目的标题、内容严格遵守一套标准,那么我们也可以实现字体、形状的平台化)

//系统源码

@Composable

fun MaterialTheme(

// 颜色

colorScheme: ColorScheme = MaterialTheme.colorScheme,

// 形状

shapes: Shapes = MaterialTheme.shapes,

//字体

typography: Typography = MaterialTheme.typography,

//可组合函数(即布局)

content: @Composable () -> Unit

) {}

形状:

@Immutable

class Shapes(

// 超小尺寸控件的圆角形状,适用于紧凑的小型元素(如小标签、 Chips、小型图标按钮等)

val extraSmall: CornerBasedShape = ShapeDefaults.ExtraSmall,

// 小尺寸控件的圆角形状,适用于常规小型交互元素(如按钮、小型卡片、输入框等)

val small: CornerBasedShape = ShapeDefaults.Small,

// 中等尺寸控件的圆角形状,适用于中型容器元素(如标准卡片、弹窗、列表项等)

val medium: CornerBasedShape = ShapeDefaults.Medium,

// 大尺寸控件的圆角形状,适用于大型容器元素(如页面级卡片、对话框、底部弹窗等)

val large: CornerBasedShape = ShapeDefaults.Large,

// 超大尺寸控件的圆角形状,适用于全屏级容器元素(如全屏弹窗、侧边栏、页面容器等)

val extraLarge: CornerBasedShape = ShapeDefaults.ExtraLarge,

) {}

字体:

@Immutable

class Typography(

// 超大标题样式,用于页面级核心标题(如应用首页主标题),视觉层级最高,通常字数极少

val displayLarge: TextStyle = TypographyTokens.DisplayLarge,

// 大标题样式,用于重要区块的主标题(如长页面中的章节标题),层级次于 displayLarge

val displayMedium: TextStyle = TypographyTokens.DisplayMedium,

// 中标题样式,用于次要区块的主标题(如大型模块的标题),层级次于 displayMedium

val displaySmall: TextStyle = TypographyTokens.DisplaySmall,

// 大标题样式,用于突出显示的内容标题(如卡片组的总标题),视觉重量略低于 display 系列

val headlineLarge: TextStyle = TypographyTokens.HeadlineLarge,

// 中标题样式,用于中等重要性的内容标题(如列表组标题),层级次于 headlineLarge

val headlineMedium: TextStyle = TypographyTokens.HeadlineMedium,

// 小标题样式,用于次要内容的标题(如小模块标题),层级次于 headlineMedium

val headlineSmall: TextStyle = TypographyTokens.HeadlineSmall,

// 大标题样式,用于核心交互元素的标题(如卡片标题、弹窗标题),强调内容的可交互性

val titleLarge: TextStyle = TypographyTokens.TitleLarge,

// 中标题样式,用于中等交互元素的标题(如列表项标题、按钮组标题)

val titleMedium: TextStyle = TypographyTokens.TitleMedium,

// 小标题样式,用于次要交互元素的标题(如标签标题、小型控件标题)

val titleSmall: TextStyle = TypographyTokens.TitleSmall,

// 大正文样式,用于主要内容的长文本(如文章正文、详情描述),可读性优先

val bodyLarge: TextStyle = TypographyTokens.BodyLarge,

// 中正文样式,用于常规内容文本(如列表项描述、说明文字),最常用的正文样式

val bodyMedium: TextStyle = TypographyTokens.BodyMedium,

// 小正文样式,用于辅助性内容文本(如补充说明、注释),层级低于主要正文

val bodySmall: TextStyle = TypographyTokens.BodySmall,

// 大标签样式,用于重要标签或按钮文本(如主要按钮文字、状态标签)

val labelLarge: TextStyle = TypographyTokens.LabelLarge,

// 中标签样式,用于常规标签文本(如次要按钮文字、分类标签)

val labelMedium: TextStyle = TypographyTokens.LabelMedium,

// 小标签样式,用于辅助性标签文本(如小按钮文字、提示标签)

val labelSmall: TextStyle = TypographyTokens.LabelSmall,

) {}

3 核心亮点

3.1 高效性、实时性

MaterialTheme 基于Compose"状态驱动机制",支持系统模式和系统色(Android 12+)动态切换,且无需重建界面或遍历View树,以最小成本实时自动切换效果。

3.2 集中性

MaterialTheme 通过 colorScheme(配色)、typography(字体)、shapes(形状) 三个核心维度,将应用的视觉样式集中管理,避免了传统 XML 中样式分散在多个资源文件(colors.xml、styles.xml 等)的碎片化问题。

3.3 灵活性、扩展性

MaterialTheme 并非固定样式模板,而是可高度定制的框架,满足不同场景下的各种需求:- 自定义主题扩展 除了默认colorScheme(配色)、typography(字体)、shapes(形状),还可通过CompositionLocal 扩展自定义主题属性。(下面会举例)- 多主题共存

假设在同一页面中存在两个Text,A Text跟随系统主题,B Text跟随自定义主题 。那么通过嵌套的方式局部的覆盖。(建议使用CompositionLocal 扩展实现,代码集中性和可读性更好。)

MaterialTheme(colorScheme = GlobalColors) {

// 全局主题

Column {

MaterialTheme(colorScheme = SpecialColors) {

Text("局部特殊主题文本") // 使用 SpecialColors

}

Text("全局主题文本") // 使用 GlobalColors

}

}

4 MaterialTheme 扩展使用

上面我们已经介绍了MaterialTheme 提供的颜色、形状、字体模板,模板的目的满足全局绝大部分需求,但在实际开发中我们还存在切换系统模式/系统色时图片资源的变化,以及要求某些组件要求始终如一。

那么我们就需要通过compositionLocalOf/staticCompositionLocalOf 和 扩展自定义主题属性了。

4.1 效果展示

- Image 随系统模式变化使用不同图片资源

- Text 背景和文字不跟随系统模式变化

4.2 定义 CompositionLocal实例

- compositionLocalOf,创建一个可变的CompositionLocal实例,值发生变化时触发依赖组件重组。

- staticCompositionLocalOf,创建一个不可变的 CompositionLocal实例,值发生变化时触发整个子树重组。

- 值变化,是指对象引用(单纯的btnBackgroundColor/btnTitleColor 变化不会导致重组)

- 整个子树重组,在使用staticCompositionLocalOf的CompositionLocalProvider内部的Content都会重组,且不会跳过重组。(如下示例是直接在Activity中使用,那么整个界面上的组件都会发生重组)

// 定义扩展主题

@Stable

class ExtendScheme(

btnBackgroundColor: Color,

btnTitleColor: Color

) {

/** 按钮背景颜色 */

var btnBackgroundColor by mutableStateOf(btnBackgroundColor)

internal set

/** 按钮标题颜色 */

var btnTitleColor by mutableStateOf(btnTitleColor)

internal set

}

// 扩展主题 --浅色

private val LightExtendScheme = ExtendScheme(

btnBackgroundColor = Color(0xFFF00FFF),

btnTitleColor = Color(0xFFFFFFFF),

)

// 扩展主题 --深色

private val DarkExtendScheme = ExtendScheme(

btnBackgroundColor = Color(0xFFF00FFF),

btnTitleColor = Color(0xFFFFFFFF),

)

// 定义一个存储 ExtendScheme 类型的CompositionLocal,默认值是浅色主题

val LocalExtendScheme = compositionLocalOf {

LightExtendScheme

}

// 定义主题资源

@Stable

class ResScheme(

imageRes: Int,

) {

var imageRes by mutableIntStateOf(imageRes)

}

// 图片资源--浅色

private val LightResScheme = ResScheme(

imageRes = R.drawable.ic_navi_home_light,

)

// 图片资源--深色

private val DarkResScheme = ResScheme(

imageRes = R.drawable.ic_navi_home_drak,

)

// 定义一个存储 ResScheme 类型的CompositionLocal,默认值是浅色资源

val LocalResScheme = compositionLocalOf {

LightResScheme

}

4.3 CompositionLocalProvider 提供数据

CompositionLocalProvider是Compose中用于在Compoasable(可组合函数)树中传递数据的核心组件,允许你在某个层级定义“局部全局变量”,让其所有子组件(无论嵌套多深)都可以便捷访问,解决了:

- 传统父组件 -> 子组件 ->孙组件这种层层传递的方式。

- 有点类似于静态变量,但相对于静态变量的全局性和唯一性,CompositionLocalProvider作用范围仅限于其内部的所有子组件,所以可以理解为“局部全局变量”

// 定义应用的主题函数

@Composable

fun TestTheme(

// 是否使用深色主题,默认根据系统设置决定

darkTheme: Boolean = isSystemInDarkTheme(),

// 是否使用动态颜色,Android 12+ 可用,默认为 false

dynamicColor: Boolean = false,

// 内容组件,使用 @Composable 函数类型

content: @Composable () -> Unit

) {

// 。。。。。 省略前面的

// 定义扩展主题

val extendScheme = if (darkTheme) {

DarkExtendScheme

} else {

LightExtendScheme

}

// 定义图片资源

val resScheme = if (darkTheme) {

DarkResScheme

} else {

LightResScheme

}

// 应用 Material Design 3 主题

MaterialTheme(

// 设置颜色方案

colorScheme = colorScheme,

// 设置排版样式

typography = Typography,

// 设置内容组件

content = {

// 提供LocalExtendScheme 和 LocalResScheme 数据,内部所有组件都可以访问

CompositionLocalProvider(

LocalExtendScheme provides extendScheme,

LocalResScheme provides resScheme

) {

content()

}

}

)

}

4.4 使用

在Theme中根据需求配置完成后,无需再关心后续的系统模式/系统色变化了。

@Composable

fun Greeting1(modifier: Modifier = Modifier) {

Image(

modifier = Modifier

.padding(start = 300.dp, top = 100.dp)

.size(200.dp, 200.dp)

.background(Color.Gray),

// 使用图片资源

painter = painterResource(LocalResScheme.current.imageRes),

contentDescription = null,

)

Text(

text = "Hello Android!",

modifier = Modifier

.padding(start = 200.dp, top = 500.dp)

.size(300.dp, 200.dp)

//使用扩展颜色

.background(LocalExtendScheme.current.btnBackgroundColor),

color = LocalExtendScheme.current.btnTitleColor

)

}

5 参考资料

- 基础组件、布局组件使用

来源:juejin.cn/post/7559469775732981779

学习webhook与coze实现ai code review

AI代码审查工具

github github.com/zhangjiadi2…

测试可使用内网穿透工具将本地服务暴露到公网, 然后配置对应webhook. 日志目前只保留发送请求的message以及ai审查报告 .

ai建议使用coze, 直接使用gpt相关接口, 暂时每次都得携带大量文本 .

项目概述

这是一个基于Node.js开发的智能代码审查工具(demo)

核心特性

🚀 多AI服务支持

- 硅基流动AI: 基于深度学习的代码分析引擎

- Coze智能体: 专业的代码审查AI助手

- 动态切换: 支持运行时切换不同的AI服务

🔗 无缝集成

- GitHub Webhook: 自动监听代码推送事件

- 实时处理: 提交后立即触发审查流程

- 零配置部署: 简单的环境变量配置即可运行

📊 智能分析

- 代码质量评估: 全面分析代码结构、性能和安全性

- 最佳实践建议: 基于行业标准提供改进建议

- 多语言支持: 支持JavaScript、Python、Java等主流编程语言

💾 结果持久化

- 本地存储: 审查结果自动保存为结构化文本文件

- 历史追踪: 完整的审查历史记录

- 便于查阅: 清晰的文件命名和内容格式

技术架构

系统架构图

GitHub Repository

↓ (Webhook)

Express Server

↓

Webhook Handler

↓

GitHub Service ←→ AI Service Factory

↓ ↓

Diff Analysis [SiliconFlow | Coze]

↓ ↓

File Storage ←── Review Results

核心组件

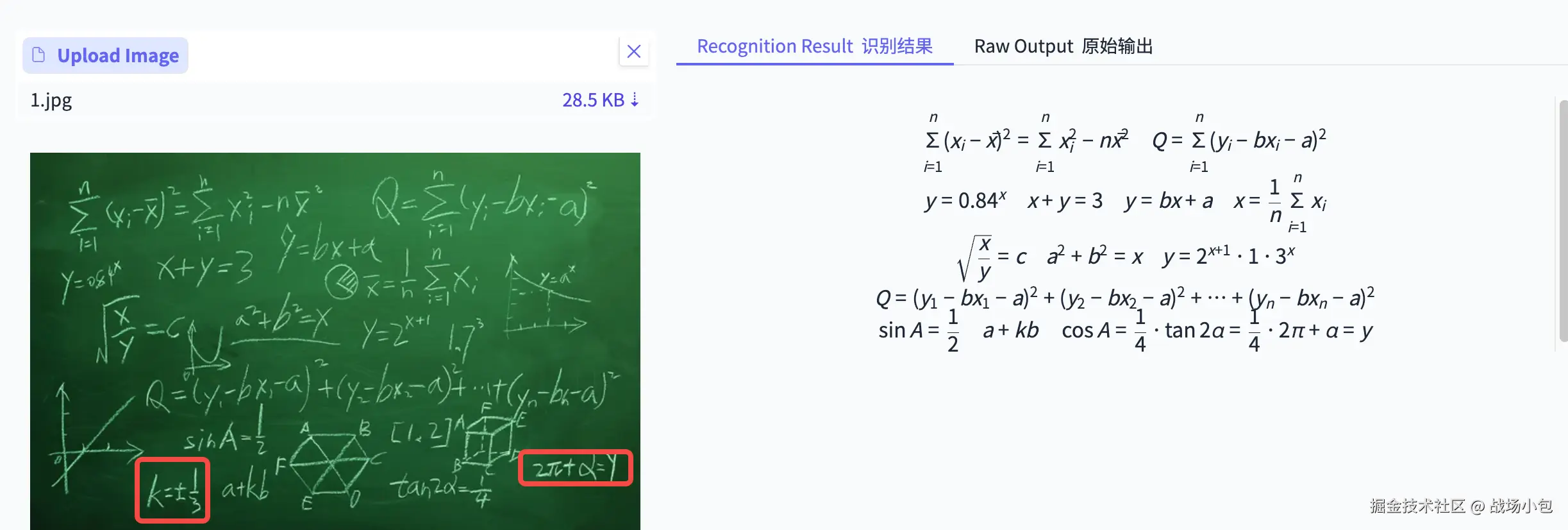

1. Web服务层 (src/index.js)

- 基于Express.js的HTTP服务器

- 提供健康检查、日志查看等管理接口

- 优雅的错误处理和请求日志

2. Webhook处理器 (src/routes/webhook.js)

- GitHub事件监听和处理

- 提交数据解析和验证

- 异步任务调度

3. GitHub服务 (src/services/github.js)

- GitHub API集成

- 代码差异获取

- 智能文件过滤(仅处理代码文件)

4. AI服务工厂 (src/services/ai/)

- 基础抽象类 (

base.js): 定义AI服务通用接口 - 硅基流动服务 (

siliconflow.js): 集成硅基流动AI API - Coze服务 (

coze.js): 集成Coze智能体平台 - 服务工厂 (

index.js): 动态服务选择和管理

工作流程

1. 代码提交触发

sequenceDiagram

Developer->>GitHub: git push

GitHub->>AI Review Tool: Webhook Event

AI Review Tool->>GitHub API: Get Commit Diff

GitHub API-->>AI Review Tool: Return Diff Data

2. AI分析处理

sequenceDiagram

AI Review Tool->>AI Service: Send Code Diff

AI Service->>AI Provider: API Request

AI Provider-->>AI Service: Analysis Result

AI Service-->>AI Review Tool: Formatted Review

3. 结果存储

sequenceDiagram

AI Review Tool->>File System: Save Review

AI Review Tool->>Logs: Record Process

AI Review Tool-->>GitHub: Response OK

安装与配置

环境要求

- Node.js 14.0+

- npm 6.0+

快速开始

- 克隆项目

git clone

cd ai-code-review

- 安装依赖

npm install

- 环境配置

cp .env.example .env

# 编辑.env文件,配置必要的API密钥

- 启动服务

# 开发模式

npm run dev

# 生产模式

npm start

配置说明

基础配置

# 服务端口

PORT=3000

# 环境类型

NODE_ENV=development

GitHub集成

# GitHub访问令牌(可选,用于私有仓库)

GITHUB_TOKEN_AI=your_github_token

AI服务配置

# 当前使用的AI服务类型

AI_SERVICE_TYPE=coze

# 硅基流动AI配置

SILICONFLOW_API_KEY=your_siliconflow_key

SILICONFLOW_MODEL=deepseek-chat

# Coze智能体配置

COZE_API_URL=https://api.coze.cn/v3/chat

COZE_API_KEY=your_coze_key

COZE_BOT_ID=your_bot_id

使用指南

GitHub Webhook配置

- 进入GitHub仓库设置页面

- 选择"Webhooks" → "Add webhook"

- 配置参数:

- Payload URL:

http://your-domain.com/webhook/github - Content type:

application/json - Events: 选择"Just the push event"

- Payload URL:

- 保存配置

审查结果查看

审查结果自动保存在reviews/目录下,文件命名格式:

review_[service]_[commit_id]_[timestamp].txt

示例文件内容:

代码审查报告 (coze)

==========================================

提交ID: abc123def456

提交信息: 修复用户登录bug

作者: 张三

审查时间: 2024-01-01T10:00:00.000Z

详细建议:

------------------------------------------

1. 安全性建议:

- 建议在密码验证前添加输入验证

- 考虑使用bcrypt进行密码哈希

2. 性能优化:

- 数据库查询可以添加索引优化

- 建议使用连接池管理数据库连接

3. 代码规范:

- 变量命名建议使用驼峰命名法

- 建议添加必要的错误处理

项目结构

ai-code-review/

├── src/ # 源代码目录

│ ├── index.js # 应用入口文件

│ ├── routes/ # 路由处理

│ │ ├── webhook.js # Webhook事件处理

│ │ ├── debug.js # 调试接口

│ │ └── logs.js # 日志查看接口

│ ├── services/ # 核心服务

│ │ ├── ai/ # AI服务模块

│ │ │ ├── base.js # AI服务基类

│ │ │ ├── index.js # 服务工厂

│ │ │ ├── siliconflow.js # 硅基流动AI服务

│ │ │ └── coze.js # Coze智能体服务

│ │ ├── github.js # GitHub API服务

│ │ └── logger.js # 日志服务

│ ├── middleware/ # 中间件(预留)

│ ├── utils/ # 工具函数(预留)

│ └── public/ # 静态资源

├── reviews/ # 审查结果存储

├── messages/ # AI请求消息存储

├── logs/ # 系统日志

├── test/ # 测试文件

├── package.json # 项目配置

├── .env # 环境变量

└── README.md # 项目说明

开发特性

代码质量保障

- ESLint: 代码风格检查

- 错误处理: 完善的异常捕获机制

- 日志系统: 详细的操作日志记录

扩展性设计

- 插件化架构: 易于添加新的AI服务

- 配置驱动: 通过环境变量灵活配置

- 模块化设计: 清晰的代码组织结构

性能优化

- 异步处理: 非阻塞的事件处理

- 智能过滤: 仅处理代码文件,忽略配置和资源文件

- 错误恢复: 优雅的错误处理,避免服务中断

最佳实践

安全建议

- 使用HTTPS部署生产环境

- 定期轮换API密钥

- 限制GitHub Token权限范围

- 配置防火墙规则

性能优化

- 定期清理历史文件

- 监控API调用频率

- 配置适当的超时时间

- 使用负载均衡(高并发场景)

来源:juejin.cn/post/7530106539467669544

从“写循环”到“写思想”:Java Stream 流的高级实战与底层原理剖析

引言

在实际开发中,很多工程师依然停留在“用 for 循环遍历集合”的思维模式。但在大型项目、复杂业务中,这种写法往往显得冗余、难以扩展,也不符合函数式编程的趋势。

Stream API 的出现,不只是“简化集合遍历”,而是把 声明式编程思想 带入了 Java,使我们能以一种更优雅、更高效、更可扩展的方式处理集合与数据流。

如果你还把 Stream 仅仅理解为 list.stream().map(...).collect(...),那就大错特错了。本文将从 高级用法、底层原理、业务实践、性能优化 四个维度,带你重新认识 Stream —— 让它真正成为你架构设计和代码表达的利器。

一、为什么要用 Stream?

在真实业务场景中,Stream 的价值不仅仅体现在“更少的代码量”,而在于:

- 声明式语义 —— 写“我要做什么”,而不是“怎么做”。

// 传统方式

List<String> result = new ArrayList<>();

for (User u : users) {

if (u.getAge() > 18) {

result.add(u.getName());

}

}

// Stream 写法:表达意图更清晰

List<String> result = users.stream()

.filter(u -> u.getAge() > 18)

.map(User::getName)

.toList();

后者的代码阅读体验更接近“业务规则”,而非“算法步骤”。

- 可扩展性 —— 同样的链式调用,可以无缝切换到 并行流(parallelStream)以提升性能,而无需修改核心逻辑。

- 契合函数式编程趋势 —— 在 Java 8 引入 Lambda 后,Stream 彻底释放了函数式编程的潜力。

二、Stream 的核心思想

Stream API 的设计核心可以用一句话概括:

把数据操作抽象成流水线,每一步都是一个中间操作,最终由终止操作触发执行。

- 数据源(Source) :集合、数组、I/O、生成器等。

- 中间操作(Intermediate Operations) :

filter、map、flatMap、distinct、sorted…,返回一个新的 Stream(惰性求值)。 - 终止操作(Terminal Operations) :

collect、forEach、reduce、count…,触发实际计算。

关键点:Stream 是惰性的。中间操作不会立即执行,直到遇到终止操作才会真正运行。

三、高级用法与最佳实践

1. 多级分组与统计

真实业务中,常见的场景是“按条件分组统计”。

// 按部门分组,并统计每个部门的人数

Map<String, Long> groupByDept = employees.stream()

.collect(Collectors.groupingBy(Employee::getDepartment, Collectors.counting()));

// 多级分组:按部门 -> 按职位

Map<String, Map<String, List<Employee>>> group = employees.stream()

.collect(Collectors.groupingBy(Employee::getDepartment,

Collectors.groupingBy(Employee::getTitle)));

2. flatMap 的威力

flatMap 可以把多层集合打平成单层流。

// 一个学生对应多个课程,如何获取所有课程的去重列表?

List<String> courses = students.stream()

.map(Student::getCourses) // Stream<List<String>>

.flatMap(List::stream) // Stream<String>

.distinct()

.toList();

3. reduce 高阶聚合

Stream 的 reduce 方法提供了更灵活的聚合方式。

// 求所有订单的总金额

BigDecimal total = orders.stream()

.map(Order::getAmount)

.reduce(BigDecimal.ZERO, BigDecimal::add);

相比 Collectors.summingInt 等方法,reduce 更加灵活,适合需要自定义聚合逻辑的场景。

4. 结合 Optional 优雅处理空值

Stream 与 Optional 配合,可以消除 if-null 的丑陋写法。

// 找到第一个满足条件的用户

Optional<User> user = users.stream()

.filter(u -> u.getAge() > 30)

.findFirst();

与传统的 null 判断相比,这种写法更安全、更符合函数式语义。

5. 并行流与 ForkJoinPool

只需一行代码,就能让 Stream 自动并行处理

long count = bigList.parallelStream()

.filter(item -> isValid(item))

.count();

注意点:

- 并行流基于 ForkJoinPool,默认线程数 = CPU 核心数。

- 不适合小数据量,启动线程开销可能大于收益。

- 不适合有共享资源的场景(容易产生锁竞争)。

四、Stream 的底层原理

理解底层机制,才能在性能和架构上做出正确决策。

- 流水线模型(Pipeline Model)

- 每个中间操作都返回一个

Stream,但实际上内部是一个Pipeline。 - 只有终止操作才会触发数据逐步流经整个 pipeline。

- 每个中间操作都返回一个

- 内部迭代(Internal Iteration)

- 相比外部迭代(for 循环),Stream 将迭代逻辑交给框架本身,从而更容易做优化(如并行)。

- 短路操作(Short-circuiting)

anyMatch、findFirst等操作可以在满足条件时立刻返回,避免不必要的计算。

- 内存与性能

- 惰性求值减少不必要的计算。

- 但过度链式调用可能带来额外开销(对象创建、函数调用栈)。

五、业务场景中的最佳实践

1. 日志分析系统

日志按时间、级别分组统计:

Map<LogLevel, Long> logCount = logs.stream()

.filter(log -> log.getTimestamp().isAfter(start))

.collect(Collectors.groupingBy(Log::getLevel, Collectors.counting()));

2. 电商系统订单处理

对订单进行聚合,计算 GMV(成交总额):

BigDecimal gmv = orders.stream()

.filter(o -> o.getStatus() == OrderStatus.FINISHED)

.map(Order::getAmount)

.reduce(BigDecimal.ZERO, BigDecimal::add);

3. 权限系统多对多关系处理

用户-角色-权限的映射去重:

Set<String> permissions = users.stream()

.map(User::getRoles)

.flatMap(List::stream)

.map(Role::getPermissions)

.flatMap(List::stream)

.collect(Collectors.toSet());

六、性能优化与陷阱

- 避免在 Stream 中修改外部变量

List<String> result = new ArrayList<>();

list.stream().forEach(e -> result.add(e)); //违反函数式编程

应该用 collect。

- 适度使用并行流

- 小集合别用并行流。

- 线程池可通过

ForkJoinPool.commonPool()自定义。

- 避免链式调用过长

虽然优雅,但可读性会下降,必要时拆分。 - Stream 不是万能的

- 对于简单循环,普通 for 循环更直观。

- 对性能敏感的底层操作(如数组拷贝),直接用原生循环更高效。

总结

Stream 并不是一个“语法糖”,而是 Java 向函数式编程迈进的重要里程碑。

它让我们能以声明式、可扩展、可并行的方式处理数据流,提升代码表达力和业务抽象能力。

对于中高级开发工程师来说,Stream 的价值在于:

- 提升业务逻辑的可读性和可维护性

- 利用底层并行能力提升性能

- 契合函数式思维,帮助团队写出更现代化的 Java 代码

未来的你,写业务逻辑时,应该少考虑“怎么遍历”,多去思考“我要表达的业务规则是什么”。

来源:juejin.cn/post/7538829865351036967

这样代码命名,总不会被同事蛐蛐了吧

1. 引言

....又好笑,又不耐烦,懒懒的答他道,“谁要你教,不是草头底下一个来回的回字么?”孔乙己显出极高兴的样子,将两个指头的长指甲敲着柜台,点头说,“对呀对呀!……回字有四样写法,你知道么?”我愈不耐烦了,努着嘴走远。孔乙己刚用指甲蘸了酒,想在柜上写字,见我毫不热心,便又叹一口气,显出极惋惜的样子

针对于同一个代码变量或者函数方法,张三可能认为可以叫 xxx,李四可能摇头说 不不不,得叫 yyyy ,好的命名让人如沐春风,原来是这个意思;坏的代码命名,同事可能会眉头紧锁,然后送你两斤熏鸡骨头让你炖汤

比如隔壁小组新来的一个同事,对字符串命名就用 s,对于布尔值的命名就用 b,然后他的主管说他的变量名起的跟他人一样。如何做到信雅达的命名,让同事不会再背后蛐蛐,我是这样想的。

2. 代码整洁之道

2.1 团队规范

“我在上家公司都是这样命名的,在这里我也要这样命名”

小组里张三给 Service 起的名字叫 UserService 实现类是 UserServiceImpl;小组里李四给 Service 起的名字叫 CustomerService 实现类 CustomerServiceImpl

你跳出来出来说,统统不对,接口需要区分对待 得叫 IUserService 和 ICustomerService

但是组里成员都不习惯往接口类加个 I;或许这就是 E 人编码吧,不能写 I(我承认这个梗有点烂)

双拳难敌四手,亲,这边建议你按照 UserService 和 CustomerService 起名

这只是个简单的例子,还有就是你认为 4 就是 for,2 就是 to,如果小组内的成员表示认可你的想法,那你就尽管大胆的使用,但是小组成员要是没有这一点习惯,建议还是老老实实 for 和 to,毕竟你没有一票否决权

诸如此类的还有 request -> req、response -> resp 等

以下所有的代码命名建议都不能打破团队规范这一条大原则

2.2 统一业务词汇

在各行各业中,基于业务属性,我们都有一些专业术语,对于专业术语的命名往往在设计领域模型的时候已经确定下来,建议有一份业务词汇来规范团队同学命名,或者以数据库字段为准

比如在保险行业中,我们有保费(premium)、保单(policy)、被保人(assured)等,针对于这些业务词汇,务必需要统一。被保人就是 assured 不是 Insured Person

2.2 名副其实

“语义一定要清晰,不然后续接手的人根本看不懂,我的这个函数名是用来对订单进行删除操作,然后进行 MQ 消息推送的,我准备给他起名为 deleteOrderByCustomerIdAndSendMqMessage”

对,函数名很长很清晰,虽然我的屏幕很宽,但是针对于这样的命名,我觉得不可取,函数名和函数一样应该尽量短小,当你的命名极其长的时候你需要考虑简化你的命名,或者 考虑你的函数是否遵循到了单一职责。

bad😭

deleteOrderByCustomerIdAndSendMqMessage(String userId)

good🤭

deleteOrder(String userId)

sendMq()

我们在做阅读理解的时候,需要结合上下文来作答,同样,我们的命名需要让下一个做阅读理解的人感受到我们的上下文含义。在我们删除订单的时候,假设我们需要用到订单的 ID,那么我们的命名需要是 orderId = 123,而不是 id = 123

bad😭 这个 id 指代的是什么,订单ID 还是用户 ID

id = 123

good🤭

deleteOrder(String userId)

orderId = 123

人靠衣装马靠鞍,变量类型需“平安”,我们在起名的时候需要对的起自己的名字

bad😭 tm的喵,我以为是个 list

String idList = "1,2,3"

good🤭

List<String> idList = ImmutabList.of("1", "2", "3")

默认我的同事的英文水平只有四级,我们变量命名的时候,尽量取一些大众化的词汇,可以四级词汇,切莫六级词汇

bad😭

actiivityOrchestrater

good🤭 活动策划人

actiivityPlanner

普通函数、方法命名以动词开头

bad😭

messageSend

good🤭

sendMessage

减少介词链接,考虑使用 形容词+名词

productListForSpecialOffer -> specialOfferProductList

productListForNewArrival -> newArrivalProductList

productListFromHenan -> henanProductList

productListWithGiftBox -> withGiftBoxProductList \ giftBoxedProductList

productListWithoutGiftBox -> withoutGiftBoxProductList \ noGiftBoxProductList \ unGiftBoxedProductList

消除无意义的前后缀单词: userInfo、userData,info 和 data 的含义过于宽泛,没有实质性意义所以我们可以不用写。或者诸如在 UserService 类中,我们可以可以尝试将 selectUserList 更换为 selectList,因为我们调用的时候,上下文一定是 userService.selectList,阅读者是可以感受到我们的语义的

userInfo -> user

userService.selectUserList -> userService.selectList

做有意义的方法名的区分:在我刚入职的时候,有一个 OrderService 中,存在 4个方法,enableOrder、enableOrderV2、enableOrderV3、enableOrderV4,我问组里的同事,有什么区别,他们告诉我,现在各个外部服务用的不同,不知道有啥区别。所以为了避免给类似我这样的菜鸟产生歧义,建议在方法起名的时候做好区分,以免埋坑

3. 常见开发词汇

来源:juejin.cn/post/7449083760618684467

通信的三种基本模式:单工、半双工与全双工