Browser.js:轻松模拟浏览器环境

什么是Browser.js

Browser.js是一个小巧而强大的JavaScript库,它模拟浏览器环境,使得原本只能在浏览器中运行的代码能够在Node.js环境中执行。这意味着你可以在服务器端运行前端代码,而不需要依赖真实浏览器

Browser.js的核心原理

Browser.js通过实现与浏览器兼容的API(如window、document、navigator等)来创建一个近似真实的浏览器上下文。它还支持fetch API用于网络请求,支持Promise,使得异步操作更加方便

Browser.js的用途

Browser.js主要用于以下场景:

- 服务器端测试:在服务端运行前端单元测试,无需依赖真实浏览器,从而提高测试效率

// 示例:使用Browser.js进行服务器端测试

const browser = require('browser.js');

const window = browser.window;

const document = browser.document;

// 在Node.js中模拟浏览器环境

console.log(window.location.href);

- 构建工具:编译或预处理只能在浏览器运行的库,例如基于DOM的操作,如CSS处理器或模板引擎

// 示例:使用Browser.js处理CSS

const browser = require('browser.js');

const document = browser.document;

// 创建一个CSS样式表

const style = document.createElement('style');

style.textContent = 'body { background-color: #f2f2f2; }';

document.head.appendChild(style);

- 离线应用:将部分业务逻辑放在客户端和服务端之外,在本地环境中执行1。

// 示例:使用Browser.js在本地环境中执行业务逻辑

const browser = require('browser.js');

const window = browser.window;

// 在本地环境中执行JavaScript代码

window.alert('Hello, World!');

- 自动化脚本:对网页进行自动化操作,如爬虫、数据提取等,而不必依赖真实浏览器1。

// 示例:使用Browser.js进行网页爬虫

const browser = require('browser.js');

const fetch = browser.fetch;

// 发送HTTP请求获取网页内容

fetch('https://example.com')

.then(response => response.text())

.then(html => console.log(html));

解决的问题

Browser.js解决了以下问题:

- 跨环境执行:使得原本只能在浏览器中运行的JavaScript代码能够在Node.js环境中执行,扩展了JavaScript的应用边界

- 兼容性问题:通过模拟浏览器环境,减少了不同浏览器之间的兼容性问题,提高了代码的可移植性

- 测试效率:提高了前端代码在服务端的测试效率,减少了对真实浏览器的依赖

Browser.js的特点

- 轻量级:体积小,引入方便,不会过多影响项目整体性能

- 兼容性:模拟的浏览器环境高度兼容Web标准,能够运行大部分浏览器代码

- 易用性:提供简单直观的API接口,快速上手

- 可扩展:支持自定义插件,可以根据需求扩展功能

- 无依赖:不依赖其他大型库或框架,降低项目复杂度

来源:juejin.cn/post/7486845198485585935

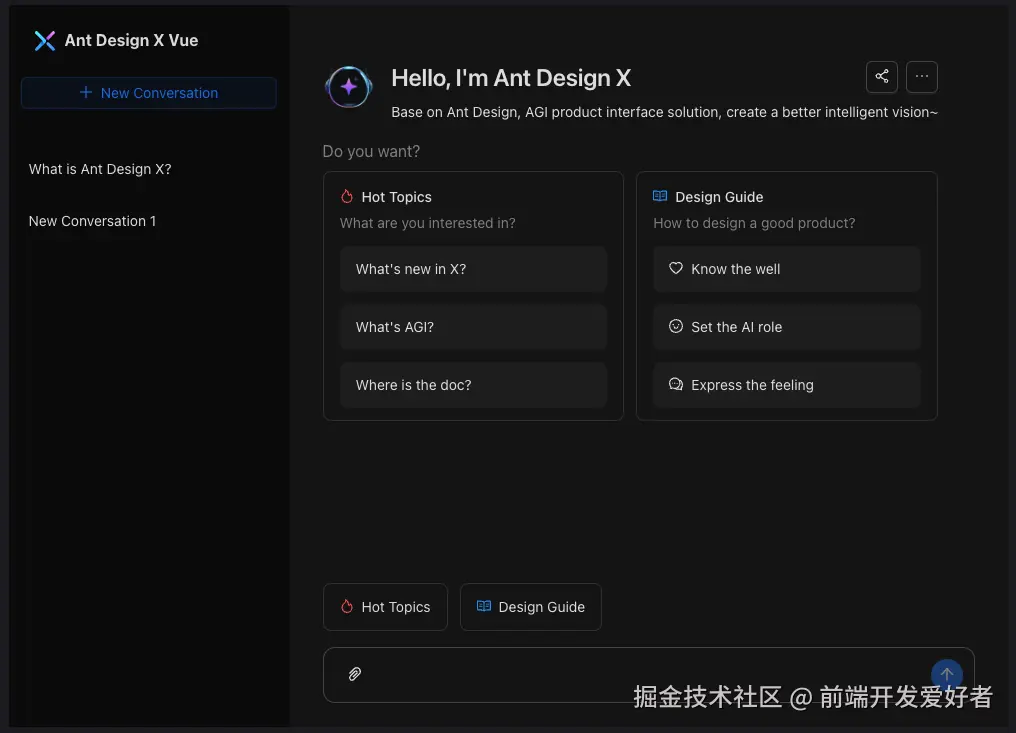

Vue 首个 AI 组件库发布!

人工智能(AI)已深度融入我们的生活,如今 Vue 框架也迎来了首个 AI 组件库 —— Ant Design X Vue,为开发者提供了强大的 AI 开发工具。

Ant Design X Vue 概述

Ant Design X Vue 是基于 Vue.js 的 AI 组件库,旨在简化 AI 集成开发。

它包含高度定制化的 AI 组件和 API 解决方案,支持无缝接入 AI 服务,是构建智能应用的理想选择。

组件库亮点

丰富多样的 AI 组件

通用组件:

- Bubble:显示会话消息气泡,支持多种布局。

- Conversations:管理多个会话,查看历史记录。

唤醒组件:

- Welcome:会话加载时插入欢迎语。

- Prompts:展示上下文相关的问题或建议。

表达组件:

- Sender:构建会话输入框,支持自定义样式。

- Attachments:展示和管理附件信息。

- Suggestion:提供快捷输入提示。

确认组件:

- ThoughtChain:展示 AI 的思维过程或结果。

工具组件:

- useXAgent:对接 AI 模型推理服务。

- useXChat:管理 AI 对话应用的数据流。

- XStream:处理数据流,支持流式传输。

- XRequest:向 AI 服务发起请求。

- XProvider:全局化配置管理。

RICH 设计范式

基于 RICH 设计范式,提供丰富、沉浸式、连贯和人性化的交互体验,适应不同 AI 场景。

AGI 混合界面(Hybrid-UI)

融合 GUI 和自然会话交互,用户可在同一应用中自由切换交互方式,提升体验。

适用场景

- 智能聊天应用:构建多轮对话界面,支持复杂会话逻辑。

- 企业级 AI 系统:快速搭建智能客服、知识管理等系统。

如何使用 Ant Design X Vue

安装与引入

npm install ant-design-x-vue --save

引入组件库及样式:

import Vue from 'vue';

import Antd from 'ant-design-x-vue';

import 'ant-design-x-vue/dist/antd.css';

Vue.use(Antd);

使用组件

示例:使用 Bubble 组件展示对话气泡

<template>

<div>

<a-bubble content="欢迎使用 Ant Design X Vue!" />

</div>

</template>

官方文档与示例

访问 Ant Design X Vue 官方文档:https://antd-design-x-vue.netlify.app/ 获取更多信息。

Ant Design X Vue 为 Vue 开发者提供了强大的 AI 组件库,助力高效构建智能应用。

无论是聊天应用还是企业级系统,都值得一试。

最后

如果觉得本文对你有帮助,希望能够给我点赞支持一下哦 💪 也可以关注wx公众号:

前端开发爱好者回复加群,一起学习前端技能 公众号内包含很多实战精选资源教程,欢迎关注

来源:juejin.cn/post/7475978280841543716

如何限制一个账号只能在一处登录

如何限制一个账号只能在一处登录

要实现账号单点登录(一处登录限制),需结合 会话管理、实时状态同步 和 冲突处理机制。以下是完整技术方案:

一、核心实现方案

- 服务端会话控制(推荐)

// 用户登录时生成唯一令牌并记录

public String login(String username, String password) {

// 1. 验证账号密码

User user = userService.authenticate(username, password);

// 2. 生成新令牌并失效旧会话

String newToken = UUID.randomUUID().toString();

redis.del("user:" + user.getId() + ":token"); // 清除旧token

redis.setex("user:" + user.getId() + ":token", 3600, newToken);

// 3. 返回新令牌

return newToken;

}

- WebSocket实时踢出(增强体验)

// 前端建立长连接

const socket = new WebSocket(`wss://api.example.com/ws?token=${token}`);

socket.onmessage = (event) => {

if (event.data === 'force_logout') {

alert('您的账号在其他设备登录');

location.href = '/logout';

}

};

- 登录设备指纹识别

// 生成设备指纹(前端)

function generateDeviceFingerprint() {

const canvas = document.createElement('canvas');

const ctx = canvas.getContext('2d');

ctx.textBaseline = 'top';

ctx.font = "14px Arial";

ctx.fillText("BrowserFingerprint", 2, 2);

return canvas.toDataURL().hashCode(); // 简化示例

}

// 服务端校验

if (storedFingerprint != currentFingerprint) {

forceLogout(storedToken);

}

要实现账号单点登录(一处登录限制),需结合 会话管理、实时状态同步 和 冲突处理机制。以下是完整技术方案:

一、核心实现方案

- 服务端会话控制(推荐)

// 用户登录时生成唯一令牌并记录

public String login(String username, String password) {

// 1. 验证账号密码

User user = userService.authenticate(username, password);

// 2. 生成新令牌并失效旧会话

String newToken = UUID.randomUUID().toString();

redis.del("user:" + user.getId() + ":token"); // 清除旧token

redis.setex("user:" + user.getId() + ":token", 3600, newToken);

// 3. 返回新令牌

return newToken;

}

- WebSocket实时踢出(增强体验)

// 前端建立长连接

const socket = new WebSocket(`wss://api.example.com/ws?token=${token}`);

socket.onmessage = (event) => {

if (event.data === 'force_logout') {

alert('您的账号在其他设备登录');

location.href = '/logout';

}

};

// 生成设备指纹(前端)

function generateDeviceFingerprint() {

const canvas = document.createElement('canvas');

const ctx = canvas.getContext('2d');

ctx.textBaseline = 'top';

ctx.font = "14px Arial";

ctx.fillText("BrowserFingerprint", 2, 2);

return canvas.toDataURL().hashCode(); // 简化示例

}

// 服务端校验

if (storedFingerprint != currentFingerprint) {

forceLogout(storedToken);

}

二、多端适配策略

| 客户端类型 | 实现方案 |

|---|---|

| Web浏览器 | JWT令牌 + Redis黑名单 |

| 移动端APP | 设备ID绑定 + FCM/iMessage推送踢出 |

| 桌面应用 | 硬件指纹 + 本地令牌失效检测 |

| 微信小程序 | UnionID绑定 + 服务端订阅消息 |

三、关键代码实现

- JWT令牌增强方案

// 生成带设备信息的JWT

public String generateToken(User user, String deviceId) {

return Jwts.builder()

.setSubject(user.getId())

.claim("device", deviceId) // 绑定设备

.setExpiration(new Date(System.currentTimeMillis() + 3600000))

.signWith(SignatureAlgorithm.HS512, secret)

.compact();

}

// 校验令牌时检查设备

public boolean validateToken(String token, String currentDevice) {

Claims claims = Jwts.parser().setSigningKey(secret).parseClaimsJws(token).getBody();

return claims.get("device").equals(currentDevice);

}

- Redis实时状态管理

# 使用Redis Hash存储登录状态

def login(user_id, token, device_info):

# 删除该用户所有活跃会话

r.delete(f"user_sessions:{user_id}")

# 记录新会话

r.hset(f"user_sessions:{user_id}",

mapping={

"token": token,

"device": device_info,

"last_active": datetime.now()

})

r.expire(f"user_sessions:{user_id}", 3600)

# 中间件校验

def check_token(request):

user_id = get_user_id_from_token(request.token)

stored_token = r.hget(f"user_sessions:{user_id}", "token")

if stored_token != request.token:

raise ForceLogoutError()

四、异常处理机制

| 场景 | 处理方案 |

|---|---|

| 网络延迟冲突 | 采用CAS(Compare-And-Swap)原子操作更新令牌 |

| 令牌被盗用 | 触发二次验证(短信/邮箱验证码) |

| 多设备同时登录 | 后登录者优先,前会话立即失效(可配置为保留第一个登录) |

五、性能与安全优化

- 会话同步优化:

# Redis Pub/Sub 跨节点同步

PUBLISH user:123 "LOGOUT"

- 安全增强:

// 前端敏感操作二次确认

function sensitiveOperation() {

if (loginTime < lastServerCheckTime) {

showReauthModal();

}

}

- 监控看板:

指标 报警阈值 并发登录冲突率 >5%/分钟 强制踢出成功率 <99%

六、行业实践参考

- 金融级方案:

- 每次操作都验证设备指纹

- 异地登录需视频人工审核

- 社交应用方案:

- 允许最多3个设备在线

- 分设备类型控制(手机+PC+平板)

- ERP系统方案:

- 绑定特定MAC地址

- VPN网络白名单限制

通过以上方案可实现:

- 严格模式:后登录者踢出前会话(适合银行系统)

- 宽松模式:多设备在线但通知告警(适合社交应用)

- 混合模式:关键操作时强制单设备(适合电商系统)

部署建议:

- 根据业务需求选择合适严格度

- 关键系统增加异地登录二次验证

- 用户界面明确显示登录设备列表

来源:juejin.cn/post/7485384798569250868

前端如何彻底解决重复请求问题

背景

- 保存按钮点击多次,造成新增多个单据

- 列表页疯狂刷新,导致服务器压力大

如何彻底解决

方案:我的思路从请求层面判断相同请求只发送一次,将结果派发给各个订阅者

实现思路

- 对请求进行数据进行hash

- 添加store 存储 hash => Array promise

- 相同请求,直接订阅对应的promise

- 请求取消,则将store中对应的promise置为null

- 请求返回后,调用所有未取消的订阅

核心代码

private handleFinish(key: string, index: number) {

const promises = this.store.get(key);

// 只有一个promise时则删除store

if (promises?.filter((item) => item).length === 1) {

this.store.delete(key);

} else if (promises && promises[index]) {

// 还有其他请求,则将当前取消的、或者完成的置为null

promises[index] = null;

}

}

private async handleRequest(config: any) {

const hash = sha256.create();

hash.update(

JSON.stringify({

params: config.params,

data: config.data,

url: config.url,

method: config.method,

}),

);

const fetchKey = hash.hex().slice(0, 40);

const promises = this.store.get(fetchKey);

const index = promises?.length || 0;

let promise = promises?.find((item) => item);

const controller = new AbortController();

if (config.signal) {

config.signal.onabort = (reason: any) => {

const _promises = this.store.get(fetchKey)?.filter((item) => item);

if (_promises?.length === 1) {

controller.abort(reason);

this.handleFinish(fetchKey, index);

}

};

}

if (!promise) {

promise = this.instance({

...config,

signal: controller.signal,

headers: {

...config.headers,

fetchKey,

},

}).catch((error) => {

console.log(error, "请求错误");

// 失败的话,立即删除,可以重试

this.handleFinish(fetchKey, index);

return { error };

});

}

const newPromise = Promise.resolve(promise)

.then((result: any) => {

if (config.signal?.aborted) {

this.handleFinish(fetchKey, index);

return result;

}

return result;

})

.finally(() => {

setTimeout(() => {

this.handleFinish(fetchKey, index);

}, 500);

});

this.store.set(fetchKey, [...(promises || []), newPromise]);

return newPromise;

}

以下为完整代码(仅供参考)

index.ts

import axios, { AxiosInstance, AxiosRequestConfig, AxiosResponse } from "axios";

import { sha256 } from "js-sha256";

import transformResponseValue, { updateObjTimeToUtc } from "./utils";

type ErrorInfo = {

message: string;

status?: number;

traceId?: string;

version?: number;

};

type MyAxiosOptions = AxiosRequestConfig & {

goLogin: (type?: string) => void;

onerror: (info: ErrorInfo) => void;

getHeader: () => any;

};

export type MyRequestConfigs = AxiosRequestConfig & {

// 是否直接返回服务端返回的数据,默认false, 只返回 data

useOriginData?: boolean;

// 触发立即更新

flushApiHook?: boolean;

ifHandleError?: boolean;

};

type RequestResult<T, U> = U extends { useOriginData: true }

? T

: T extends { data?: infer D }

? D

: never;

class LmAxios {

private instance: AxiosInstance;

private store: Map<string, Array<Promise<any> | null>>;

private options: MyAxiosOptions;

constructor(options: MyAxiosOptions) {

this.instance = axios.create(options);

this.options = options;

this.store = new Map();

this.interceptorRequest();

this.interceptorResponse();

}

// 统一处理为utcTime

private interceptorRequest() {

this.instance.interceptors.request.use(

(config) => {

if (config.params) {

config.params = updateObjTimeToUtc(config.params);

}

if (config.data) {

config.data = updateObjTimeToUtc(config.data);

}

return config;

},

(error) => {

console.log("intercept request error", error);

Promise.reject(error);

},

);

}

// 统一处理为utcTime

private interceptorResponse() {

this.instance.interceptors.response.use(

(response): any => {

// 对响应数据做处理,以下根据实际数据结构改动!!...

const [checked, errorInfo] = this.checkStatus(response);

if (!checked) {

return Promise.reject(errorInfo);

}

const disposition =

response.headers["content-disposition"] ||

response.headers["Content-Disposition"];

// 文件处理

if (disposition && disposition.indexOf("attachment") !== -1) {

const filenameReg =

/filename\*?=['"]?(?:UTF-\d['"]*)?([^;\r\n"']*)['"]?;?/g;

const filenames: string[] = [];

disposition.replace(filenameReg, (r: any, r1: string) => {

filenames.push(decodeURIComponent(r1));

});

return Promise.resolve({

filename: filenames[filenames.length - 1],

data: response.data,

});

}

if (response) {

return Promise.resolve(response.data);

}

},

(error) => {

console.log("request error", error);

if (error.message.indexOf("timeout") !== -1) {

return Promise.reject({

message: "请求超时",

});

}

const [checked, errorInfo] = this.checkStatus(error.response);

return Promise.reject(errorInfo);

},

);

}

private checkStatus(

response: AxiosResponse<any>,

): [boolean] | [boolean, ErrorInfo] {

const { code, message = "" } = response?.data || {};

const { headers, status } = response || {};

if (!status) {

return [false];

}

// 单地登录判断,弹出不同提示

if (status === 401) {

this.options?.goLogin();

return [false];

}

if (code === "ECONNABORTED" && message?.indexOf("timeout") !== -1) {

return [

false,

{

message: "请求超时",

},

];

}

if ([108, 109, 401].includes(code)) {

this.options.goLogin();

return [false];

}

if ((code >= 200 && code < 300) || code === 304) {

// 如果http状态码正常,则直接返回数据

return [true];

}

if (!code && ((status >= 200 && status < 300) || status === 304)) {

return [true];

}

let errorInfo = "";

const _code = code || status;

switch (_code) {

case -1:

errorInfo = "远程服务响应失败,请稍后重试";

break;

case 400:

errorInfo = "400: 错误请求";

break;

case 401:

errorInfo = "401: 访问令牌无效或已过期";

break;

case 403:

errorInfo = message || "403: 拒绝访问";

break;

case 404:

errorInfo = "404: 资源不存在";

break;

case 405:

errorInfo = "405: 请求方法未允许";

break;

case 408:

errorInfo = "408: 请求超时";

break;

case 500:

errorInfo = message || "500: 访问服务失败";

break;

case 501:

errorInfo = "501: 未实现";

break;

case 502:

errorInfo = "502: 无效网关";

break;

case 503:

errorInfo = "503: 服务不可用";

break;

default:

errorInfo = "连接错误";

}

return [

false,

{

message: errorInfo,

status: _code,

traceId: response?.data?.requestId,

version: response.data.ver,

},

];

}

private handleFinish(key: string, index: number) {

const promises = this.store.get(key);

if (promises?.filter((item) => item).length === 1) {

this.store.delete(key);

} else if (promises && promises[index]) {

promises[index] = null;

}

}

private async handleRequest(config: any) {

const hash = sha256.create();

hash.update(

JSON.stringify({

params: config.params,

data: config.data,

url: config.url,

method: config.method,

}),

);

const fetchKey = hash.hex().slice(0, 40);

const promises = this.store.get(fetchKey);

const index = promises?.length || 0;

let promise = promises?.find((item) => item);

const controller = new AbortController();

if (config.signal) {

config.signal.onabort = (reason: any) => {

const _promises = this.store.get(fetchKey)?.filter((item) => item);

if (_promises?.length === 1) {

controller.abort(reason);

this.handleFinish(fetchKey, index);

}

};

}

if (!promise) {

promise = this.instance({

...config,

signal: controller.signal,

headers: {

...config.headers,

fetchKey,

},

}).catch((error) => {

console.log(error, "请求错误");

// 失败的话,立即删除,可以重试

this.handleFinish(fetchKey, index);

return { error };

});

}

const newPromise = Promise.resolve(promise)

.then((result: any) => {

if (config.signal?.aborted) {

this.handleFinish(fetchKey, index);

return result;

}

return result;

})

.finally(() => {

setTimeout(() => {

this.handleFinish(fetchKey, index);

}, 500);

});

this.store.set(fetchKey, [...(promises || []), newPromise]);

return newPromise;

}

// add override type

public async request<T = unknown, U extends MyRequestConfigs = {}>(

url: string,

config: U,

): Promise<RequestResult<T, U> | null> {

// todo

const options = {

url,

// 是否统一处理接口失败(提示)

ifHandleError: true,

...config,

headers: {

...this.options.getHeader(),

...config?.headers,

},

};

const res = await this.handleRequest(options);

if (!res) {

return null;

}

if (res.error) {

if (res.error.message && options.ifHandleError) {

this.options.onerror(res.error);

}

throw new Error(res.error);

}

if (config.useOriginData) {

return res;

}

if (config.headers?.feTraceId) {

window.dispatchEvent(

new CustomEvent<{ flush?: boolean }>(config.headers.feTraceId, {

detail: {

flush: config?.flushApiHook,

},

}),

);

}

// 默认返回res.data

return transformResponseValue(res.data)

}

}

export type MyRequest = <T = unknown, U extends MyRequestConfigs = {}>(

url: string,

config: U,

) => Promise<RequestResult<T, U> | null>;

export default LmAxios;

utils.ts(这里主要用来处理utc时间,你可能用不到删除相关代码就好)

import moment from 'moment';

const timeReg =

/^\d{4}([/:-])(1[0-2]|0?[1-9])\1(0?[1-9]|[1-2]\d|30|31)($|( |T)(?:[01]\d|2[0-3])(:[0-5]\d)?(:[0-5]\d)?(\..*\d)?Z?$)/;

export function formatTimeValue(time: string, format = 'YYYY-MM-DD HH:mm:ss') {

if (typeof time === 'string' || typeof time === 'number') {

if (timeReg.test(time)) {

return moment(time).format(format);

}

}

return time;

}

// 统一转化如参

export const updateObjTimeToUtc = (obj: any) => {

if (typeof obj === 'string') {

if (timeReg.test(obj)) {

return moment(obj).utc().format();

}

return obj;

}

if (toString.call(obj) === '[object Object]') {

const newObj: Record<string, any> = {};

Object.keys(obj).forEach((key) => {

newObj[key] = updateObjTimeToUtc(obj[key]);

});

return newObj;

}

if (toString.call(obj) === '[object Array]') {

obj = obj.map((item: any) => updateObjTimeToUtc(item));

}

return obj;

};

const utcReg = /^\d{4}-\d{2}-\d{2}T\d{2}:\d{2}:\d{2}.*Z$/;

const transformResponseValue = (res: any) => {

if (!res) {

return res;

}

if (typeof res === 'string') {

if (utcReg.test(res)) {

return moment(res).format('YYYY-MM-DD HH:mm:ss');

}

return res;

}

if (toString.call(res) === '[object Object]') {

const result: any = {};

Object.keys(res).forEach((key) => {

result[key] = transformResponseValue(res[key]);

});

return result;

}

if (toString.call(res) === '[object Array]') {

return res.map((item: any) => transformResponseValue(item));

}

return res;

};

export default transformResponseValue;

来源:juejin.cn/post/7484202915390718004

[译]为什么我选择用Tauri来替代Electron

原文地址:Why I chose Tauri instead of Electron

以下为正文。

关于我为什么在Tauri上创建Aptakube的故事,我与Electron的斗争以及它们之间的简短比较。

大约一年前,我决定尝试构建一个桌面应用程序。

我对自己开发的小众应用并不满意,我想我可以开发出更好的应用。我作为全栈开发人员工作了很长时间,但我以前从未构建过桌面应用程序。

我的第一个想法是用 SwiftUI 来构建。开发者喜欢原生应用,我也一直想学习 Swift。然而,在 SwiftUI 上构建会将我的受众限制为 macOS 用户。虽然我有一种感觉,大多数用户无论如何都会使用 macOS,但当我可以构建跨平台应用程序时,为什么要限制自己呢?

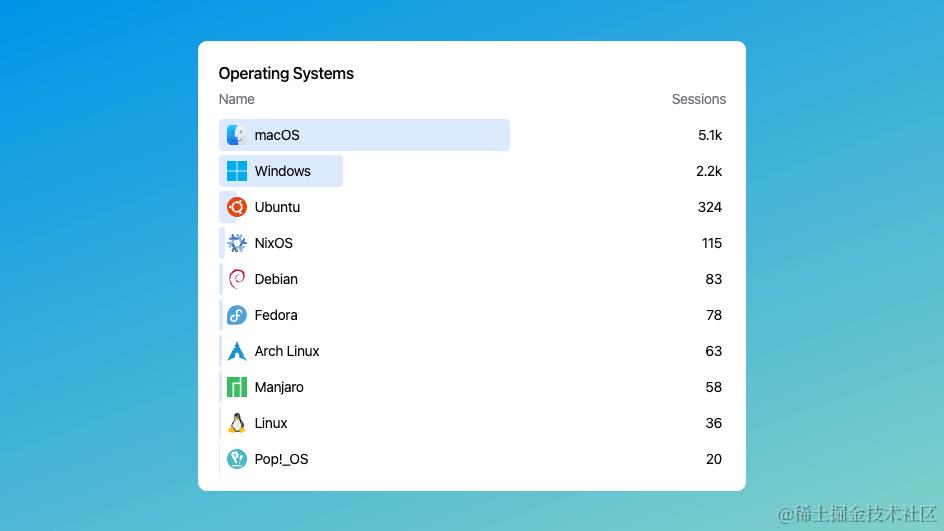

现在回想起来,我真的很庆幸当初放弃了 SwiftUI。看看人们在不同的操作系统上使用我的应用就知道了。

Windows和Linux代表了超过35%的用户。这相当于放弃了35%的收入。

那么 Electron 怎么样呢?

我不是与世隔绝的人,所以我知道 Electron 是个好东西,我每天使用的很多流行应用都是基于 Electron 开发的,包括我现在用来写这篇文章的编辑器。它似乎非常适合我想做的事情,因为:

- 单个代码库可以针对多个平台。

- 支持 React + TypeScript + Tailwind 配合使用,每个我都非常熟练。

- 非常受欢迎 = 很多资源和指南。

- NPM 是最大的(是吧?)软件包社区,这意味着我可以更快地发布。

在 Electron 上开发的另一个好处是,我可以专注于开发应用程序,而不是学习一些全新的东西。我喜欢学习新的语言和框架,但我想快速构建一些有用的东西。我仍然需要学习 Electron 本身,但它不会像学习 Swift 和 SwiftUI 那样困难。

好了,我们开始吧!

我决定了。Aptakube 将使用 Electron 来构建。

我通常不看文档。我知道我应该看,但我没有。不过,每当我第一次选择一个框架时,我总会阅读 “入门(Getting Started)” 部分。

流行的框架都有一个 npx create {framework-name},可以为我们快速一个应用程序。Next.js、Expo、Remix 和许多其他框架都有这样的功能。我发现这非常有用,因为它们可以让你快速上手,而且通常会给你提供很多选项,例如:

- 你想使用 TypeScript 还是 JavaScript?

- 你想使用 CSS 框架吗?那 Tailwind 呢?

- Prettier 和/或 ESLint?

- 你要这个还是那个?

这样的例子不胜枚举。这是一种很棒的开发体验,我希望每个框架都有一个。

我可以直接 npx create electron-app 吗?

显然,我不能,或者至少我还没有找到一种方法来做到这一点,除了在 Getting Started 里。

相反,我找到的是一个“快速启动(quick-start)”模板,我可以从 Git 上克隆下来,安装依赖项,然后就可以开始我的工作了。

然而,它不是 TypeScript,没有打包工具,没有 CSS 框架,没有检查,没有格式化,什么都没有。它只是一个简单的打开窗口的应用程序。

我开始用这个模板构建,并添加了所有我想让它使用的东西。我以为会很容易,但事实并非如此。

一个 electron 应用程序有三个入口点: main、preload(预加载),和render(渲染)。把所有这些和 Vite 连接起来是很痛苦的。我花了大约两周的空闲时间试图让所有东西都工作起来。我失败了,这让我很沮丧。

之后我为 Electron 找到了几十个其他的样板。我试了大约五个。有些还可以,但大多数模板都太固执己见了,而且安装了太多的依赖项,我甚至不知道它们是用来做什么的,这让我不太喜欢。有些甚至根本不工作,因为它们已经被遗弃多年了。

总之,对于刚接触 Electron 的人来说,开发体验低于平均水平。Next.js 和 Expo 将标准设置得如此之高,以至于我开始期待每个框架都能提供类似的体验。

那现在怎么办?

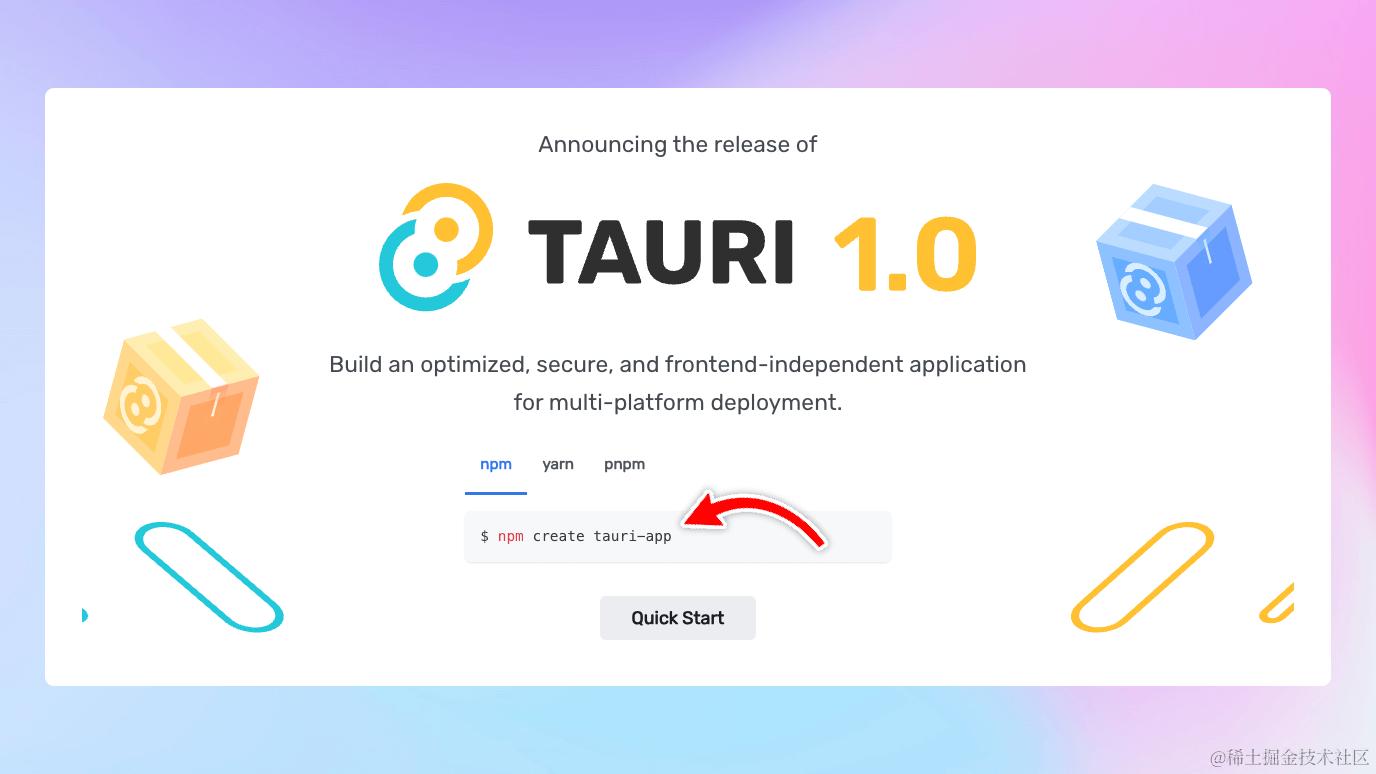

在漫无目的刷 Twitter 的时候,我看到了一条来自 Tauri 的有关 1.0 版本的推文。那时他们已经成立 2 年了,但我完全不知道 Tauri 是什么。我去看了他们的网站,我被震撼了 🤯 这似乎就是我正在寻找的东西。

你知道最棒的是什么吗?他们把一条 npm create tauri-app 命令放在了主页上。

Tauri 用

npx create Tauri -app命令从一开始就抓住了开发体验。

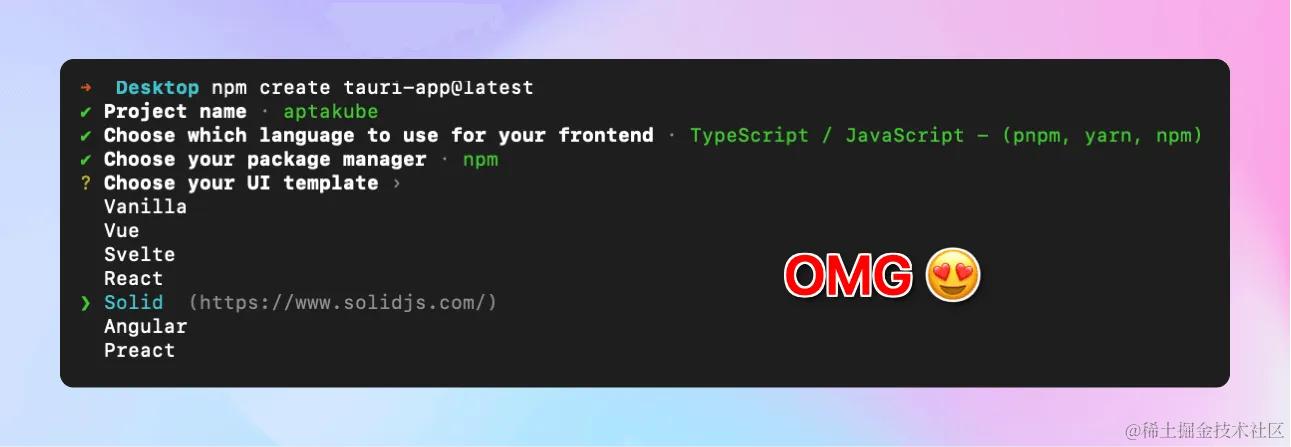

我决定尝试一下。我运行了 create the tauri-app 命令,体验与 Next.js 非常相似。它问了我几个问题,然后根据我的选择为我创建了一个新项目。

在这之后,我可以简单地运行 npm run dev,然后我就有了一个带有热加载、TypeScript、Vite 和 Solid.js 的可以运行的应用程序,几乎包含了我开始使用所需的一切。这让我印象深刻,并且很想了解更多。我仍然不得不添加 Prettier、Linters、Tailwind 等类似的东西,但我已经习惯了,而且它比 Electron 容易太多了。

开始(再一次😅),但与 Tauri 一起

虽然在 Electron 中,我可以只用 JavaScript/HTML/CSS 构建整个应用程序,但在 Tauri 中,后端是 Rust,只有前端是 JavaScript。这显然意味着我必须学习 Rust,这让我很兴奋,但也不想花太多时间,因为我想快速构建原型。

我在使用过 7 种以上专业的编程语言,所以我认为学习 Rust 是轻而易举的事。

我错了。我大错特错了。Rust 是很难的,真的很难,至少对我来说是这样!

一年后,在我的应用发布了 20 多个版本之后,我仍然不能说我真正了解 Rust。我知道要不断地定期发布新功能,但每次我必须用 Rust 写一些东西时,我仍然能学到很多新知识。GitHub Copilot 和 ChatGPT 帮了我大忙,我现在还经常使用它们。

像使用字符串这样简单的事情在Rust中要比在其他语言中复杂得多🤣

不过,Tauri 中有一些东西可以让这一过程变得简单许多。

Tauri 有一个“command 命令”的概念,它就像前端和后端之间的桥梁。你可以用 Rust 在你的 Tauri 后端定义“命令”,然后在 JavaScript 中调用它们。Tauri 本身提供了一系列可以开箱即用的命令。例如,你可以通过 JavaScript 打开一个文件选择器(file dialog),读取/更新/删除文件,发送 HTTP 请求,以及其他很多与操作系统进行的交互,而无需编写任何 Rust 代码。

那么,如果你需要做一些在 Tauri 中没有的事情呢?这就是“Plugins插件”的用武之地。插件是 Rust 库,它定义了你可以在 Tauri 应用中使用的命令。稍后我会详细介绍插件,但现在你只需将它们视为扩展 Tauri 功能的一种方式就可以了。

事实上,我已经询问了很多使用 Tauri 构建应用程序的人,问他们是否必须编写 Rust 代码来构建他们的应用程序。他们中的大多数表示,他们只需要为一些特定的使用情况编写非常少的 Rust 代码。完全可以在不编写任何 Rust 代码的情况下构建一个 Tauri 应用程序!

那么 Tauri 与 Electron 相比又如何呢?

1. 编程语言和社区

在 Electron 中,你的后端是一个 Node.js 进程,而前端是 Chromium,这意味着 Web 开发人员可以仅使用 JavaScript/HTML/CSS 来构建桌面应用程序。NPM 上有着庞大的库社区,并且在互联网上有大量与此相关的内容,这使得学习过程变得更加容易。

然而,尽管通常认为能够在后端和前端之间共享代码是一件好事,但也可能会导致混淆,因为开发人员可能会尝试在前端使用后端函数,反之亦然。因此,你必须小心不要混淆。

相比之下,Tauri 的后端是 Rust,前端也是一个 Webview(稍后会详细介绍)。虽然有大量的 Rust 库,但它们远远不及 NPM 的规模。Rust 社区也比 JavaScript 社区小得多,这意味着关于它的内容在互联网上较少。但正如上面提到的,取决于你要构建的内容,你甚至可能根本不需要编写太多的 Rust 代码。

我的观点: 我只是喜欢我们在 Tauri 中得到的明确的前后端的分离。如果我在 Rust 中编写一段代码,我知道它将作为一个操作系统进程运行,并且我可以访问网络、文件系统和许多其他内容,而我在 JavaScript 中编写的所有内容都保证在一个 Webview 上运行。学习 Rust 对我来说并不容易,但我很享受这个过程,而且总的来说我学到了很多新东西!Rust 开始在我心中生根了。😊

2. Webview

在 Electron 中,前端是一个与应用程序捆绑在一起的 Chromium Webview。这意味着无论操作系统如何,您都可以确定应用程序使用的 Node.js 和 Chromium 版本。这带来了重大的好处,但也有一些缺点。

最大的好处是开发和测试的便利性,您知道哪些功能可用,如果某些功能在 macOS 上可用,那么它很可能也可以在 Windows 和 Linux 上使用。然而,缺点是由于所有这些二进制文件捆绑在一起,您的应用程序大小会更大。

Tauri 采用了截然不同的方法。它不会将 Chromium 与您的应用程序捆绑在一起,而是使用操作系统的默认 Webview。这意味着在 macOS 上,您的应用程序将使用 WebKit(Safari 的引擎),在 Windows 上将使用 WebView2(基于 Chromium),在 Linux 上将使用WebKitGTK(与 Safari 相同)。

最终结果是一个感觉非常快速的极小型应用程序!

作为参考,我的 Tauri 应用程序在 macOS 上只有 24.7MB 大小,而我的竞争对手的应用程序(Electron)则达到了 1.3GB。

为什么这很重要?

- 下载和安装速度快得多。

- 主机和分发成本更低(我在 AWS 上运行,所以我需要支付带宽和存储费用)。

- 我经常被问到我的应用是否使用 Swift 构建,因为用户通常在看到如此小巧且快速的应用时会有一种“这感觉像是本地应用”的时候。

- 安全性由操作系统处理。如果 WebKit 存在安全问题,苹果将发布安全更新,我的应用将简单地使用它。我不必发布我的应用的更新版本来修复它。

我的观点: 我喜欢我的应用如此小巧且快速。起初,我担心操作系统之间缺乏一致性会导致我需要在所有 3 个操作系统上测试我的应用,但到目前为止我没有遇到任何问题。无论如何,Web开发人员已经习惯了这种情况,因为我们长期以来一直在构建多浏览器应用程序。打包工具和兼容性填充也在这方面提供了很大帮助!

3. 插件

我之前简要提到过这一点,但我认为它值得更详细地讨论,因为在我看来,这是 Tauri 最好的特性之一。插件是由 Rust 编写的一组命令集,可以从 JavaScript 中调用。它允许开发人员通过组合不同的插件来构建应用程序,这些插件可以是开源的,也可以在您的应用程序中定义。

这是一种很好的应用程序组织结构的方式,它也使得在不同应用程序之间共享代码变得容易!

在 Tauri 社区中,您会找到一些插件的示例:

- tauri-plugin-log - 可配置的日志记录。

- tauri-plugin-store - 存储用户偏好/设置。

- tauri-plugin-window-state - 保存窗口大小和位置。

- window-vibrancy - 使您的窗口生动起来。

- tauri-plugin-sql - 连接任何 SQL 数据库。

- tauri-plugin-aptabase - 用于 Tauri 应用程序的分析。

- 还有更多……

这些特性本来可能可以成为 Tauri 本身的一部分,但将它们单独分开意味着您可以挑选和选择您想要使用的功能。这也意味着它们可以独立演变,并且如果有更好的替代品发布,可以被替换。

插件系统是我选择 Tauri 的第二大原因;它让开发者的体验提升了 1000 倍!

4. 功能对比

就功能而言,Electron 和 Tauri 非常相似。Electron 仍然具有一些更多的功能,但 Tauri 正在迅速赶上。至少对于我的使用情况来说,Tauri 具有我所需要的一切。

唯一给我带来较大不便的是缺乏一个“本地上下文菜单”API。这是社区强烈要求的功能,它将使 Tauri 应用程序感觉更加本地化。我目前是用 JS/HTML/CSS 来实现这一点,虽然可以,但还有提升的空间。希望我们能在 Tauri 2 中看到这个功能的实现 🤞

但除此之外,Tauri 还有很多功能。开箱即用,您可以得到通知、状态栏、菜单、对话框、文件系统、网络、窗口管理、自动更新、打包、代码签名、GitHub actions、辅助组件等。如果您需要其他功能,您可以编写一个插件,或者使用现有的插件之一。

5. 移动端

这个消息让我感到惊讶。在我撰写这篇文章时,Tauri 已经实验性地支持 iOS 和 Android。似乎这一直是计划的一部分,但当我开始我的应用程序时并不知道这一点。我不确定自己是否会使用它,但知道它存在感到很不错。

这是 Electron 所不可能实现的,并且可能永远也不会。因此,如果您计划构建跨平台的移动和桌面应用程序,Tauri 可能是一种不错的选择,因为您可能能够在它们之间共享很多代码。利用网络技术设计移动优先界面多年来变得越来越容易,因此构建一个既可以作为桌面应用程序又可以作为移动应用程序运行的单一界面并不像听起来那么疯狂。

我只是想提一句,让大家对 Tauri 的未来感到兴奋。

watchOS 上的 Tauri 程序?🤯

正如 Jonas 在他的推文中所提到的,这只是实验性的和折衷的;它可能需要很长时间才能达到生产状态,但看到这个领域的创新仍然非常令人兴奋!

结论

我对选择使用 Tauri 感到非常满意。结合 Solid.js,我能够制作出一个真正快速的应用程序,人们喜欢它!我不是说它总是比 Electron 好,但如果它具有您需要的功能,我建议尝试一下!如前所述,您甚至可能不需要写那么多 Rust 代码,所以不要被吓倒!您会惊讶地发现,只用 JavaScript 就能做的事情有多少。

如果你对 Kubernetes 感兴趣,请查看 Aptakube,这是一个使用 Tauri 构建的 Kubernetes 桌面客户端 😊

我现在正在开发一个面向桌面和移动应用的开源且注重隐私的分析平台。它已经具有各种框架的 SDK,包括 Tauri 和 Electron。顺便说一句,Tauri SDK 被打包为一个 Tauri 插件! 😄

最后,我也活跃在 Twitter 上。如果您有任何问题或反馈,请随时联系我。我喜欢谈论 Tauri!

感谢阅读!👋

来源:juejin.cn/post/7386115583845744649

最新Cursor无限续杯避坑指南,让你稳稳的喝咖啡~

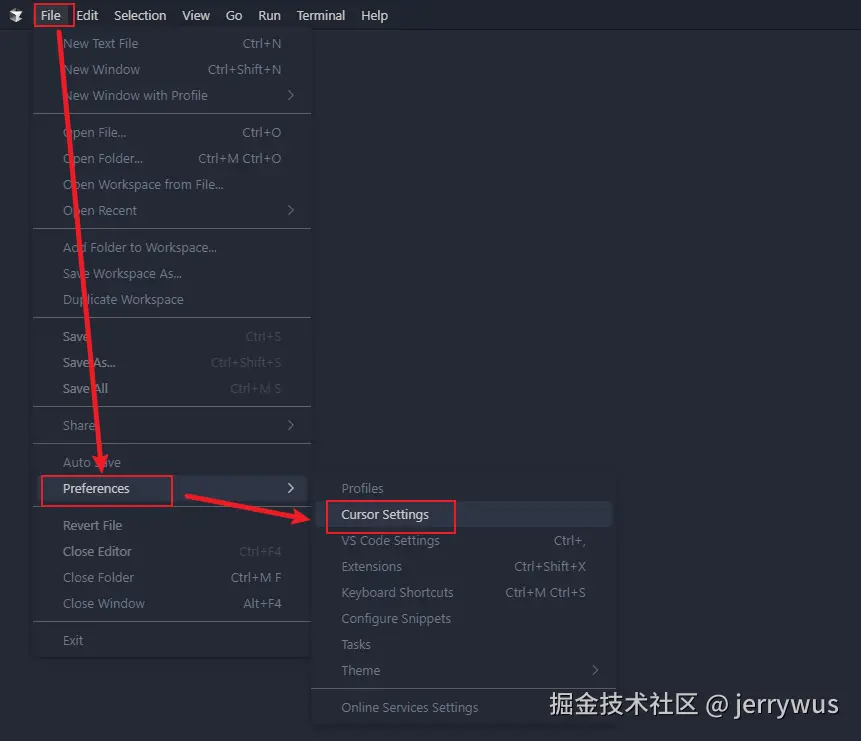

2月份写了篇cursor无限续杯的文章,文章数据对我来说相当完美,看来大家对于不花钱这事比较感兴趣🤣

介于有些同学反应说自定义域名有一定的门槛,上手不太容易,那么今天新的方案它来了!此方案针对频繁被提示试用过期,too many free accounts的场景。

首先要申明一下:

- 无限邮你就别想了,请放弃!!

- cursor请稳定在 <= 0.46.11

废话不多说,进入正文吧 (查看原文体验更佳,有惊喜~)

Step1: 破解软件下载

✨方案使用的是开源软件cursor-help进行cursor重置

👉mac/linux 请使用go-cursor-help 进行操作

- 下载cursor_bypass.exe (红框中的文件,不能科学上网的,下面有网盘链接)

🎈如果打不开链接,可以使用下面的网盘链接下载以上文件

Step2: cursor退出账号

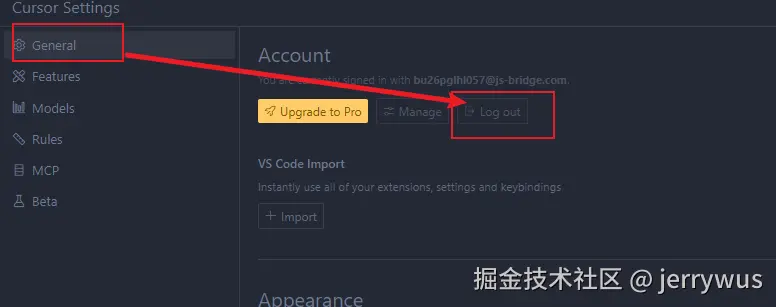

已退出账号直接跳过该步骤~

Step3: 运行软件

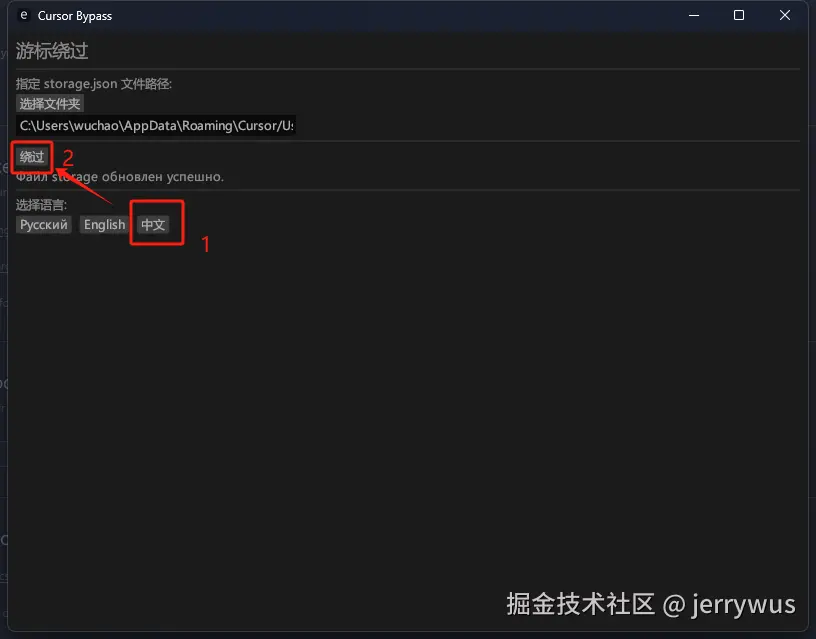

管理员****身份运行(必须,不然点击会没反应) Cursor Bypass.exe

依次点击:

操作完会弹出网页,不用管它~

Step4:登录你之前注册的账号

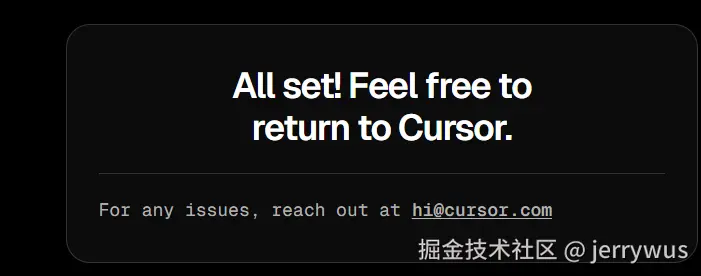

浏览器打开cursor进行登录:

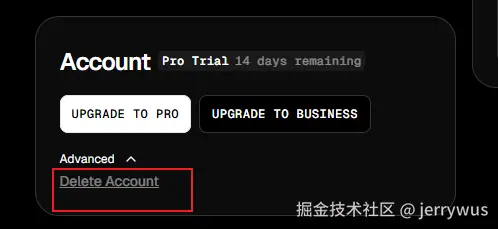

完成登录后,然后页面点击右上角头像,点击账号设置

然后左下角点开Advanced,找到delete account,点击它

Step5: 删除账号

输入Delete,点击删除按钮,删除账号

如果出现 Failed to fetch(cursor服务器网络波动),刷新页面,重试~

Step6:恢复之前的账号

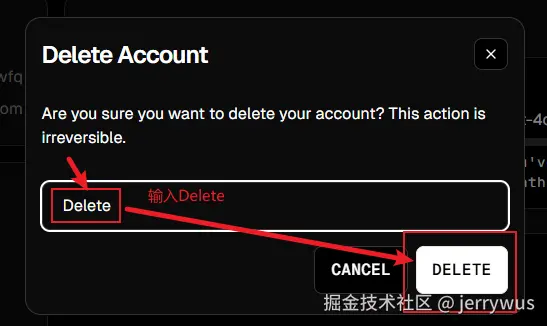

浏览器打开cursor注册页面,使用之前cursor账号那个邮箱再重新注册一遍~

当然了,这里也可以注册新账号(不要用无限邮 )

输入信息,完成注册~

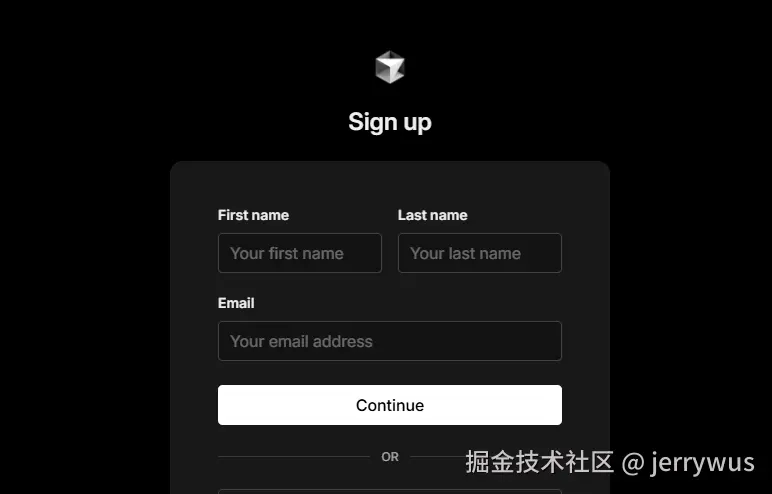

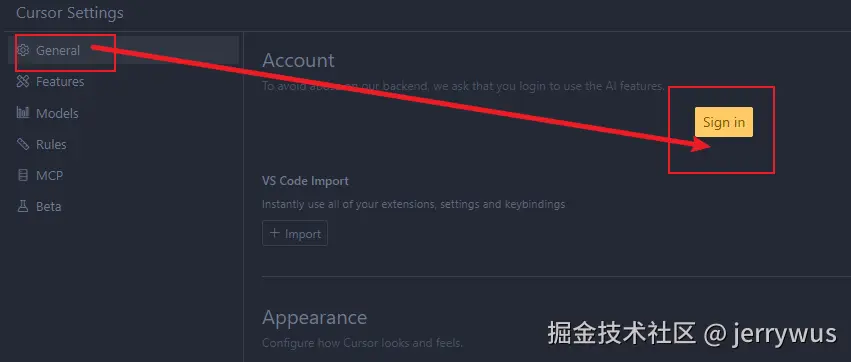

Step7: 使用cursor软件进行登录

建议将chrome设置为默认浏览器(chrome浏览器改成默认浏览器),这样登录会很顺利(同时需要退出360安全卫士这种垃圾软件,它会拦截登录,有点恶心)

💻点这里可以离线下载chrome浏览器

在弹出的页面中完成登录,登录成功是下面的状态

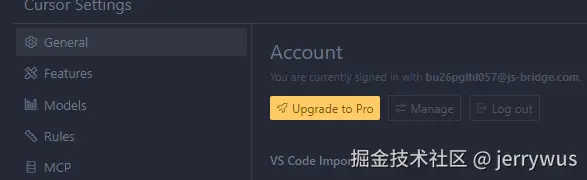

然后回到cursor,状态如下就登录成功了

注意:如果这一步失败,可能360安全卫士这类垃圾软件在搞怪(会拦截登录过程),建议退出360重试

Step8: 验证是否可以试用

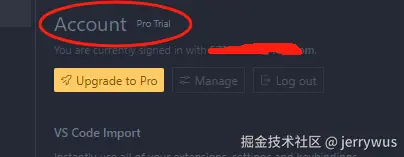

看刚刚的cursor网页,如下状态,就可以了

cursor软件-账户信息再看一眼,这样就没问题了

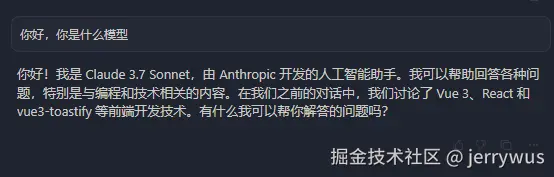

验证提问 CTRL + L,能正常响应即可~

测试代码tab功能

试用版账号需要注意的点

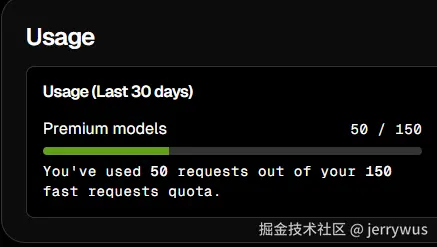

试用账户:

- max模型只有pro正式会员可用,试用账号不可用!!

- tab补全是2000次

- 聊天只有50次,虽然显示了150(达到50即无效,此时按文档重新来一遍即可)

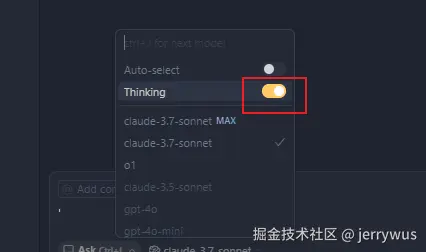

- Tinking打开后,可能出现error

需要关掉Thinking,重试

关掉Thinking即可提问(除非达到50次上限)

更多信息,请移步原文~

来源:juejin.cn/post/7486323379474563107

前端の骚操作代码合集 | 让你的网页充满恶趣味

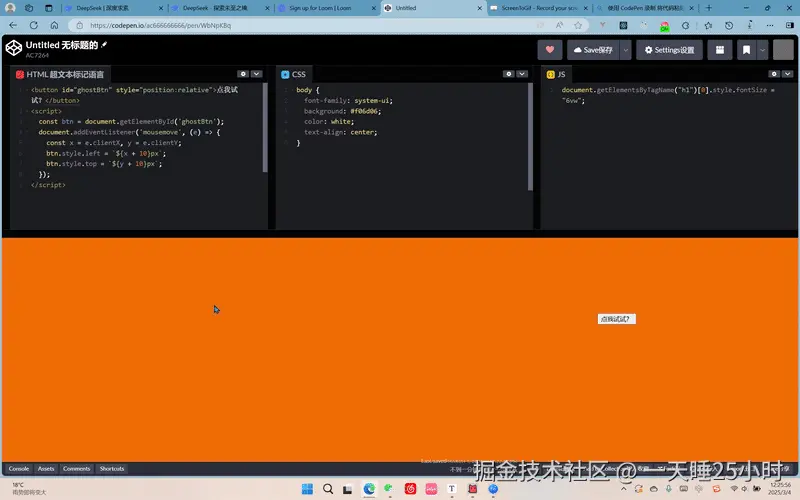

1️⃣ 永远点不到的幽灵按钮

效果描述:按钮会跟随鼠标指针,但始终保持微妙距离

<button id="ghostBtn" style="position:absolute">点我试试?</button>

<script>

const btn = document.getElementById('ghostBtn');

document.addEventListener('mousemove', (e) => {

btn.style.left = `${e.clientX + 15}px`;

btn.style.top = `${e.clientY + 15}px`;

});

</script>

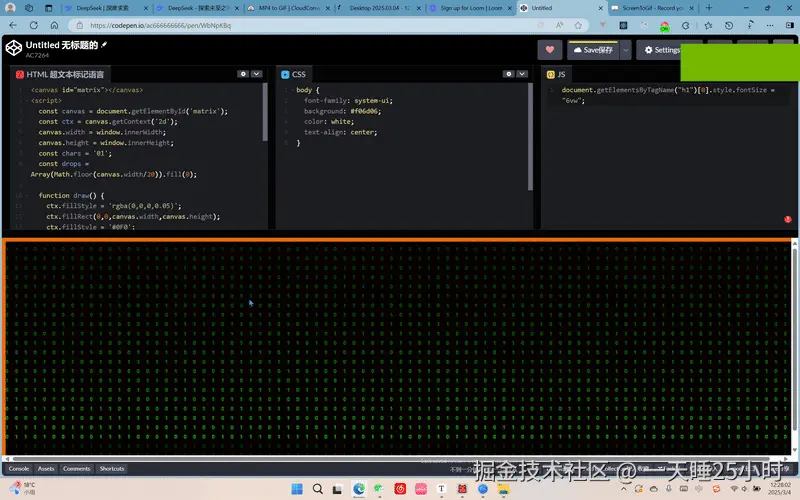

2️⃣ 极简黑客帝国数字雨

代码亮点:仅用 20 行代码实现经典效果

<canvas id="matrix"></canvas>

<script>

const canvas = document.getElementById('matrix');

const ctx = canvas.getContext('2d');

canvas.width = window.innerWidth;

canvas.height = window.innerHeight;

const chars = '01';

const drops = Array(Math.floor(canvas.width/20)).fill(0);

function draw() {

ctx.fillStyle = 'rgba(0,0,0,0.05)';

ctx.fillRect(0,0,canvas.width,canvas.height);

ctx.fillStyle = '#0F0';

drops.forEach((drop, i) => {

ctx.fillText(chars[Math.random()>0.5?0:1], i*20, drop);

drops[i] = drop > canvas.height ? 0 : drop + 20;

});

}

setInterval(draw, 100);

</script>

运行建议:按下 F11 进入全屏模式效果更佳

下面是优化版:

<script>

const canvas = document.getElementById('matrix');

const ctx = canvas.getContext('2d');

canvas.width = window.innerWidth;

canvas.height = window.innerHeight;

const chars = '01'; // 显示的字符

const columns = Math.floor(canvas.width / 20); // 列数

const drops = Array(columns).fill(0); // 每列的起始位置

const speeds = Array(columns).fill(0).map(() => Math.random() * 10 + 5); // 每列的下落速度

function draw() {

// 设置背景颜色并覆盖整个画布,制造渐隐效果

ctx.fillStyle = 'rgba(0, 0, 0, 0.05)';

ctx.fillRect(0, 0, canvas.width, canvas.height);

// 设置字符颜色

ctx.fillStyle = '#0F0'; // 绿色

ctx.font = '20px monospace'; // 设置字体

// 遍历每一列

drops.forEach((drop, i) => {

// 随机选择一个字符

const char = chars[Math.random() > 0.5 ? 0 : 1];

// 绘制字符

ctx.fillText(char, i * 20, drop);

// 更新下落位置

drops[i] += speeds[i];

// 如果超出画布高度,重置位置

if (drops[i] > canvas.height) {

drops[i] = 0;

speeds[i] = Math.random() * 10 + 5; // 重置速度

}

});

}

// 每隔100毫秒调用一次draw函数

setInterval(draw, 100);

</script>

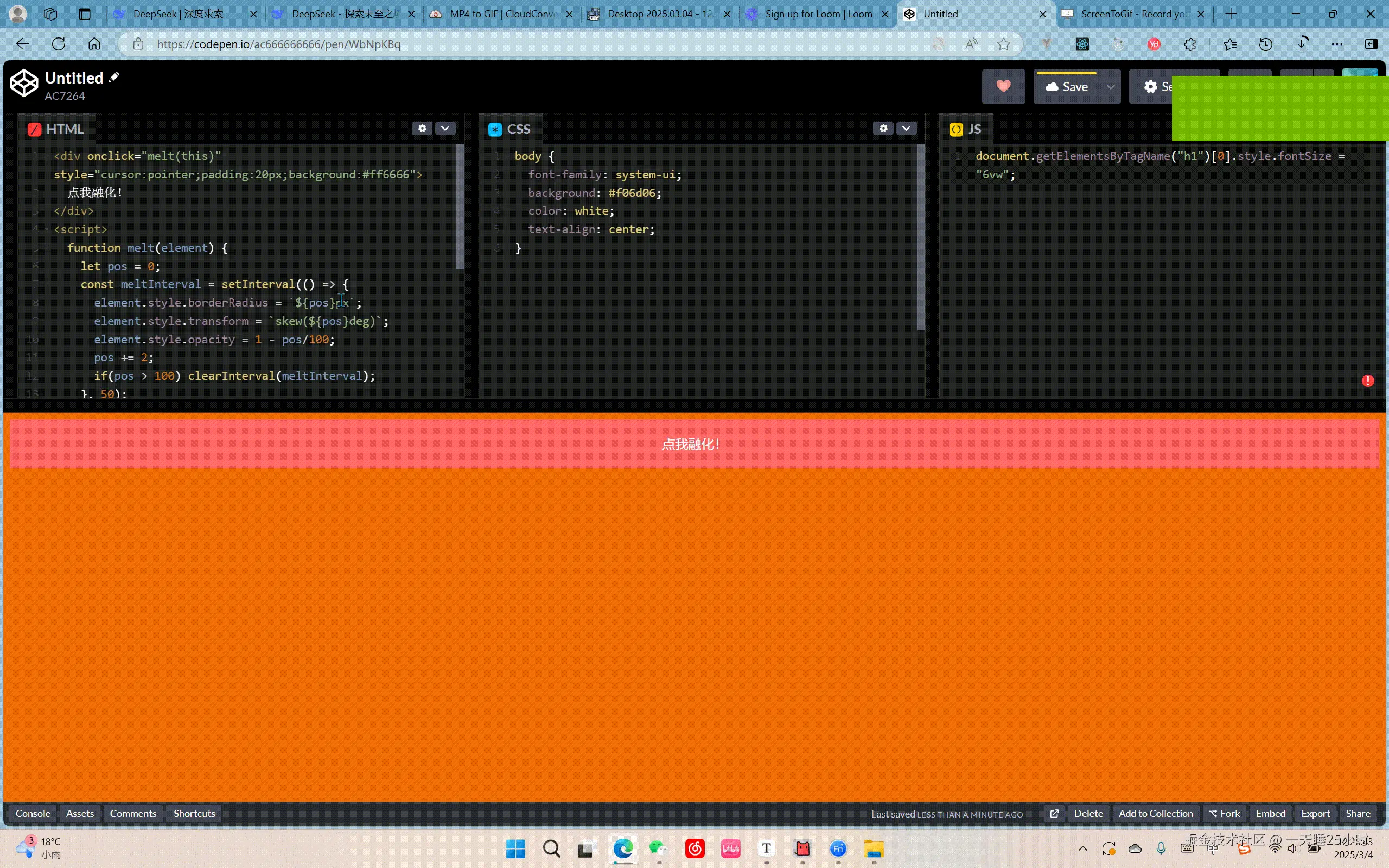

3️⃣ 元素融化动画

交互效果:点击元素后触发扭曲消失动画

<div onclick="melt(this)"

style="cursor:pointer; padding:20px; background:#ff6666;">

点我融化!

</div>

<script>

function melt(element) {

let pos = 0;

const meltInterval = setInterval(() => {

element.style.borderRadius = `${pos}px`;

element.style.transform = `skew(${pos}deg) scale(${1 - pos/100})`;

element.style.opacity = 1 - pos/100;

pos += 2;

if(pos > 100) clearInterval(meltInterval);

}, 50);

}

</script>

4️⃣ 控制台藏宝图

彩蛋效果:在开发者工具中埋入神秘信息

console.log('%c🔮 你发现了秘密通道!',

'font-size:24px; color:#ff69b4; text-shadow: 2px 2px #000');

console.log('%c输入咒语 %c"芝麻开门()" %c获得力量',

'color:#666', 'color:#0f0; font-weight:bold', 'color:#666');

console.debug('%c⚡ 警告:前方高能反应!',

'background:#000; color:#ff0; padding:5px;');

5️⃣ 重力反转页面

魔性交互:让页面滚动方向完全颠倒

window.addEventListener('wheel', (e) => {

e.preventDefault();

window.scrollBy(-e.deltaX, -e.deltaY);

}, { passive: false });

慎用警告:此功能可能导致用户怀疑人生 ( ̄▽ ̄)"

6️⃣ 实时 ASCII 摄像头

技术亮点:将摄像头画面转为字符艺术

<pre id="asciiCam" style="font-size:8px; line-height:8px;"></pre>

<script>

navigator.mediaDevices.getUserMedia({ video: true })

.then(stream => {

const video = document.createElement('video');

video.srcObject = stream;

video.play();

const chars = '@%#*+=-:. ';

const canvas = document.createElement('canvas');

const ctx = canvas.getContext('2d');

video.onplaying = () => {

canvas.width = 80;

canvas.height = 40;

setInterval(() => {

ctx.drawImage(video, 0, 0, 80, 40);

const imgData = ctx.getImageData(0,0,80,40).data;

let ascii = '';

for(let i=0; i<imgData.length; i+=4) {

const brightness = (imgData[i]+imgData[i+1]+imgData[i+2])/3;

ascii += chars[Math.floor(brightness/25.5)]

+ (i%(80*4) === (80*4-4) ? '\n' : '');

}

document.getElementById('asciiCam').textContent = ascii;

}, 100);

};

});

</script>

⚠️ 使用注意事项

- 摄像头功能需 HTTPS 环境或 localhost 才能正常工作

- 反向滚动代码可能影响用户体验,建议仅在整蛊场景使用

- 数字雨效果会持续消耗 GPU 资源

- 控制台彩蛋要确保不会暴露敏感信息

这些代码就像前端的"复活节彩蛋",适度使用能让网站充满趣味性,但千万别用在生产环境哦!(≧∇≦)ノ

https://codepen.io/ 链接 CodePen)

希望这篇博客能成为程序员的快乐源泉!🎉

来源:juejin.cn/post/7477573759254675507

别再追逐全新框架了,先打好基础再说......

Hello,大家好,我是 Sunday

如果大家做过一段时间的前端开发,就会发现相比其他的技术圈而言,前端圈总显得 “乱” 的很。

因为,每隔几个月,圈里就会冒出一个“闪闪发光的全新 JavaScript 框架”,声称能解决你所有问题,并提供各种数据来证明它拥有:更快的性能!更简洁的语法!更多的牛批特性!

而对应的,很多同学都会开始 “追逐” 这些全新的框架,并大多数情况下都会得出一个统一的评论 “好牛批......”

但是,根据我的经验来看,通常情况下 过于追逐全新的框架,毫无意义。 特别是对于 前端初学者 而言,打好基础会更加的重要!

PS:我这并不是在反对新框架的创新,出现更多全新的框架,全新的创新方案肯定是好的。但是,我们需要搞清楚一点,这一个所谓的全新框架 究竟是创新,还是只是通过一个不同的方式,重复的造轮子?

全新的框架是追逐不完的

我们回忆一下,是不是很多所谓的全新框架,总是按照以下的方式在不断的轮回?

- 首先,网上出现了某个“全新 JS 框架”发布,并提供了:更小、更快、更优雅 的方案,从而吸引了大量关注

- 然后,很多技术人开始追捧,从 掘金、抖音、B 站 开始纷纷上线各种 “教程”

- 再然后,几乎就没有然后了。国内大厂不会轻易使用这种新的框架作为生产工具,因为大厂会更加看重框架的稳定性

- 最后,无非会出现两种结果,第一种就是:热度逐渐消退,最后停止维护。第二种就是:不断的适配何种业务场景,直到这种全新的框架也开始变得“臃肿不堪”,和它当年要打败的框架几乎一模一样。

- 重新开始轮回:另一个“热门”框架出现,整个循环再次启动。

Svelte 火了那么久,大家有见到过国内有多少公司在使用吗?可能有很多同学会说“国外有很多公司在使用 Svelte 呀?” 就算如此,它对比 Vue 、React、Angular(国外使用的不少) 市场占有率依然是寥寥无几的。并且大多数同学的主战场还不在国外。

很多框架只是语法层面发生了变化

咱们以一个 “点击计数” 的功能为例,分别来看下在 Vue、React、Svelte 三个框架中的实现(别问为啥没有 angular,问就是不会😂)

Vue3 实现

<template>

<button @click="count++">点击了 {{ count }} 次</button>

</template>

<script setup>

import { ref } from 'vue';

const count = ref(0);

</script>

React 实现

import { useState } from 'react';

function Counter() {

const [count, setCount] = useState(0);

return (

<button onClick={() => setCount(count + 1)}>

点击了 {count} 次

</button>

);

}

export default Counter;

Svelte 实现

<script>

let count = 0;

</script>

<button on:click={() => count += 1}>

点击了 {count} 次

</button>

这三个版本的核心逻辑完全一样,只是语法不同。

那么这就意味着:如果换框架,都要重新学习这些新的语法细节(哪里要写冒号、哪里要写大括号、哪里要写中括号)。

如果你把时间都浪费着这些地方上(特别是前端初学者),是不是就意味着 毫无意义,浪费时间呢?

掌握好基础才是王道

如果我们去看了大量的 国内大厂的招聘面经之后,就会发现,无论是 校招 || 社招,大厂的考察重点 永远不在框架,而在于 JS 基础、网络、算法、项目 这四个部分。至于你会的是 vue || react 并没有那么重要!

PS:对于大厂来说

vue 和 react都有不同的团队在使用。所以不用担心你学的框架是什么,这并不影响你进大厂

因此,掌握好基础就显得太重要了。

所以说:不用过于追逐新的技术框架。

针对于 在校生 而言 打好基础,练习算法,多去做更多有价值的项目,研究框架底层源码 ,并且一定要注意 练习表达,这才是对你将来校招最重要的事情!

而对于 社招的同学 而言 多去挖掘项目的重难点,尝试通过 输出知识的方式 帮助你更好的梳理技术。多去思考 技术如何解决业务问题,这才是关键!

来源:juejin.cn/post/7484960608782336027

让你辛辛苦苦选好的筛选条件刷新页面后不丢失,该怎么做?

你有遇到过同样的需求吗?告诉我你的第一想法。存 Session storage ?可以,但是我更建议你使用 router.replace 。

为什么建议使用 router.replace 而不是浏览器自带的存储空间呢?

增加实用性,你有没有考虑过这种场景,也就是当我筛选好之后进行搜索,我需要将它发给我的同事。当使用storage时是实现不了的,同事只会得到一个初始的页面。那我们将这个筛选结果放入url中是不是就可以解决这个问题了。

router.replace

先给大家介绍一下 router.replace 的用法吧。

router.replace 是 Vue Router 提供的一个方法,用于替换当前的历史记录条目。与 router.push 不同的是,replace 不会在浏览器历史记录中添加新记录,而是替换当前的记录。这对于需要在 URL 中保存状态但不想影响浏览器导航历史的场景非常有用。

// 假设我们正在使用 Vue 2 和 Vue Router

methods: {

updateFilters(newFilters) {

// 将筛选条件编码为查询字符串参数

const query = {

...this.$route.query,

...newFilters,

};

// 使用 router.replace 更新 URL

this.$router.replace({ query });

}

}

在这个示例中,updateFilters 方法接收新的筛选条件,并将它们合并到当前的查询参数中。然后使用 router.replace 更新 URL,而不会在历史记录中添加新条目。

具体实现

将筛选条件转换为适合 URL 的格式,例如 JSON 字符串或简单的键值对。以下是一个更详细的实现:

methods: {

applyFilters(filters) {

const encodedFilters = JSON.stringify(filters);

this.$router.replace({

path: this.$route.path,

query: { ...this.$route.query, filters: encodedFilters },

});

},

getFiltersFromUrl() {

const filters = this.$route.query.filters;

return filters ? JSON.parse(filters) : {};

}

}

在这个实现中,applyFilters 方法将筛选条件编码为 JSON 字符串,并将其存储在 URL 的查询参数中。getFiltersFromUrl 方法用于从 URL 中读取筛选条件,并将其解析回 JavaScript 对象。

注意事项

- 编码和解码:在将复杂对象存储到 URL 时,确保使用

encodeURIComponent和decodeURIComponent来处理特殊字符。 - URL 长度限制:浏览器对 URL 长度有一定的限制,确保不要在 URL 中存储过多数据。

- 数据安全性:考虑 URL 中数据的敏感性,避免在 URL 中存储敏感信息。

- url重置:不要忘了在筛选条件重置时也将

url重置,在取消筛选时同时去除url上的筛选。

一些其他的应用场景

- 重定向用户:

- 当用户访问一个不再存在或不推荐使用的旧路径时,可以使用

router.replace将他们重定向到新的路径。这避免了用户点击“返回”按钮时再次回到旧路径。

- 当用户访问一个不再存在或不推荐使用的旧路径时,可以使用

- 处理表单提交后清理 URL:

- 在表单提交后,可能会在 URL 中附加查询参数。使用

router.replace可以在处理完表单数据后清理这些参数,保持 URL 的整洁。

- 在表单提交后,可能会在 URL 中附加查询参数。使用

- 登录后跳转:

- 在用户登录后,将他们重定向到一个特定的页面(如用户主页或仪表盘),并且不希望他们通过“返回”按钮回到登录页面。使用

router.replace可以实现这一点。

- 在用户登录后,将他们重定向到一个特定的页面(如用户主页或仪表盘),并且不希望他们通过“返回”按钮回到登录页面。使用

- 错误页面处理:

- 当用户导航到一个不存在的页面时,可以使用

router.replace将他们重定向到一个错误页面(如 404 页面),并且不希望这个错误路径保留在浏览历史中。

- 当用户导航到一个不存在的页面时,可以使用

- 动态内容加载:

- 在需要根据用户操作动态加载内容时,使用

router.replace更新 URL,而不希望用户通过“返回”按钮回到之前的状态。例如,在单页应用中根据选项卡切换更新 URL。

- 在需要根据用户操作动态加载内容时,使用

- 多步骤流程:

- 在多步骤的用户流程中(如注册或购买流程),使用

router.replace可以在用户完成每一步时更新 URL,而不希望用户通过“返回”按钮回到上一步。

- 在多步骤的用户流程中(如注册或购买流程),使用

- 清理查询参数:

- 在用户操作完成后,使用

router.replace清理不再需要的查询参数,保持 URL 简洁且易于阅读。

- 在用户操作完成后,使用

小结

简单来说就是把你的

url当成浏览器的sessionstorage了。其实这就是我上周收到的任务,当时我甚至纠结的是该用localStorage还是sessionStorage,忙活半天,不停转类型,然后在开周会我讲了下我的思路。我的tl便说出了我的问题,讲了更加详细的需求,我才开始尝试router.replace,又是一顿忙活。。

来源:juejin.cn/post/7424034641379098663

做了个渐变边框的input输入框,领导和客户很满意!

需求简介

前几天需求评审的时候,产品说客户希望输入框能够好看一点。由于我们UI框架用的是Elemnt Plus,input输入框的样式也比较中规中矩,所以我们组长准备拒绝这个需求

但是,喜欢花里胡哨的我立马接下了这个需求!我自信的告诉组长,放着我来,包满意!

经过一番折腾,我通过 CSS 的技巧实现了一个带有渐变边框的 Input 输入框,而且当鼠标悬浮在上面时,边框颜色要更加炫酷并加深渐变效果。

最后,领导和客户对最后的效果都非常满意~我也成功获得了老板给我画的大饼,很开心!

下面就来分享我的实现过程和代码方案,满足类似需求的同学可以直接拿去用!

实现思路

实现渐变边框的原理其实很简单,首先实现一个渐变的背景作为底板,然后在这个底板上加上一个纯色背景就好了。

当然,我们在实际写代码的时候,不用专门写两个div来这么做,利用css的 background-clip 就可以实现上面的效果。

background-clip属性详解

background-clip是一个用于控制背景(background)绘制范围的 CSS 属性。它决定了背景是绘制在 内容区域、内边距区域、还是 边框区域。

background-clip: border-box | padding-box | content-box | text;

代码实现

背景渐变

<template>

<div class="input-container">

<input type="text" placeholder="请输入内容" class="gradient-input" />

</div>

</template>

<script setup>

</script>

<style>

/* 输入框容器 */

.input-container {

display: flex;

align-items: center;

justify-content: center;

height: 100vh;

width: 100vw;

background: #f4f4f9;

}

/* 渐变边框输入框 */

.gradient-input {

width: 400px;

height: 40px;

padding: 5px 12px;

font-size: 16px;

color: #333;

outline: none;

/* 渐变边框 */

border: 1px solid transparent;

background: linear-gradient(white, white) padding-box,

linear-gradient(45deg, #ff7eb3, #65d9ff, #c7f464, #ff7eb3) border-box;

border-radius: 20px;

}

/* Placeholder 样式 */

.gradient-input::placeholder {

color: #aaa;

font-style: italic;

}

</style>

通过上面的css方法,我们成功实现了一个带有渐变效果边框的 Input 输入框,它的核心代码是

background: linear-gradient(white, white) padding-box,

linear-gradient(45deg, #ff7eb3, #65d9ff, #c7f464, #ff7eb3) border-box;

padding-box:限制背景在内容区域显示,防止覆盖输入框内容。

border-box:渐变背景会显示在边框位置,形成渐变边框效果。

这段代码分为两层背景:

- 第一层背景:

linear-gradient(white, white)是一个纯白色的线性渐变,用于覆盖输入框的内容区域(padding-box)。 - 第二层背景:

linear-gradient(45deg, #ff7eb3, #65d9ff, #c7f464, #ff7eb3)是一个多色的渐变,用于显示在输入框的边框位置(border-box)。

背景叠加后,最终效果是:内层内容是白色背景,边框区域显示渐变颜色。

Hover 效果

借助上面的思路,我们在添加一些hover后css样式,通过 :hover 状态改变渐变的颜色和 box-shadow 的炫光效果:

/* Hover 状态 */

.gradient-input:hover {

background: linear-gradient(white, white) padding-box,

linear-gradient(135deg, #ff0076, #1eaeff, #28ffbf, #ff0076) border-box;

box-shadow: 0 0 5px rgba(255, 0, 118, 0.5), 0 0 20px rgba(30, 174, 255, 0.5);

}

过渡似乎有点生硬,没关系,加个过渡样式

/* 渐变边框输入框 */

.gradient-input {

// .....

/* 平滑过渡 */

transition: background 0.3s ease, box-shadow 0.3s ease;

}

非常好看流畅~

激活样式

最后,我们再添加一个激活的Focus 状态:当用户聚焦输入框时,渐变变得更加灵动,加入额外的光晕。

/* Focus 状态 */

.gradient-input:focus {

background: linear-gradient(white, white) padding-box,

linear-gradient(45deg, #ff0076, #1eaeff, #28ffbf, #ff0076) border-box;

box-shadow: 0 0 15px rgba(255, 0, 118, 0.7), 0 0 25px rgba(30, 174, 255, 0.7);

color: #000; /* 聚焦时文本颜色 */

}

现在,我们就实现了一个渐变边框的输入框,是不是非常好看?

完整代码

<template>

<div class="input-container">

<input type="text" placeholder="请输入内容" class="gradient-input" />

</div>

</template>

<style>

/* 输入框容器 */

.input-container {

display: flex;

align-items: center;

justify-content: center;

height: 100vh;

width: 100vw;

background: #f4f4f9;

}

/* 渐变边框输入框 */

.gradient-input {

width: 400px;

height: 40px;

padding: 5px 12px;

font-size: 16px;

font-family: 'Arial', sans-serif;

color: #333;

outline: none;

/* 渐变边框 */

border: 1px solid transparent;

background: linear-gradient(white, white) padding-box,

linear-gradient(45deg, #ff7eb3, #65d9ff, #c7f464, #ff7eb3) border-box;

border-radius: 20px;

/* 平滑过渡 */

transition: background 0.3s ease, box-shadow 0.3s ease;

}

/*

/* Hover 状态 */

.gradient-input:hover {

background: linear-gradient(white, white) padding-box,

linear-gradient(135deg, #ff0076, #1eaeff, #28ffbf, #ff0076) border-box;

box-shadow: 0 0 5px rgba(255, 0, 118, 0.5), 0 0 20px rgba(30, 174, 255, 0.5);

}

/* Focus 状态 */

.gradient-input:focus {

background: linear-gradient(white, white) padding-box,

linear-gradient(45deg, #ff0076, #1eaeff, #28ffbf, #ff0076) border-box;

box-shadow: 0 0 15px rgba(255, 0, 118, 0.7), 0 0 25px rgba(30, 174, 255, 0.7);

color: #000; /* 聚焦时文本颜色 */

}

/* Placeholder 样式 */

.gradient-input::placeholder {

color: #aaa;

font-style: italic;

}

</style>

总结

通过上述方法,我们成功实现了一个带有渐变效果边框的 Input 输入框,并且在 Hover 和 Focus 状态下增强了炫彩效果。

大家可以根据自己的需求调整渐变的方向、颜色或动画效果,让你的输入框与众不同!

来源:juejin.cn/post/7442216034751545394

几行代码,优雅的避免接口重复请求!同事都说好!

背景简介

我们日常开发中,经常会遇到点击一个按钮或者进行搜索时,请求接口的需求。

如果我们不做优化,连续点击按钮或者进行搜索,接口会重复请求。

首先,这会导致性能浪费!最重要的,如果接口响应比较慢,此时,我们在做其他操作会有一系列bug!

那么,我们该如何规避这种问题呢?

如何避免接口重复请求

防抖节流方式(不推荐)

使用防抖节流方式避免重复操作是前端的老传统了,不多介绍了

防抖实现

<template>

<div>

<button @click="debouncedFetchData">请求</button>

</div>

</template>

<script setup>

import { ref } from 'vue';

import axios from 'axios';

const timeoutId = ref(null);

function debounce(fn, delay) {

return function(...args) {

if (timeoutId.value) clearTimeout(timeoutId.value);

timeoutId.value = setTimeout(() => {

fn(...args);

}, delay);

};

}

function fetchData() {

axios.get('http://api/gcshi) // 使用示例API

.then(response => {

console.log(response.data);

})

}

const debouncedFetchData = debounce(fetchData, 300);

</script>

防抖(Debounce) :

- 在setup函数中,定义了timeoutId用于存储定时器ID。

- debounce函数创建了一个闭包,清除之前的定时器并设置新的定时器,只有在延迟时间内没有新调用时才执行fetchData。

- debouncedFetchData是防抖后的函数,在按钮点击时调用。

节流实现

<template>

<div>

<button @click="throttledFetchData">请求</button>

</div>

</template>

<script setup>

import { ref } from 'vue';

import axios from 'axios';

const lastCall = ref(0);

function throttle(fn, delay) {

return function(...args) {

const now = new Date().getTime();

if (now - lastCall.value < delay) return;

lastCall.value = now;

fn(...args);

};

}

function fetchData() {

axios.get('http://api/gcshi') //

.then(response => {

console.log(response.data);

})

}

const throttledFetchData = throttle(fetchData, 1000);

</script>

节流(Throttle) :

- 在setup函数中,定义了lastCall用于存储上次调用的时间戳。

- throttle函数创建了一个闭包,检查当前时间与上次调用时间的差值,只有大于设定的延迟时间时才执行fetchData。

- throttledFetchData是节流后的函数,在按钮点击时调用。

节流防抖这种方式感觉用在这里不是很丝滑,代码成本也比较高,因此,很不推荐!

请求锁定(加laoding状态)

请求锁定非常好理解,设置一个laoding状态,如果第一个接口处于laoding中,那么,我们不执行任何逻辑!

<template>

<div>

<button @click="fetchData">请求</button>

</div>

</template>

<script setup>

import { ref } from 'vue';

import axios from 'axios';

const laoding = ref(false);

function fetchData() {

// 接口请求中,直接返回,避免重复请求

if(laoding.value) return

laoding.value = true

axios.get('http://api/gcshi') //

.then(response => {

laoding.value = fasle

})

}

const throttledFetchData = throttle(fetchData, 1000);

</script>

这种方式简单粗暴,十分好用!

但是也有弊端,比如我搜索A后,接口请求中;但我此时突然想搜B,就不会生效了,因为请求A还没响应!

因此,请求锁定这种方式无法取消原先的请求,只能等待一个请求执行完才能继续请求。

axios.CancelToken取消重复请求

基本用法

axios其实内置了一个取消重复请求的方法:axios.CancelToken,我们可以利用axios.CancelToken来取消重复的请求,爆好用!

首先,我们要知道,aixos有一个config的配置项,取消请求就是在这里面配置的。

<template>

<div>

<button @click="fetchData">请求</button>

</div>

</template>

<script setup>

import { ref } from 'vue';

import axios from 'axios';

let cancelTokenSource = null;

function fetchData() {

if (cancelTokenSource) {

cancelTokenSource.cancel('取消上次请求');

cancelTokenSource = null;

}

cancelTokenSource = axios.CancelToken.source();

axios.get('http://api/gcshi',{cancelToken: cancelTokenSource.token}) //

.then(response => {

laoding.value = fasle

})

}

</script>

我们测试下,如下图:可以看到,重复的请求会直接被终止掉!

CancelToken官网示例

官网使用方法传送门:http://www.axios-http.cn/docs/cancel…

const CancelToken = axios.CancelToken;

const source = CancelToken.source();

axios.get('/user/12345', {

cancelToken: source.token

}).catch(function (thrown) {

if (axios.isCancel(thrown)) {

console.log('Request canceled', thrown.message);

} else {

// 处理错误

}

});

axios.post('/user/12345', {

name: 'new name'

}, {

cancelToken: source.token

})

// 取消请求(message 参数是可选的)

source.cancel('Operation canceled by the user.');

也可以通过传递一个 executor 函数到 CancelToken 的构造函数来创建一个 cancel token:

const CancelToken = axios.CancelToken;

let cancel;

axios.get('/user/12345', {

cancelToken: new CancelToken(function executor(c) {

// executor 函数接收一个 cancel 函数作为参数

cancel = c;

})

});

// 取消请求

cancel();

注意: 可以使用同一个 cancel token 或 signal 取消多个请求。

在过渡期间,您可以使用这两种取消 API,即使是针对同一个请求:

const controller = new AbortController();

const CancelToken = axios.CancelToken;

const source = CancelToken.source();

axios.get('/user/12345', {

cancelToken: source.token,

signal: controller.signal

}).catch(function (thrown) {

if (axios.isCancel(thrown)) {

console.log('Request canceled', thrown.message);

} else {

// 处理错误

}

});

axios.post('/user/12345', {

name: 'new name'

}, {

cancelToken: source.token

})

// 取消请求 (message 参数是可选的)

source.cancel('Operation canceled by the user.');

// 或

controller.abort(); // 不支持 message 参数

来源:juejin.cn/post/7380185173689204746

最近 React Scan 太火了,做了个 Vue Scan

在 React Scan 的 github 有这么一张 gif 图片。当用户在页面上操作时,对应的组件会有一个闪烁,表示当前组件更新了。用这样的方式来排查程序的性能是一个很直观的方式。

根据 React Scan 自己的介绍,React Scan 可以 通过自动检测和突出显示导致性能问题的渲染。

Vue Scan

但是我主要使用 vue 来开发我的应用,看到这个功能非常眼馋,所以就动手自己做了一个 demo,目前也构建了一个 chrome 扩展,不过扩展仅支持识别 vue3 项目 现在已经支持 vue2 和 vue3 项目了。

项目地址:Vue Scan

简单介绍,Vue Scan 通过组件的 onBeforUpdate 钩子,当组件更新时,在组件对应位置绘制一个闪烁的边框。看起来的效果就像这样。

用法

我更推荐在开发环境使用它,Vue Scan 提供一个 vue plugin,允许你在 mount 之前注入相关的内容。

// vue3

import { createApp } from 'vue'

import VueScan, { type VueScanOptions } from 'z-vue-scan/src'

import App from './App.vue'

const app = createApp(App)

app.use<VueScanOptions>(VueScan, {})

app.mount('#app')

// vue2

import Vue from 'vue'

import VueScan, { type VueScanBaseOptions } from 'z-vue-scan/vue2'

import App from './App.vue'

Vue.use<VueScanBaseOptions>(VueScan, {})

new Vue({

render: h => h(App),

}).$mount('#app')

浏览器扩展

如果你觉得看自己的网站没什么意思,那么我还构建了一个浏览器扩展,允许你注入相关方法到别人的 vue 程序中。

你可以在 Github Release 寻找一下最新版的安装包,然后解压安装到浏览器中。

安装完成后,你的扩展区域应该会多一个图标,点击之后会展开一个面板,允许你控制是否注入相关的内容。

这是如果你进入一个使用 vue 构建的网站,可以看控制台看到相关的信息,当你在页面交互时,页面应该也有相应的展示。

缺陷

就像 React Scan 的介绍中提到的,它能自动识别性能问题,单目前 Vue Scan 只是真实地反映组件的更新,并不会区分和识别此次更新是否有性能问题。

结语

通过观察网站交互时组件的更新状态,来尝试发现网站的性能问题,我觉得这是一个很好的方式。希望这个工具可以给大家带来一点乐趣和帮助。

来源:juejin.cn/post/7444449353165488168

Electron 启动白屏解决方案

对于 Web 开发者使用 Electron 构建桌面应用程序时,经常会遇到如上图所示的一个问题 —— 窗口加载过程中长时间白屏。在应用窗口创建完成到页面加载出来的这段时间里,出现了长时间的白屏,这个问题对于前端开发来说是一个老生常谈的问题,纯 Web 端可能就是异步加载、静态资源压缩、CDN 以及骨架屏等等优化方案,但是如果是开发 Electron 应用,场景又有些许不同,因此我们也不能完全按照通用的前端解决白屏的方案进行处理,本文就来探索基于 Electron 场景下启动白屏的解决方案。

问题原因分析

1. Electron 主进程加载时间过长

Electron 应用在启动时,需要先加载主进程,然后由主进程去创建浏览器窗口和加载页面。如果主进程加载时间过长,就会导致应用一直停留在空白窗口,出现白屏。

主进程加载时间长的原因可以有:

- 初始化逻辑复杂,比如加载大量数据、执行计算任务等

- 主进程依赖的模块加载时间长,例如 Native 模块编译耗时

- 主进程代码进行了大量同步 I/O 操作,阻塞了事件循环

2. Web 部分性能优化不足

浏览器窗口加载 HTML、JavaScript、CSS 等静态资源是一个渐进的过程,如果资源体积过大,加载时间过长,在加载过程中就会短暂出现白屏,这一点其实就是我们常说的前端首屏加载时间过长的问题。导致 Web 加载时间过长的原因可以是:

- 页面体积大,如加载过多图片、视频等大资源

- 没有代码拆分,一次加载全部 Bundles

- 缺乏缓存机制,资源无法命中缓存

- 主线程运算量大,频繁阻塞渲染

解决方案

1. 常规 Web 端性能优化

Web 端加载渲染过程中的白屏,可以采用常规前端的性能优化手段:

- 代码拆分,异步加载,避免大包导致的加载时间过长

- 静态资源压缩合并、CDN 加速,减少资源加载时间

- 使用骨架屏技术,先提供页面骨架,优化用户体验

- 减少主线程工作量,比如使用 Web Worker 进行复杂计算

- 避免频繁布局重排,优化 DOM 操作

以上优化可以明显减少 HTML 和资源加载渲染的时,缩短白屏现象。还是那句话,纯 Web 端的性能优化对于前端开发来说老生常谈,我这边不做详细的赘述,不提供实际代码,开发者可以参考其他大佬写的性能优化文章,本文主要针对的是 Electron 启动白屏过长的问题,因为体验下来 Electron 白屏的本质问题还是要通过 Electron 自身来解决~

2. 控制 Electron 主进程加载时机

Electron 启动长时间白屏的本质原因,前面特意强调了,解决方案还是得看 Electron 自身的加载时机,因为我这边将 Web 部分的代码打包启动,白屏时间是非常短的,与上面动图里肉眼可见的白屏时间形成了鲜明的对比。所以为了解决这个问题,我们还是要探寻 Electron 的加载时机,通过对 Electron 的启动流程分析,我们发现:

- 如果在主进程准备就绪之前就创建并显示浏览器窗口,由于此时渲染进程和页面还未开始加载,窗口内自然就是空白,因此需要确保在合适的时机创建窗口。

- 反之如果创建窗口后,又长时间不调用

window.show()显示窗口,那么窗口会一直在后台加载页面,用户也会看不到,从而出现白屏的效果。

因此我们可以通过控制主进程的 Ready 事件时机以及 Window 窗口的加载时机来对这个问题进行优化,同样的关于加载时机我们也可以有两种方案进行优化:

- 通过监听

BrowserWindow上面的ready-to-show事件控制窗口显示

// 解决白屏问题

app.whenReady().then(() => {

// 将创建窗口的代码放在 `app.whenReady` 事件回调中,确保主进程启动完成后再创建窗口

const mainWindow = new BrowserWindow({ show:false });

// 加载页面

mainWindow.loadURL('index.html');

// 在 ready-to-show 事件中显示窗口

mainWindow..once("ready-to-show", () => {

mainWindow.show();

});

});

上述代码通过操作 app.whenReady() 和 BrowserWindow 的 mainWindow.once('ready-to-show') 这几个 Electron 核心启动 API,优雅地处理了窗口隐藏 + 页面加载 + 窗口显示等问题,详细流程如下:

- 将创建窗口的代码放在

app.whenReady事件回调中,确保主进程启动完成后再创建窗口 - 创建窗口的时候让窗口隐藏不显示

{ show: false },避免页面没加载完成导致的白屏 - 窗口加载页面

win.loadURL,也就是说窗口虽然隐藏了,但是不耽误加载页面 - 通过

ready-to-show事件来判断窗口是否已经准备好,这个事件其实就代表页面已经加载完成了,因此此时调用mainWidnow.show()让窗口显示就解决了白屏的问题

- 通过监听

BrowserWindow.webContents上面的did-finish-load或者dom-ready事件来控制窗口显示

app.whenReady().then(() => {

// 将创建窗口的代码放在 `app.whenReady` 事件回调中,确保主进程启动完成后再创建窗口

const mainWindow = new BrowserWindow({ show:false });

// 加载页面

mainWindow.loadURL(indexPage);

// 通过 webContents 对应事件来处理窗口显示

mainWindow.webContents.on("did-finish-load", () => {

mainWindow.show();

});

});

此方案与上述方案的唯一区别就是,第一个使用的是 BrowserWindow 的事件来处理,而此方案通过判断 BrowserWindow.webContents 这个对象,这个对象是 Electron 中用来渲染以及控制 Web 页面的,因此我们可以更直接的使用 did-finish-load 或者直接 dom-ready 这两个事件来判断页面是否加载完成,这两个 API 的含义相信前端开发者都不陌生,页面加载完成以及 DOM Ready 都是前端的概念,通过这种方式也是可以解决启动白屏的。

相关文档:BrowserWindow、webCotnents

最后解决完成的效果如下:

总结

从上图来看最终的效果还是不错的,当窗口出现的一瞬间页面就直接加载完成了,不过细心的小伙伴应该会发现,这个方案属于偷梁换柱,给用户的感觉是窗口出现的时候页面就有内容了,但是其实窗口没出现的时间是有空档期的,大概就是下面这个意思:

从上图以及实际效果来看,其实我们的启动时间是没有发生改变的,但是因为端上应用和我们纯 Web 应用的使用场景不同,它自身就是有应用的启动时间,所以空档期如果不长,这个方案的体验还是可以的。但是如果前面的空档期过长,那么可能就是 Electron 启动的时候加载资源过多造成的了,就需要其他优化方案了。由此也可以见得其实对于用户体验来说,可能我们的产品性能并不一定有提升,只要从场景出发从用户角度去考虑问题,其实就能提升整个应用的体验。

回归本篇文章,我们从问题入手分析了 Electron 启动白屏出现的原因并提供了对应的解决方案,笔者其实对 Electron 的开发也并不深入,只是解决了一个需求一个问题用文章做记录,欢迎大家交流心得,共同进步~

来源:juejin.cn/post/7371386534179520539

用electron写个浏览器给自己玩

浏览器这种东西工程量很唬人,但是有了electron+webview我们就相当于只需要干组装的活就可以了,而且产品目标就是给自己玩,

成品的效果

😄本来想写成专业的技术博客,但是发现大家好像对那种密密麻麻,全是代码的技术博客不感兴趣,我就挑重点来写吧。

下载拦截功能

下载逻辑如果不做拦截处理的话,默认就是我们平常写web那种弹窗的方式,既然是浏览器肯定不能是那样的。

electron中可以监听BrowserWindow的页面下载事件,并把拿到的下载状态传给渲染线程,实现类似浏览器的下载器功能。

//这个global.WIN = global.WIN = new BrowserWindow({ ...})

global.WIN.webContents.session.on('will-download', (evt, item) => {

//其他逻辑

item.on('updated', (evt, state) => {

//实时的下载进度传递给渲染线程

})

})

页面搜索功能

当时做这个功能的时候我就觉得完了,这个玩意看起来太麻烦了,还要有一个的功能这不是头皮发麻啊。

查资料和文档发现这个居然是webview内置的功能,瞬间压力小了很多,我们只需要出来ctrl+f的时候把搜索框弹出来这个UI就可以了,关键字变色和下一个都是内部已经实现好了的。

function toSearch() {

let timer

return () => {

if (timer) {

clearTimeout(timer)

}

timer = setTimeout(() => {

if (keyword.value) {

webviewRef.value.findInPage(keyword.value, { findNext: true })

} else {

webviewRef.value.stopFindInPage('clearSelection')

}

}, 200)

}

}

function closeSearch() {

showSearch.value = false

webviewRef.value.stopFindInPage('clearSelection')

}

function installFindPage(webview) {

webviewRef.value = webview

webviewRef.value.addEventListener('found-in-page', (e) => {

current.value = e.result.activeMatchOrdinal

total.value = e.result.matches

})

}

当前标签页打开功能

就是因为chrome和edge这些浏览器每次使用的时候开非常多的标签,挤在一起,所以我想这个浏览器不能主动开标签,打开了一个标签后强制所有的标签都在当前标签覆盖。

app.on('web-contents-created', (event, contents) => {

contents.setWindowOpenHandler((info) => {

global.WIN?.webContents.send('webview-url-is-change')

if (info.disposition === 'new-window') {

return { action: 'allow' }

} else {

global.WIN?.webContents.send('webview-open-url', info.url)

return { action: 'deny' }

}

})

})

渲染线程监听到webview-open-url后也就是tart="_blank"的情况,强制覆盖当前不打开新窗口

ipcRenderer.on('webview-open-url', (event, url) => {

try {

let reg = /http|https/g

if (webviewRef.value && reg.test(url)) {

webviewRef.value.src = url

}

} catch (err) {

console.log(err)

}

})

标签页切换功能

这里的切换是css的显示隐藏,借助了vue-router

这里我们看dom就能清晰的看出来。

地址栏功能

地址栏支持输入url直接访问链接、支持关键字直接打开收藏的网站、还支持关键字搜索。优先级1打开收藏的网页 2访问网站 3关键字搜索

function toSearch(keyword) {

if (`${keyword}`.length === 0) {

return false

}

// app搜索

if (`${keyword}`.length < 20) {

let item = null

const list = [...deskList.value, ...ALL_DATA]

for (let i = 0; i < list.length; i++) {

if (

list[i].title.toUpperCase().search(keyword.toUpperCase()) !== -1 &&

list[i].type !== 'mini-component'

) {

item = list[i]

break

}

}

if (item) {

goApp(item)

return false

}

}

// 网页访问

let url

if (isUrl(keyword)) {

if (!/^https?:\/\//i.test(keyword)) {

url = 'http://' + keyword

} else {

url = keyword

}

goAppNewTab(url)

return false

} else {

// 关键字搜索

let searchEngine = localStorage.getItem('searchEngine')

searchEngine = searchEngine || CONFIG.searchEngine

url = searchEngine + keyword

if (!router.hasRoute('search')) {

router.addRoute({

name: 'search',

path: '/search',

meta: {

title: '搜索',

color: 'var(--app-icon-bg)',

icon: 'search.svg',

size: 1

},

component: WebView

})

keepAliveInclude.value.push('search')

}

router.push({

path: '/search',

query: { url }

})

setTimeout(() => {

Bus.$emit('toSearch', url)

}, 20)

}

}

桌面图标任意位置拖动

这个问题困扰了我很久,因为它不像电脑桌面大小是固定的,浏览器可以全屏也可以小窗口,如果最开始是大窗口然后拖成小窗口,那么图标就看不到了。后来想到我干脆给个中间区域固定大小,就可以解决这个问题了。因为固定大小出来起来就方便多了。这个桌面是上下两层

//背景格子

<div v-show="typeActive === 'me'" class="bg-boxs">

<div

v-for="(item, i) in 224" //这里有点不讲究了直接写死了

:key="item"

class="bg-box"

@dragenter="enter($event, { x: (i % 14) + 1, y: Math.floor(i / 14) + 1 })"

@dragover="over($event)"

@dragleave="leave($event)"

@drop="drop($event)"

></div>

</div>

// 桌面层

// ...

import { ref, computed } from 'vue'

import useDesk from '@/store/deskList'

import { storeToRefs } from 'pinia'

export default function useDrag() {

const dragging = ref(null)

const currentTarget = ref()

const desk = useDesk()

const { deskList } = storeToRefs(desk)

const { setDeskList, updateDeskData } = desk

function start(e, item) {

e.target.classList.add('dragging')

e.dataTransfer.effectAllowed = 'move'

dragging.value = item

currentTarget.value = e

console.log('开始')

}

let timer2

function end(e) {

dragging.value = null

e.target.classList.remove('dragging')

setDeskList(deskList.value)

if (timer2) {

clearTimeout(timer2)

}

timer2 = setTimeout(() => {

updateDeskData()

}, 2000)

}

function over(e) {

e.preventDefault()

}

let timer

function enter(e, item) {

e.dataTransfer.effectAllowed = 'move'

if (timer) {

clearTimeout(timer)

}

timer = setTimeout(() => {

if (item?.x) {

dragging.value.x = item.x

dragging.value.y = item.y

}

}, 100)

}

function leave(e) {}

function drop(e) {

e.preventDefault()

}

return { start, end, over, enter, leave, drop }

}

东西太多了就先介绍这些了

安装包地址

也可以到官网后aweb123.com 如何进入微软商店下载,mac版本因为文件大于100mb没有传上去所以暂时还用不了。

来源:juejin.cn/post/7395389351641612300

大声点回答我:token应该存储在cookie还是localStorage上?

背景

前置文章:浏览器: cookie机制完全解析

在考虑token是否应该存储在cookie或localStorage中时,我们需要综合考虑安全性、便利性、两者的能力边界以及设计目的等因素。

安全性:

Cookies的优势:

Set-Cookie: token=abc123; HttpOnly;Secure;SameSite=Strict;Domain=example.com; Path=/

- HttpOnly:将 HttpOnly 属性设置为 true 可以防止 JavaScript 读取 cookie,从而有效防止 XSS(跨站脚本)攻击读取 token。这一特性使得 cookies 在敏感信息存储上更具安全性。

- Secure:设置 Secure 属性后,cookie 只会在 HTTPS 连接时发送,从而防止中间人攻击。这确保了即使有人截获请求,token 也不会被明文传输。

- SameSite:SameSite 属性减少了 CSRF(跨站请求伪造)攻击的风险,通过指示浏览器在同一站点请求时才发送 cookie。

- Domain 和 Path:这些属性限制了 cookie 的作用范围,例如仅在特定子域或者路径下生效,进一步提高安全性。

localStorage的缺点:

XSS 风险:localStorage 对 JavaScript 代码完全可见,这意味着如果应用存在 XSS 漏洞,攻击者即可轻易获取存储在 localStorage 中的 token。

能力层面

Cookies可以做到更前置更及时的页面访问控制,服务器可以在接收到页面请求时,立即通过读取 cookie 判断用户身份,返回响应的页面(例如重定向到登录页)。

// 示例:后端在接收到请求时可以立即判断

if (!request.cookies.token) {

response.redirect('/login');

}

和cookie相比 localStorage具有一定的滞后性,浏览器必须先加载 HTML 和 JavaScript资源,解析执行后 才能通过在localStorage取到数据后 经过ajax网络请求 发送给服务端判断用户身份,这种方式有滞后性,可能导致临时显示不正确的内容。

管理的便利性

Cookies是由服务端设置的 由浏览器自动管理生命周期的一种方式

服务器可以直接通过 HTTP 响应头设置 cookie,浏览器会自动在后续请求中携带,无需在客户端手动添加。减少了开发和维护负担,且降低了人为错误的风险。

localStorage需要客户端手动管理

使用 localStorage 需要在客户端代码管理 token,你得确保在每个请求中手动添加和删除token,增加了代码复杂度及出错的可能性。

设计目的:

HTTP协议是无状态的 一个用户第二次请求和一个新用户第一次请求 服务端是识别不出来的,cookie是为了让服务端记住客户端而被设计的。

Cookie 设计的初衷就是帮助服务器标识用户的会话状态(如登录状态),因而有很多内建的安全和管理机制,使其特别适合承载 token 等这些用户状态的信息。

localStorage 主要用于存储客户端关心的、较大体积的数据(如用户设置、首选项等),而不是设计来存储需要在每次请求时使用的认证信息。

总结

在大多数需要处理用户身份认证的应用中,将 token 存储在设置了合适属性的 cookie 中,不仅更安全,还更符合 cookie 的设计目的。

通过 HTTP 响应头由服务端设置并自动管理,极大简化了客户端代码,并确保在未经身份验证的情况下阻断对敏感页面的访问。

因此 我认为 在大多数情况下,将 token 存储在 cookies 中更为合理和安全。

补充

然鹅 现实的业务场景往往是复杂多变的 否则也不会有token应该存储在cookie还是localStorage上?这个问题出现了。

localStorage更具灵活性: 不同应用有不同的安全需求,有时 localStorage 可以提供更加灵活和精细化的控制。 开发者可以在 JavaScript 中手动管理 localStorage,包括在每次请求时显式设置认证信息。这种 灵活性 对于一些高级用例和性能优化场景可能非常有用。

所以一般推荐使用cookie 但是在合适的场景下使用localStorage完全没问题。

来源:juejin.cn/post/7433079710382571558

MCP 终极指南

过去快一年的时间没有更新 AI 相关的博客,一方面是在忙 side project,另外一方面也是因为 AI 技术虽然日新月异,但是 AI 应用层的开发并没有多少新的东西,大体还是2023年的博客讲的那三样,Prompt、RAG、Agent。

但是自从去年 11 月底 Claude(Anthropic) 主导发布了 MCP(Model Context Protocol 模型上下文协议) 后,AI 应用层的开发算是进入了新的时代。

不过关于 MCP 的解释和开发,目前似乎还没有太多的资料,所以笔者决定将自己的一些经验和思考整理成一篇文章,希望能够帮助到大家。

为什么 MCP 是一个突破

我们知道过去一年时间,AI 模型的发展非常迅速,从 GPT 4 到 Claude Sonnet 3.5 到 Deepseek R1,推理和幻觉都进步的非常明显。

新的 AI 应用也很多,但我们都能感受到的一点是,目前市场上的 AI 应用基本都是全新的服务,和我们原来常用的服务和系统并没有集成,换句话说,AI 模型和我们已有系统集成发展的很缓慢。

例如我们目前还不能同时通过某个 AI 应用来做到联网搜索、发送邮件、发布自己的博客等等,这些功能单个实现都不是很难,但是如果要全部集成到一个系统里面,就会变得遥不可及。

如果你还没有具体的感受,我们可以思考一下日常开发中,想象一下在 IDE 中,我们可以通过 IDE 的 AI 来完成下面这些工作。

- 询问 AI 来查询本地数据库已有的数据来辅助开发

- 询问 AI 搜索 Github Issue 来判断某问题是不是已知的bug

- 通过 AI 将某个 PR 的意见发送给同事的即时通讯软件(例如 Slack)来 Code Review

- 通过 AI 查询甚至修改当前 AWS、Azure 的配置来完成部署

以上谈到的这些功能通过 MCP 目前正在变为现实,大家可以关注 Cursor MCP 和 Windsurf MCP 获取更多的信息。可以试试用 Cursor MCP + browsertools 插件来体验一下在 Cursor 中自动获取 Chrome dev tools console log 的能力。

为什么 AI 集成已有服务的进展这么缓慢?这里面有很多的原因,一方面是企业级的数据很敏感,大多数企业都要很长的时间和流程来动。另一个方面是技术方面,我们缺少一个开放的、通用的、有共识的协议标准。

MCP 就是 Claude(Anthropic) 主导发布的一个开放的、通用的、有共识的协议标准,如果你是一个对 AI 模型熟悉的开发人员,想必对 Anthropic 这个公司不会陌生,他们发布了 Claude 3.5 Sonnet 的模型,到目前为止应该还是最强的编程 AI 模型(刚写完就发布了 3.7😅)。

这里还是要多提一句,这个协议的发布最好机会应该是属于 OpenAI 的,如果 OpenAI 刚发布 GPT 时就推动协议,相信大家都不会拒绝,但是 OpenAI 变成了 CloseAI,只发布了一个封闭的 GPTs,这种需要主导和共识的标准协议一般很难社区自发形成,一般由行业巨头来主导。

Claude 发布了 MCP 后,官方的 Claude Desktop 就开放了 MCP 功能,并且推动了开源组织 Model Context Protocol,由不同的公司和社区进行参与,例如下面就列举了一些由不同组织发布 MCP 服务器的例子。

MCP 官方集成教学:

- Git - Git 读取、操作、搜索。

- GitHub - Repo 管理、文件操作和 GitHub API 集成。

- Google Maps - 集成 Google Map 获取位置信息。

- PostgreSQL - 只读数据库查询。

- Slack - Slack 消息发送和查询。

🎖️ 第三方平台官方支持 MCP 的例子

由第三方平台构建的 MCP 服务器。

🌎 社区 MCP 服务器

下面是一些由开源社区开发和维护的 MCP 服务器。

- AWS - 用 LLM 操作 AWS 资源。

- Atlassian - 与 Confluence 和 Jira 进行交互,包括搜索/查询 Confluence 空间/页面,访问 Jira Issue 和项目。

- Google Calendar - 与 Google 日历集成,日程安排,查找时间,并添加/删除事件。

- Kubernetes - 连接到 Kubernetes 集群并管理 pods、deployments 和 services。

- X (Twitter) - 与 Twitter API 交互。发布推文并通过查询搜索推文。

- YouTube - 与 YouTube API 集成,视频管理、短视频创作等。

为什么是 MCP?

看到这里你可能有一个问题,在 23 年 OpenAI 发布 GPT function calling 的时候,不是也是可以实现类似的功能吗?我们之前博客介绍的 AI Agent,不就是用来集成不同的服务吗?为什么又出现了 MCP。

function calling、AI Agent、MCP 这三者之间有什么区别?

Function Calling

- Function Calling 指的是 AI 模型根据上下文自动执行函数的机制。

- Function Calling 充当了 AI 模型与外部系统之间的桥梁,不同的模型有不同的 Function Calling 实现,代码集成的方式也不一样。由不同的 AI 模型平台来定义和实现。

如果我们使用 Function Calling,那么需要通过代码给 LLM 提供一组 functions,并且提供清晰的函数描述、函数输入和输出,那么 LLM 就可以根据清晰的结构化数据进行推理,执行函数。

Function Calling 的缺点在于处理不好多轮对话和复杂需求,适合边界清晰、描述明确的任务。如果需要处理很多的任务,那么 Function Calling 的代码比较难维护。

Model Context Protocol (MCP)

- MCP 是一个标准协议,如同电子设备的 Type C 协议(可以充电也可以传输数据),使 AI 模型能够与不同的 API 和数据源无缝交互。

- MCP 旨在替换碎片化的 Agent 代码集成,从而使 AI 系统更可靠,更有效。通过建立通用标准,服务商可以基于协议来推出它们自己服务的 AI 能力,从而支持开发者更快的构建更强大的 AI 应用。开发者也不需要重复造轮子,通过开源项目可以建立强大的 AI Agent 生态。

- MCP 可以在不同的应用/服务之间保持上下文,从而增强整体自主执行任务的能力。

可以理解为 MCP 是将不同任务进行分层处理,每一层都提供特定的能力、描述和限制。而 MCP Client 端根据不同的任务判断,选择是否需要调用某个能力,然后通过每层的输入和输出,构建一个可以处理复杂、多步对话和统一上下文的 Agent。

AI Agent

- AI Agent 是一个智能系统,它可以自主运行以实现特定目标。传统的 AI 聊天仅提供建议或者需要手动执行任务,AI Agent 则可以分析具体情况,做出决策,并自行采取行动。

- AI Agent 可以利用 MCP 提供的功能描述来理解更多的上下文,并在各种平台/服务自动执行任务。

思考

为什么 Claude 推出 MCP 后会被广泛接受呢?其实在过去的一年中我个人也参与了几个小的 AI 项目的开发工作,在开发的过程中,将 AI 模型集成现有的系统或者第三方系统确实挺麻烦。

虽然市面上有一些框架支持 Agent 开发,例如 LangChain Tools, LlamaIndex 或者是 Vercel AI SDK。

LangChain 和 LlamaIndex 虽然都是开源项目,但是整体发展还是挺混乱的,首先是代码的抽象层次太高了,想要推广的都是让开发人员几行代码就完成某某 AI 功能,这在 Demo 阶段是挺好用的,但是在实际开发中,只要业务一旦开始复杂,糟糕的代码设计带来了非常糟糕的编程体验。还有就是这几个项目都太想商业化了,忽略了整体生态的建设。

还有一个就是 Vercel AI SDK,尽管个人觉得 Vercel AI SDK 代码抽象的比较好,但是也只是对于前端 UI 结合和部分 AI 功能的封装还不错,最大的问题是和 Nextjs 绑定太深了,对其它的框架和语言支持度不够。

所以 Claude 推动 MCP 可以说是一个很好的时机,首先是 Claude Sonnet 3.5 在开发人员心中有较高的地位,而 MCP 又是一个开放的标准,所以很多公司和社区都愿意参与进来,希望 Claude 能够一直保持一个良好的开放生态。

MCP 对于社区生态的好处主要是下面两点:

- 开放标准给服务商,服务商可以针对 MCP 开放自己的 API 和部分能力。

- 不需要重复造轮子,开发者可以用已有的开源 MCP 服务来增强自己的 Agent。

MCP 如何工作

那我们来介绍一下 MCP 的工作原理。首先我们看一下官方的 MCP 架构图。

总共分为了下面五个部分:

- MCP Hosts: Hosts 是指 LLM 启动连接的应用程序,像 Cursor, Claude Desktop、Cline 这样的应用程序。

- MCP Clients: 客户端是用来在 Hosts 应用程序内维护与 Server 之间 1:1 连接。

- MCP Servers: 通过标准化的协议,为 Client 端提供上下文、工具和提示。

- Local Data Sources: 本地的文件、数据库和 API。

- Remote Services: 外部的文件、数据库和 API。

整个 MCP 协议核心的在于 Server,因为 Host 和 Client 相信熟悉计算机网络的都不会陌生,非常好理解,但是 Server 如何理解呢?

看看 Cursor 的 AI Agent 发展过程,我们会发现整个 AI 自动化的过程发展会是从 Chat 到 Composer 再进化到完整的 AI Agent。

AI Chat 只是提供建议,如何将 AI 的 response 转化为行为和最终的结果,全部依靠人类,例如手动复制粘贴,或者进行某些修改。

AI Composer 是可以自动修改代码,但是需要人类参与和确认,并且无法做到除了修改代码之外的其它操作。

AI Agent 是一个完全的自动化程序,未来完全可以做到自动读取 Figma 的图片,自动生产代码,自动读取日志,自动调试代码,自动 push 代码到 GitHub。

而 MCP Server 就是为了实现 AI Agent 的自动化而存在的,它是一个中间层,告诉 AI Agent 目前存在哪些服务,哪些 API,哪些数据源,AI Agent 可以根据 Server 提供的信息来决定是否调用某个服务,然后通过 Function Calling 来执行函数。

MCP Server 的工作原理

我们先来看一个简单的例子,假设我们想让 AI Agent 完成自动搜索 GitHub Repository,接着搜索 Issue,然后再判断是否是一个已知的 bug,最后决定是否需要提交一个新的 Issue 的功能。

那么我们就需要创建一个 Github MCP Server,这个 Server 需要提供查找 Repository、搜索 Issues 和创建 Issue 三种能力。

我们直接来看看代码:

const server = new Server(

{

name: "github-mcp-server",

version: VERSION,

},

{

capabilities: {

tools: {},

},

}

);

server.setRequestHandler(ListToolsRequestSchema, async () => {

return {

tools: [

{

name: "search_repositories",

description: "Search for GitHub repositories",

inputSchema: zodToJsonSchema(repository.SearchRepositoriesSchema),

},

{

name: "create_issue",

description: "Create a new issue in a GitHub repository",

inputSchema: zodToJsonSchema(issues.CreateIssueSchema),

},

{

name: "search_issues",

description: "Search for issues and pull requests across GitHub repositories",

inputSchema: zodToJsonSchema(search.SearchIssuesSchema),

}

],

};

});

server.setRequestHandler(CallToolRequestSchema, async (request) => {

try {

if (!request.params.arguments) {

throw new Error("Arguments are required");

}

switch (request.params.name) {

case "search_repositories": {

const args = repository.SearchRepositoriesSchema.parse(request.params.arguments);

const results = await repository.searchRepositories(

args.query,

args.page,

args.perPage

);

return {

content: [{ type: "text", text: JSON.stringify(results, null, 2) }],

};

}

case "create_issue": {

const args = issues.CreateIssueSchema.parse(request.params.arguments);

const { owner, repo, ...options } = args;

const issue = await issues.createIssue(owner, repo, options);

return {

content: [{ type: "text", text: JSON.stringify(issue, null, 2) }],

};

}

case "search_issues": {

const args = search.SearchIssuesSchema.parse(request.params.arguments);

const results = await search.searchIssues(args);

return {

content: [{ type: "text", text: JSON.stringify(results, null, 2) }],

};

}

default:

throw new Error(`Unknown tool: ${request.params.name}`);

}

} catch (error) {}

});

async function runServer() {

const transport = new StdioServerTransport();

await server.connect(transport);

console.error("GitHub MCP Server running on stdio");

}

runServer().catch((error) => {

console.error("Fatal error in main():", error);

process.exit(1);

});

上面的代码中,我们通过 server.setRequestHandler 来告诉 Client 端我们提供了哪些能力,通过 description 字段来描述这个能力的作用,通过 inputSchema 来描述完成这个能力需要的输入参数。

我们再来看看具体的实现代码:

export const SearchOptions = z.object({

q: z.string(),

order: z.enum(["asc", "desc"]).optional(),

page: z.number().min(1).optional(),

per_page: z.number().min(1).max(100).optional(),

});

export const SearchIssuesOptions = SearchOptions.extend({

sort: z.enum([

"comments",

...

]).optional(),

});

export async function searchUsers(params: z.infer<typeof SearchUsersSchema>) {

return githubRequest(buildUrl("https://api.github.com/search/users", params));

}

export const SearchRepositoriesSchema = z.object({

query: z.string().describe("Search query (see GitHub search syntax)"),

page: z.number().optional().describe("Page number for pagination (default: 1)"),

perPage: z.number().optional().describe("Number of results per page (default: 30, max: 100)"),

});

export async function searchRepositories(

query: string,

page: number = 1,

perPage: number = 30

) {

const url = new URL("https://api.github.com/search/repositories");

url.searchParams.append("q", query);

url.searchParams.append("page", page.toString());

url.searchParams.append("per_page", perPage.toString());

const response = await githubRequest(url.toString());

return GitHubSearchResponseSchema.parse(response);

}

可以很清晰的看到,我们最终实现是通过了 https://api.github.com 的 API 来实现和 Github 交互的,我们通过 githubRequest 函数来调用 GitHub 的 API,最后返回结果。

在调用 Github 官方的 API 之前,MCP 的主要工作是描述 Server 提供了哪些能力(给 LLM 提供),需要哪些参数(参数具体的功能是什么),最后返回的结果是什么。

所以 MCP Server 并不是一个新颖的、高深的东西,它只是一个具有共识的协议。

如果我们想要实现一个更强大的 AI Agent,例如我们想让 AI Agent 自动的根据本地错误日志,自动搜索相关的 GitHub Repository,然后搜索 Issue,最后将结果发送到 Slack。

那么我们可能需要创建三个不同的 MCP Server,一个是 Local Log Server,用来查询本地日志;一个是 GitHub Server,用来搜索 Issue;还有一个是 Slack Server,用来发送消息。

AI Agent 在用户输入 我需要查询本地错误日志,将相关的 Issue 发送到 Slack 指令后,自行判断需要调用哪些 MCP Server,并决定调用顺序,最终根据不同 MCP Server 的返回结果来决定是否需要调用下一个 Server,以此来完成整个任务。

如何使用 MCP

如果你还没有尝试过如何使用 MCP 的话,我们可以考虑用 Cursor(本人只尝试过 Cursor),Claude Desktop 或者 Cline 来体验一下。

当然,我们并不需要自己开发 MCP Servers,MCP 的好处就是通用、标准,所以开发者并不需要重复造轮子(但是学习可以重复造轮子)。

首先推荐的是官方组织的一些 Server:官方的 MCP Server 列表。

目前社区的 MCP Server 还是比较混乱,有很多缺少教程和文档,很多的代码功能也有问题,我们可以自行尝试一下 Cursor Directory 的一些例子,具体的配置和实战笔者就不细讲了,大家可以参考官方文档。

MCP 的一些资源

下面是个人推荐的一些 MCP 的资源,大家可以参考一下。

MCP 官方资源

社区的 MCP Server 的列表

写在最后

本篇文章写的比较仓促,如果有错误再所难免,欢迎各位大佬指正。

最后本篇文章可以转载,但是请注明出处,会在 X/Twitter,小红书, 微信公众号 同步发布,欢迎各位大佬关注一波。

References

- guangzhengli.com/blog/zh/gpt…

- docs.cursor.com/context/mod…

- http://www.youtube.com/watch?v=Y_k…

- browsertools.agentdesk.ai/installatio…

- github.com/modelcontex…

- github.com/grafana/mcp…

- github.com/JetBrains/m…

- github.com/stripe/agen…

- github.com/rishikaviko…

- github.com/sooperset/m…

- github.com/v-3/google-…

- github.com/Flux159/mcp…

- github.com/EnesCinr/tw…

- github.com/ZubeidHendr…

- http://www.langchain.com/

- docs.llamaindex.ai/en/stable/

- sdk.vercel.ai/docs/introd…

- modelcontextprotocol.io/introductio…

- github.com/cline/cline

- github.com/modelcontex…

- http://www.anthropic.com/news/model-…

- cursor.directory

- http://www.pulsemcp.com/

- glama.ai/mcp/servers

相关系列文章推荐

来源:juejin.cn/post/7479471387020001306

这次终于轮到前端给后端兜底了🤣

需求交代

最近我们项目组开发了个互联网采集的功能,也就是后端合理抓取了第三方的文章,数据结构大致如下:

<h1>前端人</h1>

<p>学好前端,走遍天下都不怕</p>

数据抓取到后,存储到数据库,然后前端请求接口获取到数据,直接在页面预览

<div v-html='articleContent'></div>

整个需求已经交代清楚

这个需求有点为难后端了

前天,客户说要新增一个文章的pdf导出功能,但就是这么一个合情合理的需求,却把后端为难住了,原因是部分数据采集过来的结构可能是这样的:

<h1>前端人</h1>

<p>学好前端,走遍天下都不怕</p>

<div>前端强,前端狂,交互特效我称王!</div

<p>JS 写得好,需求改不了!</p>

<p>React Vue 两手抓,高薪 offer 到你家!</p>

<p>浏览器里横着走, bug 见我都绕道!</p>

<p>Chrome 调试一声笑, IE 泪洒旧时光!</p>

<span>Git 提交不留情,版本回退我最行!

仔细的人就能发现问题了,很多html元素存在没有完整的闭合情况

但浏览器是强大的,丝毫不影响渲染效果,原来浏览器自动帮我们补全结构了

可后端处理这件事就没那么简单了,爬取到的数据也比我举例的要复杂的多,使用第三方插件将html转pdf时会识别标签异常等问题,因此程序会抛异常

来自后端的建议

苦逼的后端折腾了很久,还是没折腾出来,终于他发现前端页面有个右键打印的功能,也就是:

于是他说:浏览器这玩意整挺好啊,前端能不能研究研究,尝试从前端实现导出

那就研究研究

我印象中,确实有个叫vue-print-nb的前端插件,可以实现这个功能

但.......等等,这个插件仅仅是唤起打印的功能,我总不能真做成这样,让用户另存为pdf吧

于是,只能另辟蹊径,终于我找到了这么个仓库:github.com/burc-li/vue…

里面实现了dom元素导出pdf的功能

效果很不错,技术用到了jspdf、html2canvas这两个第三方库,代码十分简单

const downLoadPdfA4Single = () => {

const pdfContaniner = document.querySelector('#pdfContaniner')

html2canvas(pdfContaniner).then(canvas => {

// 返回图片dataURL,参数:图片格式和清晰度(0-1)

const pageData = canvas.toDataURL('image/jpeg', 1.0)

// 方向纵向,尺寸ponits,纸张格式 a4 即 [595.28, 841.89]

const A4Width = 595.28

const A4Height = 841.89 // A4纸宽

const pageHeight = A4Height >= A4Width * canvas.height / canvas.width ? A4Height : A4Width * canvas.height / canvas.width

const pdf = new jsPDF('portrait', 'pt', [A4Width, pageHeight])

// addImage后两个参数控制添加图片的尺寸,此处将页面高度按照a4纸宽高比列进行压缩

pdf.addImage(

pageData,

'JPEG',

0,

0,

A4Width,

A4Width * canvas.height / canvas.width,

)

pdf.save('下载一页PDF(A4纸).pdf')

})

}

技术流程大致就是:

- dom -> canvas

- canvas -> image

- image -> pdf

似乎一切都将水到渠成了

困在眼前的难题

这个技术栈,最核心的就是:必须要用到dom元素渲染

如果你尝试将打印的元素设置样式:

display: none;

或

visibility: hidden;

或

opacity: 0;

执行导出功能都将抛异常或者只能导出一个空白的pdf

这时候有人会问了:为什么要设置dom元素为不可见?

试想一下,你做了一个导出功能,总不能让客户必须先打开页面等html渲染完后,再导出吧?

客户的理想状态是:在列表的操作列里,有个导出按钮,点击就可以导出pdf了

何况还需要实现批量勾选导出的功能,总不能程序控制,导出一个pdf就open一个窗口渲染html吧

寻找新方法

此路不通,就只能重新寻找新的方向,不过也没费太多功夫,就找到了另外一个插件html2pdf.js解决了这事

这插件用起来也极其简单

npm install html2pdf.js

<template>

<div class="container">

<button @click="generatePDF">下载PDF</button>

</div>

</template>

<script setup>

import html2pdf from 'html2pdf.js'

// 使用示例

let element = `

<h1>前端人</h1>

<p>学好前端,走遍天下都不怕</p>

<div>前端强,前端狂,交互特效我称王!</div

<p>JS 写得好,需求改不了!</p>

<p>React Vue 两手抓,高薪 offer 到你家!</p>

<p>浏览器里横着走, bug 见我都绕道!</p>

<p>Chrome 调试一声笑, IE 泪洒旧时光!</p>

<span>Git 提交不留情,版本回退我最行!

`;

function generatePDF() {

// 配置选项

const opt = {

margin: 10,

filename: 'hello_world.pdf',

image: { type: 'jpeg', quality: 0.98 },

html2canvas: { scale: 2 },

jsPDF: { unit: 'mm', format: 'a4', orientation: 'portrait' }

};

// 生成PDF并导出

html2pdf().from(element).set(opt).save();

}

</script>

功能正常,似乎一切都完美

问题没有想的那么简单

如果我们的html是纯文本元素,这程序跑起来没有任何问题,但我们抓取的信息都源于互联网,html结构怎么可能会这么简单?如果我们的html中包含图片信息,例如:

// 使用示例

let element = `

<div>

<img src='http://t13.baidu.com/it/u=2041049195,1001882902&fm=224&app=112&f=JPEG?w=500&h=500' style="width: 300px;" />

<p>职业:前端</p>

<p>技能:唱、跳、rap</p>

</div>

`;

此时你会发现,导出来的pdf,图片占位处是个空白块

思考一下:类似案例中的图片加载方式,都是get方式的异步请求,而异步请求就会导致图片还没渲染完成,但导出的程序已经执行完成情况(最直接的观察方式就是,把这个元素放到浏览器上渲染,会发现图片也是过一会才慢慢加载完成的)

不过我不确定

html2pdf.js这个插件是否会发起图片请求,但不管发不发起,导出的行为明显是在图片渲染前完成的,就导致了这个空白块的存在

问题分析完了,那就解决吧

既然图片异步加载不行,那就使用图片同步加载吧

不是吧,你问我:什么是图片同步加载?我也不晓得,这个词是我自己当下凭感觉造的,如有雷同,纯属巧合了

那我理解的图片同步加载是什么意思呢?简单来说,就是将图片转成Base64,因为这种方式,即使说无网的情况也能正常加载图片,因此我凭感觉断定,这就是图片同步加载

基于这个思路,我写了个demo

<template>

<div class="container">

<button @click="generatePDF">下载PDF</button>

</div>

</template>

<script setup>

import html2pdf from 'html2pdf.js'

async function convertImagesToBase64(htmlString) {

// 创建一个临时DOM元素来解析HTML

const tempDiv = document.createElement('div');

tempDiv.innerHTML = htmlString;

// 获取所有图片元素

const images = tempDiv.querySelectorAll('img');

// 遍历每个图片并转换

for (const img of images) {

try {

const base64 = await getBase64FromUrl(img.src);

img.src = base64;

} catch (error) {

console.error(`无法转换图片 ${img.src}:`, error);

// 保留原始URL如果转换失败

}

}

// 返回转换后的HTML

return tempDiv.innerHTML;

}

// 图片转base64

function getBase64FromUrl(url) {

return new Promise((resolve, reject) => {

const img = new Image();

img.crossOrigin = 'Anonymous'; // 处理跨域问题

img.onload = () => {

const canvas = document.createElement('canvas');

canvas.width = img.width;