为什么现在连Date类都不建议使用了?

本文已经授权【稀土掘金技术社区】官方公众号独家原创发布。

一、有什么问题吗java.util.Date?

java.util.Date(Date从现在开始)是一个糟糕的类型,这解释了为什么它的大部分内容在 Java 1.1 中被弃用(但不幸的是仍在使用)。

设计缺陷包括:

- 它的名称具有误导性:它并不代表 a

Date,而是代表时间的一个瞬间。所以它应该被称为Instant——正如它的java.time等价物一样。 - 它是非最终的:这鼓励了对继承的不良使用,例如

java.sql.Date(这意味着代表一个日期,并且由于具有相同的短名称而也令人困惑) - 它是可变的:日期/时间类型是自然值,可以通过不可变类型有效地建模。可变的事实

Date(例如通过setTime方法)意味着勤奋的开发人员最终会在各处创建防御性副本。 - 它在许多地方(包括)隐式使用系统本地时区,

toString()这让许多开发人员感到困惑。有关此内容的更多信息,请参阅“什么是即时”部分 - 它的月份编号是从 0 开始的,是从 C 语言复制的。这导致了很多很多相差一的错误。

- 它的年份编号是基于 1900 年的,也是从 C 语言复制的。当然,当 Java 出现时,我们已经意识到这不利于可读性?

- 它的方法命名不明确:

getDate()返回月份中的某一天,并getDay()返回星期几。给这些更具描述性的名字有多难? - 对于是否支持闰秒含糊其辞:“秒由 0 到 61 之间的整数表示;值 60 和 61 仅在闰秒时出现,即使如此,也仅在实际正确跟踪闰秒的 Java 实现中出现。” 我强烈怀疑大多数开发人员(包括我自己)都做了很多假设,认为 for 的范围

getSeconds()实际上在 0-59 范围内(含)。 - 它的宽容没有明显的理由:“在所有情况下,为这些目的而对方法给出的论据不必落在指定的范围内; 例如,日期可以指定为 1 月 32 日,并被解释为 2 月 1 日。” 多久有用一次?

原文如下:为什么要避免使用Date类?

二、为啥要改?

我们要改的原因很简单,我们的代码缺陷扫描规则认为这是一个必须修改的缺陷,否则不给发布,不改不行,服了。

解决思路:避免使用

java.util.Date与java.sql.Date类和其提供的API,考虑使用java.time.Instant类或java.time.LocalDateTime类及其提供的API替代。

三、怎么改?

只能说这种基础的类改起来牵一发动全身,需要从DO实体类看起,然后就是各种Converter,最后是DTO。由于我们还是微服务架构,业务服务依赖于基础服务的API,所以必须要一起改否则就会报错。这里就不细说修改流程了,主要说一下我们在改造的时候遇到的一些问题。

1. 耐心比对数据库日期字段和DO的映射

(1)确定字段类型

首先你需要确定数据对象中的 Date 字段代表的是日期、时间还是时间戳。

- 如果字段代表日期和时间,则可能需要使用

LocalDateTime。 - 如果字段仅代表日期,则可能需要使用

LocalDate。 - 如果字段仅代表时间,则可能需要使用

LocalTime。 - 如果字段需要保存时间戳(带时区的),则可能需要使用

Instant或ZonedDateTime。

(2)更新数据对象类

更新数据对象类中的字段,把 Date 类型改为适当的 java.time 类型。

2. 将DateUtil中的方法改造

(1)替换原来的new Date()和Calendar.getInstance().getTime()

原来的方式:

Date nowDate = new Date();

Date nowCalendarDate = Calendar.getInstance().getTime();

使用 java.time 改造后:

// 使用Instant代表一个时间点,这与Date类似

Instant nowInstant = Instant.now();

// 如果需要用到具体的日期和时间(例如年、月、日、时、分、秒)

LocalDateTime nowLocalDateTime = LocalDateTime.now();

// 如果你需要和特定的时区交互,可以使用ZonedDateTime

ZonedDateTime nowZonedDateTime = ZonedDateTime.now();

// 如果你需要转换回java.util.Date,你可以这样做(假设你的代码其他部分还需要使用Date)

Date nowFromDateInstant = Date.from(nowInstant);

// 如果需要与java.sql.Timestamp交互

java.sql.Timestamp nowFromInstant = java.sql.Timestamp.from(nowInstant);

一些注意点:

Instant表示的是一个时间点,它是时区无关的,相当于旧的Date类。它通常用于表示时间戳。LocalDateTime表示没有时区信息的日期和时间,它不能直接转换为时间戳,除非你将其与时区结合使用(例如通过ZonedDateTime)。ZonedDateTime包含时区信息的日期和时间,它更类似于Calendar,因为Calendar也包含时区信息。- 当你需要将

java.time对象转换回java.util.Date对象时,可以使用Date.from(Instant)方法。这在你的代码需要与旧的API或库交互时非常有用。

(2)一些基础的方法改造

a. dateFormat

原来的方式

public static String dateFormat(Date date, String dateFormat) {

SimpleDateFormat formatter = new SimpleDateFormat(dateFormat);

return formatter.format(date);

}

使用java.time改造后

public static String dateFormat(LocalDateTime date, String dateFormat) {

DateTimeFormatter formatter = DateTimeFormatter.ofPattern(dateFormat);

return date.format(formatter);

}

b. addSecond、addMinute、addHour、addDay、addMonth、addYear

原来的方式

public static Date addSecond(Date date, int second) {

Calendar calendar = Calendar.getInstance();

calendar.setTime(date);

calendar.add(13, second);

return calendar.getTime();

}

public static Date addMinute(Date date, int minute) {

Calendar calendar = Calendar.getInstance();

calendar.setTime(date);

calendar.add(12, minute);

return calendar.getTime();

}

public static Date addHour(Date date, int hour) {

Calendar calendar = Calendar.getInstance();

calendar.setTime(date);

calendar.add(10, hour);

return calendar.getTime();

}

public static Date addDay(Date date, int day) {

Calendar calendar = Calendar.getInstance();

calendar.setTime(date);

calendar.add(5, day);

return calendar.getTime();

}

public static Date addMonth(Date date, int month) {

Calendar calendar = Calendar.getInstance();

calendar.setTime(date);

calendar.add(2, month);

return calendar.getTime();

}

public static Date addYear(Date date, int year) {

Calendar calendar = Calendar.getInstance();

calendar.setTime(date);

calendar.add(1, year);

return calendar.getTime();

}

使用java.time改造后

public static LocalDateTime addSecond(LocalDateTime date, int second) {

return date.plusSeconds(second);

}

public static LocalDateTime addMinute(LocalDateTime date, int minute) {

return date.plusMinutes(minute);

}

public static LocalDateTime addHour(LocalDateTime date, int hour) {

return date.plusHours(hour);

}

public static LocalDateTime addDay(LocalDateTime date, int day) {

return date.plusDays(day);

}

public static LocalDateTime addMonth(LocalDateTime date, int month) {

return date.plusMonths(month);

}

public static LocalDateTime addYear(LocalDateTime date, int year) {

return date.plusYears(year);

}

c. dateToWeek

原来的方式

public static final String[] WEEK_DAY_OF_CHINESE = new String[]{"周日", "周一", "周二", "周三", "周四", "周五", "周六"};

public static String dateToWeek(Date date) {

Calendar cal = Calendar.getInstance();

cal.setTime(date);

return WEEK_DAY_OF_CHINESE[cal.get(7) - 1];

}

使用java.time改造后

public static final String[] WEEK_DAY_OF_CHINESE = new String[]{"周日", "周一", "周二", "周三", "周四", "周五", "周六"};

public static String dateToWeek(LocalDate date) {

DayOfWeek dayOfWeek = date.getDayOfWeek();

return WEEK_DAY_OF_CHINESE[dayOfWeek.getValue() % 7];

}

d. getStartOfDay和getEndOfDay

原来的方式

public static Date getStartTimeOfDay(Date date) {

if (date == null) {

return null;

} else {

LocalDateTime localDateTime = LocalDateTime.ofInstant(Instant.ofEpochMilli(date.getTime()), ZoneId.systemDefault());

LocalDateTime startOfDay = localDateTime.with(LocalTime.MIN);

return Date.from(startOfDay.atZone(ZoneId.systemDefault()).toInstant());

}

}

public static Date getEndTimeOfDay(Date date) {

if (date == null) {

return null;

} else {

LocalDateTime localDateTime = LocalDateTime.ofInstant(Instant.ofEpochMilli(date.getTime()), ZoneId.systemDefault());

LocalDateTime endOfDay = localDateTime.with(LocalTime.MAX);

return Date.from(endOfDay.atZone(ZoneId.systemDefault()).toInstant());

}

}

使用java.time改造后

public static LocalDateTime getStartTimeOfDay(LocalDateTime date) {

if (date == null) {

return null;

} else {

// 获取一天的开始时间,即00:00

return date.toLocalDate().atStartOfDay();

}

}

public static LocalDateTime getEndTimeOfDay(LocalDateTime date) {

if (date == null) {

return null;

} else {

// 获取一天的结束时间,即23:59:59.999999999

return date.toLocalDate().atTime(LocalTime.MAX);

}

}

e. betweenStartAndEnd

原来的方式

public static Boolean betweenStartAndEnd(Date nowTime, Date beginTime, Date endTime) {

Calendar date = Calendar.getInstance();

date.setTime(nowTime);

Calendar begin = Calendar.getInstance();

begin.setTime(beginTime);

Calendar end = Calendar.getInstance();

end.setTime(endTime);

return date.after(begin) && date.before(end);

}

使用java.time改造后

public static Boolean betweenStartAndEnd(Instant nowTime, Instant beginTime, Instant endTime) {

return nowTime.isAfter(beginTime) && nowTime.isBefore(endTime);

}

我这里就只列了一些,如果有缺失的可以自己补充,不会写的话直接问问ChatGPT,它最会干这事了。最后把这些修改后的方法替换一下就行了。

四、小结一下

这个改造难度不高,但是复杂度非常高,一个地方没改好,轻则接口报错,重则启动失败,非常耗费精力,真不想改。

文末小彩蛋,自建摸鱼网站,各大网站热搜一览,上班和摸鱼很配哦!

来源:juejin.cn/post/7343161506699313162

延迟双删如此好用,为何大厂从来不用

摘要: 在绝大多数介绍缓存与数据库一致性方案的文章中,随着 Cache-aside 模式的数据变更几乎无例外的推荐使用删除缓存的策略,为进一步降低数据不一致的风险通常会配合延迟双删的策略。但是令人意外的是,在一些互联网大厂中的核心业务却很少使用这种方式。这背后的原因是什么呢?延迟双删策略有什么致命缺陷么?以及这些大厂如何选择缓存与数据库一致性保障的策略呢?如果你对此同样抱有有疑问的话,希望本文能为你答疑解惑。

当数据库(主副本)数据记录变更时,为了降低缓存数据不一致状态的持续时间,通常会选择主动 失效 / 更新 缓存数据的方式。绝大多数应用系统的设计方案中会选择通过删除缓存数据的方式使其失效。但同样会出现数据不一致的情况,具体情况参见下图:

所以延迟双删又成为了组合出现的常见模式。延迟双删最复杂的技术实现在于对延迟时间的确定上,间隔时间久的话数据不一致的状态持续时间会变长,如果间隔时间过短可能无法起到一致性保障的作用。所以基于经验会将这个时间设定在秒级,如 1-2 秒后执行第二次删除操作。

延迟双删的致命缺陷

但是延迟时间最大的问题不在于此,而是两次删除缓存数据引起的缓存穿透,短时间对数据库(主副本)造成的流量与负载压力。绝大多数应用系统本身流量与负载并不高,使用缓存通常是为了提升系统性能表现,数据库(主副本)完全可以承载一段时间内的负载压力。对于此类系统延迟双删是一个完全可以接受的高性价比策略。

现实世界中的系统响应慢所带来的却是流量的加倍上涨。回想一下当你面对 App 响应慢的情况,是如何反应与对待便能明白,几乎所有用户的下意识行为都是如出一辙。

所以对于那些流量巨大的应用系统而言,短时的访问流量穿透缓存访问数据库(主副本),恐怕很难接受。为了应对这种流量穿透的情况,通常需要增加数据库(主副本)的部署规格或节点。而且这类应用系统的响应变慢的时候,会对其支持系统产生影响,如果其支持系统较多的情况下,会存在影响的增溢。相比延迟双删在技术实现上带来高效便捷而言,其对系统的影响与副作用则变得不可忽视。

Facebook(今 Meta)解决方案

早在 2013 年由 Facebook(今 Meta)发表的论文 “Scaling Memcache at Facebook” 中便提供了其内部的解决方案,通过提供一种类似 “锁” 的 “leases”(本文译为“租约”)机制防止并发带来的数据不一致现象。

租约机制实现方法大致如下:

当有多个请求抵达缓存时,缓存中并不存在该值时会返回给客户端一个 64 位的 token ,这个 token 会记录该请求,同时该 token 会和缓存键作为绑定,该 token 即为上文中租约的值,客户端在更新时需要传递这个 token ,缓存验证通过后会进行数据的存储。其他请求需要等待这个租约过期后才可申请新的租约。

可结合下图辅助理解其作用机制。也可阅读缓存与主副本数据一致性系统设计方案(下篇)一文中的如何解决并发数据不一致,又能避免延迟双删带来的惊群问题章节进一步了解。

简易参考实现

接下来我们以 Redis 为例,提供一个 Java 版本的简易参考实现。本文中会给出实现所涉及的关键要素与核心代码,你可以访问 Github 项目 来了解整个样例工程,并通过查阅 Issue 与 commits 来了解整个样例工程的演化进程。

要想实现上述租约机制,需要关注的核心要素有三个:

- 需要复写 Redis 数据获取操作,当 Redis 中数据不存在时增加对租约的设置;

- 需要复写 Redis 数据设置操作,当设置 Redis 中数据时校验租约的有效性;

- 最后是当数据库(主副本)数据变更时,删除 Redis 数据同时要连带删除租约信息。

同时为了保障 Redis 操作的原子性,我们需要借助 Lua 脚本来实现上述三点。这里以字符串类型为例,对应脚本分别如下:

Redis 数据获取操作

返回值的第二个属性作为判断是否需要执行数据获取的判断依据。当为 false 时表示 Redis 中无对应数据,需要从数据库中加载,同时保存了当前请求与 key 对应的租约信息。

local key = KEYS[1]

local token = ARGV[1]

local value = redis.call('get', key)

if not value then

redis.replicate_commands()

local lease_key = 'lease:'..key

redis.call('set', lease_key, token)

return {false, false}

else

return {value, true}

end

Redis 数据设置操作

返回值的第二个属性作为判断是否成功执行数据设置操作的依据。该属性为 false 表示租约校验失败,未成功执行数据设置操作。同时意味着有其他进程/线程 执行数据查询操作并对该 key 设置了新的租约。

local key = KEYS[1]

local token = ARGV[1]

local value = ARGV[2]

local lease_key = 'lease:'..key

local lease_value = redis.call('get', lease_key)

if lease_value == token then

redis.replicate_commands()

redis.call('set', key, value)

return {value, true}

else

return {false, false}

end

Redis 数据删除操作

当数据库变更进程/线程 完成数据变更操作后,尝试删除缓存需要同时清理对应数据记录的 key 以及其关联租约 key。防止数据变更前的查询操作通过租约校验,将旧数据写入 Redis 。

local key = KEYS[1]

local token = ARGV[1]

local lease_key = 'lease:'..key

redis.call('del', key, leask_key)

该方案主要的影响在应用层实现,主要在集中在三个方面:

- 应用层不能调用 Redis 数据类型的原始操作命令,而是改为调用 EVAL 命令;

- 调用 Redis 返回结果数据结构的变更为数组,需要解析数组;

- 应用层对于 Redis 的操作变复杂,需要生成租约用的 token,并根据每个阶段返回结果进行后续处理;

为应对上述三点变化,对应操作 Redis 的 Java 实现如下:

封装返回结果

为便于后续操作,首先是对脚本返回结果的封装。

public class EvalResult {

String value;

boolean effect;

public EvalResult(List<?> args) {

value = (String) args.get(0);

if (args.get(1) == null) {

effect = false;

} else {

effect = 1 == (long) args.get(1);

}

}

}

组件设计

封装 Redis 操作

因为在样例工程中独立出了一个 Query Engine 组件,所以需要跨组件传递 token,这里为了实现简单采用了 ThreadLocal 进行 token 的传递,具体系统可查阅样例工程中的用例。

public class LeaseWrapper extends Jedis implements CacheCommands {

private final Jedis jedis;

private final TokenGenerator tokenGenerator;

private final ThreadLocal<String> tokenHolder;

public LeaseWrapper(Jedis jedis) {

this.jedis = jedis;

this.tokenHolder = new ThreadLocal<>();

this.tokenGenerator = () -> UUID.randomUUID().toString();

}

@Override

public String get(String key) {

String token = this.tokenGenerator.get();

tokenHolder.set(token);

Object result = this.jedis.eval(LuaScripts.leaseGet(), List.of(key), List.of(token));

EvalResult er = new EvalResult((List<?>) result);

if (er.effect()) {

return er.value();

}

return null;

}

@Override

public String set(String key, String value) {

String token = tokenHolder.get();

tokenHolder.remove();

Object result = this.jedis.eval(LuaScripts.leaseSet(), List.of(key), List.of(token, value));

EvalResult er = new EvalResult((List<?>) result);

if (er.effect()) {

return er.value();

}

return null;

}

}

补充

在上面的简易参考实现中,我们并没有实现其他请求需要等待这个租约过期后才可申请新的租约。该功能主要是防止惊群问题,进一步降低可能对数据库造成的访问压力。要实现该功能需要在 Redis 数据获取操作中改进脚本:

local key = KEYS[1]

local token = ARGV[1]

local value = redis.call('get', key)

if not value then

redis.replicate_commands()

local lease_key = 'lease:'..key

local current_token = redis.call('get', lease_key)

if not current_token or token == current_token then

redis.call('set', lease_key, token)

return {token, false}

else

return {current_token, false}

end

else

return {value, true}

end

同时也可以为租约数据设定一个短时 TTL,并在应用层通过对 EvalResult 的 effect 判断为 false 的情况下等待一段时间后再次执行。

上述实现的复杂点在于租约过期的时间的选取,以及超过设定时间的逻辑处理。我们可以实现类似自旋锁的机制,在最大等待时间内随时等待一个间隙向 Redis 发起查询请求,超过最大等待时间后直接查询数据库(主副本)获取数据。

Uber 解决方案

在 Uber 今年 2 月份发表的一篇技术博客 “How Uber Serves Over 40 Million Reads Per Second from Online Storage Using an Integrated Cache” 中透露了其内部的解决方案,通过比对版本号的方式避免将旧数据写入缓存。

版本号比对机制实现方法大致如下:

将数据库中行记录的时间戳作为版本号,通过 Lua 脚本通过 Redis EVAL 命令提供类似 MSET 的更新操作,基于自定义编解码器提取 Redis 记录中的版本号,在执行数据设置操作时进行比对,只写入较新的数据。

其中 Redis 的数据记录对应的 Key-Value 编码格式如所示:

简易参考实现

接下来我们以 Redis 为例,提供一个 Java 版本的简易参考实现。本文中会给出实现所涉及的关键要素与核心代码,你可以访问 Github 项目 来了解整个样例工程,并通过查阅 Issue 与 commits 来了解整个样例工程的演化进程。

我们这里不采取定制数据格式,而是通过额外的缓存 Key 存储数据版本,要想实现类似版本号比对机制,需要关注的核心要素有两个:

- 需要复写 Redis 数据设置操作,当设置 Redis 中数据时校验版本号;

- 在版本号比对通过后需要绑定版本号数据,与主数据同步写入 Redis 中。

同时为了保障 Redis 操作的原子性,我们需要借助 Lua 脚本来实现上述两点。这里以字符串类型为例,对应脚本分别如下:

Redis 数据设置操作

返回值的第二个属性作为判断是否成功执行数据设置操作的依据。该属性为 false 表示数据未成功写入 Redis。同时意味当前 进程/线程 执行写入的数据为历史数据,在次过程中数据已经发生变更并又其他数据写入。

local key = KEYS[1]

local value = ARGV[1]

local current_version = ARGV[2]

local version_key = 'version:'..key

local version_value = redis.call('get', version_key)

if version_value == false or version_value < current_version then

redis.call('mset', version_key, current_version, key, value)

return {value, true}

else

return {false, false}

end

该方案主要的影响在应用层实现,需要在调用 Redis 的 EVAL 命令前从数据实体中提取时间戳作为版本号,同时需要保障数据实体中包含时间戳相关属性。

封装 Redis 操作

结合我们的样例工程代码,我们通过实现 VersionWrapper 对 Redis 的操作进行如下封装。

public class VersionWrapper extends Jedis implements CacheCommands {

private final Jedis jedis;

public VersionWrapper(Jedis jedis) {

this.jedis = jedis;

}

@Override

public String set(String key, String value, String version) {

Object result = this.jedis.eval(LuaScripts.versionSet(), List.of(key), List.of(value, version));

EvalResult er = new EvalResult((List<?>) result);

if (er.effect()) {

return er.value();

}

return null;

}

}

补充

透过该方案我们推测 Uber 采取的并非数据变更后删除缓存的策略,很可能是更新缓存的策略(在 Uber 的技术博客中也间接的提到了更新缓存的策略)。

因为整个版本号比对的方式与删除缓存的逻辑相悖。我们抛开 Uber CacheFront 的整体架构,仅仅将该方案应用在简单架构模型中。采取删除缓存的策略,可能会产生如下图所示的结果,此时应用服务 Server - 2 因为查询缓存未获取到值,而从数据库加载并写入缓存,但是此时缓存中写入的为历史旧值,而在该数据过期前或者下次数据变更前,都不会再触发更新了。

当然对于更新缓存的策略同样面临这个问题,因为当数据变更发生期间,缓存中并没有该数据记录时,通常我们不会采取主动刷新缓存的策略,那么则依然会面对上面的问题。

而 Uber 的 CacheFront 基于企业内部的 Flux 技术组件实现对缓存的异步处理,通过阅读文章我们也可以发现这个异步延迟在秒级,那么在如此长的时间间隙后,无论采用删除还是更新策略想要产生上图中的不一致现象都比较难,因为对应用系统来说,进程/线程阻塞 2-3 秒是很难以忍受的现象,所以通常不会出现如此漫长的阻塞与卡顿。

如果你想进一步了解如何实现与 Uber 利用 Flux 实现缓存异步处理的内容,也可阅读我们此前缓存与主副本数据一致性系统设计方案(下篇)文章中更新主副本数据后更新缓存并发问题解决方案章节。

总结

本文并非对延迟双删的全盘否定,而是强调在特殊场景下,延迟双删策略的弊端会被放大,进而完全盖过其优势。对于那些业务体量大伴随着流量大的应用系统,必应要从中权衡取舍。

每一种策略都仅适配应用系统生命周期的一段。只不过部分企业随着业务发展逐步壮大,其研发基础设施的能力也更完善。从而为系统设计带来诸多便捷,从而使得技术决策变得与中小研发团队截然不同。

所以当我们在学习他人经验的过程中,到了落地执行环节一定要结合实际团队背景、业务需求、开发周期与资金预算进行灵活适配。如果你希望了解更多技术中立(排除特定基础设施)的系统设计方案,欢迎你关注我的账号或订阅我的系统设计实战:常用架构与模式详解专栏,我将在其中持续更新技术中立的系统设计系列文章。如果您发现文章内容中任何不准确或遗漏的部分。非常希望您能评论指正,我将尽快修正疏漏,为大家提供优质技术内容。

相关阅读

- 缓存与主副本数据一致性系统设计方案

- System-Design-Codebase

- Scaling Memcache at Facebook

- How Uber Serves Over 40 Million Reads Per Second from Online Storage Using an Integrated Cache

你好,我是 HAibiiin,一名探索技术之外更多可能性的 Product Engineer。如果本篇文章对你有所启发或提供了一定价值,还请不要吝啬点赞、收藏和关注。

来源:juejin.cn/post/7447033901657096202

被阿里抛弃的那个项目,救活了!

众所周知,上个月的时候,GitHub 知名开源项目 EasyExcel 曾对外发布公告将停止主动更新,当时这个消息在网上还引发了不少讨论。

至此,这个运营了 6 年,在 GitHub 上累计收获 32k+ star 的知名项目基本就宣告停更了,大家都觉得挺可惜的。

然而,就在阿里官宣停更的同时,EasyExcel 的原作者个人当即也站出来向大家透露了一个新项目计划,表示自己将会继续接手,并重启一个新项目开源出来。

那现在,这个承诺已经如期兑现了!

就在上周,EasyExcel 作者自己也正式发文表示,EasyExcel 的替代方案正式来了,相信不少同学也看到了这个消息。

作者把新项目定名为:FastExcel(ps:作者一开始初定叫 EasyExcel-Plus,后来改名为了 FastExcel),用于取代已经被阿里官方停更的 EasyExcel 项目。

新项目 FastExcel 同样定位在一个基于 Java 的、快速、简洁、解决大文件内存溢出的 Excel 处理工具。

并且新项目将兼容老的已停更的 EasyExcel 项目,并提供项目维护、性能优化、以及bugFix。

同时作者还表示,新项目 FastExcel 将始终坚持免费开源,并采用最开放的 MIT 协议,使其适用于任何商业化场景,以便为广大开发者和企业继续提供极大的自由度和灵活性。

不得不说,作者的格局还是相当打开的。

大家都知道,其实 EasyExcel 项目的作者原本就是工作在阿里,负责主导并维护着这个项目。

然而就在去年,Easyexcel 作者就从阿里离职出来创业了。

所以在上个月 EasyExcel 被宣布停更的时候,当时就有不少网友猜测各种原因。当然背后的真相我们不得而知,不过作为用户的角度来看,Easyexcel 以另外一种形式被继续开源和更新也何尝不是一件利好用户的好消息。

之前的 EasyExcel 之所以受到开发者们的广泛关注,主要是因为它具备了许多显著的特点和优势,而这次的新项目 FastExcel 更可谓是有过之而无不及。

- 首先,FastExcel 同样拥有卓越的读写性能,能够高效地处理大规模的Excel数据,这对于需要处理大量数据的开发者来说依然是一大福音。

- 其次,FastExcel 的 API设计简洁直观,开发者可以轻松上手,无需花费大量时间学习和熟悉。

- 再者,FastExcel 同样支持流式读取,可以显著降低内存占用,避免在处理大规模数据时可能出现的内存溢出问题。

- 此外,新项目 FastExcel 完全兼容原来 EasyExcel 的功能和特性,用户可以在项目中无缝过渡,从 EasyExcel 迁移到 FastExcel 只需更换包名和依赖即可完成升级。

FastExcel 的安装配置也非常简单。

对于使用 Maven 或 Gradle 进行构建的项目来说,只需在相应的配置文件中添加如下所示的 FastExcel 的依赖即可。

- Maven项目

<dependency>

<groupId>cn.idev.excel</groupId>

<artifactId>fastexcel</artifactId>

<version>1.0.0</version>

</dependency>

- Gradle项目

dependencies {

implementation 'cn.idev.excel:fastexcel:1.0.0'

}

在实际使用中,以读取Excel文件为例,开发者只需定义一个数据类和一个监听器类,然后在主函数中调用 FastExcel 的读取方法,并传入数据类和监听器类即可。

FastExcel 会自动解析 Excel 文件中的数据,并将其存储到数据类的实例中,同时触发监听器类中的方法,让开发者可以对解析到的数据进行处理。

// 实现 ReadListener 接口,设置读取数据的操作

public class DemoDataListener implements ReadListener<DemoData> {

@Override

public void invoke(DemoData data, AnalysisContext context) {

System.out.println("解析到一条数据" + JSON.toJSONString(data));

}

@Override

public void doAfterAllAnalysed(AnalysisContext context) {

System.out.println("所有数据解析完成!");

}

}

public static void main(String[] args) {

String fileName = "demo.xlsx";

// 读取 Excel 文件

FastExcel.read(fileName, DemoData.class, new DemoDataListener()).sheet().doRead();

}

同样地,写 Excel 文件也非常简单,开发者只需定义一个数据类,并填充要写入的数据,然后调用 FastExcel 的写入方法即可。

// 示例数据类

public class DemoData {

@ExcelProperty("字符串标题")

private String string;

@ExcelProperty("日期标题")

private Date date;

@ExcelProperty("数字标题")

private Double doubleData;

@ExcelIgnore

private String ignore;

}

// 填充要写入的数据

private static List<DemoData> data() {

List<DemoData> list = new ArrayList<>();

for (int i = 0; i < 10; i++) {

DemoData data = new DemoData();

data.setString("字符串" + i);

data.setDate(new Date());

data.setDoubleData(0.56);

list.add(data);

}

return list;

}

public static void main(String[] args) {

String fileName = "demo.xlsx";

// 创建一个名为“模板”的 sheet 页,并写入数据

FastExcel.write(fileName, DemoData.class).sheet("模板").doWrite(data());

}

过程可谓是清晰易懂、直观明了,所以这对于开发者来说,在使用 FastExcel 时可以轻松上手。

新项目 FastExcel 刚开源不久,目前在 GitHub 上的 star 标星就已经突破了 2000!这也可见其受欢迎程度。

而且伴随着新项目的开源上线,开发者们的参与热情也是十分高涨的。

这才多少天,项目就已经收到上百条issue了。

仔细看了一下会发现,其中一大部分是开发者们对于新项目所提的需求或反馈。

而还有另外一部分则是对于新项目 FastExcel 以及作者的肯定与鼓励。

文章的最后也感谢项目作者的辛勤维护,大家有需要的话也可以上去提需求或者反馈一些意见,另外感兴趣的同学也可以上去研究研究相关的代码或者参与项目,尤其是数据处理这一块,应该会挺有收获的。

注:本文在GitHub开源仓库「编程之路」 github.com/rd2coding/R… 中已经收录,里面有我整理的6大编程方向(岗位)的自学路线+知识点大梳理、面试考点、我的简历、几本硬核pdf笔记,以及程序员生活和感悟,欢迎star。

来源:juejin.cn/post/7450088304001728523

面试官:GROUP BY和DISTINCT有什么区别?

在 MySQL 中,GR0UP BY 和 DISTINCT 都是用来处理查询结果中的重复数据,并且在官方的描述文档中也可以看出:在大多数情况下 DISTINCT 是特殊的 GR0UP BY,如下图所示:

官方文档地址:dev.mysql.com/doc/refman/…

但二者还是有一些细微的不同,接下来一起来看。

1.DISTINCT 介绍

- 用途:DISTINCT 用于从查询结果中去除重复的行,确保返回的结果集中每一行都是唯一的。

- 语法:通常用于 SELECT 语句中,紧跟在 SELECT 关键字之后。例如以下 SQL:

SELECT DISTINCT column1, column2 FROM table_name;

- 工作机制:DISTINCT 会对整个结果集进行去重,即只要结果集中的某一行与另一行完全相同,就会被去除。

2.GR0UP BY 介绍

- 用途:GR0UP BY 主要用于对结果集按照一个或多个列进行分组,通常与聚合函数(如 COUNT, SUM, AVG, MAX, MIN 等)一起使用,以便对每个组进行统计。

- 语法:GR0UP BY 通常跟在 FROM 或 WHERE 子句之后,在 SELECT 语句的末尾部分。例如以下 SQL:

SELECT column1, COUNT(*) FROM table_name GR0UP BY column1;

- 工作机制:GR0UP BY 将数据按指定的列进行分组,每个组返回一行数据。

3.举例说明

3.1 使用 DISTINCT

假设有一个表 students,包含以下数据:

| id | name | age |

|---|---|---|

| 1 | Alice | 20 |

| 2 | Bob | 22 |

| 3 | Alice | 20 |

使用 DISTINCT 去除重复行:

SELECT DISTINCT name, age FROM students;

结果:

| name | age |

|---|---|

| Alice | 20 |

| Bob | 22 |

3.2 使用 GR0UP BY

假设还是上面的表 students,我们想要统计每个学生的数量:

SELECT name, COUNT(*) AS count FROM students GR0UP BY name;

结果:

| name | count |

|---|---|

| Alice | 2 |

| Bob | 1 |

4.主要区别

- 功能不同:DISTINCT 用于去除重复行,而 GR0UP BY 用于对结果集进行分组,通常与聚合函数一起使用。

- 返回结果不同:DISTINCT 返回去重后的结果集,查询结果集中只能包含去重的列信息,有其他列信息会报错;GR0UP BY 返回按指定列分组后的结果集,可以展示多列信息,并可以包含聚合函数的计算结果。

- 应用场景不同:DISTINCT 更适合单纯的去重需求,GR0UP BY 更适合分组统计需求。

- 性能略有不同:如果去重的字段有索引,那么 GR0UP BY 和 DISTINCT 都可以使用索引,此情况它们的性能是相同的;而当去重的字段没有索引时,DISTINCT 的性能就会高于 GR0UP BY,因为在 MySQL 8.0 之前,GR0UP BY 有一个隐藏的功能会进行默认的排序,这样就会触发 filesort 从而导致查询性能降低。

课后思考

count(*)、count(1) 和 count(字段) 有什么区别?

本文已收录到我的面试小站 http://www.javacn.site,其中包含的内容有:Redis、JVM、并发、并发、MySQL、Spring、Spring MVC、Spring Boot、Spring Cloud、MyBatis、设计模式、消息队列等模块。

来源:juejin.cn/post/7415914114650685481

Java 8 魔法:利用 Function 接口告别冗余代码,打造高效断言神器

前言

在 Java 开发的征途中,我们时常与重复代码不期而遇。这些重复代码不仅让项目显得笨重,更增加了维护成本。幸运的是,Java 8 带来了函数式编程的春风,以 Function 接口为代表的一系列新特性,为我们提供了破除这一难题的利剑。本文将以一个实际应用场景为例,即使用 Java 8 的函数式编程特性来重构数据有效性断言逻辑,展示如何通过 SFunction(基于 Java 8 的 Lambda 表达式封装)减少代码重复,从而提升代码的优雅性和可维护性。

背景故事:数据校验的烦恼

想象一下,在一个复杂的业务系统中,我们可能需要频繁地验证数据库中某个字段值是否有效,是否符合预期值。传统的做法可能充斥着大量相似的查询逻辑,每次都需要手动构建查询条件、执行查询并处理结果,这样的代码既冗长又难以维护。

例如以下两个验证用户 ID 和部门 ID 是否有效的方法,虽然简单,但每次需要校验不同实体或不同条件时,就需要复制粘贴并做相应修改,导致代码库中充满了大量雷同的校验逻辑,给维护带来了困扰。

// 判断用户 ID 是否有效

public void checkUserExistence(String userId) {

User user = userDao.findById(userId);

if (user == null) {

throw new RuntimeException("用户ID无效");

}

}

// 判断部门 ID 是否有效

public void checkDeptExistence(String deptId) {

Dept dept = deptDao.findById(deptId);

if (dept == null) {

throw new RuntimeException("部门ID无效");

}

}

Java 8 的魔法棒:函数式接口

Java 8 引入了函数式接口的概念,其中 Function<T, R> 是最基础的代表,它接受一个类型 T 的输入,返回类型 R 的结果。而在 MyBatis Plus 等框架中常用的 SFunction 是对 Lambda 表达式的进一步封装,使得我们可以更加灵活地操作实体类的属性。

实战演练:重构断言方法

下面的 ensureColumnValueValid 方法正是利用了函数式接口的魅力,实现了对任意实体类指定列值的有效性断言:

/**

* 确认数据库字段值有效(通用)

*

* @param <V> 待验证值的类型

* @param valueToCheck 待验证的值

* @param columnExtractor 实体类属性提取函数

* @param queryExecutor 单条数据查询执行器

* @param errorMessage 异常提示信息模板

*/

public static <T, R, V> void ensureColumnValueValid(V valueToCheck, SFunction<T, R> columnExtractor, SFunction<LambdaQueryWrapper<T>, T> queryExecutor, String errorMessage) {

if (valueToCheck == null) return;

LambdaQueryWrapper<T> wrapper = new LambdaQueryWrapper<>();

wrapper.select(columnExtractor);

wrapper.eq(columnExtractor, valueToCheck);

wrapper.last("LIMIT 1");

T entity = queryExecutor.apply(wrapper);

R columnValue = columnExtractor.apply(entity);

if (entity == null || columnValue == null)

throw new DataValidationException(String.format(errorMessage, valueToCheck));

}

这个方法接受一个待验证的值、一个实体类属性提取函数、一个单行数据查询执行器和一个异常信息模板作为参数。通过这四个参数,不仅能够进行针对特定属性的有效性检查,而且还能生成具有一致性的异常信息。

对比分析

使用 Function 改造前

// 判断用户 ID 是否有效

public void checkUserExistence(String userId) {

User user = userDao.findById(userId);

if (user == null) {

throw new RuntimeException("用户ID无效");

}

}

// 判断部门 ID 是否有效

public void checkDeptExistence(String deptId) {

Dept dept = deptDao.findById(deptId);

if (dept == null) {

throw new RuntimeException("部门ID无效");

}

}

使用 Function 改造后

public void assignTaskToUser(AddOrderDTO dto) {

ensureColumnValueValid(dto.getUserId(), User::getId, userDao::getOne, "用户ID无效");

ensureColumnValueValid(dto.getDeptId(), Dept::getId, deptDao::getOne, "部门ID无效");

ensureColumnValueValid(dto.getCustomerId(), Customer::getId, customerDao::getOne, "客户ID无效");

ensureColumnValueValid(dto.getDeptId(), Dept::getId, deptDao::getOne, "部门ID无效");

ensureColumnValueValid(dto.getSupplieId(), Supplie::getId, supplierDao::getOne, "供应商ID无效");

// 现在可以确信客户存在

Customer cus = customerDao.findById(dto.getCustomerId());

// 创建订单的逻辑...

}

对比上述两段代码,我们发现后者不仅大幅减少了代码量,而且通过函数式编程,表达出更为清晰的逻辑意图,可读性和可维护性都有所提高。

优点

- 减少重复代码: 通过

ensureColumnValueValid方法,所有涉及数据库字段值有效性检查的地方都可以复用相同的逻辑,将变化的部分作为参数传递,大大减少了因特定校验逻辑而产生的代码量。 - 增强代码复用: 抽象化的校验方法适用于多种场景,无论是用户ID、订单号还是其他任何实体属性的校验,一套逻辑即可应对。

- 提升可读性和维护性: 通过清晰的函数签名和 Lambda 表达式,代码意图一目了然,降低了后续维护的成本。

- 灵活性和扩展性: 当校验规则发生变化时,只需要调整

ensureColumnValueValid方法或其内部实现,所有调用该方法的地方都会自动受益,提高了系统的灵活性和扩展性。

举一反三:拓展校验逻辑的边界

通过上述的实践,我们见识到了函数式编程在简化数据校验逻辑方面的威力。但这只是冰山一角,我们可以根据不同的业务场景,继续扩展和完善校验逻辑,实现更多样化的校验需求。以下两个示例展示了如何在原有基础上进一步深化,实现更复杂的数据比较和验证功能。

断言指定列值等于预期值

首先,考虑一个场景:除了验证数据的存在性,我们还需确认查询到的某列值是否与预期值相符。这在验证用户角色、状态变更等场景中尤为常见。为此,我们设计了 validateColumnValueMatchesExpected 方法:

/**

* 验证查询结果中指定列的值是否与预期值匹配

*

* @param <T> 实体类型

* @param <R> 目标列值的类型

* @param <C> 查询条件列值的类型

* @param targetColumn 目标列的提取函数,用于获取想要验证的列值

* @param expectedValue 期望的列值

* @param conditionColumn 条件列的提取函数,用于设置查询条件

* @param conditionValue 条件列对应的值

* @param queryMethod 执行查询的方法引用,返回单个实体对象

* @param errorMessage 验证失败时抛出异常的错误信息模板

* @throws RuntimeException 当查询结果中目标列的值与预期值不匹配时抛出异常

*/

public static <T, R, C> void validateColumnValueMatchesExpected(

SFunction<T, R> targetColumn, R expectedValue,

SFunction<T, C> conditionColumn, C conditionValue,

SFunction<LambdaQueryWrapper<T>, T> queryMethod,

String errorMessage) {

// 创建查询包装器,选择目标列并设置查询条件

LambdaQueryWrapper<T> wrapper = new LambdaQueryWrapper<>();

wrapper.select(targetColumn);

wrapper.eq(conditionColumn, conditionValue);

// 执行查询方法

T one = queryMethod.apply(wrapper);

// 如果查询结果为空,则直接返回,视为验证通过(或忽略)

if (one == null) return;

// 获取查询结果中目标列的实际值

R actualValue = targetColumn.apply(one);

// 比较实际值与预期值是否匹配,这里假设notMatch是一个自定义方法用于比较不匹配情况

boolean doesNotMatch = notMatch(actualValue, expectedValue);

if (doesNotMatch) {

// 若不匹配,则根据错误信息模板抛出异常

throw new RuntimeException(String.format(errorMessage, expectedValue, actualValue));

}

}

// 假设的辅助方法,用于比较值是否不匹配,根据实际需要实现

private static <R> boolean notMatch(R actual, R expected) {

// 示例简单实现为不相等判断,实际情况可能更复杂

return !Objects.equals(actual, expected);

}

这个方法允许我们指定一个查询目标列(targetColumn)、预期值(expectedValue)、查询条件列(conditionColumn)及其对应的条件值(conditionValue),并提供一个查询方法(queryMethod)来执行查询。如果查询到的列值与预期不符,则抛出异常,错误信息通过 errorMessage 参数定制。

应用场景:

例如在一个权限管理系统中,当需要更新用户角色时,系统需要确保当前用户的角色在更新前是 “普通用户”,才能将其升级为 “管理员”。此场景下,可以使用 validateColumnValueMatchesExpected 方法来验证用户当前的角色是否确实为“普通用户”。

// 当用户角色不是 “普通用户” 时抛异常

validateColumnValueMatchesExpected(User::getRoleType, "普通用户", User::getId, userId, userMapper::getOne, "用户角色不是普通用户,无法升级为管理员!");

断言指定值位于期望值列表内

进一步,某些情况下我们需要验证查询结果中的某一列值是否属于一个预设的值集合。例如,验证用户角色是否合法。为此,我们创建了 validateColumnValueMatchesExpectedList 方法:

/**

* 验证查询结果中指定列的值是否位于预期值列表内

*

* @param <T> 实体类型

* @param <R> 目标列值的类型

* @param <C> 查询条件列值的类型

* @param targetColumn 目标列的提取函数,用于获取想要验证的列值

* @param expectedValueList 期望值的列表

* @param conditionColumn 条件列的提取函数,用于设置查询条件

* @param conditionValue 条件列对应的值

* @param queryMethod 执行查询的方法引用,返回单个实体对象

* @param errorMessage 验证失败时抛出异常的错误信息模板

* @throws RuntimeException 当查询结果中目标列的值不在预期值列表内时抛出异常

*/

public static <T, R, C> void validateColumnValueInExpectedList(

SFunction<T, R> targetColumn, List<R> expectedValueList,

SFunction<T, C> conditionColumn, C conditionValue,

SFunction<LambdaQueryWrapper<T>, T> queryMethod,

String errorMessage) {

LambdaQueryWrapper<T> wrapper = new LambdaQueryWrapper<>();

wrapper.select(targetColumn);

wrapper.eq(conditionColumn, conditionValue);

T one = queryMethod.apply(wrapper);

if (one == null) return;

R actualValue = targetColumn.apply(one);

if (actualValue == null) throw new RuntimeException("列查询结果为空");

if (!expectedValueList.contains(actualValue)) {

throw new RuntimeException(errorMessage);

}

}

这个方法接受一个目标列(targetColumn)、一个预期值列表(expectedValueList)、查询条件列(conditionColumn)及其条件值(conditionValue),同样需要一个查询方法(queryMethod)。如果查询到的列值不在预期值列表中,则触发异常。

应用场景: 在一个电商平台的订单处理流程中,系统需要验证订单状态是否处于可取消的状态列表里(如 “待支付”、“待发货”)才允许用户取消订单。此时,validateColumnValueInExpectedList 方法能有效确保操作的合法性。

// 假设 OrderStatusEnum 枚举了所有可能的订单状态,cancelableStatuses 包含可取消的状态

List<String> cancelableStatuses = Arrays.asList(OrderStatusEnum.WAITING_PAYMENT.getValue(), OrderStatusEnum.WAITING_DELIVERY.getValue());

// 验证订单状态是否在可取消状态列表内

validateColumnValueInExpectedList(Order::getStatus, cancelableStatuses, Order::getOrderId, orderId, orderMapper::selectOne, "订单当前状态不允许取消!");

通过这两个扩展方法,我们不仅巩固了函数式编程在减少代码重复、提升代码灵活性方面的优势,还进一步证明了通过抽象和泛型设计,可以轻松应对各种复杂的业务校验需求,使代码更加贴近业务逻辑,易于理解和维护。

核心优势

- 代码复用:通过泛型和函数式接口,该方法能够适应任何实体类和属性的校验需求,大大减少了重复的查询逻辑代码。

- 清晰表达意图:方法签名直观表达了校验逻辑的目的,提高了代码的可读性和可维护性。

- 灵活性:使用者只需提供几个简单的 Lambda 表达式,即可完成复杂的查询逻辑配置,无需关心底层实现细节。

- 易于维护与扩展:

- 当需要增加新的实体验证时,仅需调用

ensureColumnValueValid并传入相应的参数,无需编写新的验证逻辑,降低了维护成本。 - 修改验证规则时,只需调整

ensureColumnValueValid内部实现,所有调用处自动遵循新规则,便于统一管理。 - 异常处理集中于

ensureColumnValueValid方法内部,统一了异常抛出行为,避免了在多个地方处理相同的逻辑错误,减少了潜在的错误源。

- 当需要增加新的实体验证时,仅需调用

函数式编程的力量

通过这个实例,我们见证了函数式编程在简化代码、提高抽象层次上的强大能力。在 Java 8 及之后的版本中,拥抱函数式编程思想,不仅能够使我们的代码更加简洁、灵活,还能在一定程度上促进代码的正确性和可测试性。因此,无论是日常开发还是系统设计,都值得我们深入探索和应用这一现代编程范式,让代码如魔法般优雅而高效。

来源:juejin.cn/post/7384256110280572980

三维gis的就业前景如何

一、前言

三维GIS是一个伪概念,GIS是地理信息系统,三维GIS就是三维地理信息系统,在课本上,专业概念上,也没有这一说法吧,所以三维GIS,就是技术人员造概念拼凑造出来的,本质上就是GIS三维可视化。

二、详细介绍

GIS从广义层面分为两大方面,第一是数据及数据管理,第二是业务功能,其中业务,就是分析、显示、交互。按照云计算服务划分,分别对应着DAAS层和SAAS层。按照所谓三维GIS的说法,那就是三维数据管理、三维分析、三维显示、三维交互。目前三维GIS基本上就是围绕着三维数据、三维分析、三维数据显示以及三维交互这四方面展开,其中三维数据是主要表现力。

1.三维数据

三维GIS场景与游戏场景的最主要也是最本质区别在于,三维GIS的数据都是真实的,来源于真实世界映射数据,包括卫星影像、三维地形DEM/DSM/DTM、倾斜摄影、点云等各式各样数据。游戏场景绝大部分人工建模出来的理想中的场景。一个是面向现实,一个面向未来,如果把两者结合,是不是有“元宇宙”的味道了呢?

2.三维分析

三维分析,即基于三维数据进行的分析计算,三维即三维空间,三维空间的GIS分析,三维空间距离量算、三维体积量算、三维高度量算……本质上应该比二维分析更丰富才对。可惜的是,三维空间分析,绝大部分在课本上找不到,更别说概念化描述。

3.三维可视化

三维可视化绝大部分是三维数据的可视化,我们常见的有地形可视化、倾斜摄影可视化

4.三维交互

除了普通的漫游、缩放、旋转、更有俯仰、翻转等操作。从上面可以看出三维GIS重点还是在于可视化,做三维GIS可视化,两大核心是GIS+图形学。想要在三维GIS深耕,就需要在计算机图形学有很好的基础,较强的GIS开发概念,以及自己的想象力。而图形学是公认的成长缓慢的大后期,比C++成长更慢,更别说与Java、JavaScript等相提并论。因此以后把三维GIS作为自己的就业方向,前景很光明,即使以后不在GIS圈,去互联网游戏行业都能胜任,而且比纯游戏开发更有优势。

三、结语

目前GIS公司对三维GIS的开发需求很强烈,但是受限于大学所学,能在大学既能懂GIS又懂图形学的,凤毛麟角,所以三维GIS开发很抢手,但是学校都找不到人,绝大部分都是招来基础好的学生,从零开始培养。

学好三维GIS,不仅仅会一个Cesium、MapBox就完了,这最初级阶段,只是二次开发,熟悉了接口,你就需要从原理角度去熟悉底层原理,渲染管线、地形瓦片及3dtiles调度与渲染等等,这些都需要你去认真深入学习的,还有一点,也是很三维GIS的最重要的一件武器:shader。这是必须熟练掌握的,包括glsl,hlsl等。

最后,就是要学游戏引擎,目前,做三维GIS与游戏引擎结合的越来越紧密,随着信创产业的快速发展,UE以后会越来越得到应用,做三维GIS,离不开熟练使用UE或者Unity。以上是我个人的一些看法,希望看到有更多的人投入到三维GIS中去,创造越来越多很酷的三维GIS产品,服务社会,造福人类!

来源:juejin.cn/post/7337188759060267023

23年计算机科学与技术毕业生的2024 年终总结

### 2024年年终工作总结

引言

随着2024年的落幕,作为一名计算机科学与技术专业的毕业生,我有幸参与到一款聊天应用的开发工作中。这一年,我不仅在技术层面获得了长足的进步,也在团队协作和项目管理方面积累了宝贵的经验。以下是我这一年工作的详细总结。

技术成长

1. 安卓开发技能提升

在这一年中,我深入学习了Android开发框架,掌握了Kotlin和Java两种编程语言,熟悉了Android Studio开发环境。

学习并实践了Material Design设计原则,优化了用户界面和用户体验。

掌握了网络编程,包括HTTP协议、RESTful API以及使用Retrofit和Volley等网络库进行数据通信。

2. 项目管理与协作

参与了敏捷开发流程,学习了Scrum框架,每周参与Scrum会议,及时同步项目进度。

学会了使用Git进行版本控制,以及在GitHub上进行代码管理和团队协作。

3. 性能优化与问题解决

学习了Android性能优化的技巧,包括内存管理、布局优化和多线程编程。

通过日志分析和性能监控工具,定位并解决了多个应用崩溃和性能瓶颈问题。

项目成果

1. 聊天应用核心功能开发

负责聊天应用的核心聊天功能模块开发,包括消息发送、接收和展示。

实现了消息加密传输,保障用户通信安全。

2. 用户界面与交互设计

参与设计并实现了应用的用户界面,使其更加直观和易用。

根据用户反馈,迭代优化了多个界面元素,提升了用户满意度。

3. 跨平台兼容性测试

参与了应用的跨平台测试工作,确保应用在不同设备和操作系统版本上的兼容性和稳定性。

团队协作与领导力

1. 团队沟通与协作

作为团队的一员,我积极参与团队讨论,提出建设性意见,并协助解决同事遇到的问题。

学会了如何更有效地与团队成员沟通,提高了团队的整体效率。

2. 领导力的培养

在项目中担任小组长,负责协调小组内的工作分配和进度跟踪,锻炼了我的领导能力。

个人成长与反思

1. 自我学习与提升

通过在线课程和专业书籍,不断学习新的技术和行业动态,保持自己的竞争力。

反思过去一年的工作,认识到自己在时间管理和优先级排序上的不足,并制定了改进计划。

2. 职业规划

明确了自己的职业发展方向,计划在未来几年内深入学习人工智能和机器学习,为公司的技术创新贡献力量。

2024年对我来说是充满挑战和成长的一年。我不仅在技术上有所提升,也在团队协作和项目管理方面获得了宝贵的经验。展望未来,我将继续努力,为公司的发展贡献自己的力量,并实现个人职业生涯的进一步发展。 环信的easyimkit很好用。

springboot多种生产打包方式简介

生产上发布 Spring Boot 项目时,流程颇为繁琐且低效。但凡代码有一丁点改动,就得把整个项目重新打包部署,耗时费力不说,生成的 JAR 包还特别臃肿,体积庞大。每次更新项目,光是上传这大文件就得花费不少时间,严重影响工作节奏。为解决这一痛点,我打算把依赖库以及配置文件(lib 文件夹下的那些 jar 包,还有config下的applacation.yml等文件)从项目主体里剥离出来,后续部署时,只需发布核心代码就行,这样既能加快部署速度,又能减轻文件传输负担,让项目更新变得轻松便捷

方法一 插件spring-boot-maven-plugin

1. 项目应用的配置文件排除 统一打包到config目录下

利用springboot中resource插件来排除配置,并统一打包到config目录下

<resources>

<resource>

<directory>src/main/resources</directory>

<!--filerting设置为true,则打包过程中会对这些文件进行过滤处理-->

<filtering>true</filtering>

<!--指定目标路径为config-->

<targetPath>${project.build.directory}/config</targetPath>

<includes>

<!--使用通配符-->

<include>**/*.properties</include>

<include>**/*.yml</include>

<include>**/*.xml</include>

<include>mapper/*.xml</include>

<!-- 这里可以根据你实际想要包含的配置文件类型来添加更多的include配置 -->

</includes>

</resource>

</resources>

2. 把我们写代码打包可执行jar,并排除依赖jar包

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<!--项目的启动类,如果有多个main就必须指定,没有可以缺失

<mainClass>XXXXX.TwinWebApplication</mainClass>-->

<!--解决windows命令行窗口中文乱码-->

<jvmArguments>-Dfile.encoding=UTF-8</jvmArguments>

<layout>ZIP</layout>

<!--配置需要打包进项目的jar-->

<includes>

<!--填写需要打包所需要的依赖 。没有匹配上任何jar包机排除依赖-->

<include>

<groupId>no-exists-jar</groupId>

<artifactId>non-exists-jar</artifactId>

</include>

</includes>

</configuration>

<executions>

<execution>

<goals>

<!-- 表示当运行mavn package打包时,使用Springboot插件打包 -->

<goal>repackage</goal>

</goals>

</execution>

</executions>

</plugin>

3 配置依赖的jar包 统一打包lib目录

<!--此插件用于将依赖包抽出-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-dependency-plugin</artifactId>

<executions>

<execution>

<id>copy-dependencies</id>

<phase>package</phase>

<goals>

<goal>copy-dependencies</goal>

</goals>

<configuration>

<outputDirectory>${project.build.directory}/lib</outputDirectory>

<excludeTransitive>false</excludeTransitive>

<stripVersion>false</stripVersion>

<includeScope>runtime</includeScope>

</configuration>

</execution>

</executions>

</plugin>

打包后目录结构,如下图所示

执行命令 java -jar -Dloader.path=./lib -jar xxx.jar

注意 springboot启动时候会优先读取config目录下配置文件 所以这里不用指定-Dspring.config.location=XX.yml文件

注意 例如日志文件配置以及mybits等配置文件 可以配成绝对路径 如下所示:

方法二 使用maven-jar-plugin插件实现

1 使用插件maven-resources-plugin处理配置文件打包到config目录

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-resources-plugin</artifactId>

<configuration>

<encoding>UTF-8</encoding>

</configuration>

<executions>

<execution>

<id>copy-dependencies</id>

<phase>package</phase>

<goals>

<goal>copy-resources</goal>

</goals>

<configuration>

<!--配置文件打包成config目录下 -->

<outputDirectory>${project.build.directory}/twin-web/config</outputDirectory>

<resources>

<resource>

<directory>src/main/resources</directory>

</resource>

</resources>

</configuration>

</execution>

</executions>

</plugin>

2. 使用maven-jar-plugin 打包可执行jar 并排除依赖

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-jar-plugin</artifactId>

<configuration>

<outputDirectory>

<!--输入打包可执行的jar到twin-web\libs\下-->

${project.build.directory}/twin-web/

</outputDirectory>

<archive>

<addMavenDescriptor>false</addMavenDescriptor>

<manifest>

<addClasspath>true</addClasspath>

<!-- 增加执行启动jar的依赖jar包目录前缀-->

<classpathPrefix>./libs/</classpathPrefix>

<!-- 指定启动类-->

<mainClass>com.keqing.twinweb.TwinWebApplication</mainClass>

</manifest>

<manifestEntries>

<!-- 增加配置文件的classpath-->

<Class-Path>./config/</Class-Path>

</manifestEntries>

</archive>

<!-- 排除配置文件-->

<excludes>

<exclude>*.yml</exclude>

<exclude>mapper/**</exclude>

<exclude>*.xml</exclude>

</excludes>

</configuration>

</plugin>

3 使用maven-dependency-plugin 打包libs目录下

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-dependency-plugin</artifactId>

<executions>

<execution>

<id>copy-dependencies</id>

<phase>package</phase>

<goals>

<goal>copy-dependencies</goal>

</goals>

<configuration>

<outputDirectory>${project.build.directory}/twin-web/libs</outputDirectory>

<excludeTransitive>false</excludeTransitive>

<stripVersion>false</stripVersion>

<includeScope>runtime</includeScope>

</configuration>

</execution>

</executions>

</plugin>

使用package打包后的目录

查看自己打包后jar目录,注意这种打包方式弊端,按照一定约定格式规范固定了,一旦依赖jar包(包括配置文件目录等)发生变化就必须重新打包

启动程序java -jar xxx.jar

方式三 使用maven-assembly-plugin打包

maven-assembly-plugin 是 Maven 中的一个插件,它允许用户将项目的输出以及依赖、模块、站点文档和其他文件打包成一个可发布的格式,例如 zip、tar.gz、jar 等。以下是使用 maven-assembly-plugin 的一些优势:

- 自定义打包格式:

maven-assembly-plugin允许你通过定义描述符文件(descriptor)来完全自定义打包的内容和格式。你可以选择包含或排除特定的文件和目录。 - 一键打包:通过一个简单的 Maven 命令,你可以创建一个包含所有必需依赖的单一归档文件,这使得分发和部署变得非常简单。

- 多环境支持:可以为不同的环境(开发、测试、生产)创建不同的打包配置,使得环境迁移更加容易。

- 依赖管理:插件会自动处理项目依赖,将它们打包到最终的归档文件中,无需手动管理。

- 模块化项目支持:对于多模块项目,

maven-assembly-plugin可以将所有模块的输出合并到一个归档文件中。 - 预配置的描述符:插件提供了一些预定义的描述符,如

bin、jar-with-dependencies等,可以直接使用,无需自定义。 - 灵活性:你可以通过修改描述符文件来调整打包行为,以适应不同的需求。

- 集成性:

maven-assembly-plugin与 Maven 生态系统紧密集成,可以与其他 Maven 插件协同工作。 - 文档和社区支持:由于

maven-assembly-plugin是 Maven 的一部分,因此有广泛的文档和社区支持。

1. 项目应用的配置文件排除

<resources>

<resource>

<directory>src/main/resources</directory>

<!--filerting设置为true,则打包过程中会对这些文件进行过滤处理-->

<filtering>true</filtering>

<includes>

<!--使用通配符-->

<include>**/*.properties</include>

<include>**/*.yml</include>

<include>**/*.xml</include>

<include>mapper/*.xml</include>

<!-- 这里可以根据你实际想要包含的配置文件类型来添加更多的include配置 -->

</includes>

</resource>

</resources>

2. 配置spring-boot-maven-plugin

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<!--项目的启动类,如果有多个main就必须指定,没有可以缺失

<mainClass>XXXXX.TwinWebApplication</mainClass>-->

<!--解决windows命令行窗口中文乱码-->

<jvmArguments>-Dfile.encoding=UTF-8</jvmArguments>

<layout>ZIP</layout>

<!--配置需要打包进项目的jar-->

<includes>

<!--填写需要打包所需要的依赖 。没有匹配上任何jar包机排除依赖-->

<include>

<groupId>no-exists-jar</groupId>

<artifactId>non-exists-jar</artifactId>

</include>

</includes>

</configuration>

<executions>

<execution>

<goals>

<!-- 表示当运行mavn package打包时,使用Springboot插件打包 -->

<goal>repackage</goal>

</goals>

</execution>

</executions>

</plugin>

3 引入springboot里约定maven-assembly-plugin

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<!-- 打包文件名字不包含 assembly.xml 中 id -->

<appendAssemblyId>false</appendAssemblyId>

<descriptors>

<!--项目所在目录配置文件的 assembly.xml文件 -->

<descriptor>assembly.xml</descriptor>

</descriptors>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

配置assembly.xml文件

<assembly>

<!-- 打包文件名的标识符,用来做后缀-->

<id>make-assembly</id>

<!-- 打包的类型,如果有N个,将会打N个类型的包 -->

<formats>

<format>tar.gz</format>

<format>zip</format>

</formats>

<!-- 压缩包下是否生成和项目名相同的根目录 -->

<includeBaseDirectory>true</includeBaseDirectory>

<!-- 用来设置一组文件在打包时的属性。-->

<fileSets>

<!-- 0755->即用户具有读/写/执行权限,组用户和其它用户具有读写权限;-->

<!-- 0644->即用户具有读写权限,组用户和其它用户具有只读权限;-->

<!-- 将src/bin目录下的jar启动脚本输出到打包后的目录中 -->

<fileSet>

<!--lineEnding选项可用于控制给定的行结束文件 -->

<lineEnding>unix</lineEnding>

<directory>${basedir}/bin</directory>

<outputDirectory>${file.separator}</outputDirectory>

<fileMode>0755</fileMode>

<includes>

<include>**.sh</include>

<include>**.bat</include>

</includes>

</fileSet>

<!-- 把项目的配置文件,打包进压缩文件的config目录 -->

<fileSet>

<directory>${basedir}/src/main/resources</directory>

<outputDirectory>config</outputDirectory>

<fileMode>0644</fileMode>

<includes>

<include>*.properties</include>

<include>*.yml</include>

<include>*.xml</include>

<include>mapper/*.xml</include>

</includes>

</fileSet>

<!-- 把项目自己编译出来的jar文件,打包进zip文件的根目录 -->

<fileSet>

<directory>${project.build.directory}</directory>

<outputDirectory>${file.separator}</outputDirectory>

<includes>

<include>*.jar</include>

</includes>

</fileSet>

</fileSets>

<!-- 依赖包的拷贝-->

<dependencySets>

<dependencySet>

<unpack>false</unpack>

<useProjectArtifact>true</useProjectArtifact>

<outputDirectory>lib</outputDirectory>

<scope>provided</scope>

</dependencySet>

<dependencySet>

<unpack>false</unpack>

<useProjectArtifact>true</useProjectArtifact>

<outputDirectory>lib</outputDirectory>

<scope>system</scope>

</dependencySet>

<dependencySet>

<unpack>false</unpack>

<useProjectArtifact>true</useProjectArtifact>

<outputDirectory>lib</outputDirectory>

<scope>runtime</scope>

</dependencySet>

</dependencySets>

</assembly>

打包后目录

解压zip目录查看

使用命令启动项目java -jar -Dloader.path=./lib -jar xxx.jar

来源:juejin.cn/post/7442154802832916530

Spring Boot + liteflow竟然这么好用!

liteflow可以帮助我们快速编排复杂的业务规则,并实现动态的规则更新。

在liteflow中,主要有以下几种组件:

- 普通组件:集成

NodeComponent,用于执行具体的业务逻辑;- 选择组件:通过业务逻辑选择不同的执行路径;

- 条件组件:基于条件返回结果,决定下一步的业务流程。

我们通过代码示例来了解每种组件的用法。

java

// 普通组件示例

@LiteflowComponent("commonNode")

public class CommonNode extends NodeComponent {

@Override

public void process() throws Exception {

// 业务逻辑

System.out.println("Executing commonNode logic");

}

}

// 选择组件示例

@LiteflowComponent("choiceNode")

public class ChoiceNode extends NodeSwitchComponent {

@Override

public String processSwitch() throws Exception {

// 根据条件返回不同的节点ID

return "nextNodeId";

}

}

// 条件组件示例

@LiteflowComponent("conditionNode")

public class ConditionNode extends NodeIfComponent {

@Override

public boolean processIf() throws Exception {

// 判断条件

return true;

}

}

EL规则文件

在liteflow中,规则文件可以采用XML格式编写,下面是一个简单的规则文件示例。

如何使用EL规则文件

- 创建规则文件:将上述规则文件保存为

flow.xml,放在项目的resources目录下; - 配置

liteflow:在Spring Boot项目中添加liteflow的配置,指定规则文件的位置;

yaml

liteflow:

rule-source: "classpath:flow.xml"

node-retry: 3

thread-executor:

core-pool-size: 10

max-pool-size: 20

keep-alive-time: 60

- 编写业务逻辑组件:按照规则文件中的定义,编写相应的组件逻辑。

数据上下文

在liteflow中,数据上下文非常重要,它用于参数传递和业务逻辑的执行。

我们可以通过以下代码示例了解数据上下文的用法

配置详解

在使用liteflow时,我们需要对一些参数进行配置,如规则文件地址、节点重试、线程池参数等。

以下是一个配置示例。

yaml

liteflow:

rule-source: "classpath:flow.xml" # 指定规则文件的位置

node-retry: 3 # 节点重试次数

thread-executor:

core-pool-size: 10 # 线程池核心线程数

max-pool-size: 20 # 线程池最大线程数

keep-alive-time: 60 # 线程存活时间

实践案例

接下来,我们来看一个完整的业务实践案例。

在电商场景下,当订单完成后,我们需要同时进行积分发放和消息发送。

这时候,我们可以利用liteflow进行规则编排,处理这些并行任务。

1. 引入依赖

首先,在pom.xml文件中添加liteflow的依赖:

xml

<dependency>

<groupId>com.yomahubgroupId>

<artifactId>liteflow-spring-boot-starterartifactId>

<version>2.6.5version>

dependency>

2. 增加配置

在application.yml文件中添加liteflow的配置:

yaml

spring:

application:

name: liteflow-demo

liteflow:

rule-source: "classpath:flow.xml" # 指定规则文件的位置

node-retry: 3 # 节点重试次数

thread-executor:

core-pool-size: 10 # 线程池核心线程数

max-pool-size: 20 # 线程池最大线程数

keep-alive-time: 60 # 线程存活时间

3. 编写规则文件

在resources目录下创建flow.xml文件,编写规则文件内容:

xml

<flow>

<parallel>

<node id="pointNode"/>

<node id="messageNode"/>

parallel>

flow>

4. 编写业务逻辑组件

按照规则文件中的定义,编写相应的业务逻辑组件:

java

@LiteflowComponent("pointNode")

public class PointNode extends NodeComponent {

@Override

public void process() throws Exception {

// 发放积分逻辑

System.out.println("Issuing points for the order");

}

}

@LiteflowComponent("messageNode")

public class MessageNode extends NodeComponent {

@Override

public void process() throws Exception {

// 发送消息逻辑

System.out.println("Sending message for the order");

}

}

5. 流程触发

当订单完成后,我们需要触发liteflow的流程来执行积分发放和消息发送的逻辑。

我们可以在订单完成的服务方法中添加如下代码:

java

@Service

public class OrderService {

@Autowired

private FlowExecutor flowExecutor;

public void completeOrder(Order order) {

// 完成订单的其他逻辑

System.out.println("Order completed: " + order.getId());

// 执行liteflow流程

flowExecutor.execute2Resp("flow", order);

}

}

性能统计

总结

来源:juejin.cn/post/7394790673612718092

一位转行Java上岸4年到技术专家的经验分享

自我介绍:

大家好, 我是你们的朋友, 晓龙。今天我想分享一下我自己艰难的Java转行经历。

为什么没有学历 , 因为大学上了一学期, 当时因为一些原因, 就辍学了。年少无知 , 发现到社会上找工作, 没有学历就没有敲门砖,最低要求也是大专。在2018年报考了大专的网络教育。同时, 自己也开始了金融学本科的自考。2018年还是比较的迷茫, 也不知道能靠什么挣钱。2019年, 开始在黑马进行Java的培训, 因为大概有4年没有学习了,加之因为0基础, 当时去的时候连Java能干什么也不知道, 所以学起来还是比较的吃力,尤其我记得当时对方法的定义, 是真的理解不了。

开局buffer就叠满了,运气一直比较的好。

工作经历:

2019年9月左右, 在武汉经过几次面似乎,找到了第一家公司, 规模比较的小, 0-20人, 当然对于当时的我来说, 能找到一份工作(上岸),也是非常开心的, 但是很遗憾的是, 这家公司我去只坚持1个月, 公司就倒闭了。

但是也没有急着找工作了,花了20天, 花了20天把自考的科目复习,在11月份继续在武汉找工作,经过面试,入职了一家比较小的公司, 后端就2人,都是培训出来的。当时我的想法很明确, 花时间补知识, 在培训班的6个月, 时间还是比较的紧的,很多东西只是知道, 都没有亲自动手实践过。公司好在不是很忙, 有一定的时间学习。当时上了2个多月,就回家过年,后面因为yq , 就没有去武汉了,这家公司也就上了3个月的班, 一直在家呆到2020年年7月,期间把慕课网的架构课程好好学习了。7月开始在重庆找工作 ,经过了一周多的努力, 找到了一家更加不规范的公司, 后端2个, 前端一个, 产品一个,其他就没有了,还在薪资给的还可以, 这个期间继续学习, 真正的代码都写得比较的少。很遗憾, 公司只坚持了6个月, 2021年1月, 公司又倒闭了。

我清晰的记得当时准备面试的那一周,是压力最大的一周。在经历了前面几家公司后, 我也知道, 如果还去一家不稳定的公司, 结果还是这样, 几个月就倒闭了, 而且整个公司没有研发体系, 自己就永远不能真正的上岸(野路子到正规军)。虽然前面1年多代码没有写多少, 但是还是有一定的知识积累。

自己也没有放弃, 我当时在BOSS上看准了一家公司, 然后就开始好好的准备, 不仅仅是准备技术方面的知识, 还去了解公司的背景, 当时觉得这家公司规模比较的大。当时面试完后, 顺利的拿到了offer , 期间我和面试官(也是我的领导)说, 我非常期待能来公司上班,即使不要钱,但是没办法, 我自己得生活。直到现在, 我还是非常的感谢这位领导, 也会在微信中和他交流近况。

是的 ,从某种意义上讲, 现在才是真正的上岸!

我在这家公司感受到什么是真正的做开发。公司有正规的研发流程, 完善的研发体系, 每一个同事都身怀绝技。在这家公司, 我给自己的定位是2年成长为高级开发工程师,期间也暴露出我的一些问题,比如代码逻辑写得不清楚(之前代码写得太少了),设计做得不好等。

我是渴望成长的, 所以我针对自己具体的问题, 在2年的时间里, 充分利用自己的时间做了这些工作:

第一阶段: 在试用期的前三个月,虽然完成了业务功能开发,但是意识到自己的代码量还是远远不够,在以最快的速度完成业务功能开发后,投入leetcode的算法练习,每一道题就是一个功能的缩影,在完成300+的练习后,业务代码就得心应手了。

第二阶段: 当时培训机构的架构课对我来说,是无法转化为我的能力的,我学习它无疑是浪费我的时间,所以我更多的选择了自己去寻找资料和书籍来学习,主要是针对这几个方面,操作系统,计算机网络,netty,JVM,并发编程,框架源码,此过程历经1年。

第三阶段: 系统设计,在经历前两个阶段后, 是时候提高我的系统设计,架构能力,这个东西学不来, 靠悟,也是最难受的地方!每一次的业务功能开发前,我都会阅读软件设计方面的资料(每阅读一次,都有不一样的收获)再对业务功能进行设计,非常的耗时,但也非常的值得,经历了一年,对模块和系统的设计都有了自己的理解。

第四阶段: 和产品的深度沟通能力,无论是在需求评审,还是自己负责的模块,系统,都要和产品深度的沟通,这个阶段经历了半年,完成了这4个阶段后,自己的能力得到了极大的提高。跳槽成功

大家会说, 现在的环境不好, 不好找工作。从我自己的经历来看, 转行培训过来的同学, 开局不管怎么样, 不管遇到多大的困难,不要放弃自己, 请坚持学习, 好好的积累3年,完善自己的各项能力, 那个时候才是真正的上岸,自己也不愁找不到工作,拿到自己满意的薪资。

目前也在写重写自己的系统框架(脚手架)fd-frameworkfd-framework, 今天为了解决springmvc对请求时间进行统一格式处理 , Long精度丢失问题处理问题, 仔细花了大概5小时阅读里面的源码,期间的实现方式改了4版, 每一次的深入,都是有新的实现想法, 真的感觉很开心,哈哈, 预祝各位转行的同学上岸。

来源:juejin.cn/post/7323408577709080610

为什么 Java 大佬都不推荐使用 keySet() 遍历HashMap?

在Java编程中,HashMap 是一种非常常见的数据结构。我们经常需要对其中的键值对进行遍历。通常有多种方法可以遍历 HashMap,其中一种方法是使用 keySet() 方法。

然而,很多Java大佬并不推荐这种方法。为什么呢?

已收录于,我的技术网站:ddkk.com 里面有,500套技术系列教程、1万+道,面试八股文、BAT面试真题、简历模版,工作经验分享、架构师成长之路,等等什么都有,欢迎收藏和转发。

keySet() 方法的工作原理

首先,让我们来看一下 keySet() 方法是如何工作的。keySet() 方法返回 HashMap 中所有键的集合 (Set<K>)。然后我们可以使用这些键来获取相应的值。

代码示例如下:

// 创建一个HashMap并填充数据

Map<String, Integer> map = new HashMap<>();

map.put("apple", 1);

map.put("banana", 2);

map.put("cherry", 3);

// 使用keySet()方法遍历HashMap

for (String key : map.keySet()) {

// 通过键获取相应的值

Integer value = map.get(key);

System.out.println("Key: " + key + ", Value: " + value);

}

这个代码看起来没什么问题,但在性能和效率上存在一些隐患。

keySet() 方法的缺点

1、 多次哈希查找:如上面的代码所示,使用 keySet() 方法遍历时,需要通过键去调用 map.get(key) 方法来获取值。这意味着每次获取值时,都需要进行一次哈希查找操作。如果 HashMap 很大,这种方法的效率就会明显降低。

2、 额外的内存消耗:keySet() 方法会生成一个包含所有键的集合。虽然这个集合是基于 HashMap 的键的视图,但仍然需要额外的内存开销来维护这个集合的结构。如果 HashMap 很大,这个内存开销也会变得显著。

3、 代码可读性和维护性:使用 keySet() 方法的代码可能会让人误解,因为它没有直接表现出键值对的关系。在大型项目中,代码的可读性和维护性尤为重要。

更好的选择:entrySet() 方法

相比之下,使用 entrySet() 方法遍历 HashMap 是一种更好的选择。entrySet() 方法返回的是 HashMap 中所有键值对的集合 (Set<Map.Entry<K, V>>)。通过遍历这个集合,我们可以直接获取每个键值对,从而避免了多次哈希查找和额外的内存消耗。

下面是使用 entrySet() 方法的示例代码:

// 创建一个HashMap并填充数据

Map<String, Integer> map = new HashMap<>();

map.put("apple", 1);

map.put("banana", 2);

map.put("cherry", 3);

// 使用entrySet()方法遍历HashMap

for (Map.Entry<String, Integer> entry : map.entrySet()) {

// 直接获取键和值

String key = entry.getKey();

Integer value = entry.getValue();

System.out.println("Key: " + key + ", Value: " + value);

}

entrySet() 方法的优势

1、 避免多次哈希查找:在遍历过程中,我们可以直接从 Map.Entry 对象中获取键和值,而不需要再次进行哈希查找,提高了效率。

2、 减少内存消耗:entrySet() 方法返回的是 HashMap 内部的一个视图,不需要额外的内存来存储键的集合。

3、 提高代码可读性:entrySet() 方法更直观地表现了键值对的关系,使代码更加易读和易维护。

性能比较

我们来更深入地解析性能比较,特别是 keySet() 和 entrySet() 方法在遍历 HashMap 时的性能差异。

主要性能问题

1、 多次哈希查找: 使用 keySet() 方法遍历 HashMap 时,需要通过键调用 map.get(key) 方法获取值。这意味着每次获取值时都需要进行一次哈希查找操作。哈希查找虽然时间复杂度为 O(1),但在大量数据下,频繁的哈希查找会累积较高的时间开销。

2、 额外的内存消耗: keySet() 方法返回的是一个包含所有键的集合。虽然这个集合是基于 HashMap 的键的视图,但仍然需要额外的内存来维护这个集合的结构。

更高效的选择:entrySet() 方法

相比之下,entrySet() 方法返回的是 HashMap 中所有键值对的集合 (Set<Map.Entry<K, V>>)。通过遍历这个集合,我们可以直接获取每个键值对,避免了多次哈希查找和额外的内存消耗。

性能比较示例

让我们通过一个具体的性能比较示例来详细说明:

import java.util.HashMap;

import java.util.Map;

public class HashMapTraversalComparison {

public static void main(String[] args) {

// 创建一个大的HashMap

Map<String, Integer> map = new HashMap<>();

for (int i = 0; i < 1000000; i++) {

map.put("key" + i, i);

}

// 测试keySet()方法的性能

long startTime = System.nanoTime(); // 记录开始时间

for (String key : map.keySet()) {

Integer value = map.get(key); // 通过键获取值

}

long endTime = System.nanoTime(); // 记录结束时间

System.out.println("keySet() 方法遍历时间: " + (endTime - startTime) + " 纳秒");

// 测试entrySet()方法的性能

startTime = System.nanoTime(); // 记录开始时间

for (Map.Entry<String, Integer> entry : map.entrySet()) {

String key = entry.getKey(); // 直接获取键

Integer value = entry.getValue(); // 直接获取值

}

endTime = System.nanoTime(); // 记录结束时间

System.out.println("entrySet() 方法遍历时间: " + (endTime - startTime) + " 纳秒");

}

}

深度解析性能比较示例

1、 创建一个大的 HashMap:

Map<String, Integer> map = new HashMap<>();

for (int i = 0; i < 1000000; i++) {

map.put("key" + i, i);

}

- 创建一个包含100万个键值对的

HashMap。 键为"key" + i,值为i。- 这个

HashMap足够大,可以明显展示两种遍历方法的性能差异。

2、 测试 keySet() 方法的性能:

long startTime = System.nanoTime(); // 记录开始时间

for (String key : map.keySet()) {

Integer value = map.get(key); // 通过键获取值

}

long endTime = System.nanoTime(); // 记录结束时间

System.out.println("keySet() 方法遍历时间: " + (endTime - startTime) + " 纳秒");

- 使用

keySet()方法获取所有键,并遍历这些键。 - 在每次迭代中,通过

map.get(key)方法获取值。 - 记录开始时间和结束时间,计算遍历所需的总时间。

3、 测试 entrySet() 方法的性能:

startTime = System.nanoTime(); // 记录开始时间

for (Map.Entry<String, Integer> entry : map.entrySet()) {

String key = entry.getKey(); // 直接获取键

Integer value = entry.getValue(); // 直接获取值

}

endTime = System.nanoTime(); // 记录结束时间

System.out.println("entrySet() 方法遍历时间: " + (endTime - startTime) + " 纳秒");

- 使用

entrySet()方法获取所有键值对,并遍历这些键值对。 - 在每次迭代中,直接从

Map.Entry对象中获取键和值。 - 记录开始时间和结束时间,计算遍历所需的总时间。

性能结果分析

假设上述代码的运行结果如下:

keySet() 方法遍历时间: 1200000000 纳秒

entrySet() 方法遍历时间: 800000000 纳秒

可以看出,使用 entrySet() 方法的遍历时间明显短于 keySet() 方法。这主要是因为:

1、 避免了多次哈希查找: 使用 keySet() 方法时,每次获取值都需要进行一次哈希查找。而使用 entrySet() 方法时,键和值直接从 Map.Entry 对象中获取,无需再次查找。

2、 减少了内存消耗: 使用 keySet() 方法时,额外生成了一个包含所有键的集合。而使用 entrySet() 方法时,返回的是 HashMap 内部的一个视图,无需额外的内存开销。

小结一下

通过性能比较示例,我们可以清楚地看到 entrySet() 方法在遍历 HashMap 时的效率优势。使用 entrySet() 方法不仅能避免多次哈希查找,提高遍历效率,还能减少内存消耗。

综上所述,在遍历 HashMap 时,entrySet() 方法是更优的选择。

几种高效的替代方案

除了 entrySet() 方法外,还有其他几种高效的替代方案,可以用于遍历 HashMap。

以下是几种常见的高效替代方案及其优缺点分析:

1. 使用 entrySet() 方法

我们已经讨论过,entrySet() 方法是遍历 HashMap 时的一个高效选择。它直接返回键值对的集合,避免了多次哈希查找,减少了内存开销。

import java.util.HashMap;

import java.util.Map;

public class EntrySetTraversal {

public static void main(String[] args) {

Map<String, Integer> map = new HashMap<>();

map.put("apple", 1);

map.put("banana", 2);

map.put("cherry", 3);

for (Map.Entry<String, Integer> entry : map.entrySet()) {

String key = entry.getKey();

Integer value = entry.getValue();

System.out.println("Key: " + key + ", Value: " + value);

}

}

}

2. 使用 forEach 方法

从 Java 8 开始,Map 接口提供了 forEach 方法,可以直接对每个键值对进行操作。这种方式利用了 lambda 表达式,代码更简洁,可读性强。

import java.util.HashMap;

import java.util.Map;

public class ForEachTraversal {

public static void main(String[] args) {

Map<String, Integer> map = new HashMap<>();

map.put("apple", 1);

map.put("banana", 2);

map.put("cherry", 3);

map.forEach((key, value) -> {

System.out.println("Key: " + key + ", Value: " + value);

});

}

}

3. 使用 iterator 方法

另一种遍历 HashMap 的方法是使用迭代器 (Iterator)。这种方法适用于需要在遍历过程中对集合进行修改的情况,比如删除某些元素。

import java.util.HashMap;

import java.util.Iterator;

import java.util.Map;

public class IteratorTraversal {

public static void main(String[] args) {

Map<String, Integer> map = new HashMap<>();

map.put("apple", 1);

map.put("banana", 2);

map.put("cherry", 3);

Iterator<Map.Entry<String, Integer>> iterator = map.entrySet().iterator();

while (iterator.hasNext()) {

Map.Entry<String, Integer> entry = iterator.next();

String key = entry.getKey();

Integer value = entry.getValue();

System.out.println("Key: " + key + ", Value: " + value);

}

}

}

4. 使用 Streams API

Java 8 引入了 Streams API,可以结合 stream() 方法和 forEach 方法来遍历 HashMap。这种方法可以对集合进行更复杂的操作,比如过滤、映射等。

import java.util.HashMap;

import java.util.Map;

public class StreamTraversal {

public static void main(String[] args) {

Map<String, Integer> map = new HashMap<>();

map.put("apple", 1);

map.put("banana", 2);

map.put("cherry", 3);

map.entrySet().stream().forEach(entry -> {

String key = entry.getKey();

Integer value = entry.getValue();

System.out.println("Key: " + key + ", Value: " + value);

});

}

}

优缺点分析

entrySet() 方法:

- 优点:避免多次哈希查找,减少内存消耗,代码简单明了。

- 缺点:没有特定缺点,在大多数情况下是最佳选择。

forEach 方法:

- 优点:代码简洁,可读性强,充分利用 lambda 表达式。

- 缺点:仅适用于 Java 8 及以上版本。

iterator 方法:

- 优点:适用于需要在遍历过程中修改集合的情况,如删除元素。

- 缺点:代码稍显繁琐,不如

entrySet()和forEach方法直观。

Streams API 方法:

- 优点:支持复杂操作,如过滤、映射等,代码简洁。

- 缺点:仅适用于 Java 8 及以上版本,性能在某些情况下可能不如

entrySet()和forEach。

结论

在遍历 HashMap 时,entrySet() 方法是一个高效且广泛推荐的选择。对于更现代的代码风格,forEach 方法和 Streams API 提供了简洁且强大的遍历方式。如果需要在遍历过程中修改集合,可以使用 iterator 方法。根据具体需求选择合适的遍历方法,可以显著提高代码的效率和可读性。

已收录于,我的技术网站:ddkk.com 里面有,500套技术系列教程、1万+道,面试八股文、BAT面试真题、简历模版,工作经验分享、架构师成长之路,等等什么都有,欢迎收藏和转发。

来源:juejin.cn/post/7393663398406799372

Java 8 魔法:利用 Function 接口告别冗余代码,打造高效断言神器

前言

在 Java 开发的征途中,我们时常与重复代码不期而遇。这些重复代码不仅让项目显得笨重,更增加了维护成本。幸运的是,Java 8 带来了函数式编程的春风,以 Function 接口为代表的一系列新特性,为我们提供了破除这一难题的利剑。本文将以一个实际应用场景为例,即使用 Java 8 的函数式编程特性来重构数据有效性断言逻辑,展示如何通过 SFunction(基于 Java 8 的 Lambda 表达式封装)减少代码重复,从而提升代码的优雅性和可维护性。

背景故事:数据校验的烦恼

想象一下,在一个复杂的业务系统中,我们可能需要频繁地验证数据库中某个字段值是否有效,是否符合预期值。传统的做法可能充斥着大量相似的查询逻辑,每次都需要手动构建查询条件、执行查询并处理结果,这样的代码既冗长又难以维护。

例如以下两个验证用户 ID 和部门 ID 是否有效的方法,虽然简单,但每次需要校验不同实体或不同条件时,就需要复制粘贴并做相应修改,导致代码库中充满了大量雷同的校验逻辑,给维护带来了困扰。

// 判断用户 ID 是否有效

public void checkUserExistence(String userId) {

User user = userDao.findById(userId);

if (user == null) {

throw new RuntimeException("用户ID无效");

}

}

// 判断部门 ID 是否有效

public void checkDeptExistence(String deptId) {

Dept dept = deptDao.findById(deptId);

if (dept == null) {

throw new RuntimeException("部门ID无效");

}

}

Java 8 的魔法棒:函数式接口

Java 8 引入了函数式接口的概念,其中 Function<T, R> 是最基础的代表,它接受一个类型 T 的输入,返回类型 R 的结果。而在 MyBatis Plus 等框架中常用的 SFunction 是对 Lambda 表达式的进一步封装,使得我们可以更加灵活地操作实体类的属性。

实战演练:重构断言方法

下面的 ensureColumnValueValid 方法正是利用了函数式接口的魅力,实现了对任意实体类指定列值的有效性断言:

/**

* 确认数据库字段值有效(通用)

*

* @param <V> 待验证值的类型

* @param valueToCheck 待验证的值

* @param columnExtractor 实体类属性提取函数

* @param queryExecutor 单条数据查询执行器

* @param errorMessage 异常提示信息模板

*/

public static <T, R, V> void ensureColumnValueValid(V valueToCheck, SFunction<T, R> columnExtractor, SFunction<LambdaQueryWrapper<T>, T> queryExecutor, String errorMessage) {

if (valueToCheck == null) return;

LambdaQueryWrapper<T> wrapper = new LambdaQueryWrapper<>();

wrapper.select(columnExtractor);

wrapper.eq(columnExtractor, valueToCheck);

wrapper.last("LIMIT 1");

T entity = queryExecutor.apply(wrapper);

R columnValue = columnExtractor.apply(entity);

if (entity == null || columnValue == null)

throw new DataValidationException(String.format(errorMessage, valueToCheck));

}

这个方法接受一个待验证的值、一个实体类属性提取函数、一个单行数据查询执行器和一个异常信息模板作为参数。通过这四个参数,不仅能够进行针对特定属性的有效性检查,而且还能生成具有一致性的异常信息。

对比分析

使用 Function 改造前

// 判断用户 ID 是否有效

public void checkUserExistence(String userId) {

User user = userDao.findById(userId);

if (user == null) {

throw new RuntimeException("用户ID无效");

}

}

// 判断部门 ID 是否有效

public void checkDeptExistence(String deptId) {

Dept dept = deptDao.findById(deptId);

if (dept == null) {

throw new RuntimeException("部门ID无效");

}

}

使用 Function 改造后

public void assignTaskToUser(AddOrderDTO dto) {

ensureColumnValueValid(dto.getUserId(), User::getId, userDao::getOne, "用户ID无效");

ensureColumnValueValid(dto.getDeptId(), Dept::getId, deptDao::getOne, "部门ID无效");

ensureColumnValueValid(dto.getCustomerId(), Customer::getId, customerDao::getOne, "客户ID无效");

ensureColumnValueValid(dto.getDeptId(), Dept::getId, deptDao::getOne, "部门ID无效");

ensureColumnValueValid(dto.getSupplieId(), Supplie::getId, supplierDao::getOne, "供应商ID无效");

// 现在可以确信客户存在

Customer cus = customerDao.findById(dto.getCustomerId());

// 创建订单的逻辑...

}

对比上述两段代码,我们发现后者不仅大幅减少了代码量,而且通过函数式编程,表达出更为清晰的逻辑意图,可读性和可维护性都有所提高。

优点

- 减少重复代码: 通过

ensureColumnValueValid方法,所有涉及数据库字段值有效性检查的地方都可以复用相同的逻辑,将变化的部分作为参数传递,大大减少了因特定校验逻辑而产生的代码量。 - 增强代码复用: 抽象化的校验方法适用于多种场景,无论是用户ID、订单号还是其他任何实体属性的校验,一套逻辑即可应对。

- 提升可读性和维护性: 通过清晰的函数签名和 Lambda 表达式,代码意图一目了然,降低了后续维护的成本。

- 灵活性和扩展性: 当校验规则发生变化时,只需要调整

ensureColumnValueValid方法或其内部实现,所有调用该方法的地方都会自动受益,提高了系统的灵活性和扩展性。

举一反三:拓展校验逻辑的边界

通过上述的实践,我们见识到了函数式编程在简化数据校验逻辑方面的威力。但这只是冰山一角,我们可以根据不同的业务场景,继续扩展和完善校验逻辑,实现更多样化的校验需求。以下两个示例展示了如何在原有基础上进一步深化,实现更复杂的数据比较和验证功能。

断言指定列值等于预期值

首先,考虑一个场景:除了验证数据的存在性,我们还需确认查询到的某列值是否与预期值相符。这在验证用户角色、状态变更等场景中尤为常见。为此,我们设计了 validateColumnValueMatchesExpected 方法:

/**

* 验证查询结果中指定列的值是否与预期值匹配

*

* @param <T> 实体类型

* @param <R> 目标列值的类型

* @param <C> 查询条件列值的类型

* @param targetColumn 目标列的提取函数,用于获取想要验证的列值

* @param expectedValue 期望的列值

* @param conditionColumn 条件列的提取函数,用于设置查询条件

* @param conditionValue 条件列对应的值

* @param queryMethod 执行查询的方法引用,返回单个实体对象

* @param errorMessage 验证失败时抛出异常的错误信息模板

* @throws RuntimeException 当查询结果中目标列的值与预期值不匹配时抛出异常

*/

public static <T, R, C> void validateColumnValueMatchesExpected(

SFunction<T, R> targetColumn, R expectedValue,

SFunction<T, C> conditionColumn, C conditionValue,

SFunction<LambdaQueryWrapper<T>, T> queryMethod,

String errorMessage) {

// 创建查询包装器,选择目标列并设置查询条件

LambdaQueryWrapper<T> wrapper = new LambdaQueryWrapper<>();

wrapper.select(targetColumn);

wrapper.eq(conditionColumn, conditionValue);

// 执行查询方法

T one = queryMethod.apply(wrapper);

// 如果查询结果为空,则直接返回,视为验证通过(或忽略)

if (one == null) return;

// 获取查询结果中目标列的实际值

R actualValue = targetColumn.apply(one);

// 比较实际值与预期值是否匹配,这里假设notMatch是一个自定义方法用于比较不匹配情况

boolean doesNotMatch = notMatch(actualValue, expectedValue);

if (doesNotMatch) {

// 若不匹配,则根据错误信息模板抛出异常

throw new RuntimeException(String.format(errorMessage, expectedValue, actualValue));

}

}

// 假设的辅助方法,用于比较值是否不匹配,根据实际需要实现

private static <R> boolean notMatch(R actual, R expected) {

// 示例简单实现为不相等判断,实际情况可能更复杂

return !Objects.equals(actual, expected);

}

这个方法允许我们指定一个查询目标列(targetColumn)、预期值(expectedValue)、查询条件列(conditionColumn)及其对应的条件值(conditionValue),并提供一个查询方法(queryMethod)来执行查询。如果查询到的列值与预期不符,则抛出异常,错误信息通过 errorMessage 参数定制。

应用场景:

例如在一个权限管理系统中,当需要更新用户角色时,系统需要确保当前用户的角色在更新前是 “普通用户”,才能将其升级为 “管理员”。此场景下,可以使用 validateColumnValueMatchesExpected 方法来验证用户当前的角色是否确实为“普通用户”。

// 当用户角色不是 “普通用户” 时抛异常

validateColumnValueMatchesExpected(User::getRoleType, "普通用户", User::getId, userId, userMapper::getOne, "用户角色不是普通用户,无法升级为管理员!");

断言指定值位于期望值列表内

进一步,某些情况下我们需要验证查询结果中的某一列值是否属于一个预设的值集合。例如,验证用户角色是否合法。为此,我们创建了 validateColumnValueMatchesExpectedList 方法:

/**

* 验证查询结果中指定列的值是否位于预期值列表内

*

* @param <T> 实体类型

* @param <R> 目标列值的类型

* @param <C> 查询条件列值的类型

* @param targetColumn 目标列的提取函数,用于获取想要验证的列值

* @param expectedValueList 期望值的列表

* @param conditionColumn 条件列的提取函数,用于设置查询条件

* @param conditionValue 条件列对应的值

* @param queryMethod 执行查询的方法引用,返回单个实体对象

* @param errorMessage 验证失败时抛出异常的错误信息模板

* @throws RuntimeException 当查询结果中目标列的值不在预期值列表内时抛出异常

*/

public static <T, R, C> void validateColumnValueInExpectedList(

SFunction<T, R> targetColumn, List<R> expectedValueList,

SFunction<T, C> conditionColumn, C conditionValue,

SFunction<LambdaQueryWrapper<T>, T> queryMethod,

String errorMessage) {

LambdaQueryWrapper<T> wrapper = new LambdaQueryWrapper<>();

wrapper.select(targetColumn);

wrapper.eq(conditionColumn, conditionValue);

T one = queryMethod.apply(wrapper);

if (one == null) return;

R actualValue = targetColumn.apply(one);

if (actualValue == null) throw new RuntimeException("列查询结果为空");

if (!expectedValueList.contains(actualValue)) {

throw new RuntimeException(errorMessage);

}

}

这个方法接受一个目标列(targetColumn)、一个预期值列表(expectedValueList)、查询条件列(conditionColumn)及其条件值(conditionValue),同样需要一个查询方法(queryMethod)。如果查询到的列值不在预期值列表中,则触发异常。

应用场景: 在一个电商平台的订单处理流程中,系统需要验证订单状态是否处于可取消的状态列表里(如 “待支付”、“待发货”)才允许用户取消订单。此时,validateColumnValueInExpectedList 方法能有效确保操作的合法性。

// 假设 OrderStatusEnum 枚举了所有可能的订单状态,cancelableStatuses 包含可取消的状态

List<String> cancelableStatuses = Arrays.asList(OrderStatusEnum.WAITING_PAYMENT.getValue(), OrderStatusEnum.WAITING_DELIVERY.getValue());

// 验证订单状态是否在可取消状态列表内

validateColumnValueInExpectedList(Order::getStatus, cancelableStatuses, Order::getOrderId, orderId, orderMapper::selectOne, "订单当前状态不允许取消!");

通过这两个扩展方法,我们不仅巩固了函数式编程在减少代码重复、提升代码灵活性方面的优势,还进一步证明了通过抽象和泛型设计,可以轻松应对各种复杂的业务校验需求,使代码更加贴近业务逻辑,易于理解和维护。

核心优势

- 代码复用:通过泛型和函数式接口,该方法能够适应任何实体类和属性的校验需求,大大减少了重复的查询逻辑代码。

- 清晰表达意图:方法签名直观表达了校验逻辑的目的,提高了代码的可读性和可维护性。

- 灵活性:使用者只需提供几个简单的 Lambda 表达式,即可完成复杂的查询逻辑配置,无需关心底层实现细节。

- 易于维护与扩展:

- 当需要增加新的实体验证时,仅需调用

ensureColumnValueValid并传入相应的参数,无需编写新的验证逻辑,降低了维护成本。 - 修改验证规则时,只需调整

ensureColumnValueValid内部实现,所有调用处自动遵循新规则,便于统一管理。 - 异常处理集中于

ensureColumnValueValid方法内部,统一了异常抛出行为,避免了在多个地方处理相同的逻辑错误,减少了潜在的错误源。

- 当需要增加新的实体验证时,仅需调用

函数式编程的力量

通过这个实例,我们见证了函数式编程在简化代码、提高抽象层次上的强大能力。在 Java 8 及之后的版本中,拥抱函数式编程思想,不仅能够使我们的代码更加简洁、灵活,还能在一定程度上促进代码的正确性和可测试性。因此,无论是日常开发还是系统设计,都值得我们深入探索和应用这一现代编程范式,让代码如魔法般优雅而高效。

来源:juejin.cn/post/7384256110280572980

只写后台管理的前端要怎么提升自己

本人写了五年的后台管理。每次面试前就会头疼,因为写的页面除了表单就是表格。抱怨过苦恼过也后悔过,但是站在现在的时间点回想以前,发现有很多事情可以做的更好,于是有了这篇文章。

写优雅的代码

一道面试题

大概两年以前,面试美团的时候,面试官让我写一道代码题,时间单位转换。具体的题目我忘记了。

原题目我没做过,但是我写的业务代码代码里有类似的单位转换,后端返回一个数字,单位是kb,而我要展示成 KB,MB 等形式。大概写一个工具函数(具体怎么写的忘记了,不过功能比这个复杂点):

function formatSizeUnits(kb) {

let units = ['KB', 'MB', 'GB', 'TB', 'PB'];

let unitIndex = 0;

while (kb >= 1024 && unitIndex < units.length - 1) {

kb /= 1024;

unitIndex++;

}

return `${kb.toFixed(2)} ${units[unitIndex]}`;

}

而在此之前,是一个后端同学写的代码(说起来,后台管理系统前端人力不够后端帮忙写好像是常规操作,后端总觉得写前端简单,而我只能说你们那代码写的,一言难尽……),如下:

function formatSizeUnits(kb) {

var result = '';

if (kb < 1024) {

result = kb + ' KB';

} else if (kb < 1024 * 1024) {

result = (kb / 1024).toFixed(2) + ' MB';

} else if (kb < 1024 * 1024 * 1024) {

result = (kb / 1024 / 1024).toFixed(2) + ' GB';

} else {

result = (kb / 1024 / 1024 / 1024).toFixed(2) + ' TB';

}

return result;

}

虽然功能都一样,但是我写在面试的时候写了上面的代码得到了面试官的赞扬,也因此非常顺利的通过了面试。而如果我写成了下面的样子,估计不会有这种效果。

如何提升代码质量

想提升代码质量,最理想的是靠 code review ,但实际上这玩意在大多数公司根本就不存在。其次就只能多看看大佬们写的代码,但是一来后台管理本来就没太大难度很少有大佬,二来很多时候一个后台管理系统就一两个人负责。

还好现在有了各种 AI 工具,可以非常方便的优化自己的代码了。

还是上面的问题,看看 GPT 给的答案

// 提问:写一个工具函数,对文件大小的单位进行转换,加注释

// 回答:下面是一个JavaScript工具函数,它接受文件大小、初始单位、目标单位和小数位数,然后返回目标单位下的文件大小。

/**

* 将文件大小从一个单位转换为另一个单位。

*

* @param {number} size 文件大小。

* @param {string} fromUnit 初始单位('B', 'KB', 'MB', 'GB', 'TB', 'PB', 'EB', 'ZB', 'YB')。

* @param {string} toUnit 目标单位('B', 'KB', 'MB', 'GB', 'TB', 'PB', 'EB', 'ZB', 'YB')。

* @param {number} [decimalPoint=2] 结果保留的小数位数,默认为2。

* @return {string} 转换后的文件大小,带单位。

*/

function convertFileSize(size, fromUnit, toUnit, decimalPoint = 2) {

// 定义单位与字节之间的转换关系

const units = ['B', 'KB', 'MB', 'GB', 'TB', 'PB', 'EB', 'ZB', 'YB'];

// 获取初始单位和目标单位的索引

const fromIndex = units.indexOf(fromUnit);

const toIndex = units.indexOf(toUnit);

// 如果单位不在列表中,抛出错误

if (fromIndex === -1 || toIndex === -1) {

throw new Error('Invalid units');

}

// 计算初始单位与目标单位之间的转换系数

const exponent = toIndex - fromIndex;

// 计算结果大小

const resultSize = size / Math.pow(1024, exponent);

// 返回格式化后的结果

return parseFloat(resultSize.toFixed(decimalPoint)) + ' ' + toUnit;

}

// 示例使用

console.log(convertFileSize(1, 'GB', 'MB')); // 输出: 1024.00 MB

console.log(convertFileSize(1, 'MB', 'KB')); // 输出: 1024.00 KB

console.log(convertFileSize(1, 'KB', 'B')); // 输出: 1024.00 B

console.log(convertFileSize(1, 'MB', 'GB', 5)); // 输出: 0.00098 GB

还能说什么,我只能说 NB!(经评论区提示,此段代码可能有问题,建议大家在使用AI工具时,重点是借鉴思路,直接使用代码需要谨慎~)

我现在每次写大段逻辑之后都习惯拿给 AI 看看,有什么更好的实现方式,或者用什么设计模式。AI 是非常低成本且高效提升代码质量的工具。

学会封装

一个功能用到了好多次,为什么不封装成组件?一个组件用到了好几个项目,为什么不单独写个npm包?差不多的项目创建了好几个,为什么不封装成脚手架?

你说,没时间,没必要,复制粘贴反而更快。

那你就完全没理解,这么做不一定是为了让工作更快完成,而是可以让你在年年终述职时更有话说(你就算写了一百个表单表格没有写一个脚手架更值得炫耀),如果不会写可以问问 AI。

而当你真正开始封装组件,开始写工具库了,你会发现你需要思考的确实比之前多了。

关注业务

对于前端业务重要吗?

相比于后端来说,前端一般不会太关注业务。就算出了问题大部分也是后端的问题。

但是就我找工作的经验,业务非常重要!

如果你做的工作很有技术含量,比如你在做低代码,你可以面试时讲一个小时的技术难点。但是你只是一个破写后台管理,你什么都没有的说。这个时候,了解业务就成为了你的亮点。

一场面试

还是拿真实的面试场景举例,当时前同事推我字节,也是我面试过N次的梦中情厂了,刚好那个组做的业务和我之前呆的组做的一模一样。

- 同事:“做的东西和咱们之前都是一样的,你随便走个过场就能过,我在前端组长面前都夸过你了!”

- 我:“好嘞!”

等到面试的时候:

- 前端ld:“你知道xxx吗?(业务名词)”

- 我:“我……”

- 前端ld:“那xxxx呢?(业务名词)”

- 我:“不……”

- 前端ld:“那xxxxx呢??(业务名词)”

- 我:“造……”

然后我就挂了………………

如何了解业务

- 每次接需求的时候,都要了解需求背景,并主动去理解

我们写一个表格简简单单,把数据展示出来就好,但是表格中的数据是什么意思呢?比如我之前写一个 kafka 管理平台,里面有表格表单,涉及什么

clustercontrollertopicbrokerpartition…… 我真的完全不了解,很后悔我几年时间也没有耐下心来去了解。 - 每次做完一个需求,都需要了解结果

有些时候,后台管理的团队可能根本没有PM,那你也要和业务方了解,这个功能做了之后,多少人使用,效率提高了吗?数据是怎样的?

- 理解需求,并主动去优化

产品要展示一千条数据,你要考虑要不要分页,不分页会不会卡,要不要上虚拟表格?

产品要做一个可拖拽表单,你要考虑是否需要拖动,是否需要配置。

其实很多时候,产品的思维可能会被局限在竞品的实现方式,而前端可以给TA更多选项。在和产品沟通的时候,你不仅是沟通页面的实现,也更能理解业务。

关注源码

说到源码, Vue,React 这些基本是每次必问,也有太多大佬们的总结我就不多说了。

除此之外,我想大家每次面试应该都会被问,你写了什么亮点的项目,困难的项目,你会说什么?哦,都是表单表格,都用 Element UI 实现的,没什么难度。那估计你面试也就到这里了。

那说什么,后台管理就这些啊?!

如果你用了 Element UI 你可以说写了什么自定义 Element UI 表单组件,Element UI 表单源码是什么原理,怎么通信的?用了 Axios 可以说 Axios 的原理,它的拦截器怎么实现的?用了编辑器 diff 那你知道 diff 算法是什么吗?用了 ECharts 那你知道他底层是用什么绘制的吗?用了 husky ?husky的原理是什么?用了Vite,它为什么快?是怎么打包的?写过插件吗?

可能有人觉得我离谱,事实上上面每一个问题都是我在面试中真实被问到的。当然,如果全部去了解,肯定不现实,每个人的精力有限,不可能每个用到的每个工具每个库都去了解原理,不过只要有一两个你去了解过,就可以在面试中引导面试官来问,要学会表现出你擅长的点。

至于怎么读源码?以前我不知道,现在嘛…… 为什么不问问神奇的 ChatGPT 呢?

讲一下 Axios 源码中,拦截器是怎么实现的?

Axios 的拦截器实现基于 Axios 的核心原理,即 Axios 实例是一个包含请求和响应拦截器堆栈的对象。当发出请求或接收响应时,Axios 会遍历这些拦截器,并按照添加的顺序执行请求拦截器,以及按照相反的顺序执行响应拦截器。

在 Axios 的源码中,拦截器是通过一个 AxiosInterceptorManager 实例来管理的,它维护了一个拦截器数组。每个拦截器都是一个包含

fulfilled和rejected函数的对象。这两个函数分别对应于拦截器成功处理和拦截器处理出错的情况。

以下是 Axios 拦截器管理器的一个简化版本,展示了其核心实现思路:

class InterceptorManager {

constructor() {

this.handlers = []; // 存储拦截器的数组

}

use(fulfilled, rejected) {

this.handlers.push({

fulfilled: fulfilled,

rejected: rejected

});

return this.handlers.length - 1; // 返回拦截器的ID

}

eject(id) {

if (this.handlers[id]) {

this.handlers[id] = null; // 移除拦截器

}

}

forEach(fn) {

this.handlers.forEach((h) => {

if (h !== null) {

fn(h);

}

});

}

}

在发送请求或接收响应时,Axios 会创建一个 promise 链,并通过

forEach方法将拦截器中的fulfilled和rejected函数添加到这个链中。这样,每个拦截器都可以对请求或响应进行处理,然后将结果传递到链的下一个拦截器,或者在出错时结束链的执行。

axios.interceptors.request.forEach(function unshiftRequestInterceptors(interceptor) {

chain.unshift(interceptor.fulfilled, interceptor.rejected);

});

axios.interceptors.response.forEach(function pushResponseInterceptors(interceptor) {

chain.push(interceptor.fulfilled, interceptor.rejected);

});

在 Axios 的完整实现中,这个拦截器机制被集成到了 Axios 的请求发送和响应处理流程中。通过这种方式,Axios 可以在发送请求之前和接收响应之后,但在用户定义的

.then或.catch执行之前,插入自定义的逻辑。

请注意,这里提供的代码只是为了说明 Axios 拦截器的实现原理,并不是 Axios 源码的完整复制。如果你对 Axios 的拦截器实现细节感兴趣,建议查看 Axios 的官方 GitHub 仓库中的源码。

前端基建

当我们工作时间久了面试难免会遇到这些问题,前端工程化,前端监控,工作流,部署,性能等等。其实我们在工作中绝大部分时间都在写代码,对于这些不是所有人都有机会接触到,不过这些和所做的业务无关,是我们提升自己很好的一个思路。

技术选型

技术栈选 Vue 还是 React?Vue 选 Vue2 还是 Vue3?组件库选 ElementUI 还是 Ant Design?微前端有没有使用过?打包工具用 Vite 还是 Webpack?有那么多表单怎么实现的,有没有什么表单配置化方案,比如Formily?

对于我这种菜鸡,我这种只写简单的表单表格的人,这些都……无所谓……

不过为了应对面试我们还是需要了解下未选择技术栈的缺点,和已选择技术栈的优点(有点本末倒置…但是常规操作啦)

Vue 你可以说简单高效轻量级,面试必会问你为什么,你就开始说 Vue 的响应式系统,依赖收集等。

React 你可以说 JSX、Hooks 很灵活,那你必然要考虑 JSX 怎么编译, Hooks 实现方式等。

总体而言,对于技术选型,依赖于我们对所有可选项的理解,做选择可能很容易,给出合理的理由还是需要花费一些精力的。

开发规范

这个方面,在面试的时候我被问到的不多,我们可以在创建项目的时候,配置下 ESlint,stylelint, prettier, commitlint 等。

前端监控

干了这么多年前端,前端监控我是……一点没做过。

前端监控,简单来说就是我们在前端程序中记录一些信息并上报,一般是错误信息,来方便我们及时发现问题并解决问题。除此之外也会有性能监控,用户行为的监控(埋点)等。之前也听过有些团队分享前端监控,为了出现问题明确责任(方便甩锅)。

对于实现方案,无论使用第三方库还是自己实现,重要的都是理解实现原理。

对于错误监控,可以了解一下 Sentry,原理简单来说就是通过 window.onerror 和 window.addEventListener('unhandledrejection', ...) 去分别捕获同步和异步错误,然后通过错误信息和 sourceMap 来定位到源码。

对于性能监控,我们可以通过 window.performance、PerformanceObserver 等 API 收集页面性能相关的指标,除此之外,还需要关注接口的响应时间。

最后,收集到信息之后,还要考虑数据上报的方案,比如使用 navigator.sendBeacon 还是 Fetch、AJAX?是批量上报,实时上报,还是延迟上报?上报的数据格式等等。

CI/CD

持续集成(Continuous Integration, CI)和 持续部署(Continuous Deployment, CD),主要包括版本控制,代码合并,构建,单测,部署等一系列前端工作流。

场景的工作流有 Jenkins、 Gitlab CI 等。我们可以配置在合并代码时自动打包部署,在提交代码时自动构建并发布包等。

这块我了解不多,但感觉这些工具层面的东西,不太会涉及到原理,基本上就是使用的问题。还是需要自己亲自动手试一下,才能知道细节。比如在 Gitlab CI 中, Pipeline 、 Stage 和 Job 分别是什么,怎么配置,如何在不同环境配置不同工作流等。

了解技术动态

这个可能还是比较依赖信息收集能力,虽然我个人觉得很烦,但好像很多领导级别的面试很愿意问。

比如近几年很火的低代码,很多面试官都会问,你用过就问你细节,你没用过也会问你有什么设计思路。

还有最近的两年爆火的 AI,又或者 Vue React的最新功能,WebAssembly,还有一些新的打包工具 Vite Bun 什么的,还有鸿蒙开发……

虽然不可能学完每一项新技术,但是可以多去了解下。

总结

写了这么多,可能有人会问,如果能回到过去,你会怎么做。

啊,我只能说,说是一回事,做又是另一回事,事实上我并不希望回到过去去卷一遍,菜点没关系,快乐就好,一切都是最好的安排。

来源:juejin.cn/post/7360528073631318027

为什么小明刚入职就碰到跨域问题然后转身离职?

故事的开始

故事还要从某个大厂的前端工程师 小明 说起。

小明兴高采烈的入职了某大厂的前端工程师岗位,就小明的水平的话,写写前端代码不在话下。

周四这天,小明吃完肯德坤之后,打开电脑浏览器,刷新页面,控制台就出现了下面的报错信息:

小明摸了摸自己大大的鼻子,一眼就看到了问题:

demo.hamm.cn访问api.hamm.cn跨域了。

凭借多年的经验,小明瞬间就想到了解决方案:

那就摇人

因为刚入职,碰到这个问题他也不知道该找哪个人来处理,因为他没有 API 服务器的权限,于是在群里说了一句:

小明(前端):“哪位大哥帮忙配置下跨域, api.hamm.cn 需要允许来自 demo.hamm.cn 的跨域请求。”

三分钟后...

小贾(Java):“收到,我看看”

小董(运维):“好的,现在在外面,半小时后回”

五分钟后,小明收到了来自 Java 同学 小贾 的私聊:

小贾(Java):“好的,已配置好跨域头,你看看”

小明(后端):“咦,可以了。感谢大哥!”

出幺蛾子了

半小时后,运维的 小董 同学回到公司,马不停蹄的给配了跨域头。

刚准备私聊告诉小明,却见 Java 的小贾同学在群里 @ 自己:

小贾(Java):“@小董(运维) 董哥,你的网关侧是不是有问题,我配置了跨域头,小明这边刚才还好好的可以跨域,这会又炸了。。。”

只见小明发了张图:

群里炸锅了

咦,两个请求头

怎么请求头两个了之后反而跨域失败了呢?

查找问题

运维哥 和 Java哥 一脸懵,于是开始查找问题。

只见小明不慌不忙的在群里 @ 了两人:

小明(前端):“@小董(运维) @小贾(Java) 两位哥,你们俩应该都配置了跨域头,两个跨域头也会跨域失败的哦~”

小董(运维):“@小贾(Java) 你应用服务里的去掉吧”

小贾(Java):“...”,心想 不是我先配置的么,凭什么。。。

你们都是在网关侧还是业务侧配置的允许跨域呢?欢迎评论区讨论

多跨域头禁止跨域

原来,多跨域头下,浏览器认为数据可能是被中间代理过,觉得不够安全,所以禁止了跨域访问。

MDN关于跨域 origin 的解释:

developer.mozilla.org/zh-CN/docs/…

第二天

小明递上了自己的离职申请书。

来源:juejin.cn/post/7444840771779690530

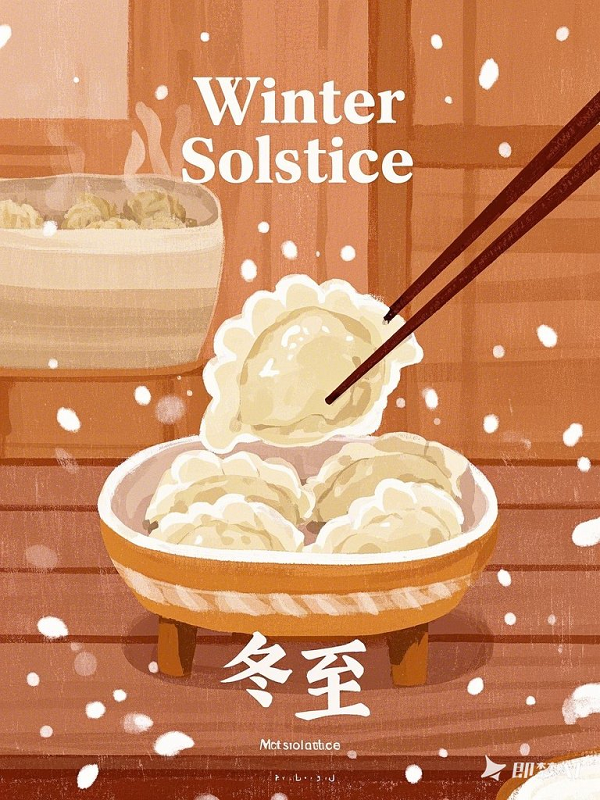

即梦AI上线新功能,可一句话生成中文海报

近日,即梦AI升级了图片生成功能,用户使用即梦pc版或app时,选择最新上线的图片2.1生图模型,通过输入文本描述,即可生成带有指定文字的海报。

例如,输入:生成一张含有筷子夹起饺子的冬至插画海报,标题是“Winter Solstice”下方是“冬至”两字,即梦就能按照指令快速完成。

据测试用户反馈,即梦AI新功能已经可以较为准确地生成中文文字,生图效果也更具影视质感。测试期间,用户已衍生出表情包、四格漫画、手写风格等多种玩法,更大限度地释放了创意。

字节豆包大模型团队相关负责人表示,豆包文生图模型通过打通LLM和DIT架构,具备更好的原生中文数据学习能力,并在此基础上强化汉字生成能力,大幅提升了生成效果。不过目前对于复杂的汉字生成还有提升的空间。据即梦相关负责人,团队正持续对文生图功能进行优化升级,近期还将上线对生成文字进行涂抹修改的功能,助力创作者们更好地实现想象力。

即梦AI是字节跳动旗下的AI内容平台,支持通过自然语言及图片输入,生成高质量的图像及视频。平台提供智能画布、故事创作模式,以及首尾帧、对口型、运镜控制、速度控制等AI编辑能力,并有海量影像灵感及兴趣社区,一站式提供用户创意灵感、流畅工作流、社区交互等资源,为用户的创作提效。(作者:李双)

收起阅读 »微信小程序批量自动化部署

CI/CD这个概念很实用,但我们这种小作坊,没有一些很高大上的应用。

最常见的使用场景就是,开发者一键提交分支master,交给工作流工具完成构建,部署的后续操作,自动更新测试或线上环境。

个人博客等项目可以使用Github action来实现,但公司的代码在云效上,我更习惯于使用云效Flow来实现自动化部署。他的操作菜单是可视化的,非常方便,还有一些推送机器人消息的傻瓜化配置插件。

目前遇到一个需求,就是同一个uni-app小程序项目,需要部署到多个不同的小程序上。每个小程序的主要功能类似,但都有一些定制改动。

每次项目发版时,如果要手动挨个在微信开发者工具上切换、上传,会非常繁琐,而且uni-app使用dev命令输出的开发环境微信小程序项目代码也没有优化,正式发版时哪怕只有一个小程序也需要在dev、build两个项目里来回切。

因此非常需要自动化部署来节省精力。

下面梳理一下微信小程序的批量自动化部署实现流程。

准备工作

常见的web项目自动化部署,至少包含代码触发、构建、部署这3个步骤。

其中构建步骤中操作的产物会被打包上传,并在部署步骤中,下载到目标服务器,然后执行后续目录操作、启动等操作。

但是微信小程序的部署不需要这些操作,而是通过在node脚本中执行miniprogram-ci这个工具的相关方法来实现的。

miniprogram-ci的相关文档请参考这里。

密钥及IP白名单配置

跟着文档操作,首先需要到微信小程序管理后台的开发设置中进行配置。

点击生成按钮即可创建密钥,关闭后只能重新生成。

将密钥文件下载到安全的位置。由于我们的项目是私有库,这里就直接放到了项目deploy目录下。多个小程序的密钥可以放在一起,默认已经用appId做了区分。

云效Flow的构建集群提供了一组IP地址,将这些IP地址加入白名单即可。地址如下:

47.94.150.88

47.94.150.17

47.93.89.246

123.56.255.38

112.126.70.240

IP地址不在白名单的话,调用上传时会报错。如果在本地调试,别忘了将本机的公网IP加入白名单,或者临时关闭。

构建脚本

uni-app项目使用vite框架,这里用到了.env环境变量的相关功能,原生微信小程序请自行实现或省略此功能。

更新版本号

微信小程序上传时,需要指定版本号。

版本号标准的用法还是放在package.json中,所以我在自动化部署实现过程中,顺便就引入了standard-version版本号管理。(项目被标记为deprecated,但我没有找到其他适合私有库的版本号管理工具,欢迎指点。)

standard-version可以自动根据git提交记录生成CHANGELOG.md。

并按照以下初始规则来生成版本号:

如果上个版本之间的提交只有fixed,更新patch版本号,比如1.0.0更新到1.0.1。

否则更新minor版本号,比如1.0.0更新到1.1.0。

更新版本号的同时,它会将CHANGELOG.md与更新版本号以后的package.json一同提交到git,同时创建一个版本号对应的tag。