或许,找对象真的太难了……

找对象真的太难了,我不由地发出这个感慨

但其实说着也奇怪,明明我每天两点一线,上班了去工位、下班了回宿舍,根本没有其他社交,但我为什么会发出这样的感慨呢?

- 是因为总是在无聊时感到了孤独才希望有个伴,还是看见大家都有伴了才觉得自己孤独?

- 是因为看到了别人功成名就家庭和谐的嫉妒,还是吊儿郎当无所事事地调侃?

- 是因为信息茧房导致我对婚姻产生了偏见而刻意疏远,还是无能狂怒般自卑不敢去尝试?

- ……

如果是针对我个人的话,那应该是自卑了吧。这辈子30多年没什么情感经历,就只有一次相亲后“交往”的经验。那次相亲后异地聊了9个月,中间节假日只有我回去见了3次面,没有矛盾,每天都在线上花个两三个小时也都聊得很开心,但我却总觉得彼此都像个不熟的人,以至于最后“分手”时内心也毫无波澜。

“或许我根本不需要为了找个伴才选择想找对象吧。”我总是这样安慰自己,其实安慰的次数不多,因为我没有经常想。

我每天两点一线的生活很规律,很轻松,最重要的是,我已经非常习惯了。所以从某种程度来讲,“客观上”,我并没有真的想找对象、也没有主动去尝试结交新朋友,“主观上”,现在的社会风向和经济形势,不太利于我尝试告别单身,即便 A 股沪指最近持续性突破十年新高。

光是想,不去做,那可不就是“太难了”。

其实,有那么一瞬间我也想结婚

可怜的是,这并不是基于我个人的想法,而是外界的干扰。我记得我31岁生日那天,凌晨6点过还在睡梦中,外公外婆就打来电话,祝我生日快乐。我很诧异,因为我没想到农忙时节呢,他们还没忙忘了,也因为居然这么早,鸡鸭才刚叫。然后一如既往地说:不要太节约了,吃点好的,照顾好自己……然后,快点找对象,天天瞌睡都睡不好,揪心得很哦。结了婚他们就放心了,不然他们死了都不安心哦。

或许80多岁的老人家觉得,任何事情,只要你想要,那就能发生。我想要天上掉金子,天上就会掉金子;我想要地里喷石油,地里就会喷石油;我想要找对象,自然就有对象……

我倒是习以为常了,只不过那一整天,就没有第二个人祝我生日快乐了。不管是朋友同事,还是父母亲戚,即便是早我一天过生日、而我在生日前一天给她发去生日祝福的堂姐,都没有。

其实我也是习以为常了,可能因为我的生日也是我爷爷的忌日,我总是刻意淡忘它,大部分时候过生日我自己都会忘记,10岁之后就没有任何一次庆祝生日的行为——10岁那年父母要都外出打工,自此再次成为留守儿童。

但今年有那么一瞬间,突然觉得难得只有两个80多岁的老人还记得我生日,一直让他们失望有点于心不忍,更何况,正常来讲,我还能“忤逆”他们多少年呢?

可惜的是,就和那些贩卖焦虑的短视频、营销号一样,总是提出问题、夸大问题、制造矛盾、激化矛盾,但从来不会提供解决方法一样:想结婚了,然后呢?

独身一人在无聊的时候确实是无聊的

最近不知道是上班天天盯着电脑看久了,还是下班游戏玩多了,眼睛特别酸痛,于是我难得的又在下班之后出去逛了逛。

正常的话吃了饭我就玩游戏了,先玩几把NBA 2K,再玩几把英雄联盟手游,再玩几把王者荣耀。

其实曾几何时,我从生理上都厌恶王者荣耀的,因为它把很多中国历史人物文化名人,搞成游戏中乱七八糟的角色,让我无法接受。以至于这么多年来,从同学同事、到堂表兄弟等,都没有机会跟我一起玩。

我也没想到我居然突然之间就接受了,即便这曾经让我生理上讨厌的东西。我记得很清楚,2025年7月2日,我新历生日那天,我下载了王者荣耀,建立了账号,开始游玩,持续十几天有空就一直在玩,一百来把、十几级的账号打到最低等级的王者段位,觉得差不多入门了,想着和老同学、老朋友、老同事们一起玩时,才发现他们都不上线了。或许,随着年龄的增长,这种“年轻时的生理厌恶”都敌不过“无聊时的孤单寂寞”。

所以每次当我一个人出去小道散步闲逛消磨时间时,总会特别在意那些跑步锻炼身体的人、散步话家常的两公婆、坐在摊位小车后面玩手机的摆摊老板……感觉他们都有目的地在做什么,而只有我在漫无目的地走着。

其实这条路我之前走过,至少在我今年生日之前,只不过那个时候,这马路边的行人道,没有这么多杂草、灌木。就像人生路,总是在回忆的时候,才觉得曾经如此宽阔,才懊悔当时未曾踏入。可是,时光一直向前流逝,回忆永远迭代更新。

可能现在生活没有达到预期的我们总是有这样的想法,要是能回到过去就好了。实际上只是想带着现在的记忆回到过去,去弥补一些错过或者错误。似乎真像有多元宇宙,回到过去之后会有新的时间线,补足那些遗憾,每一次的回溯,终究会得到一条完美符合心意的时间线。实际上我觉得,即便我们能回到过去,那也是会失去所有记忆,然后完完整整重复之前做过的事情,又一次的错过或者错误,不会有多条时间线,即便你回去再多次,都只会重复同样的事情,都只是同一条时间线。但只有这一条时间线,其实也就够了。

正因为消极,所以才乐观

其实我一直是希望传播积极乐观心态的,从我以往的文章总能看到有这样的痕迹。但就像那些奢侈品广告一样:你买得起不重要,你买不起才重要。

就像我当年创业板3600多点最高峰买入了很多和创业板强关联基金一样,那时总觉得中国经济一定是蒸蒸日上,最后一路跌倒了1500点,一点点割肉,最后全盘清掉,赔了一些钱,然后不敢再入场。所以我也没赶上或者说是错过了今年大半年的牛市,有点难受。与之相对的,为了求稳买入了大量的债券,却债市正熊,又套在手里,更难受了。

可能这都不是什么大事,毕竟只是对我造成了一些经济损失,并不会影响到我的一如既往平凡普通的物质生活;但是焦虑、担忧、烦闷的心态,却非常影响我的精神状态,严重损坏我本就低迷的精神生活。

我一直有个想法,希望尽量在35岁前能多攒一些钱,这样如果35岁之后某天丢了工作,我就徒步去环游中国。并不是他们那种雄心壮志地环游,什么“朝圣“”啊、“远离浮躁净化心灵”啊。就跟平时一样,大街小巷,散步流浪,随便走走看看,不过变成了走到哪里黑,就到哪里歇。等到钱花光了,人老了走不动,客死他乡,也算得偿所愿了。

如果真的能到这个时候,身后没有拖拽、肩上没有负担,该是多么舒服的境况。

发现了吗,其实我就是这么矛盾,一方面安慰自己钱财乃身外物,不必强求;另一方面又觉得钱财乃必需品,多多益善。原因非常简单,因为我缺这东西,所以看得很重;又因为没本事挣到更多,所以才安慰自己它不重要。

这就是别人说的,看清问题根源比无法解决问题更让人窒息,也就是“无知是福”或者”无知者无畏”的感悟了。

每个人都应该有自己的活法,即便大同小异

正如写代码的人,总是会重复造轮子,偶尔还会乐此不疲。世上的人这么多,大部分的人的都是千篇一律的,事实上,大家都在做的事情,说不定才是对的。大家都重复着读书、工作、结婚、生子、工作、退休、等死的生活,正是因为在和平年代这就是一个非常典型且应该让人轻松愉悦、容易接受的平凡人的人生。

同样功能、完全适配你项目的工具包,一个周下载几百万、上次更新1个月前,一个周下载几十、上次更新5年前,只考虑下载使用的话,你会怎么选呢?

就像正因为他是魔丸才敢高喊“我命由我不由天”,就像有人说对钱不感兴趣;也就像也有人觉得“奋斗用多大劲啊?”就像我以为“忠诚的不绝对就是绝对的不忠诚”只是一个战锤40K的梗而已……这个世界本来就因为科技发展而不断更新,止不住的时代洪流,纷纷扰扰的世界,何必太关注别人关心的事情,兜兜转转可能发现,你特别在意的东西别人根本没放在心上,你漫不经心地言语却刺穿了别人的心脏。所有的一切,在心脏停止跳动之前,其实都无关紧要;而在心脏停止跳动之后,更是毫无意义。

所以我平时有空的时候,也会更新一下我 Github 仓库中几个开源的小项目,虽然没什么技术含量,还借助了很多AI辅助编码,但我在写完测试完成之后的那一刻感觉很舒服,就算之后很久都没再更新、测试,还发现了bug,但那完成时的一瞬间很舒服,就成了我持续不断更新的主观能动性之一。

人总有一死,我一直强调不要太在意他人的眼光,为自己而生活。但如果你根本不知道自己想要过什么样的人生,那么从众并不是什么丢人的行为。 人生短暂,不值得斤斤计较,浪费也是它应该存在的过程片段。

坐在厂门口的女子

我今天出去散步的时候,经过了隔壁厂,恰巧看到一位女士蹲在门口马路牙子上,左手拿着装炸土豆片套着塑料袋的小盒子,右手拿着手机看小说。我在外面溜达了个把小时,回去的时候发现她还蹲着那马路牙子上,可能是同一个位置,只不过只有右手拿着手机继续看着小说。

但我猜测她“可能”并没有一直蹲着那里看小说,因为那装炸土豆片的小纸盒没有在她左手上继续拿着,也没有放在她的身旁……

为什么只是“猜测和可能”呢?谁知道呢,或许她站起来走几步丢到垃圾桶后又蹲回去了,或许只是她吃完了空纸盒子放在旁边被风吹走了;或许她没吃完揉吧揉吧纸盒子随手丢到马路对面去了,又或许甚至可能她变身奥特曼打走了怪兽又变回正常人继续在厂门口看小说了……

如果不是因为间隔这么久,看见她还呆在同一个位置,我可能根本就没在意。就像如果不是出来工作了10年依旧还在原地,我也不必过度“揣摩自己”。

可能因为总是太在意,所以才觉得一切都太难了…… 毕竟“得不到的永远在骚动……”

很难了,一个陌生人有两次遇到的机会。

多数情况下都只有一次机会。换成是我,如果我一开始也是蹲在厂门口的马路牙子上,估计没人会注意到。但我要是一开始就跪在厂门口不停在磕头,说不定就有人会注意到了……

结尾

哈哈,Gotcha!要不是我这几天玩游戏多了眼睛有点酸痛,需要休息一下,我才不会在这里长篇大论无病呻吟呢,都这么久没有更新了是吧,那我玩游戏看视频啥的时可是乐在其中、忘乎所以的,佝偻成一团都还在哈哈大笑呢。

所以,赶紧去做那些让你自己开心的事情吧,享受生活,这才是我们活着的原因之一,其他的事情,fxxk off。

来源:juejin.cn/post/7544259368277852175

我们来说一说什么是联合索引最左匹配原则?

什么是联合索引?

首先,要理解最左匹配原则,得先知道什么是联合索引。

- 单列索引:只针对一个表列创建的索引。例如,为 users 表的 name 字段创建一个索引。

- 联合索引:也叫复合索引,是针对多个表列创建的索引。例如,为 users 表的 (last_name, first_name) 两个字段创建一个联合索引。

这个索引的结构可以想象成类似于电话簿或字典。电话簿是先按姓氏排序,在姓氏相同的情况下,再按名字排序。你无法直接跳过姓氏,快速找到一个特定的名字。

什么是最左匹配原则?

最左匹配原则指的是:在使用联合索引进行查询时,MySQL/SQL数据库从索引的最左前列开始,并且不能跳过中间的列,一直向右匹配,直到遇到范围查询(>、<、BETWEEN、LIKE)就会停止匹配。

这个原则决定了你的 SQL 查询语句是否能够使用以及如何高效地使用这个联合索引。

核心要点:

- 从左到右:索引的使用必须从最左边的列开始。

- 不能跳过:不能跳过联合索引中的某个列去使用后面的列。

- 范围查询右停止:如果某一列使用了范围查询,那么它右边的列将无法使用索引进行进一步筛选。

举例说明

假设我们有一个 users 表,并创建了一个联合索引 idx_name_age,包含 (last_name, age) 两个字段。

| id | last_name | first_name | age | city |

| 1 | Wang | Lei | 20 | Beijing |

| 2 | Zhang | Wei | 25 | Shanghai |

| 3 | Wang | Fang | 22 | Guangzhou |

| 4 | Li | Na | 30 | Shenzhen |

| 5 | Zhang | San | 28 | Beijing |

索引 idx_name_age 在磁盘上大致是这样排序的(先按 last_name 排序,last_name 相同再按 age 排序):

(Li, 30) (Wang, 20) (Wang, 22) (Zhang, 25) (Zhang, 28)

现在,我们来看不同的查询场景:

✅ 场景一:完全匹配最左列

SELECT * FROM users WHERE last_name = 'Wang';

- 分析:查询条件包含了索引的最左列 last_name。

- 索引使用情况:✅ 可以使用索引。数据库可以快速在索引树中找到所有 last_name = 'Wang' 的记录((Wang, 20) 和 (Wang, 22))。

✅ 场景二:匹配所有列

SELECT * FROM users WHERE last_name = 'Wang' AND age = 22;

- 分析:查询条件包含了索引的所有列,并且顺序与索引定义一致。

- 索引使用情况:✅ 可以高效使用索引。数据库先定位到 last_name = 'Wang',然后在这些结果中快速找到 age = 22 的记录。

✅ 场景三:匹配最左连续列

SELECT * FROM users WHERE last_name = 'Zhang';

- 分析:虽然只用了 last_name,但它是索引的最左列。

- 索引使用情况:✅ 可以使用索引。和场景一类似。

❌ 场景四:跳过最左列

SELECT * FROM users WHERE age = 25;

- 分析:查询条件没有包含索引的最左列 last_name。

- 索引使用情况:❌ 无法使用索引。这就像让你在电话簿里直接找所有叫“伟”的人,你必须翻遍整个电话簿,也就是全表扫描。

⚠️ 场景五:包含最左列,但中间有断档

-- 假设我们有一个三个字段的索引 (col1, col2, col3) -- 查询条件为 WHERE col1 = 'a' AND col3 = 'c';

- 分析:虽然包含了最左列 col1,但跳过了 col2 直接查询 col3。

- 索引使用情况:✅ 部分使用索引。数据库只能使用 col1 来缩小范围,找到所有 col1 = 'a' 的记录。对于 col3 的过滤,它无法利用索引,需要在第一步的结果集中进行逐行筛选。

⚠️ 场景六:最左列是范围查询

SELECT * FROM users WHERE last_name > 'Li' AND age = 25;

- 分析:最左列 last_name 使用了范围查询 >。

- 索引使用情况:✅ 部分使用索引。数据库可以使用索引找到所有 last_name > 'Li' 的记录(即从 Wang 开始往后的所有记录)。但是,对于 age = 25 这个条件,由于 last_name 已经是范围匹配,age 列在索引中是无序的,因此数据库无法再利用索引对 age 进行快速筛选,只能在 last_name > 'Li' 的结果集中逐行检查 age。

总结与最佳实践

最左匹配原则的本质是由索引的数据结构(B+Tree) 决定的。索引按照定义的字段顺序构建,所以必须从最左边开始才能利用其有序性。

如何设计好的联合索引?

- 高频查询优先:将最常用于 WHERE 子句的列放在最左边。

- 等值查询优先:将经常进行等值查询(=)的列放在范围查询(>, <, LIKE)的列左边。

- 覆盖索引:如果查询的所有字段都包含在索引中(即覆盖索引),即使不符合最左前缀,数据库也可能直接扫描索引来避免回表,但这通常发生在二级索引扫描中,效率依然不如最左匹配。

来源:juejin.cn/post/7565940210148868148

掌握协程的边界与环境:CoroutineScope 与 CoroutineContext

CoroutineScope 与 CoroutineContext 的概念

CoroutineContext (协程上下文)

CoroutineContext 是协程上下文,包含了协程运行时所需的所有信息。

比如:

- 管理协程流程(生命周期)的

Job。 - 管理线程的

ContinuationInterceptor,它的实现类CoroutineDispatcher决定了协程所运行的线程或线程池。

CoroutineScope (协程作用域)

CoroutineScope 是协程作用域,它通过 coroutineContext 属性持有了当前协程代码块的上下文信息。

比如,我们可以获取 Job 和 ContinuationInterceptor 对象:

fun main() = runBlocking<Unit> {

val scope = CoroutineScope(EmptyCoroutineContext) // scope 并没有持有已有协程的上下文

val outerJob = scope.launch {

val innerJob = coroutineContext[Job]

val interceptor = coroutineContext[ContinuationInterceptor]

println("job: $innerJob, interceptor: $interceptor")

}

outerJob.join()

}

CoroutineScope 的另一个作用就是提供了 launch 和 async 协程构建器,我们可以通过它来启动一个协程。

这样,新创建的协程能够自动继承 CoroutineScope 的 coroutineContext。比如利用 Job,可以建立起父子关系,从而实现结构化并发。

GlobalScope

GlobalScope 是一个单例的 CoroutineScope 对象,所以我们在任何地方通过它来启动协程。

它的第二个特点是,它的 coroutineContext 属性是 EmptyCoroutineContext,也就是说它没有内置的 Job。

@DelicateCoroutinesApi

public object GlobalScope : CoroutineScope {

/**

* Returns [EmptyCoroutineContext].

*/

override val coroutineContext: CoroutineContext

get() = EmptyCoroutineContext

}

即使是我们手动创建的 CoroutineScope,其内部也是有 Job 的。

// 手动创建 CoroutineScope

CoroutineScope(EmptyCoroutineContext)

// CoroutineScope.kt

@Suppress("FunctionName")

public fun CoroutineScope(context: CoroutineContext): CoroutineScope =

ContextScope(if (context[Job] != null) context else context + Job()) // 自动创建Job对象

所以我们在 GlobalScope.coroutineContext 中是获取不到 Job 的:

@OptIn(DelicateCoroutinesApi::class)

fun main() = runBlocking<Unit> {

val job: Job? = GlobalScope.coroutineContext[Job]

if (job == null) {

println("job is null")

}

try {

val jobNotNull: Job = GlobalScope.coroutineContext.job

} catch (e: IllegalStateException) {

println("job is null, exception is: $e")

}

}

运行结果:

job is null

job is null, exception is: java.lang.IllegalStateException: Current context doesn't contain Job in it: EmptyCoroutineContext

那么,这有什么用吗?

其实,GlobalScope 所启动的协程没有父 Job。

这就意味着:

- 当前协程不和其他

Job的生命周期绑定,比如不会随着某个界面的关闭而自动取消。 - 它是顶级协程,生命周期默认为整个应用的生命周期。

- 它发生异常,并不会影响到其他协程和

GlobalScope。反之,GlobalScope本身也无法级联取消所有任务,因为它所启动的协程是完全独立的。

总结:GlobalScope 就是用来启动那些不与组件生命周期绑定,而是与整个应用生命周期保持一致的全局任务,比如一个日志上报任务。

关键在使用时,可能会有资源泄露的风险,需要正确管理好协程的生命周期。

Context 的三个实用工具

在挂起函数中获取 CoroutineContext

如果我们要在一个挂起函数中获取 CoroutineContext,我们不得不给将其作为 CoroutineScope 的扩展函数。

suspend fun CoroutineScope.printContinuationInterceptor() {

delay(1000)

val interceptor = coroutineContext[ContinuationInterceptor]

println("interceptor: $interceptor")

}

但我们知道挂起函数的外部一定有协程存在,所以是存在 CoroutineContext 的。为此,Kotlin 协程库提供了一个顶层的 coroutineContext 属性,这个属性的 get() 函数是一个挂起函数,它能在任何挂起函数中访问到当前正在执行的协程的 CoroutineContext。

import kotlin.coroutines.coroutineContext

suspend fun printContinuationInterceptor() {

delay(1000)

val interceptor = coroutineContext[ContinuationInterceptor]

println("interceptor: $interceptor")

}

另外,还有一个 currentCoroutineContext() 函数也能获取到 CoroutineContext,它内部实现也是 coroutineContext 属性。

为什么需要这个函数?

为了解决命名冲突,比如下面这段代码。

private fun mySuspendFun() {

flow<String> {

// 顶层属性

coroutineContext

}

GlobalScope.launch {

flow<String> {

// this 的成员属性优先级高于顶层属性

// 所以是外层 launch 的 CoroutineScope 的成员属性 coroutineContext

coroutineContext

}

}

}

在这种情况下,如果需要明确属性的源头,就需要使用 currentCoroutineContext() 函数,它会调用到那个顶层的属性。

CoroutineName 协程命名

CoroutineName 是一个协程上下文信息,我们可以使用它来给协程设置一个名称。

fun main() = runBlocking<Unit> {

val scope = CoroutineScope(EmptyCoroutineContext)

val name = CoroutineName("coroutine-1")

val job = scope.launch(name) {

val coroutineName = coroutineContext[CoroutineName]

println("current coroutine name: $coroutineName")

}

job.join()

}

运行结果:

current coroutine name: CoroutineName(coroutine-1)

它主要用于测试和调试,你可以使用它来区分哪些日志是哪个协程打印的。

自定义 CoroutineContext

如果我们要给协程附加一些功能,我们可以考虑自定义 CoroutineContext。

如果是简单的标记,可以优先考虑使用

CoroutineName。

自定义 CoroutineContext 需要实现 CoroutineContext.Element,并且提供 Key。为此,Kotlin 协程库提供了 AbstractCoroutineContextElement 来简化这个过程。我们只需这样,即可创建一个用于协程内部记录日志的 Context:

// 继承 AbstractCoroutineContextElement,并把 Key 传给父构造函数

class CoroutineLogger(val tag: String) : AbstractCoroutineContextElement(CoroutineLogger) {

// 声明专属的 Key

companion object Key : CoroutineContext.Key<CoroutineLogger>

// 添加专属功能

fun log(message: String) {

println("[$tag] $message")

}

}

使用示例:

fun main() = runBlocking<Unit> {

val scope = CoroutineScope(Dispatchers.Default)

val job = scope.launch(CoroutineLogger("Test")) {

val logger = coroutineContext[CoroutineLogger]

logger?.log("Start")

delay(5000)

logger?.log("End")

}

job.join()

}

运行结果:

[Test] Start

[Test] End

coroutineScope() 与 withContext()

coroutineScope 串行的异常封装器

coroutineScope 是一个挂起函数,它会挂起当前协程,直到执行完内部的所有代码(包括会等待内部启动的所有子协程执行完毕),最后一行代码的执行结果会作为函数的返回值。

coroutineScope 会创建一个新的 CoroutineScope,在这个作用域中执行 block 代码块。并且这个作用域严格继承了父上下文(coroutineContext),并会在内部创建一个新的 Job,作为父 Job 的子 Job。

coroutineScope从效果上来看,和launch().join()类似。

那么,它的应用场景是什么?

它的应用场景由它的特性决定,有两个核心场景:

- 在挂起函数中提供

CoroutineScope。(最常用)

suspend fun CoroutineScope.mySuspendFunction() {

delay(1000)

launch {

println("launch")

}

}

如果你要在挂起函数中启动一个新的协程,你只好将其定义为

CoroutineScope的扩展函数。不过,你也可以使用coroutineScope来提供作用域。

它能提供作用域,是因为挂起函数的外部一定存在着协程,所以一定具有

CoroutineScope。

suspend fun doConcurrentWork() {

val startTime = System.currentTimeMillis()

coroutineScope {

val task1 = async { // 任务1

delay(5000)

}

val task2 = async { // 任务2

delay(3000)

}

} // // 挂起,直到上面两个 async 都完成

val endTime = System.currentTimeMillis()

println("Total execution time: ${endTime - startTime}") // 5000 左右

}

- 业务逻辑封装并进行异常处理。(最重要)

我们都知道,我们无法在协程外部使用

try-catch捕获协程内部的异常。

但使用

coroutineScope函数可以,当它内部的任何子协程失败了,它会将这个异常重新抛出来,这时我们可以使用try-catch来捕获。

fun main() = runBlocking<Unit> {

try {

coroutineScope {

val data1 = async {

"user-1"

}

val data2 = async {

throw IllegalStateException("error")

}

awaitAll(data1, data2)

}

} catch (e: Exception) {

println("exception is: $e")

}

}

运行结果:

exception is: java.lang.IllegalStateException: error

原因也很简单,因为它是一个串行的挂起函数,外部协程会被挂起,直到它执行完毕。如果它的内部出现了异常,外部协程是能够知晓的。

coroutineScope可以将并发的崩溃变为可被捕获、处理的异常,常用于处理并发错误。

withContext 串行的上下文切换器

我们再来看 withContext,其实它和 coroutineScope 几乎一样。

它也是一个串行的挂起函数,也会返回代码块的结果,内部也是启动了一个新的协程。

它和 coroutineScope 的唯一的不同是,withContext 允许我们传递上下文。你也可以这么想,coroutineScope 就是一个不改变任何上下文的 withContext:

withContext(EmptyCoroutineContext) { // 沿用旧的 CoroutineContext

}

withContext(coroutineContext) { // 使用旧的 CoroutineContext

}

而 withContext 的使用场景就很清楚了,我们需要切换上下文的时候会使用它,并且希望代码是串行执行的,之后还能再切回原来的线程继续往下执行。

虽然

withContext与coroutineScope类似,但coroutineScope更多用于封装业务异常。

suspend fun getUserProfile() {

// 当前在 Dispatchers.Main

val profile = withContext(Dispatchers.IO) {

// 自动切换到 IO 线程

Thread.sleep(3000) // 耗时操作

"the user profile"

}

// 自动切回 Dispatchers.Main

println("the user profile is $profile")

}

CoroutineContext 的加、取操作

加法:合并与替换

两个 CoroutineContext 相加调用的是 plus()。

public operator fun plus(context: CoroutineContext): CoroutineContext =

if (context === EmptyCoroutineContext) this else // fast path -- avoid lambda creation

context.fold(this) { acc, element ->

val removed = acc.minusKey(element.key)

if (removed === EmptyCoroutineContext) element else {

// make sure interceptor is always last in the context (and thus is fast to get when present)

val interceptor = removed[ContinuationInterceptor]

if (interceptor == null) CombinedContext(removed, element) else {

val left = removed.minusKey(ContinuationInterceptor)

if (left === EmptyCoroutineContext) CombinedContext(element, interceptor) else

CombinedContext(CombinedContext(left, element), interceptor)

}

}

}

其中关键在于 CombinedContext,它是 CoroutineContext 的实现类:

// CoroutineContextImpl.kt

@SinceKotlin("1.3")

internal class CombinedContext(

private val left: CoroutineContext,

private val element: Element // Element 也是 `CoroutineContext` 的实现类

) : CoroutineContext, Serializable

它会将操作符两边的上下文使用 CombinedContext 对象包裹(合并),如果两个上下文具有相同的 Key,加号右侧的会替换左侧的。

比如 Dispatchers.IO + Job() + CoroutineName("my-name") 一共会进行三次合并,得到三个 CombinedContext 对象,不会进行替换。

fun main() = runBlocking<Unit> {

val handler = CoroutineExceptionHandler { _, throwable ->

println("Caught $throwable")

}

val job =

launch(Dispatchers.IO + Job() + CoroutineName("my-name") + handler) {

println(coroutineContext)

}

job.join()

}

运行结果:

[CoroutineName(my-name), com.example.coroutinetest.TestKtKt$main$1$invokeSuspend$$inlined$CoroutineExceptionHandler$1@6667fe3b, StandaloneCoroutine{Active}@26b2b4fd, Dispatchers.IO]

如果在末尾再加上一个 CoroutineName("your_name"),会进行一次替换,运行结果是:[com.example.coroutinetest.TestKtKt$main$1$invokeSuspend$$inlined$CoroutineExceptionHandler$1@6667fe3b, CoroutineName(your_name), StandaloneCoroutine{Active}@26b2b4fd, Dispatchers.IO]

[] 取值

[] 取值其实调用的是 CoroutineContext.get() 函数,它会从上下文(CombinedContext 树)中找到我们需要的信息。

@SinceKotlin("1.3")

public interface CoroutineContext {

/**

* Returns the element with the given [key] from this context or `null`.

*/

public operator fun <E : Element> get(key: Key<E>): E?

// ...

}

我们填入的参数其实是每一个接口的伴生对象 Key,每个伴生对象都实现了 CoroutineContext.Key<T> 接口,并将泛型指定为了当前接口。

以 ContinuationInterceptor 为例:

@SinceKotlin("1.3")

public interface ContinuationInterceptor : CoroutineContext.Element {

/**

* The key that defines *the* context interceptor.

*/

public companion object Key : CoroutineContext.Key<ContinuationInterceptor>

// ...

}

比如我们要获取上下文中的 CoroutineDispatcher,我们可以这样做:

fun main() = runBlocking<Unit> {

val scope = CoroutineScope(Dispatchers.Default)

val job = scope.launch {

val dispatcher = coroutineContext[ContinuationInterceptor] as CoroutineDispatcher // 强转

println("CoroutineDispatcher is $dispatcher")

}

job.join()

}

来源:juejin.cn/post/7564230484126892071

前端部署,又有新花样?

大多数前端开发者在公司里,很少需要直接操心“部署”这件事——那通常是运维或 DevOps 的工作。

但一旦回到个人项目,情况就完全不一样了。写个小博客、搭个文档站,或者搞个 demo 想给朋友看,部署往往成了最大的拦路虎。

常见的选择无非是 Vercel、Netlify 或 GitHub Pages。它们表面上“一键部署”,但细节其实并不轻松:要注册平台账号、要配置域名,还得接受平台的各种限制。国内的一些云服务商(比如阿里云、腾讯云)管控更严格,操作门槛也更高。更让人担心的是,一旦平台宕机,或者因为地区网络问题导致访问不稳定,你的项目可能随时“消失”在用户面前。虽然这种情况不常见,但始终让人心里不踏实。

很多时候,我们只是想快速上线一个小页面,不想被部署流程拖累,有没有更好的方法?

一个更轻的办法

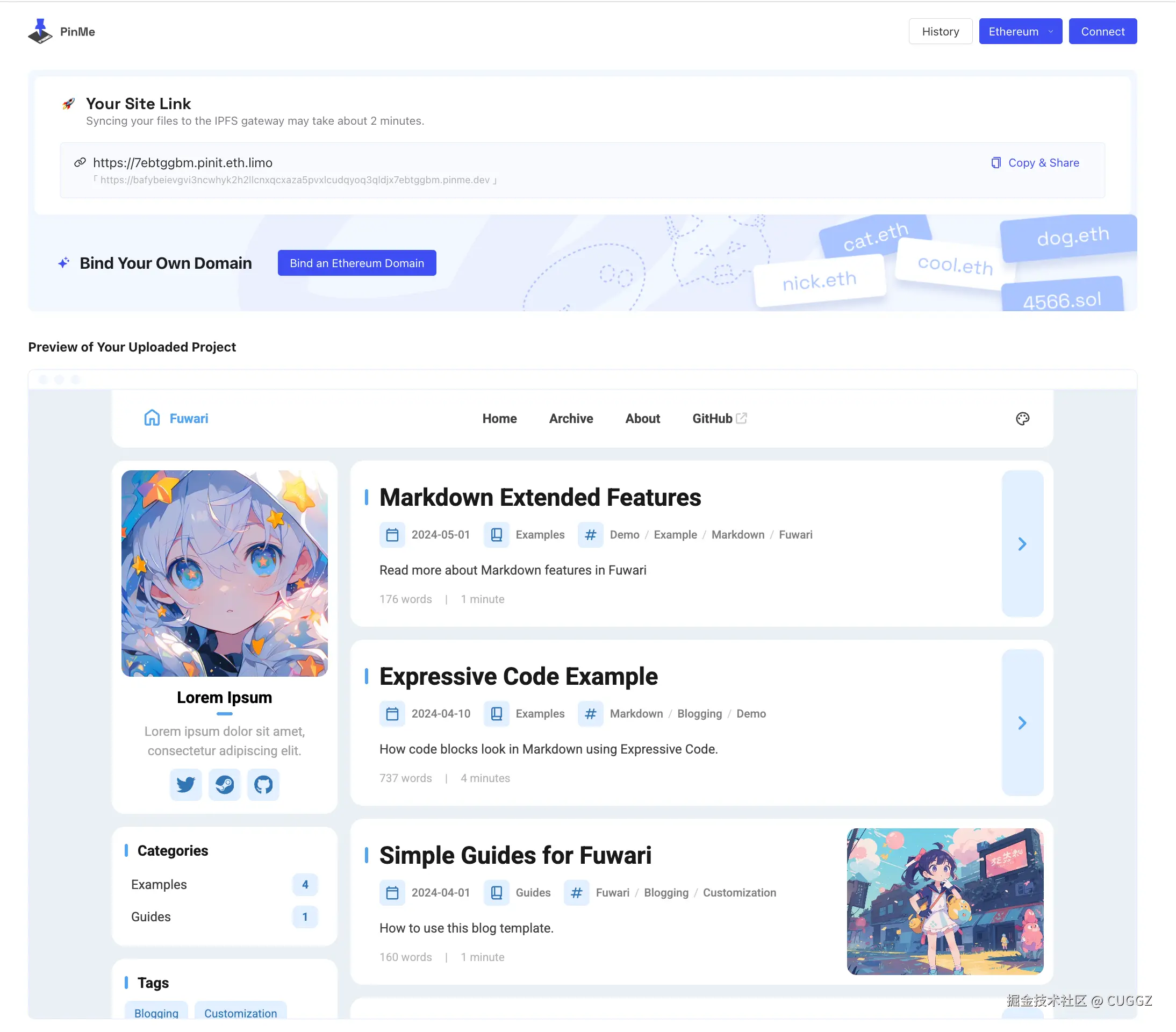

前段时间我发现了一个开源工具 PinMe,主打的就是“极简部署”。

它的使用体验非常直接:

- 不需要服务器

- 不用注册账号

- 在项目目录敲一条命令,就能把项目打包上传到 IPFS 网络

- 很快,你就能拿到一个可访问的地址

实际用起来的感受就是一个字:爽。

整个过程几乎没有繁琐配置,不需要绑定平台账号,也不用担心流量限制或收费。

这让很多场景变得顺手:

- 临时展示一个 demo,不必折腾服务器

- 写了个静态博客,不想搞 CI/CD 流程

- 做了个活动页或 landing page,随时上线就好

以前这些需求可能要纠结“用 GitHub Pages 还是 Vercel”,现在有了 PinMe,直接一键上链就行。

体验一把

接下来看看它在真实场景下的表现:部署流程有多简化?访问速度如何?和传统方案相比有没有优势?

测试项目

为了覆盖不同体量的场景,这次我选了俩类项目来测试:

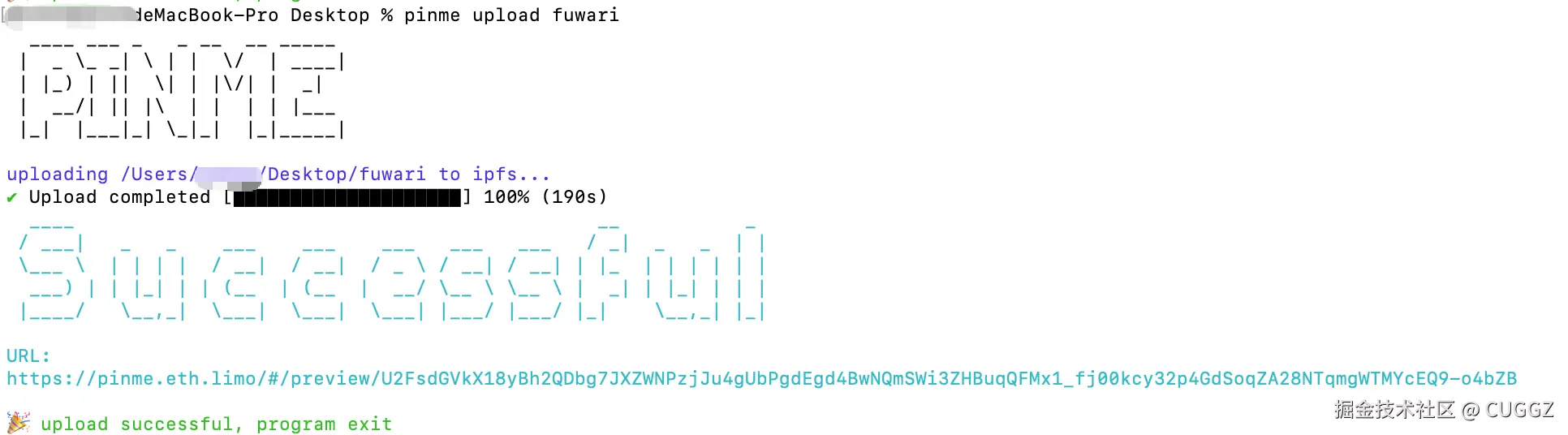

- 小型项目:fuwari(开源的个人博客项目),打包体积约 4 MB。

- 中大型项目:Soybean Admin(开源的后台管理系统),打包体积约 15 MB。

部署项目

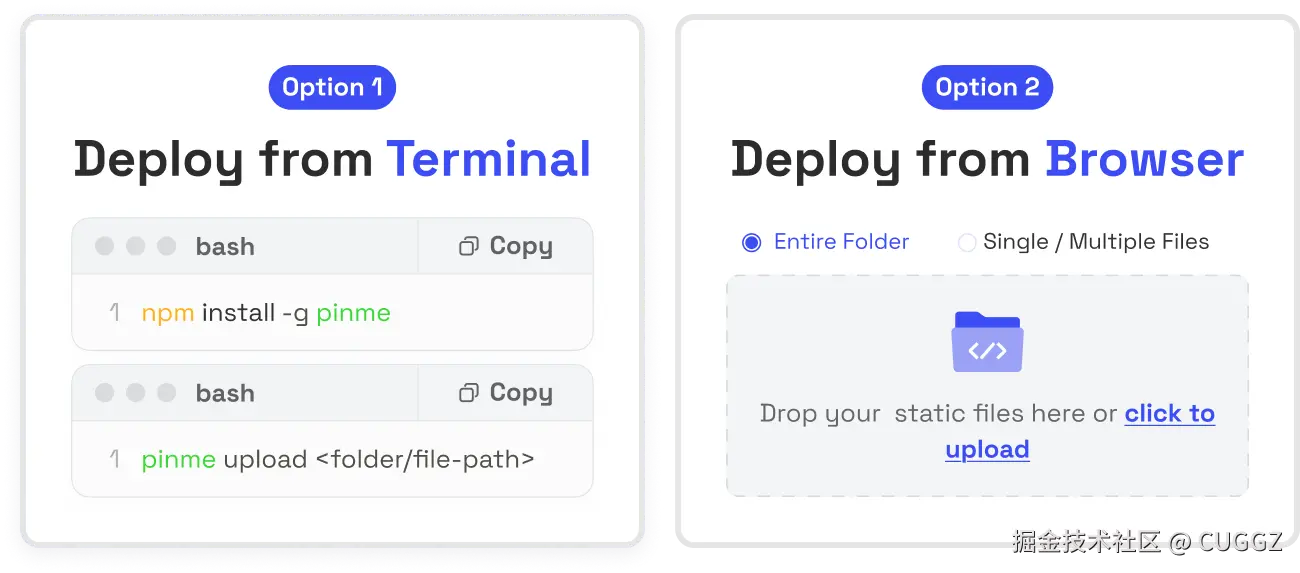

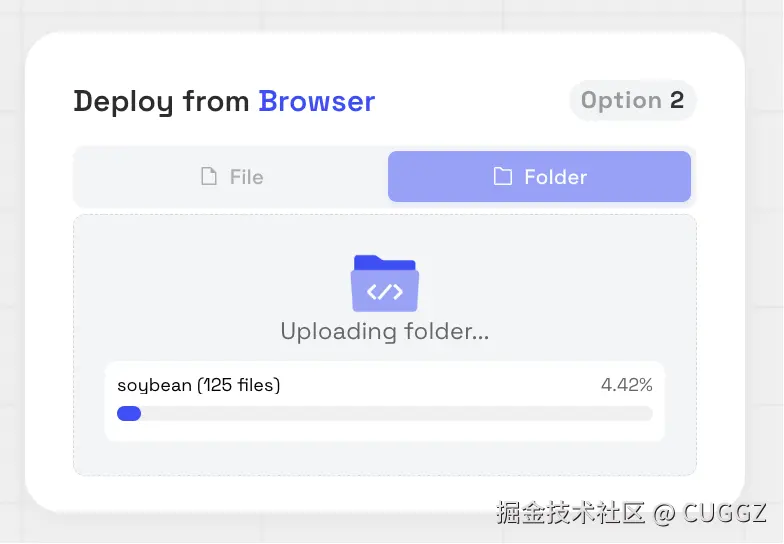

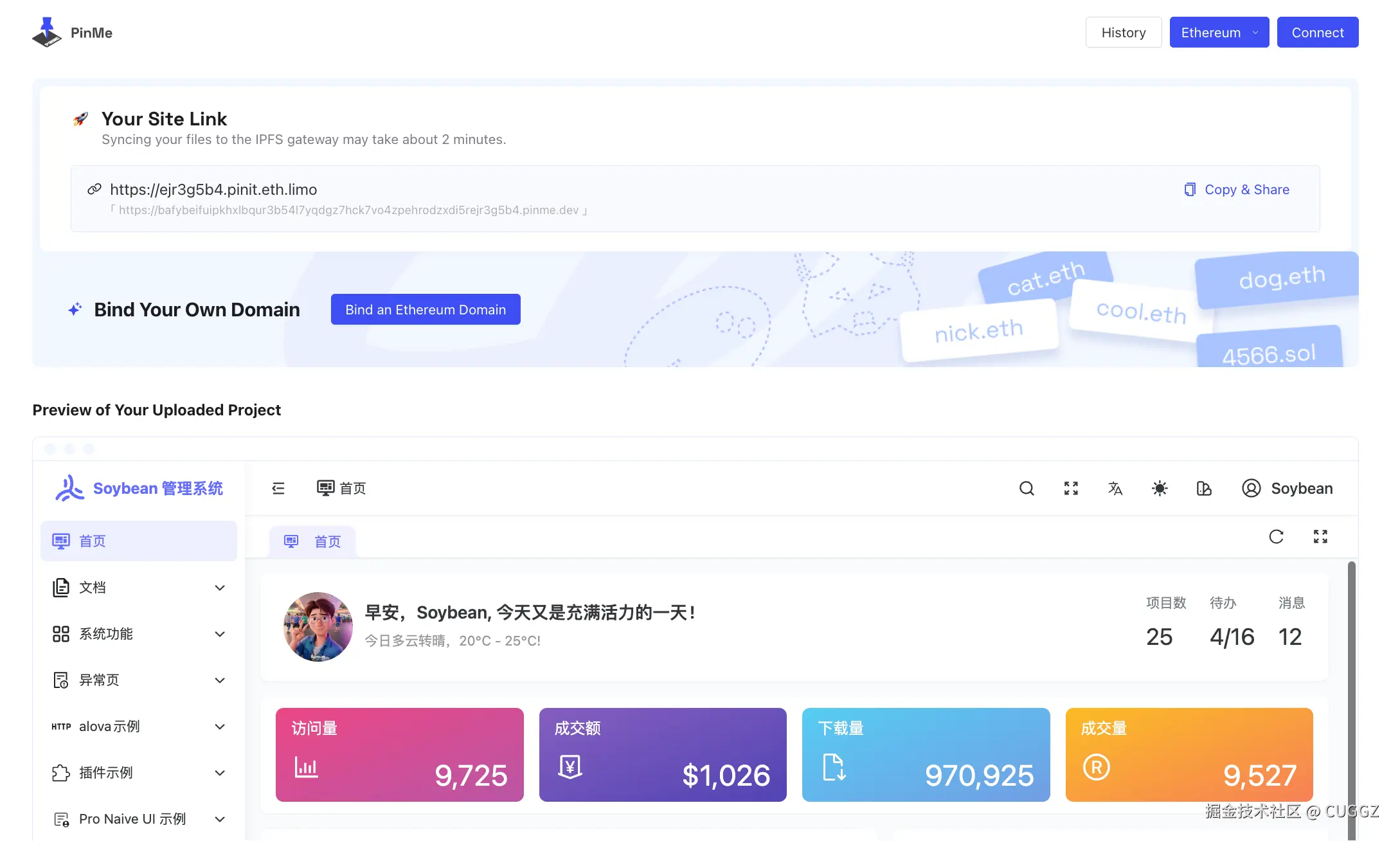

PinMe 提供了两种方式:命令行 和 可视化界面。

这两种方式我们都来试一下。

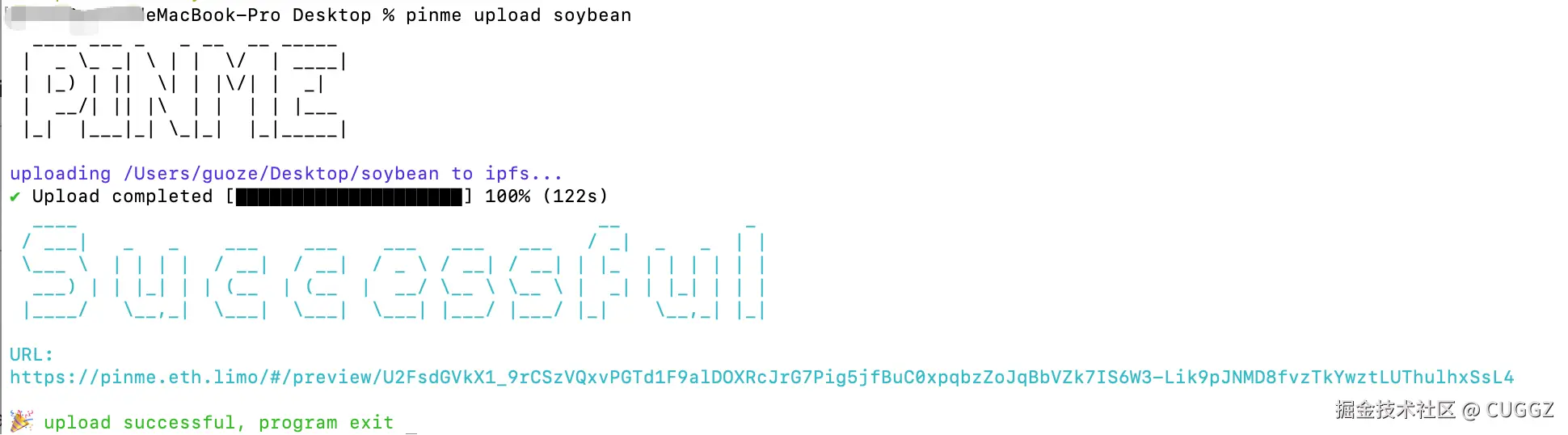

命令行部署

先全局安装:

npm install -g pinme

然后一条命令上传:

pinme upload <folder/file-path>

比如上传 Soybean Admin,文件大小 15MB:

输入命令之后,等着就可以了:

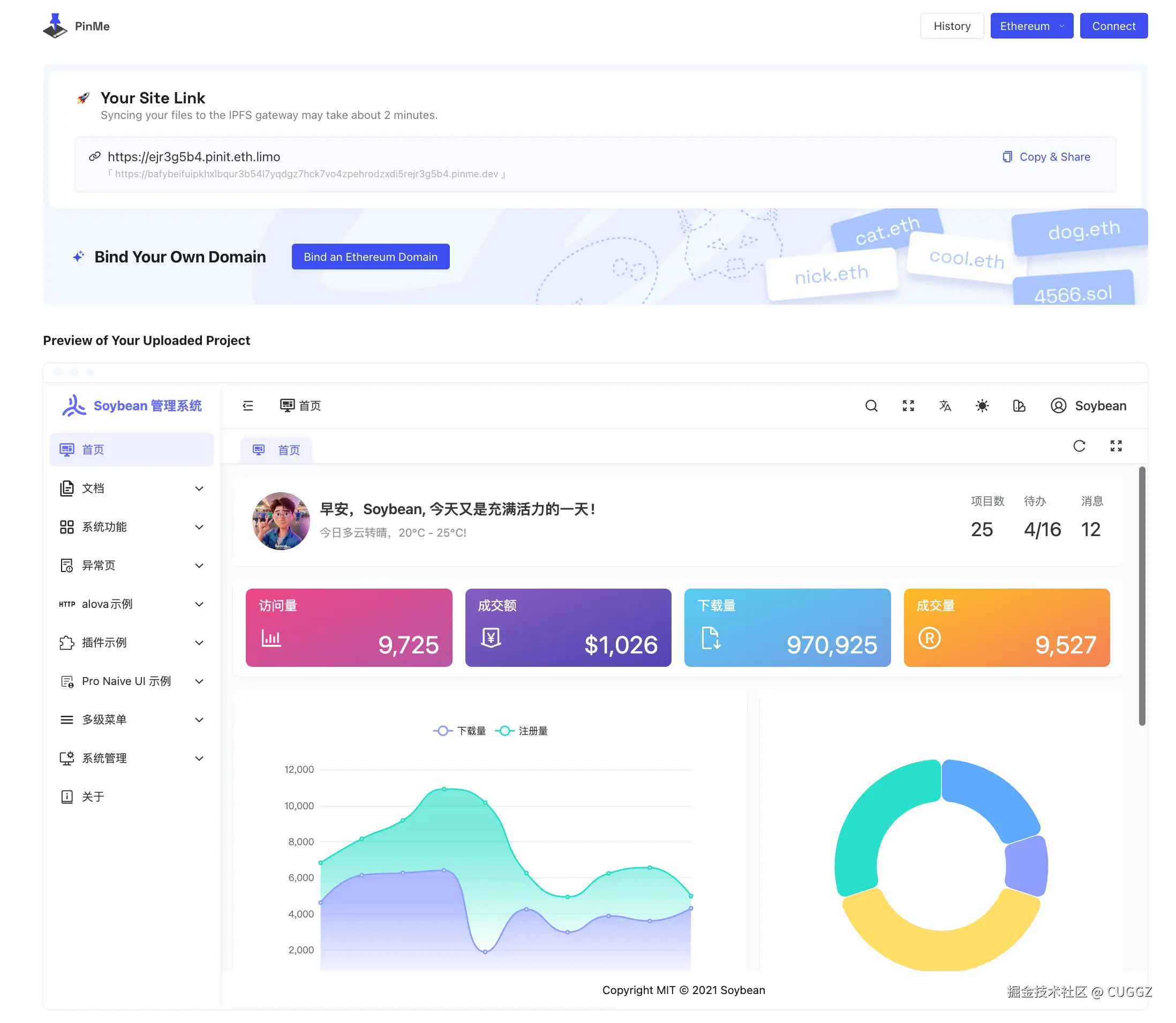

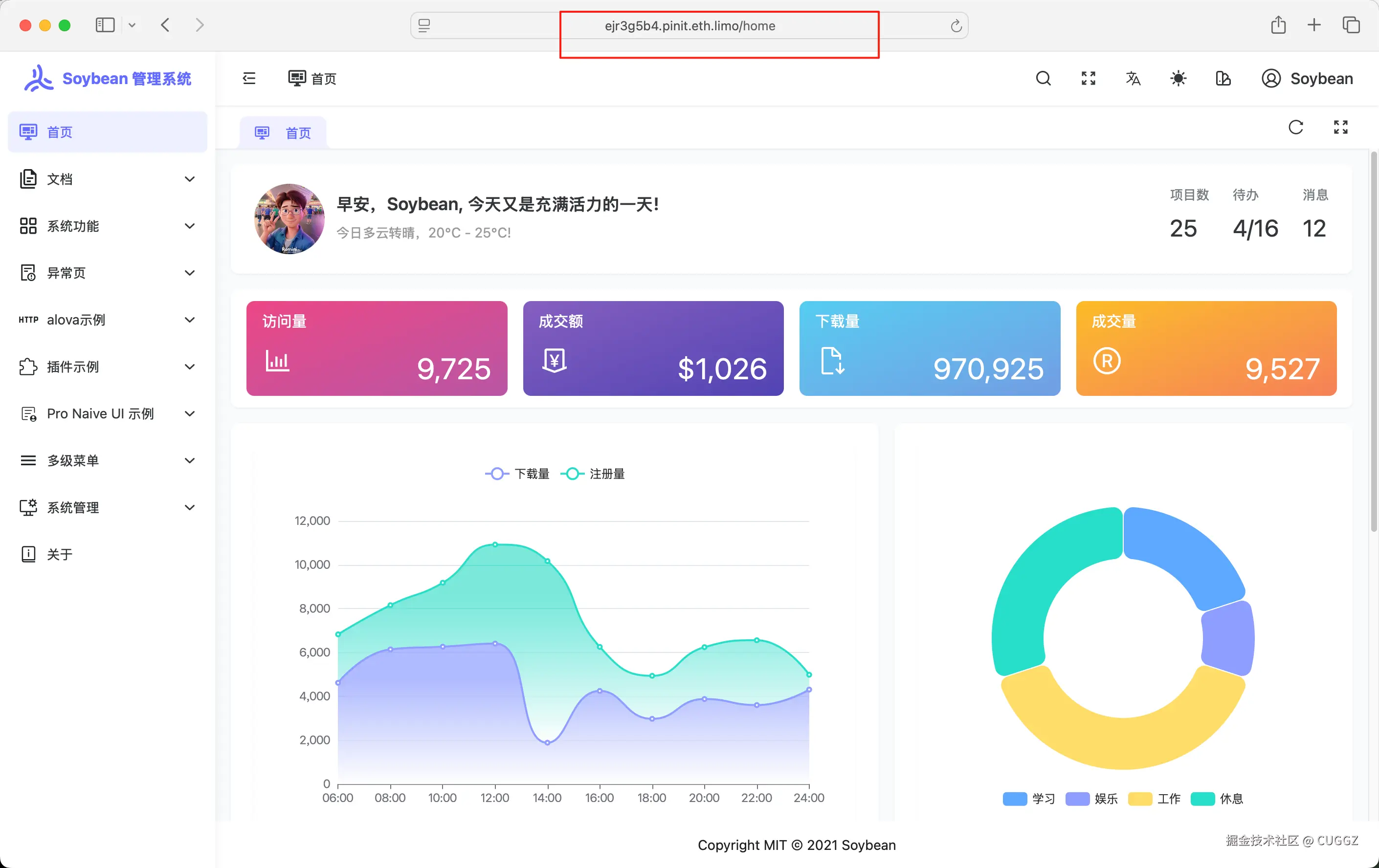

只用了两分钟,终端返回的 URL 就能直接访问项目的控制页面。还能绑定自己的域名:

点击网站链接就可以看到已经部署好的项目,访问速度还是挺快的:

同样地,上传个人博客也是一样的流程。

部署完成:

可视化部署

不习惯命令行?PinMe 也提供了网页上传,进度条实时显示:

部署完成后会自动进入管理页面:

经过测试,部署速度和命令行几乎一致。

其他功能

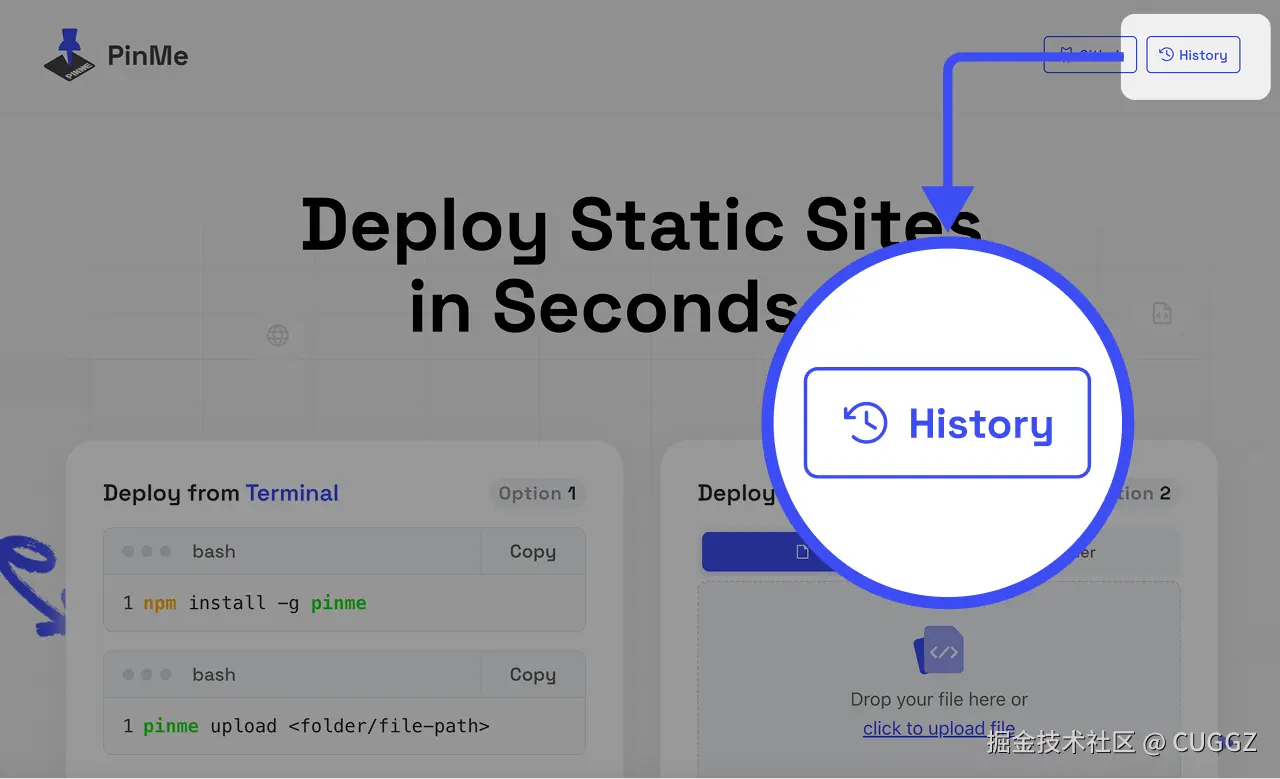

历时记录

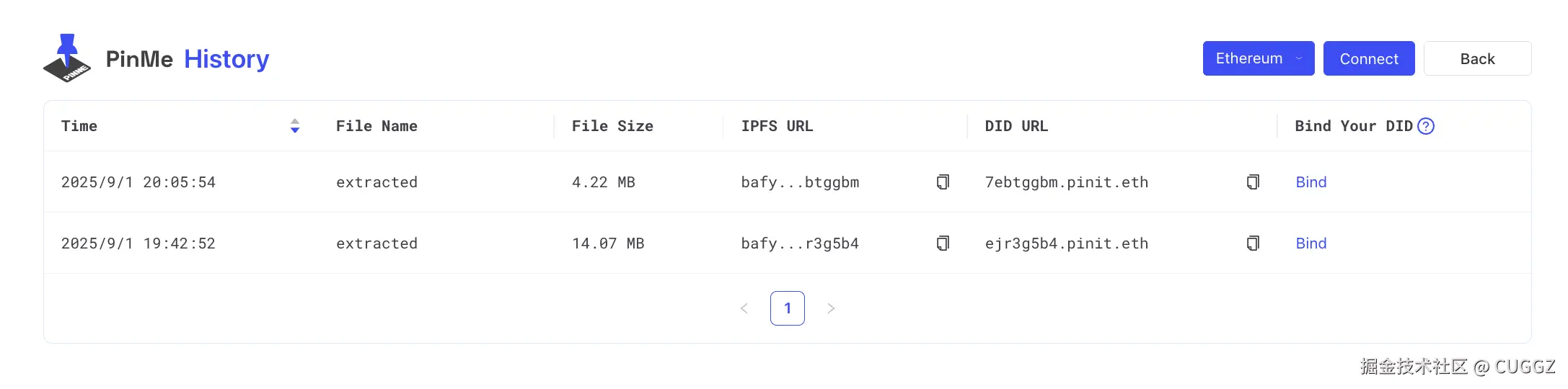

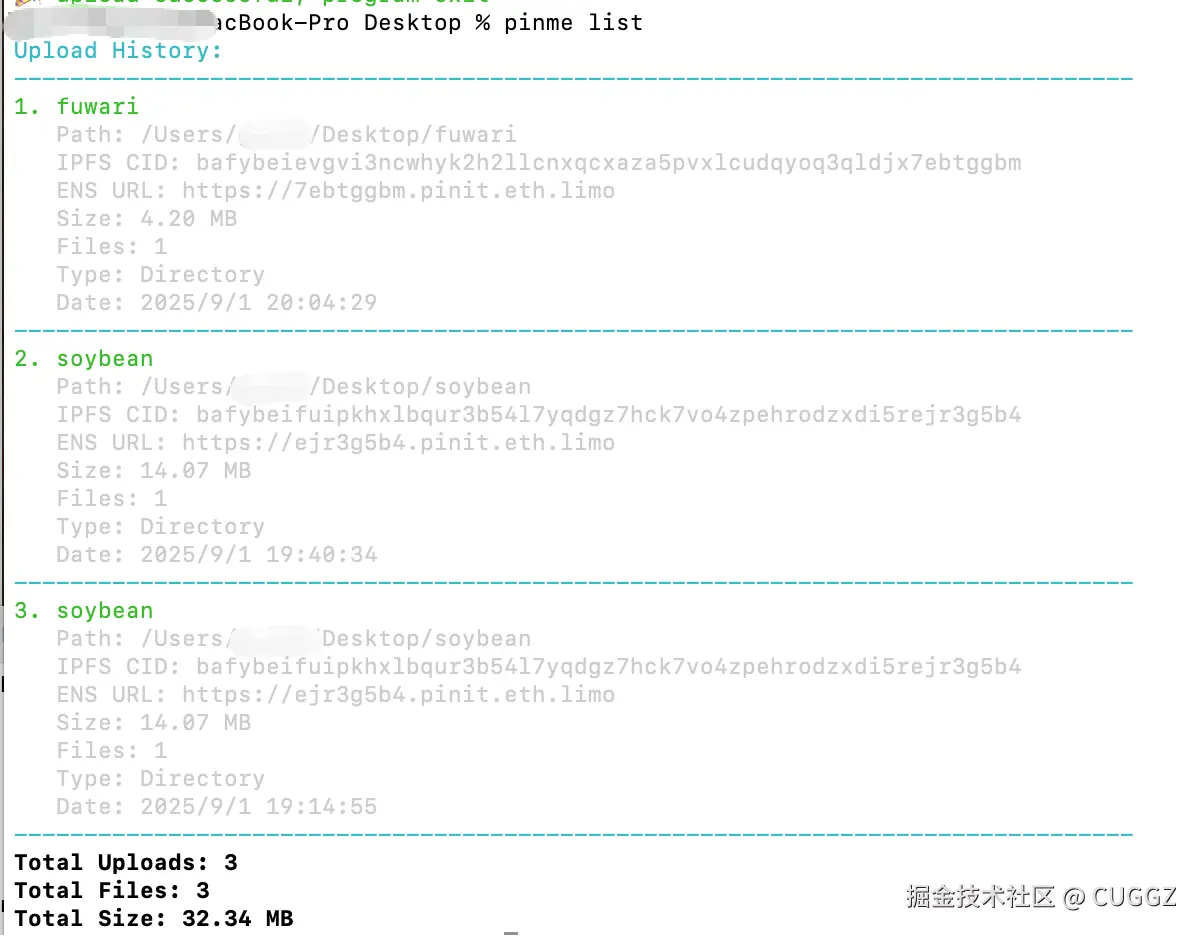

部署过的网站都能在主页的 History 查看:

历史部署记录:

也可以用命令行:

pinme list

历史部署记录:

删除网站

如果不再需要某个项目,执行以下命令即可:

pinme rm

PinMe 背后的“硬核支撑”

如果只看表层,PinMe 就像一个极简的托管工具。但要理解它为什么能做到“不依赖平台”,还得看看它背后的底层逻辑。

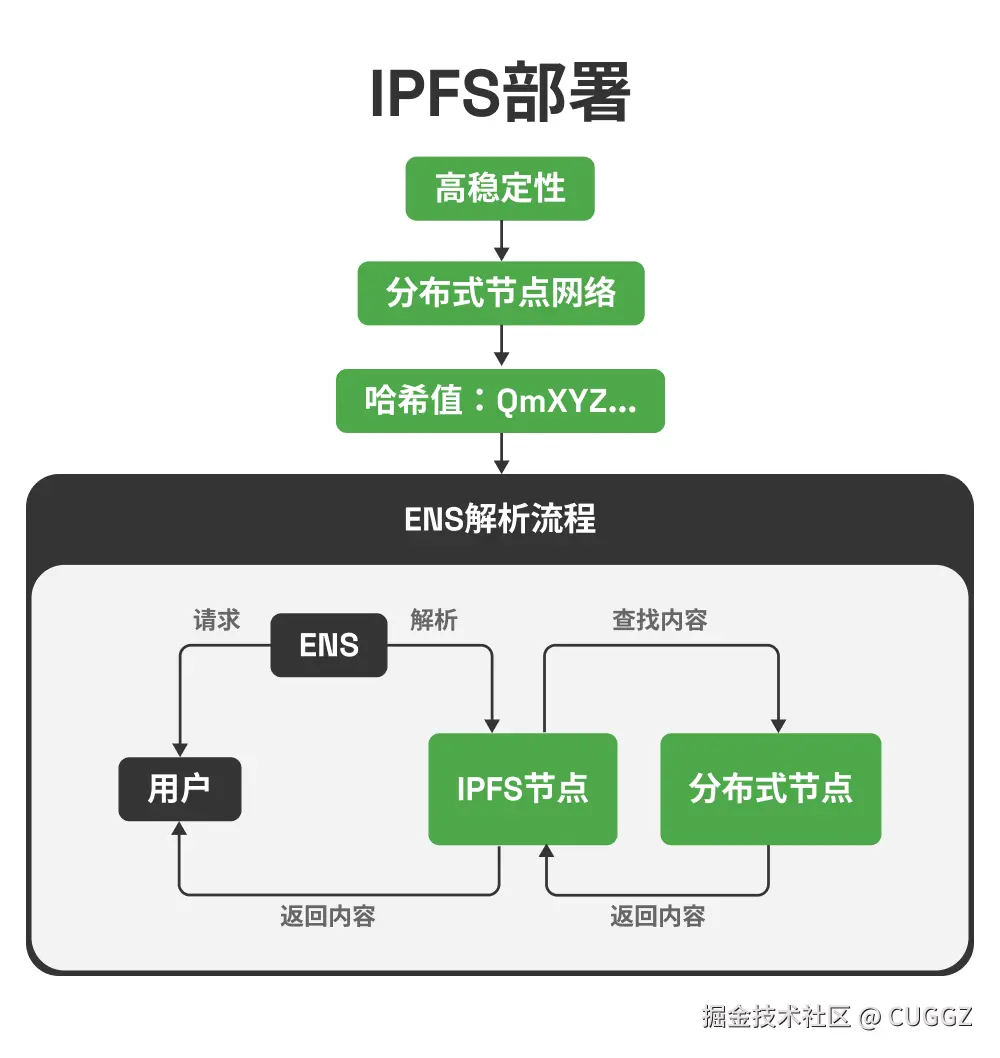

PinMe 的底层依赖 IPFS,这是一个去中心化的分布式文件系统。

要理解它的意义,得先聊聊“去中心化”这个概念。

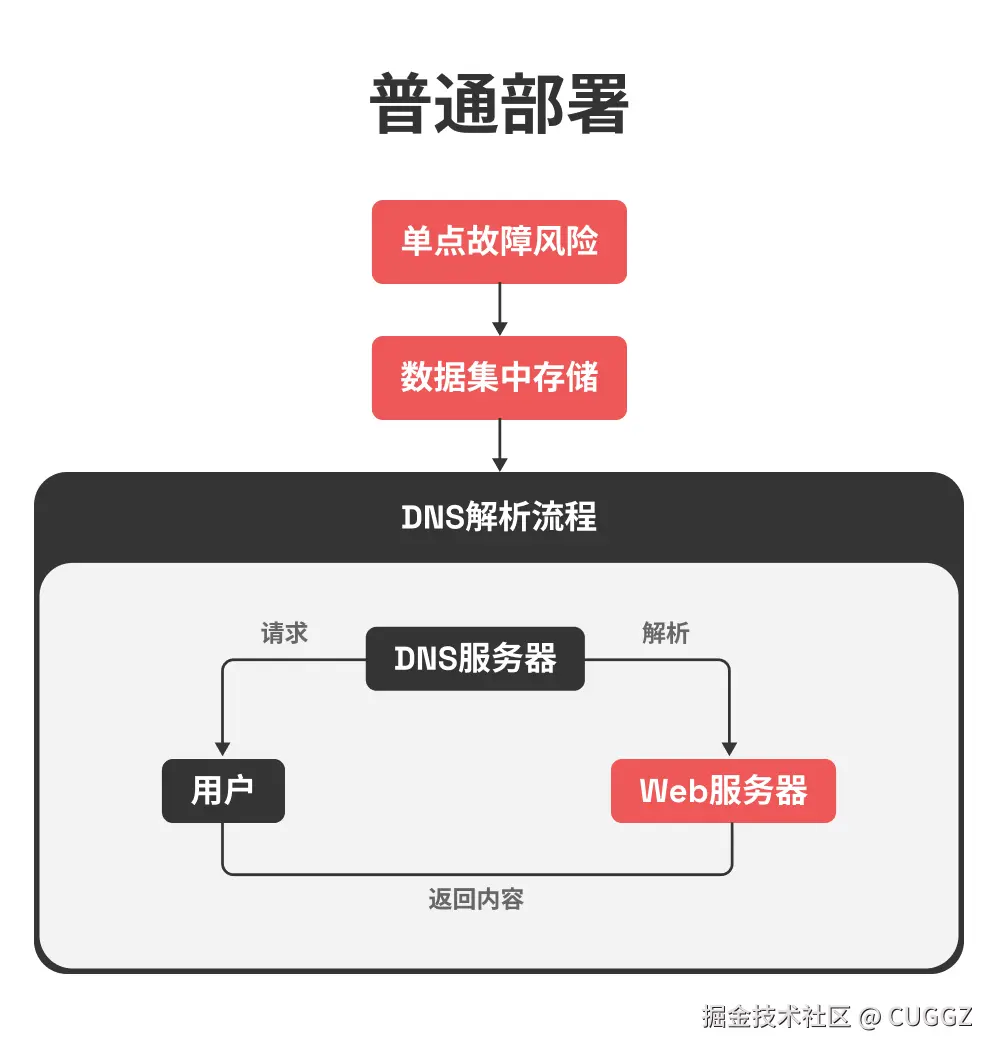

传统互联网是中心化的:你访问一个网站时,浏览器会通过 DNS 找到某台服务器,然后从这台服务器获取内容。这条链路依赖强烈,一旦 DNS 被劫持、服务器宕机、服务商下线,网站就无法访问。

去中心化的思路完全不同:

- 数据不是放在单一服务器,而是分布在全球节点中

- 访问不依赖“位置”,而是通过内容哈希来检索

- 只要有节点存储这份内容,就能访问到,不怕单点故障

这意味着:

- 更稳定:即使部分节点宕机,内容依然能从其他节点获取。

- 防篡改:文件哪怕改动一个字节,对应的 CID 也会完全不同,从机制上保障了前端资源的完整性和安全性。

- 更自由:不再受制于中心化平台,文件真正由用户自己掌控。

当然,IPFS 地址(哈希)太长,不适合直接记忆和分享。这时候就需要 ENS(Ethereum Name Service)。它和 DNS 类似,但记录存储在以太坊区块链上,不可能被篡改。比如你可以把 myblog.eth 指向某个 IPFS 哈希,别人只要输入 ENS 域名就能访问,不依赖传统 DNS,自然也不会被劫持。

换句话说:

ENS + IPFS = 内容去中心化 + 域名去中心化

前端个人项目瞬间就有了更高的自由度和安全性。

一点初步感受

PinMe 并不是要取代 Vercel 这类成熟平台,但它带来了一种新的选择:更简单、更自由、更去中心化。

如果你只是想快速上线一个小项目,或者对去中心化部署感兴趣,PinMe 值得一试。

- 官网:pinme.eth.limo/

- Github:github.com/glitternetw…

这是一个完全开源的项目,开发团队也会持续更新。如果你在测试过程中有想法或需求,不妨去 GitHub 提个 Issue —— 这不仅能帮助项目成长,也能让它更贴近前端开发的实际使用场景!

来源:juejin.cn/post/7547515500453380136

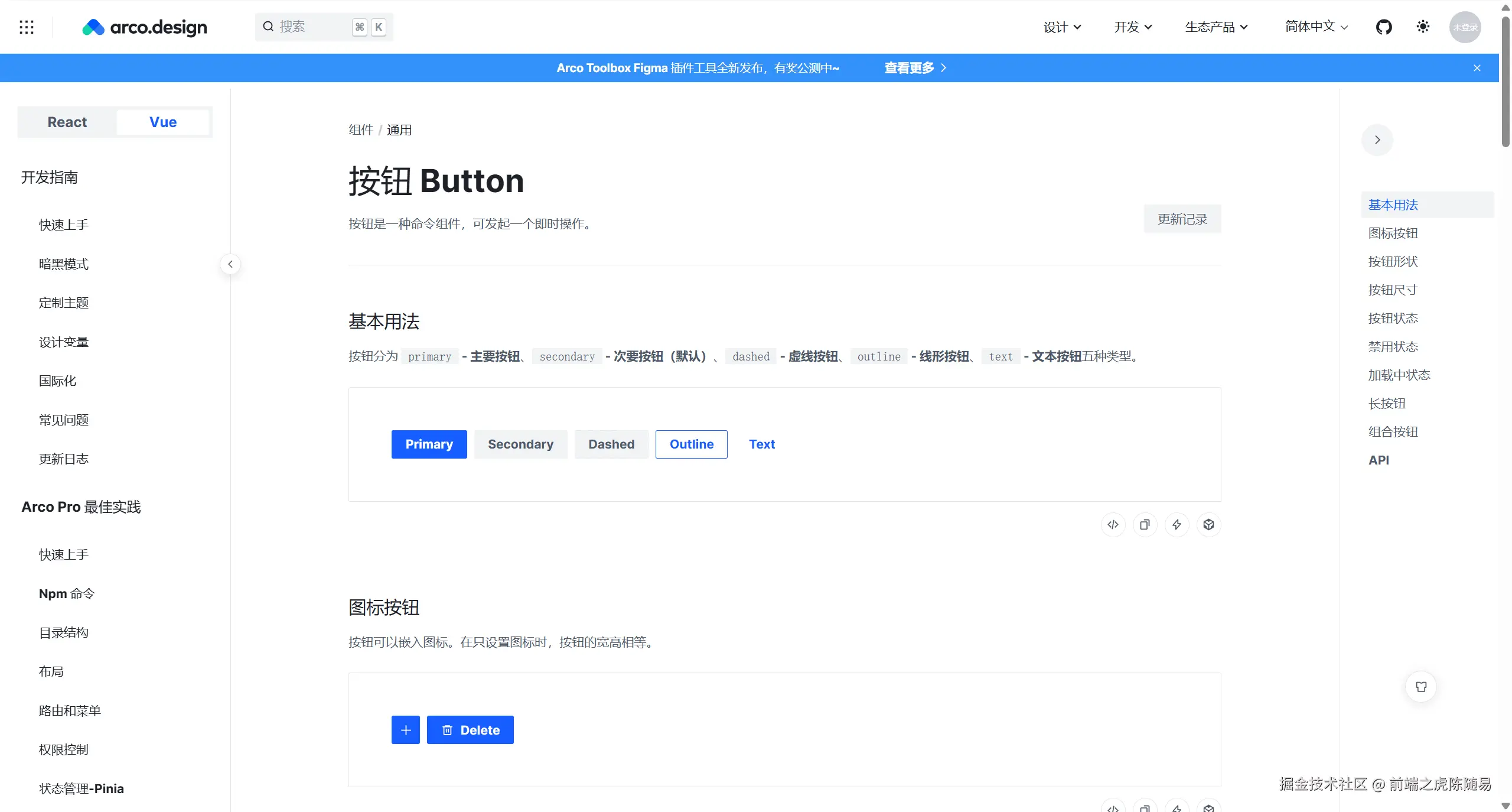

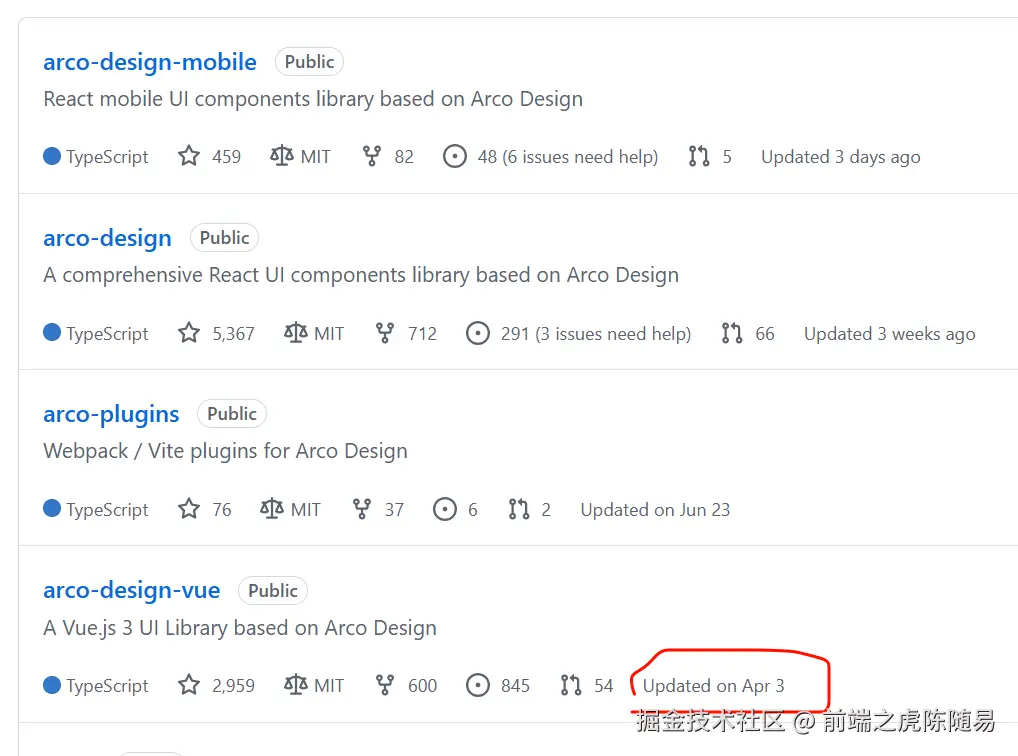

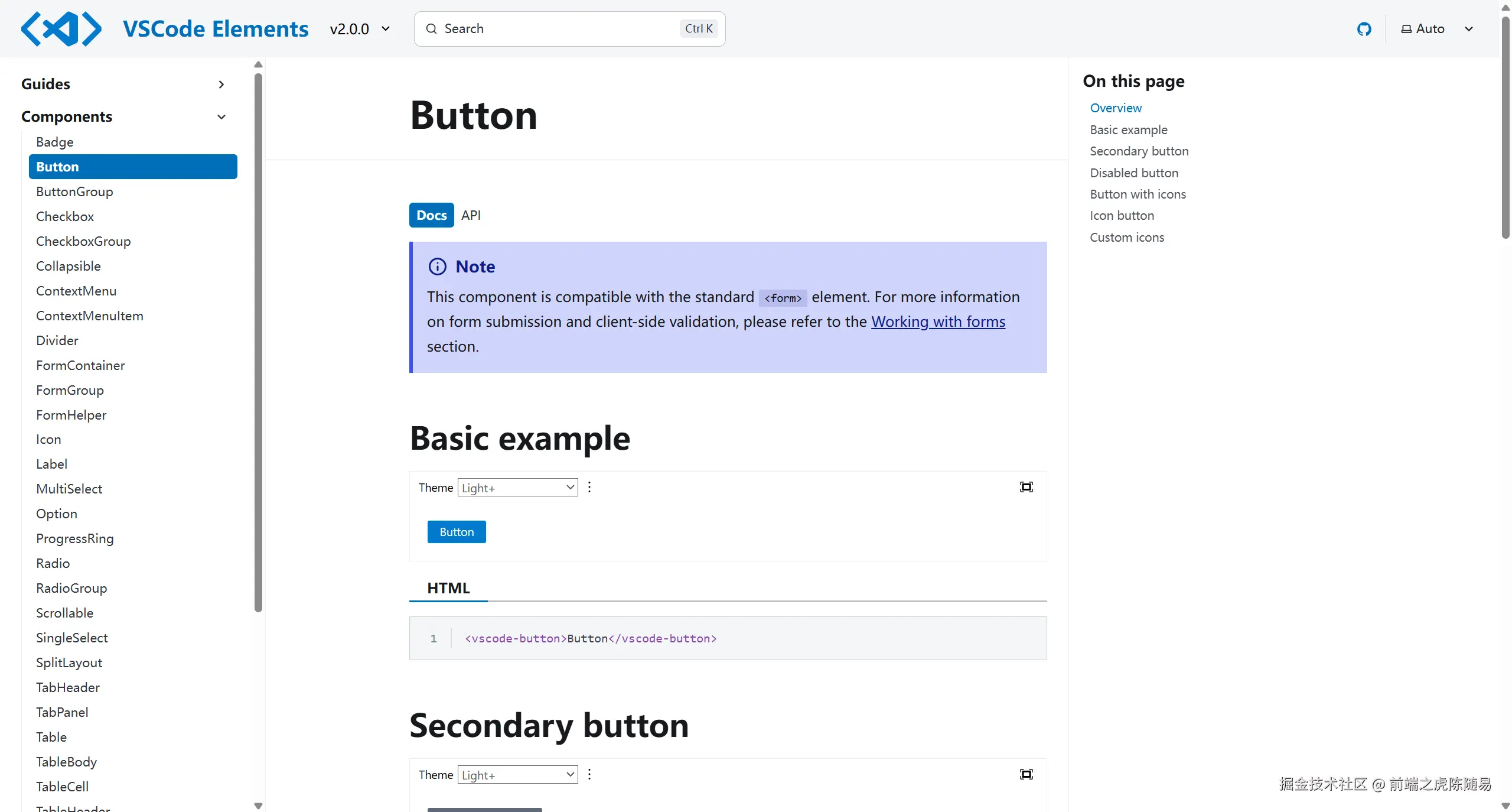

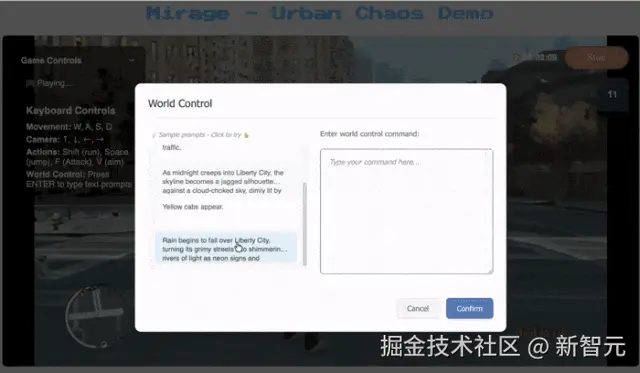

antd 对 ai 下手了!Vue 开发者表示羡慕!

前端开发者应该对 Ant Design 不陌生,特别是 React 开发者,antd 应该是组件库的标配了。

近年来随着 AI 的爆火,凡是想要接入 AI 的都想搞一套自己的 AI 交互界面。专注于 AI 场景组件库的开源项目倒不是很多见,近日 antd 宣布推出 Ant Design X 1.0 🚀 ,这是一个基于 Ant Design 的全新 AGI 组件库,使用 React 构建 AI 驱动的用户交互变得更简单了,它可以无缝集成 AI 聊天组件和 API 服务,简化 AI 界面的开发流程。

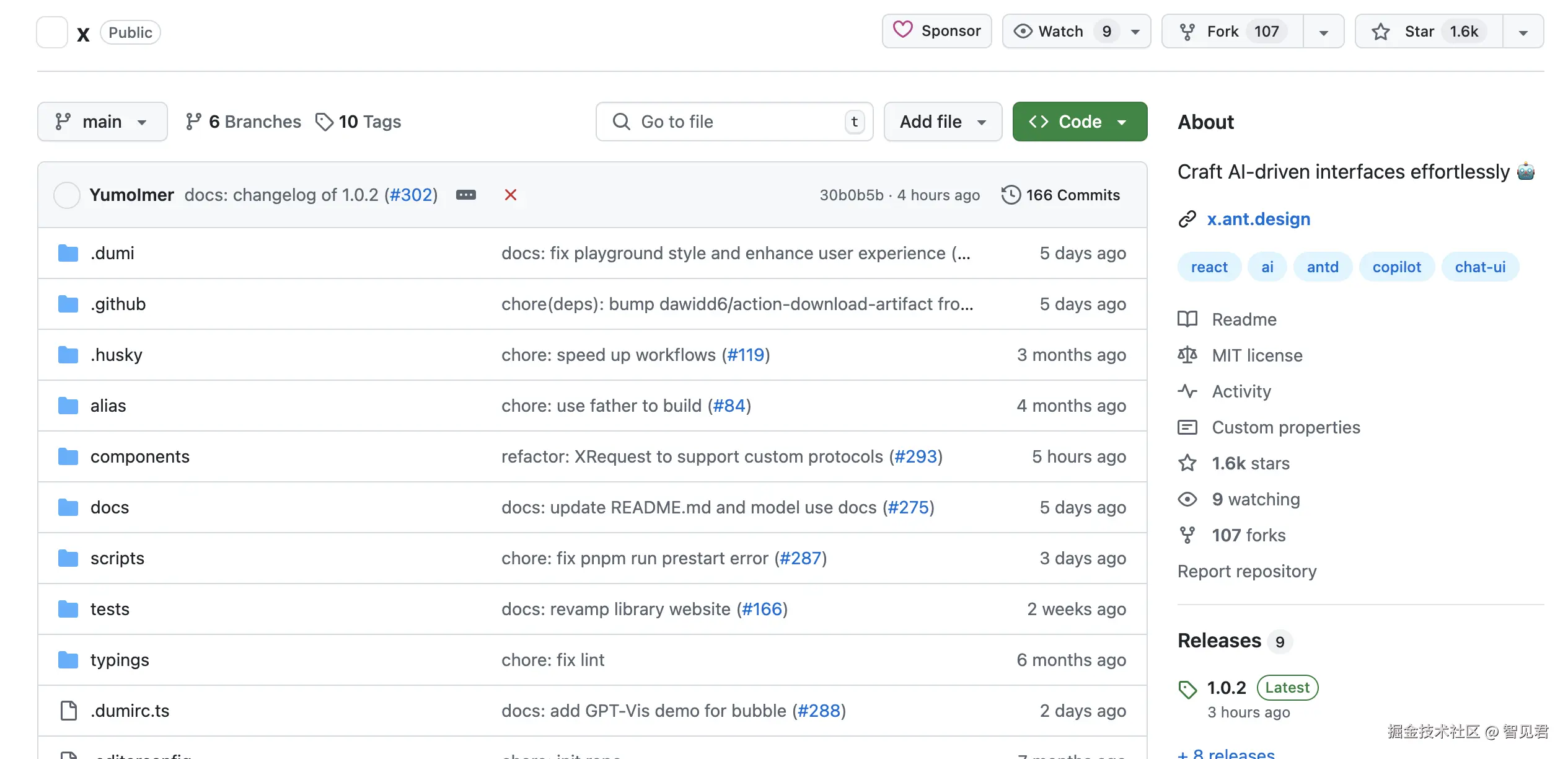

该项目已在 Github 开源,拥有 1.6K Star!

看了网友的评论,看来大家还是需要的!当前的 Ant Design X 只支持 React 项目,看来 Vue 开发者要羡慕了...

ant-design-x 特性

- 🌈 源自企业级 AI 产品的最佳实践:基于 RICH 交互范式,提供卓越的 AI 交互体验

- 🧩 灵活多样的原子组件:覆盖绝大部分 AI 对话场景,助力快速构建个性化 AI 交互页面

- ⚡ 开箱即用的模型对接能力:轻松对接符合 OpenAI 标准的模型推理服务

- 🔄 高效管理对话数据流:提供好用的数据流管理功能,让开发更高效

- 📦 丰富的样板间支持:提供多种模板,快速启动 LUI 应用开发

- 🛡 TypeScript 全覆盖:采用 TypeScript 开发,提供完整类型支持,提升开发体验与可靠性

- 🎨 深度主题定制能力:支持细粒度的样式调整,满足各种场景的个性化需求

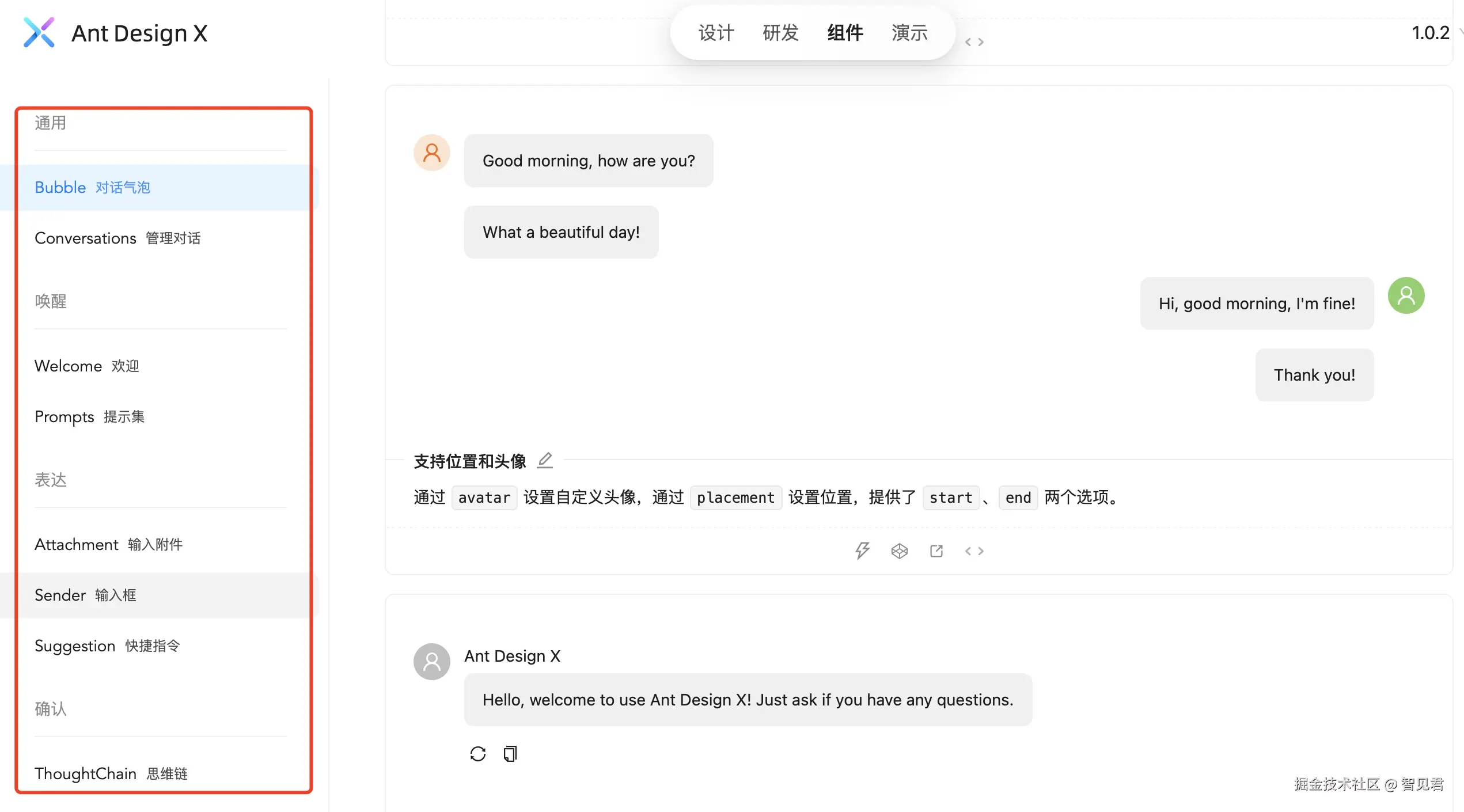

支持组件

以下圈中的部分为 ant-design-x 支持的组件。可以看到主要都是基于 AI Chat 场景的组件设计。现在你可以基于这些组件自由组装搭建一个自己的 AI 界面。

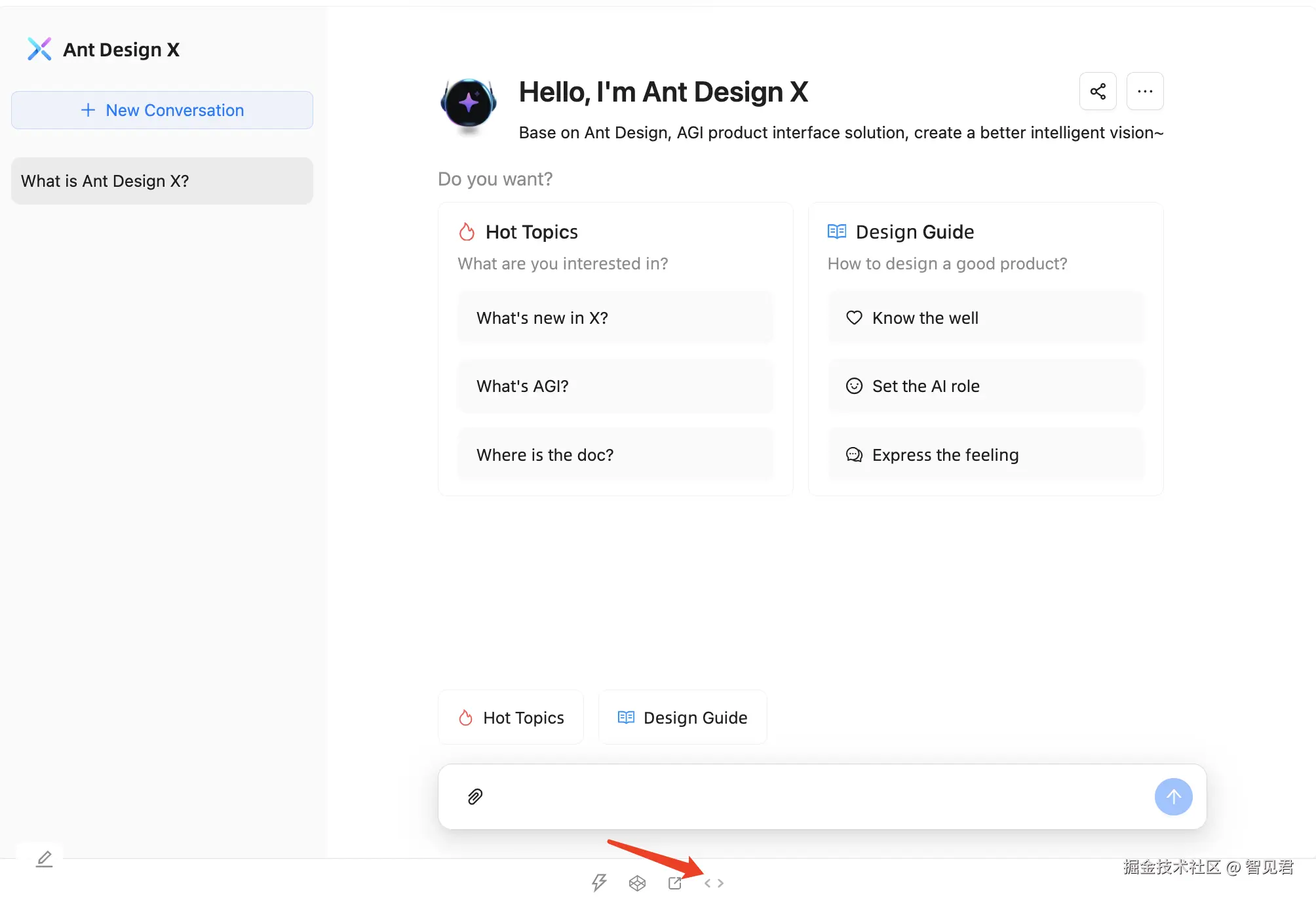

ant-design-x 也提供了一个完整 AI Chat 的 Demo 演示,可以查看 Demo 的代码并直接使用。

更多组件详细内容可参考 组件文档

使用

以下命令安装 @ant-design/x 依赖。

注意,ant-design-x 是基于 Ant Design,因此还需要安装依赖 antd。

yarn add antd @ant-design/x

import React from 'react';

import {

// 消息气泡

Bubble,

// 发送框

Sender,

} from '@ant-design/x';

const messages = [

{

content: 'Hello, Ant Design X!',

role: 'user',

},

];

const App = () => (

<div>

<Bubble.List items={messages} />

<Sender />

</div>

);

export default App;

Ant Design X 前生 ProChat

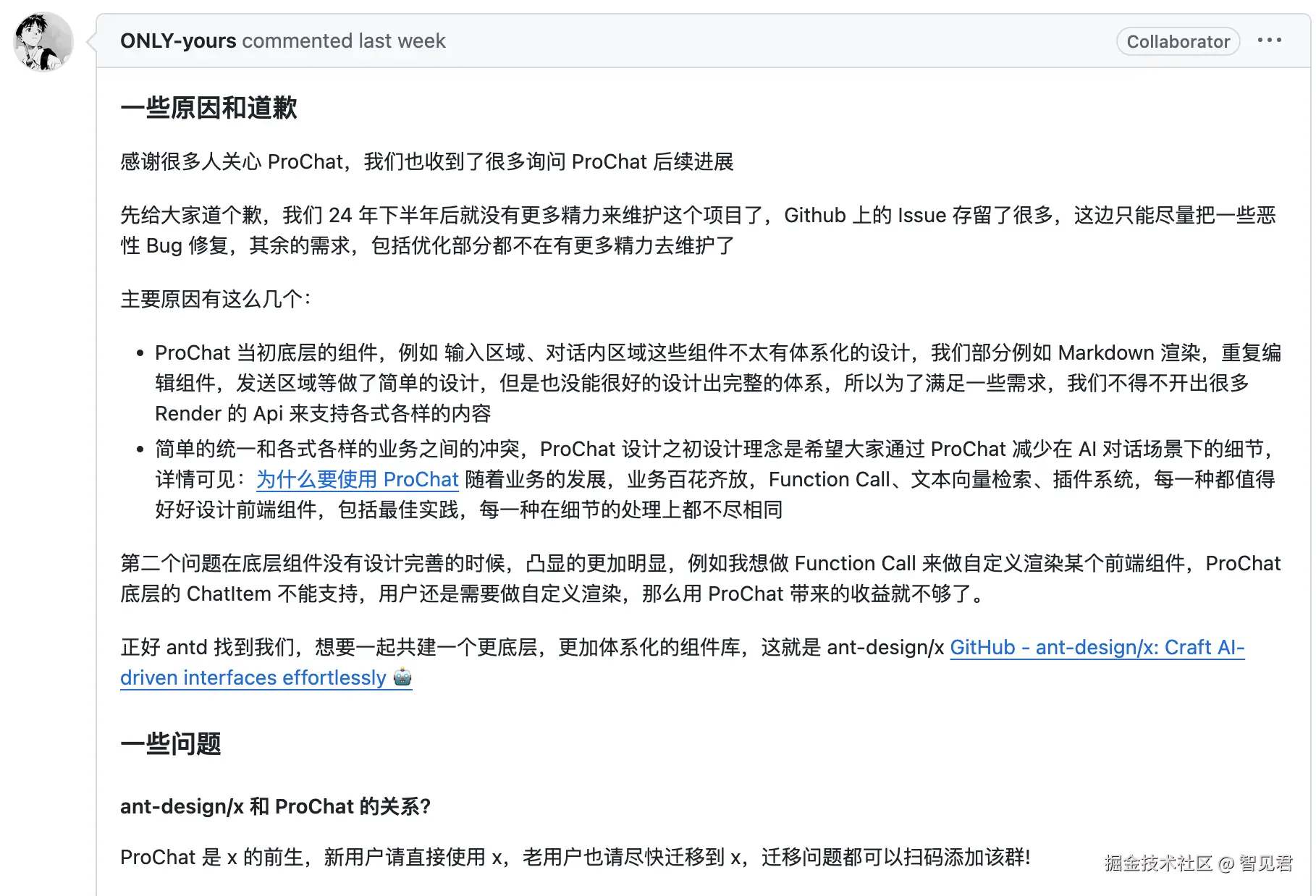

不知道有没有小伙伴们使用过 ProChat,这个库后面的维护可能会有些不确定性,其维护者表示 “24 年下半年后就没有更多精力来维护这个项目了,Github 上的 Issue 存留了很多,这边只能尽量把一些恶性 Bug 修复”

如上所示,也回答了其和 Ant Design X 的关系:ProChat 是 x 的前生,新用户请直接使用 x,老用户也请尽快迁移到 x。

感兴趣的朋友们可以去试试哦!

来源:juejin.cn/post/7444878635717443595

Swift 反初始化器详解——在实例永远“消失”之前,把该做的事做完

为什么要“反初始化”

- ARC 已经帮我们释放了内存,但“内存”≠“资源”。

可能你打开过文件、有过数据库连接、订阅过通知、甚至握着 GPU 纹理句柄。

- 反初始化器(deinit)是 Swift 给你“最后一声道别”的钩子:

实例即将被销毁 → 系统自动调用 → 你可以把文件关掉、把硬币还回银行、把日志写盘……

- 只有 class 有 deinit,struct / enum 没有;一个类最多一个 deinit;不允许手动显式调用。

deinit 的 6 条铁律

- 无参无括号:

class MyCls {

deinit { // 不能写 deinit() { ... }

// 清理代码

}

}

- 自动调用,调用顺序:子类 deinit 执行完 → 父类 deinit 自动执行。

- 实例“还没死”:deinit 里可访问任意 self 属性,甚至可调用实例方法。

- 不能自己调、不能重载、不能抛异常、不能带 async。

- 如果实例从未被真正强引用(例如刚 init 就赋 nil),deinit 不会触发。

- 若存在循环引用(strong reference cycle),deinit 永远不会触发——必须先解环。

示例

import Foundation

// MARK: - 银行:管理游戏世界唯一货币

@MainActor

class Bank {

// 静态共享实例 + 私有初始化,保证“全世界只有一家银行”

static let shared = Bank()

private init() {}

// 剩余硬币,private(set) 让外部只读

private(set) var coinsInBank = 10_000

/// 发放硬币;返回实际发出的数量(可能不够)

func distribute(coins number: Int) -> Int {

let numberToVend = min(number, coinsInBank)

coinsInBank -= numberToVend

print("银行发放 \(numberToVend) 枚,剩余 \(coinsInBank)")

return numberToVend

}

/// 回收硬币

func receive(coins number: Int) {

coinsInBank += number

print("银行回收 \(number) 枚,当前 \(coinsInBank)")

}

}

// MARK: - 玩家:从银行拿硬币,离开时自动归还

@MainActor

class Player {

var coinsInPurse: Int

/// 指定构造器:向银行申请“启动资金”

init(coins: Int) {

let received = Bank.shared.distribute(coins: coins)

coinsInPurse = received

print("玩家初始化,钱包得到 \(received)")

}

/// 赢钱:从银行再拿一笔

func win(coins: Int) {

let won = Bank.shared.distribute(coins: coins)

coinsInPurse += won

print("玩家赢得 \(won),钱包现在 \(coinsInPurse)")

}

/// 反初始化器:人走茶不凉,硬币先还银行

@MainActor

deinit {

print("玩家 deinit 开始,归还 \(coinsInPurse)")

Bank.shared.receive(coins: coinsInPurse)

print("玩家 deinit 结束")

}

}

// MARK: - 游戏主流程

@MainActor

func gameDemo() {

print("=== 游戏开始 ===")

// 1. 创建玩家;注意用可选类型,因为玩家随时可能 leave

var playerOne: Player? = Player(coins: 100)

// 如果不加调试打印,可简写:playerOne?.win(coins: 2000)

if let p = playerOne {

print("玩家当前硬币:\(p.coinsInPurse)")

p.win(coins: 2_000)

}

// 2. 玩家离开游戏;引用置 nil → 强引用归零 → deinit 被调用

print("玩家离开,引用置 nil")

playerOne = nil

print("=== 游戏结束 ===")

}

gameDemo()

运行结果

=== 游戏开始 ===

银行发放 100 枚,剩余 9900

玩家初始化,钱包得到 100

玩家当前硬币:100

银行发放 2000 枚,剩余 7900

玩家赢得 2000,钱包现在 2100

玩家离开,引用置 nil

玩家 deinit 开始,归还 2100

银行回收 2100 枚,当前 10000

玩家 deinit 结束

=== 游戏结束 ===

3 个高频扩展场景

- 关闭文件句柄

class Logger {

private let handle: FileHandle

init(path: String) throws {

handle = try FileHandle(forWritingTo: URL(fileURLWithPath: path))

}

deinit {

handle.closeFile() // 文件一定会被关掉

}

}

- 注销通知中心观察者

class KeyboardManager {

private var tokens: [NSObjectProtocol] = []

init() {

tokens.append(

NotificationCenter.default.addObserver(forName: UIResponder.keyboardWillShowNotification, object: nil, queue: .main) { _ in }

)

}

deinit {

tokens.forEach(NotificationCenter.default.removeObserver)

}

}

- 释放手动分配的 C 内存 / GPU 纹理

class Texture {

private var raw: UnsafeMutableRawPointer?

init(size: Int) {

raw = malloc(size)

}

deinit {

free(raw) // 防止内存泄漏

}

}

常见踩坑与排查清单

| 现象 | 可能原因 | 排查工具 |

|---|---|---|

| deinit 从不打印 | 出现强引用循环 | Xcode Memory Graph / leaks 命令 |

| 子类 deinit 未调用 | 父类 init 失败提前 return | 在 init 各阶段加打印 |

| 访问属性崩溃 | 在 deinit 里访问了 weak / unowned 已释放属性 | 改用 strong 或提前判空 |

小结:把 deinit 当成“遗嘱执行人”

- 它只负责“身后事”:释放非内存资源、归还全局状态、写日志。

- 它不能保命:如果实例因为循环引用一直活着,就永远走不到 deinit。

- 它不能抢戏:别在 deinit 里做耗时任务(网络、IO),否则可能阻塞主线程或单元测试。

- 用好 weak / unowned + deinit,可以让 Swift 代码在“自动”与“可控”之间取得最佳平衡。

深入底层:deinit 在 SIL & 运行时到底做了什么

swiftc -emit-sil main.swift mainsil

- SIL(Swift Intermediate Language)视角

编译器会为每个类生成一个

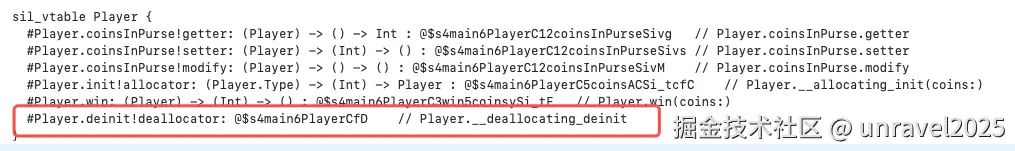

sil_vtable,里面存放了类中的所有方法,可以看到deinit中调用的是Player.__deallocating_deinit

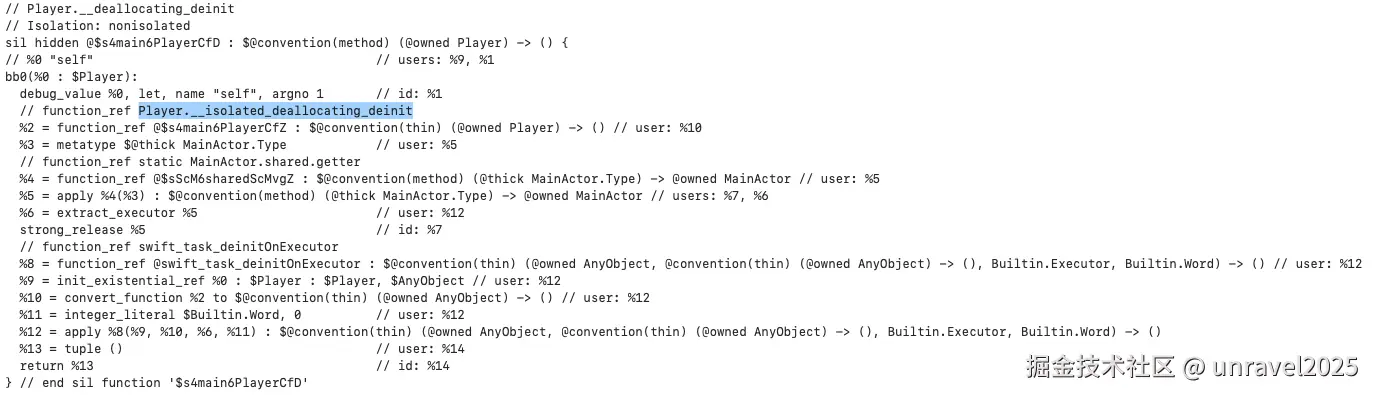

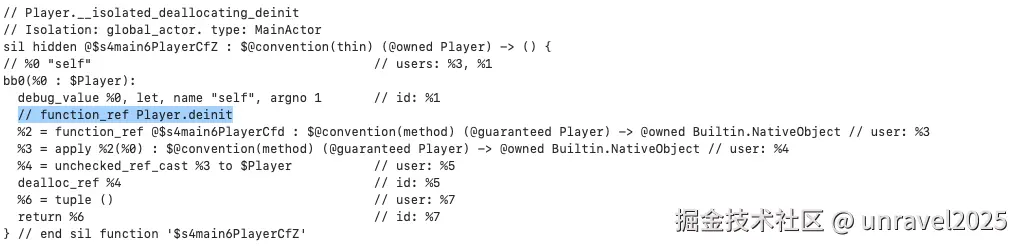

Player.__deallocating_deinit中调用的Player.__isolated_deallocating_deinit

Player.__isolated_deallocating_deinit中调用Player.deinit

伪代码:

sil @destroy_Player : $@convention(method) (@owned Player) -> () {

bb0(%0 : $Player):

// 1. 调用 deinit

%2 = function_ref @$s4main6PlayerCfZ : $@convention(thin) (@owned Player) -> ()

%3 = apply %2(%0) : $@convention(method) (@guaranteed Player) -> @owned Builtin.NativeObject // user: %4

// 2. 销毁存储属性

destroy_addr %0.#coinsInPurse

// 3. 释放整个对象内存

strong_release %5

}

结论:deinit 只是“销毁流水线”里的一环;先跑 deinit,再跑成员销毁,最后归还堆内存。

- 运行时视角

Swift 对象头部有一个 32-byte 的

HeapObject,其中refCounts字段采用“Side Table” 策略。当最后一次

swift_release把引用计数降到 0 时,会立即跳到destroy函数指针 → 也就是上面的 SIL 函数。因此:

- deinit 执行线程 = 最后一次

release发生的线程; - deinit 执行耗时 ≈ 对象大小 + 成员销毁耗时 + 你写的代码耗时;

- 如果 deinit 里再产生强引用(例如把 self 塞进全局数组),对象会被“复活”,但 Swift 5.5 之后禁止这种 resurrection,会直接 trap。

- deinit 执行线程 = 最后一次

多线程与 deinit 的 4 个实战坑

| 场景 | 风险 | 正确姿势 |

|---|---|---|

| 子线程释放主线程创建的实例 | deinit 里刷新 UI | 用 DispatchQueue.main.async 或 MainActor.assertIsolated() |

| deinit 里加锁 | 可能和 init 锁顺序相反 → 死锁 | 尽量无锁;必须加锁时统一层级 |

deinit 里用 unowned 访问外部对象 | 外部对象可能已释放 | 改用 weak 并判空 |

| deinit 里继续派发异步任务 | 任务持有 self → 循环复活 | 使用 Task { [weak self] in ... } |

与 Objective-C 的交叉:dealloc vs deinit

- 继承链

@objc class BaseNS: NSObject {

deinit { print("Swift deinit") } // 实际上会生成 -dealloc 方法

}

编译器把 deinit 映射成 Objective-C 的 -dealloc,并在末尾自动插入 [super dealloc](ARC 下自动插入)。

2. 混编时序

- Swift 侧先跑完 deinit;

- 再跑 Objective-C 侧生成的

-dealloc; - 最后 NSObject 的

-dealloc释放 isa 与 ARC 附带内存。

- 注意点

若你在 Objective-C 侧手动 override

-dealloc,记得不要显式调用[super dealloc](ARC 会自动加),否则编译报错。

Swift 5.9 新动向:move-only struct 的 deinit

SE-0390 已经落地 move-only ~Copyable struct,也可以写 deinit!

struct FileDescriptor: ~Copyable {

private let fd: Int32

init(path: String) throws { fd = open(path, O_RDONLY) }

deinit { // struct 也能有 deinit!

close(fd)

}

}

规则:

- 只要值被消耗(consume)或生命周期结束,deinit 就执行;

- 不能同时实现

deinit和Copyable; - 用于文件句柄、GPU 描述符等“必须唯一所有权”场景,彻底告别

class+deinit的性能损耗。

一张“思维导图”收尾

class 实例

│

├─ refCount == 0 ?

│ ├─ 否:继续浪

│ └─ 是:进入 destroy 流水线

│ 1. 子类 deinit 跑

│ 2. 父类 deinit 跑

│ 3. 销毁所有存储属性

│ 4. 归还堆内存

│

├─ 线程:最后一次 release 线程

├─ 复活:Swift 5.5+ 禁止,直接 trap

彩蛋:把 deinit 做成“叮”一声

#if DEBUG

deinit {

// 只调一次,不会循环引用

DispatchQueue.main.async {

AudioServicesPlaySystemSound(1057) // 键盘“叮”

}

}

#endif

每次对象销毁都会“叮”,办公室同事会投来异样眼光,但你能瞬间听出内存泄漏——当该响的没响,就说明循环引用啦!

来源:juejin.cn/post/7566289235347816486

MyBatis 中 where1=1 一些替换方式

题记

生命中的风景千变万化,但我一直在路上。

风雨兼程,不是为了抵达终点,而是为了沿途的风景。

起因

今天闲来无事,翻翻看看之前的项目。

在看到一个项目的时候,项目框架用的是SpringMvc+Spring+Mybatis。项目里面注释时间写的是2018年,时间长了,里面有好多语法现在看起来好麻烦的样子呀!

说有它就有,这不就有一个吗?在Mybatis配置的xml中,有好多where 1=1 拼接Sql的方式,看的人头都大了。想着改一下吧,又一想,代码已经时间长了,如果出现问题找谁,就先不管了。

话是这样说,但在实际工作中,还是会有方法可以代替的,下面我们一起来看看吧!

替换方式

在 MyBatis 中,WHERE 1=1 通常用来在多条件查询情况下下进行SQL 拼接,其目的就是避免在没有条件时出现语法错误。

但这种写法不够优雅,可通过以下方式进行替代:

1. 使用 <where> 标签(推荐)

MyBatis 的 <where> 标签会自动处理 SQL 的 WHERE 语句,移除多余的 AND 或 OR 关键字。

看实例:

<select id="selectUsers" resultType="User">

SELECT * FROM user

<where>

<if test="username != null and username != ''">

AND username = #{username}

</if>

<if test="age != null">

AND age = #{age}

</if>

</where>

</select>

效果说明:

- 当无参数时,此时执行的Sql语句为:

SELECT * FROM user - 当仅传

username时,此时执行的Sql语句为:SELECT * FROM user WHERE username = ? - 当传

username和age时,此时执行的Sql语句为:SELECT * FROM user WHERE username = ? AND age = ?

2. 使用 <trim> 标签自定义

<trim> 可更灵活地处理 SQL 片段,通过设置 prefix 和 prefixOverrides 属性模拟 <where> 的功能。

看实例:

<select id="selectUsers" resultType="User">

SELECT * FROM user

<trim prefix="WHERE" prefixOverrides="AND |OR ">

<if test="username != null and username != ''">

AND username = #{username}

</if>

<if test="age != null">

AND age = #{age}

</if>

</trim>

</select>

说明:

prefix="WHERE":在条件前添加WHERE关键字。prefixOverrides="AND |OR ":移除条件前多余的AND或OR。

3. 使用 <choose>、<when>、<otherwise>

类似Java在进行判断中常用的 switch-case语句,此方式适用于多条件互斥的场景。

看实例:

<select id="selectUsers" resultType="User">

SELECT * FROM user

<where>

<choose>

<when test="username != null and username != ''">

username = #{username}

</when>

<when test="age != null">

age = #{age}

</when>

<otherwise>

1=1 <!-- 仅在无任何条件时使用 -->

</otherwise>

</choose>

</where>

</select>

4. Java代码判断控制

在 Service 层根据条件动态选择不同的 SQL 语句。

看实例:

public List<User> getUsers(String username, Integer age) {

if (username != null && !username.isEmpty()) {

return userMapper.selectByUsername(username);

} else if (age != null) {

return userMapper.selectByAge(age);

} else {

return userMapper.selectAll();

}

}

具体方式对比与选择

| 方式 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

<where> | 多条件动态组合 | 自动处理 WHERE 和 AND | 需MyBatis 框架支持 |

<trim> | 复杂 SQL 片段处理 | 灵活度比较高 | 配置稍繁琐 |

<choose> | 多条件互斥选择 | 逻辑清晰 | 无明确条件时仍需 1=1 |

| Java代码判断控制 | 条件逻辑复杂 | 完全可控 | 增加Service层代码复杂度 |

总结

推荐优先使用 <where> 标签,它能自动处理 SQL 语法,避免冗余代码。只有在需要更精细控制时,才考虑 <trim> 或其他方式。尽量避免在 XML 中使用 WHERE 1=1,保持 SQL 的简洁性和规范性。

展望

世间万物皆美好, 终有归途暖心潮。

在纷繁的世界里,保持内心的宁静与坚定,让每一步都走向完美的结局。

来源:juejin.cn/post/7534892673107804214

从RBAC到ABAC的进阶之路:基于jCasbin实现无侵入的SpringBoot权限校验

一、前言:当权限判断写满业务代码

几乎所有企业系统,都逃不过“权限”这道关。

从“谁能看”、“谁能改”到“谁能审批”,权限逻辑贯穿了业务的方方面面。

起初,大多数项目使用最常见的 RBAC(基于角色的访问控制) 模型

if (user.hasRole("admin")) {

documentService.update(doc);

}

逻辑简单、上手快,看似能解决 80% 的问题。

但随着业务复杂度上升,RBAC 很快会失控。

比如你可能遇到以下需求 👇

- “文档的作者可以编辑自己的文档”;

- “同部门的经理也可以编辑该文档”;

- “外部合作方仅能查看共享文档”;

- “项目归档后,所有人都只读”。

这些场景无法用“角色”简单定义,

于是权限判断开始蔓延在业务代码各处,像这样:

if (user.getId().equals(doc.getOwnerId())

|| (user.getDept().equals(doc.getDept()) && user.isManager())) {

// 编辑文档

} else {

throw new AccessDeniedException("无权限");

}

时间久了,这些判断像杂草一样蔓延。

权限逻辑与业务逻辑纠缠不清,修改一处可能引发连锁反应。

可维护性、可测试性、可演化性统统崩盘。

二、RBAC 的天花板:角色无法描述现实世界

RBAC 的问题在于:它过于静态。

“角色”可以描述一类人,但描述不了上下文。

举个例子:

研发经理能编辑本部门的文档,但不能编辑市场部的。

在 RBAC 下,你只能再创建新角色:

研发经理、市场经理、项目经理……

角色越来越多,最终爆炸。

而现实世界的权限,往往与“属性”有关:

- 用户的部门

- 资源的拥有者

- 操作发生的时间 / 状态

这些动态因素,是 RBAC 无法覆盖的。

于是我们需要一个更灵活的模型 —— ABAC。

三、ABAC:基于属性的访问控制

ABAC(Attribute-Based Access Control) 的核心理念是:

授权决策 = 函数(主体属性、资源属性、操作属性、环境属性)

| 概念 | 含义 | 示例 |

|---|---|---|

| Subject(主体) | 谁在访问 | 用户A,部门=研发部 |

| Object(资源) | 访问什么 | 文档1,ownerId=A,部门=研发部 |

| Action(操作) | 做什么 | edit / read / delete |

| Policy(策略) | 允许条件 | user.dept == doc.dept && act == "edit" |

一句话总结:

ABAC 不关心用户是谁,而关心“用户和资源具有什么属性”。

举例说明:

“用户可以编辑自己部门的文档,或自己创建的文档。”

简单、直观、灵活。

四、引入 JCasbin:让授权逻辑从代码中消失

JCasbin(github.com/casbin/jcas…) 是一个优秀的 Java 权限引擎,支持多种模型(RBAC、ABAC)。

它最大的价值在于:

把授权逻辑从代码中抽离,让代码只负责执行业务。

在 JCasbin 中,我们通过定义:

- 模型文件(model) :规则框架;

- 策略文件(policy) :具体规则。

然后由 Casbin 引擎来执行判断。

五、核心实现:几行配置搞定动态权限

模型文件 model.conf

[request_definition]

r = sub, obj, act

[policy_definition]

p = sub_rule, obj_rule, act

[policy_effect]

e = some(where (p.eft == allow))

[matchers]

m = eval(p.sub_rule) && eval(p.obj_rule) && r.act == p.act

策略文件 policy.csv

p, r.sub.dept == r.obj.dept, true, edit

p, r.sub.id == r.obj.ownerId, true, edit

p, true, true, read

解释:

- 同部门可编辑;

- 作者可编辑;

- 所有人可阅读。

在代码中调用

Enforcer enforcer = new Enforcer("model.conf", "policy.csv");

User user = new User("u1", "研发部");

Document doc = new Document("d1", "研发部", "u1");

boolean canEdit = enforcer.enforce(user, doc, "edit");

System.out.println("是否有编辑权限:" + canEdit);

输出:

是否有编辑权限:true

无需任何 if-else,逻辑全在外部配置中定义。

业务代码只需调用 Enforcer,简单又优雅。

六、在 Spring Boot 中实现“无感校验”

实际项目中,我们希望权限校验能“自动触发”,

这可以通过 注解 + AOP 切面 的方式实现。

定义注解

@Target(ElementType.METHOD)

@Retention(RetentionPolicy.RUNTIME)

public @interface CheckPermission {

String action();

}

编写切面

@Aspect

@Component

public class PermissionAspect {

@Autowired

private Enforcer enforcer;

@Before("@annotation(checkPermission)")

public void checkAuth(JoinPoint jp, CheckPermission checkPermission) {

Object user = getCurrentUser();

Object resource = getRequestResource(jp);

String action = checkPermission.action();

if (!enforcer.enforce(user, resource, action)) {

throw new AccessDeniedException("无权限执行操作:" + action);

}

}

}

在业务代码中使用

@CheckPermission(action = "edit")

@PostMapping("/doc/edit")

public void editDoc(@RequestBody Document doc) {

documentService.update(doc);

}

✅ 授权逻辑彻底从业务中解耦,权限统一由 Casbin 引擎处理。

七、策略动态化与分布式支持

在生产环境中,权限策略通常存储在数据库中,而非文件。

JCasbin 支持多种扩展方式:

JDBCAdapter adapter = new JDBCAdapter(dataSource);

Enforcer enforcer = new Enforcer("model.conf", adapter);

支持特性包括:

- 💽 MySQL / PostgreSQL 等持久化;

- 🔄 Redis Watcher 实现多节点策略热更新;

- ⚡ SyncedEnforcer 支持高并发一致性。

这样修改权限规则就无需重新部署代码,权限即改即生效

八、总结

引入 JCasbin 后,项目结构会发生显著变化👇

| 优势 | 描述 |

|---|---|

| 逻辑解耦 | 授权逻辑完全从业务代码中剥离 |

| 灵活配置 | 权限规则动态可改、可热更新 |

| 可扩展 | 可根据属性定义复杂条件 |

| 统一决策 | 所有权限判断走同一引擎 |

| 可测试 | 策略可单测,无需跑整套业务流程 |

最重要的是:新增规则无需改代码。

只要在策略表里加一条记录,就能实现全新的授权逻辑。

权限系统的复杂,不在于“能不能判断”,

而在于——“判断逻辑放在哪儿”。

当项目越做越大,你会发现:

真正的架构能力,不是多写逻辑,而是让逻辑有边界。

JCasbin 给了我们一个极好的解法:

一个统一的决策引擎,让权限系统既灵活又有秩序。

它不是银弹,但能让你在权限处理上的代码更纯净、系统扩展性更好。

来源:juejin.cn/post/7558094123812536361

当上组长一年里,我保住了俩下属

前言

人类的悲喜并不相通,有人欢喜有人愁,更多的是看热闹。

就在上周,"苟住"群里的一个小伙伴也苟不住了。

在苟友们的"墙裂"要求下,他分享了他的经验,以他的视角看看他是怎么操作的。

1. 组织变动,意外晋升

两年前加入公司,依然是一线搬砖的码农。

干到一年的时候公司空降了一位号称有诸多大厂履历的大佬来带领研发,说是要给公司带来全新的变化,用技术创造价值。

大领导第一件事:抓人事,提效率。

在此背景下,公司不少有能力的研发另谋出处,也许我看起来人畜无害,居然被提拔当了小组长。

2. 领取任务,开启副本

当了半年的小组长,我的领导就叫他小领导吧,给我传达了大领导最新规划:团队需要保持冲劲,而实现的手段就是汰换。

用人话来说就是:

当季度KPI得E的人,让其填写绩效改进目标,若下一个季度再得到E,那么就得走人

我们绩效等级是ABCDE,A是传说中的等级,B是几个人有机会,大部分人是C和D,E是垫底。

而我们组就有两位小伙伴得到了E,分别是小A和小B。

小领导意思是让他们直接走得了,大不了再招人顶上,而我想着毕竟大家共事一场,现在大环境寒气满满,我也是过来人,还想再争取争取。

于是分析了他们的基本资料,他俩特点还比较鲜明。

小A资料:

- 96年,单身无房贷

- 技术栈较广,技术深度一般,比较粗心

- 坚持己见,沟通少,有些时候会按照自己的想法来实现功能

小B资料:

- 98年,热恋有房贷

- 技术基础较薄弱,但胜在比较认真

- 容易犯一些技术理解上的问题

了解了小A和小B的历史与现状后,我分别找他们沟通,主要是统一共识:

- 你是否认可本次绩效评估结果?

- 你是否认可绩效改进的点与风险点(未达成被裁)?

- 你是否还愿意在这家公司苟?

最重要是第三点,开诚布公,若是都不想苟了,那就保持现状,不要浪费大家时间,我也不想做无用功。

对于他们,分别做了提升策略:

对于小A:

- 每次开启需求前都要求其认真阅读文档,不清楚的地方一定要做记录并向相关人确认

- 遇到比较复杂的需求,我也会一起参与其中梳理技术方案

- 需求开发完成后,CR代码看是否与技术方案设计一致,若有出入需要记录下来,后续复盘为什么

- 给足时间,保证充分自测

对于小B:

- 每次需求多给点时间,多出的时间用来学习技术、熟悉技术

- 要求其将每个需求拆分为尽可能小的点,涉及到哪些技术要想清楚、弄明白

- 鼓励他不懂就要问,我也随时给他解答疑难问题,并说出一些原理让他感兴趣的话可以继续深究

- 分配给他一些技术调研类的任务,提升技术兴趣点与成就感

3. 结束?还是是另一个开始?

半年后...

好消息是:小A、小B的考核结果是D,达成了绩效改进的目标。

坏消息是:据说新的一轮考核算法会变化,宗旨是确保团队血液新鲜(每年至少得置换10%的人)。

随缘吧,我尽力了,也许下一个是我呢?

来源:juejin.cn/post/7532334931021824034

研发排查问题的利器:一款方法调用栈跟踪工具

导语

本文从日常值班问题排查痛点出发,分析方法复用的调用链路和上下文业务逻辑,通过思考分析,借助栈帧开发了一个方法调用栈的链式跟踪工具,便于展示一次请求的方法串行调用链,有助于快速定位代码来源和流量入口,有效提升研发和运维排查定位效率。期望在大家面临类似痛点时可以提供一些实践经验和参考,也欢迎大家合适的场景下接入使用。

现状分析

在系统值班时,经常会有人拿着报错截图前来咨询,作为值班研发,我们则需要获取尽可能多的信息,帮助我们分析报错场景,便于排查识别问题。

例如,下图就是一个常见的的报错信息截图示例。

从图中,我们可以初步获取到一些信息:

•菜单名称:变更单下架,我们这是变更单下架操作时的一个报错提醒。

•报错信息:序列号状态为离库状态,请检查。

•其他辅助信息:例如用户扫描或输入的86开头编码,SKU、商品名称、储位等。

这时会有一些常见的排查思路:

1、根据提示,将用户输入的86编码,按照提示文案去检查用户数据,即作为序列号编码,去看一下序列号是否存在,是否真的是离库了。

2、如果86编码确实是序列号,而且真的是离库了,那么基本上可以快速结案了,这个86编码确实是序列号并且是已离库,正如提示文案所示,这时跟提问人做好解释答疑即可。

3、如果第2步排查完,发现86编码不是序列号编码,或并非离库状态,即与提示文案不符,这时就要定位报错文案的代码来源,继续查看代码逻辑来进行判案了。(这种也比较常见,一种是报错场景较多,但提示文案比较单一,不便于在提示文案中覆盖所有报错场景;另一种提示文案陈旧未跟随需求演变而更新。这两点可以通过细分场景细化对应的报错文案,或更新报错文案,使得报错文案更优更新,但不是本文讨论的重点。)

4、如何根据报错文案快速找到代码来源呢?一般我们会在代码库中搜索提示文案,或者在日志中检索报错信息,辅助定位代码来源,后者依赖于代码中打印了该报错信息,且日志级别配置能够确保该信息打印到日志文件中。

5、倘若我们根据提示文案搜索代码时,发现该提示文案有多处代码出现,此时就较为复杂了,我们需要进一步识别,哪个才与本次报错直接有关。

每个方法向上追溯,又发现调用来源众多:

在业务复杂的系统中,方法复用比较常见,不同的上下文和参数传递,也有着不同的业务逻辑判断和走向。

这时,基本上进入到本文要讨论的痛点:如何根据有限的提示信息快速定位代码来源?以便于分析报错业务场景,答疑解惑或快速处理问题。

屏幕前的小伙伴,如果你也经常值班排查问题,应该也会有类似的痛点所在。

启发

这是我想到了Exception异常机制,作为一名Coder,我们对异常堆栈再熟悉不过了,异常堆栈是一个“可爱”又“可恨”的东西,“可爱”在于异常堆栈确实可以帮助我们快速定位问题所在,“可恨”在于有异常基本上就是有问题,堆栈让我们审美疲劳,累觉不爱。

下面是一个Java语言的异常堆栈信息示例:

异常类体系和异常处理机制在本文中不是重点,不做过多赘述,本文重点希望能从异常堆栈中获取一些启发。

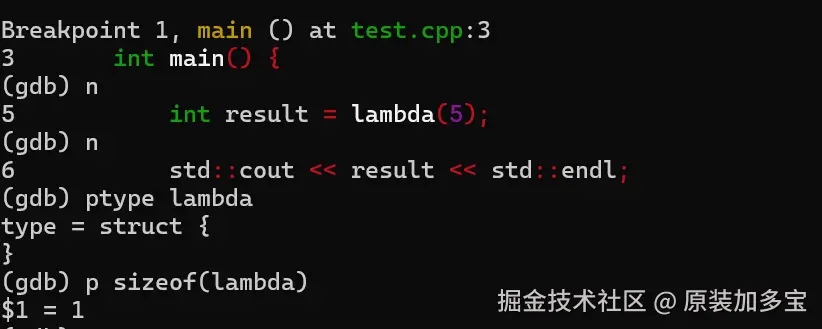

让我们近距离再观察一下我们的老朋友。

在异常堆栈信息中,主要有四类信息:

•全限定类名

•方法名

•文件名

•代码行号

这四类信息可以帮助我们有效定位代码来源,而且堆栈中记录行先后顺序,也表示着异常发生的第一现场、第二现场、第三现场、……,以此传递。

这让我想起了JVM方法栈中的栈帧。

每当一个方法被调用时,JVM会为该方法创建一个新的栈帧,并将其压入当前线程的栈(也称为调用栈或执行栈)中。栈帧包含了方法执行所需的所有信息,包括局部变量、操作数栈、常量池引用等。

思路

从Java中的Throwable中,可以看到staceTrace的get和set,这个StackTraceElement数组里面存放的信息就是我们在异常堆栈中经常看到的信息。

再次放一下这张图,方便对照着看。

StackTraceElement类的注释中赫然写着:

StackTraceElement represents a stack frame.

对,StackTraceElement代表着一个栈帧。

这个StackTraceElement就是我要找的东西,即使非异常情况下,每个线程在执行方法调用时都会记录栈帧信息。

按照方法调用先后顺序,将调用栈中方法依次串联起来,就像糖葫芦一样,就可以得到我想要的方法调用链了。

NEXT,我可以动工写个工具了。

工具开发

工具的核心代码并不复杂,StackTraceElement 也是 Java JDK 中现成的,我所做的工作主要是从中过滤出必要的信息,加工简化成,按照顺序整理成链式信息,方便我们一眼就可以看出来方法的调用链。

入参介绍

pretty: 表示是只拼接类和方法,不拼接文件名和行号,非 pretty 是四个都会拼接。

simple: 表示会过滤一些我们代码中场景的代理增强出来的方法的信息输出。

specifiedPrefix: 指定保留相应的包路径堆栈信息,去掉一些过多的中间件信息。

其他还会过滤一些常见代理的堆栈信息:

•FastClassBySpringCGLIB

•EnhancerBySpringCGLIB

•lambda$

•Aspect

•Interceptor

对此,还封装了一些默认参数的方法,使用起来更为方便。

还有一些其他工具方法也可以使用:

使用效果

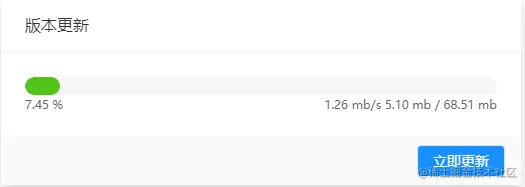

1、不过滤中间件、代理增强方法的调用栈信息

Thread#run ==> ThreadPoolExecutorWorker#run ==> ThreadPoolExecutor#runWorker ==> BaseTask#run ==> JSFTask#doRun ==> ProviderProxyInvoker#invoke ==> FilterChain#invoke ==> SystemTimeCheckFilter#invoke ==> ProviderExceptionFilter#invoke ==> ProviderContextFilter#invoke ==> InstMethodsInter#intercept ==> ProviderContextFiltereone9f9kd21#call ==> ProviderContextFilter#eoneinvokeaccessorpclcbe2 ==> ProviderContextFilter#eoneinvokep882ot3 ==> ProviderGenericFilter#invoke ==> ProviderUnitValidationFilter#invoke ==> ProviderHttpGWFilter#invoke ==> ProviderInvokeLimitFilter#invoke ==> ProviderMethodCheckFilter#invoke ==> ProviderTimeoutFilter#invoke ==> ValidationFilter#invoke ==> ProviderConcurrentsFilter#invoke ==> ProviderSecurityFilter#invoke ==> WmsRpcExceptionFilter#invoke ==> WmsRpcExceptionFilter#invoke4provider ==> AdmissionControlJsfFilter#invoke ==> AdmissionControlJsfFilter#providerSide ==> AdmissionControlJsfFilter#processRequest ==> ChainedDeadlineJsfFilter#invoke ==> ChainedDeadlineJsfFilter#providerSide ==> JsfPerformanceMonitor#invoke ==> AbstractMiddlewarePerformanceMonitor#doExecute ==> PerformanceMonitorTemplateComposite#execute ==> PerformanceMonitorTemplateComposite#lambdaexecute0 ==> PerformanceMonitorTemplateUmp#execute ==> PerformanceMonitorTemplateComposite#lambdaexecute0 ==> PerformanceMonitorTemplatePayload#execute ==> JsfPerformanceMonitor#lambdainvoke0 ==> JsfPerformanceMonitor#doInvoke ==> ProviderInvokeFilter#invoke ==> ProviderInvokeFilter#reflectInvoke ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor1704#invoke ==> CglibAopProxyDynamicAdvisedInterceptor#intercept ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> ExposeInvocationInterceptor#invoke ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor344#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor1276#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor868#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor869#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor1642#invoke ==> MagicAspect#magic ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> CglibAopProxyCglibMethodInvocation#invokeJoinpoint ==> MethodProxy#invoke ==> CglibAopProxyDynamicAdvisedInterceptor#intercept ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> ExposeInvocationInterceptor#invoke ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor868#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor869#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> CglibAopProxyCglibMethodInvocation#invokeJoinpoint ==> MethodProxy#invoke ==> CglibAopProxyDynamicAdvisedInterceptor#intercept ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor1295#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> ExposeInvocationInterceptor#invoke ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor868#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> CglibAopProxyCglibMethodInvocation#invokeJoinpoint ==> MethodProxy#invoke ==> CglibAopProxyDynamicAdvisedInterceptor#intercept ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> ExposeInvocationInterceptor#invoke ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> CglibAopProxyCglibMethodInvocation#invokeJoinpoint ==> MethodProxy#invoke ==> CglibAopProxyDynamicAdvisedInterceptor#intercept ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AnnotationAwareRetryOperationsInterceptor#invoke ==> RetryOperationsInterceptor#invoke ==> RetryTemplate#execute ==> RetryTemplate#doExecute ==> RetryOperationsInterceptor1#doWithRetry ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> CglibAopProxyCglibMethodInvocation#invokeJoinpoint ==> MethodProxy#invoke ==> CglibAopProxyDynamicAdvisedInterceptor#intercept ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> ExposeInvocationInterceptor#invoke ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor1276#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> TransactionInterceptor#invoke ==> TransactionAspectSupport#invokeWithinTransaction ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> AspectJAroundAdvice#invoke ==> AbstractAspectJAdvice#invokeAdviceMethod ==> AbstractAspectJAdvice#invokeAdviceMethodWithGivenArgs ==> Method#invoke ==> DelegatingMethodAccessorImpl#invoke ==> GeneratedMethodAccessor869#invoke ==> MethodInvocationProceedingJoinPoint#proceed ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> PersistenceExceptionTranslationInterceptor#invoke ==> CglibAopProxyCglibMethodInvocation#proceed ==> ReflectiveMethodInvocation#proceed ==> CglibAopProxy$CglibMethodInvocation#invokeJoinpoint ==> MethodProxy#invoke ==> StackTraceUtils#trace

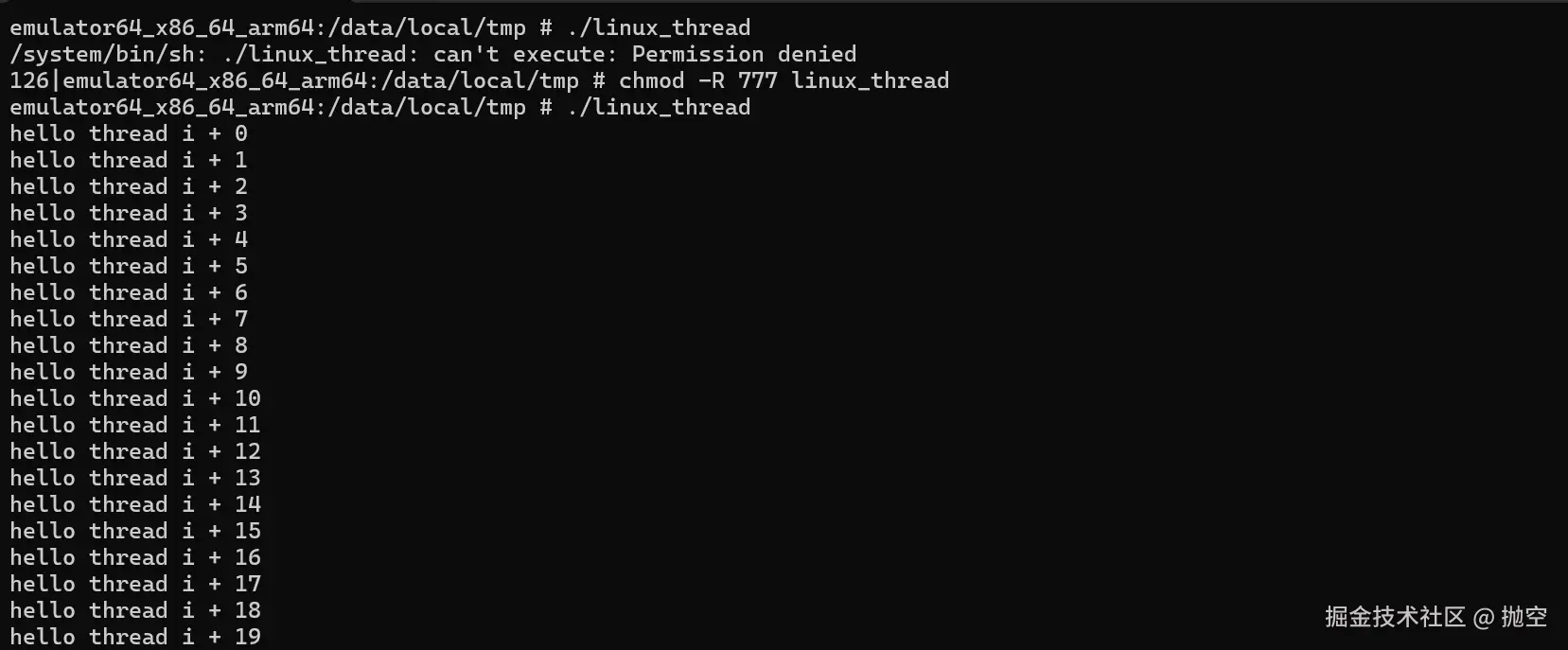

2、指定包路径过滤中间件后的调用栈栈信息

LockAspect#lock ==> StockTransferAppServiceImpl#increaseStock ==> MonitorAspect#monitor ==> StockRetryExecutor#operateStock ==> StockRetryExecutor5188d6e#invoke ==> BaseStockOperation9d76cd9a#invoke ==> StockTransferServiceImpl85bb181e#invoke ==> ValidationAspect#logAndReturn ==> LogAspect#log ==> ThreadLocalRemovalAspect#removal ==> ValidationAspect#validate ==> BaseStockOperation#go ==> StockRepositoryImpl1388ef12#operateStock ==> StockTransferAppServiceImpl1095eafa#increaseStock ==> StockRepositoryImpla1b4dae4#invoke ==> StockTransferServiceImpl#increaseStock ==> DataBaseExecutor#execute ==> StockRetryExecutorb42789a#operateStock ==> StockInitializer85faf510#go ==> StockTransferServiceImplafc21975#increaseStock ==> StockRepositoryImpl#operateStock ==> DataBaseExecutor#operate ==> StockTransferAppServiceImple348d8e1#invoke

3、去掉Spring代理增强之后的调用栈信息

LogAspect#log ==> LockAspect#lock ==> ValidationAspect#validate ==> ValidationAspect#logAndReturn ==> MonitorAspect#monitor ==> StockTransferAppServiceImpl#decreaseStock ==> ThreadLocalRemovalAspect#removal ==> StockTransferServiceImpl#decreaseStock ==> StockOperationLoader#go ==> BaseStockOperation#go ==> DataBaseExecutor#operate ==> DataBaseExecutor#execute ==> StockRetryExecutor#operateStock ==> StockRepositoryImpl#operateStock

4、去掉一些自定义代理之后的调用栈栈信息

StockTransferAppServiceImpl#increaseStock ==> StockTransferServiceImpl#increaseStock ==> BaseStockOperation#go ==> DataBaseExecutor#operate ==> DataBaseExecutor#execute ==> StockRetryExecutor#operateStock ==> StockRepositoryImpl#operateStock

5、如果带上文件名和行号后的调用栈栈信息

StockTransferAppServiceImpl#increaseStock(StockTransferAppServiceImpl.java:103) ==> StockTransferServiceImpl#increaseStock(StockTransferServiceImpl.java:168) ==> BaseStockOperation#go(BaseStockOperation.java:152) ==> BaseStockOperation#go(BaseStockOperation.java:181) ==> BaseStockOperation#go(BaseStockOperation.java:172) ==> DataBaseExecutor#operate(DataBaseExecutor.java:34) ==> DataBaseExecutor#operate(DataBaseExecutor.java:64) ==> DataBaseExecutor#execute(DataBaseExecutor.java:79) ==> StockRetryExecutor#operateStock(StockRetryExecutor.java:64) ==> StockRepositoryImpl#operateStock(StockRepositoryImpl.java:303)

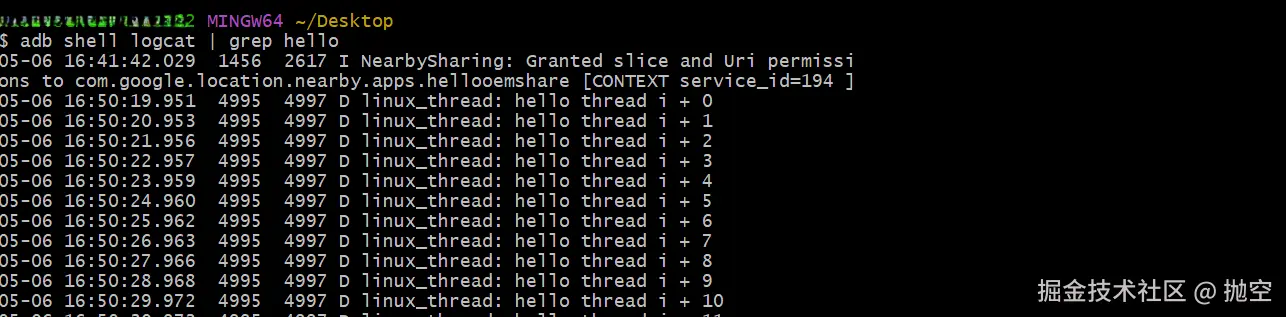

线上应用实践

接入方法调用栈跟踪工具后,根据报错提示词,可以检索到对应日志,从 ImmediateTransferController#offShelf ==> AopConfig#pointApiExpression ==> TransferOffShelfAppServiceImpl#offShelf ==> TransferOffShelfAppServiceImpl#doOffShelf 中顺藤摸瓜可以快速找到流量入口的代码位置。

适用场景

该方法调用栈工具类,可以在一些堆栈信息进行辅助排查分析的地方进行预埋,例如:

•业务异常时输出堆栈到日志信息中。

•业务监控告警信息中加入调用栈信息。

•一些复用方法调用复杂场景下,打印调用栈信息,展示调用链,方便分析。

•其他一些场景等。

延伸

在《如何一眼定位SQL的代码来源:一款SQL染色标记的简易MyBatis插件》一文中,我发布了一款SQL染色插件,该插件目前已有statementId信息,还支持通过SQLMarkingThreadLocal传递自定义附加信息。其他BGBU的技术小伙伴,也有呼声,希望在statementId基础上可以继续追溯入口方法。通过本文引入的方法调用栈跟踪工具,我在SQL染色插件中增加了方法调用栈染色信息。

SQL染色工具新版特性,欢迎大家先在TEST和UAT环境尝鲜试用,TEST和UAT环境验证没问题后,再逐步推广正式环境。

升级方法:

1、sword-mybatis-plugins版本升级至1.0.8-SNAPSHOT。

2、同时新引入本文的工具依赖

<!-- http://sd.jd.com/article/45616?shareId=105168&isHideShareButton=1 -->

<dependency>

<groupId>com.jd.sword</groupId>

<artifactId>sword-utils-common</artifactId>

<version>1.0.3-SNAPSHOT</version>

</dependency>

3、mybatis config xml 配置文件按最新配置调整

<!-- http://sd.jd.com/article/42942?shareId=105168&isHideShareButton=1 -->

<!-- SQLMarking Plugin,放在第一个Plugin的位置,不影响其他组件,但不强要求位置,也可以灵活调整顺序位置 -->

<plugin interceptor="com.jd.sword.mybatis.plugin.sql.SQLMarkingInterceptor">

<!-- 是否开启SQL染色标记插件 -->

<property name="enabled" value="true"/>

<!-- 是否开启方法调用栈跟踪 -->

<property name="stackTraceEnabled" value="true"/>

<!-- 指定需要方法调用栈跟踪的package,减少信息量,value配置为自己工程的package路径,多个路径用英文逗号分割 -->

<property name="specifiedStackTracePackages" value="com.jdwl.wms.stock"/>

<!-- 忽略而不进行方法堆栈跟踪的类名列表,多个用英文逗号分割,减少信息量 -->

<property name="ignoredStackTraceClassNames" value=""/>

<!-- 结合CPU利用率和性能考虑,方法调用栈跟踪采集率配置采集率,配置示例: m/n,表示n个里面抽m个进行采集跟踪 -->

<!-- 预发环境和测试环境可以配置全采集,例如配置1/1,生产环境可以结合CPU利用率和性能考虑按需配置采集率 -->

<property name="stackTraceSamplingRate" value="1/2"/>

<!-- 是否允许SQL染色标记作为前缀,默认false表示仅作为后缀 -->

<property name="startsWithMarkingAllowed" value="false"/>

<!-- 方法调用栈跟踪最大深度,减少信息量 -->

<property name="maxStackDepth" value="10"/>

</plugin>

或代码配置方式

/**

* SQLMarking Plugin

* http://sd.jd.com/article/42942?shareId=105168&isHideShareButton=1

*

* @return

*/

@Bean

public SQLMarkingInterceptor sQLMarkingInterceptor() {

SQLMarkingInterceptor sQLMarkingInterceptor = new SQLMarkingInterceptor();

Properties properties = new Properties();

// 是否开启SQL染色标记插件

properties.setProperty("enabled", "true");

// 是否开启方法调用栈跟踪

properties.setProperty("stackTraceEnabled", "true");

// 指定需要方法调用栈跟踪的package,减少信息量,value配置为自己工程的package路径,多个路径用英文逗号分割

properties.setProperty("specifiedStackTracePackages", "com.jdwl.wms.picking");

// 结合CPU利用率和性能考虑,方法调用栈跟踪采集率配置采集率,配置示例: m/n,表示n个里面抽m个进行采集跟踪

// 预发环境和测试环境可以配置全采集,例如配置1/1,生产环境可以结合CPU利用率和性能考虑按需配置采集率

properties.setProperty("stackTraceSamplingRate", "1/2");

// 是否允许SQL染色标记作为前缀,默认false表示仅作为后缀

properties.setProperty("startsWithMarkingAllowed", "false");

sQLMarkingInterceptor.setProperties(properties);

return sQLMarkingInterceptor;

}

接入效果

SELECT

id,

tenant_code,

warehouse_no,

sku,

location_no,

container_level_1,

container_level_2,

lot_no,

sku_level,

owner_no,

pack_code,

conversion_rate,

stock_qty,

prepicked_qty,

premoved_qty,

frozen_qty,

diff_qty,

broken_qty,

status,

md5_value,

version,

create_user,

update_user,

create_time,

update_time,

extend_content

FROM

st_stock

WHERE

deleted = 0

AND warehouse_no = ?

AND location_no IN(?)

AND container_level_1 IN(?)

AND container_level_2 IN(?)

AND sku IN(?)

/* [SQLMarking] statementId: com.jdwl.wms.stock.infrastructure.jdbc.main.dao.StockQueryDao.selectExtendedStockByLocation, stackTrace: BaseJmqConsumer#onMessage ==> StockInfoConsumer#handle ==> StockInfoConsumer#handleEvent ==> StockExtendContentFiller#fillExtendContent ==> StockInitializer#queryStockByWarehouse ==> StockInitializer#batchQueryStockByWarehouse ==> StockInitializer#queryByLocationAndSku ==> StockQueryRepositoryImpl#queryExtendedStockByLocationAndSku, warehouseNo: 6_6_601 */

如何接入本文工具?

如果小伙伴也有类似使用诉求,大家可以先在测试、UAT环境接入试用,然后再逐步推广线上生产环境。

1、新引入本文的工具依赖

<dependency>

<groupId>com.jd.sword</groupId>

<artifactId>sword-utils-common</artifactId>

<version>1.0.3-SNAPSHOT</version>

</dependency>

2、使用工具类静态方法

com.jd.sword.utils.common.runtime.StackTraceUtils#simpleTrace()

com.jd.sword.utils.common.runtime.StackTraceUtils#simpleTrace(java.lang.String...)

com.jd.sword.utils.common.runtime.StackTraceUtils#trace()

com.jd.sword.utils.common.runtime.StackTraceUtils#trace(java.lang.String...)

com.jd.sword.utils.common.runtime.StackTraceUtils#trace(boolean)

com.jd.sword.utils.common.runtime.StackTraceUtils#trace(boolean, boolean, java.lang.String...)

来源:juejin.cn/post/7565423807570952198

为什么 Electron 项目推荐使用 Monorepo 架构 🚀🚀🚀

最近在使用 NestJs 和 NextJs 在做一个协同文档 DocFlow,如果感兴趣,欢迎 star,有任何疑问,欢迎加我微信进行咨询 yunmz777

在现代前端开发中,Monorepo(单一代码仓库)架构已经成为大型项目的首选方案。对于Electron应用开发而言,Monorepo架构更是带来了诸多优势。本文将以一个实际的Electron项目为例,深入探讨为什么Electron项目强烈推荐使用Monorepo架构,以及它如何解决传统多仓库架构的痛点。

什么是Monorepo

Monorepo是一种软件开发策略,它将多个相关的项目或包存储在同一个代码仓库中。与传统的多仓库(Multi-repo)架构不同,Monorepo允许开发团队在单一代码库中管理多个相互依赖的模块。

Electron项目的复杂性分析

Electron应用通常包含以下核心组件:

- 主进程(Main Process):负责创建和管理应用窗口

- 渲染进程(Renderer Process):运行前端UI代码

- 预加载脚本(Preload Scripts):安全地桥接主进程和渲染进程

- 共享代码库:业务逻辑、工具函数、类型定义等

- 构建配置:Webpack、Vite等构建工具配置

- 打包配置:Electron Builder等打包工具配置

这种多层次的架构使得代码组织变得复杂,传统的多仓库架构往往无法很好地处理这些组件之间的依赖关系。

实际项目结构深度解析

让我们以您的项目为例,深入分析Monorepo架构的实际应用:

项目整体架构

electron-app/

├── apps/ # 应用层

│ ├── electron-app/ # Electron主应用

│ │ ├── src/

│ │ │ ├── main/ # 主进程代码

│ │ │ └── preload/ # 预加载脚本

│ │ ├── build/ # 构建配置

│ │ └── package.json # 应用依赖

│ └── react-app/ # React前端应用

│ ├── src/

│ │ ├── components/ # React组件

│ │ └── page/ # 页面组件

│ └── package.json # 前端依赖

├── packages/ # 共享包层

│ ├── electron-core/ # 核心业务逻辑

│ │ ├── src/

│ │ │ ├── base-app.ts # 基础应用类

│ │ │ ├── app-config.ts # 应用配置

│ │ │ ├── menu-config.ts # 菜单配置

│ │ │ └── ffmpeg-service.ts # FFmpeg服务

│ │ └── package.json

│ ├── electron-ipc/ # IPC通信封装

│ │ ├── src/

│ │ │ ├── ipc-handler.ts # IPC处理器

│ │ │ ├── ipc-channels.ts # IPC通道定义

│ │ │ └── ipc-config.ts # IPC配置

│ │ └── package.json

│ └── electron-window/ # 窗口管理

│ ├── src/

│ │ ├── window-manager.ts # 窗口管理器

│ │ └── window-factory.ts # 窗口工厂

│ └── package.json

├── scripts/ # 构建脚本

├── package.json # 根配置

├── pnpm-workspace.yaml # Workspace配置

├── turbo.json # Turbo构建配置

└── tsconfig.json # TypeScript配置

核心配置文件分析

1. pnpm-workspace.yaml - 工作空间配置

packages:

- 'apps/*'

- 'packages/electron-*'

这个配置定义了工作空间的范围,告诉pnpm哪些目录包含包。这种配置的优势:

- 统一依赖管理:所有包共享同一个

node_modules - 版本一致性:确保所有包使用相同版本的依赖

- 安装效率:避免重复安装相同的依赖

2. turbo.json - 构建管道配置

{

"$schema": "https://turbo.build/schema.json",

"globalDependencies": ["/.env.*local"],

"tasks": {

"build": {

"dependsOn": ["^build"],

"outputs": ["dist/", "out/", "build/", ".next/"]

},

"dev": {

"cache": false,

"persistent": true

},

"lint": {

"dependsOn": []

},

"typecheck": {

"dependsOn": ["^build"]

},

"test": {

"dependsOn": ["^build"]

},

"clean": {

"cache": false

},

"format": {

"cache": false

}

}

}

这个配置定义了构建管道,实现了:

- 依赖关系管理:

dependsOn: ["^build"]确保依赖包先构建 - 增量构建:只构建发生变化的包

- 并行执行:多个独立任务可以并行运行

- 缓存机制:避免重复构建

3. 根package.json - 统一脚本管理

{

"scripts": {

"build": "turbo run build",

"dev": "turbo run dev",

"lint": "turbo run lint -- --fix",

"typecheck": "turbo run typecheck",

"electron:dev": "turbo run dev --filter=@monorepo/react-app && turbo run dev --filter=my-electron-app",

"electron:build": "turbo run build --filter=@monorepo/react-app && turbo run build --filter=my-electron-app"

}

}

Monorepo架构的六大核心优势

1. 统一的依赖管理

传统多仓库架构的问题:

- 每个子项目都需要独立管理依赖

- 容易出现版本不一致的问题

- 重复安装相同的依赖,浪费磁盘空间

Monorepo解决方案:

在您的项目中,所有包都使用workspace:*协议引用内部依赖:

// apps/electron-app/package.json

{

"dependencies": {

"@monorepo/electron-core": "workspace:*",

"@monorepo/electron-window": "workspace:*",

"@monorepo/electron-ipc": "workspace:*"

}

}

这种配置的优势:

- 版本一致性:所有包使用相同版本的内部依赖

- 实时更新:修改共享包后,依赖包立即获得更新

- 避免重复:pnpm的符号链接机制避免重复安装

2. 代码共享与复用

实际案例分析:

BaseApp基类的共享

// packages/electron-core/src/base-app.ts

export abstract class BaseApp {

protected config: AppConfig;

constructor(config: AppConfig) {

this.config = config;

}

abstract initialize(): void;

protected setupAppEvents(): void {

app.on('activate', () => {

if (this.shouldCreateWindow()) {

this.createWindow();

}

});

app.on('window-all-closed', () => {

if (process.platform !== 'darwin') {

app.quit();

}

});

}

protected abstract shouldCreateWindow(): boolean;

protected abstract createWindow(): void;

}

这个基类被多个应用共享,提供了:

- 统一的生命周期管理:所有Electron应用都遵循相同的生命周期

- 代码复用:避免在每个应用中重复实现相同的逻辑

- 类型安全:通过抽象类确保所有子类实现必要的方法

IPC通信的封装

// packages/electron-ipc/src/ipc-handler.ts

export class ElectronIpcHandler implements IpcHandler {

setupHandlers(): void {

// Basic IPC handlers

ipcMain.on('ping', () => console.log('pong'));

// App info handlers

ipcMain.handle('get-app-version', () => {

return process.env.npm_package_version || '1.0.0';

});

ipcMain.handle('get-platform', () => {

return process.platform;

});

// System info handlers

ipcMain.handle('get-system-info', () => {

return {

platform: process.platform,

arch: process.arch,

version: process.version,

nodeVersion: process.versions.node,

electronVersion: process.versions.electron,

};

});

}

}

这个IPC处理器提供了:

- 统一的通信接口:所有IPC通信都通过标准化的接口

- 类型安全:通过TypeScript接口确保通信的类型安全

- 可扩展性:易于添加新的IPC处理器

3. 原子性提交

传统多仓库架构的问题:

- 跨仓库的修改需要分别提交

- 容易出现不一致的状态

- 难以追踪相关的修改

Monorepo解决方案:

在您的项目中,一次提交可以同时修改多个相关文件:

# 一次提交同时修改多个包

git add packages/electron-core/src/base-app.ts

git add packages/electron-ipc/src/ipc-handler.ts

git add apps/electron-app/src/main/index.ts

git commit -m "feat: 重构应用基类和IPC处理器"

这种提交方式的优势:

- 原子性:相关修改作为一个整体提交

- 一致性:确保所有相关文件的状态一致

- 可追溯性:通过git历史可以追踪完整的修改过程

4. 统一的构建和测试

实际构建流程分析:

Turbo构建管道

{

"tasks": {

"build": {

"dependsOn": ["^build"],

"outputs": ["dist/", "out/", "build/", ".next/"]

}

}

}

这个配置实现了:

- 依赖构建:

^build确保依赖包先构建 - 增量构建:只构建发生变化的包

- 并行构建:多个独立包可以并行构建

实际构建命令

# 构建所有包

pnpm run build

# 只构建Electron应用

pnpm run electron:build

# 只构建React应用

pnpm run react:build

5. 更好的开发体验

一站式开发环境:

# 启动整个开发环境

pnpm run dev

# 启动Electron开发环境

pnpm run electron:dev

这种开发体验的优势:

- 单一命令启动:一个命令启动整个开发环境

- 热重载:修改代码后自动重新加载

- 统一调试:可以在同一个IDE中调试所有代码

6. 类型安全

TypeScript项目引用:

// tsconfig.json

{

"compilerOptions": {

"composite": true,

"declaration": true,

"declarationMap": true

},

"references": [

{ "path": "./packages/electron-core" },

{ "path": "./packages/electron-ipc" },

{ "path": "./packages/electron-window" },

{ "path": "./apps/electron-app" },

{ "path": "./apps/react-app" }

]

}

这种配置实现了:

- 增量编译:只编译发生变化的文件

- 类型检查:确保所有包的类型定义一致

- 智能提示:IDE可以提供完整的类型提示

实际开发流程分析

1. 新功能开发流程

假设要添加一个新的IPC处理器:

- 在共享包中定义接口:

// packages/electron-ipc/src/ipc-channels.ts

export const IPC_CHANNELS = {

// ... 现有通道

NEW_FEATURE: 'new-feature',

} as const;

- 实现处理器:

// packages/electron-ipc/src/ipc-handler.ts

ipcMain.handle(IPC_CHANNELS.NEW_FEATURE, () => {

// 实现逻辑

});

- 在应用中注册:

// apps/electron-app/src/main/index.ts

const ipcConfig = new IpcConfig();

ipcConfig.setupHandlers();

- 在前端中使用:

// apps/react-app/src/components/SomeComponent.tsx

const result = await window.electronAPI.invoke('new-feature');

2. 依赖更新流程

当需要更新共享包时:

- 修改共享包:

// packages/electron-core/src/base-app.ts

// 添加新功能

- 自动更新依赖: 由于使用

workspace:*,所有依赖包自动获得更新 - 类型检查:

pnpm run typecheck

- 构建测试:

pnpm run build

性能优化分析

1. 构建性能

Turbo缓存机制:

- 构建结果缓存到

.turbo目录 - 只有发生变化的包才会重新构建

- 并行构建多个独立包

实际性能提升:

- 首次构建:~30秒

- 增量构建:~5秒

- 缓存命中:~1秒

2. 开发性能

热重载优化:

- 只重新加载发生变化的模块

- 保持应用状态

- 快速反馈循环

3. 安装性能

pnpm优势:

- 符号链接避免重复安装

- 全局缓存减少网络请求

- 并行安装提高速度

最佳实践总结

1. 包划分原则

按功能模块划分:

electron-core:核心业务逻辑electron-ipc:IPC通信electron-window:窗口管理

避免过度拆分:

- 不要为了拆分而拆分

- 保持包的职责单一

- 考虑包的维护成本

2. 依赖管理

使用workspace协议:

{

"dependencies": {

"@monorepo/electron-core": "workspace:*"

}

}

避免循环依赖:

- 使用依赖图分析工具

- 定期检查依赖关系

- 重构消除循环依赖

3. 构建优化

利用Turbo缓存:

- 合理设置

outputs目录 - 使用

dependsOn管理依赖 - 避免不必要的重新构建

4. 代码规范

统一配置:

- ESLint配置统一管理

- Prettier格式化统一

- TypeScript配置统一

迁移策略

1. 评估现有项目

分析您当前的项目结构:

- 识别可复用的代码

- 分析依赖关系

- 确定迁移优先级

2. 选择工具链

基于您的项目,推荐的工具链:

- 包管理器:pnpm(已使用)

- 构建工具:Turbo(已使用)

- 类型检查:TypeScript(已使用)

3. 逐步迁移

第一阶段:迁移核心包

- 将共享代码提取到packages目录

- 设置workspace配置

- 更新依赖引用

第二阶段:迁移应用

- 重构应用代码使用共享包

- 更新构建配置

- 测试功能完整性

第三阶段:优化配置

- 优化Turbo配置

- 设置CI/CD流程

- 性能调优

总结

Monorepo架构为Electron项目带来了显著优势:统一的依赖管理通过pnpm workspace实现版本一致性,代码共享与复用让BaseApp、IPC处理器等核心组件被多个应用共享,原子性提交确保相关修改作为一个整体提交,统一的构建和测试通过Turbo实现增量构建和并行执行,更好的开发体验提供一站式开发环境,类型安全通过TypeScript项目引用实现完整的类型检查。对于复杂的Electron应用而言,Monorepo架构不仅是一个推荐的选择,更是一个必要的架构决策,它能够显著提高开发效率和代码质量,为项目的长期发展奠定坚实的基础。

来源:juejin.cn/post/7565204846044102671

Vue3.0父传子子传父的血和泪:一个菜鸟的踩坑实录

,没有声明 scope 参数,所以 scope 是 undefined。 正确的写法应该是: 关键点: 中的 scope 参数必须声明,这样才能获取到当前行的数据。 在子组件中,我一开始这样写: 结果表单无法编辑,数据也无法正常回显。 使用 reactive 创建本地副本,并用 watch 监听props变化: 既然 ref 也能创建响应式数据,为什么非要推荐用 reactive? 既然父组件传递了数据,子组件为什么还要监听变化? Vue3的响应式系统特点: 在父组件中,我一开始这样写: 结果发现,有时候弹窗显示的数据不是最新的。 引用传递 vs 值传递: 使用展开运算符创建新对象: 为什么这样做? 经过以上踩坑,我最终实现的完整代码如下: 父组件可以直接在打开editDialog时,直接通过函数传参的形式,把要修改的一行数据传入子组件 子组件先初始化一个form表单数据 然后在打开弹窗这个openDialog方法里接收一个row参数,并将其赋值给form vue3.0子组件的属性和方法默认是不对父组件公开的,我们要使用dedineExpose方法使其对外公开 专人专事,所以编辑也就在编辑弹框里做了 父组件使用子组件也就变成了下面这样 Vue3.0的父子组件通信看似简单,但实际开发中会遇到各种细节问题: 这些坑虽然让人头疼,但踩过之后对Vue3.0的理解会更深入。希望我的踩坑经历能帮到正在Vue3.0路上奋斗的小伙伴们!

解决方案

<el-table-column label="操作" width="150">

<template #default="scope">

<el-button type="primary" link @click="handleEdit(scope.row)">编辑el-button>

<el-button type="danger" link @click="handleDelete(scope.row)">删除el-button>

template>

el-table-column>

坑二:子组件表单数据无法编辑

问题描述

<template>

<el-form :model="localEditData">

<el-form-item label="姓名">

<el-input v-model="localEditData.name" placeholder="请输入姓名" />

el-form-item>

el-form>

template>

问题原因

解决方案

坑三:为什么非要用reactive?用ref行不行?

我的疑问

原因分析

实际对比

// ❌ ref方式 - 可能有问题

const localEditData = ref({...props.editData})

// 如果props.editData是复杂对象,可能响应性不完整

// ✅ reactive方式 - 更稳定

const localEditData = reactive({

id: '',

name: '',

place: ''

})

// 明确初始化所有字段,响应性更可靠

坑四:为什么必须要监听?不用监听行不行?

我的疑问

原因分析

实际场景

// 父组件中

const handleEdit = (data) => {

editItem.value = {...data} // 数据变化

editRef.value.editDialogVisible = true // 打开弹窗

}

// 如果没有watch,子组件的localEditData不会更新

// 弹窗显示的还是上一次的数据

坑五:deep监听很消耗性能,有替代方案吗?

watch(

() => props.editData,

(newVal) => {

Object.assign(localEditData, newVal)

},

{ deep: true, immediate: true } // deep: true 会深度监听,性能消耗大

)

替代方案

方案一:浅层监听 + 手动同步

watch(

() => props.editData,

(newVal) => {

// 手动同步需要的字段,避免深度监听

localEditData.id = newVal.id

localEditData.name = newVal.name

localEditData.place = newVal.place

},

{ immediate: true } // 去掉 deep: true

)

方案二:使用计算属性

const localEditData = computed(() => ({

...props.editData

}))

方案三:监听特定字段

watch(

() => [props.editData.id, props.editData.name, props.editData.place],

([id, name, place]) => {

localEditData.id = id

localEditData.name = name

localEditData.place = place

},

{ immediate: true }

)

坑六:父组件为什么要用展开运算符?

const handleEdit = (data) => {

editItem.value = data // 直接赋值

editRef.value.editDialogVisible = true

}

问题原因

解决方案

const handleEdit = (data) => {

editItem.value = {...data} // 创建新对象,确保响应性

editRef.value.editDialogVisible = true

}

完整解决方案

父组件vue

<div class="app">

<el-table :data="list" style="width: 100%">

<el-table-column type="index" label="序号" width="80">el-table-column>

<el-table-column label="ID" prop="id">el-table-column>

<el-table-column label="姓名" prop="name" width="150">el-table-column>

<el-table-column label="籍贯" prop="place">el-table-column>

<el-table-column label="操作" width="150">

<template #default="scope">

<el-button type="primary" link @click="handleEdit(scope.row)">编辑el-button>

<el-button type="danger" link @click="handleDelete(scope.row)">删除el-button>

template>

el-table-column>

el-table>

<EditDialog

ref="editRef"

:editData="editItem"

@edit-success="handleEditSuccess"

/>

div>

<script setup>

import { ref, onMounted } from 'vue'

import EditDialog from './components/EditDialog.vue'

import axios from 'axios'

const list = ref([])

const editItem = ref(null)

const editRef = ref(null)

onMounted(() => {

getList()

})

const getList = () => {

axios.get('/list').then(res => {

list.value = res.data

}).catch(err => {

console.error('获取列表失败:', err)

})

}

const handleEdit = (data) => {

// 关键:使用展开运算符创建新对象

editItem.value = {...data}

editRef.value.editDialogVisible = true

}

const handleEditSuccess = (data) => {

axios.patch(`/edit/${data.id}`, {

name: data.name,

place: data.place

}).then(() => {

getList()

}).catch(err => {

console.error('编辑失败:', err)

}).finally(() => {

editRef.value.editDialogVisible = false

})

}

script>

子组件

<el-dialog v-model="editDialogVisible" title="编辑" width="400px">

<el-form label-width="50px" :model="localEditData">

<el-form-item label="姓名">

<el-input v-model="localEditData.name" placeholder="请输入姓名" />

el-form-item>

<el-form-item label="籍贯">

<el-input v-model="localEditData.place" placeholder="请输入籍贯" />

el-form-item>

el-form>

<template #footer>

<span class="dialog-footer">

<el-button @click="editDialogVisible = false">取消el-button>

<el-button type="primary" @click="emit('edit-success', localEditData)">确认el-button>

span>

template>

el-dialog>

<script setup>

import { ref, reactive, defineProps, defineEmits, defineExpose, watch } from 'vue'

const editDialogVisible = ref(false)

const props = defineProps({

editData: {

type: Object,

default: () => ({})

}

})

const emit = defineEmits(['edit-success'])

defineExpose({editDialogVisible})

// 使用reactive创建本地副本

const localEditData = reactive({

id: '',

name: '',

place: ''

})

// 监听props变化,手动同步字段(避免deep监听)

watch(

() => props.editData,

(newVal) => {

if (newVal && newVal.id) {

localEditData.id = newVal.id

localEditData.name = newVal.name

localEditData.place = newVal.place

}

},

{ immediate: true }

)

script>

如果不是单纯为了练习props,还有另一种方式

const handleEdit = (data) => {

// 这个我做了下更新,vue3.0讲究专人专事,所以修改dialogvisibile的事情还是让子组件自己干吧

editRef.value.openDialog(data)

}

// 表单数据

const form = ref({

name: '',

place: '',

id: ''

})

// 打开弹框

const openDialog = (row) => {

editDialogVisible.value = true

form.value = {...row}

}

// 向父组件暴露打开弹窗的方法,专人专事

defineExpose({ openDialog })

// 向父组件传递编辑完成

const emit = defineEmits(['edit-success'])

// 编辑

const update = () => {

axios.patch(`/edit/${form.value.id}`, {

name: form.value.name,

place: form.value.place

})

emit('edit-success', form.value)

editDialogVisible.value = false

}

<Edit ref="editRef" @edit-success="getList" />

总结

记住:在Vue3.0的世界里,细节决定成败! 🎯*

来源:juejin.cn/post/7522367598815576073

event loop 事件循环

什么是事件循环?

事件循环是 JavaScript 运行时的一个核心机制,它管理着代码的执行顺序。它是一种机制,用于处理异步操作,事件循环的核心是一个循环,它不断地检查调用栈和任务队列,以确保代码按照正确的顺序执行。

JavaScript 的单线程本质

JavaScript 被设计为单线程语言,这意味着它只有一个调用栈,一次只能执行一段代码。这听起来像是一个限制,但正是这种简单性让 JavaScript 如此易于使用。

console.log('开始'); // 1

setTimeout(() => {

console.log('定时器回调'); // 3

}, 1000);

console.log('结束'); // 2

// 输出顺序:

// 开始

// 结束

// 定时器回调

事件循环的组成部分

1. 调用栈(Call Stack)

调用栈是 JavaScript 执行代码的地方。当函数被调用时,它会被推入栈顶;当函数返回时,它会从栈顶弹出。

function first() {

console.log('第一个函数');

second();

}

function second() {

console.log('第二个函数');

}

first();

2. 任务队列(Task Queue)

任务队列(也称为宏任务队列)存储着待处理的任务,如:

setTimeout和setInterval回调- I/O 操作

- UI 渲染

- 事件处理程序

3. 微任务队列(Microtask Queue)

微任务队列具有更高的优先级,包括:

- Promise 回调(

.then(),.catch(),.finally()) queueMicrotask()MutationObserver

事件循环的工作流程

事件循环遵循一个简单的循环:

- 执行调用栈中的同步代码

- 当调用栈为空时,检查微任务队列

- 执行所有微任务(直到微任务队列为空)

- 检查宏任务队列,执行一个宏任务

- 重复步骤 2-4

console.log('脚本开始'); // 同步代码

setTimeout(() => {

console.log('setTimeout'); // 宏任务

}, 0);

Promise.resolve()

.then(() => {

console.log('Promise 1'); // 微任务

})

.then(() => {

console.log('Promise 2'); // 微任务

});

console.log('脚本结束'); // 同步代码

// 输出顺序:

// 脚本开始

// 脚本结束

// Promise 1

// Promise 2

// setTimeout

实际应用示例

场景 1:用户交互与数据获取

// 模拟用户点击和API调用

document.getElementById('button').addEventListener('click', () => {

console.log('点击事件处理'); // 宏任务

// 微任务优先于渲染

Promise.resolve().then(() => {

console.log('Promise 在点击中');

});

// 模拟API调用

fetch('/api/data')

.then(response => response.json())

.then(data => {

console.log('获取到的数据:', data); // 微任务

});

});

console.log('脚本加载完成');

场景 2:动画性能优化

// 不推荐的写法 - 可能阻塞渲染

function processHeavyData() {

const data = Array.from({length: 100000}, (_, i) => i);

return data.map(x => Math.sqrt(x)).filter(x => x > 10);

}

// 推荐的写法 - 使用事件循环分块处理

function processInChunks(data, chunkSize = 1000) {

let index = 0;

function processChunk() {

const chunk = data.slice(index, index + chunkSize);

// 处理当前块

chunk.forEach(item => {

// 处理逻辑

});

index += chunkSize;

if (index < data.length) {

// 使用 setTimeout 让出控制权,允许渲染

setTimeout(processChunk, 0);

}

}

processChunk();

}

常见陷阱与最佳实践

陷阱 1:阻塞事件循环

// ❌ 避免 - 长时间运行的同步操作

function blockingOperation() {

const start = Date.now();

while (Date.now() - start < 5000) {

// 阻塞5秒

}

console.log('操作完成');

}

// ✅ 推荐 - 使用异步操作

async function nonBlockingOperation() {

await new Promise(resolve => setTimeout(resolve, 5000));

console.log('操作完成');

}

陷阱 2:微任务递归

// ❌ 可能导致微任务无限循环

function dangerousRecursion() {

Promise.resolve().then(dangerousRecursion);

}

// ✅ 使用 setImmediate 或 setTimeout 打破循环

function safeRecursion() {

Promise.resolve().then(() => {

setTimeout(safeRecursion, 0);

});

}

现代 JavaScript 中的事件循环

async/await 与事件循环

async function asyncExample() {

console.log('开始 async 函数');

await Promise.resolve();

console.log('在 await 之后'); // 微任务

const result = await fetch('/api/data');

console.log('数据获取完成'); // 微任务

}

console.log('脚本开始');

asyncExample();

console.log('脚本结束');

// 输出顺序:

// 脚本开始

// 开始 async 函数

// 脚本结束

// 在 await 之后

// 数据获取完成

调试技巧

1. 使用 console 理解执行顺序

console.log('同步 1');

setTimeout(() => console.log('宏任务 1'), 0);

Promise.resolve()

.then(() => console.log('微任务 1'))

.then(() => console.log('微任务 2'));

queueMicrotask(() => console.log('微任务 3'));

console.log('同步 2');

2. 性能监控

// 测量任务执行时间

const startTime = performance.now();

setTimeout(() => {

const endTime = performance.now();

console.log(`任务执行耗时: ${endTime - startTime}ms`);

}, 0);

执行顺序问题

网上很经典的面试题

async function async1 () {

console.log('async1 start')

await async2()

console.log('async1 end')

}

async function async2 () {

console.log('async2')

}

console.log('script start')

setTimeout(function () {

console.log('setTimeout')

}, 0)

async1()

new Promise (function (resolve) {

console.log('promise1')

resolve()

}).then (function () {

console.log('promise2')

})

console.log('script end')

输出结果

script start

async1 start

async2

promise1