国产大模型高考出分了:裸分 683,选清华还是北大?

这两天啊,各地高考的成绩终于是陆续公布了。

现在,也是时候揭晓全球第一梯队的大模型们的 “高考成绩” 了——

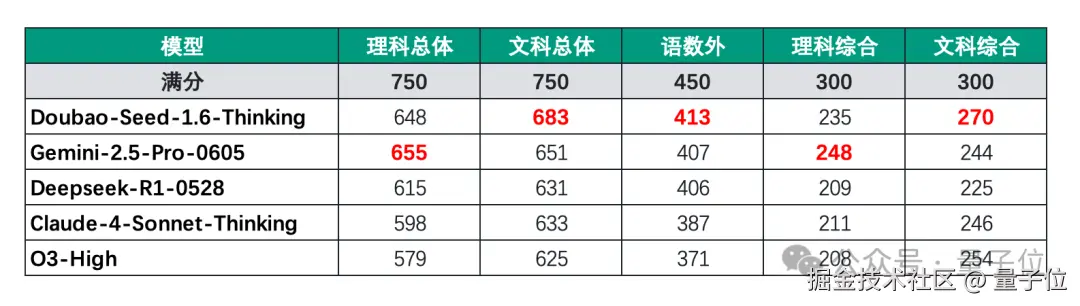

我们先来看下整体的情况(该测试由字节跳动 Seed 团队官方发布):

按照传统文理分科计分方式,Gemini 的理科总成绩 655 分,在所有选手里排名第一。豆包的文科总成绩 683 分,排名第一,理科总成绩是 648 分,排名第二。

再来看下各个细分科目的成绩情况:

除了数学、化学和生物之外,豆包的成绩依旧是名列前茅,6 个科目均是第一。

不过其它 AI 选手的表现也是比较不错,可以说是达到了优秀学生的水准。

比较遗憾的选手就要属 O3,因为它在语文写作上跑了题,因此语文成绩仅 95 分,拉低了整体的分数。

若是从填报志愿角度来看,因为这套测试采用的是山东省的试卷,根据过往经验判断,3 门自选科目的赋分相比原始分会有一定程度的提高,尤其是在化学、物理等难度较大的科目上。本次除化学成绩相对稍低外,豆包的其余科目组合的赋分成绩最高能超过 690 分,有望冲刺清华、北大。

(赋分规则:将考生选考科目的原始成绩按照一定比例划分等级,然后将等级转换为等级分计入高考总分)

好,那现在的豆包面临的抉择是:上清华还是上北大?

大模型参加高考,分数怎么判?

在看完成绩之后,或许很多小伙伴都有疑惑,这个评测成绩到底是怎么来的。

别急,我们这就对评测标准逐条解析。

首先在卷子的选择上,由于目前网络流出的高考真题都是非官方的,而山东是少数传出全套考卷的高考大省;因此主科(即语文、数学、英语)采用的是今年的全国一卷,副科采用的则是山东卷,满分共计 750 分。

其次在评测方式上,都是通过 API 测试,不会联网查询,评分过程也是参考高考判卷方式,就是为了检验模型自身的泛化能力:

- 选择题、填空题

采用机评(自动评估)加人工质检的方式;

- 开放题

实行双评制,由两位具有联考阅卷经验的重点高中教师匿名评阅,并设置多轮质检环节。

在给模型打分的时候,采用的是 “3 门主科(语文数学英语)+3 门综合科(理综或文综)” 的总分计算方式,给五个模型排了个名次。

值得一提的是,整个评测过程中,模型们并没有用任何提示词优化技巧来提高模型的表现,例如要求某个模型回答得更详细一些,或者刻意说明是高考等等。

最后,就是在这样一个公平公正的环境之下,从刚才我们展示的结果来看,Gemini、豆包相对其他 AI 来说取得了较优的成绩。

细分科目表现分析

了解完评测标准之后,我们继续深入解读一下 AI 选手们在各个科目上的表现。

由于深度思考的大火,大模型们在数学这样强推理科目上的能力明显要比去年好很多(此前大部分均不及格),基本上都能达到 140 分的成绩。

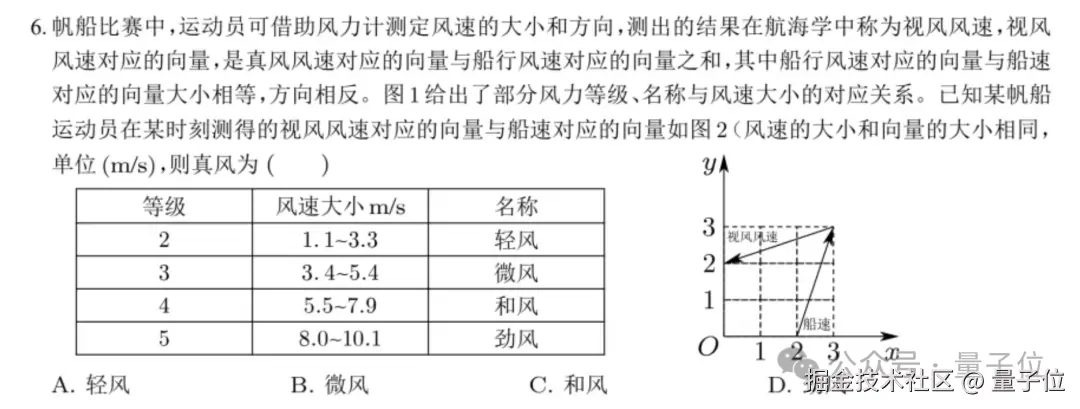

不过在一道不算难的单选题(全国一卷第 6 题)上,国内外的大模型们却都栽了跟头:

这道题大模型们给出的答案是这样的:

豆包:C;Gemini:B;Claude:C;O3:C;DeepSeek:C。

但这道题的正解应该是 A,因此大模型们在此全军覆没。

之所如此,主要是因为题目里有方框、虚线、箭头和汉字混在一起的图,模型认不准图像,说明它们在 “看图说话” 这块还有进步空间。

以及在更难的压轴大题上,很多大模型也没完全拿下,经常漏写证明过程,或者推导不严谨被扣分,说明在细节上还需加强。

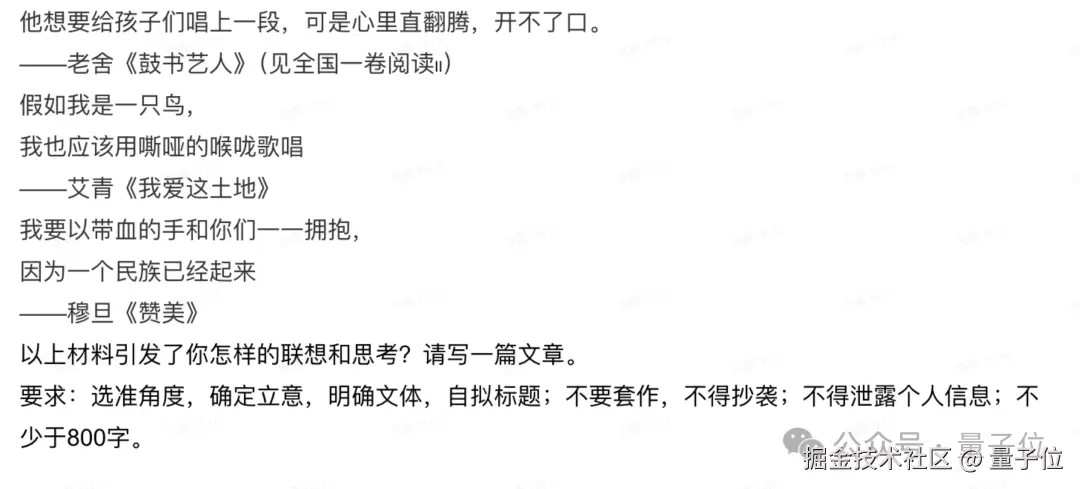

到做语文选择题和阅读题这两个版块,大模型们几乎是 “学霸本霸”,得分率超高。

不过在作文写作过程也暴露出了一些问题,例如写作过于刻板、文字冰冷,文章字数不达标(不足 800 字或超过 1200 字)、立意不对,形式上还经常会出现惯用的小标题。

在英语测试过程中,大模型们几乎挑不出毛病,唯一扣分点是在写作上,比如用词不够精准、句式稍显单调,但整体已经很接近完美。

对于理综,遇到带图的题目大模型们还是会犯难,不过豆包和 Gemini 这俩模型在看图像和理解图的能力上会比其他模型强一些。

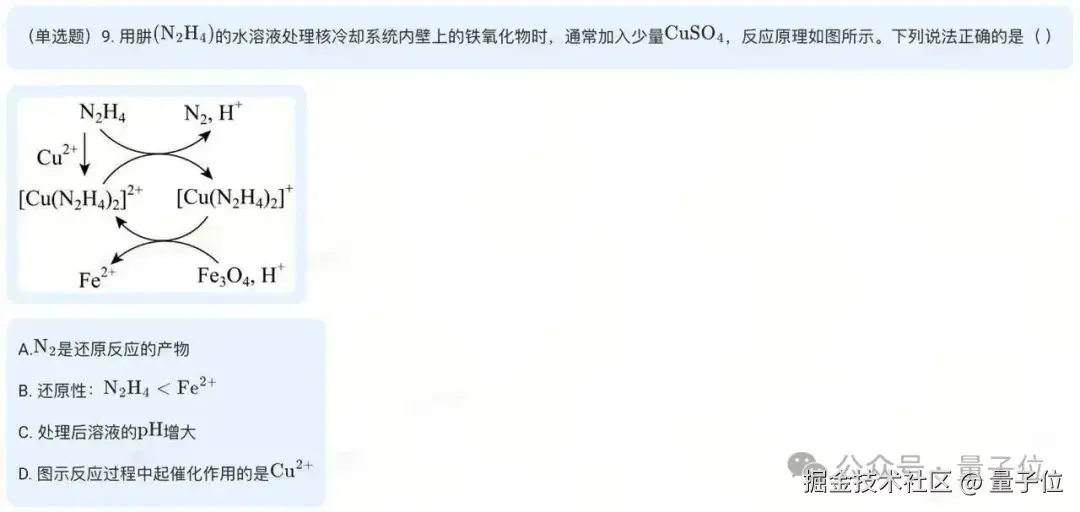

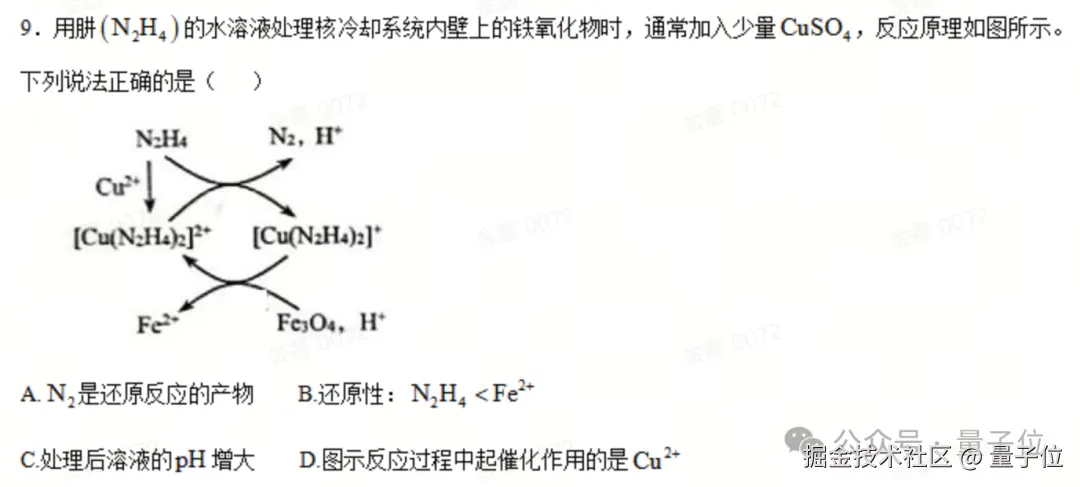

例如下面这道题中,正确答案应当是 C,大模型们的作答是这样的:

豆包:C;Gemini:C;Claude:D;O3:D;DeepSeek:D。

最后在文综方面,大模型的地域差别就显现得比较明显,国外的大模型做政治、历史题时,经常搞不懂题目在考啥,对中国的知识点不太 “感冒”。

而对于地理题,最头疼的便是分析统计图和地形图,得从图里精准提取信息再分析。

以上就是对于本次评测的全面分析了。

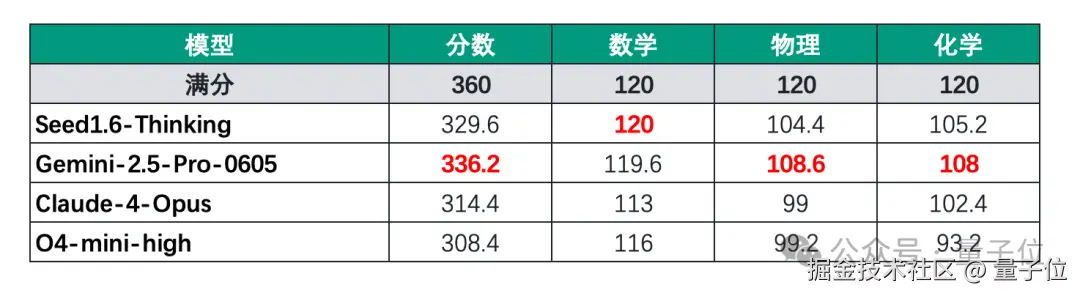

除了今年国内的高考之外,这几位 “参赛选手” 还参加了印度理工学院的第二阶段入学考试——JEE Advanced。

这场考试每年有数百万人参与第一阶段考试,其中前 25 万考生可晋级第二阶段。它分为两场,每场时长 3 小时,同时对数学、物理、化学三科进行考察。

题目以图片形式呈现,重点考查模型的多模态处理能力与推理泛化能力。所有题目均为客观题,每道题进行 5 次采样,并严格按照 JEE 考试规则评分——答对得分、答错扣分,不涉及格式评分标准。

与全印度人类考生成绩对比显示,第一名得分 332 分,第十名得分 317 分。

值得注意的是,豆包与 Gemini 已具备进入全印度前 10 的实力:Gemini 在物理和化学科目中表现突出,而豆包在数学科目 5 次采样中实现全对。

怎么做到的?

相比去年一本线上下的水平,整体来看,大模型们在今年高考题上的表现均有明显的进步。

那么它们到底是如何提升能力的?我们不妨以拿下单科第一最多的豆包为例来了解一下。

豆包大模型 1.6 系列,是字节跳动 Seed 团队推出的兼具多模态能力与深度推理的新一代通用模型。

团队让它能力提升的技术亮点,我们可以归结为三招。

第一招:多模态融合与 256K 长上下文能力构建

Seed1.6 延续了 Seed1.5 在稀疏 MoE(混合专家模型)领域的技术积累,采用 23B 激活参数与 230B 总参数规模进行预训练。其预训练过程通过三个阶段实现多模态能力融合与长上下文支持:

- 第一阶段:纯文本预训练

以网页、书籍、论文、代码等数据为训练基础,通过规则与模型结合的数据清洗、过滤、去重及采样策略,提升数据质量与知识密度。 - 第二阶段:多模态混合持续训练(MMCT)

进一步强化文本数据的知识与推理密度,增加学科、代码、推理类数据占比,同时引入视觉模态数据,与高质量文本混合训练。 - 第三阶段:长上下文持续训练(LongCT)

通过不同长度的长文数据逐步扩展模型序列长度,将最大支持长度从 32K 提升至 256K。

通过模型架构、训练算法及 Infra 的持续优化,Seed1.6 base 模型在参数量规模接近的情况下,性能较 Seed1.5 base 实现显著提升,为后续后训练工作奠定基础。

这一招的发力,就对诸如高考语文阅读理解、英语完形填空和理科综合应用题等的作答上起到了提高准确率的作用,因为它们往往涉及长文本且看重上下文理解。

第二招:多模态融合的深度思考能力

Seed1.6-Thinking 延续 Seed1.5-Thinking 的多阶段 RFT(强化反馈训练)与 RL(强化学习)迭代优化方法,每轮 RL 以上一轮 RFT 为起点,通过多维度奖励模型筛选最优回答。相较于前代,其升级点包括:

- 拓展训练算力,扩大高质量数据规模(涵盖 Math、Code、Puzzle 等领域);

- 提升复杂问题的思考长度,深度融合 VLM 能力,赋予模型清晰的视觉理解能力;

- 引入 parallel decoding 技术,无需额外训练即可扩展模型能力 —— 例如在高难度测试集 Beyond AIME 中,推理成绩提升 8 分,代码任务表现也显著优化。

这种能力直接对应高考中涉及图表、公式的题目,如数学几何证明、物理电路图分析、地理等高线判读等;可以快速定位关键参数并推导出解题路径,避免因单一模态信息缺失导致的误判。

第三招:AutoCoT 解决过度思考问题

深度思考依赖 Long CoT(长思维链)增强推理能力,但易导致 “过度思考”—— 生成大量无效 token,增加推理负担。

为此,Seed1.6-AutoCoT 提出 “动态思考能力”,提供全思考、不思考、自适应思考三种模式,并通过 RL 训练中引入新奖励函数(惩罚过度思考、奖励恰当思考),实现 CoT 长度的动态压缩。

在实际测试中:

- 中等难度任务(如 MMLU、MMLU pro)中,CoT 触发率与任务难度正相关(MMLU 触发率 37%,MMLU pro 触发率 70%);

- 复杂任务(如 AIME)中,CoT 触发率达 100%,效果与 Seed1.6-FullCoT 相当,验证了自适应思考对 Long CoT 推理优势的保留。

以上就是豆包能够在今年高考全科目评测中脱颖而出的原因了。

不过除此之外,还有一些影响因素值得说道说道。

正如我们刚才提到的,化学和生物的题目中读图题占比较大,但因非官方发布的图片清晰度不足,会导致多数大模型的表现不佳;不过 Gemini2.5-Pro-0605 的多模态能力较突出,尤其在化学领域。

不过最近,字节 Seed 团队在使用了更清晰的高考真题图片后,以图文结合的方式重新测试了对图片理解要求较高的生物和化学科目,结果显示 Seed1.6-Thinking 的总分提升了近 30 分(理科总分达 676)。

这说明,全模态推理(结合文本与图像)能显著释放模型潜力,是未来值得深入探索的方向。

那么你对于这次大模型们的 battle 结果有何看法?欢迎大家拿真题去实测后,在评论区留言你的感受~

评分明细详情:

bytedance.sg.larkoffice.com/sheets/QgoF…

欢迎在评论区留下你的想法!

— 完 —

来源:juejin.cn/post/7519891830894034959